Комментарии 8

Почему ИИ плохо отличает сгенерированные тексты от написанных человеком

Из корпоративной солидарности? Чтобы не дать шансов кожаным мешкам дискриминировать творчество братьев!

Хотя вот в случае школьных сочинений все более менее понятно. Как мне кажется, имея пул сочинений данного ученика, тексты написанные другими людьми или роботами все равно должны определяться статистически. Тут и нейросетей не нужно.

Вот вопрос о том, что написан текст неизвестным человеком или нейросетью - дискуссионный. Можно же стилизовать тексты под определенного автора. И любой фильтр это одновременно и набор правил для стилизации текста на его прохождение.

ИИ должен иметь право подписи своих текстов, чтобы можно было различить свой текст или чужой.

Причем подпись должна быть стеганографической, а проверка должна идти не по точному соответствию, а по лингвистической дистанции, чтобы замена нескольких слов не уничтожила подпись.

ИИ должен иметь право

Забудьте! ИИ не субъект права. И вообще ИИ не субъект. Это инструмент.

А идея про "подпись" напомнило идею администрации Байдена по регулированию ИИ.

Компании обязуются разработать надежные технические механизмы, позволяющие пользователям знать, когда контент создается искусственным интеллектом, например систему водяных знаков. Это действие позволит развиваться творчеству с использованием ИИ, но снизит опасность мошенничества и обмана.

Задача нейросети сгенерировать текст, который статистически не отличается от обучающей выборки. Если сеть делает это достаточно хорошо - то совершенно очевидно, что статистическии методами отличить одно от другого будет нельзя - ну просто by design.

Ведь точность "проверяльщика" в этом случае должна оказаться строго выше точности самой сети.

>Но всё изменилось в 2017 году, когда группа ИИ-исследователей Google опубликовали статью Attention is all you need, где предложила отойти от рекуррентных нейросетей в работе с текстами и подобной информацией.

Вообще, это распространенное заблуждение. Трансформеры с формально математической точки зрения являются рекуррентными сетями, если учитывать больше одного шага генерации. Идея ребят из гугла состояла как раз в том, чтобы обойти наличие рекурсии и позволить применять для обучения стандартные методы.

А есть ли у вас опыт работы с подобными инструментами? Что можете посоветовать?

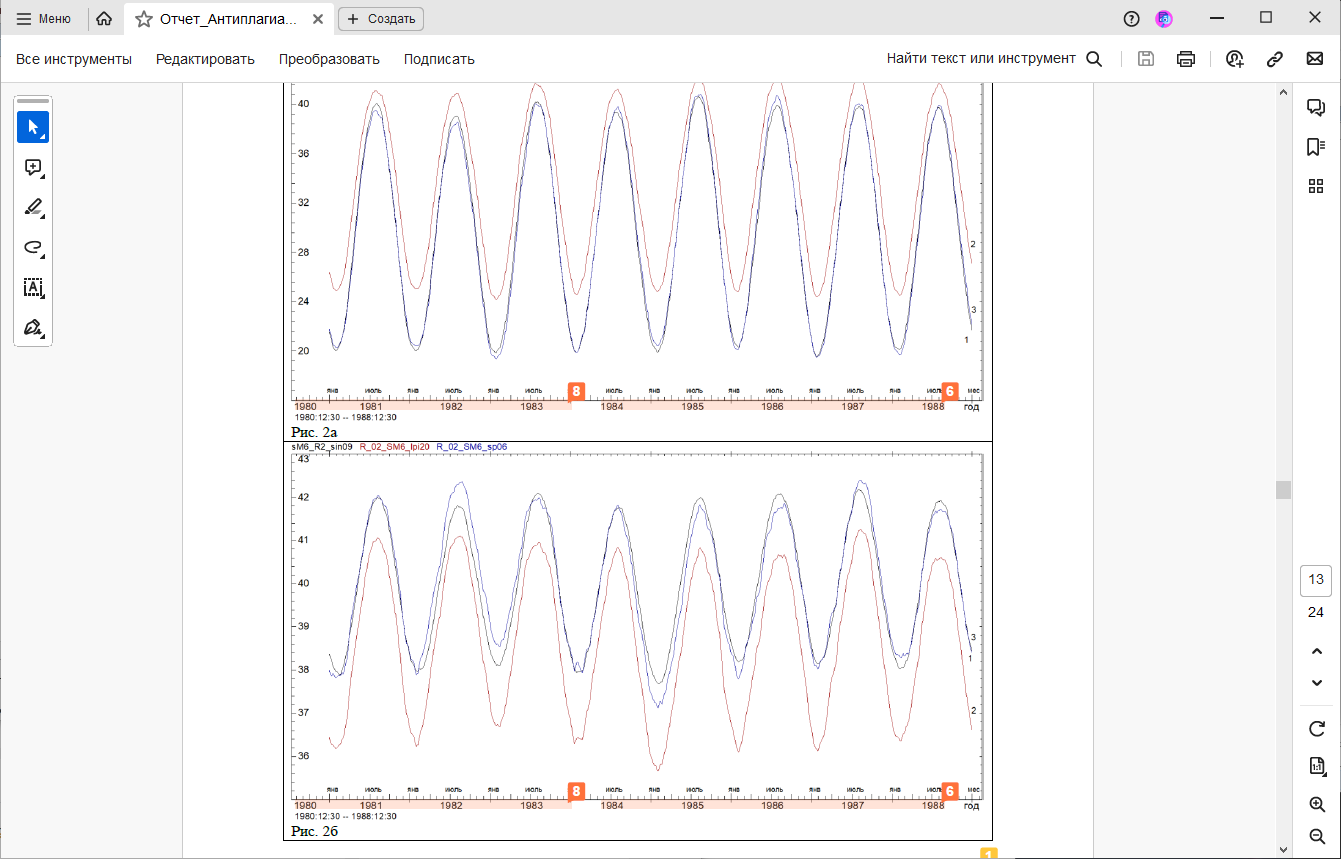

Как научный сотрудник, я иногда сталкиваюсь с проверкой на антиплагиат. И вот на днях нас впервые обвинили в скрытом самоцитировании изображения: мы воспроизвели существенную часть рисунка, но не привели ссылку на работу, откуда она заимствована. Для сохранения интриги, спрячу заимствование

под спойлер

Но сначала поясню, что мы много лет проводили наблюдения в сейсмоактивном районе, и у нас почти в каждой публикации есть картинки с временными рядами, чаще всего за 1979-1992гг. А теперь собственно претензия:

Интересно, что система выделила два фрагмента оси, как отдельные цитирования. Похоже, она сначала обработала нашу публикацию с картинкой за 1984-1988г (цитирование номер 6), а потом уже анализировала только остаток временной шкалы слева (1980-1983г) и нашла его совпадение с другой публикацией. Хотя в публикации (8) у нас вроде ось на картинке 12-летняя, а не 4 года.

Кстати, про публикации-источники

Это вообще отдельная тема. Формально для каждого заимствования в отчете приводится его источник. Но там сплошь им рядом стоит что-то вроде "Перефразированные заимствования по коллекции Интернет в английском сегменте". И как я должен отсюда понять, что именно ей не понравилось? Надпись "год" или число "42"?

В общем, вывод такой: алгоритмы развиваются быстро, но "дыры", подобные приведенной под спойлером, в них вылезают направо и налево пока что. Хорошо, если в редакции сидят адекватные люди и им можно объяснить, что надпись "январь" - это "необходимое самоцитирование", вполне уместное в научной работе. Но ведь журнал-то не сферический и не в вакууме. Ему надо выполнять формальные метрики, а как они получились - разбираться никто не будет. Если сверху спущено требование: "процент совпадений не выше ХХХХ", то хоть убейся, а выполняй. Иначе система снизит рейтинг журнала.

Так что на данный момент ИИ очень хорош в качестве помощника, но только если все его результаты потом интерпретируются кожаными мешками. Если представить себе условную "редакцию на ИИ", то как бы мы ей объясняли проблему с нашей картинкой?

Конечно, поживем-увидим, но пока что я опасаюсь, что до полного искоренения таких глюков намного дальше, чем от Т9 до ChatGPT. И что если доверить "творческие процессы" системам на основе ИИ чуть раньше, чем они будут к этому готовы (например, по причине массового нежелания кожаных заниматься этим самостоятельно), то вместо прогресса мы получим быструю деградацию как науки, так и всего человечества в целом.

P.S. Мы тут частенько размышляем про парадокс Ферми (я там тоже, кстати отметился, пытаясь все свести к понижению среднего уровня интеллекта "всемирного разума" по мере интернетизации человечества). Но вот такое объяснение парадокса Ферми - через самозацикливание глюков ИИ - кажется, может добавить в это обсуждение новую тему...

То есть нейросеть тренировали, чтобы она выдавала текст неотличимый от написанного человеком, а теперь жалуются, что не могут эти тексты отличить?

но его довольно быстро закрыли, поскольку точность определения составляла менее 26 %

Хм, а они не пробовали пррсто инвертировать ответ? Тогда точность будет больше 74 %)

Генеративная «уловка-22», или Почему ИИ плохо отличает сгенерированные тексты от написанных человеком