Comments 42

Если же вы опытный, ждем в комментариях. Поделитесь своей историей и мнением: видите ли вы смысл в таком волонтерстве?Я не слишком опытный, но еще в прошлом веке встречался с сурьезным челом, который мне тогда же и объяснил смысл всей этой движухи.

Его сайт давно умер, поэтому я считаю возможным публично сослаться на его адрес www.werwolf.de

Да, сейчас там стандартная заглушка.

Нет, я не считаю интересным для себя писать на эту тему здесь, на Хабре: кому интересно — в личку, мож и споёмся…

который мне тогда же и объяснил смысл всей этой движухи.

Судя по его сайту, он участвовал в distibuted.net. Это было не волонтерство, а конкурс с денежными призами.

Хехе, живы еще, чертяки…

в те времена такие сети использовали для собственных задач — для экстренного брута, когда не хватало своих мощностей.

Я уже тогда был двинут на конспирологии, поэтому мне и тогда, и сейчас нравится эта гипотеза. Я встречался с ним лично в мск по его инициативе — это не первый раз, когда я кого-то случайно заинтересовывал в рунете, хе-хе

Хехе, живы еще, чертяки…www.youtube.com/watch?v=YXIH8XgvVPY

Я два месяца назад портировал Rosetta@Home на ARM. Команда приняла мои патчи и быстро выпустила новый релиз, с поддержкой ARM. За эти два месяца армовские устройства уже сделали серьезный вклад в общую сумму вычислений для проекта.

Также прямо сейчас я работаю над новой версией Folding@Home, в которой очень много улучшений, и она поддерживает ARM. Работа на финальном этапе, мы уже выпустили первую закрытую бету для тестирования. В ближайшие недели, думаю, будет релиз.

ARM устройств в мире очень много, и они значительно более энергоэффективны, чем Intel и AMD. Я полагаю, что с выходом новой версии мы сможем значительно увеличить количество экзафлопов для проекта.

Почему Folding@Home не перейдет на BOINC или хотя бы не сделает дополнительную возможность просчет в нем?

Ну и по поводу SETI — вроде они не так давно завязали с добровольными вычислениями.

Про SETI@home все так: 31 марта объявили о закрытии. Ученые сообщили, что проанализировали практически данные, необходимые на текущий момент.

Folding@Home в первую очередь научный проект. В его составе много ученых, но мало программистов. И у них просто нет времени на дополнительные работы, тем более, что там есть намного более актуальные проблемы. Собственно говоря, я и делаю им новую версию потому, что у них самих ресурсов на это нет. Они до сих пор используют Gromacs 5.0.4 шестилетней давности. И есть множество проблем, которые можно решить, только перейдя на Gromacs 2020 (чем я и занимаюсь последние два месяца и финал уже близок).

BOINC довольно требователен к проектам-участникамАпачиму? Спрос превышает предложение или по другим причинам?

Для начала, там довольно нетривиальная завязка с BOINC: клиент общается с BOINCом через специальную структуру в shared memory. Без этого боинк не может считалку ни запустить, ни приостановить, ни прогресс показать.

Понятно, что надо как-то договориться с боинком об именах файлов, формате воркюнитов и т.п. (в поздних версиях боинка добавили проверку подписей в данных, чтобы злые хакеры не могли накрутить себе рейтинг модифицированными результатами).

Ну и надо было зарегистрировать свой проект в боинке, чтобы он появился в списке проектов.

Впрочем, все это лирика. Смутно вспоминаю, что в боинке одно время была целая куча всяческих невнятных проектов, поэтому не думаю, что все трудности были прямо такими непреодолимыми. Скорее всего, ребята пришли в неудачное время (смена команды BOINC) с уже готовым кодом, который не очень хорошо списывался в инфраструктуру. Пока они его переделывали — BOINC тоже активно перепиливался. В результате они отложили интеграцию, а потом и совсем на нее забили — и так все хорошо.

Вопрос вот в чем: можно ли изменить логику работы так, чтоб сделать ее эффективной?

Люди уходят (или не приходят) из проектов, по причинам из статьи выше, но лично я выделяю эти причины:

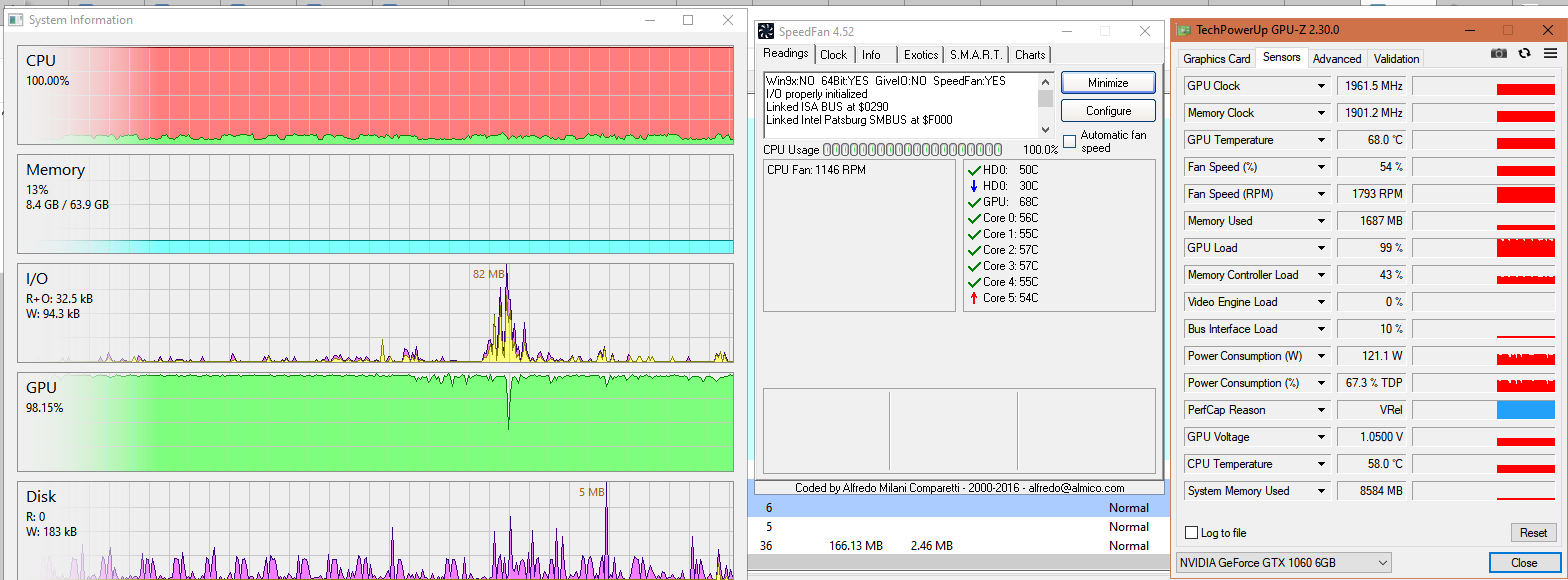

- Электричество

- Шум от кулеров

- Снижение производельности

Снижение производительности можно избежать грамотной настройкой клиента, однако случаются разные моменты, которые логика нескольких if-ов не способна понять.

Например я смотрю фильм. Не двигаю курсор N минут. BOINC думает, что я не активен, запуская вычисления. И вот просмотр фильма слегка портится тихим "вжжжжжж" от кулера. И вот уже через пару минут тихое "вжжж" сменяется громким «ВЖЖЖ!» от 8 ядер, разогнавшихся на все свои Гигагерцы.

Частоты можно порезать через режимы энергопотребления, но хотелось бы решения этого вопроса через сам клиент.

А к чему вообще этот очень длинный коммент?

Вычисления распределенные — это круто, но было бы еще круче, если бы от них не было вреда конечному пользователю.

Для себя я написал маленький скрипт, который задает привязку к ядру процессора (обычно только одному/двум) для BOINC клиента. Процессы хоть и имеют приоритет минимальный, но ОС не считает их фоновыми (и потому увеличивает частоты ядер для большей производительности).

Электричество

Я не поленился, купил ваттметр китайский аж за 500 рублей. Разница между полным простоем CPU и полной загрузкой всех ядер (i7 3770, 4 ядра, 8 потоков) — ватт этак 50. При этом в полном простое компьютер жрет около 150 ватт. Экономия в 1/4 — это так себе экономия.

Вот полная загрузка видеокарты — да, способна подкинуть еще +100 ватт.

Шум от кулеров

Да, есть такое. Тем не менее — лечится установкой избыточного радиатора, тихих кулеров и выставлением графика оборотов в БИОСе.

Вот шум видеокарты победить сложнее, особенно если система охлаждения на видяхе не очень.

Снижение производельности

Практически незаметно на современных CPU. Например, низкоприоритетные процессы не мешают компилять программы — даже наоборот, держат ядра загруженными и не дают процессору снизить частоты. Впрочем, определенные косяки вылезают. Например, из замеченного лично мной — в винде приходится долго ждать выскакивающей менюшки «безопасное извлечение устройств» при щелчке по иконке USB-девайсов.

Вот загрузка видеокарты вполне может проявиться суровыми тормозами, это да.

Например я смотрю фильм. Не двигаю курсор N минут. BOINC думает, что я не активен, запуская вычисления. И вот просмотр фильма слегка портится тихим «вжжжжжж» от кулера.

Можно откладывать запуск вычислений, если работает полноэкранное приложение (фильм или игра). Под виндой проверка реализуется довольно просто, под линуксом — не знаю, но думаю, что тоже возможно. Почему-то в BOINC эту проверку так и не удосужились добавить, хотя я в форуме разработчиков даже код соответствующий постил. Не помню уже, чем там они мотивировали отказ — то ли тем, что «мы же можем скринсейвер запускать, а он полноэкранный», то ли еще чем.

Для себя я написал маленький скрипт, который задает привязку к ядру процессора (обычно только одному/двум) для BOINC клиента. Процессы хоть и имеют приоритет минимальный, но ОС не считает их фоновыми (и потому увеличивает частоты ядер для большей производительности).

А такая неравномерная нагрузка не вредна процессору? Одно-два ядра постоянно горячие, а остальные — почти все время холодные. Не расслоится, не треснет?

Рост ТПД в зависимости от частоты линейный. Но кроме повышения частот, включаются дополнительные ядра (обычно у меня занято 1-2/8 логических — 1 физическое работает, а 3 стоят без дела и не потребляют энергию почти что).

Шум от кулеров конечно чинится покупкой новых комплектующих, но сейчас бы покупать что-то специально под BOINC. Не все биосы дают ставить обороты, да и не все кулеры умеют в 0 оборотов.

Можно откладывать запуск вычислений, если работает полноэкранное приложение

Это было бы очень удобно, как раз решая одно из последствий проблемы, но не саму проблему.

А такая неравномерная нагрузка не вредна процессору? Одно-два ядра постоянно горячие, а остальные — почти все время холодные. Не расслоится, не треснет?

Они едва греют на 45-50 градусов, но в общем Вы правы.

Я как раз думал купить ваттметр, но тут подвернулось приложение (OpenHardwareMonitor), где можно смотреть потребление чисто процессором (не уверен в точности, однако хоть что-то).

Я «майню науку» на ноутбуке и пк. На пк проблем в общем нет, тк на нем работаю и он загружен постоянно, а когда отхожу — включается BOINC. В общем проблем нет, кроме занятой оперативки.

А вот с ноутбуком сложнее. На нем все тормоза от BOINC видны гораздо сильнее, да и с энергопотреблением/теплоотводом проблемы. Галочка «не работать, если от батареи» помогает, но на ночь ноут обычно простаивает, скачивая что-то (с зарядкой включенной).

Обычно он спокойно рассеивает 1-2вт тепла без кулеров, а вот с 2.5вт уже начинается «вжжж», под которое не очень комфортно засыпать. Настроек включения кулеров нет ни в биосе, ни в приложениях сторонних.

В итоге костыль с привязкой ядер помогает, хоть и за счет замедления выполнения.

И про то, что эффективно: в диспетчере задач есть пункт «Бездействие системы» — как раз те такты, где процессор работает впустую (обычно это 70-80%). Мой скрипт позволяет спихнуть все приложения на одно ядро. Тогда остальные ядра выключаются. В таком случае бездействие системы снижается аж до 10-20% (не 0% за счет системных процессов, которые все равно запускаются на выключенных ядрах).

0-5% Получаются только в случае 100% загрузки.

И еще раз про ваттметр. Попробуйте провести измерения при одной частоте цпу. Тогда, по моим вычислениям, разница в энергопотреблении будет почти нулевой как при 0% загрузки, так и при 100% (при условии, что будет работать постоянное количество ядер)

И еще раз про ваттметр. Попробуйте провести измерения при одной частоте цпу. Тогда, по моим вычислениям, разница в энергопотреблении будет почти нулевой как при 0% загрузки, так и при 100% (при условии, что будет работать постоянное количество ядер)

Китайский ваттметр — это отдельная тема, у него цифры на экранчике мельтешат так, что только чудом что-то можно разглядеть. Если честно, даже лень лезть под стол и втыкать его снова.

Да и вообще… Что касается расхода электричества и объема проведенных вычислений, я для себя давно уже вывел простые правила:

— вычисления на CPU дают мизерные результаты. Если задача хорошо паралеллится — даже бюджетная видеокарта покроет крутой процессор как бык овцу. Поэтому вычисления на CPU нужно пускать только в том случае, если CPU снижает частоты и из-за этого недогружается GPU.

— пускать вычисления на ноутбуках, нетбуках, распберри паях и прочей мелкой технике — прикольно. Но почти бесполезно. При наличии хоть одной видяхи класса GTX 1060, подключенной к вычислениям, вклад этих шарабаек будет измеряться десятыми долями процента.

Поэтому вычисления на CPU нужно пускать только в том случае, если CPU снижает частоты и из-за этого недогружается GPU.

— пускать вычисления на ноутбуках, нетбуках, распберри паях и прочей мелкой технике — прикольно. Но почти бесполезно.

Тут много тонкостей, далеко не всё можно запустить на GPU, там дело не только в параллелизме, GPU в принципе не может многие вещи посчитать которые может спокойно посчитать CPU. С мелкими устройствами тоже не всё так однозначно, у меня на «утилизации», например, работает OnePlus 3T, если бы экран и корпус не кокнулся то пользовался бы им до сих пор, но поскольку ремонтопригодность этих проклееных железок стремится к нулю, то либо так либо в утилизацию, ещё большое сожаление вызывает то, что убогий Android не даёт все 4 ядра утилизировать, поэтому работают только 3 из 4, да и BOINC там запущен через редкостные костыли. Насколько понимаю последняя версия на которой ещё можно пользоваться без заморочек, это Android 7, а дальше Google всё сломал. Профит с этого калькулятора есть, он довольно энергоэффективен получается, да и в плане заморочек они одноразовые: запустил, кинул на полку, он и работает.

Практически незаметно на современных CPU. Например, низкоприоритетные процессы не мешают компилять программы — даже наоборот, держат ядра загруженными и не дают процессору снизить частоты.

Подтверждаю. Во всяком случае CPU расчеты никак не мешают работе (программированию), хотя проц загружен на более чем 99%. И в настройках BOINC установлены параметры для максимальной производительности.

Разница между полным простоем CPU и полной загрузкой всех ядер (i7 3770, 4 ядра, 8 потоков) — ватт этак 50.

Что вполне ожидаемо ибо TDP у чипа 77 Вт, а процессор очевидно выкладывается не на полную ибо из проектов почти никто не использует, например AVX.

также можно настроить чтобы задания не работали когда запущены определённые приложения

Вы правы, и более того, решили мою проблему с включением во время просмотра кино )

Однако я больше топлю за утилизацию пустых тактов без увеличения энергопотребления.

Бесплатная производительность в чистом виде.

То есть по сути тут как раз бесплатная производительность.

часть ядер в многоядерной системе уходит в очень глубокий сон, а то и вовсе отключаются

Про ядра я писал выше (моя шайтан-прога ставит через маску процессу только на 1 ядро под BOINC, ибо иначе включены все ядра с загрузкой в 20-30%, что так себе сказывается на потреблении и шуме)

При одной и той же частоте загруженный процессор в разы будет потреблять энергии больше чем незагруженный.

Измерения по OpenHardwareMonitor-у с Вами будут не согласны. Надо бы проверить уже с ваттметром, но все никак не могу потратить 10$ на его покупку )

Плюс я запускал систему с выключенными некоторыми ядрами. Результат был аналогичен почти всегда: при одинаковом количестве ядер на одной частоте потребление на 100% и на 0% не отличалось (0.1-0.2вт). А вот включение каждого последующего ядра и/или рост частот, понятное дело, повышали потребление.

Так что я все еще верю в «пустые такты» :)

Как по мне такие страдания с ручным прибиванием к ядру это уже слишком, надо либо обновлять систему охлаждения чтобы не шумела, либо просто пренебречь. Опять же если вызывает такуя озабоченность энергопотребление, то тоже проще пренебречь.

% процессора просто задают количество заданий активных. При этом они по ядрам скачут как угодно (что еще хуже, ибо потребление остается, но при этом задания выполняются меньше). Время цп настраивать там вообще бесполезно. Простои как были, так и остаются.

Да и мои страдания исключительно моральные, ибо можно сделать лучше всем, но оно так не работает. А так мне не сильно жалко тех 2-3вт, которые тут идут сверх обычного потребления.

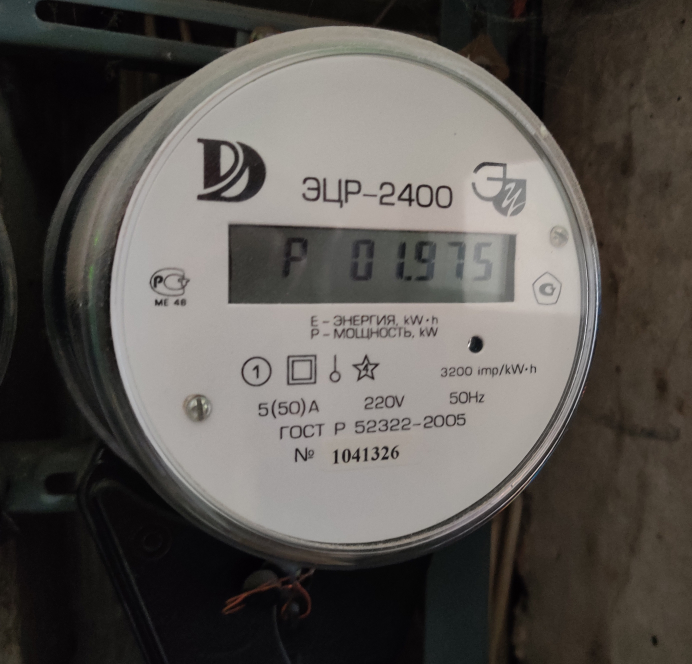

я, дабы никого не пугать, не буду показывать показания с счётчика электроэнергии

Напугайте меня — интересно просто :)

P.S. по деньгам, сейчас, 2600 — 2800 ₽ в месяц выходит за электричество, но это сумма со всего.

Занятно. А какие BOINC проекты у вас утилизируют GPU? В World community grid походу не используется.

К слову, GPUGRID довольно оперативно публикуют ещё и сведения о том каким исследованиям помогли именно твои вычисления и даже отдельные бейджи с процентами дают за каждое опубликованное на основе данных исследование.

Сейчас ещё по теме COVID-19 кранчу и для Ibercivis (на момент написания комментария сайт проекта лежит ^^). Проект Ibercivis проверяет эффективность потенциально работающих и уже существующих разрешённых препаратов против COVID-19, если повезёт то можно будет гораздо быстрее начать применять уже хорошо проверенный препарат в качестве лечения.

We are working on physically optimizing the cooling of the data center where the BOINC servers of the Covid-Phym project are hosted. To undertake the cooling works it has been necessary to cut the electricity of the entire data center. The work is expected to be completed this Friday, June 19. Once completed, all services will be raised. We deeply regret the inconvenience caused More information on the Ibercivis website

Сайт проекта лежал поскольку они вносят улучшения в систему охлаждения дата центра O_O

Хороший вариант — запускать компьютер на ночь и идти спать. Лучший — купить виртуальную машину у облачного провайдера и запустить там BOINC 24/7.

Серьезно? То то провайдер обрадуется, что на его мощностях вы решили принести благо человечеству. У большинства, если это не спецтальные инстансы для вычислений, есть в соглашении что майнить (а с точки зрения прова процесс неотличим) нельзя.

Вообще я достаточно долгое время наблюдаю за движухой, с чисто энтомологическим интересом, тк я не понимаю ЗАЧЕМ.

Если есть желание слушать рев кулеров и оплачивать счета за электричество, то можно майнить, за это ДЕНЬГИ ПЛАТЯТ.

Лично я убил серьезную сумму денег и кучу времени чтобы НЕ слушать воющие звуки высокооборотных кулеров (сборка и установка кастомной СЖО на проц и обе видеокарты), и не готов пожертвовать акустическим комфортом даже за $3 в день (примерно столько будет майнить домашняя машина), а уж за ради блага человечества…

Про то что майнинг и прочий фолдинг просто убивают игровые видеокарты, а особенно ноутбуки, которые просто конструктивно не рассчитаны на 24\7 вообще промолчу…

ЗЫ. У меня были майнинговые риги в 15 и 18 годах, какой это гемор домашние вычисления я представляю, зачем это делать бесплатно (а по сути в убыток) — нет.

Вообще я достаточно долгое время наблюдаю за движухой, с чисто энтомологическим интересом, тк я не понимаю ЗАЧЕМ.

- Дух соревнования: уделать соседа по количеству нащелканных попугаев.

- Желание доказать себе, что выжал из железа по максимуму («круто я свой райзен разогнал — вон сколько попугаев по сравнению с аналогичными конфигами!»)

- «Все равно зазря машинка работает, а так хоть какую-то пользу принесет» (о серверах и не выключаемых на ночь рабочих станциях)

А вообще, мне кажется, это сродни стремлению разогнать железо: практическая польза сомнительна, но как-то душу греет. :)

Про то что майнинг и прочий фолдинг просто убивают игровые видеокарты, а особенно ноутбуки, которые просто конструктивно не рассчитаны на 24\7 вообще промолчу…

Ноутбуки да, а насчет видеокарт можно поспорить. Все-таки игровая видеокарта рассчитана не на пятиминутные сеансы игры, а на достаточно продолжительное время — пару часов хотя бы. Зависит от системы охлаждения, конечно: глупо было бы ждать низких температур и тишины от карты с одним вентилятором. В любом случае в приличных майнинговых программах должен быть мониторинг температур и управление нагрузкой (впрочем, тут я не уверен, майнингом не занимался).

Я вот сплю в той же комнате где комп стоит, и одно дело шелест на 500RPM с расстояния три метра, а совсем другое ВУУУ ВУУУУ ВУУУУУУУ

пару часов хотя бы

Угу, как раз пара часов и 24 на 7 это две больших разницы, как практикующий майнер сообщу следующее:

1. СО, в ВК с полупассивным охлаждением (то есть кулера включаются только при нагрузке) сейчас ставят кулеры с настолько позорной наработкой на отказ… Через два года даже не 100% режима из строя выходит до половины.

2. Термопрокладки, при превышении постоянном рабочей температуры они текут и высыхают, а за ними улетают мосфеты или чипы памяти, необходима замена, которая часто должна производится до окончания гарантийного срока, и чревата слетом с гарантии.

3. В большинстве случаев при кажущихся комфортными 65гр на чипе, если радиатор питальника не сообщается с общим, то на оном может быть до 100+ гр. А никаких термодатчиков там нет. Лично я считаю что майнить на вк можно только с продольным обдувом оной серверными кулерами от 2000RPM. И разумеется происходить это должно только в открытом корпусе или корпусе типа аэродинамическая труба, а никак не внутри домашнего ПК, где майнящая Вк разогреет вообще всю комплектуху. Если она не турбина (бловер), а если турбина то надо готовить 2к на ее замену через пару лет.

1 КВт/ч стоит 3,5 рубля. Если я начну делать мир лучше на 2080ti то это 0,2КВт*24*3,5*30=500Р в месяц, а не жирно ли будет миру? Даже без учета риска убить вк за килобакс+

Я вот сплю в той же комнате где комп стоит, и одно дело шелест на 500RPM с расстояния три метра, а совсем другое ВУУУ ВУУУУ ВУУУУУУУ

А зачем гонять комп ночью? Он даже без вувуву неплохо так электричества нажрет за месяц.

Для раздачи всяких торрентов можно завести отдельную маломощную шарабайку (да хоть ту же малину ака raspberry pi) — она на пассивном охлаждении вполне справится с такими задачами.

с выключенными мониторами потребление системы ок 70вт, а в суспенде вообще практически отсутствует

Попали в SETI: добровольные вычисления для скептиков, оптимистов и искушенных кранчеров