Комментарии 273

Даже не представить, что может заставить одни контакты пропускать больший ток, чем другие - разные линии питания и неравномерная нагрузка? Но это как-то странно, чтобы не мучаться с этим как раз и объединяют все питание в общую кучу.

Но это как-то странно, чтобы не мучаться с этим как раз и объединяют все питание в общую кучу.

Проблема в том, что теперь они не знают из-за этого, пропускают ли одни контакты больший ток, чем другие. Переложили свою головную боль на юзера.

Тут не надо ничего представлять - разное сопротивление линий без их балансировки со стороны потребителя.

Ничего удивительного.

Вот 8 точек, в любом случае их сопротивление не одинаково и хоть немного отличается. Где сопротивление выше - там больше температура, чем больше температура, тем быстрее окисляется и хуже контакт и выше температура.

Тут бы активный балансир, но это дорого.

Не понимаю, что мешает колхозным паяльником припаять любой из имеющихся на рынке мощных разьёмов. Стоимость видеокарты несопоставима, со стоимостью такого разъёма вместе с услугами "рукастого" мастера, который его заменит.

На канале LTT есть видео как раз об этом.

Да как-то неохота колхозить видяху за 2.5к евро + терять гарпнтию.

Но гарантированно потерять её от пришедших в негодность контактов - охота? 😳

Да не нужен никакой балансир, нужен обычный разьём на два кабеля под нужный ток - у автомобилистов и дроноводов такого добра навалом, не ясно что мешало использовать.

Но проблема развести один контакт на плате дорожками. Площадь соединения маленькая.

На старых видеокартах с 8+8 пин, площадь соединения большая и дорожки не греются. И возможно в этом одна из проблем нового коннектора. Соединение греется, ускоренно окисляется(золотые контакты уже не в моде), появляется разница в сопротивлении.

Физика очень интересный предмет, но если его пропускать - весь мир будет похож на сказку и вокруг будет много магии!

А, вот физическое окисление контакта, недостаточный обжим или избычтоный контактов, отклонение в позиционирование контакта/гнезда приводят к тому, что между контактами в линии меняется сопротивление и как следствие - начинается нагрев контактов.

Нагреваясь - повышается сопротивление, а электричество любит выбрать самое низкое сопротивление и как следствие ток пойдет в контакт с самым низким сопротивлением, что приводит к повышению тепловыделения и нагреву, а значит увеличению сопротивления.

Вот и ответ:

Чем ниже сопротивление одного контакта - тем больше на нем сила тока - тем сильнее тепловыделение - тем выше сопротивление - тем больше тепловыделение - тем больше сопротивление - тем ближе к оплавлению пластика.

Абстрактно это понятно. Но если не решать регулярно задачи с цепочками резистором, не очевидно, что из-за столь малых сопротивлений токи могут отличаться в разы. Взял, нарисовал схему и правда - никакой магии в мире :(

Ну вот смотрите, один провод нагревается и через него начинает течь меньше тока. Ток перетикает в менее нагретый провод, соотвественно менее негретый провод начинает нагреваться, а более нагретый провод - остывать, ну и таким образом происходит авто балансировка токов и нагрева :)

Если у вас провода подключаются отдельно, то вы правы.

В штекере провода подключаются единым корпусом и нагрев одного проводника приводит к нагреву остальных, что приводит к изменению сопротивления всех проводников.

Вопрос только в том, почему сопротивление одного контакта в разы ниже других, что бы пропустить как указано в статье гораздо больший ток, чем другие.

Меня удивляет, почему сторонние производители виедокарт на чипах nVidia сами это не исправят?

Они запаралелили все пины, так что если на одном из них сопротивление чуть больше (контакт плохой или был минимальный дефект) - то по нему ток течёт меньше, а нагрузка разделяется между остальными пинами. Если есть один со значительно меньшим сопротивлением - то почти весь ток потечёт к нему.

Даже не представить, что может заставить одни контакты пропускать больший ток, чем другие - разные линии питания и неравномерная нагрузка?

Допусков при изготовлении контактов разъёма и окислов достаточно, что бы на разных проводах объединённых в группу был разный ток с разницей в два и более раза.

Мне кажется, пора уже переосмыслить вообще стандарты подключения видеокарт в ПК. Во‑первых, отказаться от фишки с втыканием в материнку — четырёхслотовое трёхкилограммовое чудовище размером с клавиатуру просто просто выламывает её. И подпорка‑ножка в комплекте — это несерьёзно. Кто там шутил про советские микросхемы с ручками?

Видеокарта должна ставиться отдельно, причём иметь собственный изолированный впуск и выпуск воздуха, чтобы не выдувать свои киловатты (или сколько там будет в будущем) внутрь корпуса на все его компоненты.

И соединяться кабелем с материнкой. Вот как SSD постепенно вросли в материнку, отказавшись от всяких SATA проводов и дойдя до M2, так и видеокарта должна отпочковаться, став отдельной штукой на проводе. И да, я в курсе про райзеры. Но райзеры — это костыль.

Во‑вторых, пора в качестве стандарта в БП компов добавить 24 или даже 48 вольт. И пусть до видеокарты идёт один, ОДИН провод на 20 квадратов под напряжением 48 вольт. Ну и ноль ещё. Такой же толщины. А чего такого? Если посмотреть шланги любой СЖО, там примерно такая же толщина.

В моём представлении в корпусе ПК внизу на полу должно быть что‑то типа сокета. В нём и питание, и передача данных. И видеокарта на него ставится и защёлкивается. И прижимается к нему своим весом (сколько они там весить будут, килограмм сто?).

Корпорации вроде Nvidia вполне могут запилить и продвинуть такой стандарт — ресурсов им хватит.

Мне нравится ход ваших мыслей, полностью потдерживаю.

А раз будет отдельное устройство, то пусть вообще питается отдельно – от розетки. Зачем такие танцы с 48 вольтами и 20 кв. длинным кабелем?

Я имею ввиду как HDD, то есть она остаётся внутри корпуса ПК, просто не стыкуется с материнской платой, а прикручена к корпусу изнутри и соединяется с ней проводом. По типу радиаторов СЖО — они крепятся к корпусу, а не к материнке.

Я имел ввиду, что ваше предложение, это полумеры, смотря как развиваются с временем видеокарты. :)

Так уже есть

https://www.aorus.com/ru-ru/Keyfeature/805/

Осталось только засунуть туда 5090 вместо 1080

eGPU существуют уже давно, хоть и достаточно нишевые штуки. А так да можно было бы их популяризовать, для таких монстров как 5090, вижу только плюсы от этого

Это уже напоминает тогда Sega CD 32x...

Или решение попроще - выпкускать побольше видеокарт с водянкой. Большой и тяжёлый там кулер, сама плата не сильно выросла с времен когда АТИ ещё была компанией. А то смешно выходит - почти любая современная сборка охлажадет проц (лучший для игр 9800х3д жрёт не более 120 Вт) водой с огромным 360мм радиатором, а 600-ватная видеокарта охлаждается по-старинке, воздухом.

вода потом тоже охлаждается воздухом :-)

Вот кстати, почему не сделать для водянок охлаждение излучением? вывести наружу радиатор, покрасить черным - будет даже стильно. и поток воздуха сам конвекцией будет.

Площадь радиатора/теплообменника получится в пару квадратных метров.

не уверен, если честно. стандартные конвекторы центрального отопления имеют мощность что-то типа 200 ватт, но покрашены в белый, + температура теплоносителя там ниже (у меня в батарее до 60 градусов зимой поднимали судя по тепловизору в самые морозы, при этом температура самого радиатора была не такой чтобы высокой - можно было на него опереться спиной и греться, так что одной секции может и хватить (при росте температуры растет рассеиваемая мощность, причем нелинейно). Если что - это юмор. А квалификации посчитать - нет. Если есть студенты-теплотехники - то они могут развлечься.

Почему же не сделать?

Из серийно выпускавшихся знаю Zalman Reserator 1 (вроде бы три модификации было), Zalman Reserator 2.

Из "комплектующих для кастомной СВО" знаю Alphacool Cape Cora Konvekt HF.

https://youtu.be/iLHC2_gByQ8?si=JNZgKjWMP_il6Ind

Сделали =) Только вот получилось 30кг чудовище с ценником в 1к вечнозеленых (или в 2к, если брать медь). Да и тесты дают хоть и рабочие, но не особо хорошие температуры.

Бонус правильно сделанной СВО в просторном корпусе, помимо эстетики, хороших температур при низком уровне шума - весь горячий воздух выводится из корпуса. Мое имхо - больше видеокарт с изначально установленным водоблоком - хороший вариант. Не теряется гарантия, не платишь лишние 50-100-200 долларов за радиатор, который потом снимешь и в шкафу будешь хранить.

У Caselabs была хорошая концепция, которую вроде частично другие производители делали, но в широкие серии не пошло - раздельные секции, как в их SMA-8. В нижнюю секцию можно было установить 480 + 360. 240 вроде радиатор вместе с блоком питания. Все вентиляторы в одну сторону, радиаторы продуваются воздухом извне - и сразу его выводят из корпуса. А в основном отсеке достаточно 3-4 обычных тихих вентилятора на вдув \ выдув, чтобы охлаждать компоненты на материнке.

Ну там без помпы, это совсем жесть. Всё-таки если жижа не совсем самотеком будет течь, то поэффективнее будет охлаждение и нужно будет всего меньше. А так - прикольно )

UPD: посмотрел - там испарительная камера. ну тогда оно в принципе работает только на определенной температуре, и не факт, что такая дура сверху нужна. С жидкостью можно потоком регулировать.

Радиатор то ерунда, пригодится - а вот ватерблоки покупать под выидеокарту это ж бред. Они ведь одноразовые.

Зато свежим + площадь больше и продувается насквозь.

По сути GPU это уже компьютер в компьютере: свой процессор, своя память. Если решить вопрос подключения шины данных (нужен быстрый и помехоустойчивый интерфейс), то можно легко вынести. Так уже делают адепты eGPU, но там скорости и можщности не те. А в серверных так и вообще можно было GPU устанавливать в виде отдельного юнита.

ОДИН провод на 20 квадратов под напряжением 48 вольт.

да это же 4квт махина выйдет

Один чип Cerebras потребляет 15кВт.

ну извините меня, там чип по площади примерно в 60 раз больше чем на rtx5090, у такой махины в любом случае энергопотребление будет выше, да и никто никогда такой чип в домашний пк не поставит(слишком сложно отсеивать брак на производстве, его невозможно производить в больших количествах)

Не сработает. Резко упадёт скорость обмена данными с процессором и оперативкой компа. Наиболее вменяемый вариант - развернуть видеокарту до материнки, один хрен сейчас цена материнки в разы, а то и десятки раз меньше, чем у нормальной видюхи. То есть, покупаешь материнку с уже распаянной на ней 5090.

По какой причине упадёт скорость?

Скорость света + прочие такие штуки. Со своей стороны могу сказать, что можно дорожки от сокета процессора вести сразу вниз вправо к краю материнки, и там небольшой шлейф сделать до сокета видеокарты.

По длине будет даже меньше, чем когда карту через райзер втыкают. А если дорожки сделать оптические — даже быстрее может получиться.

Паразитные индуктивности в кабеле не убрать никак. Они не позволят выйти на нужные частоты.

В PciE разве есть какие-то механизмы снижения частоты при наличии помех?

PCIE трассируется на плате с соблюдением целой кучи требований. Попытка запихать эти же данные в кабель - приведёт к тому, что связи попросту не будет, пока тем или иным способом не будет понижена частота обмена. Например - переходом на более древний стандарт PCIE.

Не соглашусь, кабель гораздо легче защитить от помех, чем дорожки на плате, поэтому собственно есть как минимум два стандарта, "зпихивающие" Pcie в кабель: U.2 и Oculink, оба серверные, для подключения SSD в основном конечно, но согласитесь, там уже давно не древние стандарты тоже.

Тем не менее, особого распространения за пределами серверов эти стандарты не получили. Может быть потому, что уже PCIE 2.0 запихать в кабель становится сложнее и дороже, чем на плате сделать? Даже 10Гб Ethernet особого распространения не получил.

С ростом частоты слишком большую роль начинают играть паразитные индуктивноси. На 10 ГГц банальный небольшой изгиб кабеля уже начнёт создавать проблемы.

Реально, проще в видеокарту добавить слот под процессор и оперативку, и превратить её в своеобразную материнскую плату. К ней и радиатор можно бахнуть на весь форм-фактор ATX, и питание развести по человечески, и вообще

плюс к тому что написали - я купил как то удлинитель (райзер) разъёма для видеокарты, хотел её выносной сделать (корпус ПК был самодельный) так вот, длинна шлейфа 19 - см, вроде совсем не много, контакт хороший, комп включается, работает, всё нормально. Но как только заходишь в CS sourse, или любую игру с 3D, то фпс где то в районе 5-10 был. Ставишь видеокарту напрямую - всё летает 90 фпс.

.Скорее просто райзер попался такой, я видел продают райзеры просто на плоском шлейфе, вообще не понятно, как оно такое должно работать, да. У меня уже несколько eGPU было на окулинке и китайском переходнике с м 2, падение производительности только за счёт того, что там 4 линии вместо 16, а так - 50см вообще без проблем работает по стабильности и производительности. Ну и собственно как я выше говорил, окулинк это серверный стандарт, не стали бы в серверах использовать нестабильные решения. Именитые производители не берут себе окулинк на ноутбуки только потому, что там нет горячего подключения и других фишек юзерфрендли интерфейсов типа Тандерболта

Перейдем на оптику

Во‑вторых, пора в качестве стандарта в БП компов добавить 24 или даже 48 вольт. И пусть до видеокарты идёт один, ОДИН провод на 20 квадратов под напряжением 48 вольт. Ну и ноль ещё. Такой же толщины. А чего такого? Если посмотреть шланги любой СЖО, там примерно такая же толщина.

Там явно просится что-то вроде PoE/PD. Сопротивление провода кстати легко мониторится. И на основании мощности БП и сопротивления провода карта выставляет powerlimit. И это надо было сделать еще когда появился отдельный разъем питания на проц.

Но и без всего этого моделисты уже многог лет имеют дело с токами по 200-300А. При том разъемы у них в разы компактнее.

Вообще такое ощущение что у них питанием ардуинщики занимаются.

Тут не надо ничего представлять - разное сопротивление линий без их балансировки со стороны потребителя.

Сопротивления проводов и контактов достаточно для балансировки при условии параллельного включения. И контакт с повышенным сопротивлением будет естественным образом разгружаться. Тут явно какая-то принудительная дисбалансоровка.

"Корпорации вроде Nvidia вполне могут запилить и продвинуть такой стандарт — ресурсов им хватит."

А заодно и с воздушными потоками разобраться, а то в текущем виде горячий воздух просто перемешивается кулерами видеокарты внутри корпуса.

Ну у вас же есть вдув-выдув, чтобы этот горячий воздух из корпуса выносить?

Карты, которые выдувают сразу назад, гораздо шумнее, геймеры не хотят брать

Физику фиг обманешь.

Тихая видеокарта это 3 слотовая железка.

А это дорого в изготовлении.

Юзеры не хотят больше 2 слотов занимать видеокартой.

Что намекает на некоторую непроработанность концепции. Для успешного протягивания всей массы нагретого воздуха корпусным вентиляторам недостаёт статического давления, к тому же видеокарта дамбой перегораживает этот поток, в результате о каком-то осмысленном теплоотводе речи не идёт, КМК. Для сравнения - одного не слишком производительного вентилятора хватает на охлаждения киловаттного БП, питающего компьютер, в котором может быть установлено ещё с десяток вентиляторов!

Пока существенного прогресса в снижении тепловыделения полупроводников не предвидится, как и в вовлечение в полупроводниковое производство более термостойких полупроводников.

А ведь индустрия не собирается останавливаться на достигнутом (энергопотреблении).

Уже сейчас игровой компьютер оснащён 300 Вт процессором и парой таких же GPU, скоро нормой must have станет установка отдельного прожорливого NPU. Киловаттные БП перестали быть чем-то экзотическим, а их КПД пока никто не торопится массово повышать сверх 80-90%.

Если крупный кулер-башня охлаждает процессор лучше стокового, значит и видеочип нуждается (или скоро будет нуждаться) в таком охлаждении. Башня продувается насквозь, в отличие от непродуктивного взбивания горячего воздуха вокруг перегретого чипа. А это приведёт к изменению форм-фактора видеокарты - она уже давно переросла формат дочерней карты и в механическом, и энергетическом, и в смысле сложности реализации (своя продвинутая ОЗУ, широкая шина, своя подсистема питания,...).

Видеоускорители появились во времена процессоров вменяемого энергопотребления, но на данный момент обогнали их по аппетитам и требуют к себе соответственного отношения.

Альтернативой КМК может быть новая модульная конструкция ПК, где полностью пассивная материнская плата будет выполнять только функции интерконнекта, а остальные элементы будут группироваться вокруг соответствующих ключевых элементов, формируя модули универсального форм-фактора. На одних - CPU+ОЗУ+необходимая логика, на других GPU+ОЗУ, на третьих NPU+ОЗУ, NextGenAccelerator+ОЗУ...

Попутно не забываем разрабатывать новые, более скоростные интерфейсы.

PSU выполняем в таком же форм-факторе. Во все силовые преобразователи (PSU, VRM) не скупимся ставить драйверы идеального диода, тем самым увеличивая КПД и в разы уменьшая тепловые потери на силовых элементах и сопутствующий нагрев.

Далее модули собираем в пакет исходя из желаемых скоростей/задержек интерконнекта, а также тепловыделения, чем горячее - тем дальше.

И получаем ... форм-фактор майнера - удлиннёный квадратный в сечении корпус, продуваемый парой вентиляторов. С хорошим фильтром на входе, иначе всё быстро порастёт пылью.

Примерно такая же конструкция используется в мощных звуковых усилителях.

И главное - используя новые костыли компьютеры активно занимаемся разработкой следующего поколения, ибо складывается впечатление, что дальше разгонять имеющуюся технологию некуда. Нужны либо новые полупроводниковые материалы с меньшей шириной запрещённой зоны (привет, токи утечки), либо напротив с большей (GaN, SiC...) и большими напряжением питания/нагревом, но спокойно переносящим более высокие температуры.

Всё это требует огромных затрат на разработку, стандартизацию и вывод на рынок.

Жидкостное охлаждение КМК так и останется нишевым, тепловые трубки и модные vapour chamber также, ибо не лечат болезнь, а маскируют симптомы.

одного не слишком производительного вентилятора хватает на охлаждения киловаттного БП

Там рассеивается не вся выдаваемая мощность, а только 1-кпд*потребляемая мощность, т.е. гораздо меньше.

Так ведь и дальше происходит тоже самое? Видеокарта же не рассеивает 500Вт?

Вот именно что рассеивает.

Киловаттный БП с кпд 80% на максимальной своей мощности потребляет из силовой сети 1250 Ватт, из которых 250 рассеивает на себе, переводя эту часть во внутреннюю энергию (тепло), а 1000 Ватт отдаёт в виде электрической энергии. Если взять 80% от 1250, получится 1000.

500-Ваттная видеокарта на максимальной своей мощности потребляет 500 Ватт и никуда ни в каком виде энергию дальше не передаёт, всю эту энергию она рассеивает на себе в виде тепла.

Или она куда-то ещё какую-то часть полученной энергии передаёт?

Всё уже придумали, проблема в скорости шины, это сразу становится горлышком. Видеокарта это такая тварь, которая требует не только много питания, но и много шины. Я бы сказал что видеокарты в потребительских ПК - основной потребитель ширины PCI Express, по сравнению с которым всё остальное (SSD, USB/TB) это слёзы.

Если производители перестанут выжимать с железа последний гигагерц кажется процентов 90 проблем исчезнет. Снизить все частоты процентов на 25, а с ними и напряжения и столько проблем не станет - охлаждение, радиаторы, сложность схем питания, необходимость в мощных электронных компонентах, блоках питания, вентиляторы, компоновка внутри корпуса, учет распределения тепла от процессора и гпу по мат.плате в её дизайне, шум, потребление электроэнергии в мире и если подумать можно ещё продолжать. Особенно раздражает что любой ноутбук начинает шуршать кулером, помню когда интел 2-ядерный haswell в планшет с пассивным охладом засунул с частотой 1.6. Я решил что настает время эффективной вычислительной техники. А нет - скоро в смартфонах вентиляторы будут кажется. Все выжимают максимум

Всем нужно соревноваться с конкурентами в попугаях на доллар. Удивляет, что зеленые не поднимают тему ограничений на мощность видеокарт или системы в целом. Сидишь под энергоэффективной лампой с энергоэффективным монитором и потребляешь 500+ Вт для игр. Как будто не замечают этой точки приложения силы)

Уже!

В некоторых странах зелёные продавили стандарты на ограничение потребляемой мощностью личным ПК.

В т.ч. игровыми ПК.

Это уже на идиократию похоже. Тот момент когда конкурент - здравый смысл. Как будто только герцы можно продавать, а остальных параметров не существует

Меня кстати это тоже удивляет почему все не замечают потребления домашних пк, давно заметил

скоро в смартфонах вентиляторы будут кажется

Только не лопастные, а ультразвуковые. Которые 2 года как существуют (но пока массово не применяются, хотя уже кое-где встраивали).

Вот такие: https://habr.com/ru/news/776860/

А лопастные отдельным модулем и сейчас продают.

Так это выбор не производителей, а пользователей. Есть же масса моделей которые не выжимают этот последний гигагерц и обладают скромными аппетитами. Ну банально вместо 4090/5090 взять хотя бы 4080/5080/ Radeon 9070 и вот уже уложитесь в безопасные 350Вт. Ну и дальше простор для снижения энергопотребления огромен вплоть до ноутов и компактных ПК и вплоть до пассивного охлаждения. Мой ноутбук например при обычной работе вентилятор вообще не включает и вообще не греется он тупо холодный.

Рынок предлагает выбор на любой вкус и в статье и в комментариях речь исключительно об очень узкой нише тех, кто готов терпеть огромное тепловыделение ради топовой производительности.

Интересная интерпретация.

Но нет, пользователи просто хотят производительность и их особо не волнует как. Когда то было нормальным что процессору достаточно радиатора и можно было просто не создавать тренд с активных охлаждением.

Самое то глупое что гигагерцы дают наименее эффективную прибавку производительности. Потребление линейно зависит от частоты, и квадратично от напряжения. Частота требует соответствующего напряжения(линейно). Получается уже зависимость в 3-ей степени. То есть если даже снизить частоту на 10% то получим потребление 0.9^3=0.729 - более чем на четверть меньше. Если бы на протяжении всей временной линии максимальные частоты цп и гп были на 10% меньше быть может всей этой статьи(и ей подобных) с комментариями не было бы.

Но идем дальше

Есть что то ещё

Посмотрите как зависит потребление 1 ядра от частоты

https://www.anandtech.com/show/16214/amd-zen-3-ryzen-deep-dive-review-5950x-5900x-5800x-and-5700x-tested/8

Больше похоже на 4-ю степень. Кто-то писал что на самом деле зависимость в 4-ой степени, я не уверен почему.

Ну и если ещё чуть чуть пожертвовать долей перфа - хотя бы 15%

0.85^3=~0.615

И на более оптимистичный случай

0.85^4=~0.523

Производители могли верхнюю границу сделать чуть ниже и не задавать нелепые тренды на видеокарты размером с пк

Не все пользователи, а очень небольшая их часть. Топовые процессоры, что центральные, что графические - это единичные проценты рынка.

Самая популярная видеокарта в Steam например - это 3060 и первые 15 позиций в топе это разные вариации x60, x70 и встроенной графики.

Первая видеокарта x80 - 3080 появляется на 17 месте с долей 1,84% и дальше идет еще 11 позиций х50, х60, х70 и встроек, дальше 4090 с долей 0,91% и еще пять позиций x50, x60, x70 и встроек.

И это в игровом сервисе среди игроков. Среди обычных людей доля разных встроенных в процессор видеокарт будет в районе 80-90%, а все отдельные игровые - это оставшиеся 10-20% среди которых как выше написал процентов 95 это решения серий x70 и ниже.

>Производители могли верхнюю границу сделать чуть ниже и не задавать нелепые тренды на видеокарты размером с пк

Так они это и делают - в более дешевых и менее производительных моделях.

Те кто этого хочет - те и покупают холодные, компактные и маложрущие карты. И это подавляющее большинство.

Видеокарты размером с ПК - это узкая ниша специально для тех кто хочет именно такие видеокарты.

Крикливое меньшинство против молчаливого большинства, как говорят в англоязычном интенете.

Я все это понимаю. Я лишь указал на то что и этих процентов бы не существовало будь верхняя граница частоты чуть меньше и что буст частот вообще зло

Сам тренд на частоты есть, везде он просматривается.

Зачем мне в ноуте турбобуст до 4.5Ghz я вообще не понимаю.

Чтобы что - в максимальной нагрузке на долю секунды что-то ускорить?

Типичное поведение

Я хочу выполнить задачу которую он будет выполнять часы как ни крути

Вот я им пользовался, что-то простое делал. И включил нагрузку

Зашумел кулер

Частоты сползли вниз

Кулер стал тише, приемлемый уровень

Температура опустилась до момента на котором снова тригеррится турбобуст.

Снова шум

Цикл

Вот это всё зачем вообще?

Можно же не выжимать до 4.5Ghz

У меня был планшет cube mix plus с core m3 7y30

У него предел был 2.6Ghz. Он его не держал конечно

Я вскрыл и сделал что называется термомод.

Медный квадратик подточил под нужную толщину и положил на чип. Крышка у планшета металл, и между крышкой и cpu был воздух.

Получился отличный девайс. Крышка стала теплой.

Я эту точку запомнил

kaby lake 2x2.6Ghz работают на пассивном охладе

Если ещё нагрузить остальное - подсистему памяти и gpu потребление поднималось до 12W. Лишь только частота ядер до 2.4 падала и на них держалась стабильно сколько угодно. Температура по aida64 не более 85

Затем я взял не помню что на Intel Core i5-1035G4, как обычно без dgpu

О нагрузке на igpu даже речи нет.

Винт работает всегда. Отключается он если прям рабочий стол оставить и не трогать

Что ни делай - турбобуст, шум ... и весь этот цикл, только даже сильно нагружать не приходится. Частоты прыгают туда сюда как не в себе

Андервольтинг на интелах теперь не сделать, спасибо CVE с регулированием напряжений

Да, последние модели типа core ultra и ryzen ai не проверял. Но смотрю я на их частоты и кажется что тоже самое

core 5 120u up to 5Ghz

amd 7320u up to 4.1 GHz

Ну и где мне взять fanless ноутбук(мне x86 к сожалению пока нужен чисто как isa) который будет при максимальной нагрузке просто приемлемые частоты держать?

Держим в уме что kaby lake 2x2.6Ghz мог работать пассивно на 14nm

Пока проценты всех gpu составляют раскочегаренные gpu, в ноутбуках наоборот - попробуй найди холодный в нагрузке ноут

Либо брать совсем что то простое типа n100, либо берешь "нормальную" архитектуру, но на нормальных частотах тебе ей воспользоваться не дадут - получи в подарок over super turbo speed shift ai-driven turboboost must have

Фанлесс ноуты есть у всяких китайцев на али. Правда проц там будет что-то типа N4400 или чуть лучше. У меня такой комп был, отличная машинка, особенно если сделать термомод как у вас. Тогда будет держать верхнюю планку частоты процессора, не снижая. Но работать на таком не выйдет, только серфинг-ютуб-кино.

Сама Нвидиа ещё пытается делать карты разумных размеров, а партнёров давно унесло и первоапрельская штука от CaptainsWorkspace стала явью:

https://x.com/aorus_es/status/1895821906848428201

Честно говоря, делать отдельный корпус для видеокарты вне системного блока сейчас — слишком громоздко и неудобно для большинства юзеров, да и выглядит не особо лаконично(не ставить же его на системный блок или просто на пол), плюс надо искать для него место на столе. Соглашусь, что пора отказаться от «втыкания» карты прямо в материнскую плату и все таки, райзер нам тут сильно поможет.

По моему мнению, производителям корпусов стоит переосмыслить внутреннее пространство: создать отдельную площадку для видеокарты, которая позволяла бы ей работать на выдув. Так весь горячий поток воздуха не будет крутиться внутри корпуса.

Со своей стороны, производителям видеокарт стоит задуматься о смене дизайна: переместить лицевую(там всякие подсветки и логотипы) часть на заднюю сторону. Так мы сможем использовать карту в конфигурациях с активным выдувом, сохранив при этом обычный внешний вид.

Красивое. Не подскажите, что там за райзер такой супердлинный? Мне бы тоже не помешал.

Честно говоря, делать отдельный корпус для видеокарты вне системного блока сейчас — слишком громоздко и неудобно для большинства юзеров, да и выглядит не особо лаконично(не ставить же его на системный блок или просто на пол), плюс надо искать для него место на столе. Соглашусь, что пора отказаться от «втыкания» карты прямо в материнскую плату и все таки, райзер нам тут сильно поможет.

Имхо, лучший вариант — не прямо отдельный корпус, а отдельный отсек. Как в корпусах делают сейчас для БП.

В среднестатистическом компе три источника тепла: процессор, видеокарта, блок питания. В идеале каждый из них должен иметь свой изолированный отсек с отдельными впуском воздуха и выпуском. Совсем в идеале — впуск снизу, выпуск — сверху.

У меня используется райзер от Lian Li длиной 380 мм, но если видеокарта будет расположена, как у меня, вертикально, то лучше использовать райзер подлиннее 600mm PCI-e 4.0 riser cable, чтобы его можно было провести через заднюю стенку. Так пропадут «лишние» провода с лицевой части :)

А насчет Вашего примера с вдувом и выдувом, есть один момент. Для этого требуется очень большой и длинный корпус, где смогут разместиться как минимум 7 вентиляторов 120мм (3 для GPU и 3 для CPU, ну и один для БП, это если рассматриваем большой теплоотвод) в верхней базе. Поэтому, кажется, что оптимальное базирование охлаждения для CPU - сверху, для GPU - сбоку и для БП - так же сбоку.

У меня используется райзер от Lian Li длиной 380 мм, но если видеокарта будет расположена, как у меня, вертикально, то лучше использовать райзер подлиннее 600mm PCI‑e 4.0 riser cable, чтобы его можно было провести через заднюю стенку. Так пропадут «лишние» провода с лицевой части:)

Спасибо! Жаль только, что он PCI‑e 4. Я хочу попробовать её на ребро поставить, чтобы разъём был сверху. Как у Вас ставить, пожалуй, не буду, т.к. опасаюсь перегрева и падения скорости.

А насчет Вашего примера с вдувом и выдувом, есть один момент. Для этого требуется очень большой и длинный корпус, где смогут разместиться как минимум 7 вентиляторов 120мм (3 для GPU и 3 для CPU, ну и один для БП

Если мне не изменяет память, есть квадротичная зависимость эффективности вентилятора от его диаметра. Если так — можно просто обойтись двумя 140 мм вентиляторами на отсек, стоящими поперёк.

Плюс тут эффективность охлаждения будет гораздо выше: воздух входит всегда холодный, уже нагретый не пропускается по нескольку раз через компоненты + радиаторы имеют намного большую площадь. Поэтому, мне кажется, такая схема вполне рабочая. Тогда корпус будет в ширину 280 мм, в длину 420 мм, что вполне себе ок.

При тестировании своей собственной RTX 5090 FE под нагрузкой Роман обнаружил, что из шести 12-вольтовых проводов один почему-то нагружается гораздо сильнее остальных.

А есть кто-то, кто бы более профессионально описал эту ситуацию? Провод, который "нагружается гораздо сильнее остальных" у человека, знакомого с законом Ома вызывает лёгкий когнитивный диссонанс.

Вместо нормальных 6-8 ампер через него проходило более 22!

Если разъем поганый, с оксидной пленкой на контакте, а на видеокарте по 12 вольтам собран источник тока - так и должно быть.

Поганый контакт ограничивает ток за счёт оксидной пленки на нем, а плата пытается все равно получить из источника питания требуемую мощность. Ток - растет, а лишняя мощность выделяется на непропае|окисленом контакте в виде тепла.

Это приводило к тому, что температура в месте соединения с блоком питания достигала 150 градусов Цельсия всего через четыре минуты работы под нагрузкой.

Ключевая фраза - "в месте соединения". Т. е. Nvidia права и надо кабель менять либо разъем на плате пропаять.

Или просто кривая схема питания самой видеокарты, которой нужно, чтобы весь ток шел по одной жиле...

Поддерживаю. Всё равно питание разведено по отдельным каналам, почему нельзя было их контролировать и ограничивать по токоотдаче, непонятно. Скинули всё на кривой автобаланс, который как качели с подвижным центром тяжести. Стоит только начаться его смещению и рано или поздно ситуация приведёт к оплавлению разъёма.

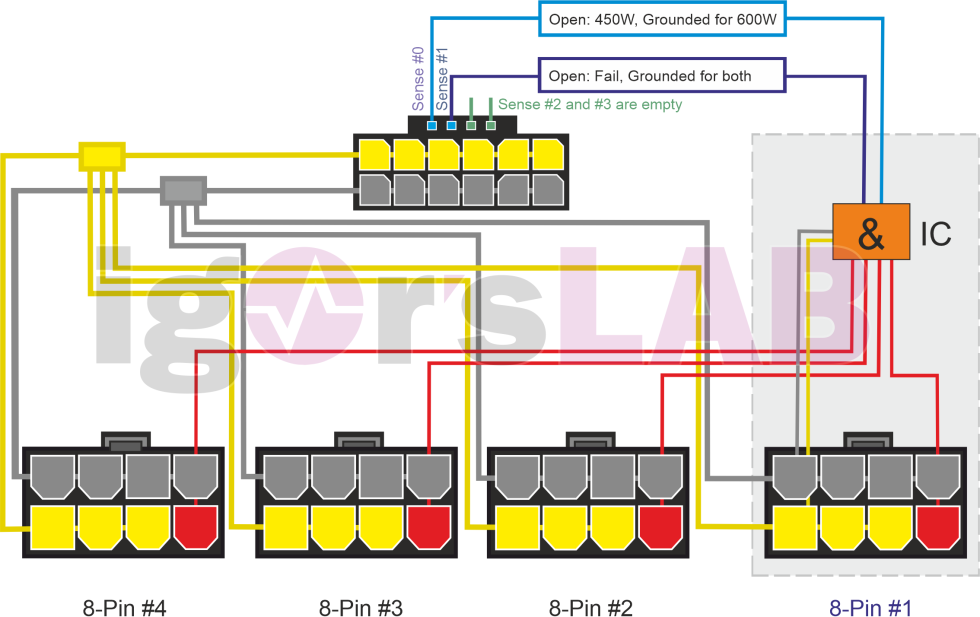

Так там и нет никакой балансировки. В 3090Ti была группировка по 2 провода, вроде. У RDNA4 по 3 провода. А тут ... А тут вообще фиолетово, запараллели 6 проводов одной линии без какого либо запаса по мощности - "и так сойдёт" (с)

Да похоже что те кто проектировал новый разъём, прогуливали физику в школе.

На тестированиях всё было нормально, ведь там условия близкие к идеальным, но те кто делал выводы из тестов, забыли про то что реальность не идеальна.

Это как с клавиатурой бабочкой Эппл. На тестах всё было идеально, но реальность оказалась слишком суровой для проектировщиков.

Тогда бы провод грелся наравне с разъемом.

При токе 20А на 1м провода сечением 1.5 мм**2 выделяется 4 Вт мощности.

Это - не бог весть сколько.

А длина кабеля - сантиметров 30. Т. е. около 1 Вт.

Так что виноват разъем и только разъем....

Этому "экспериментатору" взять бы мультиметр и померить падение напряжения на проводе, по которому течет ток 20А. Один щуп на дорожку 12В на блоке питания поставить, а второй - на дорожку 12В - на плате видеокарты.

А потом - разделить измеренное напряжение на измеренный ток.

И таким же образом поступить с другими проводами, где 6-8А.

"Метод вольтметра-амперметра" называется.

Тогда станет ясна причина разных токов.

А так его "измерения" - просто "цирк с конями"...

Там не только разъем греется, но и провода.

Вообще говоря, при перегреве разъемов провода тоже греются, за счёт теплопередачи

Там не только разъем греется, но и провода.

Судя по картинке там примерно 40-50° температура на проводе.

Что для 1 Вт на 30 см - нормально.

Нужно реальное сопротивление между платами померить. У "плохого" провода и сравнить его с "хорошим".На сопоставимом токе. Не омметром.

Если сопротивление отличается - значит "виноват" провод с разъемом. Если одинаковое - причина в БП или видеокарте.

Хорош уже. Потребитель или источник должны быть защищены от такого сценария, раз уж в параллель кинули 6+6 проводов на нагрузку. А то провод виноват, пины, кто угодно ... Что теперь, кабеля из палаты мер и весов выпускать, да при подключении чистить и контактной пастой обрабатывать (а заодно и разбирать, пропаивать) пины?

Хорош уже. Потребитель или источник должны быть защищены от такого сценария, раз уж в параллель кинули 6+6 проводов на нагрузку. А

Парень, о котором речь в статье, - типа "разобрался".

А по факту - опубликовал какие-то "Веселые картинки" и сделал выводы "от фонаря".

Есть ведь стандарты на сечение провода для того или другого тока.

Для 20А - 1.5 мм**2 вполне допустимо, как и долговременная температура 45°.

Переходное сопротивление разъема тоже нормируется.

Тем более, что проблема известная и для RTX 5xxx выпустили кабель с новым разъемом 12VHPWR.

У него длина, а значит и площадь контакта вдвое больше. А значит - переходное сопротивление - меньше.

Или Рукожопии Михалычи ставят "незачет" Нвидии, потому что спаянные в китайском гараже кабели греются и обгорают?

Если переходное сопротивление разъёма нормируется с допуском в четыре раза между минимум-максимумом (а это вполне нормально), то на предельных мощностях токи тоже будут в три четыре раза между проводниками различаться. Что мы имеем. Сделать разъём, у которого сопротивление нормируется в очень узком диапазоне, это та ещё задача. И её, кстати, нельзя решить в бытовых условиях, так как там нужна чистка и обработка разъёма при перестыковке. И конструкция пина там тоже очень сложная получается.

Ну, перепаять на клеммы "под винт". Колхоз, но если хочется играть...

Ха! И нужно будет шайбы и гроверы подкладывать и с нормированным усилием затягивать. В шаловливых руках пользователя гореть будет пуще прежнего.

Ну, вы, блин, даете ))

Нормальные клеммы в сборе, например, Degson DG127-5.08: по IEC 15А/250В, по UL 300В/12А (не спрашивайте, что за стандарты, не знаю). Да, есть нормированный момент затяжки. Но я не смог сорвать винты, а затянул крепко, будьте уверены )) (там уже разъем чуть разворачивать в отверстиях платы начало)

Мне так ка-а-ца, что "прижатые к друг другу" контакты завсегда меньше могут, чем "прижатые винтом". Впрочем, может кто-нибудь и попробует, и отпишется.

Вот, к удивлению узнал, С-образный держатель самого распространенного типа предохранителей-стекляшек 5*20 может только до 6 ампер.

Если разъем видеокарты похож на разъем ATX материнской платы, то глядя на piouts.ru, это MOLEX 44206-0007, у которого между пинами расстояние 4.2мм, а между рядами 5.5мм. Тогда можно попробовать "приколхозить" разъем DG350R-3.96-02P: набрать три двухполюсных в один ряд и такие же три в другой, развернутых на 180°. Итого будет 12*10А=120Аmax. А в блоке питания провода припаять напрямую в плату.

Ха! И нужно будет шайбы и гроверы подкладывать и с нормированным усилием затягивать.

(разглядывая Wago) Ну зачем же вручную заставлять? Надо подпружиненные. Вилку в разъем воткнул (без натяга и чертыхания - все еще свободно входит), рычажок опустил - и все крепко сидит.

перепаять на клеммы "под винт".

И будет как-то так:

Если переходное сопротивление разъёма нормируется с допуском в четыре раза между минимум-максимумом

Откуда инфа?

Кто-нибудь замерил сопротивление провода и разъемов на 20А?

Никто же эту работу не сделал.

В чем причина локального нагрева соединения в районе разъема как на веселой картинке показано?

Кто-нибудь взял на себя труд разобраться?

Но Нвидию пинать и о колхозах порассуждать разглядывая картинки - достаточно охотников.

Хотя Нвидия вопрос решила.

Рукожопии Михалычи тоже могли бы его решить.

Желтенькие провода с сечением 2.5 мм**2 и разъемы этого типа бОльшей высоты вполне себе доступны. Закажи и поменяй, раз ты такой крутой, что даже пирометром фоточек нащелкал...

Если переходное сопротивление разъёма нормируется с допуском в четыре раза между минимум-максимумом

Где это написано?

На заборе гаражного кооператива?

Переходное сопротивление в Омах нормируется. Для силовых разъемов вроде бы 0,005 Ом должно быть .

При токе 20А мощность, выделяемая на контакте 20**2 * 0,005= 2Вт.

А по факту сколько сопротивление контактов и провода кабеля?

Кто-нибудь взял на себя труд это выяснить?

Или проще на картинки глядеть и о колхозах рассуждать?

А вот насчёт контактной пасты -- хорошая идея, ИМХО. Тёртое медно- или серебро-графитовое наполнение на какомнть нейтрально-гидрофобном связующем, например.

Судя по левому скрину, в основном нагрузка идет через два провода. При этом тока через провод достаточно, чтобы перегреть контактную группу в разъеме видеокарты. Однако, в современных блоках питания в самом блоке питания эта группа проводов также подключена через разъем. И через контактную группу разъема блока питания проходит точно такой же ток... Но что-то я не слышал о глобальной проблеме с разъемами в блоках питания. Может, дело всё же в контактах???

Кажется, я прогуливал физику в школе - разве можно измерять силу тока на одной жиле токовыми клещами при питании постоянным током?

Существуют токовые клещи, способные измерять не только переменный, но и постоянный ток. В таких клещах принцип их работы основан на эффекте Холла, когда параметры тока выводятся из параметров порождаемого им магнитного поля, воздействующего на полупроводник и инициирующего в нем эффект Холла.

На переменном токе - обычный трансформатор, на постоянном - датчик Холла.

В косячном потреблении питания конечно дело. Такие перегрузки не могут быть объяснены просто оксидной пленкой. Просто кто-то накосячил в распределении питания на карте.

Исключено, там на печатной плате к разьёму идут две толстые дорожки, а в разьеме уже ток разводится по разным жилам. Если сопротивление одного контакта чуть выше - по закону Ома ток по нему меньше, а на остальных - больше.

А есть кто-то, кто бы более профессионально описал эту ситуацию? Провод, который "нагружается гораздо сильнее остальных" у человека, знакомого с законом Ома

Так именно законом Ома это и объясняется.

Когда сопротивление самого провода 0.1Ω, и сопротивление контакта 0.05Ω (с каждой стороны), погрешностью изготовления провода пренебрежём (а она есть), а вот погрешность сопротивления контакта допустим даст результат ещё 0.05Ω. Тогда на каких-то проводах будет общее сопротивление 0.2Ω, а на других — 0.3Ω. Учитывая, что шунты нжидия старательно изводит, получается что падение напряжения на всех линиях будет одно и тоже, а значит ток на них будет отличаться в полтора раза (или больше, при других вводных, например пыли в контактах, или действительно некачественных проводах).

Как будет отличаться ток при наличии шунтов по 0.1Ω можете посчитать сами.

Кроме закона Ома было бы так же неплохо вспомнить закон Джоуля-Ленца. P = U²R и температурную зависимость удельного электросопротивления r = r0·(1 + aT). Соединив все вместе получится, что высокий ток приводит к нагреву контакта в разъеме, его удельное (и не только) электросопротивление растет, что приводит к большему падения напряжения на нем и увеличению тепловыделения, что приводит... ну Вы поняли. Кстати, упомянутые тут кем-то 130 °С на разъеме - это температура усредненная. На самой контактной площадке точечно может быть и больше 250 °С.

закон Джоуля-Ленца. P = U²R

Для цепи постоянного тока:

ибо, в данном случае, удобнее говорить о выделенной энергии за время t, а не о мощности (нагрев обусловен именно выделением энергии за время, а не мощностью как таковой, собственно, классическая формулировка закона Джоуля-Ленца именно о тепловом действии тока, т.е. энергии). Ну и в формуле вы ошиблись, как я выше показал:

Да. Разделить. Позорище. Засыпался пеплом...

Ничего, измерители скорости строительства электростанций ещё глубже лежат.

Ну тут немного не так, ведь греется не тот провод у которого высокое сопротивление, а как раз тот у которого низкое) т.е. там где контакт по какой то причине оказался лучше остальных а не хуже.

Не с этого нужно начинать. А с того, чем для видеокарты является блок питания: источником тока или напряжения.

Если первое, то чем больше сопротивление, тем хуже, если второе - наоборот.

Про шунты я обсуждение не понял, но в силовой электронике решений по балансировке параллельной нагрузки хватает.

Могу путать за давностью лет, но вроде как биполярные транзюки-ключи на один радиатор вешать нельзя, коэффициент передачи по току имеет положительную зависимость и самый "крутой" начнёт на себя тянуть ток, сгорит, остальные скачком получат прирост тока и поехали доминошки.

А с полевыми вроде как всё наоборот. Только надо ток через транзюк в напряжение на затворе перевести.

В общем, грешить на неравномерность в параллельных питающих проводах какая-то дичь. Это входное условие для проектирования, а не требование для обеспечения работоспособности.

А с того, чем для видеокарты является блок питания: источником тока или напряжения.

Если первое, то чем больше сопротивление, тем хуже, если второе - наоборот.

По идее источником напряжения, с верхним лимитом по отдаваемому току линии.

в силовой электронике решений по балансировке параллельной нагрузки хватает.

Проблема в том, что на 4080/4090/5080/5090 этих решений мы не видим

Могу путать за давностью лет, но вроде как биполярные транзюки-ключи на один радиатор вешать нельзя, коэффициент передачи по току имеет положительную зависимость и самый "крутой" начнёт на себя тянуть ток, сгорит, остальные скачком получат прирост тока и поехали доминошки.

А с полевыми вроде как всё наоборот.

Все так, с ростом температуры биполяры увеличивают проводимость => больше греются ввиду больших токов => увеличивают проводимость => …

Полевики с ростом температуры наоборот проводимость снизят

Но я не думаю что там много будет биполяров, у нас засилье КМОП

А есть кто-то, кто бы более профессионально описал эту ситуацию? Провод, который "нагружается гораздо сильнее остальных" у человека, знакомого с законом Ома вызывает лёгкий когнитивный диссонанс.

Вся ситуация с историей как нвидия постепенно факапила питание на своих картах в этом видео достаточно подробно изложена.

Т.к. зумерам непонятен устаревший фразеологизм экономия на спичках, то

Nvidia дала им современную версию:

разъем питания для 5090.

В этой схеме больше всего тепла будет выделяться на том контакте разъема, сопротивление которого будет самым близким к сопротивлению провода.

эта схема нарисована апологетами кривой NVIDIA.

А если внимательно почитать автора, то он всё-таки обвиняет провода и блоки питания.

> Казалось бы, к выходу RTX 50 все должно было измениться. Компания заявила, что новый улучшенный разъем 12V-2×6 полностью решает проблему.

> Однако реальность оказалась иной.

> Не использовать свои старые кабели 12VHPWR, изготовленные до 2025 года

> Подбирайте блоки питания для компьютера в соответствии с калькулятором

Реальноть не оказалось иной.

Реальность оказалось той же самой. Нельзя использовать блоки питания, если сопротивление проводов ужасно большое - в китайских проводах почти нет меди. Там или железо или алюминий с небольшим слоем чего-то рыжего на поверхности. Горели горят и будут продолжать гореть, потому что они окисляются.

И 150С не проблема, если медный провод прижат пружиной. Но там нет ни пружины ни меди.

Наоборот, тонкие провода (если они все одинакового сечения) послужат выравнивающими резисторами.

Как сказали несколько человек ниже, самый коварный разъемный контакт отнюдь не худший, а лучший по сопротивлению, так как на нём будет выделяться наибольшая мощность. Это и на моей схеме видно.

Хорошие провода только усугубят проблему, т.к. основной точкой выделения мощности будет самый лучший контакт разъёма. Который не рассчитан на такой ток.

Тут напрашивается колхоз, как дешево и сердито предупредить проблемы малой кровью:

Взять 6 резисторов сопротивлением 0.05 Ом в корпусе TO-220, повесить их на один радиатор.

Для рассеивания 20-30 Вт достаточно ребристого радиатора от ssd, просверлив 6 отверстий. Резисторы впаять в разрыв 12-вольтовых проводов, идущих к разъему видеокарты, чтобы выполняли роль шунтов.

Если у меня будет 5090, то так и сделаю. Стоимость шунтов по сравнению со стоимостью этой видеокарты - копейки.

Как выравнивать токи по нулевым проводам, я не знаю, там мешает дополнительная нешунтированная цепь через материнку.

Провод, который "нагружается гораздо сильнее остальных" у человека, знакомого с законом Ома вызывает лёгкий когнитивный диссонанс.

Я знаком, у меня не вызывает. 12 Вольт и 300Ватт- P=UI=U^2/R => R=P/U^2= 300/144= 2 Ом. полное сопротивление входного тракта карты- всего 2 Ома. сопротивление проводов должно быть ну раз в 20 меньше, иначе в проводах будет рассеиваться больше 20 Вт тепла, то есть, сопротивление проводов должно быть не больше 0,1Ом. при таком сопротивлении любая грязь, пыль, следы пальцев или оксидная пленка на контакте будут давать существенный разброс в полном сопротивлении отдельных проводников в жгуте, и если после жгута их контакты объединены в один общий- то и кратные разбросы в токах, протекающих через отдельные провода жгута тоже обеспечены. и даже просто небольшое снижение сопротивления отдельной линии в жгуте будет приводить к тому, что ток через нее будет возрастать, а так как тепловыделение провода- те же самые U^2/R (только уже не входного тракта карты, а падение напряжения на проводе- одинаковое для всего жгута и сопротивление самого провода- разное для разных контактов в жгуте)-, то снизив сопротивление одного проводника на 20% (как бы улучшив его характеристики!) мы получим увеличение выделяемого на нем тепла на те же самые 20%, но прикол в том, что при таких малых сопротивлениях легко можно получить разброс и в 50%. То есть, проблема может быть не в плохом контакте, а как раз в слишком хорошем- улучшили один контакт- и именно этот хороший контакт начал греться особенно сильно.

Я знаком, у меня не вызывает. 12 Вольт и 300Ватт- P=UI=U^2/R => R=P/U^2= 300/144= 2 Ом. полное сопротивление входного тракта карты- всего 2 Ома.

Плохо знакомы, не перепроверяете.

12 Вольт, 2 Ома, по закону Ома ток — 6 Ампер.

12 Вольт, 6 Ампер, 72 Ватта.

Вот вам и 300 Ватт.

Меньше полуОма там сопротивление.

не понимаю, за что Вам минус влепили, за мой эпикфейл спасибо :-) делить разучился :-)

делить разучился :-)

Скорее, выполнять преобразования при решении уравнения.

Ошибки бывают, и достаточно часто.

Это — данность, с которой приходится иметь дело.

Однако, с этой данностью можно эффективно бороться, снижая количество ошибок до уровня, близкого к 0.

Для этого необходимо перепроверять способом, отличным от прямого вычисления.

Примерно, как проверяют найденные корни уравнения подстановкой их значений в уравнение и проверкой, что знак равенства выполняется.

В этом случае работает перемножение довольно малых вероятностей.

Если вероятность ошибиться как при прямом вычислении, так и при перепроверке — 10%, то общая вероятность после их перемножения даёт всего 1%, что явно лучше 10%.

Если исходные вероятности ещё меньше, то эффект — ещё значительнее.

Можно и вторую перепроверку использовать каким-нибудь третьим способом, чтобы ещё уменьшить результирующую вероятность ошибиться, но обычно достаточно одной перепроверки.

А совсем без перепроверки ошибки обычно слишком часты.

вся эта тема раздута для хайпа - потому что NVIDIA карта дорогая и компаиня богатая -- в глазах обывателя, экономящего на спичках и покупающего дешевые китайские поделки под видом блоков питания с проводами, в которых вообще нет или очень мало меди. Без меди это не работает, как мы видим. Пять-шесть втыканий разъема, тонкий слой проводника облетает и привет горящему пластику. Кто-нибудь пробовал залудить эти "медные" провода? Они совершенно не паяются обычными флюсами для пайки меди -- ровно как и полагается алюминию и прочей таблице Межделеева, которую туда напихали, лишь бы сэкономить пару центов.

https://youtu.be/Ndmoi1s0ZaY

В чем хайп то? В том что нвидия в течение двух поколений карт последовательно все больше экономила на спичках и убирала балансировку нагрузки на стороне карты? Нету ни одной адекватной причины почему нвидия все упихала в один 600w канал.

Ну давайте еще, я не знаю, обвиним машиниста в том что у него вагон электропоезда загорелся из-за того что сборщики на заводе решили что в сети питания не может быть скачка напряжения.

если это источник тока- то он не может вместо 6А выдать 22! он будет повышать напряжение на плохом контакте, сохраняя постоянный ток через него. А вот если растет именно ток- то это значит, что у нас работает источник напряжения, нагруженный пачкой параллельных сопротивлений, и как раз никакой балансировки токов нет. При этом, что контринтуитивно несколько, в такой схеме будет греться не плохой контакт, а наоборот- самый хороший, у него как раз сопротивление маленькое и потому через него течет повышенный ток, что при константном падении напряжения даст повышенный нагрев.

1) Как закон ома противоречит тому, что напряжение у разных проводов будет разное ?

2) Если вспомнить закон Ома, который вы цитировали ниже, то при повышении сопротивления ток не увеличивается, а уменьшается.

Можно немного снизить энергопотребление карты. Используйте MSI Afterburner и уменьшите Power Limit до 90% от максимума. Это создаст небольшой запас по питанию и может уберечь от перегрузок, при этом производительность снизится не так значительно — вы потеряете всего 3-5%.

Отличный совет покупателям 5090. Купите видеокарту по цене машины и урежьте те крохи производительности, что она получила в сравнении с 4090.

А если по теме, то я реально не понимаю, почему не был выбран разъем XT60 (например) вместо 12VHPWR. Все-равно же и на сторону БП пришлось внедреять новый разъем. Кто-то говорит, что это экономия на цене разъема и двух толстых кабелей. Но кабель 12VHPWR с разъемами тоже стоит денег и при текущих ценах на видеокарты и БП это капля в море.

Что-то больно маленький для 350A. У меня такой же по размерам валяется, так там всего 175A. Причем кабель, вроде, потолще - 4 AWG (21.2 mm^2).

У Китайских "моделистов" есть XT60, XT90, T-plug и "силовые бананы", до 90 А на контакт, проводки жирные(8AWG уже 95 А/жила, есть жирнее) и гибкие, жилки мелкие не ломаются, изоляция силиконовая, не горит на жале паяльника...

Резюме: Нвидиа не смога изобрести вилку с розеткой.

И это даже не совсем шутка: современные видихи уже такого размера, что даже обычные розетки уместились бы.

Не, не, мы место экономим и меняем miniFit на microFit, понимать надо )

Зачем плодить форматы давайте type-c запитаем.

Вот зачем вы подсказываете?!

Пока нельзя, актуальная ревизия допускает всего 240Вт по PD

Когда-то у меня было две видюхи, соединенные мостом. Подключить можно было до 3х видюх вместе. Так что два-три usb-c точно можно.

Соединение было по питанию, что ли?

Если это технологии, когда синхронизировались карты для повышения производительности, то питание к ним отдельно шло, когда использовалось дополнительное, а не только через слот PCIe.

Просто у меня была видюха и с ней шла в комплекте перемычка для соединения 2 видюх.

Вот у меня с перемычками две такие и были - там две перемычки ставились между и они в паре работали. Но можно было и три - тогда перемычки шахматно шли. Крайсис на ультрах всё равно не тянуло и в итоге пришлось брать одну, но толстую.

Ну так те перемычки не для питания были.

Питание через другие места заходило: разъём PCIe и 6-пиновый разъём с противоположной стороны от гребёнки разъёма на карте

У меня была вот такая Sapphire HD4850 512MB (которая красного цвета, а не чёрная версия Toxic): https://www.ferra.ru/review/computers/82572.htm

А где по type-c хотя бы мизерные полкиловатта передавали?

Емнип там больше 200Вт даже не пытались, с которыми у видюх и так никаких проблем уже лет так 20 не было.

Интересно, есть ли какие-нибудь компании, производящие одновременно видеокарты и блоки питания, способные их объединить?

Gigabyte производит видеокарты и блоки питания. Как там насчёт способности объединить не скажу.

Не, Gigabyte закупает OEM платформы, как и прочие вендоры.

Не знал. Казалось бы, назвался груздём - полезай в кузовок, покупать комплектующие одного бренда, в случае чего пускай чинит, так ведь нет - наверняка авторизованные сервис-центры для видеокарты и блока питания будут разные (встречал, материнку и процессор трижды отправлял в ремонт порознь, пока не забил, пока не купил за свой счёт новую материнку). Остаётся только кабель пополам перерезать и отправить в оба СЦ сразу.

Как понять объединить? Подводить питание 230В AC? )

Купил карту чтобы играть но, теперь нужно следить чтобы она не перегрелась,

Есть же прекрасные автомобильные разъемы, где ток на один контакт может быть и 50 Ампер. Например, в разъеме на силовой замок зажигания. Собственно, одним контактом можно и нужно ограничиться - силовую проводку нельзя соединять в параллель. Причины указаны выше в комментариях. И не горит в автомобилях годами.

Есть и недостаток - такие разъемы сложно вставить, и еще сложнее вынуть. Усилия надо прилагать совсем не детские.

Ну есть XT-60, ну решён уже вопрос, ничего тут притаскивать не надо уже.

Собственно не важно из какой области взять разъем, главное чтобы эти 50 ампер были по одному проводу.

силовую проводку нельзя соединять в параллель.

Истинно так! я хочу гдето пруф на какойто стандарт который это описывает....я этот пруф безуспешно искал в начале нулевых но не смог осилить в рамках своей молодости и неопытности

когда я работал электриком, одни дельцы которые поставляли нам промышленный агрегат для тестирования генераторов, проложили проводку (к нагрузочным резисторам) не двумя кабелюками с полруки толщиной, а парой десятков мелких проводов...потому что так дешевле, а там ток от 500 до 1000А...они просто набрали квадратуру мелкими проводами и типа "да какая разница"..

оно за пару месяцев спеклось всё вместе так что мы из стены дрелью высверливали насколько оно туда впаялось сварившись в т.ч. кабельканалом

хотя прям чуял, когда они это монтировали что так нельзя делать изначально

Этот стандарт называется "здравый смысл инженера". Переходное сопротивление исправной контактной группы лежит примерно в пределах от 10 до 50 мОм. Если параллельно идет несколько соединений - ток распределится по ним не равномерно. То есть где то возникнет перегрузка, контакт начнет греться, его сопротивление расти - и нагрев тоже вырастет. Последствия вы знаете.

По такой логике, если сопротивление провода будет увеличиваться с нагревом (а оно действительно так и будет), ток через него должен перенаправиться на соседние параллельные провода, у которых сопротивление меньше...

Как же тогда работают многопровоочные провода?

у них контакт имеется между проволочками по всей длине жилы, а у жил контакт может быть (ну пока изоляция ещё не исчезла на них) только в начале и конце изолированого участка

Дроссели, трансформаторы, обмотки электрических машин и т.п. прекрасно мотаются в несколько изолированных жил.

Сам тезис о том, что "силовую проводку нельзя соединять параллельно", тоже светится глубиной познаний и компетентностью. /s

Там так делается не от хорошей жизни, а для упрощения укладывания витков. И горят они чаще и быстрее, чем намотаные цельной жилой.

Были у нас движки на 55кВт с разным исполнением обмоток и при перегрузе намотаные проводом горели сильно чаще при одинаковой нагрузке.

Там так делается не от хорошей жизни, а для упрощения укладывания витков.

Это только одна причина, в общем случае - нет.

Были у нас движки на 55кВт с разным исполнением обмоток и при перегрузе намотаные проводом горели сильно чаще при одинаковой нагрузке.

Это может быть связано с более свободным шевелением обмоток под действием ЭМИ и перетиранием изоляции и последующим межвитковым замыканием. Т.е. это термический и механический износ изоляции. Обычно правильная пропитка сводит эту проблему к нулю.

Но какое это имеет отношение к характеристикам обмотки по постоянному току?

Можно, но только на заводе и чтобы разъём был одним контактом на полюс. В автомобилях жгуты отлично работают, но они заводской опрессовки и с разъёмами на дурные токи.

Tesla Supercharger, паралелит ток в зарядном посте(та штука куда ручка вешается) на две линии, в сумме более 300А. Но там стоят датчики тока и следят за дисбаллансом.

2 месяца назад именно это исследование Der8auer облетело все хардварные ресурсы, а X-com только сейчас решил сделать интенрацию.

Чисто ради эксперемента никто не пробовал тупо перерезать проблемную жилу в проводе питания и посмотреть, как расперделится нагрузка, может по остальным она ляжет ровно.

Вообще интересно, как там все спроектированно, что отбор мошьности идет приоритето мо подному проводу. Такое ощущение, что входное сопротивление для разных проводов разное.

Вообще можно перерезать почти все провода — даже всего два не будут нагреваться до оплавления https://youtu.be/XNoBsrgoppQ?t=2622

В какой-то момент один DC-DC преобразователь отключился по каким-то причинам (перегрев или брак, например). А дальше цепная реакция: нагрузка распределилась по остальным, они стали греться больше, дальше снова какой-то отключился и так далее, пока весь ток потребления видеокарты не пойдёт через один единственный контакт разъёма 12 В. Само собой, последний на это не рассчитан и плавится. Интересно бы увидеть съёмку этого лавинообразного процесса на тепловизоре.

Думаю люди, снимающие заводские крышки с процессоров, придумают мод по выпаиванию родного разъема питания с видеокарты и установке туда более надежной конструкции (и в БП тоже)

Да чего там придумывать - делюсь бесплатно.

Разделяем жгут на 3 части - земля, +12, и всё остальное (если есть). Со жгутами земля и питание проводим следующую операцию ! По отдельности ! :

Снимаем изоляцию посредине жгута не разрезая проводник. Обкручиваем медной проволокой, соединяя все проводники жгута (ток будет небольшим). Изолируем место соединения. Продолжаем методом половинного деления согласуясь со здравым смыслом.

Я одного не пойму, зачем вам вообще разъемы в такой постановке вопроса? Просто припаиваешь проводами подлиннее и всё. Гарантированно будет работать без проблем.

Для монтажа и демонтажа без паяльника.

Можно припаяться только к видеокарте, а на стороне БП оставить разъем (там ведь ничего не плавится?). Будет плата с хвостиком.

Это какая-то самоцель ? Сколько раз в год вы что-то перемонтируете ? Я обычно.... ноль.

Демонтаж кусачками будет даже быстрее. Для монтирования да придется использовать паяльник.

Несколько раз в год. Без демонтажа видеокарты неудобно, например, вставлять M.2 SSD, добавлять оперативную память, менять процессор/кулер и подключать кабели SATA. Некоторые даже раз в полгода термопасту меняют.

Да, кто-то один раз купил пк и больше ничего с ним не делает, но некоторым всё-таки иногда приходится что-то менять внутри и не надо отрицать такой сценарий использования.

Ну и кроме того, лично знаю человека, который на выходе 5090 сразу её покупает и продаёт предыдущую 4090. Ему тоже предлагаете кусачками откусывать и менять вместе с видеокартой ещё и БП?

? В чем проблема вынуть карту, сделать дела и вставить ее обратно. Используйте нормального сечения провод, и можете хоть метровым ее подключать....

В другой комп переставить будет сложнее. В тот-же проще. Вообще ничего не надо отсоединять...

БП то зачем менять ? Один раз припаялся к нему и используй с любой картой. Но требует минимальной квалификации. Лучше бы были порты "под винт", но это вопрос к производителям карт...

Вот нормальный тест https://youtu.be/XNoBsrgoppQ?t=1755

У людей разьемы плавятся при плохом коннекте на двух проводах.

Поэтому все, что доказывает это видео, это что пару часов (может даже дней) конфигурация с плохим коннектом еще поживет. Ну и обычно видеокарты все же не на открытом стенде стоят и дополнительно прогреваются, так что тут борода тоже налажал (у него с этим в последнее время вообще проблемы).

Давно пора повысить напряжение питания видеокарт, та же мощность при меньшем токе

Это нужен новый стандарт блоков питания, никто не хочет этим заниматься

Проще, как уже выше предложили, подключать видеокарту напрямую в розетку.

Тогда предлагаю питать от 1кВ: будет достаточно проводков, как в самых говёных китайских наушниках-таблетках за пару центов (в 90-х такие на каждом углу встретить можно было: там каждый канал имел максимум по три волосинки в качестве проводника).

Правда у каждого провода будет изоляции столько, что он будет с палец толщиной примерно, но это мелочи. =)

«Сам коннектор не плохой. Он просто рассчитан на слишком высокую мощность, что оставляет мало запаса прочности» - как это?

Ну это как лопата, сама по себе не плохой инструмент, но она не рассчитана на ту производительность которая нужна что бы выкопать фундамент для многоэтажного дома в приемлемые сроки.

(шутку про солдат стройбата не учитываем)

Нет, там фраза про коннектор идиотская. Если коннектор рассчитан на высокую мощность, то "запас прочности" у него большой.

Да там наоборот ситуация когда есть экскаватор и нужно выкопать ямку с ведёрко и это проблема потому что экскаватор слишком быстро копает

Удивительно, что еще не было.

Передача такой мощности через 12 вольт и контакты всегда будет громоздка и ненадёжна.

Почему бы такие видеокарты не питать от сети 220 с преобразователем в самой карте?

Ведь преобразователь там и так уже есть. Только сделать не 12 в 1, а 300 в 1.

Ну пусть будет на пару см длиннее зато не будет контактов и

в будущем можно перейти на трёхфазную сеть до 10 квт.

Кстати, можно просто проходной IEC C13 с ответвлением длиной сантиметров 25 до видеокарты делать, который прямо перед блоком питания бы вставлялся в комп.

Выше 36В в бытовой технике, а данная видео карта бытовая, использовать слишком проблематично.

Да и никому не хочется менять стандарты на ATX PSU.

Вся бытовая техника питается от 220 и никаких проблем.

ATX менять не нужно. Сетевой разъём будет сзади ВК как на БП уже в 60**.

Не вся: в некоторых странах стандартное напряжение в сети - это 100, 110, 115 или 127 Вольт.

https://ru.wikipedia.org/wiki/Стандарты_напряжений_и_частот_в_разных_странах

Бытовая техника имеющая питание от 230В по другим стандартам изготавливается.

В отличии от техники питаемой напряжением до 36В.

Плюс в видео карте масса разъемов разных стандартов под подключение мониторов.

Которые будут подключать необученные юзеры.

Короче лоеры уже потирают руки, в предвкушении простудиться с зелёными.

Если они 230В подключат к бытовым видеокартам.

Ну, бросьте уже. Идея про 230В на видяхе часто озвучивается, но это абсурд. Полноценный, качественный сетевой БП с активным PFC, защитами, изоляцией высоковольтной части — это сложное и дорогое устройство. Установленный на картах DC/DC step-down преобразователь, это лишь малюсенькая частичка от полноценного сетевого БП. Гораздо резоннее просто добавить новую линию на безопасных 24/48 вольтах в существующий БП, всё равно 12VHPWR, по-хорошему, требовал замены БП на совершенно новый. А на самих GPU даже step-down-конвертер мог бы почти не отличаться от сегодняшнего, разве что компоненты должны быть рассчитаны на более высокое напряжение. Ну и XT60/XT90 с нормальным, толстым, силиконовым проводом, здесь уже упоминались.

Только вот киловаттный бп стоит не как два по 500вт, а гораздо дороже. Выходит снабдить видеокарту собственным бп будет ещё и дешевле...

киловаттный бп стоит не как два по 500вт, а гораздо дороже.

Вы уверены? Пробежался глазами по DNSу, если брать БП от одного производителя из одной серии, то два будут даже чуть дороже одного мощного. Мы же не собираемся ставить в GPU китайский драйвер для светодиодных лент за $10? Ну и отдельный БП для видео ≠ интегрированный в GPU PSU. Майнинг-фермы давно по несколько БП в одном юните используют и им норм.

Hidden text

xcom-shop... Калькулятор БП у вас недоделанный.

У меня 8 модулей DDR4. У вас можно максимум 4 выбрать.

СЖО у меня из 1 помпы и 9 вентиляторов. Где этот вариант?

После нажатия на кнопку "подобрать БП", перебрасывает на "404 not found". Ощущение, что ссылку для переадресации нужно поменять.

Тем временем бесщеточный моторчик 3S 1200Вт, у которого разъем намного меньше, но ни разу ни у кого не загорелся, смотрит на инженеров нвидии свысока... Кстати говоря, серверные собратья 5090 тоже не одобряют пожары, что тонко намекает на грубую халтуру при разработке "геймерской" версии.

1200Вт это макс нагрузка за какой-то период времени. Большую часть двигатель работает на гораздо меньшей мощности, а то сгорит.

а напряжение то у него какое? вы же про мощность пишете, пишите про ток которые через разъем проходит, всё сразу понятно станет почему он маленький

если бахнуть 1200Вт на 380 вольт (условно, не для этого двигателя, а вообще), то там чутьли не проводом от дешевой зарядки телефонной подключить на скрутках можно будет и он не сгорит

Подозреваю я, что "3S" — это три последовательные банки лития, то есть ≈11.1В.

т.е. 108А?

Меня это тоже несколько удивило. Вообще, nS часто используется для обозначения кол-ва последовательных банок лития. Упомянутый здесь XT90, кратковременно, должен 100А вывести. Мне интереснее, что за контроллер для этого используется, ну и за подробностями к @kenomimi

Надо было сразу клеммную колодку с болтовым соединением как на электроплиту под силовую часть запилить при таком потреблении!

Разрабатывают одни из самых передовых чипов в мире, но не могут коммутировать какие-то жалкие 600Вт без проблем. Это же просто посмешище.

Ну, как обычно, виноваты все, кроме самой компании

Суть проблемы лежит гораздо глубже: в погоне за т. н. "прогрессом" производители видеокарт упёрлись в пределы техпроцесса (меньше транзисторы сложно делать) и пошли по экстенсивному пути развития, что означает повышение потребления электроэнергии и связанные с этим проблемы. В результате видеокарта греется как печка, но игры всё равно тормозят и выдают паршивое качество картинки, ибо RTX, который сильно ресурсоёмкий и не работает без агрессивного сглаживания.

Именно! И имхо — выход в оптических процессорах. Причём если начинать, то можно сразу дропнуть этап с цифрой и делать сразу аналоговые под нейросети.

игры всё равно тормозят и выдают паршивое качество картинки, ибо RTX, который сильно ресурсоёмкий и не работает без агрессивного сглаживания.

Я думаю тут проблема скорее в том, что на оптимизацию забивают болт — рыночек порешал. А оптимизированные игры оно +‑ тянет. Например, Metro Exodus Enchached на ультрах с лучами без DLSS выдаёт 50 фпс в разрешении 12К с VRR, что более чем достойно.

Просто есть теперь соблазн у разработчиков — не вручную все света‑тени настраивать, и думать, где что запекать, а где считать в реалтайме, а где применить хитрость, а тупо лучи включить и пусть оно само все сделает и будет красивенько. И этим соблазном все будут пользоваться.

По поводу заявления зелёных что это юзеры во всех бедах 5090 сами виноваты...

Вспомнилось заявление Джобса "Вы его неправильно держите" (C)😁

Когда его телефоны работали далеко не идеально.

Не хватает только резерфордовских коннекторов, резерфордовской обжимки и пары дюаров азота.

Обеспечьте хорошую вентиляцию корпуса, особенно в районе видеокарты и блока питания. Дополнительное охлаждение поможет снизить температуру компонентов и уменьшить риск перегрева.

Риск перегрева да. Риск оплавления – нет.

Так почему же на самом деле горят видеокарты ?

Судя по тексту, NVidia не сказали ничего нового, что уже известно как 2 месяца.

Заголовок попахивает желтизной.

6. Поменять 5090 на что-то более надёжное

Про карты в играх медленнее примерно на 10–15%. Да и не в играх тоже, скажем, в каком‑нибудь рендеринге небольшой сцены.

О каких про картах ты ведёшь речь? Я имел в виду 4080 супер, например. Или 5080 на худой конец. Или вообще что-то от АМД

Так они слабые. Если менять то менять на что‑то соответствующей мощности. А если изначально было достаточно 5080, то нет смысла хвататься за 5090.

Там вся мощность фейковая, реальная производительность не настолько большая, чтобы играть в русскую рулетку беря заведомо бракованный товар.

вся мощность фейковая

Вся? Или не вся? И мощность, или прирост мощности? И по сравнению с чем?

Там 32 гб настоящие и хардварная поддержка 4бит с плавающей запятой нормальная. А прирост производительности по сравнению с предыдущим поколением сам по себе может и небольшой, но когда её всегда мало, даже такой полезен. По надёжности и размерам да, это пакость. Но выбирать не приходится.

Мухлёж маркетологов не отменяет реальных плюсов и минусов продукта.

Минусы в виде высокой вероятности выхода из строя нивелируют все плюсы. Если производительности всегда мало, то незначительный прирост погоды не сделает. Уж лучше сидеть на предыдущем поколении, которое не горит, чем ради каких-то 20-30% выкидывать деньги на ветер. Да и вообще, коль уж на то пошло, никакой прирост, когда его всё равно в любом случае будет мало, не стоит такого риска. И для чего мало? В игры играть и рендерить видосы с головой хватит вышеуказанной 4080 супер.

Во‑первых, есть такая штука, как гарантия. В три года, например. Во‑вторых, 5090 быстрее 4080 super в полтора(!) раза, а не на 25%. В‑третьих, есть штука, которая называется разрешение.

Нет, не хватит 4080S для рендеринга — если в видеопамять сцена не поместится хотя бы чуть-чуть, производительность сыпется ниже CPU. А если рендерить 8K, или пускать рендер двух анимаций параллельно, или моделить одну пока рендерится другая, память сожрать очень легко.

А тут можно рендерить две сцены, моделить третью и ещё видео параллельно кодировать в H265. И при этом держать открытыми Photoshop и AE, не боясь, что сейчас система встанет или драйвер вылетит. Я уж не говорю про возможность пуска двух Unreal Engine с отладкой C++.

И нет, не хватит 4080 Super с головой для игр, если даже 5090 без dlss выдаёт 50 фпс. А в bf4 — игре 2014 года, на минуточку, выдаёт 120–150 fps. Ну то есть 4080 super села бы в 30 фпс в первом случае, и ниже 100 во втором.

Есть ситуации где за прирост в 5% третью карту ставят, просто потому что стоит вопрос реалтайм успеет или нет. А тут 50%.

Резюмируя: всё зависит от нагрузки на железо. Если оно не справляется — каждый процент прироста может быть важен. Если справляется — то даже двукратный прирост может быть не нужен.

Как-то ведь справлялись до этого. Поумерь свой пыл и занимайся чем-то одним. А так тебе и на йух сесть и рыбку съесть. Это во-первых. Во-вторых, если технологии до сих пор не доросли до 4к без подключения костылей в виде DLSS, то и нехрен насиловать железо. Поумерь своё ЧСВ и играй в народные фулл хд (по статистике стима до сих пор преобладающее разрешение), ну или 2к на худой конец. И в-третьих, такая штука как гарантия в данном случае не работает, так как компания не признаёт косяк и виноват пользователь. Сгорела карта - сам виноват, покупай новую.

Даже не читал. Дайте угадаю, виноваты юзеры, блоки питания, провода, корпус. Что или кто угодно виноват, но не nvidia, да?

Вот этого поворот: NVIDIA рассказала, почему на самом деле горят видеокарты RTX 50