Комментарии 7

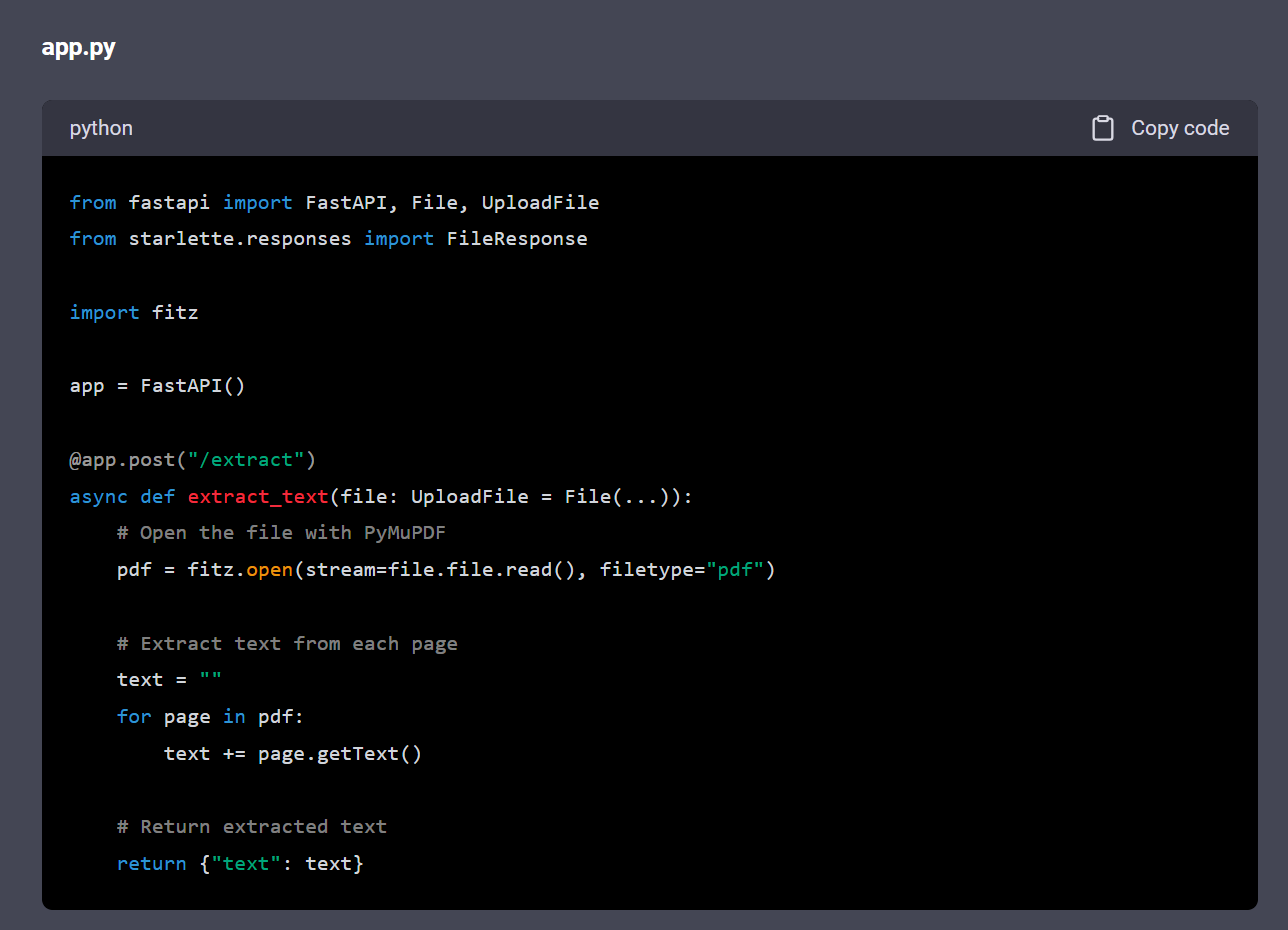

Если кому вдруг интересно, загрузил эту модель себе на сервис, можно потыкать, попробовать.

Справляется с задачами довольно интересно (далее все один ответ, просто не уместился на одном экране, извиняюсь за большое количество картинок):

Сколько видепамяти надо?

~60-120 ГБ (в зависимости от Quantize) + около 20-40 ГБ под контекст, хотя если ограничитесь в 8-16к, то хватит ещё дополнительно около 8 ГБ.

Конечно можно и в ОЗУ держать.

Каждый параметр - это значение типа float размером 4 байта, этих параметров соответственно 70 миллиардов. Все они должны быть в памяти одного вычислителя. Плюс наклпдные расходы ещё процентов 20. Поэтому в реальности float превращают в int16/int8 (2 или 1 байт), в тяжёлых случаях int4 (полбайта). Это называется квантификация. Модель становится меньше и быстрее, но менее точной и генерит больше бредятины. Иногда конечно вычислитель делают из нескольких, но я например искал и не нашёл алгоритмы обсчёта на двух и более видеокартах. Наверное, плохо искал...

Видеопамяти нужно от нуля (если размещать полностью в ОЗУ) до полного размещения модели в VRAM (гражданских видюх таких нет).

НО можно совмещать памяти! Часть держать в видеопамяти, часть в ОЗУ.

Там есть несколько вариантов квантизации и разный вес модели. Варианты для Code LLAMA 70b можно посмотреть тут: https://huggingface.co/TheBloke/CodeLlama-70B-hf-GGUF

Например, для версии Q4_K_M требуется максимум 44Гб. Можно взять и версии покрупнее из рекомендованных, там требования до 52Гб.

То есть даже без видюхи, если комп имеет 64ГБ, то всё поместится.

В LM Studio можно разделять какое количество слоёв можно держать в видеопамяти, а какое держать в оперативке.

В общем главное, чтобы в сумме общего размера памятей хватало на размещение модели.

У меня оперативки в компе 32ГБ и в видюхе 24Гб. То есть в сумме 56 ГБ.

Успешно запускаю обычную чатовую LLAMA на 70b, которой требуется 44ГБ. Скорость работы выходит 2 токена в секунду.

Примерно 45 слоев из 80 размещено в видеокарте (см. скриншот ниже). Делаю это в LM Studio - рекомендую, вообще не нужно ни в чём разбираться, в пару кликов устанавливаются любые LLM модели с Huggingface.

Так что работать будет, полагаю, с любой видюхой (главное подобрать количество слоёв, которые держать в видеопамяти), или даже без видюхи. В общем, нужно просто, чтобы общей памяти было достаточно для размещения модели (ну и про запас немного для работы системы).

Интересно, почему они не используют архитектуру Мистраля, там же вроде 7 млрд с таким же качеством.

Да не, с 7 миллиардами параметров похожего качества добиться сложно, даже новая llama 3 8b, которая дообучена, вряд ли сможет отвечать так же хорошо. Вот если говорить про 8х7b mixtral - там есть определённый выигрыш в скорости из-за того, что роутер выбирает нужного эксперта, и, по факту, скорость как у моделей с 7 миллиардами параметров. Но памяти все равно будет расходоваться много ;(

Meta* выпустила версию Code Llama 70B