Можно встретить много критических замечаний о том, что биологический мозг или биологические нейронные сети работают совершенно не так как ныне популярные компьютерные нейронные сети. К подобным замечаниям прибегают различные специалисты, как со стороны биологов, нейрофизиологов так и со стороны специалистов по компьютерным наукам и машинному обучению, но при этом очень мало конкретных замечаний и предложений. В этой статье мы попытаемся провести анализ этой проблемы и выявить частные различия между работой биологической и компьютерной нейронной сетью, и предложить пути улучшения компьютерных нейронных сетей которые приблизят их работу к биологическому аналогу.

Граница знаний

Прежде я хочу пояснить, почему, по моему мнению, в вопросе создания сильного искусственного интеллекта до сих пор всё так печально, не смотря на грандиозные успехи в компьютерных науках и знаниях о биологическом мозге. Прежде всего, это связано с большой идеологической пропастью между этими двумя столпами науки. Компьютерные науки требуют некой схематичной простоты, строгости и лаконичности в описании систем, некого системного подхода, в отбрасывании лишнего и чёткой структуризации достаточной для оформления в программном коде. В биологии же главенствует подробность описания наблюдаемых систем, ничто не может быть отброшено или проигнорировано из наблюдений. В описываемые системы должны быть включены все наблюдаемые факты. Поэтому биологам сложно применять системный подход к своим обширным знаниям для создания алгоритмов мозга. Ведь чтобы создать конструктив самолёта потребовалось очень многое пересмотреть и отбросить из образа птицы.

С другой стороны легко понять учёных и инженеров, которые при погружении в изучение компьютерных нейронных сетей из описания принципов работы мозга довольствуются коротким абзацем текста о нейроне, который с помощью синапсов на дендритах «слушает» другие нейроны и по единичному аксону передаёт результат вычислений суммации по слою дальше, не применяя к этим знаниям никакой критической оценки. Даже нейробиологи применяют формальный нейрон Маккаллока — Питтса при описаний принципов работы биологического нейрона, но делают они это по другой причине, по причине того что нет достойных альтернатив, нет в биологии чёткого описания того что делает нейрон, какую логику он выполняет, несмотря на обширные знания о нём.

Если кто-то попробует провести реинжиниринг работы мозга, то встретит целый пласт накопленных противоречивых знаний, разобраться в которых фактически не хватит жизни даже биолога, не говоря уже о системном инженере который привычен к более другой форме знаний. Работать с таким объёмом информации возможно только через призму некой общей теории работы мозга, которой пока нет.

Человечество обладает технологиями колоссальных вычислительных мощностей и гигантским объёмом знаний о мозге, но не может получить синтез этих вещей. Давайте же попытаемся решить эту проблему и сотрём эту границу знаний.

Мозг это должно быть просто

Первый очень важный принцип, которым следует руководствоваться – это идея того, что мозг должен работать по неким очень простым правилам, т.е. все когнитивные процессы какими бы сложными они не казались, основаны на простых базовых принципах. Это отличается от того, что мы привыкли слышать о мозге. Длительное отсутствие общей теории работы мозга породило множество спекуляций на тему того, что мозг — некий непостижимо сложный объект, или природа его работы выходит далеко за рамки тех научных методов изучения, которые к нему применяют. К примеру, сравнивают мозг с квантовым компьютером, или незаслуженно приписывают отдельным нейронам свойства сложных вычислителей, что вкупе с их количеством в нервной системе делают требования к вычислительным мощностям для моделирования мозга не достижимыми.

На мой взгляд, ученых, которые высказываются о том, что Человечеству никогда не постичь сложность человеческого мозга нужно лишать научных степеней, подобные высказывания только могут подрывать боевой дух людей которые захотят посвятить себя решению этой проблемы.

Так что же свидетельствует в пользу простоты работы мозга? Здесь я приведу совершенно парадоксальный пример. Если взять виноградную улитку и подвести электроды к одному нейрону её крупного ганглия, согласно всем требованиям, которые применяются к подобным экспериментам, то мы сможем получить график активности отдельного нейрона, и попытаемся проанализировать его, то получим очень сложный характер его активности. Даже если учтём характер инвазивности нашего эксперимента, то что наши электроды приносят улитки серьёзные повреждения и ограничение её жизнедеятельности, то характер активности нейрона всё равно выглядит очень сложным. Мы увидим и спонтанную активность, и изменение в количестве и частоте спайков с течением времени. Многие учёные бьются над объяснением этого сложного поведения нейрона на протяжении уже долгого времени, ища какую-либо закономерность в этом.

Эти факты делают нейрон неким сложным вычислителем, работающим по сложному алгоритму. Учитывая, что таких нейронов в нервной системе улитки насчитывается около 20 тысяч, то можно сказать, что вычислительная мощь нервной системы рядовой улитки сопоставима с мейнфреймом. Я думаю это должно вселить в Вас трепет перед этими животными. Но давайте посмотрим, насколько сложно поведение улиток. Улитка – это некий биологический автомат, да у него существует некая степень вариативности поведения, но она очень мала. Это набор безусловных рефлексов, зачастую очень простых, которые можно объяснить уже имеющимися знаниями о нейронах, синапсах и рефлекторных актах и здесь не будет места сложным вычислениям.

В подтверждение выше изложенного хочу сделать отсылку к моей прошлой статье, в которой описывается модель головастика лягушки, в которой благодаря нервной системе из нескольких десятков нейронов можно получить достаточно сложное поведение водоплавающего существа. Причём из очень простых нейронов, модель которых основана на известных в науке фактах.

Так откуда берётся это сложное поведение нейрона, и зачем их такое большое количество? Здесь на самом деле одно вытекает из другого. В природе существует парадоксальное явление, которое можно назвать парадоксом эффективности нейрона. Оно заключается в том, что с увеличением и усложнением нервной системы эффективность или роль отдельного нейрона в этой системе падает.

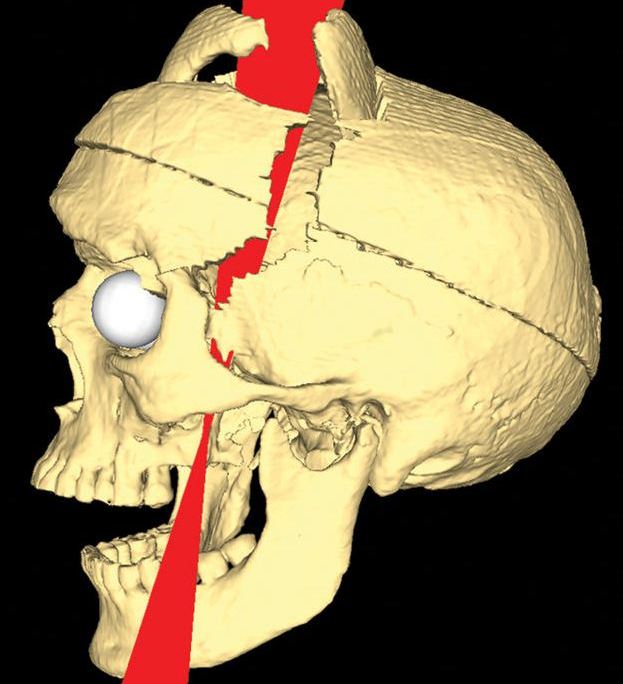

Если мы проанализируем нервную систему кольчатого червя c.elegans, животного, чей коннектом из 301 нейрона полностью составлен, то увидим, что не только отдельные нейроны важны в правильной работе его нервной системы, но и имеют значения даже отдельные синапсы. То есть мы можем присвоить отдельному нейрону кольчатого червя 100% эффективности. Если рассматривать с этой точки зрения нервную систему человека, то сложно присвоить нейронам значимое значение эффективности которые можно вынести ломиком из черепной коробки, при этом сохранив жизнедеятельность человека и даже его социальную интеграцию, ну почти сохранив.*

*отсылка к очень известному случаю Финеаса Гейджа

Регулярно можно увидеть статьи, в которых описывается случаи, где люди, живущие полноценной жизнью и социально адаптивны, вдруг обнаруживают, что их мозг лишён каких-либо областей или долей. Не удивительно, что такие факты порождают идеи того, что дело вовсе не в нейронах, да и вообще не в мозге.

Если наблюдать за активностью здорового мозга, то мы не увидим никаких лишних нейронов, каждый нейрон будет задействован, в разной степени, конечно, каждому будет присвоена своя роль. Как это делает мозг, какой должен быть алгоритм нейрона, чтобы это происходило, при низкой эффективности нейрона, я поясню ниже.

Парадокс эффективности нейрона можно объяснить тем, что при увеличении количества нейронов в нервной системе уменьшается «внимание» процессов эволюции к отдельным нейронам. Поэтому нейроны кольчатого червя, можно выразиться, работают как часы, очень точно, нейроны же виноградной улитки и Человека такой точностью похвастаться не могут, в их работе можно увидеть и спонтанную активность так и отсутствие ответа там, где он должен быть, так и его нестабильность.

Итак, на сложную активность нейрона можно представить две теории: нейрон – это сложный вычислитель, алгоритм работы которого сложно понять и обосновать, либо нейрон просто работает очень нестабильно, что компенсируется его избыточным количеством, что является самым простым решением с точки зрения эволюции. Примените к этим теориям правило бритвы Оккама, согласно которой нужно оставить идеи которые имеют самое простое объяснение и вероятнее всего эти идеи будут верными.

С одной стороны парадокс эффективности нейрона даёт нам позитивную надежду, что необходимых вычислительных мощностей для моделирования мозга потребуется значительно меньше, чем при прямой оценке по количеству нейронов и синапсов в мозге человека. С другой стороны это очень сильно усложняет изучение биологического мозга. Мы можем создать достаточно подробную модель небольшого фрагмента коры мозга, затратив большие вычислительные мощности и в этой модели не увидеть каких-либо значимых процессов, которые указывали бы на то, как протекают когнитивные механизмы в нервной системе. Такие попытки уже проводились.

На первый взгляд самый простой и прямолинейный подход в создании общей теории работы мозга – это создание подробной модели мозга, в соответствии с множеством научных фактов известных о нейроне и синапсах. Моделирование – это самый практичный научный инструмент в изучении каких-либо сложных систем. Модель буквально раскрывает суть изучаемого объекта, позволяет погружаться и влиять на внутренние процессы, протекающие в моделируемой системе, давая возможность их глубже понимать.

У нейрона нет никаких исключительных органелл, которые производили бы вычисления, но его мембрана имеет ряд особенностей, и позволяют выполнять нейрону определённую работу. Это работу можно определить с помощью системы уравнений называемой моделью Ходжкина-Хаксли, которая была разработана в 1952 году, за что её авторы получили нобелевскую премию.

Эти формулы содержат несколько коэффициентов определяющих некоторые параметры мембраны нейрона, такие как скорость реакции ионных каналов, их проводимость и т.д. Эта волшебная модель описывает сразу несколько явлений, помимо изменения заряда на поверхности мембраны нейрона. Во-первых, она описывает функцию активации нейрона, или механизм суммации, он достаточно прост. Если исходный заряд недостаточен, то модель остаётся в равновесном состоянии. Если заряд переходит через определённый порог, то модель отвечает одним спайком. Если заряд в значительной степени превышает данный порог, то модель отвечает серией спайков. В компьютерных нейронных сетях используется большое разнообразие вариантов функции активации, самые близкое к биологии может являться функция Хевисайда (единичная ступенька) и линейный выпрямитель (Rectifier). Но нужно понимать, что мы описываем достаточно простой аспект работы нейрона – суммацию. В своей работе над головастиком, упомянутой выше, я применил очень простой вариант модели суммации, который образно можно представить в виде сосуда накапливающего в себе фактор побудительного воздействия, если этот фактор превышал определённый порог, то нейрон активизировался. Чтобы этот сумматор работал в реальном времени, из образного сосуда фактор воздействия медленно истекал.

Эта модель суммации позволяла производить суммацию сигналов, которые приходили на нейрон асинхронно, и она достаточно реалистично работает. На мой взгляд, чем проще описывать этот процесс, тем лучше, и это непринципиальное отличие биологических и компьютерных сетей.

Во-вторых, модель Ходжкина-Хаксли описывает изменение заряда в одной точке мембраны, но если мы, к примеру, создадим топологически точную 3D модель нейрона и разобьём эту модель на равномерную сетку, мы сможем применить модель Ходжкина-Хаксли в каждой вершине (узле) этой сетки, с условием влияния заряда на значение в соседних вершинах по сетке. Тем самым мы получим модель распространения возбуждения по нейрону близко к тому, как это происходит в живом нейроне.

Главные выводы, которые можно сделать из этой модели, это то, что возбуждение, возникнув на любом участке мембраны, распространяется на всю мембрану, в том числе распространяется по длинному аксону к самым удалённым синапсам. Модель Ходжкина-Хаксли очень ресурсозатратна поэтому для целей моделирования используют менее затратные модели с очень схожими графиками, таких придумано несколько моделей.

В рамках проекта Human Brain Project (HBP) была создана модель небольшого фрагмента коры мозга мыши, её создатели учли очень многое. 3D модели нейронов были воссозданы по реальным нейронам, использовался один из вариантов моделей Ходжкина-Хаксли, учитывались различные типы нейронов и нейромедиаторов, и нет сомнений в том, что модель действительно соответствует биологическому аналогу. На это потрачено множество ресурсов и времени, но так и не дало значимых результатов по причине того, что в столь малом размере из-за парадокса эффективности нейрона невозможно было увидеть значимых процессов. Поэтому путь подробного повторения биологии является очень и очень трудоёмким. Залог успеха это возможность понимания того как работает нервная ткань и нейроны в более широком масштабе.

Давайте рассмотрим то как мозг обрабатывает информацию на частном примере, на обработке зрительной информации. Мы составим схему нейронной сети выполняющей эту задачу.

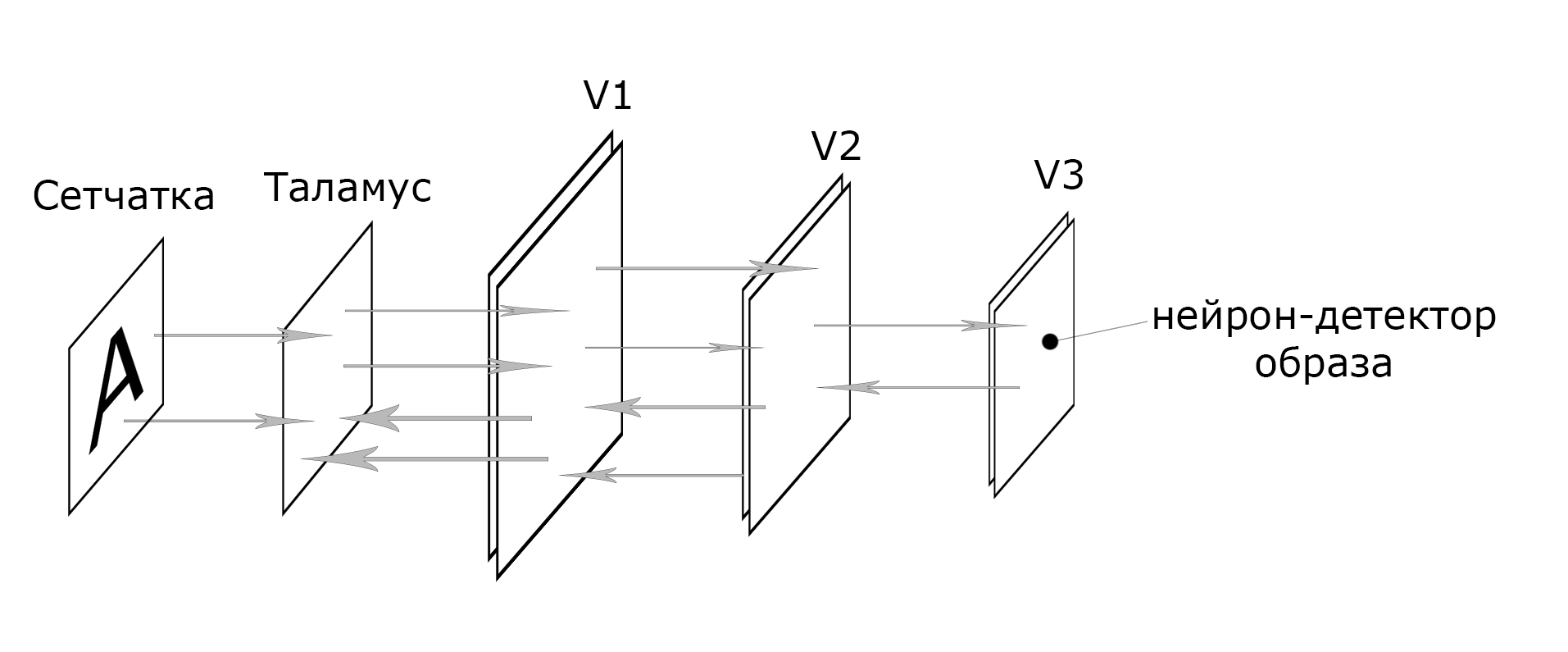

Информация с сетчатки глаза по зрительному нерву передаётся в таламус, там информация практически не подвергается значимым преобразованиям. Далее она передается в первичную зрительную зону коры головного мозга (V1). В коре головного мозга выделяют шесть слоёв, но эти слои по гистологическим или морфологическим признакам. Вероятно, здесь мы имеем дело с двумя слоями, так как некоторые структуры повторяются дважды. Но и при этом мы имеем дело скорее не с двумя отдельными самостоятельными слоями, слоями нервных клеток работающих в тандеме.

Охарактеризуем зону зрительной коры V1 как первый слой, в котором происходит обработка информации. Зона V1 также имеет обратные связи с таламусом. Подобные обратные связи имеются и между всеми последующими слоями. Эти связи формируют циклические передачи возбуждения между слоями называемыми реверберациями.

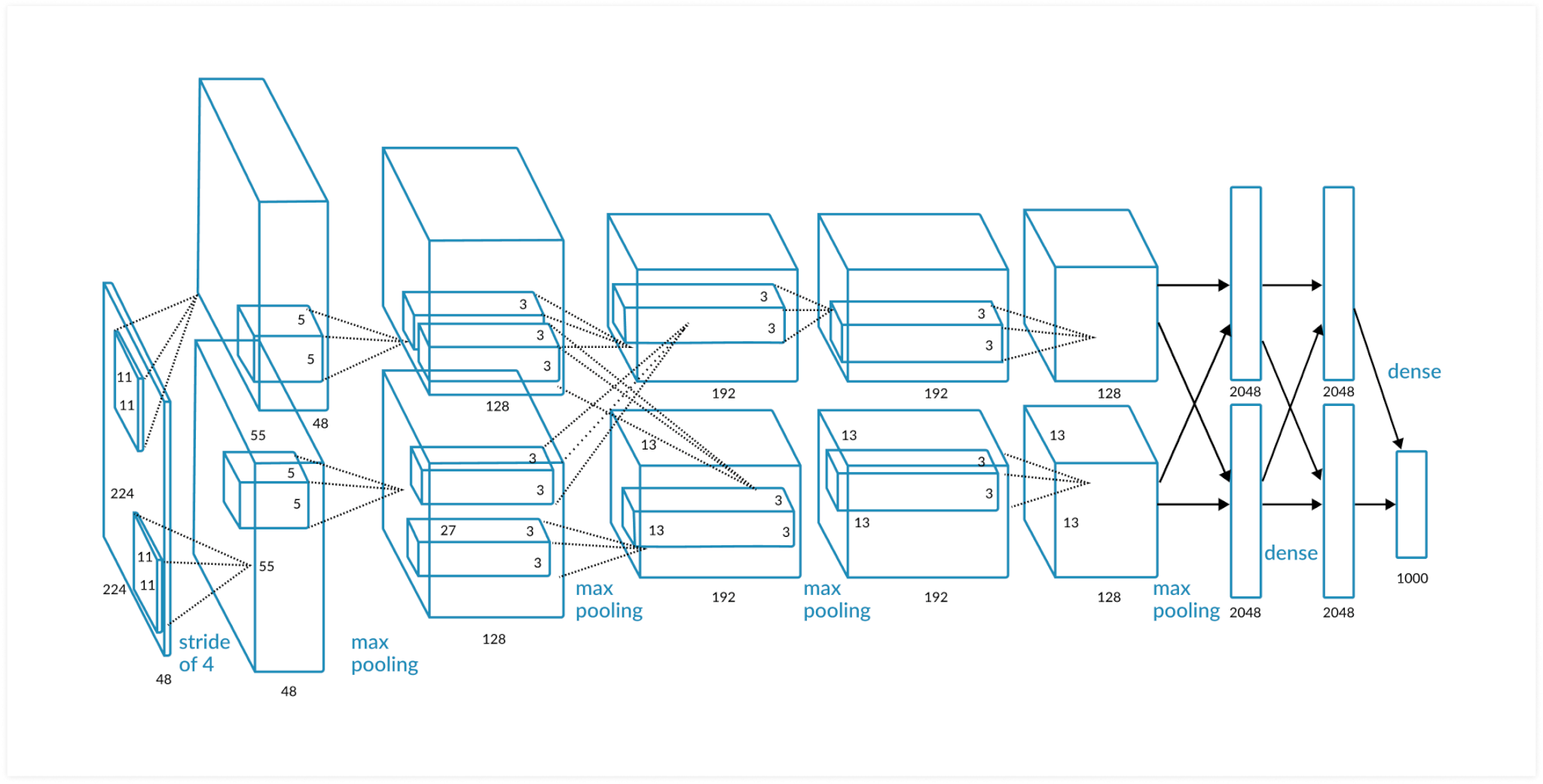

После зоны V1 информация передаётся в следующую зону V2, все последующие зоны будут иметь меньшие площади. В зависимости от того, что наблюдает мозг, был это объект, символ, лицо человека, место или что-то другое информация из V2 может передаваться в различные области V3, V4, V5. То есть уже на этой зрительной области V2 происходит серьёзная категоризация зрительных образов. И примерно уже на третьем или четвёртом слое можно будет выделить нейроны-детекторы определённых образов. К примеру, мы сможем выделить нейрон-детектор буквы «А», цифры 3 или лица Дженнифер Энистон. По активации этих нейронов-детекторов мы сможем судить об том, что в данный момент наблюдает мозг. Достаточно простая архитектура нейронной сети, если сравнить её с архитектурой компьютерных нейронных сетей специализированных на распознавании визуальных образов, свёрточных нейронных сетей.

AlexNet

Есть схожие моменты, это иерархия свёрточных слоёв, каждый последующий слой будет иметь всё меньшее количество параметров. Но у слоёв данного типа компьютерных сетей нет рекуррентных связей, конечно, их наличие не является критерием для успешного распознавания образов, так как природа ревербераций в живом мозге до конца не изучена. Есть гипотеза, что реверберации связаны с явлением моментальной памяти, той памяти, которая позволяет нам, к примеру, не сбиться при наборе номера телефона или его произношении. Реверберирующая активность как бы задерживается, обозначая участки, по которым проходит эта активность, тем самым создается контекст обрабатываемой информации.

Человек может распознать сложные образы за доли секунд, скорость распространения потенциала действия по мембране от 1 до 120 м/с, синаптическая задержка в химических синапсах составляет 0,2-0,5мс, что говорит о том, что за время распознавания может задействоваться цепочка не более чем ста нейронов.

Вышеописанное говорит о том, что в нашей черепной коробке присутствует нейронная сеть, работающая быстрее и эффективнее любой компьютерной нейронной сети, при этом организованна она относительно просто, выполняющая не сложные преобразования информации. Понимание этого и подстрекает производить поиск алгоритма сети, который бы выполнял задачу распознавания образов с применением значительно меньших вычислительных ресурсов, чем современные нейронные сети.

Формальный нейрон

Ещё со школьных лет меня волновала идея создания искусственного интеллекта, свои интерес я удовлетворял изучением литературы по нейрофизиологии, и об искусственных нейронных сетях я ничего не знал. С нейронными сетями я познакомился позже, будучи уже студентом. Знакомство с формальным нейроном Маккалока-Питса, который является основой для всех современных нейронных сетей меня озадачило и разочаровало, из-за большого акцента на дендритных синапсах.

Формальный нейрон Маккалока-Питса можно представить как некую функцию с множеством аргументов и одним ответом. Аргументы-входы преумножаются с соответствующими коэффициентами, называемыми весами (W1, W2,… Wn), затем эти значения складываются и полученная сумма проходит через активационную функцию, результат которой и является результатом вычислений нейрона. Главное это правильно подобрать веса, то есть обучить нейронную сеть. Эта модель нейрона может показаться простой и очевидной, но в ней сильный акцент на дендритных синапсах.

В химическом синапсе можно выделить две важные части: это пресинапс и постсинапс. Пресинапсы расположены на концах длинного единичного отростка аксона, который может многократно разветвляться. Пресинапс представлен в виде небольшого уплотнения на кончиках, он относится к нейрону, который передаёт возбуждение. Постсинапсы расположены на коротких ветвистых отростках дендритах, они принадлежат нейрону, которому передается возбуждение.

В пресинапсе расположены везикулы, пузырьки с порциями вещества нейромедиатора. Именно в пресинапсах прежде была выявлена неравнозначность синапсов, пресинапсы различаются по количеству порций нейромедиатора хранящегося в нем, а также по количеству выделяемого нейромедиатора при его активации. Вес или силу пресинапса обозначим буквой S.

На поверхности мембраны постсинапса расположены рецепторы, которые реагируют на нейромедиатор. Количество этих рецепторов определяет, то насколько синапс будет чувствителен. То есть постсинапс также можно охарактеризовать некоторой характеристикой, весом. Обозначим этот вес буквой A. Конечно, можно эти два параметра представить как один W, определяющий силу всего синапса, но эти параметры при обучении должны настраиваться по-разному и они относятся всё-таки к разным нейронам.

Такое представление нейрона более реалистичное, но при этом оно сильно усложняется, так как теперь предстоит понять, как настраивать все эти параметры при обучении.

Хочу представить мою версию того по какому алгоритму происходит изменения в постсинапсах, то есть дендритных синапсах. Он основан на том, что биологическому нейрону требуется поддержание определённого уровня активности. Дело в том, что нейрон как клетка очень ресурсозатратна для организма, он не может самостоятельно питаться, за него это делают клетки-спутники, глии. Поэтому если нейрон по каким-то причинам не выполняет своих функций, то лучший вариант это избавиться от него в целях эффективности всего организма. При длительном отсутствии активаций в нейроне может запуститься процесс апоптоза, этот процесс активно поддерживают клетки-спутники, буквально разрывая и растаскивая нейрон на части. Поэтому чтобы выжить нейрону в условиях недостаточного источника активаций приходится развивать ветви дендритов, увеличивать чувствительность синапсов на дендритах и иногда даже мигрировать в другие участки (это происходит крайне редко и в определённых условиях), ну или производить спонтанную активность. Об этом свидетельствуют, к примеру, зрительные или слуховые галлюцинации у людей, чьи органы зрения или слуха подвергнуты депривации, или деградации вследствие старения. Об этом подробней пишет Оливер Сакс в своей книге «Человек, который принял свою жену за шляпу».

Оливер Сакс о галлюцинациях

Подвижные нейроны

С другой стороны, чрезмерная активность нейрона также может привести к его гибели. Активность нейрона — это очень сложный процесс, который требует чёткого выполнения множества механизмов, и любой сбой их выполнения приведёт к фатальным последствиям для всей клетки. Если источники активности избыточны, то нейроны начинают процесс деградации некоторых ветвей дендритов и снижения чувствительности своих постсинапсов. Таким образом, нейрон пытается найти некий баланс, в уровне своей активности, регулируя дендритные синапсы. Нейрон, выступающий как самостоятельный агент, действующий в своих интересах, обеспечивает удивительную адаптивность и пластичность всего мозга. Несмотря на парадокс эффективности нейрона, здоровый мозг работает очень слажено, и каждый нейрон играет свою роль. Нейроны зрительных зон коры головного мозга слепых людей благодаря этому механизму будут вовлечены в другие нервные процессы, не связанные с обработкой зрительных образов. А избыточность в количестве нервных клеток делает нервную систему очень надёжной и при повреждении некоторых участков нервной ткани, нейроны могу взять на себя функции и роли потерянных клеток.

Исходя из этой версии, дендритным синапсам отводится роль, влияющая на адаптивные качества всей нервной системы, а не какие-то логические функции которые и определяют когнитивные процессы.

Для изменений в пресинапсах синапсов аксона уже существует алгоритм, так называемое правило Хебба.

Если аксон клетки А находится достаточно близко, чтобы возбуждать клетку B, и неоднократно или постоянно принимает участие в ее возбуждении, то наблюдается некоторый процесс роста или метаболических изменений в одной или обеих клетках, ведущий к увеличению эффективности А, как одной из клеток возбуждающих В.Hebb, D. O. The organization

of behavior: a neuropsychological theory. New York (2002) (Оригинальное издание — 1949) (спасибо)

Привожу здесь полный текст правила Хебба потому, что существует его множество трактовок, меняющих его смысловое значение.

Как видим, акцент отводится нейрону, который передаёт возбуждение, то есть на синапсах аксона, а не дендритных синапсах принимающего нейрона. Пресинапс и постсинапс безусловно влияют друг на друга. К примеру, при дефиците активаций нейрон прежде будет увеличивать чувствительность того постсинапса, который чаще используется. А в случае необходимости снижения уровня активации будут прежде деградировать те постсинапсы, которые использовались реже всего. Это связано с важностью сохранения логики научения при адаптивных процессах.

Если мы хотим создавать искусственную нейронную сеть, то можно пренебречь адаптивными механизмами, всё-таки биологические системы более требовательны к экономии ресурсов каждым элементом, нежели искусственные модели.

Получается, что в основу компьютерных нейронных сетей положена модель нейрона, у которой акценты расставлены наоборот, нежели чем у биологического нейрона. Поэтому и не стоит рассчитывать на качественный результат в развитии этого направления. Но понимая эти проблемы, можно изменить ситуацию, нужно перестроить концепцию нейронных сетей заново, пересмотреть ее, заложив верный фундамент.

Анализ и Синтез

Нейрофизиология это молодая еще не зрелая наука, в ней нет ещё строгих фундаментальных законов подобно законам в физике, хоть в ней присутствуют большое количество теорий и фактов. Мне кажется, такими законами могут являться постулаты и принципы рефлекторной теории Ивана Петровича Павлова. Их можно сравнивать с законами Ньютона в физике. При создании новых теорий в нейрофизиологии мы должны задаваться вопросами: как в рамках нашей теории происходят и формируются рефлексы, а также как проявляются процессы синтеза и анализа.

Анализ и синтез требуют отдельного внимания. Эти понятия кажутся очень абстрактными, но это конкретные процессы которые протекают в нервной системе. И.П. Павлов считал, что анализ и синтез непрерывно протекают в коре головного мозга. Эти процессы являются базой для когнитивной деятельности. Я попытаюсь доступно донести, что это за процессы, это очень важно для того, чтобы воссоздать когнитивные процессы в нейронных сетях.

Синтез – это механизм объединения, обобщения различных признаков в один образ или действие.

Пример из экспериментов И.П. Павлова:

Специально подготовленному модельному животному – собаке, изолированной от иных внешних раздражителей и обездвиженной (заневоленой) при кормлении включают звук метронома, который ранее для неё был индифферентен, безразличен. После нескольких таких сочетаний у собаки выработается условный рефлекс, то есть на звук только метронома у модельного животного может вырабатываться желудочный сок, как при кормлении.

Анализ – это механизм выделения, ранжирования (предания рангов, значимости) каждого признака из ограниченного набора признаков.

Пример из работ И.П. Павлова:

Ранее обученному модельному животному, у которого сформирован условный рефлекс на звук метронома выработка желудочного сока, меняют условия эксперимента, теперь животные получает пищу при звуке метронома 120 ударов в минуту, а при звуке 160 ударов в минуту не будут подкреплять ничем. Сначала выученный пищевой условный рефлекс срабатывал на оба звука метронома, но стечением множества повторений, причём значительно большего количества раз, чем при эксперименте с синтезом, собака начинает различать эти два очень сходных раздражителя и перестает реагировать на звук метронома с частотой, которая не подкреплялась.

Давайте качественно сравним эти два когнитивных процесса.

Синтез – это относительно быстрый механизм потому, что требует малого количества примеров, в свою очередь, Анализу требуется значительно больших повторений. Синтез может протекать в некоторой пассивной форме, то есть здесь главное одновременное сочетание раздражителей или признаков, чтобы их можно было объединить. Для Анализа всегда требуется эмоциональное подкрепление или некая обратная связь, которая будет определять, каким признакам повысить или понизить важность, ранг. Синтез всегда предшествует Анализу, то есть признаки должны сначала быть объедены в группу, внутри которой уже может производиться ранжирование (процесс анализа).

Анализ всегда приводит к сокращению количества ошибок, так как придаёт данным дополнительную информативность: ранги или значимость отдельных признаков. Чистый Синтез создаёт множество ошибок, так как приводит к снижению информативности исходных данных, объединив, обобщив их в единые группы.

Теперь вооружившись пониманием этих процессов, проанализируем компьютерные нейронные сети на их наличие.

Обратное распространение ошибки – это чистый Анализ, это процесс ранжирования входов нейронов по результатам работы всей нейронной сети. Синтеза как механизма в нейронных сетях нет. У каждого нейрона изначально уже сформирована группа входов, эта группа никак не меняется в процессе научения по принципу Синтеза. Может возникнуть ложное представление присутствия Синтеза в нейронных сетях благодаря их возможности классификации данных, но это результат работы механизма Анализа над данными. Синтез это способность обобщения, слияния данных, а не объединения в группы по общим признакам.

Как следствие, высокой способности к обобщению, которая свойственна человеческому интеллекту, так сильно не хватает компьютерным нейронным сетям, и это компенсируется необходимостью использовать большое количество примеров при обучении.

Надо понимать, что у алгоритмов, в которых присутствует акцент на Анализе, всё равно будет существовать преимущество в определённых задачах. К примеру, в задаче поиска закономерностей в большом количестве данных, или распознавании лиц из миллионной базы с современными нейронными сетями не сравнится уже никакой алгоритм. Но в задаче, где требуется применять опыт, полученный на небольшом количестве примеров в различных и разнообразных ситуациях, к примеру, задача автопилота, то здесь требуются другие новые алгоритмы, основанные на Синтезе и Анализе, подобно тому, как это происходит в мозге.

Вместо заключения

То, чем я занимаюсь – это поиск новых алгоритмов, это создание моделей, основанных на вышеизложенных принципах. Я вдохновляюсь изучением биологического мозга. Этот путь проходит через череду неудач и заблуждений, но с каждой новой моделью я получаю ценный опыт и становлюсь ближе к своей цели. В будущем я постараюсь поделиться некоторым своим опытом на примере разбора конкретных моделей. Разберем, как на практике я применяю свои знания о нервной системе.

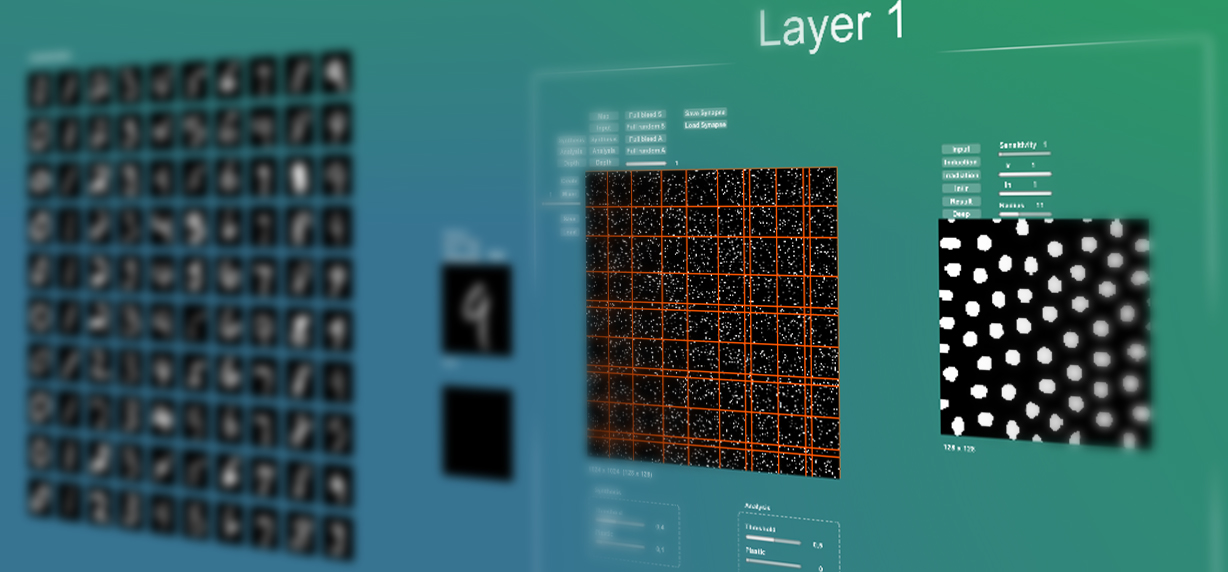

Сейчас я поставил себе задачу создать алгоритм нейронной сети, которая сможет различать рукописные цифры из стандартного набора MNIST, причём при обучении должно использоваться не более 1000 примеров и предъявлений. Результат я буду считать удовлетворительным при хотя бы 5% ошибке. Я уверен это возможно потому, что наш мозг делает нечто подобное. Напоминаю, что MNIST содержит 60 000 примеров обучения, которые для настройки нейронной сети могут предъявлять по несколько десятков раз.

С тех пор, как я стал писать о своих идеях и работе на хабре – гиктаймс, ко мне стали обращаться люди с похожими идеями и стремлениями, люди для кого мои статьи оказались вдохновляющими на собственные изыскания. На меня это также оказывает положительный мотивирующий фактор. Сейчас время возможностей, когда необязательно быть академиком или деятелем науки, чтобы создавать новые технологии или решать фундаментальные задачи. Один из таких искателей, как и я, Николай — он самостоятельно создаёт некую платформу для моделирования нервной системы простейшего животного, проект «Дафния». Проект открыт, и желающие могут подключиться.

In English on Medium: Comparison of the brain with a computer neural network