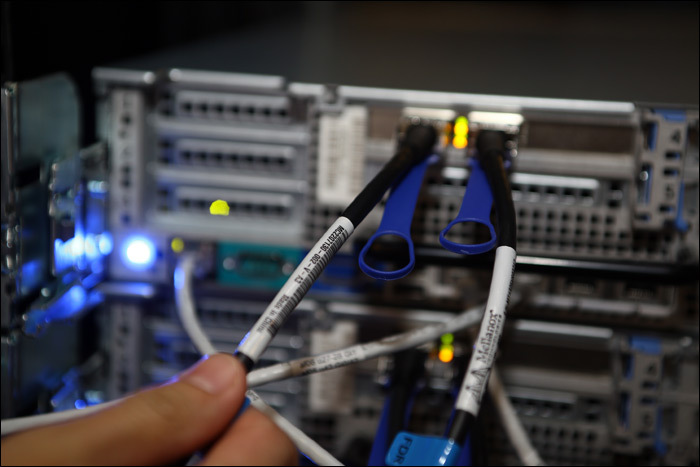

История такая: будучи одной из крупнейших ИТ-компанией на российском рынке ИТ-аутсорсинга и услуг, мы очень часто оказываемся в ситуации поддержки решений на стыке двух-трёх производителей. И когда возникает проблема, например, от которой зависит, заплатят людям вовремя пенсию или нет, в общем случае начинается следующая история:

— Ну что вы, наше железо отлично работает, проблема в ПО, — говорит первый вендор и отправляет ко второму.

— Как можно! Наш софт протестирован, проблема в аппаратной части, — говорит второй и отправляет к первому.

Если на этой стадии начать их знакомить, собирать встречи и объяснять, что надо работать, а не переводить стрелки, то конечные пользователи могут выйти толпой на улицы.

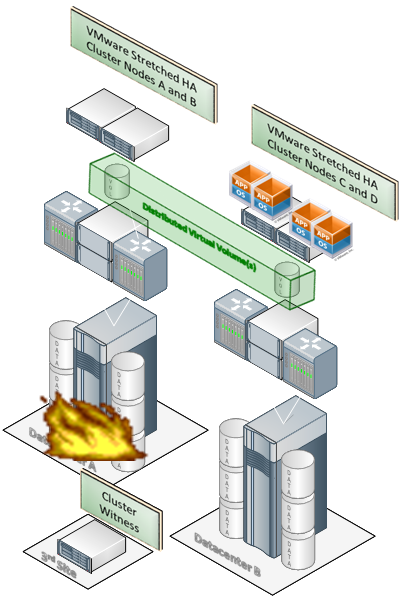

Поэтому работаем вместо них мы. Один раз – даже включенными в кислородно-изолирующие приборы после сработки пожарной сигнализации.