Comments 195

Отлично!!! Буду юзать 100%.

+11

Мне кажется, что ценность бекапов состоит в их быстродоступности. 4-5 часов это перебор.

+10

Потому они и позиционируют это как архивирование, а не как бэкап.

+3

ценность бакапов в их доступности. Основная фигка глаши — то, что бакапы почтинаверняка будут доступны если не дай бог чего-то навернётся.

И хранить по такой цене можно и годичной давности без проблем, если вдруг что-то всплывёт.

И хранить по такой цене можно и годичной давности без проблем, если вдруг что-то всплывёт.

+7

Это не бэкап. Это архив.

+5

Ценность бекапов в бекапах. Когда иного нет, даже 4 часа — спасение.

+16

Ценность бэкапов в их наличии. А этот сервис можно использовать для бэкапов бэкапов, чтобы в случае полной Ж, когда бэкапы тоже потерялись, можно было что-то восстановить.

+2

А мне кажется, что ценность бекапов в том, чтобы не потерять могоголетнюю коллекцию музыки / порно / фильмов / сериалов, на восстановление которой уйдёт месяца так два-три непрерывной работы всё свободное время, при условии что все свои хобби и прочее свободное время препровождения ставится на халт.

К тому же, примерно половину не удастся восстановить вообще, потому что невозможно запомнить все наименования, которые у тебя имелись до крэша, да и скачать/купить заново в хорошем качестве лет 5 спустя не всегда возможно (если мы не говорим о мейнстриме).

Я не говорю уже о фотографиях с каникул и другом личном контенте, который невозможно заново скачать или купить.

Так вот прелесть бэкапа для меня в том, что я не потеряю часть своей жизни. А 4-5 часов я без проблем подожду.

К тому же, примерно половину не удастся восстановить вообще, потому что невозможно запомнить все наименования, которые у тебя имелись до крэша, да и скачать/купить заново в хорошем качестве лет 5 спустя не всегда возможно (если мы не говорим о мейнстриме).

Я не говорю уже о фотографиях с каникул и другом личном контенте, который невозможно заново скачать или купить.

Так вот прелесть бэкапа для меня в том, что я не потеряю часть своей жизни. А 4-5 часов я без проблем подожду.

+2

Работа по восстановлению музыки / порно / фильмов / сериалов кажется настолько творческой, что сам процесс будет увлекательным донельзя. Живенько представил среднего юзера, восстанавливающего часы сериала (подставить свой любимый) — к концу работы он неплохо режиссера заменит )

Это как написать произведение (программу, меледию, что угодно другое), УДАЛИТЬ, и создать то же заново. Второй раз будет куда изящнее :)

Это как написать произведение (программу, меледию, что угодно другое), УДАЛИТЬ, и создать то же заново. Второй раз будет куда изящнее :)

+1

В моём случае я заменю скорее библиотекаря — вся музыка у меня разсортирована по папочкам, каждый файлик переименован в соответствии с правилами оформления аудиотеки. Когда меняются правила, переименовываются и все файлы в аудиотеке. Я уже не говорю про ID3-теги — там всё с точностью до заглавных букв и пунктуации, отдельно прописаны артисты, продюссеры, вокалы. Интро- и прочие skit-треки оформлены соответствующими тэгами (что влияет на отображение в плейлисте Фубара), и т.д.

То же самое относится и к сериям, и к фильмам (но с ними проще) — оформление строго по определённой логике, прописывается дата, название, номер сезона и эпизода а так же последовательный номер эпизода (считая от первого).

Я очень расстроился, когда пол года назад у меня полетел диск с терабайтом медиатеки. Самое обидное, что я тогда специально купил два одинаковых диска (один для полного бекапа первого), но бекап ещё не настроил (т.к. не ожидал, что новый жёсткий диск может полететь в течение месяца, да).

Но вы правы, да: то, что удалось восстановить, стало лучше и чище. Но очень многое я всё-таки потерял. Слава богу, хоть все фотографии были забэкаплены на переносной HDD.

То же самое относится и к сериям, и к фильмам (но с ними проще) — оформление строго по определённой логике, прописывается дата, название, номер сезона и эпизода а так же последовательный номер эпизода (считая от первого).

Я очень расстроился, когда пол года назад у меня полетел диск с терабайтом медиатеки. Самое обидное, что я тогда специально купил два одинаковых диска (один для полного бекапа первого), но бекап ещё не настроил (т.к. не ожидал, что новый жёсткий диск может полететь в течение месяца, да).

Но вы правы, да: то, что удалось восстановить, стало лучше и чище. Но очень многое я всё-таки потерял. Слава богу, хоть все фотографии были забэкаплены на переносной HDD.

0

Я когда-то так старался… Потом понял, что хранить (если про видео) нужно сильно не все, а силы тратить на тупое переименовывание того, что однажды сотру — жаль, нашлось в жизни, на что их потратить еще.

Фото — это да, какие-то личные вещи, старые файлы/проекты — тоже да. Но кино/музыку — поскольку, поскольку могу.

Впрочем, при цене надежного хранения в 1 цент за Гб можно хотя бы личное хранить надежнее вполне можно позволить.

Фото — это да, какие-то личные вещи, старые файлы/проекты — тоже да. Но кино/музыку — поскольку, поскольку могу.

Впрочем, при цене надежного хранения в 1 цент за Гб можно хотя бы личное хранить надежнее вполне можно позволить.

0

UFO just landed and posted this here

Ох data backup provider-ов сейчас набежит…

+9

Быстро бекапы накатить не получится =)

+2

UFO just landed and posted this here

Вот наконец-то я нашел куда залить свой домашний фотоархив. На S3 — слишком дорого.

Мои, примерно, 1ТБ будут стоить на Glacier всего $10 в месяц, против $125 на S3! Куда только теперь деть домашний RAID-5 на 4ТБ? :)))

Мои, примерно, 1ТБ будут стоить на Glacier всего $10 в месяц, против $125 на S3! Куда только теперь деть домашний RAID-5 на 4ТБ? :)))

+8

А можете написать как это сделать? Ну для «тупых», вроде меня. Я бы воспользовался с удовольствием, для вашего же сценария.

+4

В факе «Use the simple Amazon Glacier APIs to upload and retrieve archives». Для этого есть вебморда или утилита?

+2

в панели есть видео www.youtube.com/watch?feature=player_embedded&v=jQR9JpVKc2A

-1

Сам еще не смотрел. Вечером, наверное, буду.

0

Flickr — 25$ в год, неограниченное место под фотографии, прямые ссылки, интеграция с блогплатформами и социальными сетями, и всё такое.

Поддерживается многими программами для обработки фотографий.

Поддерживается многими программами для обработки фотографий.

0

Ага, а что делать с RAW?

+10

Удалять. Равы нужны для возможности обработать фото после съемки, но хранить в них домашний фотоальбом — глупо.

+1

Вы совершенно исключаете вариант «а через год я могу это обработать иначе»?

Ценность негатива в том, что это негатив.

Ценность негатива в том, что это негатив.

+1

RAW — это то, что действительно необходимо хранить. Вы же не удаляете исходники прораммы, после того, как ее скомпилировали и она заработала. Более того, вы ведь, наверняка еще и историю изменений записываете в репозитории. А там могли быть неудачные решения, которые Вы потом переделали. Тем не менее, это все хранится.

Или Вы удаляете исходники?

Или Вы удаляете исходники?

+5

Через н лет вы сможете распечатать ту же фотку не в 20х12, а в, допустим, 100х60.

По-моему, это неплохо)

По-моему, это неплохо)

0

вы даете им право использовать ваши фотографии для своих нужд, насколько я помню, что не всем подходит.

если не проблема, как вариант — яндекс фотки. бесплатно, без ограничения, но очень медленный аплоад.

если не проблема, как вариант — яндекс фотки. бесплатно, без ограничения, но очень медленный аплоад.

+1

вы согласны ждать 3-4 часа чтобы показать свои фотографии друзьям?

0

После полного краха системы — да. готов.

Это именно бэкап. Основное место хранения — все равно домашний компьютер. Но боязнь потерять фотки заставили меня сперва поднять RAID-5 на домашнем сервере, а вот теперь я их с чистой совестью залью на Glacier.

Это именно бэкап. Основное место хранения — все равно домашний компьютер. Но боязнь потерять фотки заставили меня сперва поднять RAID-5 на домашнем сервере, а вот теперь я их с чистой совестью залью на Glacier.

+14

Я согласен ждать 4 часа, чтобы восстановить их. А так они хранятся у меня на винте, но винты умирают и платить еще раз 500 баксов, за восстановление информации я не хочу.

+2

Для показать есть другие сервисы, тем боле что показывать многомегапиксельную фото незачем. А вот залить исходники всех фоток — другое дело.

0

не подскажете пример с нормальной ценой за TB?

0

Если показать друзьям, то вопрос не в стоимости за TB, а в скорости и удобстве действия «найти и показать». Ведь на такой сервис можно залить отобранные и уменьшенные фото. Так что нужен сервис с быстрым download, автосозданием превьюшек, удобным мобильным приложением с грамотным кешем. Тогда TB и не понадобятся.

SugarSync, если не синхронизировать, а лить в папку для бекапа старается стать чем-то подобным.

SugarSync, если не синхронизировать, а лить в папку для бекапа старается стать чем-то подобным.

0

Photobucket неплох. Но с TB вам там не обрадуются. Бэкапьтесь на Glacier

0

slickpic.com?

0

Может быть Вам подойдёт Bitcasa, которая вышла из беты?

Предлагают $10 в месяц, или $99 за год, сейчас по акции — за $69 (для бета-тестеров — $49 с кодом BETATHANKS).

Предлагают $10 в месяц, или $99 за год, сейчас по акции — за $69 (для бета-тестеров — $49 с кодом BETATHANKS).

0

Для показать отлично подходит Дропбокс. Там по умолчанию создана папка Photos. Расшаренные в ней папки с фотографиями будут показываться как галереи с возможностью скачивания.

0

Там есть хитрость:

Таким образом, если мы храним терабайт фоток в Glacier, то в сутки мы можем скачать не более 1000 * 5% / 30 = 1.6 гига бесплатно. В случае превышения включается крайне неинтуитивная формула aws.amazon.com/glacier/faqs/#How_much_data_can_I_retrieve_for_free. Предположим, вы забыли об этом, и скачали 10 гигов за один час, а потом отключились до конца месяца. С вас все равно возьмут (10-1.6/24)*24*30*$0.01 = $71.52.

You can retrieve up to 5% of your average monthly storage (pro-rated daily) for free each month. If you choose to retrieve more than this amount of data in a month, you are charged a retrieval fee starting at $0.01 per gigabyte.

Таким образом, если мы храним терабайт фоток в Glacier, то в сутки мы можем скачать не более 1000 * 5% / 30 = 1.6 гига бесплатно. В случае превышения включается крайне неинтуитивная формула aws.amazon.com/glacier/faqs/#How_much_data_can_I_retrieve_for_free. Предположим, вы забыли об этом, и скачали 10 гигов за один час, а потом отключились до конца месяца. С вас все равно возьмут (10-1.6/24)*24*30*$0.01 = $71.52.

+16

UFO just landed and posted this here

Ну, с другой стороны, если пользователь умен и качает равномерно (на тех же 10 гигах в час – например, выставив лимит скорости в своем софте), то он сможет вытащить весь свой терабайт за 100 часов, заплатив все те же $71.50.

Но если вы нечаянно качнете 100 гигов в час (один любой случайный час), то придется раскошелиться на (100-1.6/24)*24*30*$0.01 = $719.52. На быстром канале надо быть внимательным.

Но если вы нечаянно качнете 100 гигов в час (один любой случайный час), то придется раскошелиться на (100-1.6/24)*24*30*$0.01 = $719.52. На быстром канале надо быть внимательным.

+4

UFO just landed and posted this here

А если скачаете 1 ПБ за час, то Вы таки разоритесь.

+3

Переезжайте практически в любой город с 1млн и больше жителей, будет также.

10Мбайт/с на относительно дешевых тарифах проводных провайдеров (1.5т.р/месяц и меньше).

15-20Мбайт/с тоже обычно вполне доступны.

10Мбайт/с на относительно дешевых тарифах проводных провайдеров (1.5т.р/месяц и меньше).

15-20Мбайт/с тоже обычно вполне доступны.

-5

Может быть всё-таки мегабит, а не мегабайт?

0

Да скачивать из бэкапа действительно не дешево. Но все равно, случай использования этого архива это именно полный крах системы. Когда потерял все. Все что нажито непосильным трудом за 15 лет. Я согласен за это платить деньги, так как надеюсь, что мне этого никогда не придется делать. :))

+3

Не совсем так. Если один раз выкачать 10 гигов, то возьмут чуть меньше, ведь 1.6 на 24 делить уже не надо, количество скачанного в peak hour равно количеству скачанного в peak day. В итоге получается $60.48

0

Извлечение данных тоже бесплатно в пределах 5% среднемесячного объёма хранения, за превышение лимита берут $0,01 за гигабайт.

Т.е. за 1 Тб данных возьмут 0,01*1000=10$. Это даже если забыть про бесплатные. Как вы получили 71 доллар?

Т.е. за 1 Тб данных возьмут 0,01*1000=10$. Это даже если забыть про бесплатные. Как вы получили 71 доллар?

0

Там не просто цент за гиг, а весьма хитрая формула (см. ссылку), так что хрен сразу поймешь, сколько реально придется платить. В данном конкретном случае, вроде, не 71 (у меня около 60 вышло), но и не 10.

+1

ну в принципе это не так и много за 1 ТБ данных. Полезный сервис

-1

60-70 — это не за 1Т, а за 10Г. Они считают так:

1. Смотрят отношение скачанного за пиковый час к скачанному за сутки. Если качать равномерно, с постоянной скоростью, то выйдет около 4%. Если все скачать за час, то 100%.

2. Дальше они берут дневной лимит — 5% от общего объема, деленные на 30 дней. Для 1Т это будет около 1.5Г в день бесплатно.

3. Этот лимит умножают на полученные выше 4% (или 100% — как получится). То, что получилось, вычитают из пиковой нагрузки и получают то, за что надо платить. Допустим, вы скачали весь свой терабайт за сутки. Около 40Г в час. Получится, что платить вы должны за 40-1.5*4% = практически все 40Г в час. Если вы сумели выкачать весь терабайт за час, то чуть лучше — платите только за 38.5Г (40 — 1.5*100%).

4. Ваш почасовой объем умножают на число часов в месяце (720) и на 1 цент — цену гигабайта. Получают почти 300 баксов. Это ваш счет.

Конечно, не слишком много за ценные данные. Но и не так уж мало — каждый день не повосстанавливаешь. Кроме того, если повнимательнее посмотреть на цены, то окажется, что они начинаются от 1 цента за гиг, но не ограничиваются этим. Скидки за опт.

aws.amazon.com/glacier/pricing/

Например, если вы вытащили меньше 10Т, то цена будет 12 центов за гиг. С учетом посчитанного выше, это уже не 300 баксов за терабайт, а 3000. Либо будете скачивать свой архив медленно и печально — по 5% в месяц. За полтора года, глядишь, управитесь.

Вобщем, для личного использования, мне кажется, не самый подходящий сервис.

1. Смотрят отношение скачанного за пиковый час к скачанному за сутки. Если качать равномерно, с постоянной скоростью, то выйдет около 4%. Если все скачать за час, то 100%.

2. Дальше они берут дневной лимит — 5% от общего объема, деленные на 30 дней. Для 1Т это будет около 1.5Г в день бесплатно.

3. Этот лимит умножают на полученные выше 4% (или 100% — как получится). То, что получилось, вычитают из пиковой нагрузки и получают то, за что надо платить. Допустим, вы скачали весь свой терабайт за сутки. Около 40Г в час. Получится, что платить вы должны за 40-1.5*4% = практически все 40Г в час. Если вы сумели выкачать весь терабайт за час, то чуть лучше — платите только за 38.5Г (40 — 1.5*100%).

4. Ваш почасовой объем умножают на число часов в месяце (720) и на 1 цент — цену гигабайта. Получают почти 300 баксов. Это ваш счет.

Конечно, не слишком много за ценные данные. Но и не так уж мало — каждый день не повосстанавливаешь. Кроме того, если повнимательнее посмотреть на цены, то окажется, что они начинаются от 1 цента за гиг, но не ограничиваются этим. Скидки за опт.

aws.amazon.com/glacier/pricing/

Например, если вы вытащили меньше 10Т, то цена будет 12 центов за гиг. С учетом посчитанного выше, это уже не 300 баксов за терабайт, а 3000. Либо будете скачивать свой архив медленно и печально — по 5% в месяц. За полтора года, глядишь, управитесь.

Вобщем, для личного использования, мне кажется, не самый подходящий сервис.

+12

И правда не дешевый. Только если использовать для очень нужных файлов. Например результаты исследований, опытов, чтобы при потере модно легко восстановить

0

Я набросал простенький калькулятор на Google Spreadsheets , исходя из предположения, что качать будем равномерно круглые сутки.

Желтые поля — ручки, которые крутим, в зеленом поле — результат.

Если хранить 500 Гб и в случае катастрофы быть готовым скачать его за неделю, то счет будет вполне вменяемый.

Желтые поля — ручки, которые крутим, в зеленом поле — результат.

Если хранить 500 Гб и в случае катастрофы быть готовым скачать его за неделю, то счет будет вполне вменяемый.

0

Только у вас по умолчанию стоит 1 цент за гиг, а на таких объемах цена будет 12 центов. Это, конечно, тоже не катастрофа, но уже заметно хуже.

0

Обновил табличку, чтобы она считала без учета download speed (в соответствии с рекомендациями амазона)

0

Так еще хуже выходит. При исходных данных выйдет больше 400 баксов. И это за скачивание маленькой части, а не всего архива. Не, нафиг.

0

Не совсем так. Это цена — «за передачу данных вовне aws региона.

here is no Data Transfer charge for data transferred between Amazon EC2 and Amazon Glacier within the same Region.

Таким образом берем мелкий микро сервер за 2 цента в час. Качаем на него (и подключённый S3 баккет) всё что нужно и оттуда восстановленное утаскиваем. Ну или small — у него свой hdd есть.

Цену за превышение peak hour не снизить, но вот оплату „платажей вовне“ — можно:)

here is no Data Transfer charge for data transferred between Amazon EC2 and Amazon Glacier within the same Region.

Таким образом берем мелкий микро сервер за 2 цента в час. Качаем на него (и подключённый S3 баккет) всё что нужно и оттуда восстановленное утаскиваем. Ну или small — у него свой hdd есть.

Цену за превышение peak hour не снизить, но вот оплату „платажей вовне“ — можно:)

0

Но это сценарий уже явно не для простого пользователя. Собственно, мой пойнт в том, что сервис этот для достаточно больших и толстых потребителей (магазины, банки и т.п.), а не для дома, для семьи.

0

С точки зрения стоимостей/удобства — имхо, вопрос в том как будет поставлено.

На мой взгляд гораздо удобнее sftp на микрик, а дальше микрик будет заливать в glacier.

И веб интерфейс к «retrieve this file/folder».

Надеюсь такие AMI (амазон образы) появятся.

А вот с точки зрения Российского пользователя — в случае если резервная копия на 5-10 террабайт реально понадобится — это всё равно будет качаться не так быстро как хочется :(

Что-то я с амазона ни разу в один поток больше 1.5 мегабайт не смог забрать… (поэтому и говорю про микрик откуда можно даунлоадером качать).

На мой взгляд гораздо удобнее sftp на микрик, а дальше микрик будет заливать в glacier.

И веб интерфейс к «retrieve this file/folder».

Надеюсь такие AMI (амазон образы) появятся.

А вот с точки зрения Российского пользователя — в случае если резервная копия на 5-10 террабайт реально понадобится — это всё равно будет качаться не так быстро как хочется :(

Что-то я с амазона ни разу в один поток больше 1.5 мегабайт не смог забрать… (поэтому и говорю про микрик откуда можно даунлоадером качать).

0

Например, если вы вытащили меньше 10Т, то цена будет 12 центов за гиг. С учетом посчитанного выше, это уже не 300 баксов за терабайт, а 3000.

Это не так. Вы путаете data transfer fee, которая действительно 12 центов за гиг (и падает с объемом), но которая распространяется только на те данные, которые вы скачиваете, и data retrieval fee, которая от цента за гиг, но нигде не указано, сколько она на самом деле.

0

А это имеет значение в случае, когда скачиваются все данные целиком? На самом деле, амазон так запутал описание цен, что понять, сколько реально придется платить, невозможно. Поживем — увидим. Но быть первым не очень хочется.

0

А это имеет значение в случае, когда скачиваются все данные целиком?

Конечно, имеет. $0.12 за гиг вы заплатите в любом случае (и это вам даст $120, если округлять), и это не зависит ни от чего вообще. А вот то, сколько вы заплатите за data retrieval, будет зависеть от кучи факторов (но в основном от того, какого размера у вас архив, и во сколько приемов вы будете его доставать).

0

получается если загрузить 1гб ценной инфы+20гб /dev/null (или для порядку /dev/urandom) в случае краха выйдет дешевле ценную инфу скачать?

+1

You can retrieve up to 5% of your average monthly storage (pro-rated daily) for free each month

По-моему, это означает бесплатные 5% в месяц, а не в день. А pro-rated daily означает, что в каждый день можно выкачать бесплатно 1/30 от этих 5%.

0

То есть 0.01 — это маркетинковый обман.

По честному нужно написать так: оплата не зависит от количества запросов на скачивание в месяц. Учитывается пиковое значение запрошенных вами гигабайт: 1 Гб./час стоит $7,2 доллара за вычетом скидки.

По честному нужно написать так: оплата не зависит от количества запросов на скачивание в месяц. Учитывается пиковое значение запрошенных вами гигабайт: 1 Гб./час стоит $7,2 доллара за вычетом скидки.

0

Не рассматривали как вариант Fotki.com? Для русскоязычных пользователей предоставляет неограниченное место для хранения фотографий, несколько лет уже сливаю туда фотки, думаю, 1Тб уж точно слил )) Заливать можно посредством java через браузер, десктопный софт или фтп. А показывать друзьям можно прямо с сайта или с планшета/телефона, софт под них тоже есть ))

-4

Спасибо, посмотрю. А какова у них надежность? Меня этот вопрос всегда волнует. На сайте навскидку информацию не нашел.

0

Ну, сколько уже использую — ни разу никаких проблем не возникало ))

P.S. Интересно, а почему заминусовали мое сообщение выше? Мда… сколько же здесь мудачья обитает…

P.S. Интересно, а почему заминусовали мое сообщение выше? Мда… сколько же здесь мудачья обитает…

-12

Потому что выглядит, как реклама.

+6

К сожалению, Ваша оценка далека от цифровой формы :)

вот Amazon дает грантию надежности в 11 девяток. На своем домашнем RAID-5 (с бытовыми жесткими дисками) я обеспечиваю, наверное, 5-6 девяток. Что, вообщем, неплохо, но мне мало.

Я почитал, что собой представляет fotki.com. И это решени, однозначно, не то, что мне надо. К тому-же, по ссылке в сообщении от simpel (ниже в этой нити), следует, что они хотят 6 центов за гигабайт, что в шесть раз дороже, чем Glacier.

вот Amazon дает грантию надежности в 11 девяток. На своем домашнем RAID-5 (с бытовыми жесткими дисками) я обеспечиваю, наверное, 5-6 девяток. Что, вообщем, неплохо, но мне мало.

Я почитал, что собой представляет fotki.com. И это решени, однозначно, не то, что мне надо. К тому-же, по ссылке в сообщении от simpel (ниже в этой нити), следует, что они хотят 6 центов за гигабайт, что в шесть раз дороже, чем Glacier.

+3

Ну да, как же жить с такой надежностью, домашний фотоархив пупсегов в опасности!

А вообще, спасибо, прочитал тот пост про фотки.ком и тоже задумался о смене хранилища.

А вообще, спасибо, прочитал тот пост про фотки.ком и тоже задумался о смене хранилища.

-4

5 девяток на домашнем рейде? при наличии множественных точек отказа?

Скорее всего ситуация близка к двум девяткам.

(как амазон насчитал 11 я вообще не могу понять:)

Скорее всего ситуация близка к двум девяткам.

(как амазон насчитал 11 я вообще не могу понять:)

0

Для интереса посчитал:

<a href=«www.pcworld.com/article/129558/study_hard_drive_failure_rates_much_higher_than_makers_estimate.html\»>Average Failure Rate — говорит про 0.88% в год на один диск.

С тех пор ситуация ухудшилась (по данным из внутренних источников у сборщиков) и не изменилась (согласно THG).

Теперь смотрим — 5 жестких дисков с шансом отказа 0.88%. Это значит что один из них умрет с шансом (0.88%*5). Но смерть одного рейд переживает, а вот два — (0.88%*5)*(0.88%*5)

<a href=«www.pcworld.com/article/129558/study_hard_drive_failure_rates_much_higher_than_makers_estimate.html\»>Average Failure Rate — говорит про 0.88% в год на один диск.

С тех пор ситуация ухудшилась (по данным из внутренних источников у сборщиков) и не изменилась (согласно THG).

Теперь смотрим — 5 жестких дисков с шансом отказа 0.88%. Это значит что один из них умрет с шансом (0.88%*5). Но смерть одного рейд переживает, а вот два — (0.88%*5)*(0.88%*5)

0

И даже не отредактировать :(

Калькулировал и оно отправилось:(

Механизм расчётов:

Raid Failure wiki data

Теперь смотрим — 5 жестких дисков с шансом отказа 0.88%. Это значит что один из них умрет с шансом (0.88%*5)=4.4%. Но смерть одного рейд переживает, а вот два одиночный удар молнии — данные не переживут.

Общая математика выглядит так — если у вас в устройстве два компонента с надежностью к девятки 99.99% работают вместе и умирание одного из них приводит к неработоспособности устройства — то надежность устройства три девятки 99.98%. Для того чтобы её увеличить обратно — вместо двух компонентов делают четыре (если позволяет схема) и получают свои четыре девятки обратно.

Прикиньте сами сколько у вас компонентов которые могут прибить данные:

— сгорание матери рейда — регулярно убивает данные на винтах (бывает, что только электронику)

— сдыхание двух винтов. Первого самостоятельно, второго на ребилде. (лично наблюдал как RAID10 из 6 scsi server дисках в 2003 сдох после сдыхание одного из винтов — его парный умер во время ребилда (то есть умерший был заменен на запасной, но массив не смог восстанавится. Итог несколько суток в лабе+часть данных утеряна.)

Вот зарубежная статья на эту непопулярную тему

— бросок напряжения-=>сгорание питальника-=>см выше про мать/электронику.

— бросок напряжения при сдохшей батарейке кеша-=> все железо цело, данных часто нет.

— итп.

6 девяток это когда на на 1 000 000 рейдов только 1 потеряет данные в этом году :)

Судя по процентам отказов, ругани и прочему в интернете — ситуация в порядки хуже (как и должно быть с точки зрения статистики).

Калькулировал и оно отправилось:(

Механизм расчётов:

Raid Failure wiki data

Теперь смотрим — 5 жестких дисков с шансом отказа 0.88%. Это значит что один из них умрет с шансом (0.88%*5)=4.4%. Но смерть одного рейд переживает, а вот два одиночный удар молнии — данные не переживут.

Общая математика выглядит так — если у вас в устройстве два компонента с надежностью к девятки 99.99% работают вместе и умирание одного из них приводит к неработоспособности устройства — то надежность устройства три девятки 99.98%. Для того чтобы её увеличить обратно — вместо двух компонентов делают четыре (если позволяет схема) и получают свои четыре девятки обратно.

Прикиньте сами сколько у вас компонентов которые могут прибить данные:

— сгорание матери рейда — регулярно убивает данные на винтах (бывает, что только электронику)

— сдыхание двух винтов. Первого самостоятельно, второго на ребилде. (лично наблюдал как RAID10 из 6 scsi server дисках в 2003 сдох после сдыхание одного из винтов — его парный умер во время ребилда (то есть умерший был заменен на запасной, но массив не смог восстанавится. Итог несколько суток в лабе+часть данных утеряна.)

Вот зарубежная статья на эту непопулярную тему

— бросок напряжения-=>сгорание питальника-=>см выше про мать/электронику.

— бросок напряжения при сдохшей батарейке кеша-=> все железо цело, данных часто нет.

— итп.

6 девяток это когда на на 1 000 000 рейдов только 1 потеряет данные в этом году :)

Судя по процентам отказов, ругани и прочему в интернете — ситуация в порядки хуже (как и должно быть с точки зрения статистики).

0

А за мудачье еще и карму заминусуют, и будут правы.

+2

Раз тут много комментариев про хранение фоток, могу добавить MosaicArchive.

Cсылку не даю, дабы не посчитали рекламой, кому надо — те загуглят.

У них несколько планов, есть бесплатный. Плюс лайтрум эффекты онлайн.

Единственный пока минус — клиент только под MacOS.

Cсылку не даю, дабы не посчитали рекламой, кому надо — те загуглят.

У них несколько планов, есть бесплатный. Плюс лайтрум эффекты онлайн.

Единственный пока минус — клиент только под MacOS.

0

Можете сказать, чем Flickr pro не устраивает?

0

Зеркалки зло ;))

0

На Glacier не будет произвольного доступа к фото

0

Ууф! Супер! Переезжаем с s3!

+1

Data Transfer OUT First 1 GB / month $0.000 per GB Up to 10 TB / month $0.120 per GB

Значит ли это, что скачивание стоит 12 центов за гиг?

И что это значит 4-5 часов?

То есть чтобы скачать одну фотографию нужно ждать 4 часа?

+1

Это не замена дропбоксу, это сервис, с которого скачивать файлы придётся лишь в исключительных случаях.

+3

Типа того. Скорее всего это большая ленточная библиотека. Задания на скачивание ставятся в очередь, и за 4,5 часа до вашей ленточки доходит черед.

То есть не «одна фотография — 4 часа», а «весь ваш сет будет выложен с лент на HDD — 4 часа». Но если из него нужна одна фотография — да.

То есть это в чистом виде архивное хранение, write only.

То есть не «одна фотография — 4 часа», а «весь ваш сет будет выложен с лент на HDD — 4 часа». Но если из него нужна одна фотография — да.

То есть это в чистом виде архивное хранение, write only.

+3

Там еще хитрее. Они считают не реальный объем, а пиковую скорость скачивания и растягивают ее на целый месяц. Так что цены получаются довольно кусачие. Выше обсуждаем.

0

В целом заманчиво, но все же интересно, а какая будет скорость upload/download

0

ну вообще есть и по выгодней сервисы для бекапа, да еще и с синхронизацией, к примеру Crash Plan — 3$ в месяц Unlimited + кросплатформенная тулза и даже мобильные клиенты CrashPlan Backup Software — Features Comparison

+4

Это смотря сколько данных нужно забэкапить. 3$ в месяц в сравнении с Glacier оправдано, когда вам нужно хранить больше 300 гигов информации. Правда, если это без необходимости иметь возможность моментального доступа к ней.

0

Отличные цены. Вы пользуетесь этим сервисом? Я так понял что нужно заплатить за старт 50 уе и потом 3 ежемесячно. Правильно?

0

не совсем, можно просто за год сразу заплатить, а можно по месячно. За год выгодней немного получается. Сервис отличный, и датацентры по всему миру тоже есть.

+1

все сложнее на самом деле цена $5 в месяц

а что бы получить $3/месяц надо заплатить авансом за 4 года.

а что бы получить $3/месяц надо заплатить авансом за 4 года.

0

Я пользуюсь, скорость удручает, в среднем 1-2 mbit идет загрузка данных, т.е. если очень много данных, это растянется на месяц и больше. Соответственно и скорость восстановления такая же.

0

Я пользуюсь. План CrashPlan+ Family Unlimited. Один аккаунт на все компьютеры (нужно ставить пароль для доступа к самой программе на каждом компьютере). Скорость загрузки до 4Mbit/s (подключение 30/30 mbit/s).

0

Только что записался у них на триальный месяц. Upload идет на скорости 3 мегабита в секунду – вот это немного напрягает. Конкуренты Backblaze быстрее, вроде бы; но у них, наверное, замучаюсь в клиенте указывать ограничения, что НЕ бакапить (в моем случае нужно бакапить реально только пару больших каталогов).

0

Добавьте в пост информацию, что для того, чтобы получить закачанный архив/файл, нужно инициировать job по извлечению файла, которая обычно занимает 3.5-4 часа, и только потом можно уже файл скачать. Чтобы излишней эйфории не возникало :)

0

Хм, интересно. Возможно перенесу свой фото архив на двух десятках двд-дисков.

0

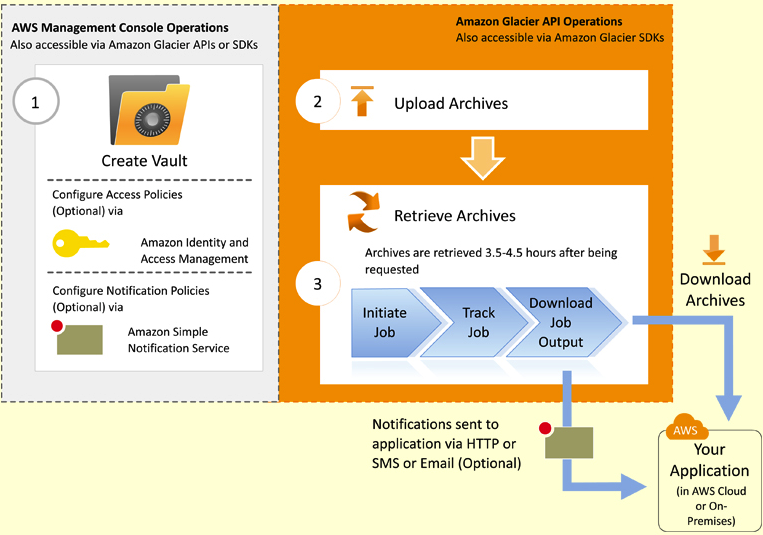

Вот схема работы:

+2

Ждем статью по автоматическому архивированию данных с домашнего ПК. Заливал бы туда на автомате содержимое фото-архива.

+3

около 30-32 копеек за гиг. ШИКАРНО!

-1

Кстати, они обещают очень полезную плюшку:

In the coming months, Amazon Simple Storage Service (Amazon S3) plans to introduce an option that will allow you to seamlessly move data between Amazon S3 and Amazon Glacier using data lifecycle policies.

То есть, в недалеком будущем можно будет настроить временное хранение на S3, например, первые 30 дней, а потом с него перекидывать на Glacier. Все автоматом. То есть, для многоих, кто уже бэкапиться на S3, даже не надо будет переделывать схему бэкапов. Всего несколько кликов мыши чтобы удешевить и/или продлить время хранения файлов.

(Я сейчас, как раз таки, бэкаплю сайтик на S3, с временем хранения файлов 30 дней).

In the coming months, Amazon Simple Storage Service (Amazon S3) plans to introduce an option that will allow you to seamlessly move data between Amazon S3 and Amazon Glacier using data lifecycle policies.

То есть, в недалеком будущем можно будет настроить временное хранение на S3, например, первые 30 дней, а потом с него перекидывать на Glacier. Все автоматом. То есть, для многоих, кто уже бэкапиться на S3, даже не надо будет переделывать схему бэкапов. Всего несколько кликов мыши чтобы удешевить и/или продлить время хранения файлов.

(Я сейчас, как раз таки, бэкаплю сайтик на S3, с временем хранения файлов 30 дней).

+1

Ценнейшая возможность. Облазил сайт, но ни web-морды, ни какого-то другого клиента не нашел. Только документация для разработчиков.

Я так понял, что пока нужно ждать появления (писать самостоятельно) официальных или сторонних клиентов и прочих средств для перекидывания информации.

Я так понял, что пока нужно ждать появления (писать самостоятельно) официальных или сторонних клиентов и прочих средств для перекидывания информации.

+2

Очень ждем клиентский софт(для домашних пользователей) аля google drive/dropbox чтобы туда было удобно перекидывать файлы.

0

Перекидывания с S3 на Glacier пока нет: «In the coming months...»

А для загрузки на Glacier есть API. Вечером дома посижу, возможно, сделаю простенькую утилиту для загрузки файла в хранилище.

А для загрузки на Glacier есть API. Вечером дома посижу, возможно, сделаю простенькую утилиту для загрузки файла в хранилище.

0

Прекрасная новость! Очень буду ждать ввода в эксплуатацию.

Проблема бэкапа личных данных встала для меня уже давно. Сначал долго хотел начать работать в spideroak, но когда гугл вышел со своим диском, я всё-таки прикупил у него несколько сотен ГБ. И пока вроде нет лучших альтернатив.

Проблема бэкапа личных данных встала для меня уже давно. Сначал долго хотел начать работать в spideroak, но когда гугл вышел со своим диском, я всё-таки прикупил у него несколько сотен ГБ. И пока вроде нет лучших альтернатив.

0

Для бекапа crashplan неплох. Для синка dropbox. А гугл пока далеко не столь удобен.

0

спасибо, раньше не видел этот сервис. Он надежный? Там реально безлимитное место? Почему? Я не понял почему они предлагают Unlimited. До этого я видел подобные сервисы, но они все были фэйковыми.

0

Супер!

Только вчера посыпался домашний WD Book live, буду оставшиеся фотки (порядка 150 Гб) сливать сюда.

Только вчера посыпался домашний WD Book live, буду оставшиеся фотки (порядка 150 Гб) сливать сюда.

0

Интересно, как это физически реализовано. Они отключают диски от компьютера, отвозят на склад, а потом привозят обратно? Тогда была бы логична задержка в 3-4 часа до восстановления данных.

0

Йес! Вот куда я все RAW солью! :)

0

Почему-то никто не вспомнил про Bitcasa. За скромные деньги обещают полный безлимит (пока бесплатная бета), в т.ч. можно делать бекап.

0

вот куда я закачаю все равы!

-1

4.5 часа ждать, да не вопрос. Когда умерла плата на диске со всем добром, месяц ждал, хорошо что вобще донора нашел.

+1

А можете объяснить пошагово непрограммисту, что именно нужно сделать, чтобы таки закачать свои файлы на этот сервис?

Ну и потом получить их обратно.

Ну и потом получить их обратно.

+1

Пока инструкция для непрограммиста выглядит так: «Пригласить программиста, показать ему страницу docs.amazonwebservices.com/amazonglacier/latest/dev/introduction.html — пусть напишет вам программу для пересылки файлов».

Но ситуация должна улучшиться в самое ближайшее время, мы наверняка увидим много различных инструментов.

Но ситуация должна улучшиться в самое ближайшее время, мы наверняка увидим много различных инструментов.

+1

Ну я так понимаю, скрипты ведь всё равно типичные должны быть для этих действий, только идентификаторы менять клиентов. Или нет?

Тогда почему просто готовый скрипт не выложили разработчики? Или тут вот до сих пор почему б не выложить, кто использует?

Можете объяснить, в чём трудность и чего я не понимаю?

Тогда почему просто готовый скрипт не выложили разработчики? Или тут вот до сих пор почему б не выложить, кто использует?

Можете объяснить, в чём трудность и чего я не понимаю?

0

Подождать месяц-другой, пока появятся дружественные пользователю бекап-клиенты с бакэндом на этот сервис. А они появятся.

0

Я один параноик, боюсь сливать личные данные в чужое облако?

0

Вопрос перспективы. Если не потерять данные важнее, чем если они попадут в ненужные руки, то Глаша — самое то. Я думаю, что с такими архитекторами — Амазон еще и секурный сервис какой-то придумают. Кроме того, если вы будете шифровать свои данные, то и доступа к ним не будет.

Почему не строят датацентры около Енисейской ГЭС? Или Саяно-Шушенской? Это же золото под ногами!

Почему не строят датацентры около Енисейской ГЭС? Или Саяно-Шушенской? Это же золото под ногами!

0

Простите, Вы серьезно со своим вопросом?

ru.wikipedia.org/wiki/Авария_на_Саяно-Шушенской_ГЭС

ru.wikipedia.org/wiki/Авария_на_Саяно-Шушенской_ГЭС

0

потому что срок окупаемости слишком большой. да и вообще не факт что окупится. + это же Россия.

0

А деньги вы свои тоже исключительно в наволочке дома храните, или все же банку доверяете?

+4

Вот интересно получается — если хранить 1Tb, то фактически за полгода набегает стоимость одного терабайтного USB жесткого диска. Поэтому, думаю, что если страховаться от, например, физической поломки основного диска (а не например пожара в квартире), то USB-шный диск для бэкапа все-же выгодней и удобней. (по крайней мере для объемов вроде сотен гигов-пара терабайт)

+3

Наполнил диск и в банковскую ячейку, и тогда пажары и другие беды в доме не страшны

0

Есть проблема, и состоит она в том, что диск может внезапно перестать читаться. Поэтому положить его и забыть на год — нельзя.

0

Это очень маловероятно, что основной диск накроется и бэкап одновременно с ним.

0

Вы готовы доверить свои данные этой вероятности?

0

Вполне. Грубо говоря, если считать, что вероятность отказа диска 10% за три года, и что после отказа основного диска вы в течение недели пользуетесь диском с бэкапа, то вероятность полной потери данных 0.1*0.1*7./365/3 = 0.006% за три года. Я готов этому довериться.

0

Скажите, а вы все эти три года диск не трогаете и данные на нем не обновляете?

0

Почему, обновляю конечно. Только формуле это без разницы. Формула считает, какова вероятность, что в течении недели упадут оба диска — она она очень мала.

0

Формула считает, какова вероятность, что в течении недели упадут оба диска — она она очень мала.

Удивительно тогда, почему в пятых рейдах (которые как раз страхуют от потери одного диска) это случается достаточно часто, чтобы люди ставили spare?

0

RAID на серверах — это все же нечто другое, потому что там во-первых постоянная загрузка, плюс к тому перестройка контрольных сумм на работающем сервере — тяжелая операция и долго занимает. Но и самое главное, обычно у людей RAID5 не из 2х дисков, а из большего количества. В таком случае действительно риск растет, чем больше дисков в рейде.

В домашней же ситуации при работе с усб-шным диском и при обратном копировании с него обратно на основной компьютер, риск потери абсолютно обыкновенный (те же 10 процентов за 3 года, грубо говоря).

В домашней же ситуации при работе с усб-шным диском и при обратном копировании с него обратно на основной компьютер, риск потери абсолютно обыкновенный (те же 10 процентов за 3 года, грубо говоря).

+1

Есть ненулевая вероятность того, что оба диска вылетят, например, от сошедшего с ума блока питания, скачка напряжения, и так далее. Да, если жесткий диск внешний, тогда вероятность будет гораздо меньше.

+1

Бекап накрывается от старости, но вы про то не знаете — он же в банковской ячейке лежит. Потом (через несколько месяцев) накрывается основной диск. Идёте за бекапом, упс.

0

Поэтому как раз желательно бэкапится регулярно, согласен. Хотя тут надо смотреть — я просто не знаю, какие вероятности отказа дисков, которые редко используются — понятно, что в них несколько компонентов: вероятность, как ф-ия возраста, как ф-ия количества проработанных часов, как ф-ия количества включений-выключений

0

Ну а кто-нибудь-то уже воспользовался этим сервисом и закачал свои файлы туда?

0

Реквестирую написание утилиты, сливающей образ раздела целиком в Glacier по расписанию.

+2

напомнило старую гугловскую идею сделать «медленное» хранилище данных на луне на солнечных батареях с 8-ми минутным пингом. кому интересно — погуглите. Но видимо отказались, поскольку в последнее время не слышно ничего про идею эту.

+1

Сделал я утилиту по их примеру. Файлы зкачиваются, получаю их идентификатор. Но в AWS консоли не отображается размер и количество архивов. Написал запрос в тех поддержку. Позже буду попробую реализовать загрузку их Glacier. Но что-то уже сомнения есть. По моему, у них косяк. Надеюсь, что только с отображением в консоли.

+2

Исходный текст, кому интерсно на github.

+1

Спустя 18 часов, один мой архив (самый первый закачанный), наконец-то отобразился в AWS консоли. Похоже у них инвентаризация закачанных архивов не мгновенная, а по расписанию. Вот теперь можно с чистой совестью реализовывать download.

Будет собранный jar, следите за обновлениями на GitHub. Будет, наверное, и статья как этим пользоваться.

Будет собранный jar, следите за обновлениями на GitHub. Будет, наверное, и статья как этим пользоваться.

+1

Вообще про инвентаризацию все написано в FAQ:

Q: Can I see what archives I have stored in Amazon Glacier?

Yes. Although you will need to maintain your own index of data you upload to Amazon Glacier, an inventory of all archives in each of your vaults is maintained for disaster recovery or occasional reconciliation purposes. The vault inventory is updated approximately once a day. You can request a vault inventory as either a JSON or CSV file and will contain details about the archives within your vault including the size, creation date and the archive description (if you provided one during upload). The inventory will represent the state of the vault at the time of the most recent inventory update.

0

UFO just landed and posted this here

Если не в машинном зале ЦОДа стоят, то у вас гораздо меньше девяток.

0

Пожар, протечка воды у соседей сверху, воры, авария на электрической подстанции, молния и, ала-улю, всех ваших девяток как ни бывало.

Надёжность, это «чуть-чуть» сложнее, чем банальное дублирование с зеркалированием.

Надёжность, это «чуть-чуть» сложнее, чем банальное дублирование с зеркалированием.

0

UFO just landed and posted this here

Сервер на другом конце города тоже относится к домашней системе?

0

UFO just landed and posted this here

При чем здесь амазон? Он, вроде, не называет свое хранилище домашним. А вы утверждаете, что ваша домашняя система дает кучу девяток. При это, внезапно, идет дублирование на другой конец города. Большой же у вас дом. :)

0

Это уже совсем не «под ногами». Да, это несколько повышает безопасновсть ваших данных, но не так, чтобы сильно.

Никто не спорит, что можно сделать достаточно надёжное хранилище и вручную, но, как правило, это и затратно и хлопотно. А тут уже всё есть. Вопрос, как обычно, сводится к выбору между временем и деньгами. А тут уже у каждого всё может быть сильно по-разному.

Никто не спорит, что можно сделать достаточно надёжное хранилище и вручную, но, как правило, это и затратно и хлопотно. А тут уже всё есть. Вопрос, как обычно, сводится к выбору между временем и деньгами. А тут уже у каждого всё может быть сильно по-разному.

0

Хранить надежно один байт бесконечно проще.

Когда речь идет о сотнях гигабайт, возникает очень много проблем, в т.ч. повреждение данных во время восстановления, устаревшие копии и т.д. Всё-таки в реальном времени большой объем не реплицируешь. Так что надежность всегда надо соотносить с объемом, которые под этой надежностью они готовы хранить.

Когда речь идет о сотнях гигабайт, возникает очень много проблем, в т.ч. повреждение данных во время восстановления, устаревшие копии и т.д. Всё-таки в реальном времени большой объем не реплицируешь. Так что надежность всегда надо соотносить с объемом, которые под этой надежностью они готовы хранить.

0

Кто-нибудь разобрался, что называется «скачиванием из Glacier»? Какая именно скорость их колышит — объём запрошенный на скачивание, или скачивание запрошенного?

Так как запрошенное доступно для скачивания в течение суток, + подготовка 3-5 часов — становится совсем не ясно как это добывать оттуда и что именно считается

Так как запрошенное доступно для скачивания в течение суток, + подготовка 3-5 часов — становится совсем не ясно как это добывать оттуда и что именно считается

0

Ну была же уже в этих комментах ссылка:

forums.aws.amazon.com/message.jspa?messageID=374065#374065

forums.aws.amazon.com/message.jspa?messageID=374065#374065

0

UFO just landed and posted this here

Как везде в AWS, пользователь оплачивает только тот объём ресурсов, которые реально использует, никакой абонентской платы и прочих хитростей.

Есть и некоторые другие особенности, см. FAQ.

Две цитаты из поста. Мне тут видится явное противоречие.

Судя по комментариям хитростей тут намного больше чем при использовании обычного хостинга.

0

Вот ребята сделали Windows версию клиента CMD и UI для Amazon Glacier www.magora-systems.com/portfolio/windows-client-for-amazon-glacier-cmd-and-ui-versions/

+1

Час назад прочитал статью и тут же зарегистировался. Чуть позже зашел чтобы попробовать что-нибудь залить, с тех пор прошло полчаса, а я так и не понял как использовать сервис. Я не программист, конечно, но как минимум продвинутый пользователь, у меня никогда не уходило больше 5 минут, что начать использовать новую программу или сервис. А тут я просто не знаю что делать, пойду читать Гугл. Представляю, если бы моя мама попробовала забекапить семейные фото на Амазоне.

0

Sign up to leave a comment.

Amazon Glacier: хранилище данных по $0,01 за 1 ГБ в месяц