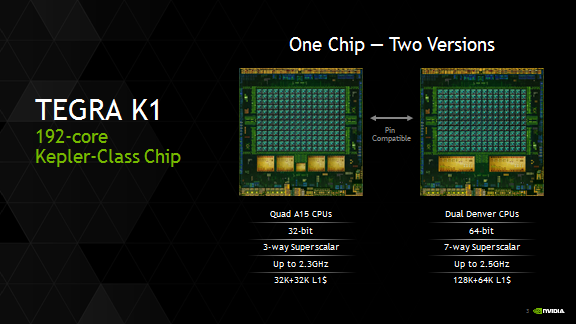

Компания NVIDIA представила новый процессор Tegra K1 еще в январе, на Хабре была соответствующая публикация. Тогда было известно о 32-разрядном четырех-ядерном Cortex-A15 процессоре. Говорилось и о том, что будет выпущен 64-разрядный процессор с двумя ядрами Denver собственной разработки от NVIDIA.

Вчера в блоге компании появилась более подробная информация о второй разновидности чипа, можно сказать, состоялась официальная презентация этого процессора.

К сожалению, точные сроки появления этого чипа не называются, но характеристики процессора все же представлены. Так вот, 64-разрядная версия Tegra K-1 «заточена» под работу с новой ОС Android L (разработчики утверждают, что производительность двух-ядерного процессора Tegra K-1 выше, чем у «мобильных» четырех и восьмиядерных процессоров). При этом обе версии процессора имеют совместимые контактные площадки, поэтому материнские платы не требуют переделки.

Tegra K-1 с Denver предназначаются, в первую очередь, для работы с «тяжелыми» приложениями, включая игрушки, а также с не менее «тяжелым» медиаконтентом.

Что касается двух ядер Denver, то к ним прибавляется и 192 ядра CUDA графической подсистемы Kepler, что позволяет за один такт обрабатывать семь инструкций, а также сохранять используемые чаще всего участки программного кода в 128 МБ буфере. Этот процесс назван Dynamic Code Optimization. Каждое из двух ядер включает 128 КБ 4-way L1 instruction cache, 64 КБ 4-way L1 data cache, и 2 МБ 16-way L2 cache.

По словам разработчиков, 64-разрядные процессоры весьма энергоэффективны, чипы работают, используя динамическое изменение как частоты, так и напряжения. Разработчики также утверждают, что такие процессоры сравнимы по производительности с Apple A7 или Celeron 2955U/Haswell.

Устройства на базе 64-bit Tegra K1 будут выпущены уже в этом году, правда, дата выхода таких устройств и их описание не предоставлено.

Via nvidia