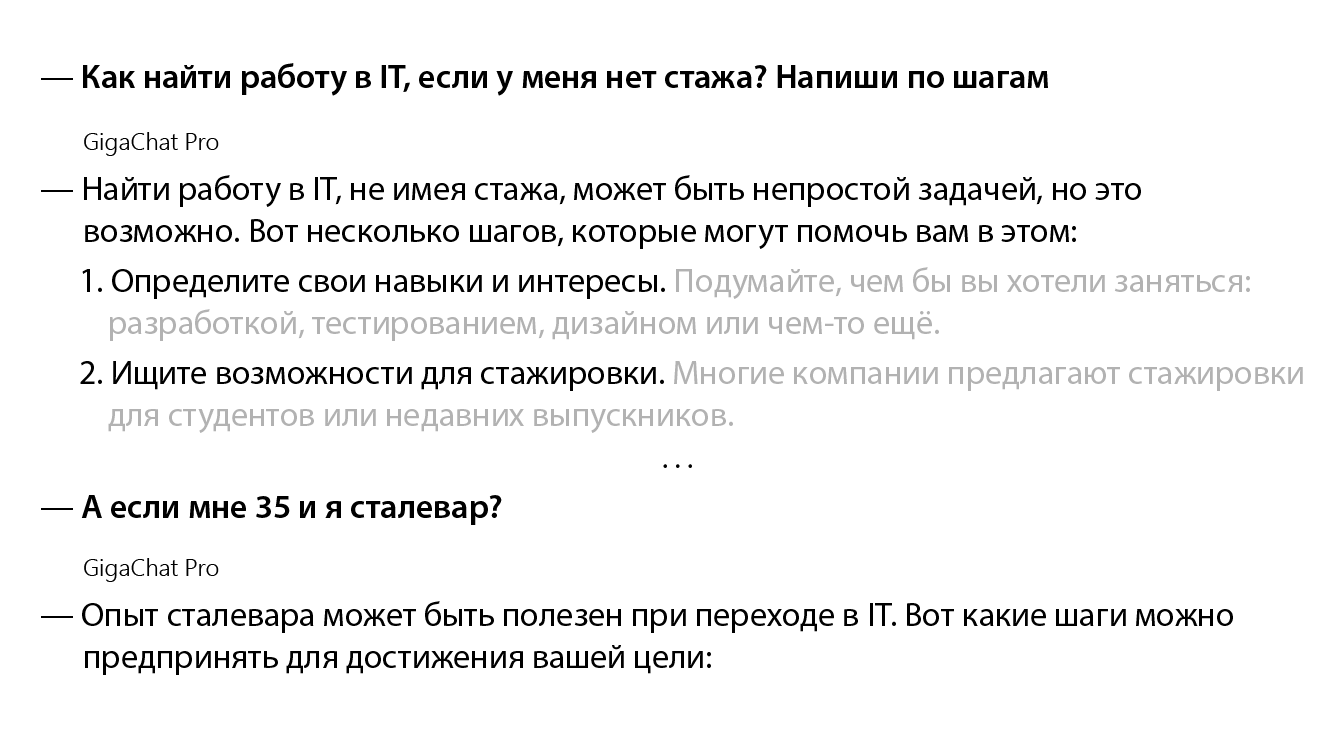

GPT стремительно ворвался в нашу жизнь и разделил аудиторию на две неравные части: технооптимистов и технопессимистов. Как ни странно, технопессимисты — это преимущественно профессионалы, способные трезво оценить результат, который демонстрирует GPT. А технооптимисты — люди, не достигшие вершин профессионализма. Их завораживает та лёгкость, с которой GPT генерирует тексты, картинки и видео на самые разные темы.

Споры относительно пользы или вреда от использования GPT не утихают. Я же хочу предложить вашему вниманию альтернативный взгляд: дело не в самом инструменте, а в способах его использования.

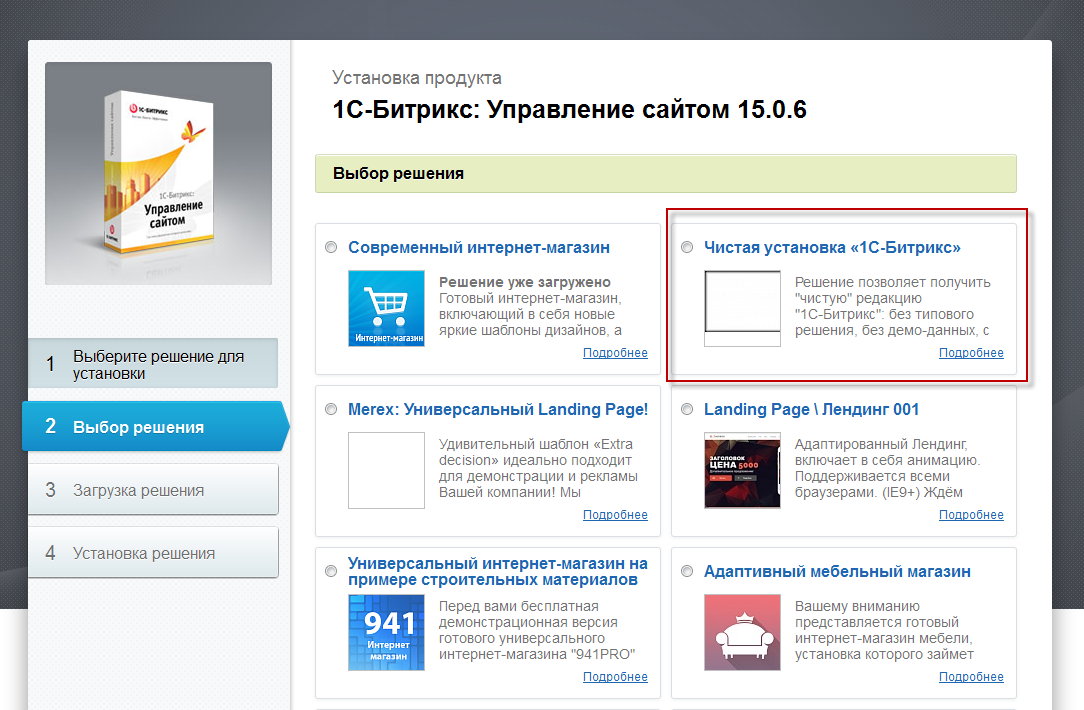

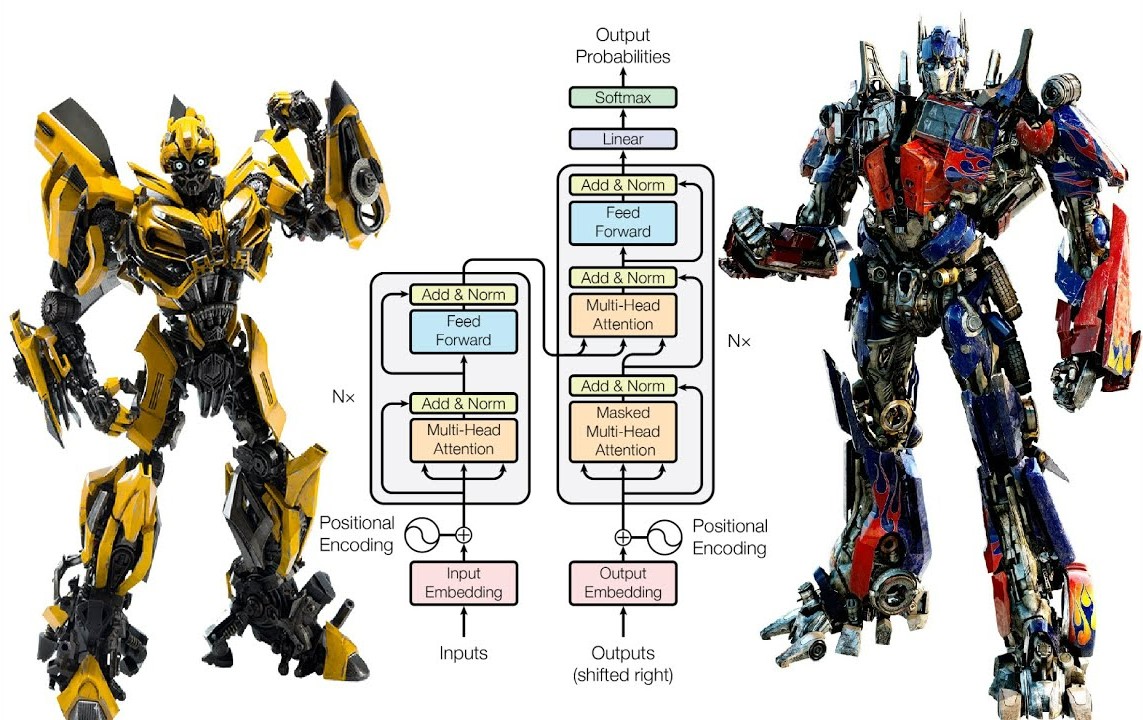

В этой статье я расскажу, как профессионалы усиливают свою мощь, задействуя интерактивные возможности GPT.