Лучшие тактильные возможности, а не только зрение, позволят роботам брать любой объект.

Простейшая задача по поднятию чего-либо не такая простая, как кажется на первый взгляд. По крайней мере, для робота. Разработчики роботов стремятся создать механизм, который сможет поднять что угодно – но сейчас большинство роботов выполняют «слепое хватание» и предназначены для поднятия заданного объекта с одного и того же места. Если что-то поменяется – форма, текстура, положение объекта, то робот не будет знать, как на это реагировать, и попытка поднять предмет провалится.

Роботы ещё долго не смогут идеально взять любой объект с первой попытки. Почему захват представляет собою такую сложную проблему? Когда люди пытаются взять что-либо, они задействуют комбинацию чувств, из которых основными выступают визуальные и тактильные. Но пока что большинство попыток решить проблему захвата опиралось лишь на зрение.

Такой подход вряд ли приведёт к результатам, сравнимым с человеческими возможностями, поскольку, хотя зрение играет важную роль в захвате предметов (например, необходимо прицелиться на нужный объект), зрение не может дать вам всю информацию о захвате. Вот как Стивен Пинкер [Steven Pinker] описывает возможности осязания. «Представьте, что вы поднимаете пакет молока. Если взять его слишком слабо, он упадёт; слишком сильно – он помнётся; а покачав пакет, вы сможете даже оценить количество молока внутри!»,- пишет он в книге «Как работает сознание» [How the Mind Works]. У робота нет таких возможностей, посему они отстают от людей в простейших задачах «поднять и переложить».

В качестве ведущего исследователя группы тактильных и мехатронных разработок в лаборатории École de Technologie Supérieure’s Control and Robotics (CoRo) в Монреале,

(Канада), я давно отслеживаю самые выдающиеся достижения в методике захватов. И я убеждён, что текущая концентрация на компьютерном зрении не даст возможности создать идеальную систему захвата. Кроме зрения, для будущего роботизированных захватов необходимо ещё и тактильный интеллект.

Предыдущие исследования концентрировались на зрении, а не на тактильном интеллекте

Пока что большинство исследований направлено на создание ИИ, основанного на визуальной обратной связи. Это можно сделать, например, через поиск совпадений в базе данных – такой метод используется в лаборатории Брауна Humans to Robots Lab в проекте Million Objects Challenge. Идея в том, что робот использует камеру для поиска нужного объекта и отслеживает свои движения при попытке захвата. В процессе робот сравнивает визуальную информацию с трёхмерным изображением из базы. Когда он находит совпадение, он может подобрать правильный алгоритм для текущей ситуации.

Подход Брауна направлен на сбор визуальных данных для разных объектов, но вряд ли разработчики роботов когда-нибудь смогут составить визуальную базу для всех объектов, которые может встретить робот. Более того, подход с поиском по БД не включает нюансы текущего окружения, поэтому не позволяет роботу адаптировать свою стратегию захвата в разных контекстах.

Другие исследователи обратились к технологиям машинного обучения для улучшения захватов. Эти технологии позволяют роботам обучаться на опыте, так что, в конце концов, робот подберёт наилучший способ схватить что-либо самостоятельно. В отличие от подхода с БД, для машинного обучения нужно мало изначальных данных. Роботам не надо получать доступ к готовой базе – им нужно лишь много тренироваться.

В журнале уже писали, как Google провёл эксперимент с технологиями захвата, комбинировавший компьютерное зрение и машинное обучение. В прошлом исследователи пытались улучшить систему захвата, обучая робота следовать человеческому выбору метода для этого. Крупнейший прорыв Google был в том, что они показали, как роботы обучаются самостоятельно – используя глубокую свёрточную нейросеть, систему зрения и очень много данных (собранных с 800 000 попыток захвата), чтобы улучшаться на основе прошлого опыта.

Результаты чрезвычайно многообещающие: поскольку реакция роботов не была запрограммирована заранее, все их успехи появились благодаря обучению. Но у возможностей помощи зрения процессу захвата есть ограничения, и Google уже, возможно, подошёл к их границам.

Концентрация исключительно на зрении приводит к проблемам

Существует три причины, по которым задачи, преследуемые Google и другими командами, тяжело решить, работая исключительно со зрением. Во-первых, у зрения есть множество технических ограничений и даже самые лучшие из этих систем испытывают затруднения с распознаванием объектов в особо сложных условиях (полупрозрачные предметы, отражения, малый цветовой контраст) или слишком тонкие объекты.

Во-вторых, во многих задачах при захвате объект плохо видно и зрение не может дать всю необходимую информацию. Если робот пытается поднять деревяшку со стола, простая система увидит только её верх и робот не будет знать, как она выглядит с другой стороны. В более сложной задаче извлечения разных объектов из корзины, целевой объект может быть закрыт, частично или целиком, окружающими предметами.

И, наконец, наиболее важной причиной служит то, что зрение не приспособлено для сути проблемы: захват происходит через контакт и силу сжатия, которые зрение не отслеживает. В лучшем случае зрение может дать информацию о наиболее подходящей комбинации пальцев, но роботу всё равно нужна тактильная информация, чтобы узнать физические параметры для данного захвата.

Как может помочь тактильный интеллект

Осязание играет центральную роль в задачах захвата и манипуляции предметов человеком. Людей с ампутированными конечностями больше всего раздражает, что они не могут ощущать, к чему они прикасаются при помощи протезов. Без осязания им приходится внимательно следить за предметами во время захватов и манипуляций, а обычный человек может поднять что-то, не глядя.

Исследователи знают о важной роли осязания, и за последние 30 лет было сделано много попыток создания тактильного датчика, воссоздающего человеческое чувство. Но сигналы, посылаемые датчиком, сложны, их много, и добавление датчиков к роботизированной руке не означает непосредственного улучшения возможностей захвата. Требуется способ преобразовать сырые данные низкого уровня в высокоуровневую информацию, что приведёт к улучшению захвата и манипуляции. Тактильный интеллект может дать роботам возможность предсказывать успех захвата через прикосновение, распознавание скольжения и определение объектов через их тактильные свойства.

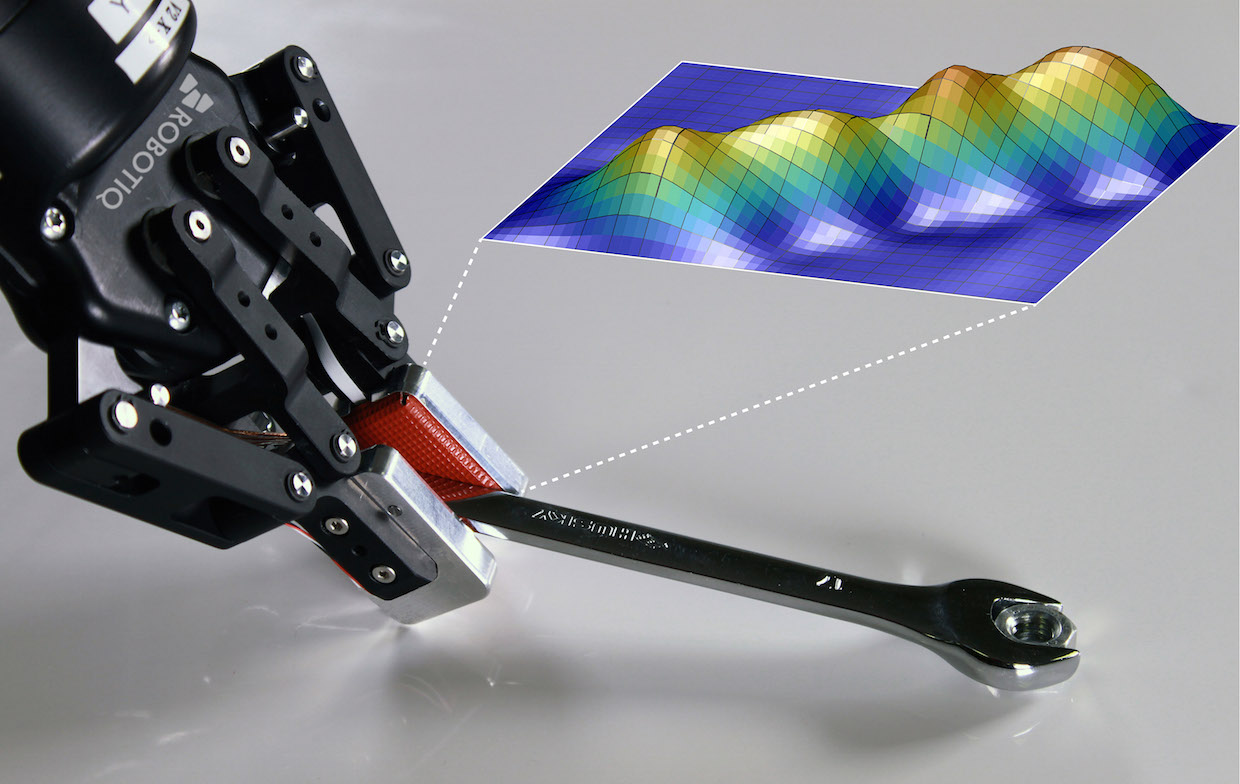

В лаборатории ÉTS’s CoRo Lab мы с коллегами создаём основные части системы, которые составят ядро такого интеллекта. Одна из последних разработок – алгоритм машинного обучения, использующий карты давления для предсказания удачных и неудачных попыток захвата. Система разработана Дином Кокбёрном [Deen Cockburn] и Жаном-Филиппом Роберже [Jean-Philippe Roberge] и пытается приблизить роботов к возможностям человека. Люди учатся распознавать, приведёт ли данная конфигурация пальцев к хорошему захвату, посредством осязания. Затем мы приспосабливаем конфигурацию до тех пор, пока не удостоверимся, что захват сработает. До того, как роботы могут научиться быстро адаптироваться, им нужно научиться предсказывать результат захвата.

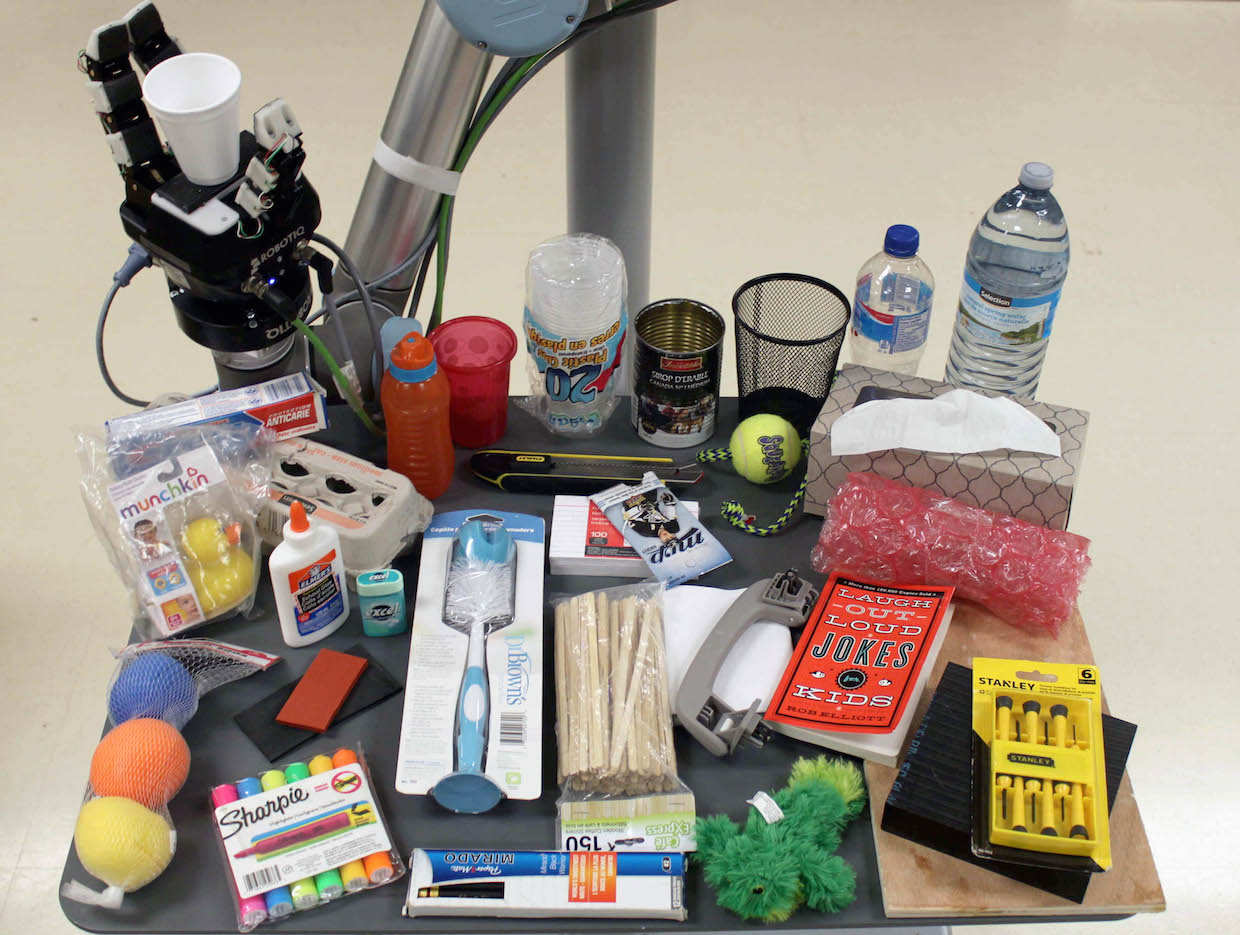

По-моему, лаборатория CoRo Lab достигла в этом успеха. Скомбинировав руку Robotiq с манипулятором UR10 от Universal Robots и добавив несколько мультимодальных тактильных датчиков, мы построили систему, использующую зрение от Kinect (которая нужна только для нахождения геометрического центра объекта). В результате роботу удалось поднять множество разных объектов и использовать их различия для обучения. В итоге мы создали систему, корректно предсказывающую, что захват неудачен, в 83% случаев.

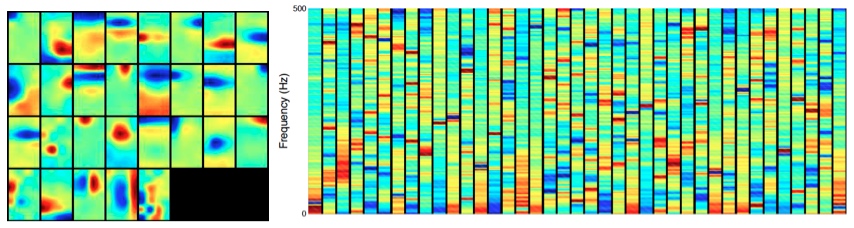

Ещё одна команда в лаборатории CoRo Lab под руководством Жана-Филиппа Роберже концентрировалась на определении проскальзывания предметов. Люди могут быстро определить, когда объект выскальзывает из захвата, потому что в пальцах есть быстро реагирующие механорецепторы. Это рецепторы в коже, распознающие быстрые изменения в давлении и вибрацию. Выскальзывание приводит к появлению вибраций на поверхности руки, так что исследователи использовали карты вибраций (спектрограммы), а не карты давления для обучения алгоритма. Используя того же робота, система смогла обучиться распознаванию картин вибрации, соответствующих выскальзывающему предмету и определяла выскальзывание в 92% случаев.

Обучение робота отслеживанию выскальзывания может показаться простым делом, поскольку это всего лишь набор вибраций. Но как обучить робота разнице между вибрациями, происходящими при выскальзывании и вибрациями, происходящими при протаскивании предмета по поверхности (например, стола)? Не забывайте, что и манипулятор при движении немного вибрирует. Три разных события генерируют схожие сигналы, но требуют различных реакций. Машинное обучение помогает находить различия между этими событиями.

Тактильный сенсор от CoRo Lab способен выдавать данные даже о капле воды

С точки зрения машинного обучения у двух команд лаборатории есть нечто общее: они не используют ручную настройку функций алгоритма. Система сама определяет, какие данные будут значимыми для классификации выскальзывания (или предсказания результата захвата) и не полагается на догадки исследователей о наилучшем индикаторе.

Высокоуровневые функции в прошлом всегда выписывались вручную, то есть, исследователи вручную выбирали те параметры, которые должны были помочь различать типы вибраций (или разницу между хорошим и плохим захватом). К примеру, они могли решить, что карта давлений, показывающая, что робот захватил только верхушку предмета, относится к плохим захватам. Но гораздо точнее будет дать роботу самому выучиться этому, тем более, что догадки исследователей не всегда соответствуют действительности.

«Разреженное кодирование» [sparse coding], один из приёмов построения нейросетей, особенно хорошо подходит в этом случае. Это алгоритм обучения без учителя, создающий «разреженный» словарь для представления новых данных. Сначала словарь создаётся при помощи спектрограмм (сырых карт давления), поступающих на вход алгоритма. Тот выдаёт словарь, состоящий из представлений высокоуровневых функций. При поступлении новых данных после следующих попыток захвата, словарь используется для преобразования новых данных в представления о данных, которые называются «разреженными векторами». Наконец, вектора группируются по разным источникам вибраций (или по успешным и безуспешным захватам).

Сейчас CoRo Lab тестирует способы автоматического обновления разреженного алгоритма, такого, чтобы каждая попытка захвата помогала роботу лучше делать предсказания. Идея в том, что робот в конце концов научится использовать эту информацию для коррекции своих действий при захвате. Это исследование – прекрасный пример совместной работы тактильного интеллекта и машинного зрения.

Будущее тактильного интеллекта

Ключевой момент исследования состоит не в том, что зрение надо выбросить из рассмотрения. Зрение всё ещё остаётся критичным для осуществления захватов. Но теперь, когда компьютерное зрение дошло до определённого уровня, лучше сфокусироваться на разработке новых аспектов тактильного интеллекта, а не пытаться напирать на зрение.

Роберже сравнивает потенциал исследования зрения с исследованием тактильного интеллекта с правилом Парето 80/20: теперь, когда 80% распознавания образов уже достигнуты, достичь идеала на оставшихся 20% очень тяжело и это не добавит ничего особенного в задачу манипулирования. И, наоборот, над 80% задачи тактильных ощущений предметов пока ещё работают исследователи. Доведение до совершенства первых 80% работы по осязанию будет достаточно простым делом и у него есть потенциал сделать огромный вклад в возможности роботизированных захватов.

Ещё, возможно, очень далеко до того дня, когда робот сможет распознать любой предмет через прикосновение, не говоря уже о том, чтобы убраться в вашей комнате – но когда он наступит, мы наверняка будем благодарить за это исследователей области тактильного интеллекта.