Комментарии 51

Мда уж, жесть. Безопасность — как будто в секретной лаборатории.

0

Почти также, как проход на закрытую территорию в одном закрытом уральском городке. Хотя работают там с вещами поопасней, что очень удивило.

0

0

Если земля лежит отдельно от питающей сети то при грозовом разряде в «витке» между питанием и землей формируется ЭДС и чем толще земля тем больше возможной ток…

0

НЛО прилетело и опубликовало эту надпись здесь

Спасибо за экскурсию. Очень интересный и познавательный пост.

0

в DataSpace кабели проложены в специальных лоткахА почему не в коробе (пластмассовом или из листового металла)? — Так кабели лучше защищены от случайных повреждений, нпр., при ремонте близкорасположенных светильников и т.д. И потом пыли меньше набирают. Даже если противопылевой режим помещения, то немного пыли всегда есть.

В машинных залах дата-центра организованы холодные коридоры. Из них оборудование получает воздух для охлаждения и выдувает его в сторону горячего коридора.Здесь не понятно: холодный воздух поступает на стойку снизу из под фальшпола?

0

СХД NetApp AFF300, специально оптимизированная для работы с SSD-накопителями. Над ней расположилась полка DS224С с двадцатью четырьмя SSD-дисками по 7,6 ТБ.

Наверное, вопрос нубский, но мне, как неспециалисту в СХД, любопытно, какой суммарный поток данных может отдать такая система при линейном чтении. Также интересно, как организована сеть, чтобы не стать узким горлышком для 24 одновременно задействованных SSD — простым умножением выходит 103Гбит/с для самых дешевых дисков, а если говорить о серьезных дисках, то цифры вообще космические.

И, как я понимаю, такое количество дисков — это работа почти в холостую —

Всего система NetApp AFF300 может обслуживать до 30 ПБ дискового пространства на быстрых «твердотельниках».

То есть, СХД способна работать с потоком данных от тысяч быстрых дисков?

0

Наверное, вопрос нубский, но мне, как неспециалисту в СХД, любопытно, какой суммарный поток данных может отдать такая система при линейном чтении.

В районе 6 ГБ/с с пары контроллеров. У классических СХД огромный оверхед и они используют всего 10% от возможностей дисков.

0

Спасибо за ссылку — у меня не нагугливалась. Интересно, а если собрать сервер вроде описанных тут, то получится ли отдать хотя бы 10ГБ/c по сети, используя несколько сетевых карт?

0

не туда

0

Сейчас мне накидают, конечно — но есть вопрос: почему же этот ваш 1cloud так хреново не очень хорошо работает?

Одно дело — реклама на хабре. Совсем другое — когда бухгалтеры глотки выгрызают перед квартальными.

Одно дело — реклама на хабре. Совсем другое — когда бухгалтеры глотки выгрызают перед квартальными.

0

А кто ваши клиенты? Не конкретно, но так чтоб понимать…

0

Клиенты очень разные.

От рядовых пользователей, которым нужно сайт разместить на VDSке, до больших компаний, которые строят на нашей базе распределенную инфраструктруру для своих сервисов, ИТ-отделов и т.д.

Интеграторы, вебстудии, 1C-франчайзи и вольные админы, фрилансеры всех мастей, маркетологи и т.д.

Сервис позволяет решать задачи в очень широком диапазоне, потому разных клиенстких кейсов тоже очень много.

От рядовых пользователей, которым нужно сайт разместить на VDSке, до больших компаний, которые строят на нашей базе распределенную инфраструктруру для своих сервисов, ИТ-отделов и т.д.

Интеграторы, вебстудии, 1C-франчайзи и вольные админы, фрилансеры всех мастей, маркетологи и т.д.

Сервис позволяет решать задачи в очень широком диапазоне, потому разных клиенстких кейсов тоже очень много.

0

Вокруг турникета на второй фотографии такие огромные дыры. Любой форточник залезет без проблем

0

Медная шина заземления соединена перемычкой из алюминия ?!

0

Когда нам рассказывают про импортозамещение вы можете поглядеть как оно выглядит на самом деле. И российского наверно только коврики резиновые и воздух.

0

Интересно, а как осуществляется эвакуация в случае пожара? Через те же «стаканы» и «миксер» или есть задняя дверка?

0

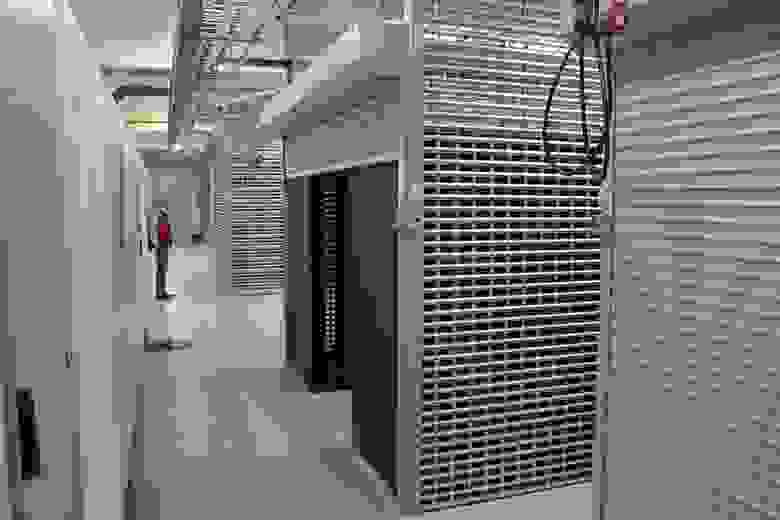

На пятой фотке точно клетка в машзале? Как-то черезчур брутально, обычно они сделаны изящней:

0

Почему нет вида всего ангара?

0

Каждый контроллер имеет четыре модуля оперативной памяти RDIMM ECC по 32 ГБ (это 128 ГБ в сумме). 120 ГБ выделено под кеш, а оставшиеся восемь — под энергонезависимую память NVRAM.

Разве оперативная память может быть энергонезависимой?

0

Для чего именно вращающиеся шипы на заборе? :D

0

Весомый аргумент в вечном холиваре «свой сервер или арендованный».

0

Это дейсвительно весомый аргумент.

Обеспечить схожий уровень безопасности и стабильности, как это делает ЦОД, большинству компаний не под силу, просто из-за масштаба.

Обеспечить схожий уровень безопасности и стабильности, как это делает ЦОД, большинству компаний не под силу, просто из-за масштаба.

0

после вашего фейла с левым юзером, весьма смелое заявление.

я бы доверился лишь первой тройке…

я бы доверился лишь первой тройке…

+2

Фейл был знатный, тут даже спорить не станем.

Тем не менее, ситуацию мы эту отработали, уязвимость закрыли, в процессах учли…

Человеческий фактор присутсвует везде, к сожалению.

Но, опять же, учитывая объемы задач связанных с безопасностью и админитсрированием, которые решает iaas-провайдер, накопленный опыт у него, в том числе по отработанным ошибкам, гораздо выше чем у сотрудников обычного ит-отдела.

Тем не менее, ситуацию мы эту отработали, уязвимость закрыли, в процессах учли…

Человеческий фактор присутсвует везде, к сожалению.

Но, опять же, учитывая объемы задач связанных с безопасностью и админитсрированием, которые решает iaas-провайдер, накопленный опыт у него, в том числе по отработанным ошибкам, гораздо выше чем у сотрудников обычного ит-отдела.

0

>двадцатью четырьмя SSD-дисками по 7,6 ТБ

А что за диски такие по 7.6Тб?

А что за диски такие по 7.6Тб?

0

Согласно требованиям ЦОД, заземляется все оборудование

Я бы спросил у подрядчика и ГИП проекта по контуру заземления:

А где собственно сам внешний контур? Почему сечение пластин меньше чем Ж/З подходящий кабель? Ответвление слева куда то еще уходит?

Соединять медные пластины алюмиением, неплохая дизайнерская мысль )))

Странно видеть бирки на кабелях в стиле СССР, ведь есть же маркировочные принтеры, пач корды промаркированы красиво.

0

У меня вопрос назрел:

-А почему лотки для СКС на 8-м фото верх ногами?

Насолько я помню с Университетского курса СКС, «провода» должны располагаться в лотках, а не на них сверу. Лотки же на фото расположены брюхом вверх, а «провода» прокинуты поверх брюха.

Скорее всего, я не понимаю специфики в конкретном случае, но хочеться объяснений.

Спаибо за ответы

-А почему лотки для СКС на 8-м фото верх ногами?

Насолько я помню с Университетского курса СКС, «провода» должны располагаться в лотках, а не на них сверу. Лотки же на фото расположены брюхом вверх, а «провода» прокинуты поверх брюха.

Скорее всего, я не понимаю специфики в конкретном случае, но хочеться объяснений.

Спаибо за ответы

0

Преимущества такого расположения наиболее подробно предоставлены в следующих роликах:

www.youtube.com/watch?v=A_VdNBDKRDg.

www.youtube.com/watch?v=zElQCERp5vE

www.youtube.com/watch?v=A_VdNBDKRDg.

www.youtube.com/watch?v=zElQCERp5vE

0

«При этом порты многофункциональны — они поддерживают технологию FCoE (Fibre Channel over Ethernet), которая позволяет переносить кадры Ethernet через FC»

наоборот — FC frames over Ethernet.

0

Зарегистрируйтесь на Хабре, чтобы оставить комментарий

Большая фотоэкскурсия по московскому облаку 1cloud