Комментарии 47

С недавно построенной серверной несколько сложнее, но как вариант — использовать ее в качестве резервной площадки, либо арендовать оптику до облака и также организовать гибрид.

А что вообще переносят в облака? Я имею в в виду какие сервисы? Вряд ли в облака отдают контроллеры домена и прочую инфраструктуру?

Практика показывает, что серверы архитектуры x86 не стоит постоянно нагружать более чем на 70-80% по процессору и 80-90% по памяти

Провайдеры очень любят делать оверселлинг на виртуалках т.к. это способ сэкономить на оборудовании. И vmware это очень даже хорошо позволяет делать. Заказчик это никак не отследит.

На тему капитальных затрат на оборудование — никто не мешает брать сервера в аренду, прямо в цодах. И это дешевле IaaS.

На тему дешевизны чужого облака — если ваши ресурсы укладываются в 1-2 железных сервера, то скорее всего у вас уже есть инженер на обслуживание этих ресурсов и переезд в чужое облако никуда этого инженера не денет. И с большой долей вероятности аренда резервного сервера будет стоить дешевле переезда в чужое облако. А в РФ возможно покупка серверов и установка в цоде отобьется уже через год.

Если у вас нету данных которые надо хранить на территории РФ, тогда вам прямой путь в европейские цоды. Они не стремятся окупить все железо за пол года и даже с учетом курса валюты, выделенные серверы там получается существенно дешевле.

Если у вас неравномерная нагрузка, тогда возможно вас спасут железные сервера на чуть выше минимальной нагрузки + для пиков нагрузки можно автоматически брать в аренду виртуалки.

Если у вас вобще неравномерная нагрузка, либо вам не хочется заниматься гибридной инфраструктурой, или не иметь геморроя с железом тогда облака ваш выход.

И не надо считать, что вам не придется периодически искать и решать нетривиальные проблемы — почему у вас так странно ведет себя приложение или трафик у облачного провайдера (у нас например диски от сервера с базой отваливались), кто виноват и что делать.

Разные облака рассчитаны для разных задач, поэтому не могу назвать оверселлинг каким-то абсолютным злом. К примеру, если вам нужно разместить не особо нагруженный сайт, то вся мощь ядер вам не нужна, и оверселлинг у провайдера специализированного веб-хостинга позволит купить услугу дешевле.

С технической же точки зрения оверселлинг является неотъемлемой частью многих современных облачных платформ — процессорные ресурсы объединяются в ресурсный пул и раздаются в виде пула гигагерцев Заказчикам. Сопоставление физических и виртуальных ядер используется достаточно редко. Как правило это делается в частных инсталляциях специализированных бизнес-приложений, чтобы сохранить поддержку вендора.

«Честные» ядра нужны в облаках, рассчитанных на корпоративные приложения. В этом случае «честность» обеспечивается контролем предельной утилизации CPU на хосте, мониторингом доступность физического процессора для ВМ (CPU ready), а также, как верно написал Spline, периодическими замерами CPU steal time.

Заказчик вполне может контролировать оверселлинг — либо делая собственные замеры, либо запрашивая графики мониторинга у провайдера.

А в облаке как они учтены? В облаке что все машины сразу в фул толеранс? Или облако автоматом для каждой первой машины по две реплики на разных сайтах держит?

Опять взяли за основу кейс аномально быстрорастущего стартапа и пытаются натянуть его на все что движется…

Под ресурсами для отказоустойчивости понимаем гарантию наличия ресурсов для работы виртуальных машин при любой поломке. Это достигается резервными свободными хостами в кластерах виртуализации и регламентами по предельной загрузке продуктивного оборудования.

Загрузка физических процессоров на конкретном хосте — не более 80%, физической памяти на конкретном хосте — не более 90%. По количеству свободных хостов требования разнятся в зависимости от облака (у нас их несколько) и конфигурации оборудования в конкретном кластере виртуализации. Стараемся держать свободными не менее четверти ресурсов конкретного кластера.

www.ovh.ie/dedicated_servers/enterprise/1801sp94.xml

1000+ евро

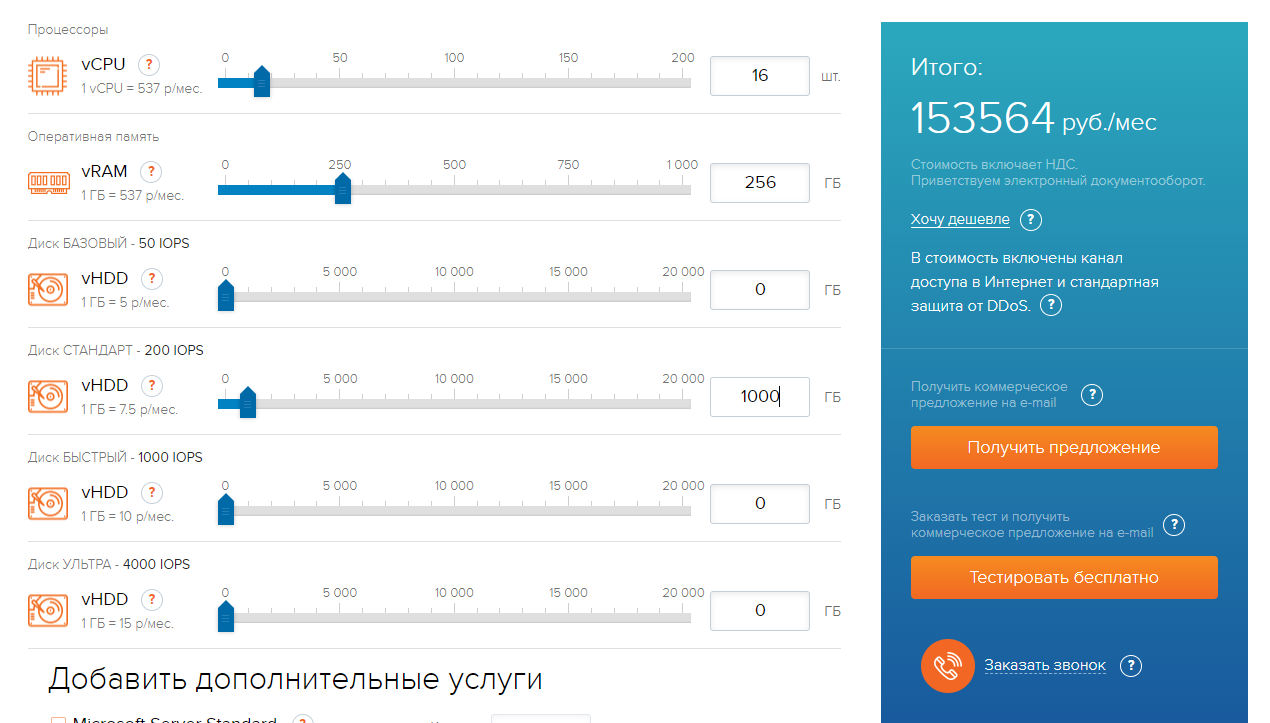

И ваш калькулятор на 2000+ евро

девопс/сисадмин мне будет нужен в любом случае.

Резерв мощностей в OVH (в сравнении с ресурсами в облаке) у меня х6 по процессору и примерно х3 по памяти

Вы можете это как-то прокомментировать?

Услуги сильно отличаются и по отказоустойчивости. Я допускаю, что в OVH хорошая система бекапирования, и при отказе арендованного железного сервера они выделят другой и накатят на него бекап — вопрос, сколько времени это займет, и будет ли, к примеру, дневной бекап актуален для вашего сервиса? В облаке при жестком отказе хоста размещенные на нем ВМ будут лишь перезагружены, а если хост просто деградировал, то машинки будут мигрированы без ребута.

Если же говорить именно о железе, то в облаке VMware, которое на скриншоте, используются процессоры Xeon E5-2697A v4, которые быстрее работают с памятью, обладают более высокой производительностью из расчета на ядро, чем Xeon E5-1660 v3, а также позволяют выдать вашему серверу значительно большее кол-во ядер, т.к. многим нагруженным аппликейшенам, серверам баз данных, OLAP-кубам или процессинговым молотилкам просто не хватит 8 ядер Xeon E5-1660 v3.

Что же касается стоимости, то в случае с OVH цена указана без НДС, а в калькуляторе — с НДС, что делает реальную разницу меньше. Плюс, с объемом более 100 т.р. вы уже можете рассчитывать на скидку, и также сможете снизить объем платежа за счет предоплаты.

P.S. Лучше ответить поздно, чем никогда )

Например, если покупаем 5 серверов с 40 процессорными ядрами и 256 ГБ RAM, то и у облачного провайдера запрашиваем аналогичные ресурсы (40*5=200 vCPU + 256*5=1280 ГБ vRAM)

это как у вас вышло 5*40 полновесных ядер = 200 vCPU !? vCPU у амазона и гугла это hardware thread, а не то что вы подумали.

Тендерную же процедуру просто повторяют периодически — кто-то раз в год, кто-то раз в 3 года, но при этом используют уже готовые тендерные документы с небольшими правками.

2. Есть облака, сертифицированные по всяким разным стандартам типа PCI DSS, БиоПД, ФСТЭК и т.д. Причем свой ДЦ еще тоже надо сертифицировать, что непросто и небыстро.

3. Для параноид-режима, типа крупных банков, возможно физическое огораживание стоек в ДЦ

С трудом верится, что прямо-таки единственным. А как же широкий выбор уже реализованных в AWS инфраструктурных сервисов, как же большое количество встроенных инструментов для разработчиков? И управлять инфраструктурой, вероятно, станет проще, а обслуживать ее — дешевле. Опять же — если стоимость AWS кажется высокой, а бизнес находится в России, рассмотрите отечественных провайдеров. Наверняка получится дешевле, и с колебаниями курсов валют как-то проще.

Вы не учли, что при переносе существующих решений в облако без коренной переработки архитектуры мы получаем самый обыкновенный хостинг у провайдера, и тут нет ничего от облаков. Выгода этого варианта сомнительна. Используется как раз при быстром наращивании мощностей стартапов или как временная мера при гибридном решении, пока не приехали сервера в свою серверную.

Для получения экономической выгоды от облаков необходимо часто в корень перерабатывать архитектуру всей инфраструктуры. Тут речь не о корпоративном портале или веб сайте компании, а о кейсах когда у компании 20+ различных решений используется. Переработка архитектуры будет стоить дороже чем выгода от экономии серверов или своей новой серверной. Окупится, может быть, через пять лет. Инвестиции на такой период с такими высокими рисками внедрения бизнес не любит.

Staff OpEx уже занимает серьезную долю бюджета и, не редко, даже людей быстро нанять сложнее чем купить сервера :)

Впрочем — допускаю, что это только мой избирательный опыт.

Что же касается коренной переработки архитектуры в компаниях, где по 20 (а иногда и по 80) различных ИТ систем используется, то такая дорогостоящая и сложная работа даст большой эффект при размещении как в облаке, так и «на земле».

У вас среднее может быть 3 мс, но если в хвосте хотя бы 1-2% влетают из 200-300 мс это может стать причиной разрыва сессий для некоторых приложений.

7 типичных ошибок при сравнении своих серверов с облаком