Меня зовут Александр Рудиков, я младший научный сотрудник Сколтеха. Я работаю в группе под руководством Ивана Оселедца, которая занимается решением дифференциальных уравнения с помощью нейронных сетей. Не так давно мы придумали, как сделать этот процесс точнее и доложили свои результаты на конференции ICML 2023, по итогам которой была опубликована статья в сборнике трудов. В этом тексте я хотел бы поделиться нашими наработками и подробнее рассказать, что именно мы сделали.

Введение

Обширные явления реального мира, такие как турбулентность, атмосферная циркуляция и напряжение деформируемых материалов и т.д., описываются лежащими в их основе дифференциальными уравнениями в частных производных (PDEs). Следовательно, решение PDEs является общей фундаментальной проблемой для многих научных и инженерных областей и может принести дальнейшую пользу важным приложениям реального мира. Например, моделирование воздушного потока для проектирования аэродинамического профиля крыла летательного аппарата, моделирование атмосферы для прогнозирования погоды, молекулярная динамика и т.д.

Традиционный подход к численному решению PDEs основан на использовании различных солверов, которые используют те или иные классические методы. Например, метод конечных элементов (FEM) или метод конечных разностей (FDM), которые решают PDEs путем дискретизации расчетной области. Однако, в этом случае точность численного решения сильно зависит от дискретизации расчетной сетки: грубые сетки работают быстро, но менее точно; мелкие — точны, но медленны. В реальных приложениях решение PDEs обычно требует очень хорошей дискретизации и, следовательно, очень сложны, времязатратны и трудоемки для традиционных солверов.

В последние несколько лет на решение этой проблемы направлены усилия ученых, занимающихся нейронными сетями (NNs). Широко известно, что NNs являются универсальными аппроксиматорами непрерывных функций. Более важным фактом является то, что NN с одним скрытым слоем может точно аппроксимировать любой нелинейный непрерывный оператор. Недавно в рамках нового направления было предложено изучение бесконечномерных операторов с помощью NNs. Нейронный оператор устраняет зависящую от сетки дискретизацию, создавая единый набор параметров NN, которые можно использовать с различными дискретизациями расчетной сетки. В этом случае мы имеем возможность передавать решения между расчетными сетками. Кроме того, нейронный оператор нужно обучить только один раз. Наконец, нейронный оператор не требует знания лежащего в основе PDE, только данные, полученные экспериментально или с помощью солверов.

Нейронный оператор

Так ка же работает нейронный оператор? Рассмотрим простой пример параметрической краевой задачи:

Существует некоторый оператор G†, отображающий коэффициент диффузии и правую часть aj(x), fj(x) в решение uj(x), т.е. uj = G†(aj, fj). Для того, чтобы получить решение uj используются традиционные солверы. Основная цель нейронного оператора — это построить аппроксимацию G† путем построения параметрического отображения Gθ†:

где θ† ∈ Θ — некоторый конечномерный вектор параметров. Если определить функционал качества как

то искомый вектор параметров находится как

Другими словами, задача сводится к обыкновенному поиску минимума функции потерь.

Трудности решения PDEs с помощью нейронных операторов

Такой подход получает решение довольно быстро, но его основная трудность заключается в том, что, чтобы получить хорошую точность решения, обучающих пар наблюдений {aj, uj}Nj=1 должно быть много. В этом случае, как уже было сказано выше, мы используем традиционный солвер, чтобы получить решения uj, со всеми сопутствующими сложностями.

В классическом машинном обучении было предложено несколько способов, целью которых было увеличение количества данных без существенных вычислительных затрат. Следует заметить, что для задач, связанных с PDEs, методов увеличения данных без существенных вычислительных затрат очень мало. Наша команда, в которую входят специалисты из Сколтеха, ИВМ РАН и AIRI, разработала новый метод, позволяющий увеличивать набор данных для обучения нейронного оператора.

Центральной идеей предложенного подхода является принцип общей ковариантности. Он заключается в том, что физика явления не зависит от выбора системы координат. Математически, ковариантность означает, что физические поля являются геометрическими объектами с определенными законами преобразования при изменении системы координат.

В ряде случаев такие преобразования оставляют инвариантными уравнения, но в большинстве случаев сохраняется только форма уравнения. Более точно, для PDEs преобразование координат, выбранное соответствующим образом, приводит к изменению параметров задачи (например, поля проницаемости, коэффициента конвекции, начальных или граничных условий и т.д.). Мы использовали этот факт для построения вычислительно дешевой и широко применяемой стратегии увеличения данных (или аугментации), основанной на простых случайных преобразованиях системы координат.

Базовый пример аугментации для PDEs

Приведем простой пример нашего подхода для параметрической краевой задачи (1). Основное наблюдение состоит в том, что, когда известно PDEs, то можно извлечь больше информации из каждого полученного решения с помощью преобразования координат. Предположим, что y(ξ) является аналитической строго монотонной функцией: [0, 1] → [0, 1]. Используя x ≡ y(ξ) как координатное преобразование, можно переписать уравнение (1) в координатах ξ следующим образом:

Как видим, преобразованное уравнение (2) имеет ту же параметрическую форму, что и исходное (1). Как следствие, если тройка функций a(x), u(x), f(x) решает исходное уравнение (1), то тройка модифицированных функции a(y(x))dx/dy, u(y(x)), f(y(x))dy/dx также решает то же уравнение (1), где мы переименовали переменную ξ в x. Таким образом, мы можем создавать новые решения из старых с использованием гладких преобразований координат и интерполяции. Как генерировать гладкие преобразования координат?

Поскольку любая строго монотонная положительная функция, отображающая [0, 1], представляет собой правильное преобразование координат, можно использовать кумулятивные функции распределения со строго положительной плотностью вероятности. Можно придумать много параметрических семейств плотностей вероятностей. Например, используя тригонометрические ряды:

После интегрирования получаем кумулятивную функцию распределения, которая служит преобразованием координат

Таким образом, вся процедура аугментации краевой задачи (1) может быть компактно записана как

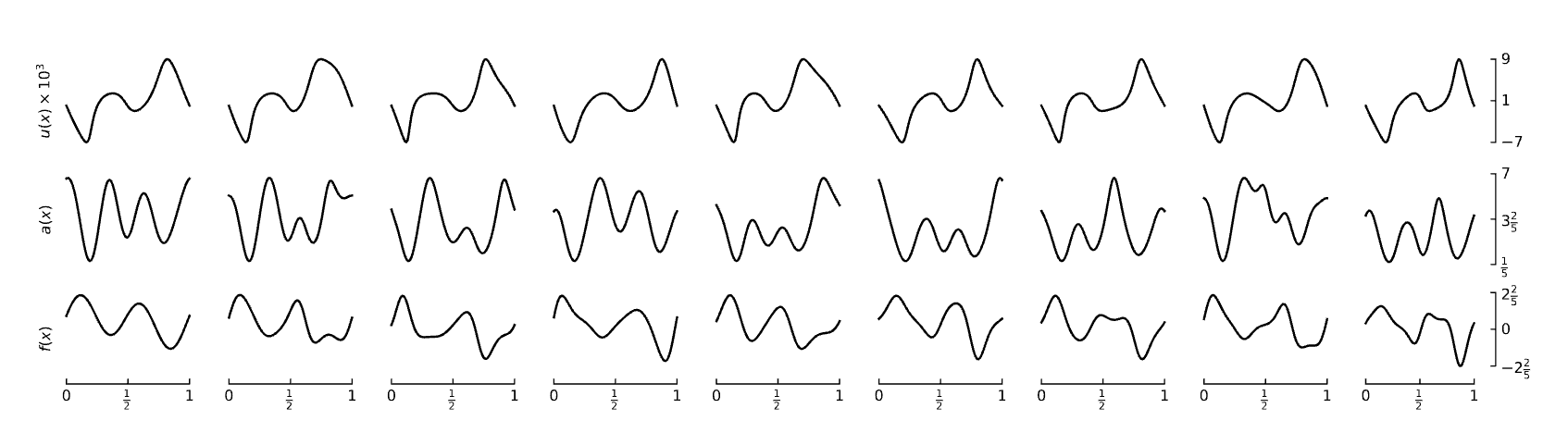

Рисунок ниже иллюстрирует предложенный подход для одномерной задачи (1) и частного набора преобразований (5):

Общая стоимость таких координатных преобразований для одной пары наблюдений {aj(x), fj, uj} составляет O(N), где N — количество узлов расчетной сетки. Это существенно быстрее, чем, например, решение уравнений Навье — Стокса методом конечных элементов, для которых сложность растет полиномиально.

Проверка на практике

Предложенная аугментация универсальна и может быть использована для любого нейронного оператора. Мы продемонстрировали подход на примере решения уравнения переноса, волнового уравнения, уравнения Навье — Стокса, эллиптических уравнений двух типов. В их исследования использовались следующие нейронные операторы: FNO, SNO, MLP, DilResNet, DeepONet и U-Net. Эксперименты проводились как для D = 1, так и для D = 2, где D — это количество аргументов.

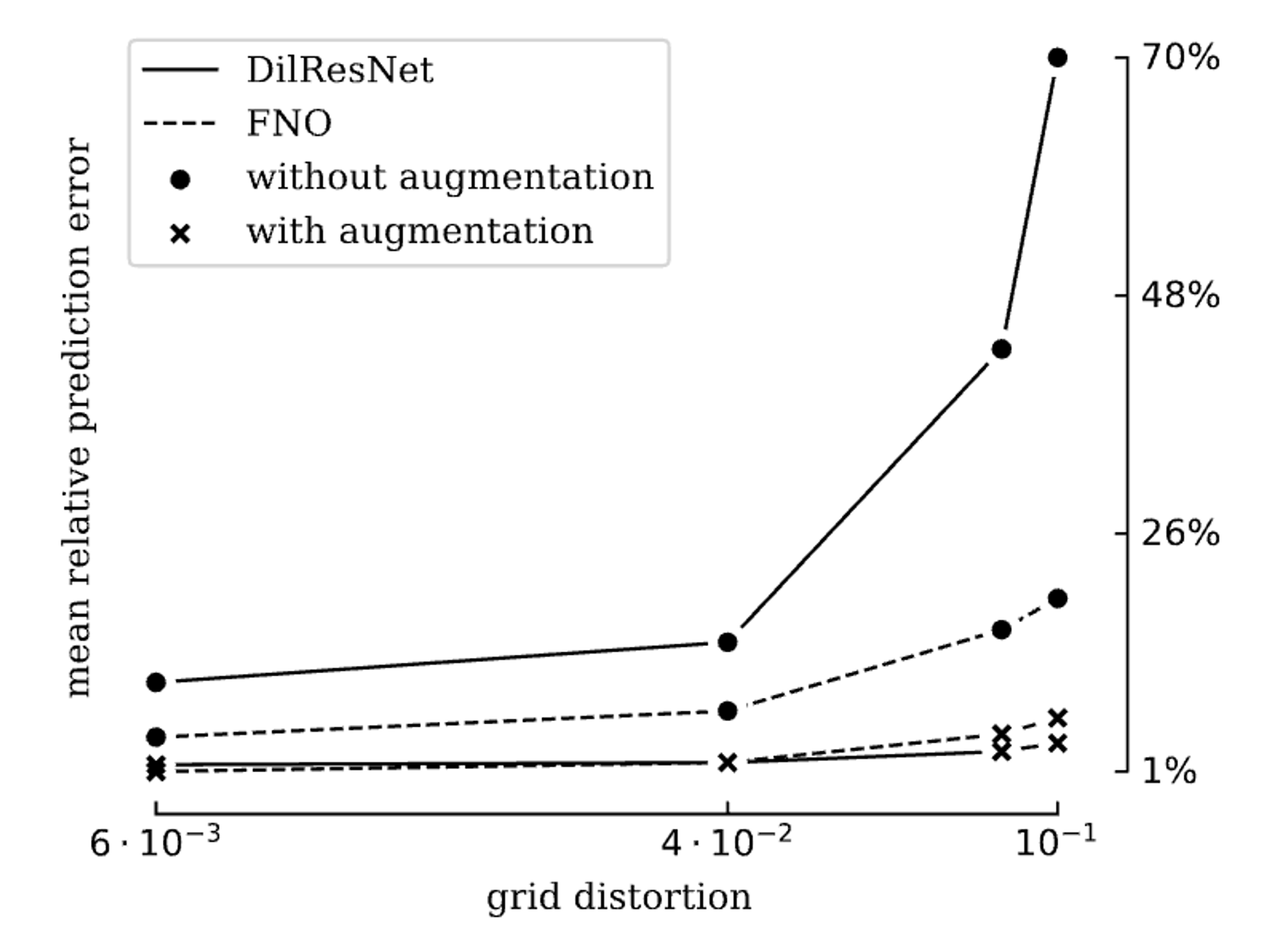

Проведенные эксперименты показали, что наша аугментация позволяет ощутимо снизить ошибку обученного нейронного оператора при тестировании. Наименьшее снижение наблюдалось при работе с MLP — ошибка снизилась на 17%. Наилучший же результат был достигнут при работе с сетью DilResNet — там этот показатель вырос до 80%. В среднем по нейронным операторам и уравнениям предложенный подход сократил ошибку тестирования на 23%.

На рисунке ниже представлен результат сравнения нейронных операторов, обученных на данных с аугментацией и без нее. Степень возмущения решетки (grid distortion), полученной преобразованием системы координат, была рассчитана как максимальная разница между исходными координатами x и преобразованными x(ξ).

Ограничения у нашего подхода тоже имеются. Одним из них стал тот факт, что пока аугментация такого типа применима к малому набору уравнений. В дальнейшем планируется расширить круг применимости путем рассмотрения более сложных уравнений и неструктурированных сеток.