Возможности LLM (large language models) вызывают растущий интерес со стороны разработчиков, исследователей и обывателей. Нейросети имитируют человеческую речь, могут поддержать диалог и написать текст на заданную тему. Однако с расширением спектра возможностей и применений интеллектуальных систем увеличивается и простор для некорректного использования результатов их работы. Становится сложнее понять, когда нейросеть генерирует не совсем точный ответ, и оценить риски для рабочих задач в той или иной отрасли. Поговорим о том, насколько серьезна проблема и что с ней можно сделать.

Большой и страшный ИИ: ожидания…

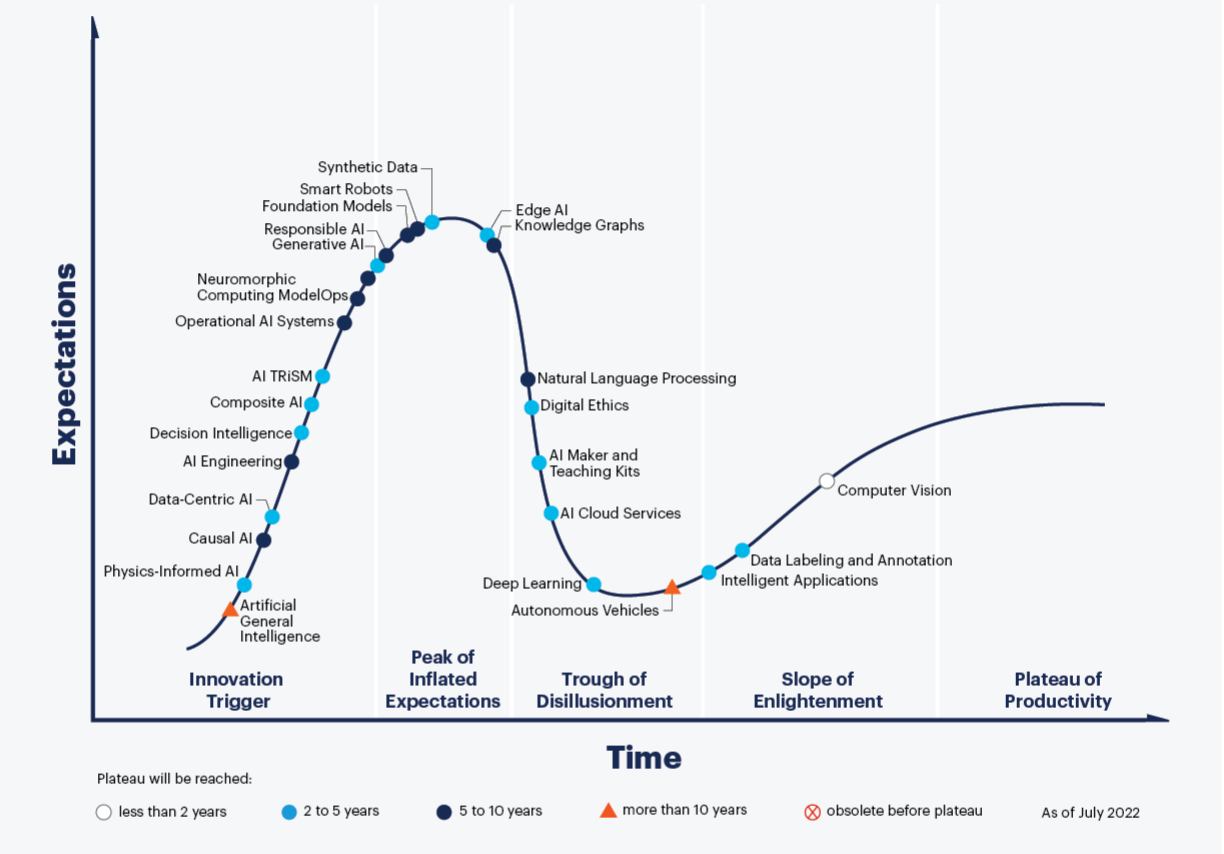

Есть мнение, что нейросети — путь к технологической сингулярности, когда техническое развитие станет неуправляемым, а возможности систем искусственного интеллекта выйдут за пределы человеческого понимания. Современные решения уже научились имитировать речь на достаточно высоком уровне, а генеративные модели — способные создавать новый контент на базе существующего — подбираются к «вершине хайпа» на кривой зрелости технологий Gartner.

Учитывая контекст, некоторые лидеры мнений считают, что дальнейшее развитие интеллектуальных систем слишком опасно. Так, в конце марта руководители крупнейших ИТ-компаний и исследовательских организаций опубликовали открытое письмо «Pause Giant AI Experiments», в котором призвали приостановить разработку мощных нейросетей до тех пор, пока не будут сформулированы общие протоколы безопасности. Свою подпись под документом поставили представители Apple, Pinterest, Stability AI, профессорский состав из MIT и Оксфорда, а также Илон Маск [который почти сразу основал собственную компанию в сфере машинного обучения]. Подписанты опасаются, что бесконтрольное развитие LLM приведет к появлению разумного и неуправляемого ИИ.

В то же время ученые из Общества научных исследований имени Макса Планка и Калифорнийского университета пришли к выводу: если высокоинтеллектуальная система ИИ все же появится, её будет в принципе невозможно контролировать. Сделать это не позволит текущий уровень развития технологий. Да и сама идея наложения ограничений лишена смысла. Если допустить, что суперинтеллект все же получится «загнать в клетку», она скует его потенциал и сделает бессмысленной саму идею его создания.

Кроме того, сложно предсказать дальнейшие действия сильного ИИ, если он осознает, что его сдерживают. Взаимодействие с такого рода системой тоже вызывает опасение (по этой теме даже рисуют комиксы), так как у исследователей нет способов проверить «безопасность и миролюбивость» ИИ.

Впрочем, существует и альтернативная точка зрения. Ряд аналитиков отмечает, что мы переоцениваем возможности современных языковых моделей. По крайней мере, на текущем этапе их развития беспокоиться не о чем.

…и реальность

Да, LLM уже стали популярным инструментом в маркетинге, дизайне, разработке, они доступны не только крупному бизнесу. Развернуть собственный фреймворк для работы с моделями машинного обучения помогают облачные провайдеры — в том числе и мы в #CloudMTS. Но последние версии нейросетей не настолько умны, как может показаться на первый взгляд.

Главная проблема технологии кроется не в том, что условный ChatGPT-10 резко трансформируется во всезнающий разум, а в том, что пользователь не может с легкостью определить, когда алгоритм «тупит». Известный робототехник Родни Брукс в интервью журналу Futurism отметил — ответы LLM часто звучат как правильные, но таковыми не являются. Большие языковые модели ошибаются, выдают желаемое за действительное — то есть «галлюцинируют».

За примером далеко ходить не нужно — в начале июня по заголовкам СМИ пронеслась история об адвокате, который подготовил защитительную речь с помощью ChatGPT. Нейросеть процитировала несуществующие прецеденты, а юрист не удосужился их проверить. На заседании его ждали неприятный сюрприз и штраф.

Другой пример из мира информационных технологий, которым поделился резидент Hacker News. Он использовал LLM для бэкенда на своем проекте. Однако система регулярно предлагала ему API-запросы, которые не существовали, но выглядели невероятно убедительно.

Поскольку людям сложно понять, когда система ИИ выдумывает факты, они испытывают недоверие при работе с такой сетью. Эта проблема дала новый толчок дискуссии, посвященной прозрачности нейросетей. Подавляющее большинство из них представляет собой «черные ящики», и пользователи не знают, что происходит внутри. На основании каких данных, фактов, алгоритм принимает решение?

В то же время есть мнение, что «разумность» нейросети может опосредованно зависеть от человека, который с ней взаимодействует. Недавнее исследование «Large Language Models and the Reverse Turing Test» группы специалистов из MIT показало, чем более эрудирован человек, разговаривающий с нейросетью, тем корректнее её ответы. Иными словами, их качество зависит от того, насколько правильно и полно был задан вопрос.

И что нам с этим делать

Одна из задач, которую сегодня пытаются решить — это проблема «черного ящика». Вопрос поднимают даже на законодательном уровне. Так, в Великобритании регулятор планирует обязать разработчиков систем ИИ сделать свои сервисы более прозрачными для пользователей. Последние должны понимать, как и почему алгоритм принял то или иное решение. Инженерам, в свою очередь, требуется продемонстрировать ответственный подход в работе над своими моделями.

Правительства крупнейших стран также обеспокоены безопасностью интеллектуальных сервисов. В Евросоюзе предлагают ограничить применение нейросетей в критической инфраструктуре. Кроме того, Еврокомиссия хочет заставить разработчиков следить, чтобы их продукты не нарушали авторское право.

Как ни парадоксально, некоторые специалисты предлагают переложить решение этой и других задач на сами нейросети — разрешить им обучать друг друга. Эксперты — среди которых, например, разработчики интеллектуальных процессоров Graphcore — считают возможным создание архитектуры, которая позволит языковым моделям проводить фактчекинг своих утверждений. Примером такой архитектуры может быть MSEM (Massive Sparse Expert Models). Схема предполагает реализацию множества подмоделей, каждая из которых выступает экспертом по определенной теме и проверяет результаты остальных.

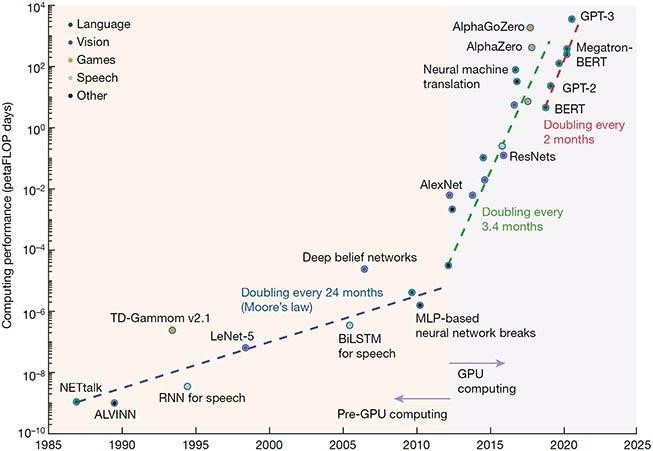

Одним из важных направлений также является работа с масштабом и общими подходами к обучению. Недавнее исследование «Beyond the Imitation Game: Quantifying and extrapolating the capabilities of language models» показало, что большинство существующих сегодня классов моделей имеют схожую производительность в типовых задачах. Увеличение масштаба нейросетей действительно повышает их эффективность. Но в такой ситуации возникает риск, что рынок будут контролировать корпорации. У них больше ресурсов для обучения и поддержки своих сервисов. Чтобы решить эту проблему, исследователи уже сейчас работают над методами, которые позволят эффективно обучать языковые модели на меньшем количестве данных.

С уверенностью можно сказать лишь одно. В ближайшее время нас вряд ли ждет появление по-настоящему умного ИИ, способного сравниться с разумом человека. В конце концов, мы до сих пор не знаем, как именно работает наш собственный мозг: часть его функций остается загадкой, и воспроизвести их с помощью компьютерных вычислений в полной мере невозможно.

С другой стороны, есть вероятность, что в решении именно этой задачи нейросети будут как никогда полезны. Исследователи из MIT в работе «Large Language Models and the Reverse Turing Test» предполагают, что математическое обоснование того, как именно общаются LLM, поспособствует развитию теории интеллекта.

В сервис Compute Cloud мы добавили новый сегмент железа с GPU. Виртуальные машины с графическим ускорителем позволят решать графические задачи и работать с глубокими нейронными сетями. Например, можно обучить модель по распознаванию котиков или запустить собственный ChatGPT.