Комментарии 46

Ну грубо говоря когда мы динамический диапазон увеличиваем — то шаг увеличивается вместе с ним. Соответственно у нас на старый-добрый sRGB не 8 бит точности, а уже 6 приходится.

Да, видно, но эта проблема отлично решается dithering-ом. Человеческий глаз в принципе не способен шум в 1 градацию, особенно на 4K мониторе.

У меня 10-битный монитор, и я не вижу абсолютно никакой разницы между честным 10-битным градиентом и преобразованным 10 bit -> 8 bit + pattern noise.

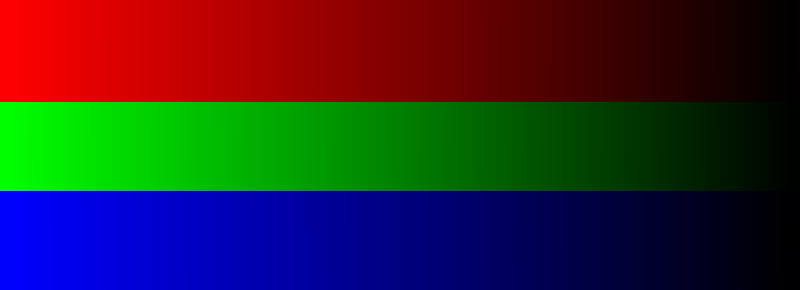

Как-то так:

Слева — исходник, по центру — 64 градации + дизеринг, справа — 64 градации без дизеринга.

Если смотреть со 100% масштабом на нормальном экране, то небольшие огрехи по центру видны, но картинка по качеству ближе к той, что слева. И примерно то же самое будет, если заменить 6 бит на 8 бит, а 8 бит на 10 бит.

Но речь немного не об этом. Дизерингом можно и полноцветный JPEG в 256 цветов перегнать так, что только при пристальном разглядывании рассмотришь. Но это уже дополнительная обработка, и фактически мы обманываем глаз, подсовывая ему БОЛЬШЕ оттенков, чем 256 по одному цветовому каналу.

Да, это дополнительная обработка, но она очень дешёвая в реализации. И в итоге утверждение, что для просмотра HDR10 контента обязательно нужен соответствующий монитор, не является верным. Монитор с расширенным цветовым охватом — возможно, но не увеличенной глубиной цвета.

Добрался до своей софтины, построил 10-битный градиент, вот результат (смотреть в полном разрешении):

(сверху — 8 бит без дизеринга, посерединие — паттерн дизеринг до 1/2 градации, снизу — до 1/4 градации)

Тут я ещё и игры с цветом, настолько я знаю, были. Ну то есть если нам нужно добавить 1/4 интенсивности к группе пикселей 2x2, то вместо того, чтобы добавить +1 RGB к одному из пикселей, я добавлял +1R, +1G, +1B к разным пикселям, чтобы результат выглядел ещё равномернее.

P.S. А ту зелёную картинку я в GIMP-е оборабатывал.

В каком именно место заметны цветовые ступеньки? А монитор калибровали?

Вот еще нашел цитату: «По разным источникам глаз человека может различать от 3 тысяч до 10 миллионов оттенков».

то их всего 256 штук, а это уже очень заметно

Ступенчатость заметна, потому что меняется не цвет, а интенсивность.

Возьмите теперь, ради интереса чисто цветовой градиент, например, вот:

https://upload.wikimedia.org/wikipedia/commons/0/08/YCbCr-CbCr_Y100.png

И, внезапно, оказывается, что увидеть ступеньки на этой картинке на откалиброванном мониторе может уже не каждый.

его поддерживают практически все производители телевизоров

А как насчёт такого производителя, как LG? Они заявляют, что HDR10+ им не нужен

Потому что они поддерживают DolbyVision. Он то же с динамической метаинформацией. И контента под него больше. Практически все современные кинофильмы сняты в сотрудничестве с Dolby.

Не согласен с изложенным.

Во-первых, динамический диапазон человеческого глаза (30+ стопов) не имеет никакого отношения к просмотру изображений на экране, ведь необходимости к адаптации к переменному освещению здесь нет, а статический диапазон глаза ближе к 10 стопам, но никак не 14.

Во-вторых, динамический диапазон современных камер намного выше. Современные зеркалки имеют статический диапазон чувствительности порядка 11-12 стопов, так что можно смело заявлять, что техника видит мир уже лучше, чем глаз. Добавляем сюда динамический диапазон — игры с диафрагмой и выдержкой — ещё 16 стопов, и вуаля — современная камера имеет 28 стопов динамического диапазона и, в отличие от глаза, камера адаптируется к смене освещения за доли секунды, чего нельзя сказать о глазе.

В-третьих, картинка SDR (8 bit) vs HDR (10 bit) — маркетинговый бред. 10-битный цвет даёт большее число промежуточных градаций, а не расширение цветового охвата.

Ну и в четвёртых, 10-битный цвет — штука хоть и полезная, но для его отображения 8-битной матрицы более чем достаточно за счёт FRC и дизеринга.

А QLED телевизор Samsung Q950T — это QLED подсветка, или QLED цветной светодиод на каждый пиксель?

Интересно авторы OLED телевизоры видели когда-нибудь?

У меня окна в пол и южная сторона, ни разу не было ситуации с нехваткой контрастности.

(Я уже молчу, что контраст это разница между самым светлым и самым темным из воспроизводимых оттенков и он по определению лучше у OLED, т.к. там самый темный это 0)

Я уже молчу, что контраст это разница между самым светлым и самым темным из воспроизводимых оттенков и он по определению лучше у OLED, т.к. там самый темный это 0

Видимо, имеется в виду, что у QLED максимальная яркость выше, чем у OLED (чтоб глаза прям выжигало, наверное?). А чистый 0 может быть только в полной темноте, потому что экран сам по себе не чёрный, и хоть немного света, да отражает.

В отличие от OLED-телевизоров, которые могут выдавать необходимый уровень контраста только при плотно зашторенных шторах.

Почему то ожидал увидеть этот комментарий в статье ))

Опять же соотношение контраста у OLED дисплеев бесконечное, так как нельзя делить на ноль :) Но так да, qled ярче. Возможно следущий телевизор будет QLED, потому как сравнительно дешевле, но меня и вполне OLED устраивает, все равно днём телевизор смотреть некогда, получается смотрю только вечерами. Да и не сказал бы, что сильно напрягает "тусклый" OLED экран LG телевизора.

Например, в случае с LG C9 OLED.

Target Max Luminance: 750 cd/m^2

Target Min Luminance: 0.00006200 cd/m^2

>смотрю только вечерами

Оба стандарта BT.709 с BT.1886 или PQ расчитаны на темную комнату. Для HDR пока что вообще не существует идельного трансфера при разном освещении, хотя Dolby пытается со своим Dolby Vision IQ и Samsung с HDR10+ Adaptive.

У меня 75Q900TS выдаёт более 500 ватт при большой яркости, зимой мне жарко.

А Сони Z9G выдаёт под киловатт на 85 дюймах. Вот она цена большой яркости.

А вот Dolby Vision контента гораздо больше. Почему не дать возможность купить этот декодер юзерам — не понимаю.

топы это хорошо, но с низу у самсунга яркость 200нит и HDR. самсунг дурит получаетсч или все сложнее?

Можно ли чайнику преобразовать DolbyVision в HDR10+?

Например, есть фильм Финч с видео в формате DV (http://kinozal.tv/details.php?id=1874351)

Можно ли (с потерей битности с 12 до 10 и другими потерями) сделать из этого видео HDR10+?

Что такое HDR10+? Разбор