Комментарии 156

возможно стоило бы упомянуть такой фактор как температура. Правильный температурный режим способен неплохо таки продлить жизнь харду.

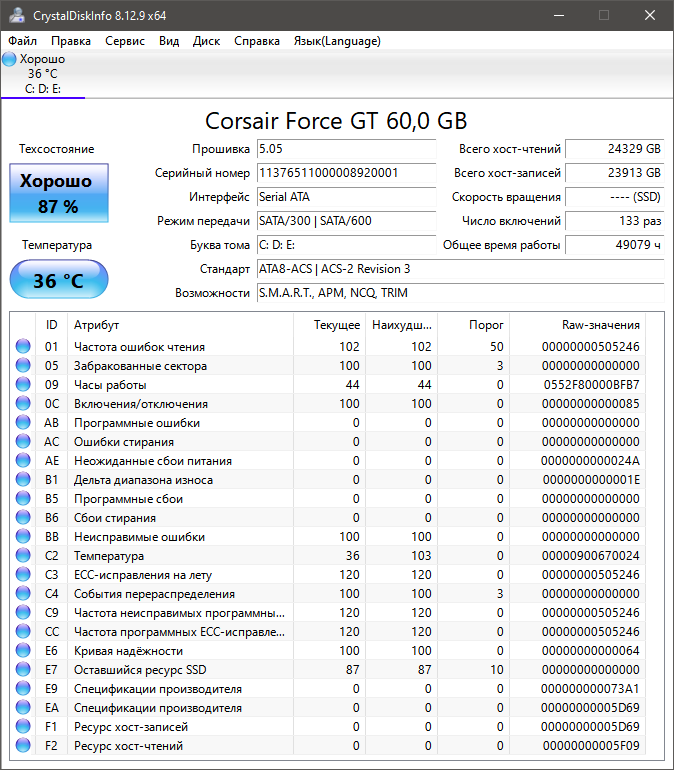

В своей практике отслеживал состояние SSD через Crystal Disk Info. Пока еще не один SSD не отказал, поэтому ничего не могу сказать о важности параметров для мониторинга.

Сам ориентировался только на TBW, но и заявленный производителем ресурс не разу не смог преодолеть, чтобы проверить, произойдет ли снижение качества работы SSD, или нет. Был Plextor 128 Гб, с параметром TBW=72 Тб, но за 7-8 лет эксплуатации дошел только до 69. В итоге продал его, вместе со старым компом.

WD Black m.2 - перешел в Read only, спасибо, что дали сохранить. Как W10 загружалась - я от сапожника столько мата не слышал, но тем не менее... Обменяли на новый без проблем, ситилинк, Краснодар.

Не вижу смысл беречь рабочий диск - менял раньше, чем в родной утилите хоть как-то менялось значение здоровья SSD. Единственное, что я включаю в Windows сжатие - "Сжать этот диск для экономии места". Субъективно мелкие файлы становятся еще меньше.

по сути сжатие - это gzip (тут другой протокол) для html. так что такая себе экономия.

дополню, т.е. оно постоянно во временую папку распаковывает. OneDrive по сути делает то же самое, задрочила эта папка OneDriveTemp (сука, ну есть же папка для временных файлов, так де и с "сохраняшками" ЛИЦЕНЗИОННЫХ игр, \MyFolder\Name, Myfolder\SaveGames\*, AppData, ...) Ну кто еще что придумает?

Некоторый смысл есть, особенно много всякого мусора сохраняют браузеры. Я обратил внимание на нескольких современных ноутбуках/моноблоках с производительным процессором, но с медленным HDD, что сжатие диска делало работу на этих устройствах заметно комфортнее.

"Логика подсказывает: если ресурс SSD ограничен количеством циклов перезаписи, то для увеличения срока жизни нужно уменьшить объём записи. " - По моему дилетантскому мнению для черепичных HDD это тоже кстати внезапно стало актуальным. По крайней мере пока не введут драйвера в ОС, в полной мере учитывающие эту особенность.

Хотел бы я купить SLC-накопитель объемом хотя бы 120ГБ, под систему, свап и подобное (или майнинг чего там, что много переписывает данных) — должна же быть возможность, если технологии с тех пор шагнули достаточно далеко. Тем более, что даже если взять "обычный" TLC и заставить его использовать 100% объема как SLC, он "похудеет" всего втрое. Но что-то я о таких не слышу… Или не там смотрю?

Такие же мысли. Здравый смысл подсказывает, что на "вечном" диске денег не заработать. Вот и отправляются в помойку ССД, которые (в теории) могли бы работать ещё сотни сроков.

В домашнем использовании SLC избыточно. Если хочется близкий к вечному диск домой - поищите MLC. Они еще продаются. У меня в домашнем компе Crucial M500 на MLC. Возраст у него к 10 годам идёт, TBW 40+, время работы ~40k часов и я думаю проживет он еще много. До момента, как станет полностью неактуален (windows n перестанет влезать в 200гб).

Новые SLC сейчас купить можно. Но из серверного сегмента, за очень дорого.

У меня есть OCZ RevoDrive X2 240 GB, купленный в 2011 году. Для того времени его параметры были фантастическими.

После почти 100 тысяч часов непрерывной работы я его отправил на полку с 97% оставшегося ресурса и заменил на NVMe. Банально морально устарел как по объёму, так и по скорости.

Так что не вижу смысла покупать что-то вечное.

У меня старичок только под систему используется. Его достаточно. Все, что требует скорости, так же переехало на m2 nvme.

Я скорее жду когда контроллеры SSD поумнеют достаточно, чтобы по мере износа автоматически переключаться по режимам QLC->TLC->MLC->SLC

Обязательно. Конечно если вы приобретете полную подписку.

Знаете, я наверно даже в какой-то мере за платную подписку на разблокировку режимов помимо QLC. В том смысле, что я вижу в этом плюсы.

Если я покупаю сразу устройство в котором всё разблокировано, то производителю невыгодно делать его надёжным. я уже все деньги заплатил.

А вот если я буду платить только после исчерпания ресурса ячеек памяти, что скорее всего будет за пределами гарантийного срока, то будет стимул делать более-менее надёжно.

Вроде ссд уже сейчас умеют переключать 1/2/4/8 бит на ячейку в зависимости от наполненности. Видно по бенчмаркам скорости работы.

Таким образом ваш крутой QLC диск магическим образом является SLC пока в нём занято меньше 25% места.

ЕМНИП большинство накопителей не имеют использовать весь свободный объём для slc-кэша.

1)ну так если SSD умрёт раньше чем будет смысл уменьшить битность то я просто не куплю подписку.

2)я слышал только про 1/4 и он в любом случае уплотняется, даже если занято только 25%, чтобы 75% ячеек были готовы к записи в SLC режиме. т.к. qlc запись очень медленная.

SMART честно говорит «через пару месяцев я помру — меняй.

Уже PLC существует, кстати.

QLC это же днище. Тормозное, со слабыми дровами и очень ненадежное. Зачем такое?

SMART честно говорит «через пару месяцев я помру — меняй.

уже несколько лет стоят несколько самсунговских qlc под кэшом нжинкса. один сдох в первые недели работы и был заменен, после этого эксцессов не было.

вот смарт с одного:

Device Statistics (GP Log 0x04)

Page Offset Size Value Flags Description

0x01 ===== = = === == General Statistics (rev 1) ==

0x01 0x008 4 11 --- Lifetime Power-On Resets

0x01 0x010 4 20082 --- Power-on Hours

0x01 0x018 6 671374134312 --- Logical Sectors Written

0x01 0x020 6 683914112 --- Number of Write Commands

0x01 0x028 6 3863889315949 --- Logical Sectors Read

0x01 0x030 6 10011152378 --- Number of Read Commands

0x01 0x038 6 2999000 --- Date and Time TimeStamp

0x04 ===== = = === == General Errors Statistics (rev 1) ==

0x04 0x008 4 0 --- Number of Reported Uncorrectable Errors

0x04 0x010 4 0 --- Resets Between Cmd Acceptance and Completion

0x05 ===== = = === == Temperature Statistics (rev 1) ==

0x05 0x008 1 38 --- Current Temperature

0x05 0x020 1 55 --- Highest Temperature

0x05 0x028 1 21 --- Lowest Temperature

0x05 0x058 1 70 --- Specified Maximum Operating Temperature

0x06 ===== = = === == Transport Statistics (rev 1) ==

0x06 0x008 4 28 --- Number of Hardware Resets

0x06 0x010 4 0 --- Number of ASR Events

0x06 0x018 4 0 --- Number of Interface CRC Errors

0x07 ===== = = === == Solid State Device Statistics (rev 1) ==

0x07 0x008 1 17 N-- Percentage Used Endurance Indicator

|||_ C monitored condition met

||__ D supports DSN

|___ N normalized valueбольше 2 лет аптайма под нагрузкой 24/7. смарт говорит израсходовано менее 1/5 ресурса.

вот именно для той задачи (пусть небольшая, но непрерывная нагрузка на диск) — да, медленное. но всё равно далеко не hdd )

а для домашнего использования за счёт slc-кэша в большинстве нагрузок будет неотличимо от прочих ssd.

Как я уже говорил — самое то для бюджетной пишущей машинки

ну вот первый пришедший в голову более-менее современный накопитель на qlc:

https://www.anandtech.com/show/16503/the-intel-ssd-670p-review/4

первые 200+ гигабайт пишутся на скорости 3 гигабайта в секунду, остаток — 300-400 мегабайт в секунду (с падением до 250 в самом конце).

случайное чтение помедленнее tlc, но не в разы.

случайная запись будет так же идти в этот большой slc-кэш.

это какой самсунг пишет на скорости 30 гигабайт в секунду? или выдает 100к iops в случайном однопоточном чтении?

в чём я передёргиваю?

нормальные пользовательские нагрузки — последовательное чтение-запись относительно больших объёмов данных, случайное чтение и случайная запись в один поток.

на всех на них накопитель показывает себя отлично.

после записи 200+ гигабайт «в один присест» скорость просядет?

a. плевать, это нетипичные для дома нагрузки;

b. просядет она примерно до цифр среднего sata ssd.

на той машине, с которой сейчас пишу, стоит sata ssd. вообще нисколько не страдаю.

какие домашние задачи кроме видеомонтажа требуют записи многих сотен гигабайт на высокой скорости?

Я же сказал, qlc — дешёвое говно, почти не лучше hdd, но сойдет для печатной машинки. А вы свой личный выбор пытаетесь оправдать

Я же сказал, qlc — дешёвое говно, почти не лучше hdd

ну да, 10000 iops на случайном чтении (и больше на случайной записи) против 100 iops — «почти не лучше».

вы так и не привели ни одного реального сценария в котором тот 770p будет ощутимо медленнее собратьев на TLC. могу привести за вас: раскатывание образа системы из бэкапа. как часто типичный домашний пользователь этим занимается?

а чтобы увидеть преимущество, нужно в качестве источника данных другой nvme, а если он не локальный — хотя бы десятигигабитную локальную сеть.

Развернуть систему из бэкапа — это самый простой кейс, тупая последовательная запись от начало диска, даже ни одна программа-оптимизатор из драйвера не задействована

Развернуть систему из бэкапа — это самый простой кейс

как часто вы на домашней машине разворачиваете бэкапы размером более 200 гигабайт? бэкап виртуалки/основной системы обычно заметно ниже.

программа-оптимизатор из драйвера

можете пояснить, что за программы-оптимизаторы?

и да, sata и nvme — стандартные интерфейсы, каких-то драйверов от производителя не требуют.

Ну да, просто защищаете свою покупку

да нет у меня в личном пользовании ни одного qlc. на серверах есть, так вышло )

1)файлопомойка для тихого компа.(так юзает мой брат)

2)игропомойка. Там записи особо нет. так что ресурса даже QLC хватит.

3)Так и я про то. Смарт должен говорить не через пару месяцев помру, а через пару месяцев переключусь в TLC.

4)Про проблему с дровами и ненадёжность QLC не слышал. слышал только про низкий ресурс.

голословное утверждение.

да и нелогично, зачем производителям контроллеров и прошивок для них создавать ухудшенную версию для qlc?

вот первый пришедший в голову контроллер:

Thanks to Phison’s SmartECC and new LDPC (Low Density Parity Check) error correction algorithms, the Phison E12 is ready for 3D TLC and 3D QLC NAND. It also supports up to 8 NAND channels and 32 NAND chip enable lines, which means it can support up to 8TB of NAND total, four times more than the 2TB the E7 could support before it.

контроллер умеет и QLC, и TLC. и на нём построены (в том числе и) вполне производительные TLC-накопители.

А данные автоматически удаляться будут? Или хочешт при форматировании выбирать и чтобы объем на четверть падал?

Но не только этим снижается ресурс записи на многобитных ячейках. Как вы могли понять из теории — аппаратных различий для MLC, TLC или QLC памяти — нет. Меняется только процесс интерпретации записи, который задаётся программно. Иными словами если контроллер накопителя это позволяет, то QLC можно записывать в более простых для записи TLC, MLC или SLC режимах. Что сейчас активно и делается, хотя не на всех накопителях, но если пару лет назад было редкость — перезапись накопителей с уплотнением, то сейчас редкость когда такого не происходит. Работу уплотнения записи отлично было видно в тестах накопителей, когда при полной последовательной записи скорость падала в несколько градаций.

Вначале накопитель занимал весь свой объём записывая всё в однобитном режиме. То есть абы какой заряд уже абы как смещает стоко-затворную характеристику, но этого достаточно чтобы записать один бит на ячейку. И в таком режиме весь объём ячеек быстро заканчивается. По данным о диске он ещё записан совсем чуть-чуть, но на самом деле он полностью забит данными. И для дальнейшего записывания накопитель начинает уплотнять запись.

Объём накопителя может снижаться только при записи.

Я хочу, чтобы при невозможности записать блок ячеек в QLC режиме, он записался в TLC режиме, а для ос это выглядело как какой-то файл занимающий те биты, которые невозможно записать.

Т.е. примерно как в виртулке хост надувает баллоны, если виртуалке выделено больше оперативной памяти, чем сейчас хост может предоставить.

Если такое невозможно, я хочу чтобы при исчерпании ресурса накопитель сказал:

Я больше в QLC писать не могу. Считай с меня все данные и отформатируй в tlc

Я хочу, чтобы при невозможности записать блок ячеек в QLC режиме, он записался в TLC режиме, а для ос это выглядело как какой-то файл занимающий те биты, которые невозможно записать.

что-то выглядит как протекание абстракций (ос работает с блочным устройством постоянного размера, к которому она имеет монопольный доступ).

и вы уверены, что «флеш износился и не может работать в qlc режиме, при этом в tlc режиме работает стабильно и ресурс в этом режиме достаточный» — это хоть сколько-нибудь часто встречающееся состояние?

вообще ИМХО износ флеша переоценен, обычно пользователь сталкивается с ним в случае брака или осознанного использования флеш-памяти низкого grade (ультра-бюджетные китайские накопители).

выше писал, что те же samsung qvo у меня трудятся под кэшем nginx, да, они мне не нравятся, тормозят, но работают же!

=== START OF INFORMATION SECTION ===

Device Model: Samsung SSD 860 QVO 2TB

ID# ATTRIBUTE_NAME FLAGS VALUE WORST THRESH FAIL RAW_VALUE

5 Reallocated_Sector_Ct PO--CK 100 100 010 - 0

9 Power_On_Hours -O--CK 096 096 000 - 18031

177 Wear_Leveling_Count PO--C- 067 067 000 - 259

179 Used_Rsvd_Blk_Cnt_Tot PO--C- 100 100 010 - 0

181 Program_Fail_Cnt_Total -O--CK 100 100 010 - 0

182 Erase_Fail_Count_Total -O--CK 100 100 010 - 0

183 Runtime_Bad_Block PO--C- 100 100 010 - 0

187 Reported_Uncorrect -O--CK 100 100 000 - 0

195 Hardware_ECC_Recovered -O-RC- 200 200 000 - 0

241 Total_LBAs_Written -O--CK 099 099 000 - 687396390381

Device Statistics (GP Log 0x04)

Page Offset Size Value Flags Description

0x07 ===== = = === == Solid State Device Statistics (rev 1) ==

0x07 0x008 1 34 N-- Percentage Used Endurance Indicatorто есть за 2 года аптайма на накопитель было записано 350 ТБ (примерно 150 его объёмов), среднее число циклов erase/program составило 259 (то есть WA ≈1.5), при этом накопитель считает, что его износ составил 34% и продолжает работать.

это, напомню, при использовании в качестве кэширующего накопителя, запись 24/7.

при типичном домашнем использовании же этот накопитель будет вечным. да, qlc.

что-то выглядит как протекание абстракций (ос работает с блочным устройством постоянного размера, к которому она имеет монопольный доступ).

1)меня устроит если ОС будет считать это скажем сетевым диском.

2)если вам надо именно как обычный диск, то я предложил вариант с форматированием... ну или спец утилитой режим переключить

и вы уверены, что «флеш износился и не может работать в qlc режиме, при этом в tlc режиме работает стабильно и ресурс в этом режиме достаточный» — это хоть сколько-нибудь часто встречающееся состояние?

Вы можете рассматривать это в обратную сторону. Добавить ещё 1 бит на ячейку для увеличения ёмкости. До тех пор пока ресурс позволяет. Потом переключиться на режим по умолчанию.

осознанного использования флеш-памяти низкого grade (ультра-бюджетные китайские накопители).

Скажем так. надо покупать либо дорогое решение, либо копаться в обзорах.

А будь такая система, то купил SSD. Сдох быстро?-гарантия. Сдох через неделю после окончания гарантии? ну потеряй 20-25% ёмкости и работай дальше. И не надо переплачивать за супер SSD или копать мануалы.

Хотел бы я купить SLC-накопитель объемом хотя бы 120ГБ, под систему, свап и подобное (или майнинг чего там, что много переписывает данных) — должна же быть возможность, если технологии с тех пор шагнули достаточно далеко. Тем более, что даже если взять «обычный» TLC и заставить его использовать 100% объема как SLC, он «похудеет» всего втрое. Но что-то я о таких не слышу… Или не там смотрю?Почитайте про SLC кэш.

Грубо говоря это оно и есть, если диск не засран сильно (занято не больше 25-50-75%), то скорости совсем другие. Можно начать с этой статьи habr.com/en/company/vdsina/blog/543608

Я знаю, что такое SLC кэш. Меня интересует возможность заставить накопитель работать в режиме "кэша" размером 100% объема. И вот такого пока не наблюдаю в потребительском сегменте. Нашел ради интереса поиском какой-то military grade SSD подходящего объема, но у него интерфейс физически очень интересный — вроде и SATA, а штырьковый разъем, вероятно, каких-то НАТОвских стандартов. Заявлен SLC, кстати. Вот хотел бы такое же, но в доступе обычным пользователям.

нет, в большистве прошивок размер slc-области сильно ограничен.

это в общем-то видно по продолжительным тестам в обзорах — никакой записью половины (трети для tlc) накопителя на высокой скорости там и не пахнет

и да, даже если накопитель записал в slc-кэш, во время простоя он начнёт переписывать данные в mlc.

P. S. https://habr.com/ru/company/first/blog/660193/#comment_24276267

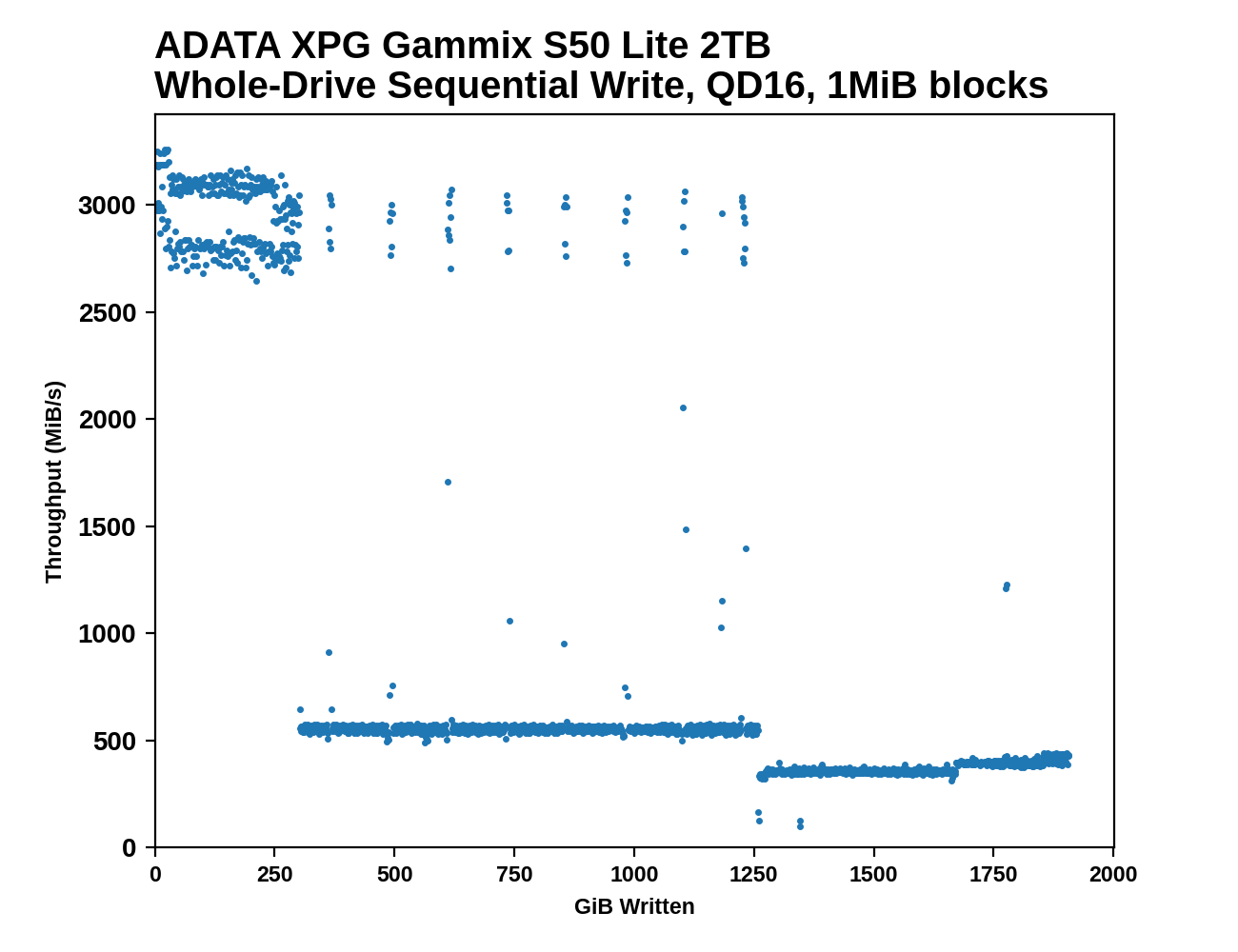

Прикол SSD заключается в том, что самый долгий процесс — это стирание ячейки, что наглядно видно на графике:

- Фаза записи в SLC-кэш.

- Фаза записи в свободные ячейки TLC.

- Фаза перезаписи TLC-ячеек (некуда писать новые данные, нужно сначала стереть существующие.

А теперь самое интересное: время, необходимое для стирания ячейки, одинаково вне зависимости от того, в каком режиме используется ячейка: SLC или TLC. А это значит, что после исчерпания свободных ячеек скорость записи в SLC-режиме будет в 3 раза ниже, чем в TLC-режиме — всего 100 мбайт/сек.

Соответственно, для сценария "хочу писать много данных" перевод диска из режима TLC и режим SLC будет контрпродуктивен, так как скорость записи будет очень сильно проседать.

Возьмите больший накопитель и ограничьте объём. Диск на 500Gb QLC (Intel) имеет SLC кэш в четверть объёма. Хотя, при частой перезаписи нужна непрерывная TRIM. Кстати, любопытно было бы посмотреть такие тесты.

По своему опыту скажу (работал в ДЦ), мрет все, HDD чаще, SSD реже, многое зависит от нагрузки.

HDD будут умирать из-за ограниченного количество операций, это число слишком низкое и как итог, диск постоянно находится под нагрузкой, в итоге ему настает время уходить, если говорить про диск в какой-то бэкапник или просто архивный сервер, то там HDD может жить долго, но зависит от производителя, те же Seagate Baracuda бывают уже трупами из коробки. При этом, только что разобрал порядка 14 HDD дисков. Seagate совсем хлипкая конструкция, пока по компонентам внутри меня удивил WD Black, довольно такая серьезная железка внутри, также за ними идут Hitachi, а все остальное...

Теперь о SSD, это говно мрет пачками, но, тут конечно зависит от типа SSD, производителя и подаваемой нагрузки, если говорить о Intel или Samsung, то есть шанс, что SSD перейдут в read only режим и будет возможность получить хотя бы информацию с них, но есть много других случаев, типа того же Crysal и Kingston, когда SSD просто отпадает и ее не видно на контроллере.

У меня до сих пор в работе, в качестве накопителя в роутере торчит SSD Intel 80GB, купленная в 11м году: SSDSA2M80G2GC, у нее 4 релокейта и она работает как часы и думаю еще долго прослужит.

под Linux можно перейти на более продвинутую файловую систему: например, ZFS со встроенным сжатием, которое снижает количество операций записи, при этом увеличивая скорость, вместительность и срок жизни накопителя

я бы так не сказал, у zfs присутствует write amplification, сама природа cow такова. можно, конечно, снизить write amplification уменьшением recordsize, но тогда вырастут накладные расходы и упадёт эффективность сжатия.

12 лет назад написал такой пост про первые массовые SSD.Так до сих пор пара этих SSD работает. https://habr.com/ru/post/83053/

Мой первый SSD - Intel 60GB (не помню модель, вроде 320). Потратил на него кучу денег относительно всяких унылых OCZ. Работает до сих пор, причём под Windows XP в IDE режиме - SSD Toolbox умеет в таком режиме тримить. В итоге с тех пор тратился только на Intel, потом перешёл на Samsung. Последние несколько SSD пользуются в режиме "а и пофиг" - ни один не умер ещё.

Так до сих пор пара этих SSD работает.

Шутка в том, что эти ранние ссд были ещё необкатанной технологией, поэтому делали их с запасом, с кучей дополнительных защит (например, по питанию). Сейчас в ссд уже много что удешевили, про ресурс флэш-памяти уже сказано, так что экстараполировать опыт первых поколений сильно не стоит.

причём под Windows XP в IDE режиме

Это диковинна какая-то, что за «IDE-режим». Ранее распространен был IDE интерфейс у накопителей, но ваш пост явно не про это (сомневаюсь, что на IDE вообще были выпущены ссд), и уж тем более интерфейс не мог быть «изменен в тулбоксе».

Может вы имеете ввиду, что он у вас по PATA работает, вместо AHCI? Да так, в принципе, любой ссд должен уметь, тем более старых, опять без каких-либо переключений. Только это бессмысленно, лишь теряете в скорости, лучше доставить на XP драйвера AHCI и переключить в нормальный режим. Я такое делал даже для обычных жестких дисков.

В целом, вопреки мифам, ссд нормально работает на win XP, с учетом двух факторов. Во-первых, надо проводить разметку диска вручную, а не встроенным установщиком, чтобы раздел начинался не с нечетного сектора (лучше вообще его выбрать с запасом, 2Мб за глаза). И, во-вторых, в XP нет автоматического трима. Для нормальных ссд от этого ни холодно ни жарко, но у дешевых могут быть проблемы с производительностью. Решается использованием отдельных утилит: или ручным запуском через определенные промежутки времени, или постановкой в планировщик.

он у вас по PATA работает, вместо AHCI?

Да, просто в BIOS того компьютера пункт называется IDE. А стоит в PATA режиме просто потому что система переехала с IDE диска, да так и оставили. Хорошо ещё, что SATA порт на материнской плате уже был.

лишь теряете в скорости

На той машине скорость не нужна. Там даже CompactFlash хватило бы, если бы они ещё остались в запасах.

Решается использованием отдельных утилит: или ручным запуском через определенные промежутки времени, или постановкой в планировщик.

Именно так и работает Intel SSD Toolbox - раз в неделю запускается и триггерит TRIM диска и PATA режим ему не помеха. Как он это делает - уже другой вопрос, но работает и ладно.

раз в неделю запускается и триггерит TRIM диска и PATA режим ему не помеха.

А вы проверяли что он реально делает трим, а не его видимость?

А как это проверить? Производительность в норме, ресурса по смарту ещё полно. Есть похожие диски на компах с семёркой и по состоянию у них примерно всё так же. Даже если и не работает как надо - за 9-летний диск никто сильно горевать не будет, заодно будет повод сделать полноценный апгрейд.

А как это проверить?

trimcheck погуглите. Лично у меня как раз оф. интеловская утилита по факту трим не делала, хотя успешно отчитывалась, и это в AHCI. Что он проходит в PATA глубоко сомневаюсь. Проблему решал сторонней утилитой, которая в честный трим оказалась способна.

Даже если и не работает как надо

Как минимум уберете из планировщика бесполезную задачу.

А в целом, да, тем старым дискам трим не особо нужен. Это новым дешевеньким фиговенько, которые стали очень критичны к выравниванию ресурса.

Оказалось, что самый старый SSD на 60 гигов, который покупался «подешевле и все равно быстрее блинов» — оказался сравним с жужжалками…

Создал в ОЗУ программой "RAMDisk" ещё один привод, ёмкостью 800 мегабайт. В настройках браузера указал путь для кэша на этот диск. Нагрузка на SSD, конечно, снизилась. Но я не уверен, что это будет превалирующим фактором в сохранении его долговечности. Хорошая вентиляция - важнее.

у самсунга есть утилитка которая использует часть озу как кеш (rapid) какого-то там уровня для диска, как раз для браузерног кеша и прочих мелких файликов

а вообще современные TLS как мне кажется очень живучие и через какое-то время из соображения обгрейда придется менять диск а не из-за того что ресурс кончился, хотя от стиля использования зависит.

Закон Мура — это не про технический прогресс, а про стоимость и максимизацию прибыли, частный случай законов Маркса. Об этом тут в далеком 2014 году писали в блоге Интел.

https://habr.com/ru/company/intel/blog/237607/

Закон Мура был и остается законом стоимости. И многие вещи были бы понятнее, если бы люди помнили об этом.

ну там надо считать, потому что цена убоя гигабайта у современного большого диска может оказаться существенно ниже чем убоя маленького и/или старого диска... ну при условии что честно покупаешь, а не берешь из тумбочки.

те на 1тб можно не только файлы подкачки хранить, но и ещё что-то виртуалки/базы/кино 4К в конце концов :) а у 125мб и ресурс меньше и хватит только под своп

Винда кстати умеет использовать SSD для ускорения HDD freemansoft/win10-storage-spaces: Scripts for creating an destroying Fault Tolerant multi-tier storage spaces on Windows 10 (github.com)

Под Linux можно перейти на более продвинутую файловую систему

Не сказал бы, что этот совет хорош. Точнее, всё зависит от сценария работы.

Ресурс SSD неплохо так расходуется при работе с мелкими файлами из-за write amplification, и использование подобных файловых систем только увеличит число мелких записей, что приведёт к более быстрому расходованию ресурса диска.

Вот только редко какой современный бук в качестве второго винта теперь поддерживает HDD. А вот лет несколько назад... Когда SSD были еще относительно маленькие. В каждом буке был лоток под 2.5 HDD. Вот и думай, что это, прогресс или просто бизнес и ничего более.

В некоторых ноутбуках была ещё опция на место CD или второго 2.5 диска поставить дополнительный аккумулятор.

Я тоже так думал на протяжении долгого времени, только у меня HP был.

А потом купил MSI PS63 и понял, что прогресс таки есть. Вес в 2 раза меньше, а время автономной работы не уменьшилось.

Вот и думай, что это, прогресс или просто бизнес и ничего более.

нечего хлипкой механике делать в ноутбуке

У последних iMac на intel SSD распаян, в интернете так и не нашел мануалов по его перепайке, или хотя бы даже что за чипы памяти там стоят. Сюрприз.

Отключил все жрущие диск процессы - укладываюсь в запись 10Гб/рабочий день, очень надеюсь увеличить срок жизни.

На М1 с 8Гб свап жрётся нещадно, намного больше - 15-20 Гб/рабочий день думаю намного быстрее крякнет, но всё-таки верю в качество чипов эпле.

Стоял бы какой-нибудь 970 PRO на 1Тб даже бы не задумывался за его износ. По стоимости не сказать чтобы дорого, а ресурса у 1Тб предостаточно на 5 лет если не извращаться и не использовать его под SQL, для этого есть Intel DC серии.

Еще есть опыт покупки в организацию в разное время 50 разных SSD на 120Гб - Crucial, A-Data, WD, SanDisk, Kingston, даже Smartbuy и что-то там еще под одну и ту же базу 1С на каждом компе, считайте 8-10 Гб чтения/записи в день, дак вот все кроме зеленых WD летели (чаще всего контроллер показывал высокую температуру хотя диск был холодный и резали скорость записи-чтения до 10-15мб) и менялись по гарантии раз в пол-года, не знаю как там сейчас с этим дела - все поменяли на WD и от 240Гб для увеличения ресурса и проблема пропала.

Кто?

По слухам — своп перестал жраться неимоверное

Нет, на последнем обновлении MBP M1 8/256 своп начинает жраться уже с открытым браузером с 5 вкладками, а на 32Гб imac своп вообще не подключается. У мака чем больше оперативки воткнешь тем больше он отожрет, с 16гб отъест 8гб, с 32гб при тех же действиях уже 14гб. Для 8Гб слабовато оптимизирована система, хотя кроме как по цифрам у М1 это не заметно.

У меня был такой. Куплен в 2010 году, умер через 1.5 года. Точнее, не умер, а начал терять информацию: появились искажения в записанных данных. Но проблема, скорее всего, была в дико сырой прошивке: судя по данным SMART, число циклов перезаписи отдельных блоков (Max PE Count) превышало 100 тысяч при ресурсе в 10 тысяч.

Если кто-то купил SSD-шник, накатил на него винду, кучу программ, и занял 90% места данными, которые не меняются годами, то остальные 10% будут изнашиваться в десять раз быстрее.

Я думаю, контроллер справится с фоновым переписыванием данных для выравнивания износа ячеек.

Тут же дело в другом:

Чем больше объём диска, тем выше суммарный ресурс и тем больше можно на него записать данных.

Чем больше свободного места на диске, тем эффективнее контроллер может его использовать: например, организовать из него SLC-кэш, что увеличит скоростные характеристики.

> то остальные 10% будут изнашиваться в десять раз быстрее

Не будут, современные диски двигают данные периодически если отдельные блоки выбиваются по износу. Одна из причин почему записанные под завязку SSD начинают тормозить.

для увеличения срока жизни нужно уменьшить объём записи.

можно перейти на более продвинутую файловую систему: например, ZFS ... или Btrfs

Я, возможно, неправ, но в какой вообще вселенной CoW FS уменьшают объем записи на диск? Особенно тут интересно про Btrfs, про которую есть тут - https://habr.com/ru/post/476414/. Вроде бы, путем тюнинга можно добиться, чтобы Btrfs или ZFS не сильно увеличивали объем записи...

Эти пессимистичные сценарии не связаны с принципиальными проблемами CoW. В типичных сценариях Btrfs и, тем более, ZFS показывают весьма и весьма приличную производительность, т.е. весьма и весьма низкие накладные расходы, как на чтении, так и на записи.

А совет связан с возможностью сжатия данных «на лету», что снижает объём записи на интерфейсе компьютер-SSD и часто ускоряет работу, т.к. алгоритмы сжатия часто работают шустрее интерфейсов SSD.

Другое дело, что в наше время «умных» SSD со встроенными механизмами сжатия, не факт, что сжатие уровня файловой системы хоть как-то снижает объёмы записи на интерфейсах собственно микросхем флэш памяти. Т.е. не факт, что включение сжатия уровня файловой системы (NTFS, APFS, HFS+, Btrfs, ZFS) вообще увеличивает срок жизни SSD.

алгоритмы сжатия часто работают шустрее интерфейсов SSD

Совмневаюсь, что на лету можно сжимать со скоростью порядка 2 гигабайт в секунду.

Для SATA это оправдано, а вот для NVMe — вряд ли.

И сжимать можно со скоростью порядка 2 гигабайт в секунду и более, хотя это и непросто, т.к. требуется несколько ядер и шустрая память.

А если тестировать просто, в один поток, то:

$ lz4 -b1

1#Synthetic 50% : 10000000 -> 5859357 (1.707),1031.7 MB/s ,7148.8 MB/sПротив:

$ dd if="$tfile2" of=/dev/null bs=8m

4257+1 records in

4257+1 records out

35715547136 bytes transferred in 10.645362 secs (3355033551 bytes/sec)Т.е. на MacBook Pro (16-inch, 2019, APPLE SSD AP2048N, NVME x4), при наивной реализации файловой системы со сжатием, в однопоточных тестах скорость записи снизится в четыре раза, но скорость чтения увеличится в полтора раза.

Это следует из утверждения, что если у вас много физической памяти, значит, вы используете большое количество ресурсо-затратных задач, и значит, вам и свопа надо больше.

Ну и ещё один момент: свободная память используется операционной системой в качестве файлового кэша. Поэтому сброс неиспользуемые программами страницы памяти могут быть сброшены в своп ради увеличения количества свободной памяти.

читаю и диву даюсь

я был против ССД и показывал на них пальцем "а вы знаете что их ресурс ограничен?" задолго до того, как производители начали стыдливо указывать это в спеках. И многие смотрели на меня как на параноика в шапочке из фольги.

минули годы, и теперь "ограниченое кол-во циклов" уже не шокирующая правда, а принятый всеми факт, и то что "йор дата нот сейф" уже никого не удивляет.

Так принято.

Капитализм любит когда платят.

"Скупой платит дважды, тупой - трижды, лох платит постоянно (привет всем любителям подписки)" - старый пост-советский мем стал реальностью.

вот вам циферки чтобы вы видели, ага! пробег, да-да! износ, извольте привыкнуть. Скоро вам подвезут супер-быстрые ССД с 50 циклами перезаписи, как вы любите, чтобы вы сидели и дрожали, пока винда самозабвенно пишет логи. И софт. Софт тоже любит логи. Это же важно. Про постоянную перезапись свопа - это "слишкам сложна" для зумеров.

у меня до сих пор для оси стоят 80-гиговые HDD и бед не знают, а ведь прошло уже больше 10 лет, периодическая дефрагментация по необходимости, смарт-показатели на отлично, бэдов нет, при том что винда любит движ, обновления и логи постоянно ведут I/O. Для хранения данных более емкие ХДД, для кеша браузера и файла подкачки - рамдиск.

Видимо я что-то делаю не так, раз все работает как часы, и мне не нужно судорожно изучать многочисленные талмуды "как мне сэкономить операции чтения\записи на диск который я зачем-то купил (впарили в магазине) и теперь дрожу как бы мои дипломы или коллекция NFT(порнушки) не отправились к праотцам".

Ну, если вам так не мешает что винда и программы грузятся по пять минут, и последние постоянно подлагивают из-за дозагрузки с диска, кто ж вам судья? А ещё в компьютере могут быть и SSD и HDD, одновременно, если вы были не в курсе.

Для домашнего использования ресурса SSD более чем достаточно, вот еще один 10-летний SSD, причем даже на момент выпуска позиционировавшийся как дешевая модель для замены традиционных жестких дисков... Работает, читается и пишется.

Ну такое себе "дешевая модель"))) SV300S37A серия на MLC, дешевая она лишь из-за объема, но в категории 60Г она недешевая)) Но серия легендарная, они еще и на авито запечатанные продаются) Насчет надежности - таки да, у меня 120G модель этой серии, причем даже 2 штуки, обе с 13 где-то года пашут, у жены на компе оно особо не нагружается, а у себе я то систему переставлю, то еще что-то, но всегда строго файло подкачки, temp - на жесткий диск, документы-загрузки-фото-рабочий стол - на жесткий диск. Второе - просто чтобы не париться и не переносить все при очередной переустановке) Hiberfil отключаю, иногда жесткими символьными ссылками перекидываю браузерные кэши. Диск в CrystalDisk абсолютно здоровый, ресурс где-то на Тб 12-13 исчерпан. Кстати, по этой же причине на жестком диске в CrystalDisk тоже все отлично - механика не нагружается кучей операций чтения-записи. Из-за того, что системник SSD - жесткий диск преимущественно работает в режиме линейного чтения или записи.

всегда строго файло подкачки, temp — на жесткий диск

зачем тогда ssd?

на своей системе могу наблюдать и тысячи iops к свопу, на отзывчивости сказывается примерно никак. был бы это hdd со своей сотней iops, система бы просто «встала колом»

Как зачем? Чтобы сберечь его ресурс и продолжать пользоваться 60-гиговым диском и через 10-15 лет.

на отзывчивости сказывается примерно никак

Из-за этого тоже могут быть проблемы. Считал я как-то пачку данных, в память не влазила, поэтому активно использовался своп. Да, система просто летала, но и писала данные со скоростью порядка 1-2 гига в секунду. Если бы я такое потребление памяти сразу не заметил, то это бы стоило 1% ресурса в час. Многовато будет.

Проблема большинство ССД дохнут до этого износа по TBW. Логичным решением видел еще 5 лет назад RAID 0 особое зеркалирование. Но не стандартный RAID 0 с двумя одинаковыми дисками ССД, а один ССД а второй НДД. Причем с особым алгоритмом зеркалирования - так как НДД медленнее чтобы он зеркалился в моменты простоя, а читался когда может и свободен (помогал как бы ССД при чтении в меру сил и незанятости). Но так и не нашел такого решения ни программного ни аппаратного. Может за 5 лет что то появилось?Никто не пробовал как то настроить RAID 0 массив из ССД и НДД с такими параметрами. Чтобы НДД постоянно зеркалил ССД и в меру сил помогал стандартно по RAID 0 при чтении и записи на ускорение ССД когда не занят зеркалированием? Зеркалирование должно производиться не в ущерб скорости, то есть НДД должен как бы догонять когда свободен ССД по точной копии, но не делать это когда ССД занят основной работой (чтобы не уменьшать производительность, не читать с ССД ничего для зеркалирования когда он занят). Наоборот в момент высшей нагрузки HDD помогал бы ССД как положено по RAID 0. Может кто знает как такое настроить или уже сделал так?

Проблема большинство ССД дохнут до этого износа по TBW

большинство? вы это серьёзно?

большинство ssd устаревают раньше, чем выходят из строя.

Ну не знаю...у меня из партии 23 штуки (брали разные) 4 уже сдохло за 2 года не отработав даже 10-ю часть TBW. При этом сдохли все Силикон повер с кучей битых ячеек в первый же год.

Один кингстон на большей части объема сейчас выдает скорость 10-20 Мб/с любых файлов и при тесте (примерно половина объема). TBW его всего 10%. Вот непонятно - это он сдыхает уже или как, хотя все программы тестов пишут "хорошее" состояние. Пытался форматировать и без формата тестить на разных компах - все равно половина областей и чтение и запись и тест просто поверхности скорость падает 2-20 Мб/с. Вообще я еще не видел на отрезке времени 7 лет ни одного ССД у нас, который бы морально устарел прежде чем сломался, и ни одного который бы доработал TBW

При этом сдохли все Силикон повер с кучей битых ячеек

да, бюджетные накопители, особенно от нонейм-производителей, часто сыпятся. секрет прост: флэш-память при производстве тестируется и делится на разные grade, цена, разумеется тоже разная. если производитель экономит на всём, то он ставит самую низкокачественную память. что-то может быть компенсировано прошивкой контроллера, но далеко не всё.

Пытался форматировать и без формата тестить на разных компах — все равно половина областей и чтение и запись и тест просто поверхности скорость падает 2-20 Мб/с

да, такое тоже бывает на бюджетных накопителях. причины две: или флеш изношен (но может быть прочитан после множества попыток), или таблица транслятора «загажена».

второе лечится secure erase, рекомендую попробовать.

обычно, если придерживаться правила покупать накопители от tier 1 (производителей флеш-памяти: micron/crucial, samsung, wd/sandisk/toshiba/koixia, hynix/intel/solidigm), и избегать самых дешёвых моделей (вроде bx500 у crucial), то ни первого, ни второго не встретите.

у других производителей, разумеется, тоже бывают удачные модели, но тут уже надо внимательнее смотреть (и помнить «не гонялся бы ты, поп, за дешевизной»).

ни одного который бы доработал TBW

это я тоже вижу нечасто, обычно ресурс tbw сильно избыточен для домашнего применения.

но есть накопители, которые по smart выработали 100% ресурса, и они просто продолжают работать.

да, бюджетные накопители, особенно от нонейм-производителей, часто сыпятся

Мы никогда не брали ноу неим....все диски кингстон, трансент, крушал, селикон повер, НР, WD, ..

обычно, если придерживаться правила покупать накопители от tier 1 (производителей флеш-памяти: micron/crucial, samsung, wd/sandisk/toshiba/koixia, hynix/intel/solidigm), и избегать самых дешёвых моделей (вроде bx500 у crucial), то ни первого, ни второго не встретите.

Самое интересное, что самые дешевые что мы брали смарт бай какие то, вот они как раз все живы и работают норм, хотя изначально не самые лучшие скорости, но их 400-500 МБ/с вполне хватает, и хватало бы у всех если бы такая надежность, то и скорости больше не нужны.

А зато вот силикон повер все сдохли в первые пол года, и кингстон потом сдыхали, а самые дешевые работают. Может реально есть смысл как то программно ограничить скорость до 300 даже нормально. Может ли это влиять на скорость деградации и пролить жизнь ССД?

Мы никогда не брали ноу неим… все диски кингстон, трансент, крушал, селикон повер, НР, WD, ..

ну из этого половина на мой вкус noname (тот же silicon power).

непонятно, почему у вас такое происходит. у меня опыт в основном с серверными моделями, но некоторое количество десктопных samsung, crucial и прочих тоже есть перед глазами, и проблем ровно 0. при этом я совершенно не сторонник «сбережения» ssd в стиле «своп отключим, а кэш браузера перенесём на hdd».

а что у вас с питанием? ранние модели могли не пережить неожиданного отключения, сейчас, вроде бы, такие ситуации везде обрабатываются корректно (могут потеряться последние записанные данные, конечно, но работоспособность накопителя не страдает).

Может реально есть смысл как то программно ограничить скорость до 300 даже нормально. Может ли это влиять на скорость деградации и продлить жизнь ССД?

нет ни одной идеи почему это могло бы сработать

Neitr, что у этих плохо работающих и сдохших SSD было с температурой, не было ли регулярного перегрева? Кстати, очень плохо, что производители SSD не записывают в SMART значение максимальной температуры (как это делала Hitachi для HDD). И что-то мне подсказывает, почему они этого не делают.

Только вы описываете не RAID 0, а RAID 1. И при чтении использование HDD практически бесполезно, так как значимого прироста не даст, а логику переусложнит.

В итоге просто получается фоновая репликация данных SSD на HDD.

Да, просто хочется или что то среднее между

RAID 1 и RAID 0, когда большие файлы пишутся на НДД, а мелкие на ССД с быстрым доступом. Но в итоге в свободное для дисков время все зеркалируется. Ну или может разные варианты настройки. К примеру еще 3-й диск НДД в массиве, который полная копия суммы ССД (с мелкими файлами) и НДД с большими.

вариант с 3-мя дисками 1 ССД и 2 НДД. На ССД пишутся мелкие файлы, на 1-й НДД пишутся большие файлы, а на 2-й НДД сумма (полный диск С) как бы пишется в свободное дисковое время. То есть 3-й НДД и есть полный диск, а ССД и 2-й НДД делят между собой крупные и мелкие файлы в какой то пропорции по алгоритму максимальной производительности.

Тогда уж не RAID 0 a RAID 1 — зеркало. А то глаза режет.

Вообще считаю, что для большого круга задач и вариантов использования ПК и подсистемы хранения данных был бы идеален в плане сбережения ССД вариант гибридных особых дисков (ССД+НДД), только не в таком варианте как сейчас гибридные диски, когда ССД часть выполняет роль больше кэширования, но и добавить алгоритм когда к примеру файлы мелкие (до 5-10 МБ) писались бы на ССД, а крупнее на НДД или какой то плавающий механизм с обучением какого размера куда писать для максимальной пары параметров производительность/сохранение ресурса ССД. Вот пока хочется реализовать это может как то программно из 2-х дисков ССД и НДД в массиве. Вручную кое что получается, но очень немногое - когда фильмы пишешь на НДД и прочие уловки. Но ведь даже вот в той же ОС или игре, бывают куча мелких файлов, и бывают очень крупные файлы. Как бы вот это разделить. Это бы очень сэкономило бы TBW ССД

А зачем SSD сохранять ресурс? Он скорее морально устареет до достижения TBW.

Зачем вместо одного носителя использовать два? Это дополнительная точки отказа.

Я выше написал, что по нашему опыту не так...ни один ССД не доработал ни до гарантийного срока ни до ресурса TBW ни тем более до морального устаревания. Да и что Вы имеете ввиду под "моральным устареванием" ССД? Я вот даже не пойму, как морально устареть может ССД у нас в системах...стоит там ОС и несколько программ, работают быстро....как может морально устареть ССД чтобы исправный нас не удовлетворял? и нуждался в замене

Вот к примеру стандартная папка винды ...у меня 18,42 Гб. всего 299349 файлов. При этом файлов больше 1 Мб размером всего 3206 штук, но они весят 11,54 Гб...то есть больше половины.

Так зачем их держать на ССД если они и с НДД не очень медленно считаются, не убивая более половины TBW. Тем более что многие из них вообще не читаются по 2-и более лет. некоторые лежат там неизменные с 2018, а к очень многим вообще не было обращения за всё время эксплуатации винды. Так зачем их писать на ССД и убивать TBW очень большой процент, если они неплохо могли бы лежать и на НДД. То же самое со многими программами и играми, я уже не говорю о фильмах и прочем медиа. Просто алгоритм разделения записи крупных файлов на НДД а мелких на ССД сэкономил бы более половины TBW при незначительном снижении производительности дисковой подсистемы или вообще не снижению на крупных файлах. Ведь реально выигрыш ССД существенный есть только на очень мелких файлах, вот и использовать ССД в том сценарии где он максимально производителен - писать на него только мелкие файлы, и пусть живет долго/дольше. Да и по цене и суммарной стоимости эксплуатации такой гибрид или массив из ССД и НДД будет дешевле в пересчете на 1 МБ хранения, чем гонять только ССД под все файлы используемые в работе.

не убивая более половины TBW

11 записанных гигов — это где-то 0.005% от TBW достаточно посредственного диска.

Ведь реально выигрыш ССД существенный есть только на очень мелких файлах, вот и использовать ССД в том сценарии где он максимально производителен — писать на него только мелкие файлы, и пусть живет долго/дольше.

Погуглите, что такое Write Amplification.

11 записанных гигов — это где-то 0.005% от TBW достаточно посредственного диска.

Если бы они просто лежали там как на НДД. Во-1-х ССД постоянно что то перезаписывает чтобы не терялся заряд, во-2-х майкроСофт постоянно обновляет эти файлы (какую то часть их них), порой просто на немного другой. Сам ССД постоянно перекидывает с ячеек на ячейки. Ну и плюс ко всему чем больше заполнен ССД тем меньше скорость его работы. Да пусть лучше они пустыми будут эти объемы. Так что файл даже если просто лежит на ССД постоянно съедает TBW гораздо больше своего объема.

Да и что Вы имеете ввиду под "моральным устареванием" ССД?

ну вот пример, у меня сейчас в старом ноутбуке стоит sata ssd на 120 гигабайт. из-за того, что в том ноуте максимум 4 гигабайта памяти, по смарту ресурс ssd давно «съеден» свопом, но ssd вполне работоспособен.

сейчас этот ноутбук неактуален, никакого разумного применения ему не придумать.

теоретически, ssd оттуда можно достать и куда-нибудь поставить, но только чисто теоретически: в домашнем компьютере основной сейчас ssd на терабайт, в другом ноутбуке на полтерабайта, ни там, ни там сотня гигабайт погоды не сделает.

и да, в новый ноут sata ssd просто не поставишь.

вот и получается, что этот ssd устарел морально.

Ну это не ССД устарел морально, это просто Вы не можете ему найти применение. Я бы нашел кучу способов для свободного 120 Гб ССД куда использовать. Как минимум просто доставить в комп под игры или программы, но чаще я просто собираю даже из малоёмких 2,5 SATA ССД (даже 60 гб) RAID 0 массивы со скоростями до 2-3 Тб/сек.

К тому же если бы можно было как то программно или аппаратно делать массив или гибрид ССД и НДД в котором мелкие файлы писались бы на ССД а крупные на НДД, то так называемое "моральное устаревание" происходило бы куда позже. Потому что ССД объема часто начинает не хватать именно из за крупных файлов выигрыш в работе с которыми у ССД не такой уж и большой, но они убивают TBW

Вот сейчас 2,5 ССД диск реально сама электроника занимает менее трети объема коробочки, ну и пусть бы там была НДД часть гибридного диска.

Ну это не ССД устарел морально, это просто Вы не можете ему найти применение

это и называется «морально устарело», когда пока ещё исправной вещи не находится применения.

массивы со скоростями до 2-3 Тб/сек

зачем устраивать путаницу из кабелей для десятка sata-накопителей, если одиночные современные nvme-накопители выдают столько и больше? при этом и latency немного ниже.

Так если нет порта для nvme . Это либо покупать плату переходник. Да потратить деньги всегда можно, вопрос то не в этом...вопрос в том, что можно же продлить эксплуатацию того что есть.

Делать бэкапы и прочее это все умеется и делается. Но это очень рутинная задача. Хочется просто либо автоматически чтобы в массиве зеркалировался системный ССД диск на НДД, либо просто увеличить срок службы да и отдалить моральное устаревание ССД тем что он будет работать только с мелкими файлами, под которые он хорошо заточен, а крупные файлы писались на НДД автоматом.

Вот у меня есть куча дисков 120 Гб которых часто не хватает просто потому что объемы программ уже больше. Да можно объединять их в RAID 0. Но так же есть куча НДД, И ССД еще бы надолго хватило 120 Гб если бы можно было сделать, чтобы все большие файлы (хотя бы больше 5-10 МБ) писались в системе не на ССД а на НДД, но видела бы это как единый диск. Реально вот отсортируйте все файлы на системном диске по размеру, вы увидите, что из миллиона файлов лишь 1-3% больше 1 Мб размером, но они занимают больше половины объема. Но реально размещайся и читайся они с НДД они бы не сильно тормозили бы весь процесс.

Конечно можно же все выкинуть под предлогом "морально устарели", накупить новых материнских плат...и в целом компов, или переходников РСI под nvme. Предлог "морально устарело" - очень удобный, но не для бюджета.

У нас вот даже 80 ГБ САТА диски нормально трудятся в RAID ах всяких комбинированных 0- 10, 1, с большими скоростями довольно. Причем это уже те диски, которые отсеяны на идеальность...видимо очень удачные, потому что многим по 15 лет даже, и ни одного проблемного показателя СМАРТ.

Есть куча 60 Гб ССД и 80-120 Гб НДД...по отдельности "морально устарели", но была бы связка ССД+НДД при котором ССД обрабатывал бы мелкие файлы, а НДД большие - это был бы нормальный сценарий по производительности для многих систем. При этом и общий объем 140-180 Гб - уже приемлемый бы был даже для сегодняшнего дня.

А у меня ещё своп на SSD и торренты туда же качаются. Мне ресурс не жалко, зато комфорта доставляет — огого. Это просто плата за комфорт. SSD — такой же расходник, как электричество, интернет.

edo1h, у вас не SSD устарел морально, а ноутбук.

разумеется, ноутбук устарел (и я уже не помню когда в последний раз включал его).

только какое отношение это имеет к вопросу устарел ли стоящий в нём ssd или нет? (и да, ssd был куплен отдельно и выпущен явно позже, чем ноутбук)

edo1h, отношение очень простое. Если бы вам хватало ноутбука, хватало бы и SSD в нём.

смелое и совершенно безосновательное заявление.

на самом деле места на том ssd перестало хватать, так что если бы я продолжал пользоваться ноутбуком, я бы задумался о замене ssd на более ёмкий

А у меня доработал. Положил на полочку PCI-E SSD на 240 гигов, купленный в 2011 году, после 10000 часов работы. Осталось ещё 97% ресурса. А вместе с ним вытащил ещё парочку SATA SSD аналогичного объёма. Заменил всё на 2TB NVM-e. Конечно, можно было оставить старые диски в работе, но зачем? Они место в корпусе занимают, а объём бестолковый.

Просто заменил на NVM-E

Морально устарел = маленький объём, а место занимает.

У вас в корпусе компа место платное что ли? Или у вас там склад еще чего то, что вы так экономите место? Весь объем корпуса для того и нужен чтобы туда что то встало, экономия этого пространства - странный аргумент. Ладно НДД - они шумят, но в ССД аргумент что занимает место в корпусе...мне непонятен. Выкинуть и не использовать ССД только с аргументом, что жалко под него место в корпусе как то уже из другой области чем "моральное устаревание"

Я не вижу смысла в огромном корпусе для домашнего сервера. А ещё да, я просто не нашёл дискам применение. Использовать старую технику ради процесса, а не результата — это не моё.

Много лет назад я доходил до того, что на материнской плате заканчивались SATA-порты, и даже ставил отдельную плату расширения, чтобы можно было ещё дисков воткнуть, тоже организовывал RAID. Просто было интересно возиться: денег мало, времени много. Но сейчас всё наоборот.

Ну я с Вашим случаем тоже согласен...но не считаю его общим. И маленькие корпуса не у всех (скорее всегда есть место и стандартные корпуса). Как частный случай - да. Но не как общий про "морально устарел". Комфорт - это не моральное устаревание детали. Можно и посуду каждый раз выкидывать а не мыть - ради комфорта...но это не значит что тарелка морально устарела. Как частный случай - замечательно.

ровно то, что вы описываете, реализовано в zfs, гуглить «zfs special device». только оно не на домашнее применение в первую очередь рассчитано.

1shaman, есть два вопроса на которые я пока не смог найти ответа. Надеюсь на вашу помощь.

Ресурс памяти TLC. Я видел два значения ~1000 перезаписей и ~3000 перезаписей. Так какая цифра верная и как это, вообще, можно определить?

TBW это хост-запись или NAND-запись (второе может быть в 3-4 раза больше)? И это гарантированная запись или до полного выхода из строя памяти?

Каков расход бензина у автомобилей с четырёхцилиндровым двигателем?

TLC бывает разный (разная толщина слоя, планарный/3d), да что там, после выпуска даже по одной технологии чипы тестируются и делятся на разные grade, у которых потом будет разная цена.

TBW указывается уже с учётом WAF для той нагрузки, для которой позиционируется накопитель.

На сайте JEDEC выложена неплохая статья

1 — Обе могут быть верными в зависимости от конкретных чипов (см. выше уже подробнее про это ответили). Скорее типичные границы диапазона в который укладывается основная масса памяти этого типа.

2 — Это хост запись считается. И гарантированный производителем объем в рамках которого накопитель должен сохранять уровень своей работоспособности/качества (таких как количество ошибок чтения, время сохранности записанных данных без перезаписи и других) не хуже предусмотренных в стандартах минимальных уровней. До "полного убития" обычно записать удается в разы больше, но уже с постепенной деградацией качества работы и надежности.

- гарантированный не значит конечно, что ВСЕ накопители данной модели его отработают. Как и с любой гарантией на любые устройства какая-то (если производитель не облажался в своих расчетах и оценках/прогнозах — совсем небольшая) часть загнется наоборот раньше. Просто это будет считаться гарантийным случаем, за который ответственность несет производитель.

Mad__Max, TBW в плане гарантии работает только в рамках указанного гарантийного срока в годах?

Да, или срок (в годах) или суммарный объем записи с хоста (TBW) — смотря что наступит раньше, тогда гарантийные обязательства производителя и кончаются.

Хотя зависит еще от производителя, некоторые при еще не кончившемся гарантийном сроке по годам и незначительном превышении TBW меняют по гарантии, например если диагностика покажет что диск не от износа умер, а каких-то других проблем. "Жест доброй воли" так сказать — превышение назначенного диску TBW дает право отказать в его гарантийном обслуживании, но не значит, что этим правом производитель всегда будет пользоваться.

Когда умрёт мой SSD — расчёт срока жизни