В своих размышлениях и прошлых попытках разработки ИИ, я добрался до сего дня llm - large language models. Однако этим моделям свойственны некоторые точности с контролем выходного результата, а именно почему получилось именно так.

Многие знают, что новое - это хорошо забытое старое. Поэтому эксперты старой закалки, опыта и знаний, находят решения, которые далеко не каждому придут в голову. Забегаю вперёд, скажу что это прототип, однако у него есть явные преимущества, плюсы и перспективы. Пока что на просторах интернета я не нашел подобных решений или они мало афишируются.

Надеюсь специалисты из крупных компаний, средними бюджетами и возможностью оплатить работу десятка специалистов, прочитают, увидят разумное зерно и преисполняется.

Техническое задание (ТЗ) на проект, основанный на извлечении триплетов из текста, логическом выводе и масштабируемой обработке графа знаний с GPU-ускорением:

---

📘 Техническое задание: Система извлечения и логического анализа триплетов с GPU-ускорением

🔹 Цель проекта

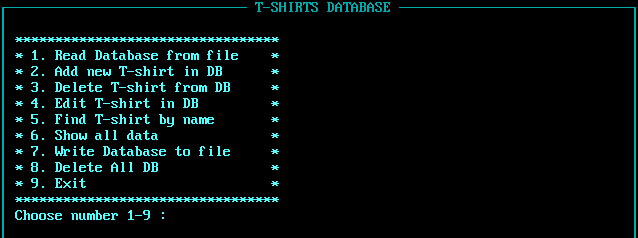

Разработка гибридной экспертной системы, способной:

- Извлекать триплеты из неструктурированного текста с помощью LLM

- Хранить и обрабатывать триплеты в логической форме (Prolog)

- Масштабировать поиск и reasoning через кластеризацию и GPU-графовые вычисления

---

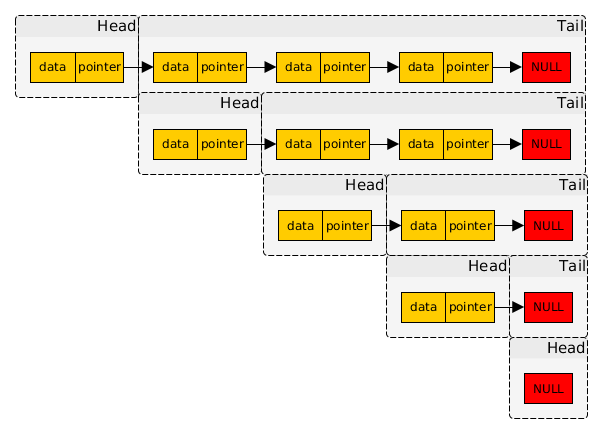

🔹 Архитектура системы

1. Модуль извлечения знаний

- Вход: текстовые данные (статьи, документы, диалоги)

- Выход: триплеты вида <субъект> — <предикат> — <объект>

- Инструменты: LLM с кастомным промптом, поддержка хотя бы одного языка. Перевод это техническая обвязка.