На днях вышло очередное обновление плагина Big Data Tools. Почти полтора года мы выпускали только Early Access Preview, и сейчас мы рады представить вам самую первую версию, рассчитанную на широкую аудиторию.

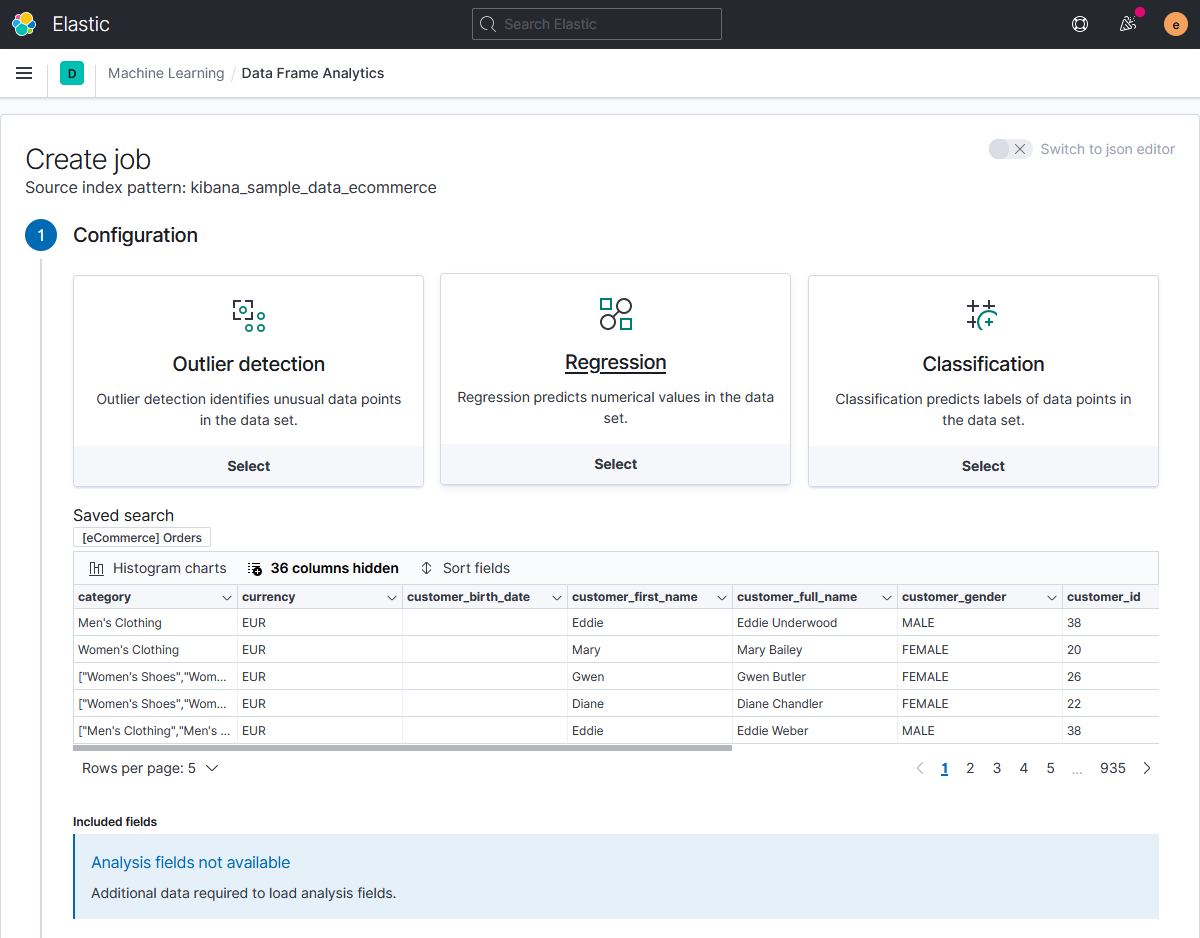

Big Data Tools — это плагин, позволяющий подключаться к кластерам Hadoop и Spark. Он предоставляет возможность мониторинга узлов, приложений и отдельных задач. Кроме того, можно создавать, запускать и редактировать ноутбуки Zeppelin. Вы можете не переключаться на веб-интерфейс Zeppelin и продолжать спокойно работать из любимой IDE. Плагин обеспечивает удобную навигацию по коду, умное автодополнение, рефакторинги и квик-фиксы прямо внутри ноутбука. Плагин доступен для установки в IntelliJ IDEA Ultimate, PyCharm и DataGrip. Вы можете скачать его со страницы плагина на сайте либо установить прямо из IDE.

Давайте подробней рассмотрим, что же изменилось в новой версии.