Жизненный цикл конфиденциальной информации в кругу централизованных сервисов

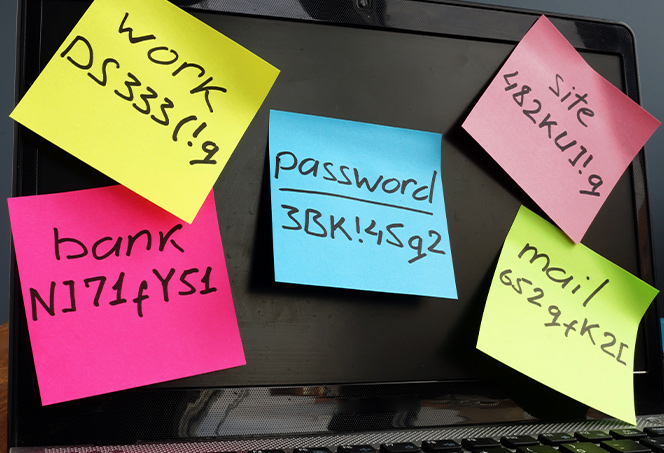

Сегодня ни для кого не секрет, что централизованные сервисы постоянно собирают о нас как можно больше информации. Любое наше действие, передвижение, сообщение считывается как на аппаратном, так и на программном уровнях, словно мы находимся в антиутопичном мире киберпанка, где за всей нашей жизнью следит тысяча механизированных глаз. Результат такого исхода событий свидетельствует лишь о том факте, что он становится экономически выгоден, рационален, оправдан компаниями, производящими массовую слежку и добычу конфиденциальной информации.

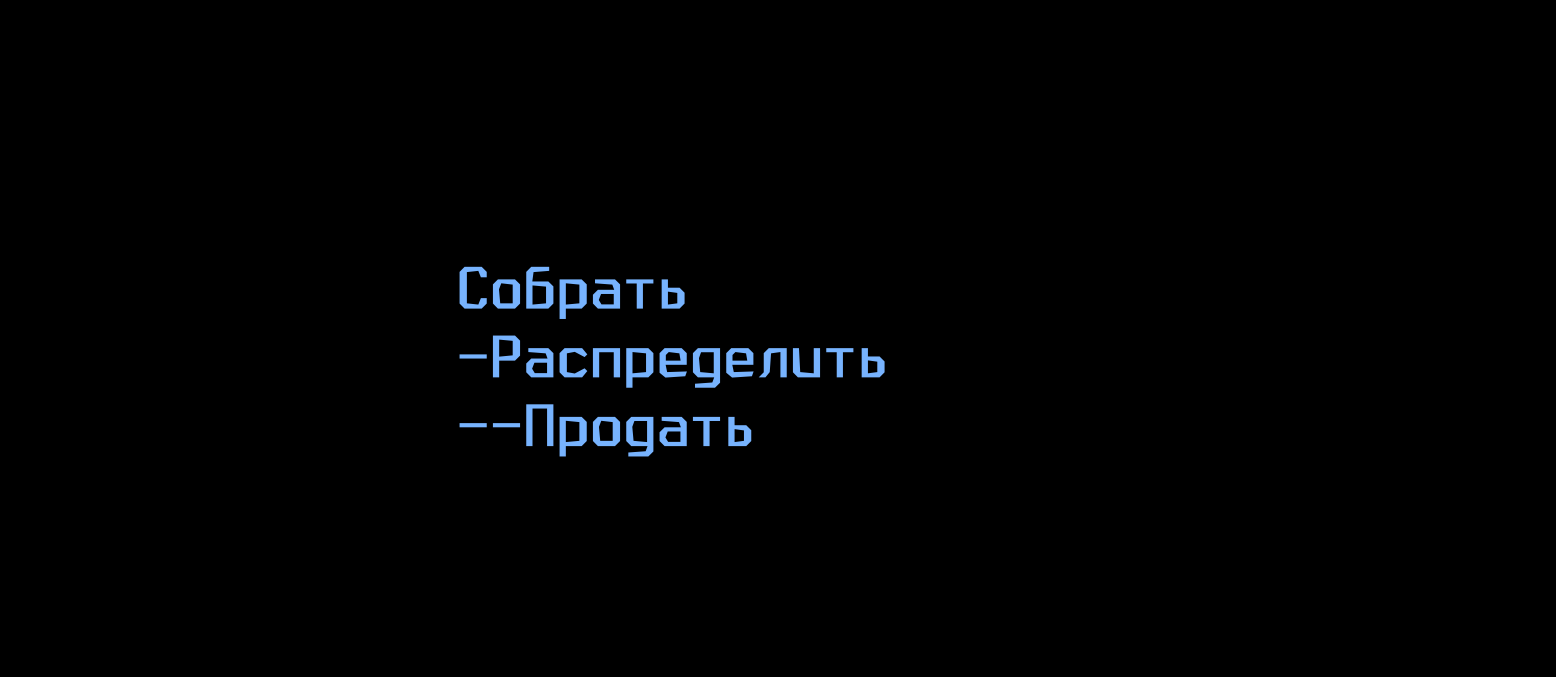

Вопрос всего этого спектакля лежит лишь в плоскости того как именно происходит сбор информации, как эта информация перераспределяется, между кем она распределяется, как она приносит выгоду, и то как она находит свою конечную цель — клиента системы. В итоге всего вышеперечисленного, целью нашей работы будет являться выявление жизненного цикла конфиденциальной информации пользователей в кругу централизованных сервисов.