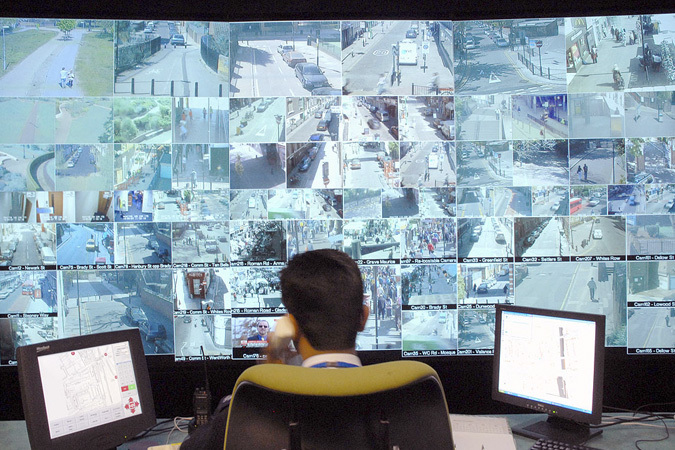

Искусственный интеллект (далее ИИ) всегда привлекал не только ученых-фантастов и писателей, но и обычных обывателей. Роботы, наделенные разумом, дразнят наше любопытство и настораживают наши первобытные страхи, становятся персонажами книг и кинолент. Однако ИИ может быть и неосязаемый, не наделенный оболочкой из металла или пластика. Совокупность программ и алгоритмов, способная самостоятельно принимать решения и изменять те или иные переменные для получения заданной цели — это тоже ИИ. В наше время, когда будущее по мнению многих фантастов уже настало, многие компании с огромным интересом и энтузиазмом смотрят в сторону использования искусственного интеллекта с целью модернизации процесса производства и предоставления товаров и услуг. Кто же, как не дата центры, должны стоять у истоков этого, возможно, революционного прорыва.

С 27 по 30 мая в Российском государственном гуманитарном университете (РГГУ) пройдет международная научная конференция по компьютерной лингвистике

С 27 по 30 мая в Российском государственном гуманитарном университете (РГГУ) пройдет международная научная конференция по компьютерной лингвистике