Задумал переделать на сайте навигационное меню изобилующее ссылками в разные разделы и сделать менее «спамное» для поисковых систем и более удобное для посетителей. Идея была проста.

- с главной страницы все ссылки на разделы сайта на HTML

- ссылки в меню из разделов только на тематические разделы

- остальные ссылки на нетематические разделы сделать на JavaScript в отдельном файле

Опущу подробности реализации сей задумки, но получилось весьма недурно, всё нравится.

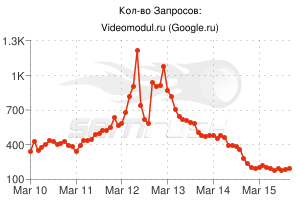

И вдруг заметил резкое падение трафика с Google. Что? Как? Почему?

Вроде наоборот хотел как лучше сделать, направить поисковые системы по правильному пути, но оказывается не всё так гладко.

С недавнего времени Google стал сканировать и индексировать AJAX сайты!

Кажется ничего нового никто и не услышал, но они просто в очередной раз всех переплюнули.

Всё очень просто.

- Сайт поддерживает схему сканирования AJAX.

- Сервер выдает снимок HTML для каждого URL AJAX, который виден пользователю (через браузер). URL AJAX содержит хэш-фрагмент, например example.com/index.html#mystate, где #mystate – хэш-фрагмент. Снимок HTML – это все содержание, отображаемое на странице после выполняемого кода JavaScript.

- Поисковые системы индексируют снимок HTML и обслуживают исходные URL AJAX в своих результатах поиска.

То есть получается что Google видел каждую страницу сайта с кучей ссылок на все разделы, сделал свои выводы и переиндексировал сайт по своему.

Живой пример, источник по сабжу.