А вот вы упоминаете что у вас есть JIRA бот, а его код не открыт случайно? Поделитесь кодом? И почему JIRA? Она же "не очень отечественная". Может есть такой же скажем для EvaTeams?

Атлассиан да, без объявления войны просто взял и заблокировал мои плагиняики в маркетплейсе, хотя они даже опенсорсные... Желаю EvaTeam успеха на этом нелёгком пути

Само решение в статье очень интересное, спасибо. Сам так хотел сделать.

Но, если я правильно понимаю, SSL не поддерживается модулем, только если кафка без авторизации можно в неё слать? При этом вроде как и lua-resty-kafka не умеет. Кто-то имел опыт с альтернативными решениями?

Python модуля как интерфейса к этому нет? Чтобы можно было удобно поиграться в Jupyter? Опять же с привычным pandas интерфейсом и встроенными визуализациями скажем в bokeh или vegas?

Ну и опять же, разве столь уж принципиально сейчас потребление памяти (если в вашем примере даже на 1000 строк не хватает 100Гб), нежели работа алгоритма на том же кластере, скажем Spark или Flink? В этом плане Java/Scala или Python кажутся более предпочтительными...

Минусы вроде джойнов и так указаны изначально. Это решается же материализацией датамартов, как производных. А иметь нормальную, структурированную и разложенную в истории базу всех данных это прекрасная идея. Разве нет?

Websites prove their identity via certificates. Firefox does not trust this site because it uses a certificate that is not valid for 2021.smartdataconf.ru. The certificate is only valid for the following names: *.jugru.org, jugru.org

«VK Tech Talks | Performance Advertising» ведёт на m.vk.com/wall-147415323_5257, откуда предлагают регистрироваться и ссылка на m.vk.com/app6013442_-147415323?form_id=12#form_id=12. А там пишут «Unfortunately, this page is unavailable in the mobile version.»

И вопрос по существу. Написано «Для тех, кто не сможет прийти, мы проведём онлайн-трансляцию в сообществе.». А запись есть? Может ссылочки выложите?

Если честно, не совсем понял. На сколько я вижу обе под одинаковыми лицензиями. Или есть разница? Если вам это правда нужно, я могу попробовать адаптировать на использование других имплементаций. Тогда хотелось бы подробнее понять потребность. Но это, полагаю, уже лучше в issue.

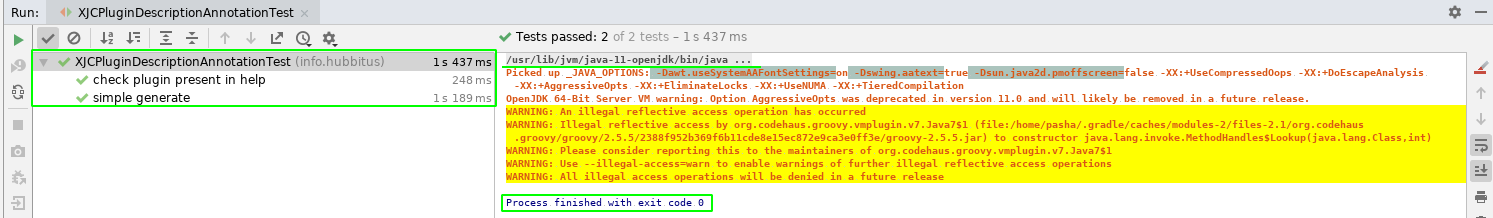

Ворнинги от groovy это лишь запуск тестов, они могут быть спокойно проигнорированы, подробнее в его багтрекере баг GROOVY-8339, то есть это никак не относится к плагину и Jaxb.

Groovy сам по себе отлаживать не проблема совершенно. Интересует как отлаживать то что мы внедрили таким изощрённым способом. Даже если подключиться дебаггером, там будет evaluate (execute) т.к. это фактически строка. Есть ли способ остановиться брэкпоинтом в коде?

Суть в том что если я внедряю в приложение логгинг подобным образом, вероятно у меня нет контроля над его исходным кодом (купленное проприетарное). То есть я не могу всё запустить в любимой IDE.

Второй вопрос здесь же — по примеру сделать скрипт легко, а если я пишу свой скрипт разбора и логгирование, а приложение стартует пару минут — поседеть можно отлаживать скрипт каждый раз перезапуская полностью. Есть ли возможность скрипт менять в рантайме?

Спасибо большое за интересные статьи и что продолжаете, как обещали.

Часть теории конечно вполне тривиальна, но здорово что всё вместе и последовательно.

Я хотел спросить на счёт порядка определения своего класса операторов. Скажем в вашем примере, сначала для комплексных чисел используется дефолтный метод. Что если мы сначала создадим btree индекс по этому полю, а потом уже определим класс операторов:

create operator class complex_ops

Достаточно ли postgres «умный» чтобы не стать использовать для индексов, создававшихся с другими операторами вновь созданный?

И если мы хотим чтобы старый индекс стал использовать новый класс операторов, его обязательно пересоздавать? Или есть другие возможности перестроения (REINDEX)?

А вот вы упоминаете что у вас есть JIRA бот, а его код не открыт случайно? Поделитесь кодом?

И почему JIRA? Она же "не очень отечественная". Может есть такой же скажем для EvaTeams?

Ссылка в статье https://tech.vk.com/experiences/46 некорректная - 404.

Атлассиан да, без объявления войны просто взял и заблокировал мои плагиняики в маркетплейсе, хотя они даже опенсорсные... Желаю EvaTeam успеха на этом нелёгком пути

Спасибо за статью.

А не планируете ли вы выпустить в опен-сорс своё PaaS решение? Такой российский OpenShift.

Само решение в статье очень интересное, спасибо. Сам так хотел сделать.

Но, если я правильно понимаю, SSL не поддерживается модулем, только если кафка без авторизации можно в неё слать?

При этом вроде как и lua-resty-kafka не умеет. Кто-то имел опыт с альтернативными решениями?

What the problem do you have with nginx 1.24.1?

С SSL не работает?

А можно как в Excel написать функцию, которую потом можно было бы использовать в формуле?

Спасибо, выглядит весьма интересно.

Python модуля как интерфейса к этому нет? Чтобы можно было удобно поиграться в Jupyter? Опять же с привычным pandas интерфейсом и встроенными визуализациями скажем в bokeh или vegas?

Ну и опять же, разве столь уж принципиально сейчас потребление памяти (если в вашем примере даже на 1000 строк не хватает 100Гб), нежели работа алгоритма на том же кластере, скажем Spark или Flink? В этом плане Java/Scala или Python кажутся более предпочтительными...

Минусы вроде джойнов и так указаны изначально. Это решается же материализацией датамартов, как производных. А иметь нормальную, структурированную и разложенную в истории базу всех данных это прекрасная идея. Разве нет?

А здесь беда с SSL сертификатом:

Websites prove their identity via certificates. Firefox does not trust this site because it uses a certificate that is not valid for 2021.smartdataconf.ru. The certificate is only valid for the following names: *.jugru.org, jugru.org

Error code: SSL_ERROR_BAD_CERT_DOMAIN

Добрый день. А ссылки-то на все доклады битые. 404 ошибка.

Есть возможность поправить?

github.com/ExchangeCalendar/exchangecalendar тоже поддерживает только версии thunderbird до 60, даже в альфа пре-релизах.

Получается альтернатив больше нет?

И вопрос по существу. Написано «Для тех, кто не сможет прийти, мы проведём онлайн-трансляцию в сообществе.». А запись есть? Может ссылочки выложите?

Так а нет проблемы!

Хотя в демо-проекте и указано sourceCompatibility = 1.8 это лишь чтобы не поднимать требования напрасно.

Т.к. явно указаны зависимости как API, таки имплементации, нет никаких проблем. Тесты нормально проходят под openjdk 11:

Ворнинги от

groovyэто лишь запуск тестов, они могут быть спокойно проигнорированы, подробнее в его багтрекере баг GROOVY-8339, то есть это никак не относится к плагину иJaxb.Суть в том что если я внедряю в приложение логгинг подобным образом, вероятно у меня нет контроля над его исходным кодом (купленное проприетарное). То есть я не могу всё запустить в любимой IDE.

Второй вопрос здесь же — по примеру сделать скрипт легко, а если я пишу свой скрипт разбора и логгирование, а приложение стартует пару минут — поседеть можно отлаживать скрипт каждый раз перезапуская полностью. Есть ли возможность скрипт менять в рантайме?

Часть теории конечно вполне тривиальна, но здорово что всё вместе и последовательно.

Я хотел спросить на счёт порядка определения своего класса операторов. Скажем в вашем примере, сначала для комплексных чисел используется дефолтный метод. Что если мы сначала создадим btree индекс по этому полю, а потом уже определим класс операторов:

Достаточно ли postgres «умный» чтобы не стать использовать для индексов, создававшихся с другими операторами вновь созданный?

И если мы хотим чтобы старый индекс стал использовать новый класс операторов, его обязательно пересоздавать? Или есть другие возможности перестроения (REINDEX)?