Из того, что поменялось — теперь я могу не просто написать статью, а сделать это в блоге компании. И, надеюсь, не один раз. Самопиар окончен, теперь к делу.

Большие данные и всё о них

Довольно часто enterprise задачи по обработке данных затрагивают данные, сопровождаемые временной меткой. В R такие метки, обычно хранятся как класс POSIXct. Выбор методов работы с таким типом данных по принципу аналогии может привести к большому разочарованию и убеждению о крайней медлительности R. Хотя если взглянуть на эту чуть более пристально, то оказывается, что дело не совсем в R, а в руках и голове.

Ниже затрону пару кейсов, которые встретились в этом месяце и возможные варианты их решения. В ходе решения появляются весьма интересные вопросы. Заодно упомяну инструменты, которые оказываются крайне полезными для решения подобных задачек. Практика показала, что об их существовании знают немногие.

Дата инженер в ожидании задачи на спарке.

За годы разработки Wrike у нас накопилось много разрозненной информации о действиях пользователя. Эта информация разбросана по нескольким базам данных, логам, и внешним сервисам, и нам, аналитикам, нужно собрать эти данные вместе, найти в них закономерности и найти ответы на вечные вопросы SaaS’а:

Большинство задач мы решаем с помощью SQL, но запросы к логам через SQL — громоздкие и медленные. Их можно использовать для автоматики или подробной аналитики, но если нужно что-то быстро посмотреть, на подготовку данных уйдёт больше времени, чем на анализ.

Если смотреть приходится много и часто, это вызывает боль, в этой статье мы расскажем, как её преодолеть и как извлечь максимальную пользу из полученных данных.

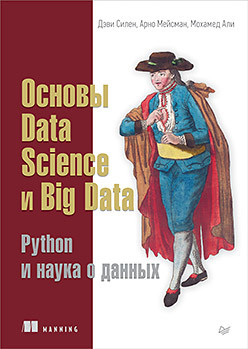

Data Science — это совокупность понятий и методов, позволяющих придать смысл и понятный вид огромным объемам данных.

Data Science — это совокупность понятий и методов, позволяющих придать смысл и понятный вид огромным объемам данных.Несмотря на то, что задачи рядового бизнеса очень часто далеки от популярной темы больших данных и машинного обучения и часто связаны с обработкой относительно малых объёмов информации [десятки мегабайт — десятки гигабайт], размазанной в произвольных представлениях по различным видам источников, применение R в качестве основного инструмента позволяет легко и элегантно автоматизировать и ускорить эти задачи.

И, естественно, после проведения анализа необходимо все это презентовать, для чего можно с успехом использовать Shiny. Далее я приведу ряд трюков и подходов, которые могут помочь в этой задачах. Уверен, что любой практикующий аналитик сможет легко добавить свои хитрости, все зависит от решаемого класса задач.

Привет, Хабр! Меня зовут Александр Крашенинников, я руковожу DataTeam в Badoo. Сегодня я поделюсь с вами простой и элегантной утилитой для распределённого выполнения команд в стиле xargs, а заодно расскажу историю её возникновения.

Наш отдел BI работает с объёмами данных, для обработки которых требуются ресурсы более чем одной машины. В наших процессах ETL (Extract Transform Load) в ход идут привычные миру Big Data распределённые системы Hadoop и Spark в связке с OLAP-базой Exasol. Использование этих инструментов позволяет нам горизонтально масштабироваться как по дисковому пространству, так и по CPU/ RAM.

Безусловно, в наших процессах ETL существуют не только тяжеловесные задачи на кластере, но и машинерия попроще. Широкий пласт задач решается одиночными PHP/ Python-скриптами без привлечения гигабайтов оперативной памяти и дюжины жёстких дисков. Но в один прекрасный день нам потребовалось адаптировать одну CPU-bound задачу для выполнения в 250 параллельных инстансов. Настала пора маленькому Python-скрипту покинуть пределы родного хоста и устремиться в большой кластер!

WANTED: талантливые математики на интересный и денежный контракт

Целевая специализация — матстатистика, матмоделирование, нейросети.

Описание задачи — ниже.

Вторая попытка по человечески сформулировать задачу из предыдущего постинга.