Comments 74

Так выглядит лазер от ASML

Добавлю, пожалуй, в статью…

С этим дополнением всё встаёт на свои места — да у Intel проблемы, но проблемы с ценой при новом техпроцессе, поэтому они сделали финт и поместили 2 кристалла, собраные по старому техпроцессу в 1 корпус ( Xeon Platinum 92xx) — закон продолжает работать.

Xeon Platinum… стоит он правда 10k… сомнительное решение для масс-маркета.

а мой взгляд, мы уже выбрали практически все возможности для развития уремниевой электроники

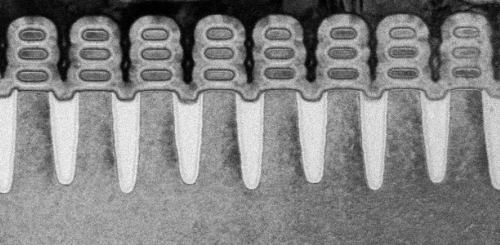

Во-первых, новые техпроцессы от Samsung выглядят вот так:

Растить стопик транзисторов ввысь можно будет еще долго, главное придумать, как это потом охлаждать.

Во-вторых, возможности развития кремниевой электроники — это уже давно не только и не столько закон Мура и вычислительная мощность фон Неймановских цифровых микропроцессоров. Есть, как вы верно сказали, новые технологии вычислений, например, аппаратные реализации нейросетей. Есть огромный рынок, не имеющий отношения к высокпроизводительным вычислениям — IoT, автоэлектроника, радиоэлектроника и т.д. и т.п. Там традиционный КМОП кремний в каком-то виде будет совершенно точно актуален еще очень много лет.

IMHO, нишевое и маркетинговое решение ( Наши новые камни быстрее AMD EPYC!)

Кстати, я голосовал за 1x CPU, но на 20 ядер, но 2x GPU — это ж так круто…

Нашёл статью, где сравнивали hadoop поверх Intel / AMD, но делали это немного странно: мало нод, не самые быстрые конфигурации, и в облаке (AWS), при этом, в процессе сравнения обнаружилось, что у серверов на AMD ниже пропускная способность дисков.

В итоге получилось, что в среднем (но не везде) Intel быстрее, но дороже.

Не знаю, что такое COMSOL, но «не тянут» только алгоритмы, точнее — возможность их параллелизации. А так просто запустить миллион потоков на миллионе ядер — никаких проблем. Только это работает для допускающих независимую обработку данных алгоритмов.

Нет какого то оpensource аналога?

А причину "не тянет" вы примерно сформулировали, но стоит уточнить что сделать обработку сильно независимой там нельзя. До какой-то степени можно разнести обработку по ядрам с обменом через общую память, но довольно быстро всё упирается именно в обмен.

В целом всё похоже на тренировку нейросетей, когда 4-ре акселератора через InfiniBand иногда дают лишь 30% прироста.

в текущих дата-центрах не получится отводить на ~40% больше тепла с сервера и подводить 80кВт на серверную стойку без перестройки самого датацентра

На самом деле, с использованием внутрирядных кондиционеров и шинопроводов все вполне нормально апгрейдится. 60 кВт на стойку работают с 2011 года, 72 кВт на стойку работают с 2012 года. (да-да! стандартные 42U, 600x1000 мм!) Охлаждать воздухом можно и больше — как раз в 12-м году вышли вентиляторы, которые позволили бы отводить 150-170 кВт из стандартной 42U стойки.

А вендорское железо — тем более, у вендоров строгие требования к температуре / питанию / охлаждению, какой-то пункт не выполнен — прощай гарантия ( в смысле — вот гайд, сделайте хорошо и оплатите выезд специалиста для освидетельствования на бис, а если что-то сломалось до восстановления гарантии — ремонт за ваш счёт)

у вендоров строгие требования к температуре / питанию / охлаждению

Ага. Обычно «100-240В, 50/60 Гц, от 0 до 35 градусов C, влажность от 0 до 95% без конденсации». Выйти за эти пределы, при наличии минимального мониторинга — задача нетривиальная.

без переделок серверной не взлетит

Там не просто, а очень просто. Кондиционеры — внутрирядные. Ставятся прямо на пол или фальшпол, разводку труб можно сделать армированной полиэтиленовой трубой сверху (при этом трубы внутри серверной могут быть вообще без стыков, кроме как внутри кондиционера). Шинопровод, опять же, одна дыра в стене. Это все можно практически без пыльных работ провести в живой работающей серверной. Да, где-то снаружи нужно будет место под ИБП, чиллеры и т.п. Но внутри помещения серверной — все очень легко апгрейдится.

Рекомендуемые — 20-22 градуса тепла на вход с 40-50% влажностью.

Пожалуй, всё лучше, чем я думал до изучения доков.

PS спасибо за описание работ, возможно, когда-нибудь пригодится.

PPS я немного не о том, не о физической невозможности охладить/запитать новые сервера с горячими процессорами, а о том, что в большинстве случаев нельзя вытащить старые сервера и вставить новые без доп.работ.

в большинстве случаев нельзя вытащить старые сервера и вставить новые без доп.работ.

Примерно никогда нельзя. Другое дело, что очень часто можно обойтись сравнительно небольшим апгрейдом. Например, очень часто для того, чтобы все заработало достаточно просто закрыть в стойках пустые юниты и другие щели, убрать красивые стеклянные двери, выключить потолочные вентиляторы, где они есть. Если не помогает — изолировать холодный или горячий коридор. Дальше апгрейтиться уже после того, как уперлись в максимальную мощность ИБП и кондиционеров.

Самое грустное здесь, что, например, охлаждать непосредственно кристалл «водой» — в любом случае будет нетривиальной задачей, требующей промежуточных теплообменников и сложной механики — вода достаточной степени очистки, чтобы на кристалле не образовывалась накипь, трубки/помпы/теплообменники из материалов, которые гарантированно не будут в воду выделять примеси/ионы, которые могут отложиться на кристалл или вызвать коррозию. Резервирование помп, датчики давления и скорости потока жидкости, автоматизация всего этого… Причем, единственный способ гарантировать чистоту воды и качество материалов — запаивать это все в процессорный блок прямо на заводе, в чистом помещении. И, если я правильно помню, ультрачистая вода в опытах IBM оказалась слишком грязной для длительной эксплуатации — в отчете, который я встречал лет тому 10 назад, примеси в воде, кажется, упоминались как одна из больших проблем.

PS: 300 кВт тепла из под капота автомобиля — это уже что-то…

И да, цифры все приблизительные, т.к. баланс между температурой выхлопа и тепловыделением в охлаждающую жидкость производители двигателей могут менять в зависимости от целей и задач…

Так же как и задача охлаждения любого плоского объекта, которым является примерно любая микросхема. Это отработано, есть масса вариантов, выбирай на вкус исходя из задач, целей и бюджета.

Задача отвода тепла от кристалла на крышку процессора — чуть более сложная, но тоже пока вполне нормально решается для микросхем с тепловыделением больше 200 Вт. (там реально более прикольная штука — как завести 130-150 ампер тока так, чтобы сокет не отпаялся и чтобы соседний QPI на полной скорости работал… Но опять же, это все решается на этапе разработки референс-дизайна и те, кто серийно штампует материнки, с проблемой уже практически никогда не сталкиваются...)

Задача отвода тепла от кристалла на крышку процессора — чуть более сложная, но тоже пока вполне нормально решается для микросхем с тепловыделением больше 200 Вт.Во-первых, отведите мне пожалуйста 100 Вт от десятиногого чипа с площадью кристалла скажем десять квадратных миллиметров)

Во-вторых, речь про охлаждение идет в контексте вертикальной интеграции транзисторов, а значит роста тепловыделения на порядок по сравнению с существующими процессорами.

Но тут вторая тонкость: нас уже больше 10 лет пугают чипами, которые будет невозможно охладить, но… их все еще нет. И все еще всякие наработки с микро каналами для воды в кристалле так никому и не понадобились…

Другой вопрос — как вы будете 75А по 10 ногам заводить в микросхему?

Но тут вторая тонкость: нас уже больше 10 лет пугают чипами, которые будет невозможно охладить, но… их все еще нет.Есть они, вполне себе. прсто это не процессоры. В силовой автоэлектронике миллиарды в переход на карбид кремния инвестируются, потому что от него, в отличие, от кремния, можно нормально отводить тепло.

Другой вопрос — как вы будете 75А по 10 ногам заводить в микросхему?Если импульсно, то почему нет? Это не говоря уже о том, что я имел в виду десять ног у микросхемы всего, а не каждого типа силовых.

я имел в виду десять ног у микросхемы всего

И я про то же… 75 А нужно ну хотя бы 10 квадратных миллиметров меди… при хорошем охлаждении.

В силовой автоэлектронике миллиарды в переход на карбид кремния инвестируются

А тем временем китайские и не китайские производители ИБП уже выпускают силовые модули (AC-DC-AC) мощностью 50 кВт в 3U. С КПД 97% и выше. И прекрасно охлаждают их воздухом.

Я не против карбида кремния и не говорю, что это бессмысленно. Другое дело, что развитие идет несколькими путями. Кто-то придумывает новую элементную базу, кто-то разрабатывает новую схемотехнику, на которой все будет работать как надо. Например, 4 и 5-уровневые инверторы, которые позволяют резко уменьшить необходимый размер силовых транзисторов и резко снизить количество коммутаций этих транзисторов, что позволяет сильно поднять КПД и плотность мощности.

Сейчас специальные жидкости с высоким коэффициентом преломления (до 1,8)

А нет ли ссылки, что это за жидкость такая, что и 1.8 и облучение УФ держит? Самому поиграть захотелось )

Мы как-то при поиске материалов натыкались на такую жидкость. Правда это был УФ-отверждаемый компаунд. :D

Пожалуйста, играйтесь — https://doi.org/10.1021/la8026896

Да? А я как-то в детстве (10 класс) поинтересовался этим вопросом и мне удалось получить стабильную плазму.

А из-за неустранимых неоднородностей в колбе эта пульсация плазменного пучка приводит к его танцу вокруг среднего положения (что-то вроде лоренцовского аттрактора, только по-другому).

Ну, и для «ровного светового потока» хватит увеличить частоту колебаний до невидимого глазом уровня.

Кстати, несколько раз удавалось получить плазменный «шнур», закрученный в спираль (2-4 витка на полтора метра) при токе в несколько миллиампер (лампа ЛД80). От положения в пространстве ничего не менялось. То есть, незаметно, что бы было влияние магнитного поля земли.

В люминесцентных лампах есть примерно три разных "нестабильности": (1) пульсации 100 Гц из-за питания переменным током 50 Гц, (2) турбулентные флуктуации (конвекция газа, броуновское движение, внешнее электро-магнитное излучение и т.д.), (3) автоколебательный процесс в плазме.

С первым (пульсации 100 Гц) легко бороться питая ламу более-менее постоянным током (http://eco-e.ru/goodies/stati/svetovaya-sreda/20-pulsatsiya-lyuminestsentnykh-lamp).

От второго и третьего избавится примерно невозможно, но можно существенно уменьшить.

Когда я работал в НИИ, не сразу привык к интеллигентному обращению. Никто не допытывался как мне что-то удалось и практически никто не выражал недоверия к моим рассказам. Да, я люблю эпатировать и эффектно подать. Но я никогда не переходил в область вымысла. Некоторые неточности были, но это от того, что у меня было мало инструментальной аппаратуры (особенно точной, метрологической).

Если я говорил, что создал предусилитель с динамическим диапазоном 126 дБ, то никто не высказал недоверия. А когда понадобилось для работы — смакетировал и продемонстрировал. Это были 70-е годы, когда 80-90 дБ были верхом достижений.

Нисколько не пытался ни выведывать что-либо, ни как-либо Вас задеть.

Просто из контекста и из предыдущих сообщение (IMHO) не следует что серьезно занимались плазмой в НИИ.

В частности, потому что для люминесцентных ламп не нужна плазма "стабильнее" чем без существенных 100-герцовых пульсаций и их гармоник (устранение которых сложно отнести к проблеме стабилизации плазмы).

Занимался не в НИИ, а у себя дома. Хотелось иметь источник света без пульсаций и максимально естественный. Питание постоянным током (со стабилизацией тока) как раз и выявило хаотические пульсации лампы. На глаз практически незаметно, но это до тех пор, пока не застабилизировать световой поток, устранить шум плазмы. Вот после этого, даже стабильный ток воспринимается как «некомфорт».

Вышло громоздко (там большой конденсатор 1500 мкф — 400 вольт + транзисторы генератора тока, радиатор). Да еще и проблема с «ионным насосом» — переключать с помощью реле слишком неудобно (щелчок, мигание...), а высоковольтных транзисторов в то время не было у меня.

Главное — идею проверил, отработал основную технологию. И отложил до лучших времен.

тайваньская TSMC перейдут на EUV-литографию

В 2017 рассказывали, что им электричества слишком много требуется:

https://english.cw.com.tw/article/article.action?id=1663 Can Taiwan Power TSMC’s Dream? 2017-08-25

TSMC is planning to locate its advanced 5-nanometer foundry in the Southern Taiwan Science Park, which will increase demand for electricity and water far beyond the capacity the park was designed for.… TSMC’s 5-nanometer plant will need an estimated 720 megawatts of electricity… Chuang said the less TSMC used of the EUV technology the better because “it is too expensive and uses too much power.” ASML has yet to disclose how much power one of its EUV machines consumes… TSMC manager… 5-nm foundry will use 48 percent more power than a mainstream 28-nm foundry… “And only half of the production in the 5-nm plant will use EUV technology,” says an analyst

Попадаются интересные презентации в https://euvlitho.com/2018/ и рядом https://www.euvlitho.com/2018/2018%20EUVL%20Workshop%20Proceedings.pdf

Оптика для EUV "Starlith 3400" от Carl Zeiss https://www.euvlitho.com/2018/P22.pdf

https://www.euvlitho.com/2018/P3.pdf Continued Scaling in Semiconductor Manufacturing with EUV Lithography, ASML

резисты — https://www.euvlitho.com/2018/P48.pdf https://www.euvlitho.com/2018/P42.pdf

На самом деле, все эти технологические нормы в единицы и десятки нм давно оторвались от физических размеров и стали больше элементами маркетинга. Как минимум последние лет 15: после перехода со 130 нм на 90 нм.

Поэтому я дома использую PowerMac G5 с 90нм IBMовским PowerPC чипом 2005 года. Какой смысл тратить $12к на новую «тёрку» от Apple если всё это лишь маркетинг? ;)

Для лично ваших задач может и Intel4004 хватать, но это не будет значить, что все чипы после Intel 4004 — «всего лишь маркетинг».

Волнуюсь за линзу,

как предусмотрительно Вы спасли её(и нас всех?), обозвав «крайней».

Из: https://en.wikipedia.org/wiki/Field-effect_transistor

Most FETs have a fourth terminal called the body, base, bulk, or substrate. Понятно что говорится о terminal, т.е. вывод, но называется он явно по тому, к чему подключен. Да и в дискретных полевиках этот вывод называется «подложка».

Казус вот только в том, что подложка — это вроде как не «область» вовсе. Но во второй части статьи автор очень часто манипулирует понятием «база», по логике, как мне кажется, имея в виду канал. У него там даже появляется термин «пробой базы» (?)

Ещё отыскал картинку здесь для наглядности:

Собственно, вы всё правильно написали, что эта область называется тело MOSFET, база, объём п/п или — парарапам — подложка.

Канал возникает в базе/подложке, верно?

Но эту область никто, кроме вышеупомянутой русскоязычной страницы Википедии, не называет «база». Просто потому что это неверно. Попробуйте найти какой-то рецензируемый источник и убедитесь сами, что это невозможно.

вышеупомянутой русскоязычной страницы Википедии

Она-то как раз англоязычная ;)

По ссылке на design & reuse можете также убедиться, что: MOS transistor is a 4-terminal device having terminal drains, source, gate and body (substrate).

Область под затвором зовется базой.

Цитата вроде как и не цитата…

Отмотайте вверх, спуститесь до раздела озаглавленного «МОП-транзисторы»,

далее под схематическим рисунком «Схематический вид n-канального транзистора в разрезе»,

Раскройте спойлер «Описание принципов работы».

Там будет текст: «Область под затвором зовется базой.»

то определенную гипотезу можно прочесть здесь (англ.): Intel 10nm process problems — my thoughts on this subject

Второй вопрос затронутый статьёй поднят 17 июня (англ. там же): Is Intel 10nm really denser than TSMC 7nm?

Технологии микроэлектроники на пальцах: «закона Мура», маркетинговые ходы и почему нанометры нынче не те. Часть 1