Как и многие другие интернет-компании, Amazon не разглашает информацию о своей инфраструктуре, в том числе о количестве серверов. Но аналитик из Accenture Technology Labs произвёл собственный подсчёт: у него получилось, что в семи дата-центрах Amazon Web Services должно быть по крайней мере 454 400 серверов.

Интересно, что 70% из них находится в регионе US East (Виргиния).

Amazon использует регулярный паттерн присвоения внутренних IP-адресов: каждый инстанс получает адрес 10.x.x.x, а каждая стойка получает диапазон 10.x.x.x/22, то есть можно определить все виртуальные машины в этой стойке. Исследователь просканировал AWS путём DNS-запросов внутри сети EC2, используя внешние IP-адреса инстансов, их диапазоны известны.

Непосредственно количество блэйд-серверов оценивалось исходя из информации о 64 блэйдах на стойку — четыре шасси 10U, на каждом шасси по 16 блэйдов (вот как раз это предположение ни на чём не основано).

Подробнее о методологии исследования см. в блоге автора.

Данная оценка уже вызвала дебаты среди экспертов. Они спорят, сколько серверов может быть на самом деле в каждой стойке, потому что у компании сменилось несколько поколений оборудования. Но в любом случае общее мнение сходится к тому, что Amazon по количеству серверов уже обогнал всех хостинг-провайдеров, которые публично разглашают информацию о количестве серверов, но ещё точно не догнал Google, у которой в сети дата-центров около 900 тыс. серверов.

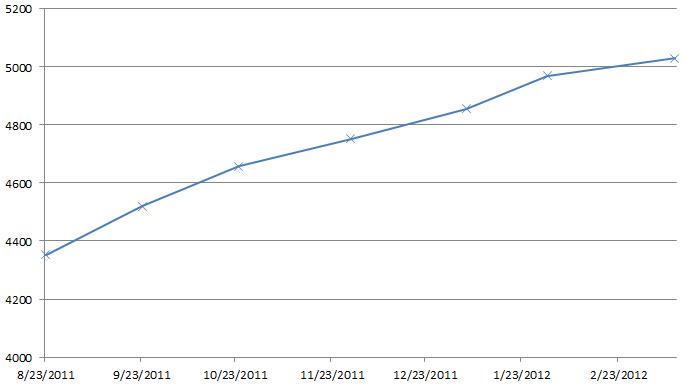

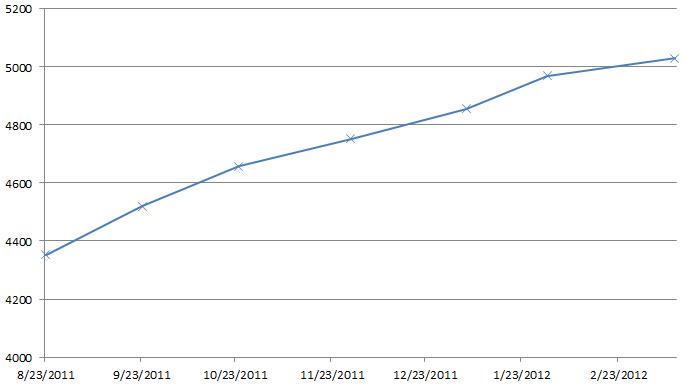

Нужно также отметить довольно быстрый рост инфраструктуры Amazon, на графике показано увеличение количества стоек в регионе US East, за указанный период он прибавлял в среднем по 110 стоек в месяц.

Интересно, что 70% из них находится в регионе US East (Виргиния).

| Кол-во серверных стоек | Кол-во блэйд-серверов | |

| US East (Виргиния) | 5030 | 321 920 |

| US West (Орегон) | 41 | 2624 |

| US West (Сев. Калифорния) | 630 | 40 320 |

| EU West (Ирландия) | 814 | 52 096 |

| AP Northeast (Япония) | 314 | 20 096 |

| AP Southeast (Сингапур) | 246 | 15 744 |

| SA East (Сан-Паулу) | 25 | 1600 |

| Всего | 7100 | 454 400 |

Amazon использует регулярный паттерн присвоения внутренних IP-адресов: каждый инстанс получает адрес 10.x.x.x, а каждая стойка получает диапазон 10.x.x.x/22, то есть можно определить все виртуальные машины в этой стойке. Исследователь просканировал AWS путём DNS-запросов внутри сети EC2, используя внешние IP-адреса инстансов, их диапазоны известны.

Непосредственно количество блэйд-серверов оценивалось исходя из информации о 64 блэйдах на стойку — четыре шасси 10U, на каждом шасси по 16 блэйдов (вот как раз это предположение ни на чём не основано).

Подробнее о методологии исследования см. в блоге автора.

Данная оценка уже вызвала дебаты среди экспертов. Они спорят, сколько серверов может быть на самом деле в каждой стойке, потому что у компании сменилось несколько поколений оборудования. Но в любом случае общее мнение сходится к тому, что Amazon по количеству серверов уже обогнал всех хостинг-провайдеров, которые публично разглашают информацию о количестве серверов, но ещё точно не догнал Google, у которой в сети дата-центров около 900 тыс. серверов.

Нужно также отметить довольно быстрый рост инфраструктуры Amazon, на графике показано увеличение количества стоек в регионе US East, за указанный период он прибавлял в среднем по 110 стоек в месяц.