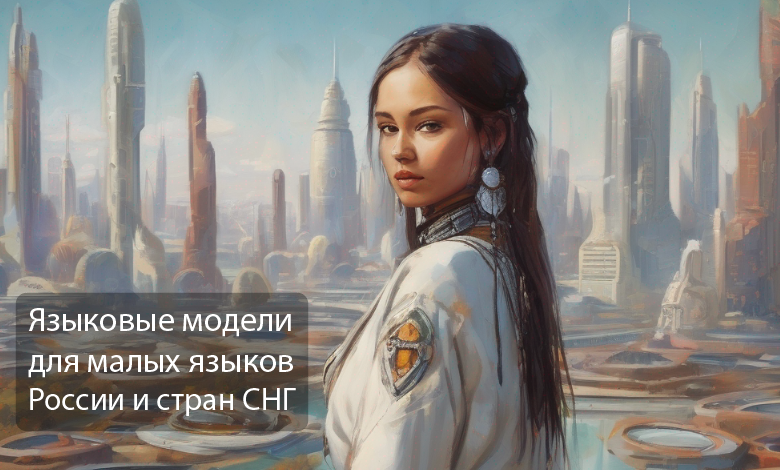

Не так давно мы рассказывали про то, как мы обучили модель-полиглот mGPT, которая говорит на 61 языке. Этим летом в открытый доступ мы выложили большую мультиязычную модель (претрейн) mGPT-13B под открытой лицензией MIT.

Сегодня мы хотим поделиться с вами семейством моделей-экспертов на основе оригинальной mGPT для языков СНГ и малых народов России. Оригинальная модель уже владела этими языками, но нам хотелось сделать максимально качественные моноязычные модели, использовав доступные открытые сеты.

Из общего набора в 61 язык мы дообучили 23 модели на дополнительных данных под каждый язык стран СНГ и малых народов России. И в этой статье мы расскажем про то, как мы это сделали и насколько лучше каждый конкретный файнтьюн знает свой язык. А сами модели можете найти на Hugging Face.