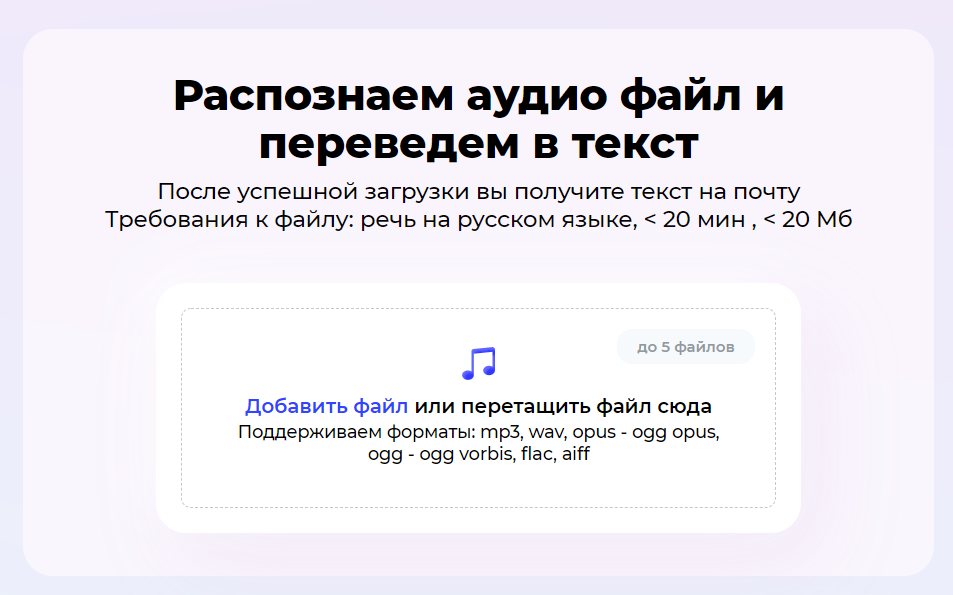

При решении задач, связанных с распознаванием (Speech-To-Text) и генерацией (Text-To-Speech) речи важно, чтобы транскрипт соответствовал тому, что произнёс говорящий — то есть реально устной речи. Это означает, что прежде чем письменная речь станет нашим транскриптом, её нужно нормализовать.

Другими словами, текст нужно провести через несколько этапов:

- Замена числа прописью:

1984 год -> тысяча девятьсот восемьдесят четвёртый год;

- Расшифровка сокращений:

2 мин. ненависти -> две минуты ненависти;

- Транскрипция латиницы:

Orwell -> Оруэлл и т.д.

В этой статье я коротко расскажу о том, как развивалась нормализация в датасете русской речи Open_STT, какие инструменты использовались и о нашем подходе к задаче.

Как вишенка на торте, мы решили выложить наш нормализатор на базе seq2seq в открытый доступ: ссылка на github. Он максимально прост в использовании и вызывается одним методом:

norm = Normalizer()

result = norm.norm_text('С 9 до 11 котики кушали whiskas')

>>> 'С девяти до одиннадцати котики кушали уискас'