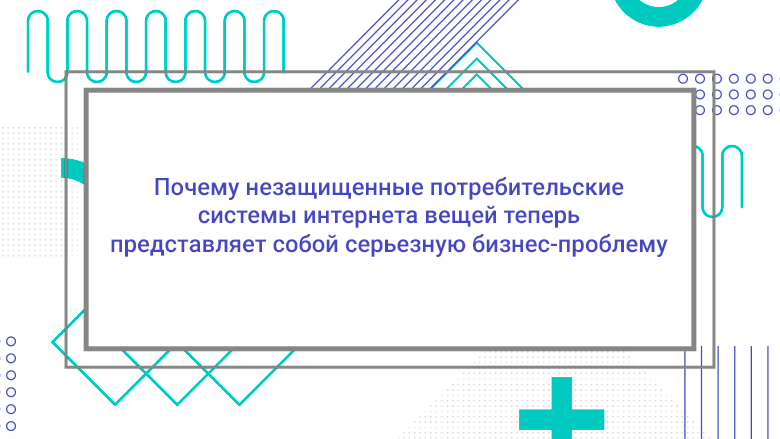

С большой долей вероятности, в большинстве предприятий найдется хотя бы один сотрудник с уязвимым устройством. Для кибер-преступников достаточно и одного.

В потребительской сфере технология интернета вещей (Internet of Things — IoT) давно славится своей чрезвычайно халтурной секьюрностью.

Сегодня дома наводнены устройствами с подключением к интернету — будь то эспрессо-кофемашина с приложением или камера видеонаблюдения с подключением к Wi-Fi. По данным Statista, в 2020 году на бытовую электронику будет приходиться 63% всех установленных IoT устройств. Эти устройства могут собирать о своих пользователях данные, которые отправляются обратно поставщикам услуг, чтобы помочь улучшить их продукты. Производство этих устройств является прибыльным делом, и по мере роста спроса потребители все чаще покупают более дешевые устройства экономкласса. Проблема в том, что стандарты безопасности у них обычно довольно слабые.