Глубокие нейронные сети сейчас модная тема.

В Сети много тюториалов и видеолекций, и других материалов обсуждающих основные принципы построения нейронных сетей, их архитектуру, стратегии обучения и т.д. Традиционно, обучение нейронных сетей производится путем предявления нейронной сети пакетов изображений из обучающей выборки и коррекции коэффициентов этой сети методом обратного распространения ошибки. Одним из наиболее популярных инструментов для работы с нейронными сетями является библиотека Tensorflow от Google.

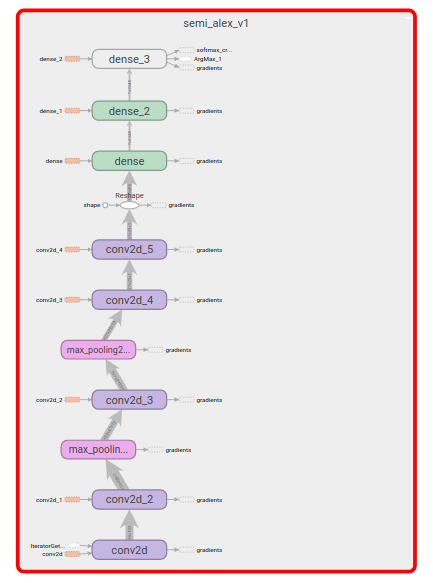

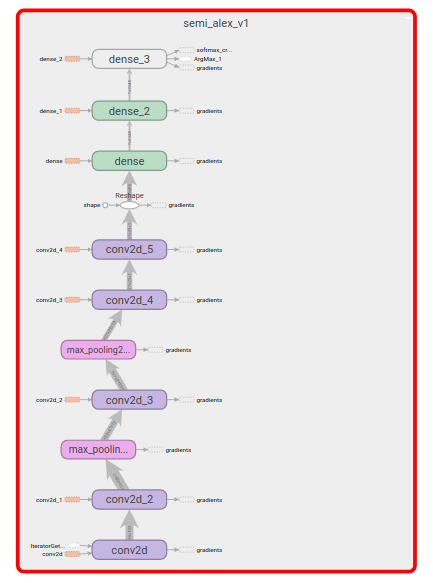

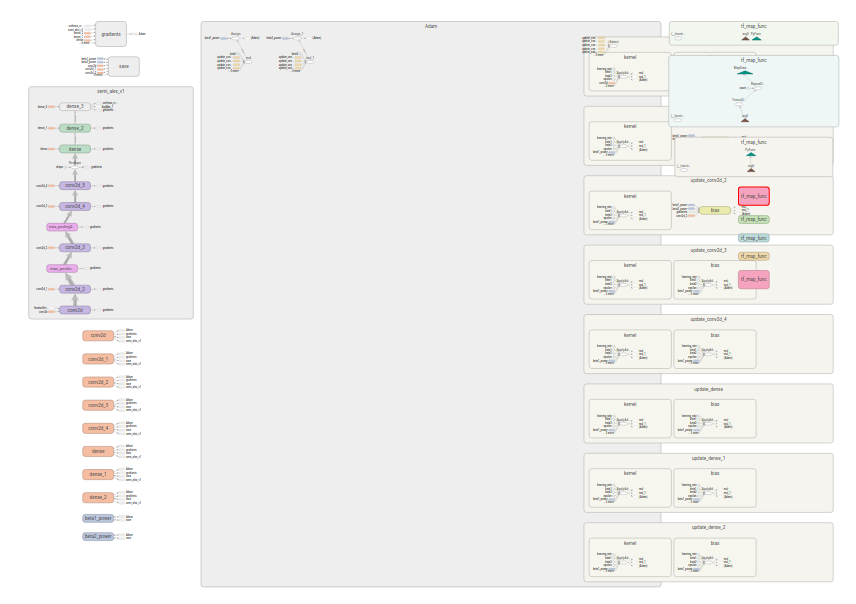

Нейронная сеть в Tensorflow представляется последовательностю операций-слоев

(таких как перемножение матриц, свертка, пулинг и т.д.). Слои нейронной сети совместно с операциями корректировки коэффициентов образуют граф вычислений.

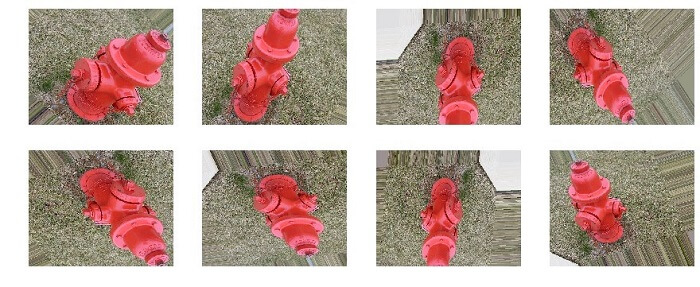

Процесс обучения нейронной сети при этом заключается в "предъявлении" нейронной

сети пакетов объектов, сравненнии предсказанных классов с истинными, вычисления

ошибки и модификации коэффициентов нейронной сети.

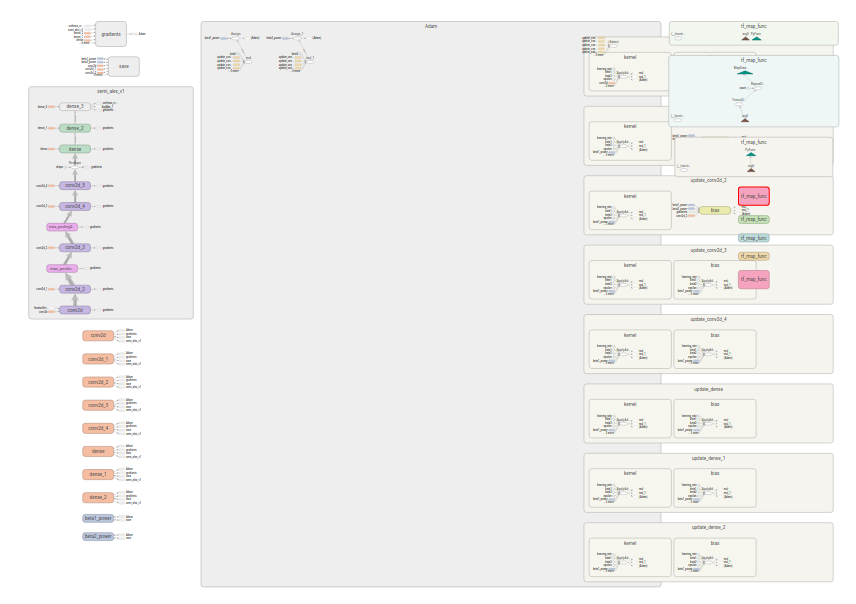

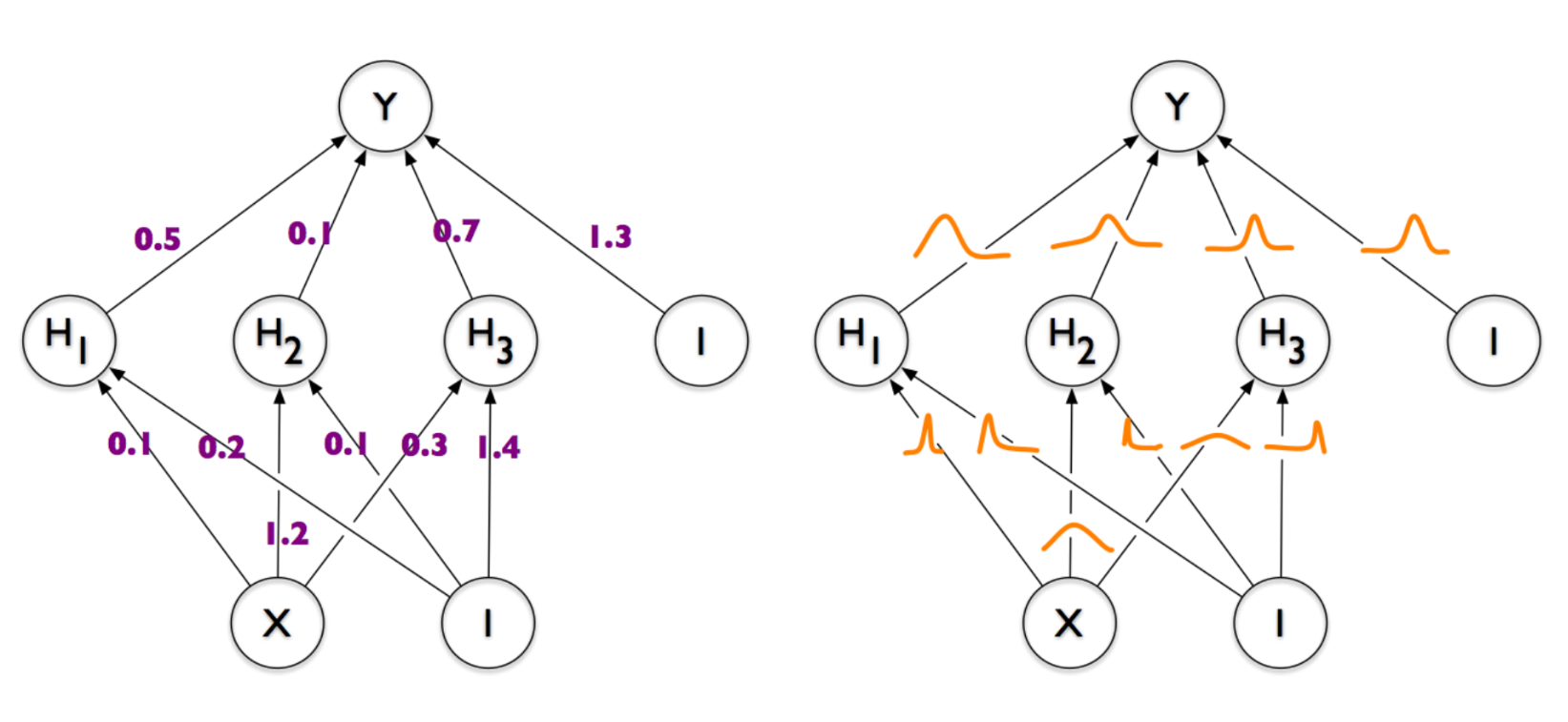

При этом Tensoflow скрывает технические подробности обучения и реализацию алгоритма корректировки коэффициентов, и с точки зрения программиста можно говорить в основном только о графе вычислений, производящем "предсказания". Сравните граф вычислений, о котором думает программист

с графом который в том числе выполняет подстройку коэффициенотов

.

.

Но что Tensorflow не может сделать за программиста, так это преобразовать входной датасет в датасет удобный для тренировки нейронной сети. Хотя библиотека имеет довольно много "базовых блоков".

Как с их использованием построить эффективный конвеер для "питания" (англ feed) нейронной сети входными данными я и хочу расскажу в этой статье.

Это будет длиннопост. Я давно хотел написать этот обзор, но

Это будет длиннопост. Я давно хотел написать этот обзор, но

.

.