Big Data *

Большие данные и всё о них

Генератор кликов на Python для программы Data Engineer

Предыстория

В этот раз для нас всё было довольно просто. Несколько выпускников нашей программы «Специалист по большим данным» в течение, наверное, года просили:

Сделайте для нас еще одну программу, где мы бы могли научиться работать с Kafka, Elasticsearch и разными инструментами экосистемы Hadoop, чтобы собирать пайплайны данных.

Потом со стороны работодателей стали «прилетать» запросы, которые собирательно можно описать так:

Data Engineer'ы – это очень горячие вакансии!

Реально их уже на протяжении полугода никак не можем закрыть.

Очень здорово, что вы обратили внимание именно на эту специальность. Сейчас на рынке очень большой перекос в сторону Data Scientist'ов, а больше половины работы по проектам – это именно инженерия.

С этого момента стало понятно, что спрос есть, и проблема существует. Надо бросаться в разработку программы!

Распознавание дорожных знаков с помощью CNN: Инструменты для препроцессинга изображений

Введение

За последние несколько лет сфера компьютерного зрения (CV) переживает если не второе рождение, то огромный всплеск интереса к себе. Во многом такой рост популярности связан с эволюцией нейросетевых технологий. Например, сверточные нейронные сети (convolutional neural networks или CNN) отобрали себе большой кусок задач по генерации фич, ранее решаемых классическими методиками CV: HOG, SIFT, RANSAC и т.д.

Маппинг, классификация изображений, построение маршрута для дронов и беспилотных автомобилей — множество задач, связанных с генерацией фич, классификацией, сегментацией изображений могут быть эффективно решены с помощью сверточных нейронных сетей.

MultiNet как пример нейронной сети (трех в одной), которую мы будем использовать в одном из следующих постов. Источник.

В разрезе: новостной агрегатор на Android с бэкендом. Вводная часть, идея, технологии

Время шло, а вместе с ним приходило понимание, что дальнейшая работа в рамках только текущей должности не только сузит мой кругозор, но и лишит каких-либо конкурентных возможностей на рынке труда. Сторонние подработки в качестве программиста не давали необходимого системного подхода.

В связи с этим было принято решение об изучении новых технологий в области разработки на базе небольшого домашнего проекта (вычитываемые из книг и интернета знания без опыта применения улетучивались очень и очень быстро). Необходимые знания были, время выделить для своего развития я мог всегда.

В качестве проекта была выбрана идея реализации новостного агрегатора (с клиентом на Android) и его серверной стороны для сбора, обработки, хранения и представления данных.

R и большие данные: использование Replyr

replyr — сокращение от REmote PLYing of big data for R (удаленная обработка больших данных в R). Почему стоит попробовать

replyr? Потому что он позволяет применять стандартные рабочие подходы к удаленным данным (базы данных или Spark).Можно работать так же, как и с локальным

data.frame. replyr предоставляет такие возможности:- Обобщение данных:

replyr_summary(). - Объединение таблиц:

replyr_union_all(). - Связывание таблиц по строкам:

replyr_bind_rows(). - Использование функций разделения, объединения, комбинирования (

dplyr::do()):replyr_split(),replyr::gapply(). - Аггрегирование/распределение:

replyr_moveValuesToRows()/replyr_moveValuesToColumns(). - Отслеживание промежуточных результатов.

- Контроллер объединений.

Скорее всего, вы всё это делаете с данными локально, поэтому такие возможности сделают работу со

Spark и sparklyr гораздо легче.replyr — продукт коллективного опыта использования R в прикладных решениях для многих клиентов, сбора обратной связи и исправления недостатков.Примеры ниже.

Данные: красивые и ужасные

Данные повсюду. И это прекрасно. Они меняют нашу жизнь, заново изобретают сторителлинг и оказывают влияние практически на все отрасли — бизнес, искусство, развлечения, музыку, технологии.

Вот некоторые яркие примеры…

Информационная журналистика

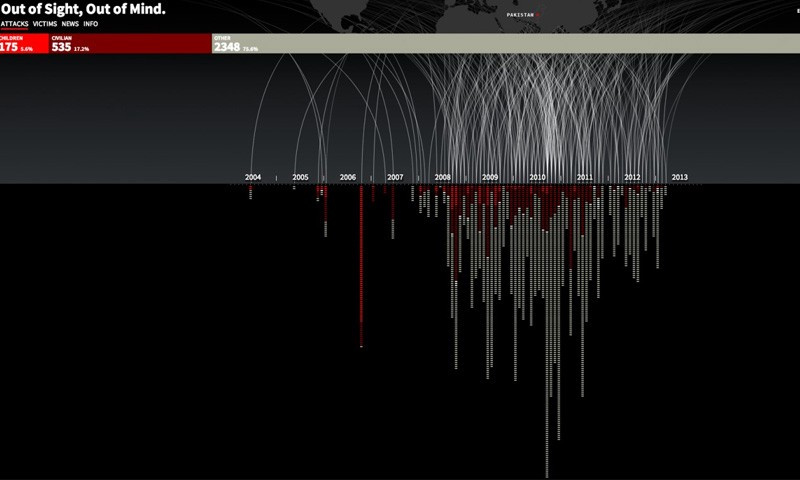

Совершенно ужасающая инфографика. Проект, который называется «С глаз долой, из сердца вон», — это хронология ударов беспилотных дронов в Пакистане с июля 2004 года по декабрь 2013 года.

С 2004 года США практиковали новый вид подпольной военной операции. Использование беспилотных летательных аппаратов для уничтожения вражеских целей казалось привлекательным, так как устраняло риск потери американских военных и политически было намного легче осуществимо. Показатель эффективности оказался крайне низок, а потери среди взрослого и детского гражданского населения очень высоки. Весь мир мог бы остаться в неведении о том, что на самом деле происходит, и, как говорится, с глаз долой, из сердца вон. Этот проект помогает осветить тему беспилотных летательных аппаратов, не говоря за или против. Изучив данные, вы можете самим решить, сможете ли вы поддерживать подобное использование беспилотных летательных аппаратов или нет.

«Data mining сейчас — это преимущество на рынке»: о конференции SmartData и больших данных

Конференции, посвящённые одной и той же теме, могут выглядеть совершенно по-разному. И когда планируется совсем новое мероприятие, заранее не вполне понятно, чего ожидать. Если конференция посвящена «большим и умным данным», то не окажется ли, что она рассчитана на гигантские компании и сотрудникам маленьких там делать нечего? И не будет ли там такого уклона в data science, что людям без учёной степени лучше не заходить?

В ожидании конференции SmartData, которая впервые состоится в Санкт-Петербурге 21 октября, мы решили внести ясность и расспросили двух членов её программного комитета: Виталия Худобахшова (Одноклассники) и Романа p0b0rchy Поборчего. Они развеяли многие опасения, а разговор получился не только о конференции, но и о состоянии индустрии: что сейчас происходит вокруг machine learning, зачем маленьким компаниям лезть в data mining, почему менеджеры покупают билеты на техническую конференцию о больших данных.

Отчет с Science Slam Digital 7 июля

7 июля Science Slam Digital собрал в нашем офисе более 600 зрителей, а число просмотров трансляции в соцсетях Одноклассники и ВКонтакте превысило 420 тысяч. Формат Science Slam зародился в Германии семь лет назад для популяризации научных достижений среди простых обывателей. Он состоит из серии научных лекций, которые читают молодые ученые. Доклад участника должен быть коротким (10 минут), доступным и информативным. Победителя слема определяют с помощью определения громкости аплодисментов зрителей шумометром.

Нам очень понравился этот формат, и мы захотели провести свой Science Slam, только цифровой, чтобы рассказать о технологиях просто и понятно. О том, что происходит внутри компании и чем занимаются сотрудники. Шесть разработчиков рассказали гостям и зрителям трансляции, что можно определить по почте, не открывая самих писем; как выяснить возраст человека в социальных сетях, даже если он не указан; какие тренды в медиапотреблении можно выделить уже сейчас и как они влияют на восприятие информации; как модифицировать социальную сеть, которой пользуются 100 миллионов человек, чтобы у них ничего не сломалось. Как это у нас получилось, вы можете посмотреть по нашим докладам.

Анализируем карьеру игроков NHL с помощью Survival Regression и Python

Когда у данного пациента произойдет рецидив? Когда наш клиент уйдет? Ответы на подобные вопросы можно найти с помощью анализа выживания, который может быть использован во всех областях, где исследуется временной промежуток от «рождения» до «смерти» объекта, либо аналогичные события: период от поступления оборудования до его выхода из строя, от начала использования услуг компании и до отказа от них и т.д. Чаще всего данные модели используются в медицине, где необходимо оценить риск летального исхода у больного, чем и обусловлено название модели, однако они также применимы в сфере производства, банковском и страховом секторах.

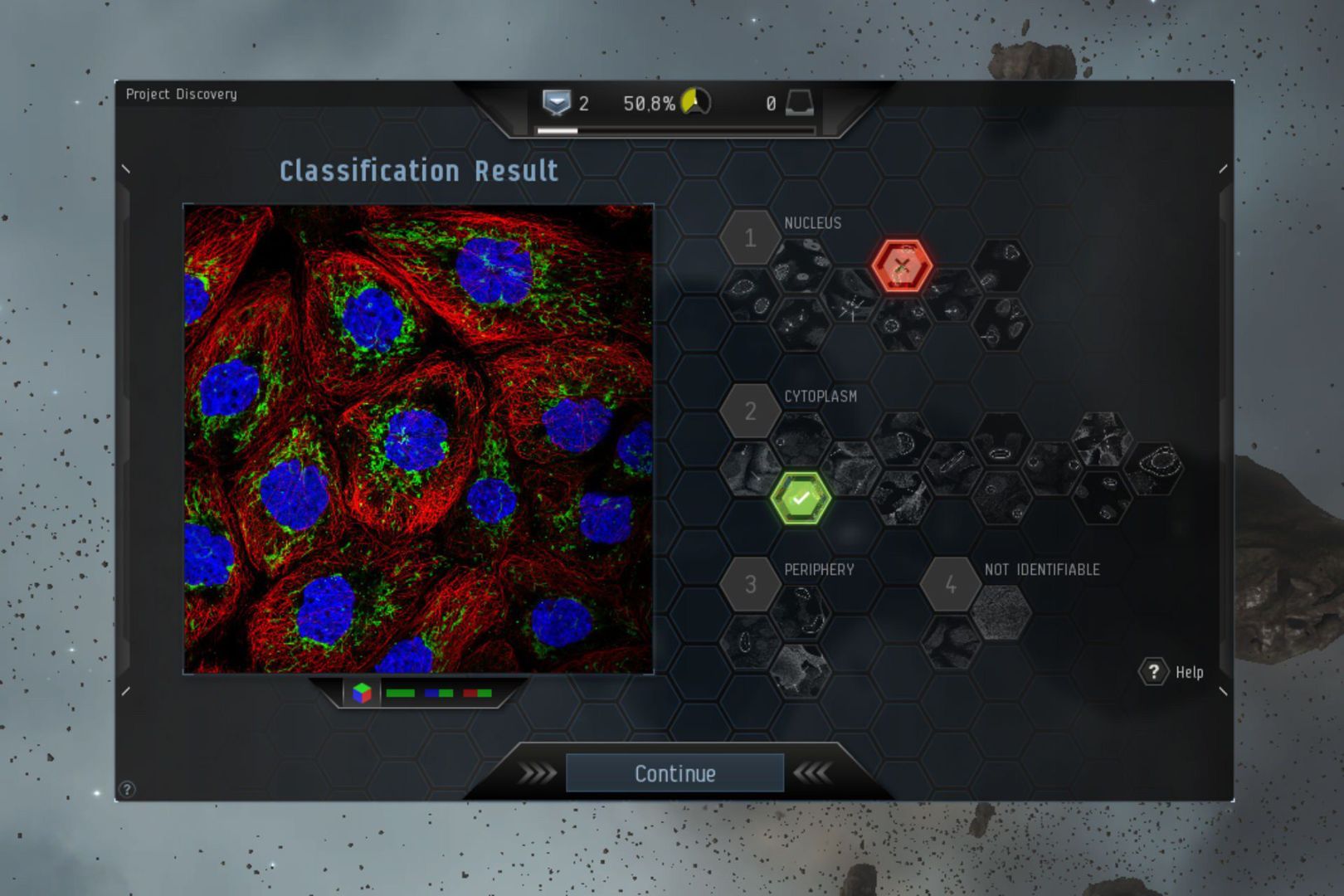

Как тысячи игроков Eve Online помогают в расшифровке человеческого тела

Представляю вашему вниманию перевод статьи Мэта Камена (Matt Kamen) от 28 апреля 2016 года.

В статье рассказывается о том, какие возможности могут предоставить и предоставляют многопользовательские игры в решении важных проблем для всего человечества, связанных с необходимостью привлечения большого количества человеческих ресурсов.

Credit CCP Games

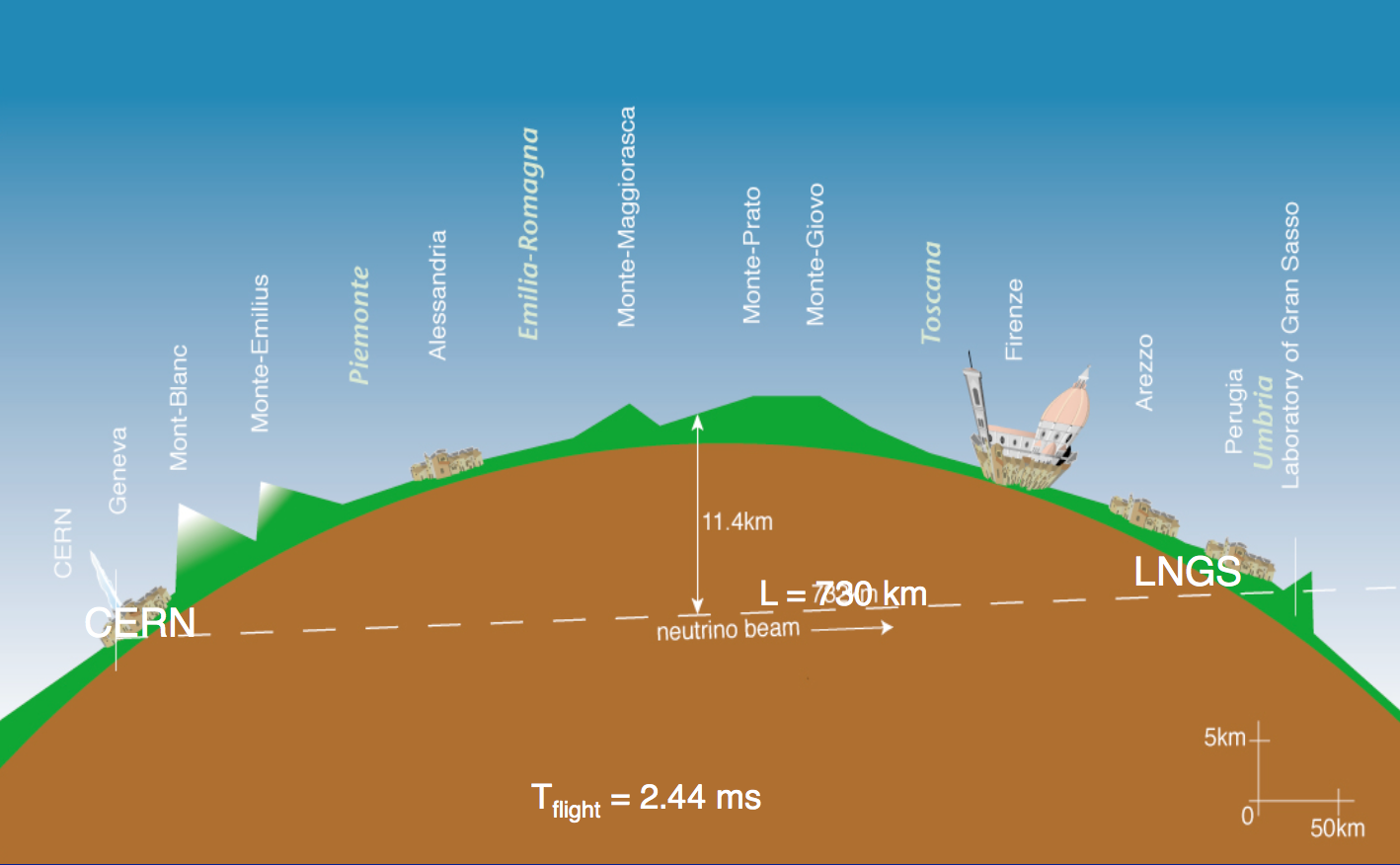

Машинное обучение и поиск темной материи: соревнование от ЦЕРНа и Яндекса

Яндекс уже несколько лет сотрудничает с ЦЕРНом. Он сделал для учёных-физиков поиск по событиям в БАК, предоставил свои вычислительные ресурсы и технологии обработки данных — в том числе Матрикснет и ClickHouse. В 2014 году Яндекс стал ассоциированным членом CERN openlab.

Школа анализа данных Яндекса принимает участие в двух экспериментах ЦЕРНа — SHiP и LHCb. Машинное обучение в наши дни становится «микроскопом» для современных учёных, которым необходимо изучать большие объемы данных и находить в них различные закономерности. В этом году ШАД совместно с лабораторией Методов анализа больших данных Вышки и Имперским колледжем Лондона организует в Великобритании международную школу, которая посвящена способам применения современных технологий в научных исследованиях.

Эксперимент OPERA — из Швейцарии в Италию (картинка взята с сайта коллаборации OPERA)

Сегодня в рамках школы начинается открытое соревнование, участники которого будут ни много ни мало искать нейтрино. Принять участие в поисках мы приглашаем всех желающих. Им предстоит обрабатывать данные с международного эксперимента OPERA. Для этого будут предоставлены исходные данные — результаты сканирования слоев фотопленок одного «кирпича» эксперимента OPERA. Соревнование состоит из двух этапов. На первом этапе участники будут искать отдельный ливень в «кирпиче», первая вершина которого известна, на втором — несколько ливней, рассредоточенных по объему «кирпича» без дополнительной информации. Победители смогут рассказать о своих решениях ученым, работающим в ЦЕРНе.

Запись с 1 млн нейронов: новые планы DARPA

Знакомьтесь, Apache BookKeeper — реплицируемый сервис журналов

По роду своей деятельности мне достаточно часто приходится участвовать в проектах, в которых создаются высокодоступные, высокопроизводительные системы для различных рынков — реклама, финтех, сервисы классов SaaS, PaaS. В таких системах применяется вполне устоявшийся набор архитектур и компонентов, которые позволяют эффективно обеспечить соответствие продукта требованиям, например, lambda-архитектура для поточной обработки данных, масштабируемый микросервисный дизайн программного обеспечения, ориентированный на горизонтальное масштабирование, noSQL СУБД (Redis, Aerospike, Cassandra, MongoDB), брокеры сообщений (Kafka, RabbitMQ), распределенные серверы координации и обнаружения (Apache Zookeeper, Consul). Такие базовые инфраструктурные блоки чаще всего позволяют успешно решить большую часть задач и команда разработки не сталкивается с задачами разработки компонентов среднего уровня (middleware), которые, в свою очередь, будут использованы бизнес-ориентированной частью разрабатываемой системы.

Ближайшие события

Лекция о двух библиотеках Яндекса для работы с большими данными

Под катом — расшифровка и часть слайдов.

Moneyball на бирже: как новые технологии меняют не только трейдинг, но и работу хедж-фондов

В 2003 году был опубликован бестселлер Майкла Льюиса под названием «Человек, который изменил все» (“Moneyball”) — это биографическая спортивная драма, рассказывающая историю генерального менеджера бейсбольной команды «Окленд Атлетикс» Билли Бина. Ему удалось добиться впечатляющих успехов с помощью анализа данных при формировании состава.

Бин смог эксплуатировать неэффективности, существовавшие на рынке игроков в бейсбол — он подбирал членов команды не на основе «шестого чувства», на которое опирались большинство скаутов команд, а с помощью статистического подхода. Это позволило ему при относительно небольшом бюджете показать лучший результат, чем большинство более богатых команд.

Этот же подход может быть применен к инвестированию и торговле на бирже — данные помогают обнаруживать и использовать существующие на финансовом рынке неэффективности, пишут финансисты Джон Гилчрист и Грант Уотсон на страницах издания Business Live.

Выбор алгоритма вычисления квантилей для распределённой системы

Всем привет! Меня зовут Александр, я руковожу отделом Data Team в Badoo. Сегодня я расскажу вам о том, как мы выбирали оптимальный алгоритм для вычисления квантилей в нашей распределённой системе обработки событий.

Анонс Moscow Spark #2

Как мы и обещали, наше мероприятие становится регулярным – 27 июля состоится Moscow Spark #2! Moscow Spark #1, организованный группой компаний Rambler&Co, собрал больше 200 участников, и мы надеемся, что жаркая погода, которая когда-нибудь установится в московском регионе, не помешает нам собрать столько же (и даже больше) участников в этот раз. Тем более, что мы нашли новых, интересных докладчиков.

Big Data в Райффайзенбанке

Про аналитику и серебряные пули или «При чем здесь Рамблер/топ-100?»

Всем привет! Я тимлид проекта Рамблер/топ-100. Это лонгрид о том, как мы проектировали архитектуру обновлённого сервиса веб-аналитики, с какими сложностями столкнулись по пути и как с ними боролись. Если вам интересны такие базворды как Clickhouse, Aerospike, Spark, добро пожаловать под кат.

Шесть мифов о Big Data

Big Data в последнее время стали трендом. Но что это такое, понятно не всем.

Многие думают, что большие данные — это либо просто огромный массив данных, либо простой и дешевый способ их хранения.

Большие данные вовсе не предмет, а совокупность подходов, инструментов и методов обработки структурированных и неструктурированных данных огромных объёмов. Это технологии, которые помогают решать важные задачи для бизнеса и науки. Из-за непонимания сути технологии возникли мифы, которые я попыталась развенчать в этой статье.

Вклад авторов

moat 815.0Aleron75 528.0Syurmakov 524.4alexanderkuk 501.03Dvideo 490.0i_shutov 488.0m31 483.2shukshinivan 460.0s_valuev 446.0o6CuFl2Q 445.0