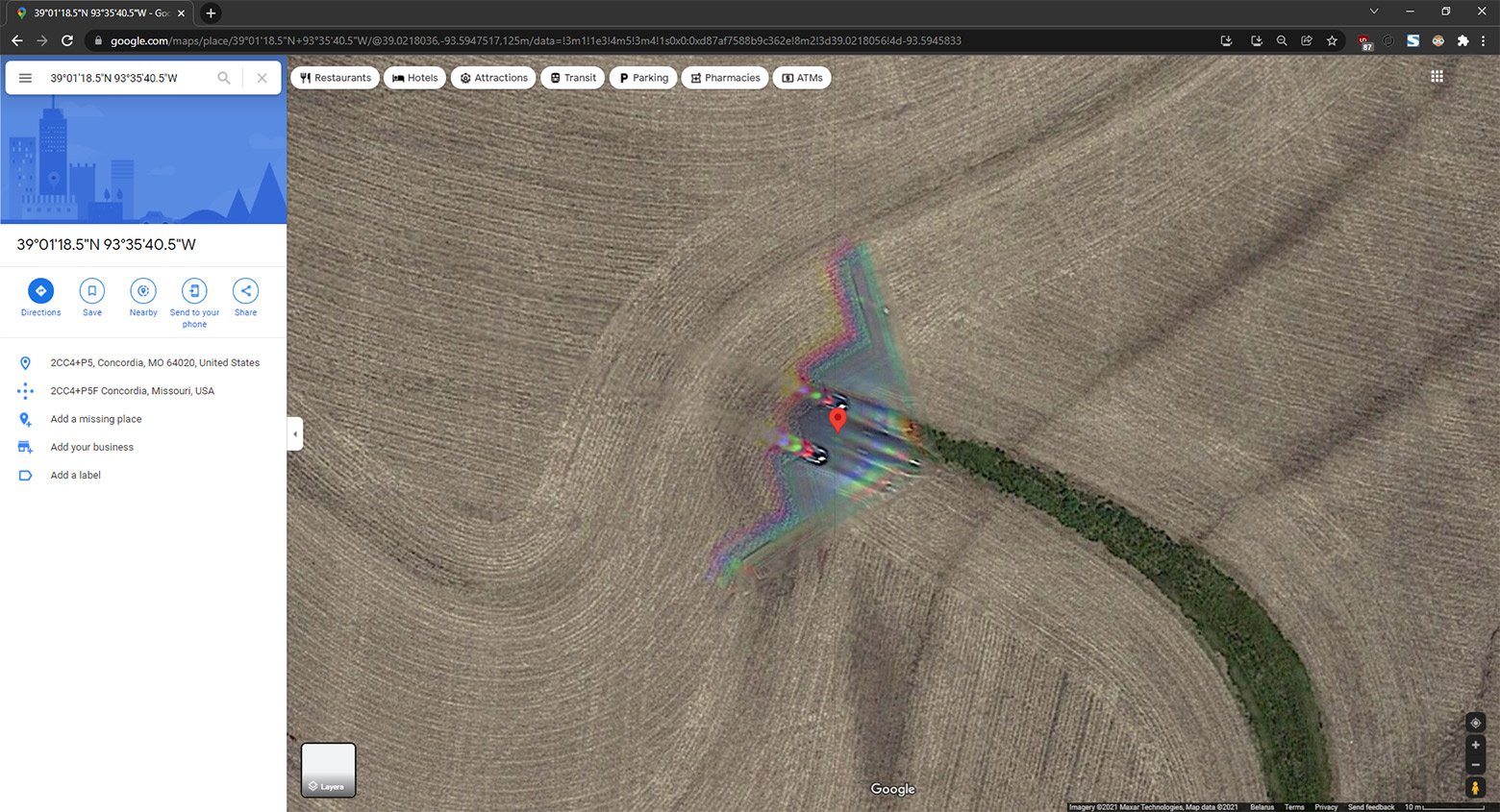

Привет, Хабр! Меня зовут Федор Клименко, я СЕО компании GreenMDC – мы занимаемся разработкой и производством модульных дата-центров. И иногда доставляем и собираем наши МЦОДы в экзотических регионах. Например, в марте запустили МЦОД в Якутске, где зимой столбик термометра опускается до -60 градусов. Сегодня расскажу о том, как мы везли дата-центр за 9 000 км и собирали его при -30, сколько слоев одежды было на монтажниках, как мы нашли работающий при такой погоде кран и избежали пайки фреонопроводов на морозе.

Предыстория

Для начала скажу, что хоть и являюсь гендиром компании, но в душе остаюсь инженером и люблю путешествовать. А потому часто работаю «в полях» и лично принимаю участие в монтаже и запуске МЦОДов, особенно, если проект интересный – такой как в Якутске.

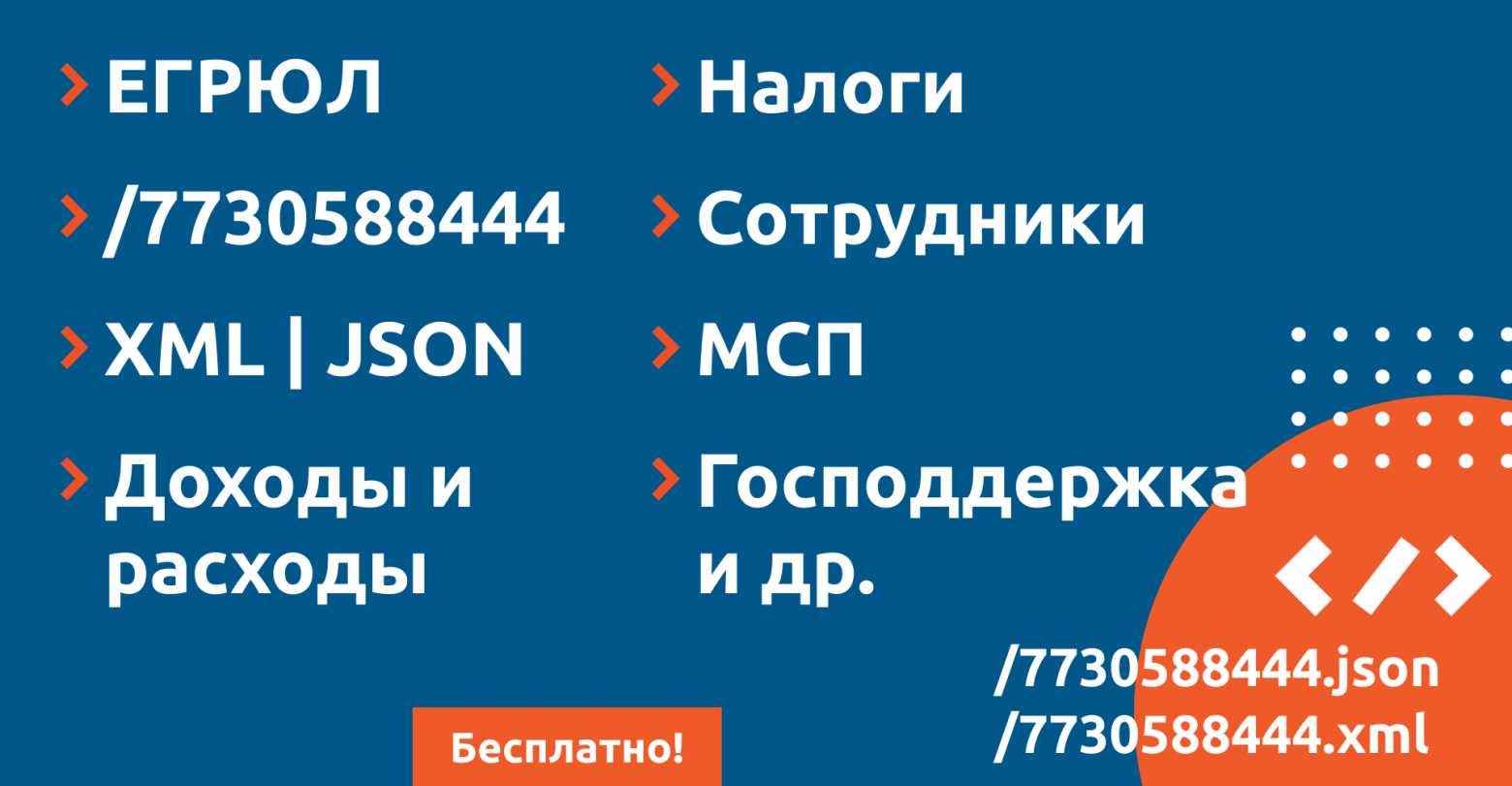

Этот модульный ЦОД мы разработали по заказу «Республиканского центра информационных технологий» Республики Саха (Якутия) и сделали это в рамках проекта по цифровизации региональных госуслуг. Соответственно, МЦОД хранит и обрабатывает информацию, которая касается таких сфер жизни, как здравоохранение, образование, служба МЧС, банковские услуги, сельское хозяйство и др. Здесь, например, разместился портал госуслуг, мониторинг обстановки при ЧС, в том числе лесных пожаров, колл-центр 122, интеллектуальная транспортная система региона и единая система электронного документооборота.