Машинное обучение поможет сократить популяцию мух цеце, чтобы снизить уровень заболеваемости сонной болезнью

Самки мухи цеце спариваются один раз в жизни, что дает возможность контролировать размеры популяции этих вредных насекомых. Так у самки, которая спаривается с бесплодным самцом, не будет потомства. При контроле достаточного количества спариваний, в результате можно снизить их популяцию, следовательно, снизить уровень заболеваемости сонной болезни среди людей и крупного рогатого скота.

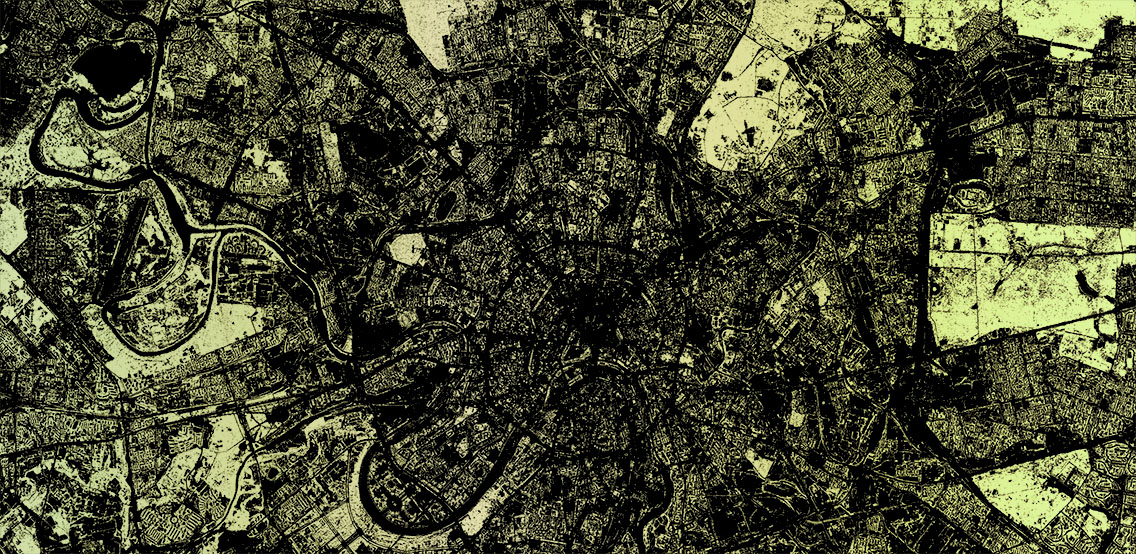

Исследование, проводимое в Сенегале, показало, что эта идея осуществима. За последние пять лет самцы мухи цеце, стерилизованные с использованием гамма-лучей, выпускались три раза в неделю в зараженные районы. Это позволило снизить местную популяцию мух на 98%, с соответствующим снижением заболеваемости сонной болезнью. Но такие проекты требуют огромного количества стерильных самцов, которых нужно разводить и доставлять своевременно, а это сложно.

Одна из проблем, заключается в том, что разведение самцов неизбежно затрагивает и размножение самок. Сортировка по половой принадлежности необходима для того чтобы производить облучение исключительно самцов. Элементарное облучение обоих полов вызывает проблемы, поскольку для стерилизации самок требуется более высокая доза облучения, которая может вызвать гибель самцов. Сортировка Цеце заключается в выжидании, пока мухи не вылупятся из куколок. Одновременно охлаждая их, чтобы уменьшить метаболизм и, следовательно, их активность. Отделение самцов от самок производится вручную при помощи кисточки. Самец отличается от самки наличием усиков, что помогает его идентифицировать. Этот процесс является эффективным, но трудозатратным и занимающим много времени. Зелда Моран из Колумбийского университета, считает, что есть способ лучше.