Как мы используем NLP в банке

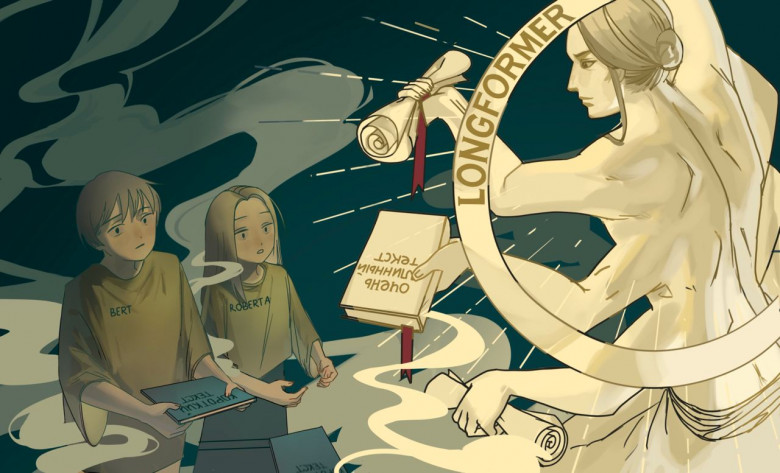

Это данные оплаты различных штрафов, пошлин, налогов и так далее. Такая информация потенциально может быть полезна для разных банковских сервисов. Например, если человек часто платит штрафы ГИБДД, значит, у него есть автомобиль, и это полезно знать для многих вещей вроде кредитного скоринга или понимания, что он может легко уехать в соседний регион и сделать «нетипичную» транзакцию в банкомате. Это позволяет, к примеру, эффективнее проводить фрод-мониторинг по картам и нетипичному месту проведения операции, что привлекательно и для банка, и для клиентов. Таких классов — сотни, то есть в идеале надо пытаться понять по документам платежа смысл действия.

Сначала мы просто искали слова вроде «авто» правилами, а потом перешли на NLP-подходы.

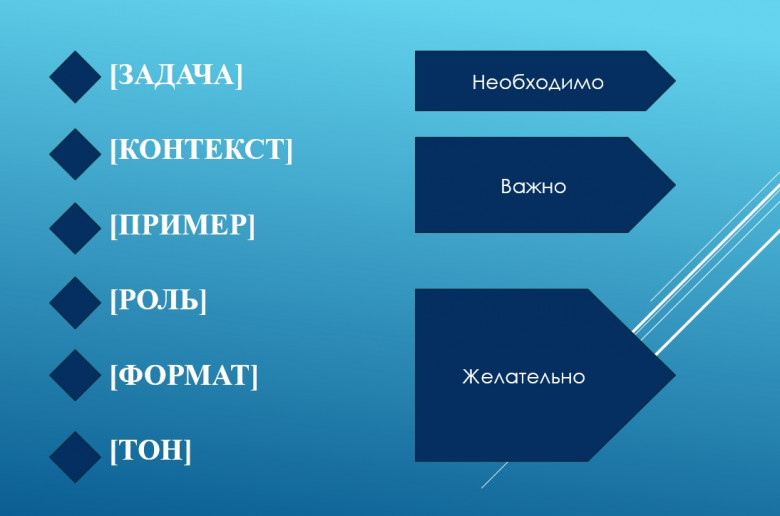

Natural Language Processing чаще всего используется в банках для автоматизации обработки заявок и анализа входящих документов, чтобы их маршрутизировать или классифицировать.

Конечно, это можно было бы делать и руками, но тогда это стало бы очень долго и дорого.