Подробный разбор того, как команда OpenAI Codex создаёт своего кодового агента, как его используют другие команды, как он влияет на инженерные практики создателей ChatGPT и что это может значить для будущего разработки ПО.

Чтобы в этом разобраться, я поговорил с тремя сотрудниками OpenAI:

Тибо Соттио (Thibault Sottiaux) — руководитель Codex.

Шао-Цянь Ма (Shao-Qian (SQ) Mah) — исследователь в команде Codex, обучающий модели, на которых тот работает.

Эмма Тан (Emma Tang) — руководитель data-инфраструктуры; она не входит в команду Codex, но её команда активно им пользуется.

В этом разборе:

Как всё начиналось. От внутреннего эксперимента в конце 2024 года до продукта, которым пользуется больше миллиона разработчиков.

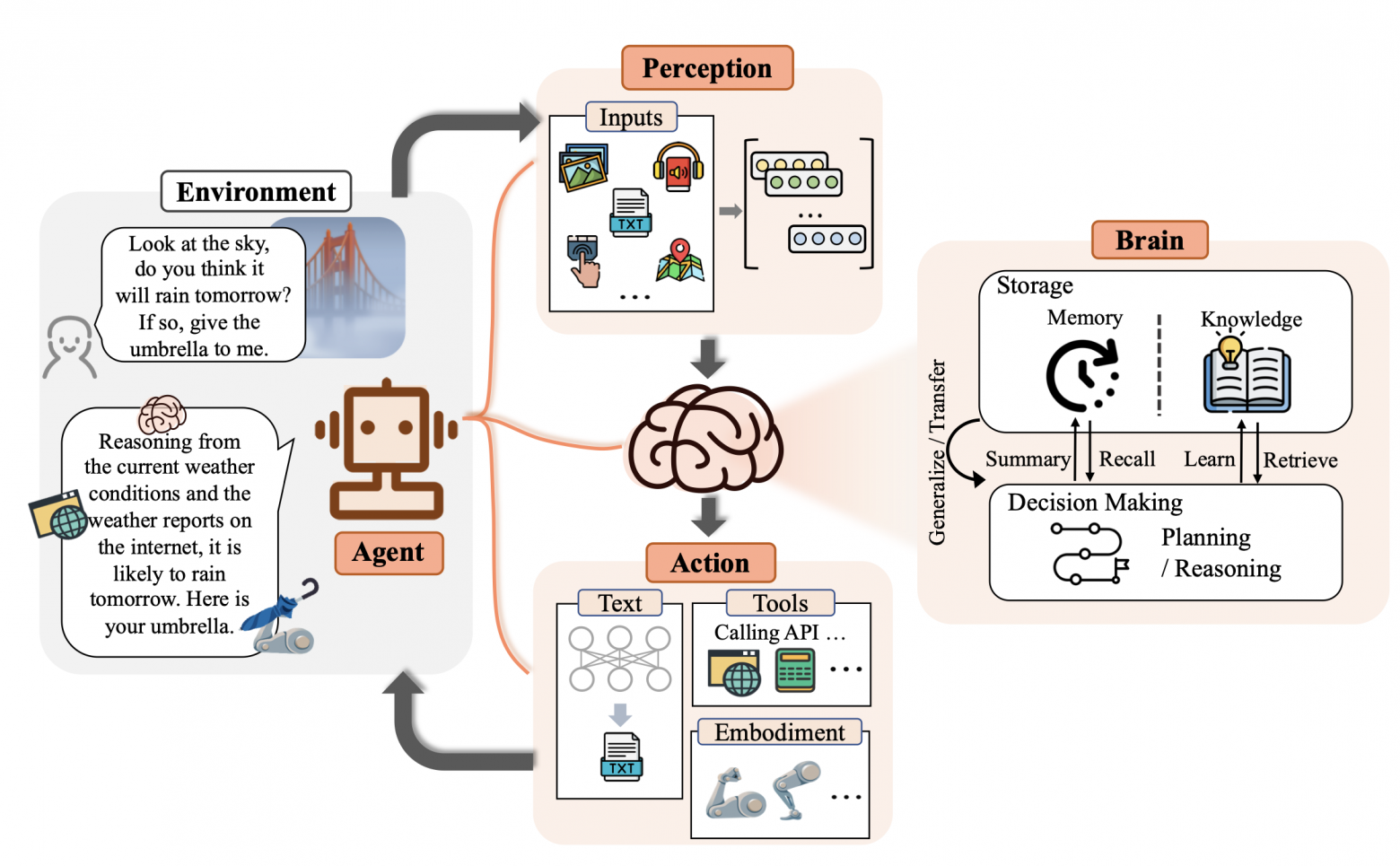

Технологические и архитектурные решения. Почему Rust и open source? Подробно о том, как работает агентный цикл.

Как Codex создаёт сам себя. По оценкам команды, более 90% кода приложения написано самим агентом. А ещё: интересные инженерные практики — как проводят код-ревью, самотестирование Codex и онбординг новых инженеров.

Исследования. Обучение следующей модели с помощью текущей и параллели с разработкой ПО. Запуск eval'ов, A/B-тестирование и внутренний догфудинг (использование сотрудниками собственных наработок в повседневной работе — прим перев.).

Использование Codex в OpenAI. Количество PR стало таким, что традиционный процесс ревью начинает трещать по швам. Мысли команды про то, что с этим делать.

Как меняется разработка ПО в OpenAI. «Правило 30/70», возвращение некоторых инженеров к tab completion и значение «инженерного вкуса».