Comments 260

Плюс со временем часть фотографий желтеют и это тоже вносит свой вклад.

В аналоге нюансов бесконечно больше, там и свойства пленки, и используемые реактивы, и даже условия хранения дают свой эффект. Я много занимался восстановлением старых фотографий и колоризацией, на большинстве снимков даже один тон неконтролируемо «плавает».

К тому-же нейросети не для дилетантов, это вполне обычные программы, которые созданы решать некоторую определенную задачу. Если задача не определена, то и результат получаем соответствующий. Сотворить и обучить нейросеть может любая обезьяна, тут знаний надо меньше чем для веб-программирования. Большинство начинаний идут от студентов, которым нужен не продукт, а хотя-бы какой-то результат, чтобы запостить публикацию и получить зачет. И делается это все на паре десятков «позвоночников», предобученных на условном ImageNet.

Если нам надо раскрашивать машины, то мы берем фотографии машин до «состаривания» фотографии и после, обучаем раскрашивающий фильтр. Если нам надо раскрашивать обезьян, фотографии машин нам уже не годятся, так же как не годится троллейбус из хлеба для полетов в космос.

Ну а теперь вопрос — какая нейросети разница какой оптической плотностью передан на моей фотографии тот или иной оттенок? Машина может быть изначально зелёного цвета, а может я просто переэкспонировал кадр.

Больше удивило то, как некоторые сервис крайне неаккуратно «раскрашивают» — постоянно вылезая за границы контура. Я-то кажется понимаю откуда растут ноги — и это удивляет ещё больше. Аккуратно «раскрасить» используя только цветовые каналы Lab и кривые/уровни — вообще не проблема. Но кто-то, видимо, решил подрубить и blur.

Если нужно имитировать совсем старое монохромное фото, берем только B.

ЧБ на черно-белой пленке образовано не только монохромными RGB, но и остальными частями видимого спектра и кусочками ИК и УФ, причем для разных пленок с несколько различающимися кривыми чувствительности.

Так что, как могут предлагать "универсальную" раскрашивающую нейросеть — хз.

Так что, как могут предлагать "универсальную" раскрашивающую нейросеть — хз.

Я список сервисов для теста по интернету собирал. В разных обсуждениях и обзорах.

Нигде не пишут "Эта нейросеть предназначена только для раскрашивания цветочков. Не используйте её для раскрашивания лиц."

Просто рассказывают о прелестях новых технологий.

Если нам надо раскрашивать обезьян, фотографии машин нам уже не годятся, так же как не годится троллейбус из хлеба для полетов в космос.

Именно.

У людей ровно то же самое

Беда, коль пироги начнёт печи сапожник,

А сапоги тачать пирожник,

И дело не пойдёт на лад.

Но среди не-айтишников это не все понимают.

Многим кажется, что волшебная нейросеть универсальна и может всё.

Вы это к тому, что будь нейросети тренированы по ЧБ в фотошопе (они, кстати, скорее всего были тренированы по "ЧБ в фотошопе", ибо откуда еще взять нужное для тренировки число пар "ЧБ"-цвет), то результат был бы принципиально иным? Сильно сомневаюсь.

Задачи, затронутые автором статьи, на 100% не способна решить даже лучшая из известных на данный момент нейросетей — ваш мозг. И это при том, что ему доступны такие инструменты, как "поискать в архивах, каких цветов выпускались Ford A в 1920 году.

На самом деле проблема-то довольно похожа на давнешнюю историю с улучшайзерами в звукозаписи/воспроизведении.

И вот что-то мне смутно подсказывает, что в 1920 цвета „глубокий зеленый металлик“, в которой раскрасили Ford самые настоящие

Спасибо за статью, но что-то мне подсказывает, что ЧБ на тогдашней фотографии и ЧБ в фотошопе дадут разный результат.

Да, Вы правы.

Есть несколько формул обесцвечивания. Я в PaintShopPro делал и просто перевод в оттенки серого и перевод в чёрно-белую фотографию. Результаты разные.

И разница будет и и при аналоговой фотографии. Разная плёнка. Разная бумага. Недосветил фотоувеличителем. Передержал в проявителе.

В данной ситуации, для меня важным было не только то что сервисы в реальный цвет не попадают, а ещё и то что они все дают разные результаты.

Но всё очень правдоподобно смотрится.

Иногда, раскрашенные машинки выглядят интересней чем оригинальные.

Придумали антибиотики, стали пичкать ими животных на фермах получая полирезистентную флору. Научились извлекать ископаемые топлива принялись расточительно их жечь. Придумали пластик, стали экономить и делать из него упаковку товаров и продуктов (дешево же) и получили планетарное загрязнение, которое непонятно как аукнется. Придумали как удешевлять программирование через фреймворки и получили современный веб или драйверы объемом в сотни мегабайт.

На очереди применение нейросетей в целях пропаганды. И мы получим веб в виде гигантской непроходимой помойки, заваленной неструктурированным инфохламом. Что там еще осталось, околоземный космос? И там мусора полно.

Пожалуй, с атомным и биологическим оружием у нас хватило воли и прогностических способностей сказать «стоп».

Пожалуй, с атомным и биологическим оружием у нас хватило воли и прогностических способностей сказать «стоп»

Тут вы явно ошибаетесь.

Этот вывод может быть корректным лишь «задним числом». Когда данное оружие исчезнет со сцены не будучи использованным.

А на данный момент и то, и другое вполне налицо, и как чеховское ружье на стене лишь ждет своего момента.

А на данный момент и то, и другое вполне налицо, и как чеховское ружье на стене лишь ждет своего момента.По крайней мере, ружьё это появилось не вчера, и висит уже достаточно давно, чтобы начать если не ржаветь, то основательно покрываться пылью.

основательно покрываться пылью

Какое поразительное невежество…

Оно не только не «покрывается пылью», но непрерывно совершенствуется — в сторону ПОНИЖЕНИЯ порога применения.

Что еще как бы пол-беды. Настоящая беда — оно РАСПОЛЗАЕТСЯ. Попадая в руки, в которых прямо скажем очень не хочется видеть. Опять же дело не столько в пакистанцах или северных корейцах как таковых, как например в недееспособности пакистанского государства. В силу чего очень велика вероятность попадания ЯО в руки группы фанатиков или уголовников.

Оно не только не «покрывается пылью», но непрерывно совершенствуется — в сторону ПОНИЖЕНИЯ порога применения.

А тут пишут что последняя производившаяся в США спец-БЧ — боеголовка для Трайдент-2 и ее производство завершено 31 год назад.

Настоящая беда — оно РАСПОЛЗАЕТСЯ. Попадая в руки, в которых прямо скажем очень не хочется видеть. Опять же дело не столько в пакистанцах или северных корейцах как таковых, как например в недееспособности пакистанского государства. В силу чего очень велика вероятность попадания ЯО в руки группы фанатиков или уголовников.

Верхушка хоть фанатиков хоть уголовников — люди прагматичные и с айку выше среднего ибо другие в конкурентной борьбе не выживают. И она прекрасно понимает что от применения одиночной бомбы будет хуже им же ибо карательная экспедиция после Хиросимы-2 начнет применять методы времен Киплинга, а не как сейчас.

Историю с Аум Синрикё или Храмом народов знаете?

Аум Синрикё пытались достать ядерное оружие, естественно, не получилось, пришлось обходиться химическим. Но речь не об этом, а о том, что ни Сёко Асахара, ни Джим Джонс не производят впечатления прагматичных людей. Конечно, среди лидеров сект есть люди вроде Хаббарда, но далеко не все они такие.

Оно может исчезнуть со сцены только после появления оружия аннигиляционного (примерно, как исчезли луки, арбалеты и конница)

Технологии нельзя закопать и забыть (без уничтожения их носителей, естественно)

Технологии нельзя закопать и забытьАмериканцы когда-то посылали человека на Луну за 400 тыс.км., сейчас не могут забросить на МКС, а это меньше 400 км. Всего-то 50 лет прошло.

Технологии никто не забывал, при желании и средствах ту же аппаратуру можно воспроизвести намного быстрее, чем было прии изначальной разработке.

Начнём с того, что нет ни того сырья, ни оборудования под которые были разработаны техпроцессы.

Именно поэтому, кстати, крупные производители всякого железа делают запасы запчастей — хрен их потом воспроизведёшь, после утраты технологической цепочки.

просто невыгодно отправлять туда людей?Илон Маск об этом не знает и вкладывается в разработку пилотируемых ракет. И каждый год обещает отправить человека на МКС. Надо же.

сейчас не могут забросить на МКС, а это меньше 400 км.

Технически могут — Дракон стыковался еще в 2012. Не забрасывают потому что НАСА вдруг стало страшно посылать астронавтов на корабле без САС.

Маск обещал послать человека в космос в 2017-2018-2019-2020 году и что?Я правильно понимаю, что любой случай когда стартап/компания что-то обещает и не делает, вы относите к утере технологий?

По поводу других случаев регресса — «темные века» в истории Западной Европы. Это яркий пример «утери технологий», после Древнего Рима.

Это ответ на ваше утверждение, что американцы просто «не хотят» в космос.Интересно конечно, но я ни такого ни похожего утверждения не писал.

Если обещают, значит хотят. Если нарушают обещания, значит на могут.Здесь абсолютно с вами не согласен. Сплошь и рядом ситуации, когда (i) государства или компании что-то на публику обещают, а на самом деле руководители не хотят этого, и (ii) когда что-то обещанное (государством или компанией) не выполняется. Примеров огромное количество, как у нас так и за океаном. Вы хотите все невыполненные обещания считать за утерю технологий?

А в середине прошлого века не боялись на машинах без ремней безопасности ездить. Куда катится автомобильная промышленность.

Как минимум по будням я обедаю в кафе. Но не потому что закопал и забыл технологии приготовления пищи, а потому что мне так проще (и в итоге — дешевле).

Американцы когда-то не "посылали человека на луну". Я не про конспирологию, а про то, что не было научной, или тем более экономической задачи "послать человека на луну", была политическая задача "обойти СССР в космосе". И под эту политическую задачу выделили соответствующее (гигантское) финансирование и послали на луну людей (думаю что на современных технологиях в такой бюджет можно и марсианскую миссию организовать). Замечу, что советская лунная программа была свернута после успеха американской (политической выгоды уже не получить, а научно-техническая не стоит тех затрат).

Сейчас такой задачи нет. Нет и финансирования.

Строго говоря в обозримой перспективе человеку вообще мало что делать в космосе: автоматика справляется лучше. И если пока что дешевле посылать астронавтов в космос через байконур, то почему бы и нет. И неспешно пилить свой дешевый вариант доставки. Шаттлы-то перестали делать и запускать не потому что полимеры просрали, а потому что дорого. И холодная война закончилась (а вместе с ней и потенциальные околовоенные применения шаттлов).

Сейчас такой задачи нет. Нет и финансирования.

Вообще-то финансирование есть — 3-4 миллиарда в год на SLS и Орион. Вот только пилить бюджет умеют и в американском аэрокосе правда делают это так что формально не подкопаться.

Шаттлы-то перестали делать и запускать не потому что полимеры просрали, а потому что дорого.

По официальной версии потому что опасно — до катастрофы Колумбии планировали использовать до 2015 с возможностью продления.

Вообще-то финансирование есть — 3-4 миллиарда в год на SLS и Орион

Не тот масштаб финансирования. "Согласно словам Стива Гарбера, куратора сайта об истории НАСА, окончательная стоимость программы «Аполлон» была от 20 до 25,4 миллиардов долларов США 1969 года, или приблизительно 136 миллиардов в долларах 2005 года."

По официальной версии потому что опасно — до катастрофы Колумбии планировали использовать до 2015 с возможностью продления.

При энерговооруженности шаттла принципиальных технических проблем оснастить его системой спасения быть не должно. Вопрос в цене.

Не тот масштаб финансирования.

А им и не надо разрабатывать супертяж с нуля и впервые в мире — RS-25 достался готовый от шаттла, ТТУ — почти готовые от того же Шаттла (пришлось добавлять одну секцию, но это было сделано еще в 2009), RL-10 для второй ступени (или третьей по российской классификации) — вообще от лунной программы. Нового там только баки и моторамы и СУ.

При энерговооруженности шаттла принципиальных технических проблем оснастить его системой спасения быть не должно. Вопрос в цене.

САС Колумбию бы не спасла. А после Челленджера продолжили летать без САС ибо Боинг и Ко мамой поклялись что больше не рванет.

Пожалуй, с атомным и биологическим оружием у нас хватило воли и прогностических способностей сказать «стоп».

В 2020ом часы судного дня снова вперёд вроде переводили. Ядерный арсенал никуда не делся и как мы знаем из истории, как минимум один раз мы были близки к очень большой беде.

О, это мое любимое! Сраный клиент для винды, следящий за изменениями файлов запускает порядка 5 процессов, выжирает для себя полгига ОЗУ и суммарно под 200 (!!! прописью: двести) потоков.

Цифры конечно ужасают, но при этом на практике dropbox с ~2013 года, и ни на одном из компьютеров конкретно он не становился причиной тормозов. Включая машинки с HDD. Так может и фиг с ним, пускай кушает, если это позволяет ему быстрее отслеживать изменения и заливать их в облако/из облака, а мне не доставляет проблем?

Потому что… хз почему. Потому что может!

Так может и фиг с ним, пускай кушает

Вопрос в том, нафига они такое нагородили. Это всё можно было бы уложить в системный сервис + утилитку в трее с контекстным меню на 2 пункта. Но нет! Мы притащим сюда весь Qt5 (включая 70-мегабайтный Qt5WebEngineCore.dll), Питон с кучей пэкэджей, компилятор шейдеров от Хромиума, либу OpenGL, редистрибьютабл С++, отдельный UI для WindowsXP и ещё кучу-кучу всяких костылей и велосипедов. И это для утилиты, которая 10 лет назад весила мегабайтов 5, помещалась вся в три бинарника, создавали три потока — и делала то-же самое, что и сейчас!

Судя по командной строке: Основной, крашхендлер и exit-monitor.

180+ потоков суммарно.

И чем вам так плох современный веб?

Тем, что если раньше разработчики страдали во благо пользователей, то теперь пользователи страдают «во благо» разработчиков. А именно — ценой тормозов, нервов и потраченных на апгрейд денег. А апгрейд ради чего? Что функционально изменится? Ничего, просто это апгрейд в угоду ленивому разработчику, который без фреймворка уже и лендинг сделать не сможет.

По поводу фреймворков — удешевление и упрощение разработки заставляет разработчиков меньше думать о потребляемых ресурсов вообще и о памяти в частности. В итоге имеем т.н. Пейсбук, от главной страницы которого мой ноутбук пытается улететь в стратосферу на вентиляторе, имеем Инстаграм, который на самом деле веб-сайт и от которого мой телефон ощутимо нагревается просто при редактировании статичной картинки в сториз.

Да, современная разработка дешевле, потому что компании переложили стоимость разработки на стоимость оборудования, способного вытянуть современные поделия.

Если бы закон Мура не компенсировался законом Вирта, то во вселенной начались бы уменьшение энтропии, всеобщее благоденствие и прочие недопустимые вещи

не факт, что альтернативы лучше, или возможны

Почему раньше работало, а сейчас перестало? Иногда в качестве контраргумента приводят довод о том, что, дескать, раньше веб-страницы были проще и вообще приложениями не считались. Так вот, неправда, вспомните панели управления WordPress, phpMyAdmin, DLE, простиг-споди 1С: Битрикс — они достаточно сложны, на порядок сложнее, чем Инстаграм или Фейсбук, но при этом они работают в разы быстрее. Внешний вид? Так это решается средствами CSS, а не фреймворками.

Потому что TL;DR.

фб — единая распределённая система. админки сайтов или майадмина сами по себе. и вряд ли они смогли бы так же шустро работать при сопоставимых нагрузках.

хотя да, монстры типа фб, джимэйла и прочих "богатых сетевых приложений" ;) жрут много память на свои свистелки-перделки. а интерфейс фб так вообще ужасен генетически. но нагрузку держит

Про атомное я согласен. Но биологическое… ТВ не смотрите?

Пожалуй, с атомным и биологическим оружием у нас хватило воли и прогностических способностей сказать «стоп».

Биологическое (как и химическое) просто оказалось неэффективным. С атмомным — никакого «стопа» нет и близко. Думаю, скоро увидим применение его как тактического. Увы.

Странно, что ты не написал про современную концепцию сверхпотребления вообще, когда вся промышленность, производящая товары народного потребления, фактически работает сразу на свалку, настолько мало живут эти товары у пользователя.

Пока на планете доминирует общественно-экономическая формация, главной целью которой является извлечение максимальной прибыли любой ценой, человечество и будет вести себя как подростки.

Я в общем обременён аналогичными мыслями о потребительстве, индустрии «говна» и прочих прелестях современности. Однако до вашего поста эта тема была вне контекста. Хотя на мой взгляд опасности от описанных «экономических эффектов» ни то чтоб меньше… по моему скромному мнению ориентация на экономический аспект общественной жизни от человека как существа живого, одушевлённого, осознающего ни останется и пустого места.

Больше того кажется мне, что для этого и увели на экономико-демократический, вместо социально-политического, фронт народы современного мира.

Ничего особенно современного в этом нет

Странно, что ты не написалЧто случилось месяц-два назад, что Хабр начал активно переходить на «ты»? Я сам не против, но я явно пропустил какое-то событие.

Биологическое (как и химическое) просто оказалось неэффективным.

Химическое широко и успешно применяли до конца ПМВ при наличии противогазов. Хинт — противогаз еще надо успеть одеть. С биологическим да — не взлетело.

С атмомным — никакого «стопа» нет и близко.

Настолько нет и близко что последнее боевое применение в 1945?

Думаю, скоро увидим применение его как тактического. Увы.

И какие тактические задачи сейчас решаются только тактическим ядерным оружием и ни каким другим?

Странно, что ты не написал про современную концепцию сверхпотребления вообще, когда вся промышленность, производящая товары народного потребления, фактически работает сразу на свалку, настолько мало живут эти товары у пользователя.

Мой предыдущий смартфон прожил 4 года без единого ремонта, предыдущая персоналка — 9 лет и пошла в отставку только потому что мне хотелось в одну современную игру погонять. ЧЯДНТ?

Пока на планете доминирует общественно-экономическая формация, главной целью которой является извлечение максимальной прибыли любой ценой

Уже давно не доминирует и не факт что вообще доминировала. Если капиталист будет максимизировать прибыль любой ценой — он прогорит ибо не делал инвестиций в развитие.

человечество и будет вести себя как подростки

Как будто что-то плохое.

Если капиталист будет максимизировать прибыль любой ценой — он прогорит ибо не делал инвестиций в развитие.Это разве только малого бизнеса касается. Вот что должен сделать например Боинг, чтоб прогореть? Да это абсолютно невозможно, государство спасёт его в любом случае, даже в самой скверной ситуации.

Читал статью с недоумением, а теперь вижу, что ой не зря ее автор написал…

Читал статью с недоумением, а теперь вижу, что ой не зря ее автор написал…

Велкам ту зэ клаб :)

Обезьяна в фаре — отлично демонстрирует работу нейросетей.Я думаю, автор это и имел в виду, когда чуть ниже написал:

«теперь эта проблема обрела своё конкретное лицо».

Обезьяна в фаре — это нечто ещё более страшное, чем обезьяна в vim-е.

для сложных задач не используют такие обобщённые нейросети

И даже когда технологии продвинутся вперёд и таких размазываний не станет, это не изменит ситуации с тем, что восстановить происходившее между кадрами невозможно, и всё что нам остаётся — дорисовывать некое усреднённое состояние.

Но ведь от этих «увеличителей fps», как мне казалось, никто и не ждал появления новых деталей. Просто увеличится комфорт от просмотра фильмов

Было бы интересно, чтобы нейронная сеть «улучшала» промежуточные кадры на основе соседних, имеющихся в видео. Но в реал-тайме вряд ли сейчас такой объём вычислений возможен.

Но ведь от этих «увеличителей fps», как мне казалось, никто и не ждал появления новых деталей.

Я не уверен в слове "никто".

Люди далёкие от технологий не понимают что происходит.

Им говорят "нейросеть восстановила цвет" и они считают что перед ними изначальный цвет, который был во времена создания исходной фотографии.

Так же и с размерами и с дополнительными кадрами.

В оптических приборах можно увеличить и рассмотреть детали. Так почему тут нельзя?

Вот и приходится объяснять, почему именно нельзя.

Я поэтому и начал писать книжку в среде максимально далёкой от профессионального IT-сообщества, ибо это разные аудитории с которыми надо разговаривать разным языком.

Да, да — все дело в подборе слов. Если бы говорили «нейросеть _добавила_ цвет» — это было бы ближе к истине. Хотя все равно нашлись бы люди, которые бы поняли как то, что это изначальный цвет.

Есть идея, которая звучит в комментариях со стороны фанатов ненейросетей, но не всего её понимают.

Эта идея о том, что нейросеть строит модель.

Набираем примером полёта камня у поверхности Земли, нейросеть строит модель и способна дальше с этой моделью работать.

То же самое, с распространением эпидемий, сейсморазведкой полезных ископаемых и пр.

Но в случае с преобразованием чб->цвет не существует возможности построить модель.

Не "сложно", а именно что "невозможно".

А если нельзя построить модель, то это не моделирование, а фантазирование.

Или возьмём пример из обработки текстов (мне это ближе). Вот цитата из Чайковского, слегка упрощённая и изменённая:

Музыка не только развлекает, но доводит до ощущения блаженства, для его до бесконечности.

Мы хотим её перевести на английский язык. В подавляющем большинстве случаев слово «для» переводится как предлог «for». Но человек, хорошо владеющий русским языком, поймёт, что в данном случае оно использовано как деепричастие от глагола «длить». Потому что обстоятельство времени «до бесконечности» хорошо сочетается с глаголом «длить». Тем не менее, все нейросетевые переводчики переводят в этой фразе «для» как «for»:

- Яндекс Переводчик: Music not only entertains, but brings to a sense of bliss, for it to infinity.

- Google Translate: Music not only entertains, but brings to the sensation of bliss, for it to infinity.

- DeepL: Music not only entertains, but brings a sense of bliss, for it to infinity.

Это значит, что у них два пути:

- Ещё больше увеличивать выборки параллельных текстов, стараясь охватить все возможные употребления всех возможных слов

- Вводить элементы экспертных систем перевода, которые развивались до широкого распространения нейросетей.

Так вот, значит, откуда ноги у градиентной колоризации от mail.ru

Поддерживаю. Я как-то загружал старое ч/б фото в нейросеть. На фото из-за дефекта проявки (неоднородность температуры, перемешивания или чего там еще) был слабый градиент, который сводил нейросеть с ума, потому что в ее обучащаем наборе из цифровых фотографий такого не было и не могло быть.

Та же самая ерунда случается с сервисами переводов, основанными на нейросетях. Особенно если выбрать два достаточно близких языка, но для которых во время обучения сеть не тренировалась на прямых переводах.

Например, если взять польский текст и перевести на белорусский язык. Иногда получается перевод надуманный, в котором вроде и слова примерно правильные используются, но в целом получается нелепица, а то и полностью "ортогональный" смысл. Такое происходит и в Гугл Транслейт, и в Яндекс. Потому что не имея достаточно опыта разбора готовых прямых польско-белорусских переводов, они внутренне гоняют текст через английский и русский, по дороге теряя оригинальные детали, и приобретая элементы этих промежуточных языков.

а у кого-нибудь есть граф по которому гоняет GT?

Насколько я знаю, некоторые пары языков она переводит не через английский (скажем ру-укр)

А мы не переставали — Гугл Транслейт достойно принял эстафету компьютерного перевода и радует нас раз за разом :)

Гуртовщики мыши — навечно в моём сердце, и никакой Гугл Транслейт их не заменит :)

Она всегда будет додумывать детали. :(

Но если её тенировали на правильном датасете, то это просто не будет бросаться в глаза.

Это одновременно является и плюсом для кинозрителя, и минусом для историка.

а нейросеть неспособна определить, какие данные ей подсунули, какой из известных ей датасетов применять в конкретном случае? (понимаю, что зависит от реализации. но есть такие или нет?)

А вот это одна из главных проблем использования нейросетей.

Человек-аналитик или компьютерная программа выполняющая строгий математический расчёт скажут "данных для расчёта недостаточно".

Нейросеть же свою работу сделает независимо от количества данных в датасете и того подходит ли датасет в конкретном случае.

И если несуразность результата не будет бросаться в глаза (как в случае с лицом в фаре или раскрашиванием от mail.ru ), то у нас нет возможности проверить полученный результат.

после прочтения захотелось, чтобы на таких обработанных фотографиях обязательно добавлялся текст об обработке. другой вопрос что в современных фотокамерах обработка начинается на этапе самой фотографии. интересно, а «обезьяны» будут появляться на современных SpaceZoom и прочем?

Где-то в обзорах телефонов в прошлом (или поза-прошлом) году, при обзоре камеры демонстрировали, что нейросеть в телефоне улучшила резкость окон дома, где-то на заднем плане. Форма окон при этом изменилась на другую )

Проблема ещё в том, что современные фотографии в самом фотоаппарате/смартфоне зачастую прогоняются через неотключаемый улучшайзер. Потом, на Хабре несколько лет назад была статья на Хабре про слишком умные копиры, которые в процессе копирования документов с мелкими цифрами вносят критические ошибки, например, рисуют цифру 1 вместо буквы I или l или наоборот. Или путают 1 и 7. Понятно, какие последствия это может иметь — любые, и в том числе очень печальные. Например, если в самолёт зальют не 4740 кг топлива, а 4140 и самолёт не долетит. Или будет ошибка в площади продаваемой недвижимости в нотариально заверенных бумагах, что повлечёт годы судебных разбирательств.

несколько лет назад была статья на Хабре про слишком умные копиры, которые в процессе копирования документов с мелкими цифрами вносят критические ошибки, например, рисуют цифру 1 вместо буквы I или l или наоборот.

Да, это история очень показательная во многих отношениях. Проблема была известна за несколько лет до того как о неё громко заговорили.

А в моём случае всё гораздо хуже — речь об использовании популярного алгоритма сжатия, который активно использовали для сохранения отсканированных письменных источников. И до сих пор используют.

И когда этот алгоритм путает "и" и "н" это не так страшно, хотя и затрудняет поиск по тексту.

Но когда перепутаны "6" и "8" — это уже проблема.

Увеличение частоты кадров можно делать через SVP.

Далее, рендерер можно использовать madVR, вот здесь:

https://yabb.jriver.com/interact/index.php?topic=110989.0

описываются настройки SVP с madVR'ом для получения качественного улучшения картинки («киношное» видео с увеличенным fps).

Все вышеперечисленное — без нейросетей, ну и результат мне нравится.

И в динамических сценах тоже все хорошо (на это я обращал внимание в первую очередь), если видеокарта и процессор позволяют.

SVP хорошо работает только на небольшом подмножестве задач.

В стоке, как я выше написал, мне не очень нравился результат.

Наверное, один из самых плохих кадров, который мог выдать SVP, зато хорошо видно проблему. Идеальной интерполяции кадров я пока не видел.

SVP в стоке

SVP + madVR

На мой взгляд, качество разительно отличается.

https://yabb.jriver.com/interact/index.php?topic=110989.0

Да ладно, я сто раз в кино видел, как читают надписи на визитке, увеличивая картинку с камеры наблюдения за три квартала!

И на хабре статья проскакивала, кстати.

Алгоритм пишет все цифры в нужно плоскости, а потом ухудшает изображение цифр до исходника.

И смотрит какие цифры какие результаты дали. Иными словами — каждая цифра дает свой достаточно уникальный отпечаток и по этому отпечатку алгоритм способен её узнать.

В некоторых случаях, даже если цифра деградировала до одного пикселя — восстановление возможно.

Основная проблема в подборе параметров сжатия. Т.к. надо учитывать множество параметров которые влияли на данные в процессе записи(освещение, шумы, пространственные искажения и т.п.)

Эти некоторые случаи называются "переобученная нейросеть".

Если ей подсовывать те пиксели, на которых ее обучали — будет прям удивительно хорошо "восстанавливать информацию".

Если другие, то тоже будет "восстанавливать", но ту же самую информацию, что и в предыдущем случае

суть не меняется

заточенный на восстановление цифр из пикселей алгоритм прекрасно восстановит в цифру 8 пиксель, в молодости бывший буквой ё

А еще она не сможет восстановить цифру из пикселя, если на него оказывала влияние соседняя цифра.

Здесь нет магии. Достаточно простые, но в ряде случаев вполне эффективные алгоритмы.

Например, номер автомобиля очень хорошо попадает в разряд ситуаций, где этот алгоритм хорошо себя показывает. Мы знаем шрифт, мы знаем набор возможных символов, мы знаем цвет фона, нам не нужна 100% точность, достаточно лишь серьезно сократить выборку.

Обычно для этого используется несколько кадров.

Но даже дополнение про «некоторые случаи» там не обязательно, т.к. вполне очевидно что подобные алгоритмы будут иметь ограничения.

В следующий раз предлагаю вам докопаться до формулировки в описании автомобиля «разгон до 100 км/ч за 10 секунд» фразой «Лихо у вас выходит. А если я бетонную стену перед машиной поставлю — что, тоже разгонится?»

Мне правда интересно, есть ли такие волшебные алгоритмы, что умеют из таких скудных данных вытаскивать ответ. С нужной точностью проходят через все вылезающие интегральные уравнения, и это решение остается устойчивым несмотря на погрешности, вносимые неидеальностью оптики камеры, индивидуальными различиями отдельных пикселей матрицы, дробностью оцифровки…

В последних версиях блендера впилили интеловский денойзер и он работает превосходно, порой напоминая магию. Я не совсем понимаю как именно он работает но на его вход подается не только картинка, но и карта нормалей. Которая, видимо, подсказывает алгоритму как нужно фильтровать каждый участок.

PS: Не думали над переводом на английский язык? Есть ощущение, что «стрельнет» хорошо.

Вы всерьез думали, что нейрость понимает по ЧБ картинке какой там был исходный цвет?

ДАже автор упомянутого оцветнения прибытия поезда в своей статьей прямым текстом говорил, что сеть делает вывод о возможном цвете предмета на основе его формы и положения.

Вы как-то странно воспринимаете нейросети, как такого "универсального мудреца", который всё знает. Но нейросеть — это не один гуру. Это скорее соцсеть для студентов, их много, и что-то они умеют, но только то, чему их научили.

Посадите толпу не очень грамотных студентов раскрашивать фотографии — будет тот же эффект: "эта машина, наверное, была красная". Чтобы понимать, что эта машина должна быть чёрной, студенты должны разбираться в истории автомобилей тех лет.

Если нейросеть обучить на таком сете, научить разбираться в ретромобилях — будет нормально красить. То же самое с раскраской статуй или архитектурными деталями — если нейросеть научить распознавать архитектуру, автомобильные детали и логотипы, она справится. И обезьяна в фаре — это, в целом, правильно, нейросети, скорее, "мерещится" там обезьяна, чем какие-то непонятные полоски или логотипы.

Так научили, а без специфических навыков можно и кошку принять за пакет, и жену за шляпу.

А то, что mail.ru сделали к 9 мая — это просто массовая игрушка к празднику, не стоит ожидать от неё серьёзных, исторически достоверных результатов. Для этого нужны не студенты, а грамотные историки. Т.е. соответственно обученная нейросеть.

Вы как-то странно воспринимаете нейросети, как такого "универсального мудреца", который всё знает.

Я — нет.

Но я общаюсь с людьми, которые не понимают принципов работы цифровых технологий и связанных с этим сложностей.

А ещё, я понимаю, что через 10-20 лет, никто уже и не вспомнит как именно была создана та или иная фотография или фильм.

Сейчас мы общаемся со старыми фотографиями (которые, конечно же, очень сильно не идеальны), а в будущем "семейный архив" будет* состоять из фотографий с наложенными фильтрами.

Я на эту ситуацию смотрю как историк, а не как кинозритель.

Ну а как кинозритель, я в большом восторге. :)

- как показывает практика, утверждение о том, что наши электронные фотоальбомы будут сущестовать через 10-20 лет является излишне смелым и оптимистичным :(

Но никто же не печалиться, что в портртной живописи куча искажений фантазий и так далее.

Полагаю, что по этому поводу много кто печалится :)

Увы кроме голографии (за вычетом цвета) точное запечателние всех деталей оптического мира не возможно.

Да, но ровно до того момента, пока эту голографию не прогонят через нейросетевой реставратор голограмм :)

Поэтому, как говорится — на чем обучили, то и получили.

По теме вашего недовольства коверканьем истории, мне нечего сказать, это личное дело вкуса в какой форме потреблять контент.

По фактической части: вы используете легко доступные инструменты, не требующие возни. И делаете выводы о текущих возможностях по технологиям трёхлетней давности.

Вот мой аргумент. Ч/б это исходный кадр, цветной это вытащенная картинка. (цвет черновой, смотрите только на разницу в четкости).

Полный кадр

Главный посыл автора, как я понимаю, не в том, что улучшайзинг плохой и не нужен. А в том, что результаты улучшайзинга могут заменить оригиналы.

И каким бы не был хорошим улучшайзинг исходную информацию он может только терять. В случае утраты оригиналов новым, боле улучшенным улучшайзерам будет просто не с чем работать.

не знаю

но индустрия звукозаписи, увы, знает примеры

Так ведь нет никаких архивов, точнее, их не будет тогда и в той области, когда и где они понадобятся. Об этом автор в 0 главе сказал прямым текстом.

Почему вдруг могут смешаться true-архивные копии и производные медиа? Архивы, архивами, а производный контент отдельно.

Вы удивитесь, но "true-архивные копии" существуют в исчезающе малом количестве и расчитывать на них не стоит.

У музейщиков просто в книге написано кто и когда передал в музей ту или иную железку или документ.

А в госархивах рядом с официальной отчётностью лежит дневник директора.

Архивы, архивами, а производный контент отдельно.

А семейные архивы и мемуары это "архивы" или "производный контент"?

1) Пожар на складе матриц для изготовления винила — матрицы утеряны, самих мастер-лент не сохранилось увы.

2) Объединение студий звукозаписи, переезд, раздолбайство. Как результат — утеряны мастеры и матрицы. Иногда эти утери всплывают на распродажах вида «купил складскую ячейку, а там оборудование и прочее от студии, которой уже 40 лет не существует»

3) Кража, пиратское издание, после которого те, кто украл исходные матрицы их уничтожают, чтобы уже никто не переиздал

4) Пункт 2, но с изменениями, переезд, раздолбайство, ленты и матрицы хранятся в таких условиях, что приходят в полную негодность к дальнейшему использованию.

5) Новые технологии, переписываем с аналога на цифру (актуально для такого процесса в 80х годах), цифровые копии храним на ленте в фиг знает каких условиях. Аналоговые записи естественно после копирования уничтожены.

Во всех этих случаях true-архивные копии уже не существуют, максимум того, что может студия — сделать производные медиа.

И вообще, архивы сдаются в утиль, гниют и горят. :(

https://ru.wikipedia.org/wiki/%D0%9F%D0%BE%D0%B6%D0%B0%D1%80_%D0%B2_%D0%B1%D0%B8%D0%B1%D0%BB%D0%B8%D0%BE%D1%82%D0%B5%D0%BA%D0%B5_%D0%98%D0%9D%D0%98%D0%9E%D0%9D_%D0%A0%D0%90%D0%9D

https://www.nytimes.com/2019/06/11/magazine/universal-fire-master-recordings.html

Например мы подаем на вход размытое фото машины, программа распознает модель, в базе данных находит

Это совсем другой процесс, не имеющий никакого отношения к обсуждаемому "мы обучили нейросеть на ведре картошки и теперь она красит все автомобили в цвет грязи".

В ваших рассуждениях есть два слабых места:

1) наличие в базе чертежей

2) вера в то, что в процессе производства, или нелегкой жизни образец не был без всякой исполнительной документации доработан напильником.

Именно, "реалистично синтезировала", а не показала реальность. И до тех пор, пока результат работы нейросети используется исключительно как иллюстрация, без цели делать по ней далеко идущие выводы — всё замечательно. Если дорисованную нейросетью картинку пытаются использовать как источник фактов — могут быть проблемы.

Ну и абстрактному вопросу абстрактный ответ: зависит от целей, которые преследует наблюдатель. Если нейросеть, утрирую, вмятины и потёртости которые были в оригинале уберёт, а наблюдателю наличие или отсутствие этих вмятин необходимо для каких-то выводов и действий — да, таки искажение.

Никто же не говорит, что нейросетки зло, что мутная старая картинка всегда лучше чёткой и т.п. Но тут вопрос совсем не во вкусе, а в том, что есть факты, а есть дорисованная картинка. Есть "потребление" контента, а есть "анализ" контента. И если для первой задачи сеточки почти определённо благо, для второго — не всё так однозначно. И автор про это очень метко напомнил.

Политика здесь для примера, а так потенциальные недоразумения могут быть любого характера. Хоть медицинского, хоть детективного, хоть личного.

Но. Так как пока работа со смысловым контекстом ни черта не развита, нейросети дорисовывают только усредненные типичные признаки. Дорисовывание какой-то непонятной хрени обычно является проблемой для разработчика, а не классной фичей.

Дорисовывание какой-то непонятной хрени обычно является проблемой для разработчика, а не классной фичей.

В первую очередь, это проблема для будущих потребителей.

Морда в фаре в глаза вообще не бросается и её можно сразу не заметить.

Удалённая штуковина рядом с фонтаном — из той же оперы.

А через 50 лет, по этим фотографиям могут начать реставрировать реальные фонтаны и автомобили. Может даже раньше.

А что доказывает ваш «аргумент»?

Что людям связанным с историческими (и не только) исследованиями нужно понимать с чем именно они имеют дело.

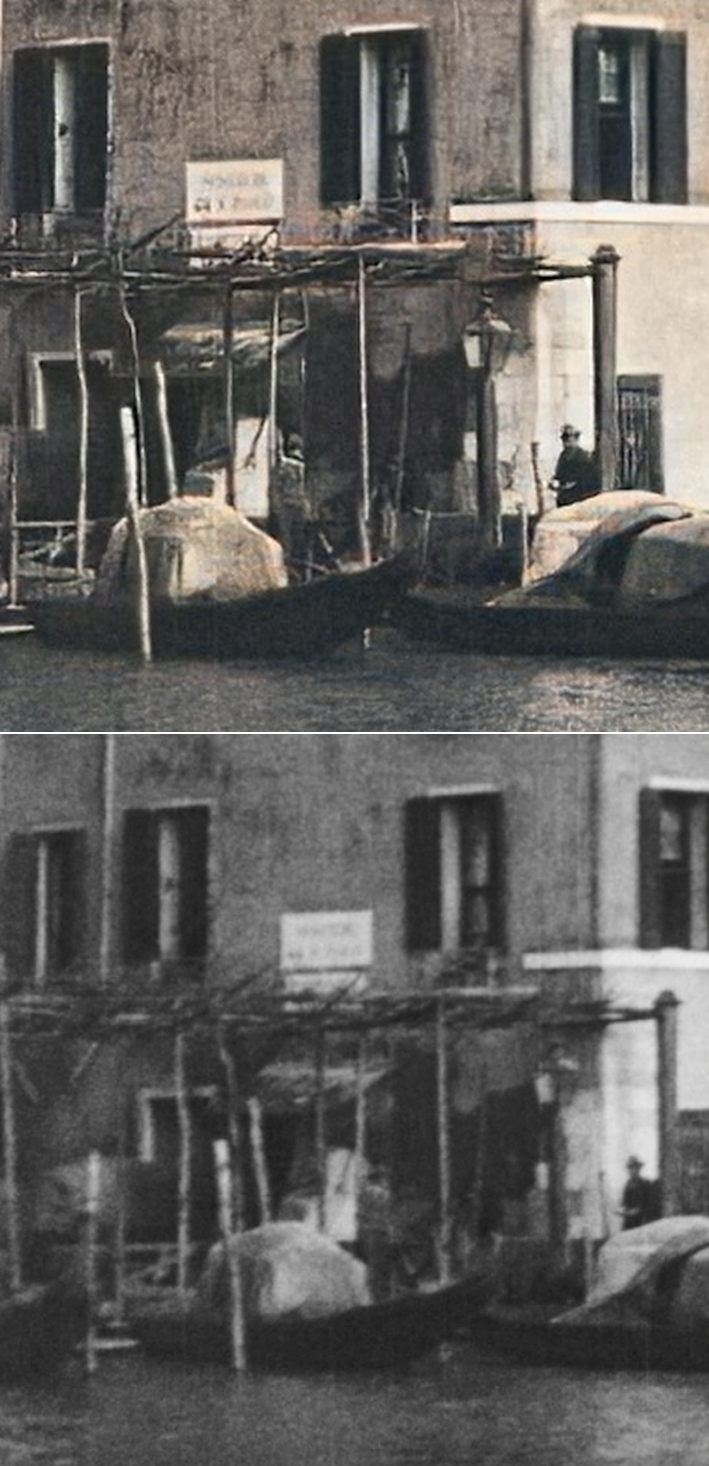

Мужчина на берегу. На «реставрации» — это кряжистый мужик, похожий на лопатобородого и в головном уборе, смахивающем на кепку с жестким козырьком. Этакий «кулак» из советских фильмов. Лицом почти к нам. В оригинале — это средней комплекции мужчина одетый «цивильно»-по-европейски, в пальто и шляпу. Глядит на лодку.

Человек на лодке. На «реставрации» — это юноша в пилотке, повернутый к нам затылком, судя по напряженной позе, всматривается, не спрятался ли кто-то за той белой штукой под навесом. В оригинале — скорее сухощавый старик, в шляпе, спокойно смотрящий на мужчину на берегу.

Разница в направлении взглядов до реставрации и после — пи/2 для одного и пи/4 для другого, в сумме почти полный угол.

Так в чем тут «улучшение»?

(Страшно представить, если такой улучшатель будет встроен прямо в камеру, как добавка к «цифровому увеличению», и кто-то использует такую картинку в криминалистической, скажем, экспертизе.)

Страшно представить, если такой улучшатель будет встроен прямо в камеру, как добавка к «цифровому увеличению»

Это в каком-то видео?

Можно ссылочку?

Спасибо

mobile-review.com/articles/2020/birulki-579.shtml

В середине статьи блок про камеру Galaxy S20 Ultra.

Кроп в комментариях выложили

Полный снимок:

mobile-review.com/articles/2020/image/birulki-579/photo/zoom/low/photo09.jpg

Ссылка на полноразмерную фотку — mobile-review.com/articles/2020/image/birulki-579/photo/zoom/photo09.jpg

По теме вашего недовольства коверканьем истории, мне нечего сказать, это личное дело вкуса в какой форме потреблять контент.

У меня нет недовольства.

У меня печаль и обеспокоенность.

А вот последний пример, с видео, некорректный. Почитайте, что такое «motion blur» и «правило 180 градусов». Не ставится задача сделать промежуточный кадр максимально чётким, просто смаз на видео должен выглядеть наиболее естественно для глаза. Именно этого и добились разработчики DAIN.

Не ставится задача сделать промежуточный кадр максимально чётким, просто смаз на видео должен выглядеть наиболее естественно для глаза.

Именно об этом и речь.

С помощью нейросетей делают видео которое будет легко восприниматься в виде видео.

Но раньше, это был просто набор фотографий, которые можно было рассматривать по отдельности.

А теперь это именно видео, и каждый отдельный кадр перестаёт быть самостоятельным документом.

А для меня проблема именно в этом — в процессе улучшения потребительских характеристики фото или видео, происходит искажение исторического источника.

Поэтому, надо крепче держаться за бэкапы и понимать, что "улучшенная" фотография это всего лишь копия созданная для решения какой-то текущей задачи.

Оригинала она всё равно не заменит

Интересный вопрос.

По идее, дырки от пуль не всегда можно будет отличить от повреждения поверхности фотографии.

А если фото совсем мелкое, то алгоритм запросто может разгладить, сочтя за незначительные отклонения.

Я делал тесты на фотографиях мотоциклов из того же зала. Уменьшал картинку, а потом "улучшал". После улучшения разглаживало даже то, что на уменьшенной картинке было различимо.

Было различимо — это когда нейросеть в вашей голове понимает, что вот эти пиксели — это решетка радиатора, а вот эти — дырки от пуль.

Вполне естественно что современные нейронки не настолько хороши, чтобы увидеть на изображении больше деталей чем может увидеть мозг.

Да и задача у них совсем другая — сделать изображение более «приятным», а никак не «восстановить то, что не может увидеть человек»

Было различимо — это когда нейросеть в вашей голове понимает, что вот эти пиксели — это решетка радиатора, а вот эти — дырки от пуль.

Конечно, я врое бы даже пару раз в тексте написал (если не удалилось при правках) что нейросеть и человек работают по сходным принципам

Да и задача у них совсем другая — сделать изображение более «приятным», а никак не «восстановить то, что не может увидеть человек»

Да, и они в своём праве.

Краткий пересказ статьи. "Пытаюсь забить шуруп молотком. Видимо с молотком дом не построить..."

НС один из инструментов, который может помочь в принятии решении. Что мешает использовать использовать несколько?

Если задача ответственная и потери ошибки велики, можно просто предоставить на верификацию человеком.

Пытаюсь забить шуруп молотком. Видимо с молотком дом не построить...

Я этот момент отдельно оговорил в тексте, что я понимаю что делаю.

Но многие не понимают, их много и они активно пользуются указанными в тексте сервисами не по назначению.

На них льётся мощный поток хайпа от маркетологов нейросеточных стартапов и слепо-восторженных технофанатиков типа тех, которые понабежали здесь в комментариях, даже не удосужившись прочесть статью глазами.

Т.е. чисто гипотетически мы имеем в распоряжении отретушированную веками наскальную живопись и должны быть осторожны в попытках дальнейшего "восстановления" оной нейросетями?

Если разрешение фотографии хорошее, а хроматическая коррекция объектива плохая — можно попробовать восстановить цвет из картины аберраций.

За счёт придумывания нейросетью деталей фото выглядело натурально.

Так что если пользоваться по назначению, то почему бы и нет.

Так что если пользоваться по назначению, то почему бы и нет.

Тут как и во всех прочих случаях

"Нейросеть сделала очень правдоподобную картинку" это одновременно и плюс и минус, в зависимости от ситуации.

Плюсы — понятны и неоспоримы.

Большие риски в виде каких-нибудь подделок — так же понятны.

Но есть риски связанные с массовым использованием не по назначению, без осознания проблемы и с последующим замещением "оригинальных изображений" на "улучшенные копии".

Это неизбежный процесс, но если его осознавать, то можно попытаться снизить риски для самого себя.

Проблема, о которой пойдёт речь, возникает из-за того, как именно работают реальные историки и нейросети.

Нет. Проблема возникает из-за того, как именно работают реальные историки. Приписывать сюда нейросети — это обвинение скамейки в том что ты об неё споткнулся и упал.

Хотя, есть способ доступный всем людям, независимо от профессии — перестать называть процесс создания легкоусвояемого медийного контента словами «восстановление» и «реставрация», чтобы не создавать у непосвящённых ложного впечатления о сути этого процесса и получаемого в результате продукта.

Хотя я безусловно поддерживаю правильное использование слов, однако как именно подобный способ поможет историкам решить проблему — непонятно. Может, следует просто рассказать историкам как работают нейросети?

Энциклопедический словарь Брокгауза и Ефрона: Том XXVIА, стр. 624

Опубликовано в ТЫСЯЧА ВОСЕМЬСОТ ДЕВЯНОСТО ДЕВЯТОМ году.

Как видим, эта проблема известна не первое тысячелетие и была актуальна уже во времена появления оригинального фильма «Прибытие поезда».

Из существования определения слова "ретушь" в словаре от некоего года никоим образом не следует существование, известность и актуальность описанной проблемы. Для подобного утверждения нужны другие аргументы.

Приписывать сюда нейросети — это обвинение скамейки в том что ты об неё споткнулся и упал.

Ух, я куда-то вписал обвинения в адрес нейросетей?

Дайте конкретную цитату — обязательно поправлю.

Ух, я куда-то вписал обвинения в адрес нейросетей?

В моём комментарии нет утверждения о том, что в статье обвиняются нейросети; это вы себе вообразили.

Я так понимаю, Вы текст вообще не читали :)

Из того факта, что я в контексте «Предложенное вами решение неработоспособно, вот пример работоспособного решения» повторил утверждение, использованное вами в статье, нельзя с гарантией утверждать что я читал либо не читал статью. Вероятность случайно повторить утверждение из статьи не читая её гораздо ниже, чем вероятность повторить утверждение из статьи, которая была недавно прочитана — потому что случайное совпадение мыслей двух людей маловероятно.

повторил утверждение, использованное вами в статье, нельзя с гарантией утверждать что я читал либо не читал статью

Вы не повторили моего утверждения, Вы задали вопрос.

А то самое моё утверждение является на него ответом.

Вероятность случайно повторить утверждение из статьи не читая её гораздо ниже, чем вероятность повторить утверждение из статьи, которая была недавно прочитана

То что Ваш вопрос совпал с одним и утверждений в тексте, это не случайность и не совпадение.

Я просто учёл наиболее очевидные вопросы и возражения и заранее дал на них ответы.

Ага, я просчитал Вас комментарий задолго до того как Вы его написали. :)

Может, следует просто рассказать историкам как работают нейросети?

Я так понимаю, Вы текст вообще не читали :)

42

Угадайте, какие три числа я сложил, чтобы получить 42

ps:

на самом деле складывал я пять чисел, а если ещё точнее — интегрировал функцию, но нужный ответ состоит из трёх

Нельзя, и в этом вся суть проблемы.

Суть процесса обесцвечивания описывается формулой:

к1КРАСНЫЙ+к2ЗЕЛЁНЫЙ+к3*СИНИЙ=СЕРЫЙ

Это как посчитать сумму всех цифр в трёхзначном числе — эту операцию невозможно обратить.

В принципе невозможно.

к1КРАСНЫЙ+к2ЗЕЛЁНЫЙ+к3*СИНИЙ=СЕРЫЙ

Все ещё хуже: в конкретной точке искомый СЕРЫЙ это интеграл от произведения функции чувствительности пленки на спектральный состав света, взятый по интервалу с заходом в ик и уф.

Плюс ещё особенности работы оптической системы, если смотреть не на 'пиксели', а на кадр в целом

Все ещё хуже

Это да, но всё равно основной процесс сведётся именно к множителям по каждому цвету (как то я криво формулу записал), а уже множители будут включать в себя много чего.

Есть очень небольшой шанс зацепиться при обработке кино. Можно попробовать проследить за неизлучающим объектом, пока он перемещается из зоны с одним освещением, в другую зону. Например, с прямого солнечного света в тень здания, или сравнить тень человека с остальной поверхностью предмета, на который падает эта тень. Основываясь на предположении о спектральных составах этих источников света и методах, упомянутых здесь коллегами, можно составить систему уравнений, множество решений которой ограничит область поиска исходного цвета. Но трудности начинаются сразу с деталей источников света.

(на будущее.)

Идея про то, что видео это набор фотографий верна для киноплёнки и не совсем верна для многих современных видеокодеков — там есть полные опорные кадры, но между ними кадры с частичным перерисовыванием картинки.

То что их можно разложить в отдельные фотографии, не означает что они являются таковыми внутри видеофайла.

Да, всё верно — это морда обезьяны.

А, по-моему, это не обезьяна, а человеческое лицо. Наверняка ту нейросеть обучали на множестве фотографий людей (а не обезьян), вот ей и «мерещатся» лица. Интересно, что человеческому мозгу свойственно совершать схожие ошибки, поскольку он хорошо приспособлен к тому, чтобы распознавать лица. Наверняка многие замечали в хаотичных узорах (на линолеуме, обоях и т.п.) изображения, похожие на лица. Похожее явление — антропоморфизм: человек «видит» человеческие качества у животных, явлений природы и прочих объектов, которые, в действительности, их не имеют.

Это один из главных моментов данной темы — разным людям нужно разное.

Но многие этот факт игнорируют.

petapixel.com/2020/08/17/gigapixel-ai-accidentally-added-ryan-goslings-face-to-this-photo

Обсуждение на ХН:

news.ycombinator.com/item?id=24196650

Спасибо, очень интересно и наглядно.

Заголовок отдельно прекрасен )

просто не могу не оставить это здесь

Когда я слышу слова «нейросеть восстановила», я лезу проверять бэкапы