Comments 757

Почему не могут, если делают?В приведенных вами тестах не участвуют десктопные x86.

ни у интела, ни у амд, не будет больших проблем использовать его в своих x86-совместимых процессорах

И да, и нет. И да, потому что концептуально можно положить ARM ядро и назвать этот процессор Intel Core или там Ryzen. Более того, AMD в начале 10х экспериментировала с выпуском ARM процессоров.

С другой стороны, разработка ядер CPU и процессоров на их базе — основной бизнес Intel и бОльшая часть бизнеса AMD. Если они начнут эти ядра у кого-то покупать (а Apple, на сколько я понимаю, все таки разрабатывает сама и ядра, и процессор, а не покупает их на стороне, как делают многие производители мобильных чипов), то это будет означать фактическую смерть обоих компаний, так как основную ценность и главную компетенцию они потеряют.

Кроме этого, если у них нет туза в рукаве на базе «таких хороших ядер» на ARM (а у Intel его судя по всему нет) — разрабатывать его с ноля займет годы. И проблемы с техпроцессом. Кроме того, в случае с Intel и их собственными уникальными фабриками, придется еще и перепроектировать все это под собственно их фабрики, что тоже займет долгое время, т.к. нельзя просто взять условную пачку документаций и спецификаций с фабрики TSMC и начать делать то же самое на фабрике от Intel или от Samsung. Даже на одном и том же условном «10нм» техпроцессе техпроцесс у каждого производителя отличается и чип надо под него перепроектировать.

В общем — все на самом деле очень непросто.

повернуть в сторону и разработать нечто похожее для них большой проблемой не будет.

Будет. Intel вот пыталась пару лет назад и в модемы, и в процессоры мобильные. Слилась, не смогла.

Если бы могли — сделали бы. Intel/AMD и любая другая подобная компания каждый год миллиарды долларов в RnD закапывают. Пока в ARM и подобные показатели производительности у них даже близко не получилось.

А на счет покупать — во-первых могут и не продать, во-вторых — все, что доступно к свободной покупке не блещет показателями. Так то да, вон готовые Cortex ядра продаются.

Весь грешный инжиниринг делается купленными на стороне руками и головами.

Вот только процессоры они разрабатывают in house. Даже компанию для этого купили в начале нулевых, специализирующуюся на разработке процессоров. Там не только маркетологи работают все таки, с времен создания первого айфона поменялось достаточно много. Ну и контрактников конечно никто не отменял, они есть у любой крупной компани.

Кто мешает тому же интелу, если прям так сильно пахнет жаренным, точно так же перекупить тех, что умеет делать лучшие ядра?

А нет их доступных к покупке. А если представить такую ситуацию, что есть абстрактная команда, которая офигенно пилит новые ядра на ARM и она вдруг осталась без контрактов и решила продаться, то Intel может оказаться бедновата для получения над ней контроля. У Apple денег даже в кэше 75 миллиардов против 16 у Intel.

это ARM, а не что-то неведомо-новое, т.е. его архитектура прекрасно известна и доступна всем желающим.

Так и x86_64 всем известен и доступен всем желающим по лицензии. Проблем нет. Вот только архитектура != ядро или процессор под нее. Разница примерно как между алфавитом определенного языка и его грамматикой и написанной с помощью этого алфавита на этом языке книгой.

Знание языка необходимо, но совершенно недостаточно для того, чтобы написать книгу. Ну то есть что-то конечно можно изобразить, но до бестселлера этому произведению будет далековато.

Будет. Intel вот пыталась пару лет назад и в модемы, и в процессоры мобильные. Слилась, не смогла.

Не "пару лет", а побольше. И ушла не потому, что "не смогла", а потому, что эти рынки — низкомаржинальные. Затрат много, конкуренция высокая, прибыли (относительно десктопных и серверных процессоров) — низкие.

Реальная очевидная проблема у Интела сейчас одна — они впервые за очень долгое время потеряли лидерство в техпроцессе, и никак не могут его наладить. На этом фоне рассуждать о том, что у Эппла или АМД архитектура лучше, а Интел якобы "не смог" — занятие так себе.

Интеловская 64 разрядная технология (IA-64) вообще не взлетела.

Впрочем, ограниченную распространённость получила и до сих пор используется, но как раз наступает EOL.

Если уж HP и Intel, потратив огромное количество ресурсов на разработку технологии, решили от неё отказаться, значит есть другие варианты.

Я думаю, что выбор x86 <-> ARM был в другом — Apple уже давненько сама разрабатывает процессоры для своих телефонов и увидела, что это у неё успешно получается + провела моделирование быстродействия для десктопных задач. Результаты её устроили и поэтому она решила перевести на них Маки.

Купить болванку. А сделать ее быстрой, если дело только в наборе команд, должны суметь, иначе грош им цена.

Так дело же совершенно НЕ в наборе команд. Дело в том, как реализовано выполнение этих команд.

Вот про это я и говорю.

Поглощения компаний ради готовых компетенций — нормальный путь развития крупного бизнеса. В этом нет ничего удивительного. Посмотрите сколько компаний поглатила та же Intel — newsroom.intel.com/tag/acquisition/#gs.l7gq90

Большая часть из них была про микроэлектронику. Получается там тоже одни маркетологи сидят?

Apple даже светоча своего Джобса умудрилась просрать в свое время, опыт есть.

Причем тут конкретный человек и компания?

Конечно, но раз apple не стала пилить свой x86, а пошла на кардинальную смену набора команд и выбрала arm, значит архитектура решает, не так ли?

Нет, не так. Apple была в соучеридителях ARM, много лет разрабатывала мобильные процессоры на этой архитектуре и теперь пришла в другой сегмент. Они же не вчера этим занялись. Как раз те самые компетенции. Всмысле они научились очень хорошо работать в рамках этой архитектуры. Вероятно даже лучше, чем AMD/Intel в рамках своей х86 и лучше, чем Qualcomm в рамках той же ARM. Если бы дело было только в архитектуре, Qualcomm, Samsung, Huawei и еще пара десятков компаний помельче давно бы пришели и нагнули парочку Intel/AMD.

Известно, что лицензией на архитектуру Arm64, на которой построены все современные ARM процессоры (то есть возможность заглянуть вообще везде и во все детали и крутить ее как надо, а не купить готовые ядра в формате black box), есть как минимум у Apple, Samsung, Applied Micro, Broadcomm, AMD(да да), Cavium, Huawei, Nvidia.

У Intel есть лицензия на Arm32, есть ли она на Arm64 неизвестно, по крайней мере в открытых источниках я не нашел, но у них в линейке есть процессор Intel Movidius, а он на Arm64. Возможно ядра лицензированы, подробностей о нем мало. Процессор этой линейки ставился в Intel Neural Compute Stick.

Вообще, ARM как системе команд уже хрен знает сколько лет. Весь мобильный рынок на ней. Кое-кто экспериментирует с разработкой процессоров для более серьезных задач (Amazon, к примеру). Но это все совершенно не значит что интел или кто-то еще может пойти, взять эту систему команд и что-то внятное на ней изобразить. Архитектура достаточно удачная сама по себе, да. Но есть и другие, и даже открытые (OpenRISC). Что-то никому это особо не помогает делать какие-то особо быстрые и эффективные процессоры. Равно как и многолетняя разработка процессоров на ARM не помогает той же Qualcomm сделать такой-же быстрый и эффективный процессор, как M1.

Так дело же совершенно НЕ в наборе команд. Дело в том, как реализовано выполнение этих команд.

Дело в наборе команд. RISC при прочих равных всегда уделает CISC. Собственно и у Интела CISC уже давно аппаратно эмулируется поверх RISC‐ядра. Убираем слой эмуляции — получаем более холодные камни с большими возможностями для оптимиации компилятором.

youtu.be/1kQUXpZpLXI?t=782

Убираем слой эмуляции — получаем более холодные камни с большими возможностями для оптимиации компилятором.

Мсье теоретик? Где все эти "более холодные камни с большими возможностями по оптимизации" были, пока Интел по техпроцессам не отставал? :) x86 за время своего существования повыбивал самые разные "более эффективные" RISC-процессоры из разных ниш, так что объективная реальность несколько отличается от "сделаем без эмуляции — получим преимущество".

Где все эти «более холодные камни с большими возможностями по оптимизации» были, пока Интел по техпроцессам не отставал?

В телефонах и планшетах.

x86 за время своего существования повыбивал самые разные «более эффективные» RISC-процессоры из разных ниш

При этом с худшим техпроцессом чисто из‐за преимуществ x86 архитектуры, наверное. (нет)

В телефонах и планшетах.

Вы ещё стиральные машины забыли. Ещё раз — рынок мобильных процессоров, в отличие от рынка настольных и особенно серверных, низкомаржинальный. Есть некоторая разница между "проиграли технологически" и "не захотели сильно вкладываться из-за низкой нормы прибыли".

При этом с худшим техпроцессом чисто из‐за преимуществ x86 архитектуры, наверное.

Разумеется, нет, потому что внешняя архитектура команд с определенного момента вообще перестала играть существенную роль в производительности. О чем я вам и говорю.

Не настолько. В CISC-декодер сложнее вносить изменения и он имеет больше пространства для нежелательных сайд-эффектов в силу сложности, но транзисторного бюджета и TDP он в товарных количествах не потребляет.

А вот то, что у него L1I 192kB и L1D 128kB и 12 MB shared L2 — вносит огромный вклад в производительность.

Тот же АЛУ может какое‐то время не использоваться, и статическая память кеша не потребляет, пока в ней не меняются данные, а вот декодер должен отработать на каждом такте.

Но даже если модифицировать схему: убираем CISC‐декодер → снижаем сложность и избавляемся от сайд‐эффектов → упрощаем внесение изменений → делаем более производительный процессор.

Всё равно получается, что и таким образом архитектура набора команд играет существенную роль в производительности.

У них, как бы, довольно долго вполне получалось.

Тот же Haswell/Broadwell были крайне удачны.

Да и нельзя забывать, что M1 пока не поступили в массово в реальную эксплуатацию, и еще не понятно, какие у них по факту узкие места. Тот же RPi 4 на десктопе — не очень торт, а потребляет наравне с Atom.

Убрать декодер нельзя, ибо совместимость. Можно только добавить еще регистров и завести отдельный набор команд — но это новшество не будет востебовано еще долго и пока оно не будет востребовано, его обслуживание будет стоит транзисторного бюджета и tdp (даже если его немного совсем) которые можно было бы расходовать иначе.

Например, на раширение L1.

Так что это очень сложный вопрос даже на взгляд непрофессионала.

Убрать декодер нельзя, ибо совместимость

Это я про концептуальное «убрать», то есть перейти на RISC ISA, чтобы CISC‐декодер не требовался. Понятно, что в самих x86‐процессорах декодер не убрать, а вот перейти на ARM можно, который сразу RISC.

И это было бы замечательно, потому что можно делать очень быстрые n‐МОП транзисторы на германии, но из‐за высокого потребления в статике сверхобольшие интегральные схемы n‐МОП увы невозможны.

Декодер работает на каждом такте, если процессор что‐то делает. А вот АЛУ уже нужны не всегда. Регистры тоже простаивают, пока в них лежат промежуточные данные вычеслений. Кеш ещё реже работает.

Поэтому и тротлинг работает — уменьшение частоты существенно снижает энергопотребление.

А я говорю, что играет. Убираем CISC‐декодер, работающий на каждом такте → снижаем TDP

А вы не говорите, а маленький расчет сделайте — какую часть чипа занимает декодер и сколько потребляет энергии в сравнении с остальным. Вот тогда будет что-то похожее на предметный разговор.

Но тогда почему у Intel не получилось в мобильные процессоры

Я вам уже ответил, но вы проигнорировали — причины маркетинговые, а не технические. С технической точки зрения там всё прекрасно получалось.

А вы не говорите, а маленький расчет сделайте — какую часть чипа занимает декодер и сколько потребляет энергии в сравнении с остальным. Вот тогда будет что-то похожее на предметный разговор.

При этом вы почему‐то такой маленький расчёт не сделали, который показал бы, что не влияет.

Так что может влияет, а может и не влияет, но есть ещё одна гипотеза, по которой RISC позволяет сделать более производительные процессоры: habr.com/ru/post/528658/?reply_to=22333998#comment_22333328

Сколько вклад каждой из них посчитать, конечно, возможно, но у меня ресурсов для этого, к сожалению, недостаточно.

Конечно, но раз apple не стала пилить свой x86, а пошла на кардинальную смену набора команд и выбрала arm, значит архитектура решает, не так ли?

Apple делает ARM процессоры уже 17-лет, причем последние 10 лет на собственной микроархитектуре, так что ни на какую смену набора команд она не шла.

Весь грешный инжиниринг делается купленными на стороне руками и головами.

Простите, сотрудникам интел не платят, или что означает «купленными на стороне»?

повернуть в сторону и разработать нечто похожее для них большой проблемой не будетВы вообще представляете себе цикл разработки процессора с нуля? Вы понимаете, что от первых идей до релиза проходит 3-5 лет (в свете чего, кстати, хардварные косяки иногда исправляются через 1-2 поколения, а не сразу, ибо банально нельзя «повернуть в сторону» посреди процесса, не потеряв миллионы долларов, если не десятки-сотни оных), которые конкуренты на жопе не сидят, а тоже что-то делают? И это на знакомой архитектуре.

Нельзя просто взять и пересадить инженеров-хардварщиков, которые собаку съели на интеловском х86, на АРМ, и сказать «сделайте конфетку». Это так не работает. Это другие компетенции. Из тракториста не получится сразу сделать гонщика Формулы-1.

ARM продает много всего. В том числе лицензии на набор команд и на архитектуру.

Тае вот. Ни Apple ни Qualcomm не покупали ядра. Они купили лицензии на архитектуру и разработали свои ядра.

Использование RISC архитектуры набора команд процессора раздувает код программы до совершенно избыточных размеров

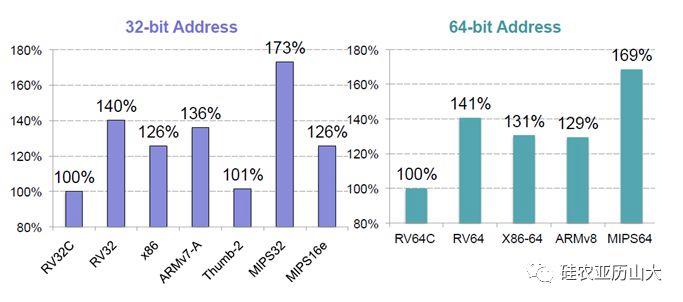

Это больше похоже на VLIW… где-то попадалась сравнительная диаграмма плотности кода: она для ARM/x86_64/RV64 примерно одинакова, но RISC, как правило, имеет компактную версию.

Ссылка на статью

Если, конечно, не брать за образец MIPS или Freescale.

Собственно, непонятно как

Использование RISC архитектуры набора команд процессора раздувает код программы до совершенно избыточных размеров

Армы да, имея RISC-основу они взяли некоторые черты CISC.

На практике в RISC реализуются разные сокращенные подмножества, а для CISC такое невозможно, так как он уже состоит из подмножеств. Причем, оптимальность изначальной нарезки бит в инструкциях определяет сложность дальнейшего расширения. А самое главное, нельзя просто взять и выкинуть некоторое подмножество (на самом деле иногда можно, но чтобы выкинуть что-то бесполезное сначала надо ввести что-то бесполезное, как было с командами мониторинга в Pentium, емнип, эволюционировавшими в префиксы AMD64).

Отчего CISC обречен пухнуть, а RISC — быть гибким и уменьшаться.

сокращенные подмножества

Thumb, Thumb-2, RV64C, RV32C — вот это вот все.

почему выкинуть что-либо из CISC проблемнее чем из RISC

Ну вот смотрите: пилите вы свой идеальный передовой 16-битный процессор.

- У вас есть некоторое количество базовых операций которые вам надо выполнять наиболее часть: загрузка, сложение/вычитание, сдвиг, условный переход, ротация возврат. Вы хотите сделать их как можно короче, одно байтовыми.

Кроме этого, у вас еще может быть i8/i16 операнд и косвенная адресация — все это должно влезть в инструкцию. А еще надо адресовать регистровый файл. Допустим, он будет состоять из 32 байтовых GPR, которые объединяются попарно для 16-битных операций.

CISC:

Адресуя 32 регистра пятью битами, вы можете реализовать всего 2³=8 команд. Сложение, вычитание и сдвиг вправо и влево в знаковом и беззнаковом вариантах, ротация и условный переход — это уже 10!

Ок, режем количество GPR до 8, освободим аж два бита для команд, потребуется всего три бита для кодирования регистра и можно сделать больше коротких однобайтовых инструкций. Теперь вы реализовали загрузки и сохранение и у вас есть даже задел на будущее в виде еще 16 (для простоты счета) свободных опкодов — круто!

При этом короткие инструкции всегда неявно подразумевают работу с R0/R1R0.

RISC:

Ок, используем два байта для команды. Адресуем Op0 и Op1 младшими 10 бит для команд, требующих два операнда, для остальных используем Op1 как расширение опкода. Immed-операнд размещается следом за командой, расширеный до 16 бит.

16-тибитные команды состоят из флага в 15 бите, 7 бит опкода (даже больше, чем у 8-мибитных) и двух нибблов для Op0 и Op1.

Результат:

Пока что системы команд обоих архитектур достаточно близки, и декодируются простой таблицей.

Какие смешные эти RISC, они на любую инструкцию тратят на байт, а то и три, больше! А ведь его из памяти прочитать еще надо!

- Добавляем косвенный переход и индексную адресацию.

CISC

Оукей, у нас в условном переходе используется 4 бита под номер флажка, двойных регистров у нас всего 4 — это всего 8 опкодов.

Черт, нам бы еще пару индексных регистров, а то ворочать массивы будет очень тормозно! Добавим еще опкоды… для всех операций, только теперь индексные… Нам нехватает опкодов — вводим двухбайтовую кодировку, пусть все опкоды 0xCx будут префиксами!

RISC

Вводит два новых опкода в 16-тибитную часть.

Результат

CISC: ладно, я все равно местами быстрее.

- Добавляется FPU…

CISC

Так, ребята помните, какая жопа у нас случилась в прошлый раз? Давайте теперь не будем маяться дурью и сразу сделаем команды для FPU — префиксными.

RISC

Добавляет еще несколько опкодов.

Результат

На 8-мибитной шине CISC показывает небольшое преимущество, на 16-бит они идут ноздря в ноздрю.

- Итак, парни, у нас новинка: 32 бита! У нас много работы!

CISC

Окей. Парни, во-первых, давайте расширимся: стыдно в наше-то время со всего 8 GPR ходить, сделаем их 16.

Кроме того, у нас уже большой, сложный декодер, давайте не изобретать велосипед, а просто его переиспользуем. Отпрефиксим новые инструкции, у нас еще этих префиксов полдюжины! За работу!

RISC

Невозмутимо расширяет командное слово до 32 бит. И все GPR. Теперь можно адресовать одновременно 3 GPR одной командой.

Добавляет условное исполнение.

Результаты:

CISC страдает на ветвлениях и переходах, но не подает виду.

- Гипервизор …

- SIMD

- Виртуализация…

- Еще SIMD

- 64-бит

ну, вы же уже догадались, да?

Вообще по этому поводу у меня была мысль ввести механизм эпох. По сути — что бы в специальном регистре можно было задавать разные режимы декодирования команд, и программы могли использовать такую упаковку, которая им по душе. Правда, не уверен, что зависимость декодирования от данных в регистрах может быть реализована без больших накладных расходов. Да и вообще, даже на x86 упереться во фронтенд могут не только лишь все, так что скорее всего оно того просто не стоит.

Это истории реальных RISC и CISC )

Во-первых, все свойственное CISC многообразие опкодов, структуры инструкций и регистров, оно не от хорошей жизни, а от кроилова, приводящего к сиюминутной выгоде — и попадалову в будущем.

Во-вторых, по мере развития CISC обратно эволюционирует в сторону RISC (увеличивает регистровый файл, лишает особенные регистры особенного статуса — что дополнительно приводит к росту сложности системы команд) а RISC приобретает некоторые черты CISC (у некоторых GPR появляются выделеные роли).

В результате через лет 20÷30 CISC вынужден поддерживать огромным, трудноотлаживаемым и труднооптимизируемым декодером все исторические наслоения наборов команд развесистого префиксного дерева, с самого своего появления — одна и та же ассемблерная мнемоника может быть реализована несколькими ассемблерными кодами, а современные компьютеры до сих пор стартуют в 16-битном режиме; в то время как RISC имеет простые и быстрые табличные декодеры для каждого поддерживаемого набора команд и волен не тащить с собой все легаси.

Идеальная система команд CISC, к которой стремится, например, x86 — это RISC, но отягощенный x86-legacy.

Опять же, Вы привязываетесь к конкретным архитектурам, а я оцениваю CISC и RISC концептуально. Это не CISC, а x86 тащит легаси из неоптимально спроектированных команд, CISC сам по себе к этому не обязывает. И это в x86 нет упрощенных наборов команд с разными декодерами — в самой концепции CISC я не вижу на это никаких ограничений.

В общем, у Вас аргументация вида «когда-то придумали передавать данные по сети в виде цифрового сигнала, потом появился веб, и вот, спустя 30 лет, он как-то не очень подходит для современных задач — значит надо было передавать сигнал в аналоговом виде».

истории x86 и ARM … они кстати обе CISC

ARM (Advanced RISC Machine)

У них есть одно важное отличие: они выжили и распространились настолько, что стали конкурировать друг с другом.

И это отлично иллюстрирует разницу Complex и Reduced систем: они обе начиная с одного и того же ставят разные цели — и получают разные результаты.

Это не CISC, а x86 тащит легаси из неоптимально спроектированных команд

Они были крайне оптимально спроектированы и востребованы на момент разработки.

Сейчас те их фичи не востребованы, но продолжают висеть в legacy.

CISC сам по себе к этому не обязывает

Вы знаете, техника развивается и требования меняются.

В истории x86 было три поворотных момента, когда можно было все переиграть и сделать как у взрослых.

- в 386, который ввел 32-бит, но использовался как быстрый 286

- в 486, который получил RISC-ядро (наверное, от идеальности CISC, да? нельзя быть слишком идеальным)

- в AMD64

Один раз — случайность, два раза — совпадение, три — уже система.

И этот выбор делали не комментаторы на хабре отнюдь

Просто вещи так устроены: либо вы делаете complex, но извлекаете прибыль сейчас, чтобы расплачиваться в будущем, либо KISS.

Если вы продумываете march&ISA на два шага вперед — вы делаете RISC, если вы извлекаете профит сейчас — у вас получится CISC. That's all.

В общем, у Вас аргументация вида

а вот это уже лежит на тонкой грани между wishful thinking и подменой…

ARM (Advanced RISC Machine)Можно называть утку медведем, но она все равно будет выглядеть как утка и крякать как утка.

они выжили и распространилисьТолько вот x86 распространился на персоналках и серверах, что повлекло за собой проблему обратной совместимости, а ARM — на single-program девайсах и мобилках с JVM. Но проблемы с легаси на x86 разумеется исключительно из-за CISC.

получил RISC-ядро (наверное, от идеальности CISC, да? нельзя быть слишком идеальным)Уже тоже не разграничиваете RISC-ядро и RISC-процессор? Я нигде не говорил, что нужно исполнять CISC-команды в том виде в каком они есть.

Если вы продумываете march&ISA на два шага вперед — вы делаете RISC, если вы извлекаете профит сейчас — у вас получится CISCА если CISC с разными декодерами и возможностью переключаться от одного к другому?

а вот это уже лежит на тонкой грани между wishful thinking и подменой…А натягивание ARM-совы на RISC-глобус — это другое.

Можно называть утку медведем, но она все равно будет выглядеть как утка и крякать как утка

Знаете

А натягивание ARM-совы на RISC-глобус — это другое

А AVR — тоже не RISC?

Вы заставляете этого цитировать самого себя:

по мере развития CISC обратно эволюционирует в сторону RISC (увеличивает регистровый файл, лишает особенные регистры особенного статуса — что дополнительно приводит к росту сложности системы команд) а RISC приобретает некоторые черты CISC (у некоторых GPR появляются выделеные роли)

Кроме того, вам всегда, независимо от микроархитектуры, необходимо иметь выделенный command counter, flags и stack pointer (если стек используется), data stack pointer (если есть стек данных, отдельный от стека адресов возврата); если используется сегментная модель памяти или изоляция приложений — то еще и регистры сегментов.

Кроме того, операции с неявным аккумулятором, который еще и может быть физически отдельным, для ускорения таких операций, подсоединенным прямо к ALU, но явно адресуемым как r0, добавляет, как это ни удивительно, производительности.

Разумеется, эти технические ньюансы накладывают свой отпечаток на ISA.

Поэтому какого-то там идеализированного полностью неспециалированного RISC в природе быть не может, так же как и идеально специализированного CISC.

Принципиальные отличия RISC — это большой регистровый файл равноправных регистров и простая регулярная система команд vs малое количество разнородных GPR и специальные регистры со специальными командами для обращения к ним.

И это различие — не догма, не божественное повеление, а условность, показавшаяся достаточно очевидной во время определения терминов.

А если CISC с разными декодерами и возможностью переключаться от одного к другому?

У вас уже — God Object, в виде декодера. Хотите добавить еще парочку?

Потому что первое C в CISC — это Complex. Сложно. Понимаете?

Complete оно станет тогда и только тогда, когда его перестанут производить.

Потому что тогда его перестанут дополнять.

Потому что полное не дополняется.

Что проще: реализовать пару альтернативных простых таблиц трансляции, или несколько God Objects?

UPD:

Уже тоже не разграничиваете RISC-ядро и RISC-процессор?

А вы можете точно сказать, где лежит граница между RISC-ядром с CISC-декодером и RISC-процессором с CISC-сабсетом, если кроме CISC-декодера у них все остальное — одинаковое?

И это различие — не догма, не божественное повеление, а условность, показавшаяся достаточно очевидной во время определения терминов.А, ну я оперирую терминами как они есть, а Вы подстраиваете их под ARM. Ладно, пусть будет так.

Что проще: реализовать пару альтернативных простых таблиц трансляции, или несколько God Objects?Тут расчет на то, что от того, что God Object'ов несколько, они будут не такие уж и God.

А вы можете точно сказать, где лежит граница между RISC-ядром с CISC-декодером и RISC-процессором с CISC-сабсетом, если кроме CISC-декодера у них все остальное — одинаковое?В моем понимании терминологии RISC-процессор с CISC-дополнениями — это уже CISC. То есть был такой строгий и тривиальный RISC, добавили сложные команды, добавили поддержку укороченных команд — все, стал CISC. Но, возможно, это действительно неправильное понимание. Хотя подстраивать термины под хотелки ARM — тоже выглядит странно.

Вы подстраиваете их под ARM. Ладно, пусть будет так.

Этот говорил об абстрактном RISC. RISCV тут подойдет ничуть не хуже, но у него история короче, и он не настолько известен.

Тут расчет на то, что от того, что God Object'ов несколько, они будут не такие уж и God.

А зачем вообще делать God Object?

То есть был такой строгий и тривиальный RISC, добавили сложные команды, добавили поддержку укороченных команд — все, стал CISC.

Эмм… то есть, даже наивная реализация гарвардской архитектуры и банальная оптимизация r0 — уже делает CISC?

Ну и ну и ну.

Это ж тогда Power и VLIW тогда — тоже CISC. И введение не то что FPU/SIMD, а даже стека и инструкции call/ret тоже делает CISC %)

Хотя подстраивать термины под хотелки ARM — тоже выглядит странно

Поэтому надо подогнать все под x86.

Разве наши слоны уже летают?

А зачем вообще делать God Object?Я могу сказать для чего делать переменную длину команд — для оптимизации размера кода программы. А проблему того, что со временем одни команды становятся менее используемыми, а другие наоборот — решать введением нескольких типов декодеров, между которыми можно переключаться.

И введение не то что FPU/SIMD, а даже стека и инструкции call/ret тоже делает CISC %)Э нет. FPU/SIMD/стек — имеют поддержку на уровне исполнительных блоков (ну или дополнительных кешей в случае со стеком). И команды эти нужны для того, что бы задействовать эти самые аппаратные возможности. А вот введение команд типа SSE-шных dpps и crc32, которые просто транслируются в набор элементарных математических инструкций — это уже CISC-элементы.

Поэтому надо подогнать все под x86.Почему подгонять под x86? Он-то очевидно CISC по самое не хочу.

для оптимизации размера кода программы

Что очень актуально, пока вы работаете с 8-бит внешней шиной, менее актуально с 16 и совершенно неактуально с 32+.

И заодно приводит к проблемам при появлении кэша.

И требует сложного декодера.

Но позволяет урвать немного производительности, пока вы на 8/16-битной внешней шине.

И делается гораздо эффективнее RISC с сохранением всех их преимуществ.

(ну или дополнительных кешей в случае со стеком)

Нет, к кешам стэк не имеет никакого отношения.

А вот введение команд типа SSE-шных dpps и crc32

А что именно делает объединение часто используемых вместе команд в одну — CISC?

То так, если что, все математические операции эмулируются сложением, инверсией и сдвигом. Запретить RISC'ам MUL и FPU? Они же просто объединение длинной последовательности простых команд — CISC-элемент!

Почему подгонять под x86?

Вы последовательно подгоняете идеологическую (не доказательную) базу под "если в RISC есть хоть какие-то оптимизации, то это CISC". x86 просто характерный успешный представитель, ну и от RISC/CISC уже в глазах рябит. Можете читать как CISC.

Что очень актуально, пока вы работаете с 8-бит внешней шиной, менее актуально с 16 и совершенно неактуально с 32+.Ну не знаю, мы точно не упремся в подгрузку кода с RAM на какой-нибудь простыне из арифметических инструкций на 0.1-0.2 такта каждая?

Нет, к кешам стэк не имеет никакого отношения.Спутал с call/ret — в Intel'ах есть кеш точек возврата, который с ними взаимодействует.

То так, если что, все математические операции эмулируются сложением, инверсией и сдвигом. Запретить RISC'ам MUL и FPU?Срочно запретить, если нет аппаратных умножителей чисел с плавающей точкой. Если есть — так же срочно разрешить.

Вы последовательно подгоняете идеологическую (не доказательную) базу под «если в RISC есть хоть какие-то оптимизации, то это CISC».Тут смотря какие оптимизации. Если что-то вроде «ой а тут надо сделать набор инструкций уменьшенного размера» или «ну нарушим разок load/store принцип, и что с того» — то да, подгоняю.

Ну не знаю, мы точно не упремся в подгрузку кода с RAM на какой-нибудь простыне из арифметических инструкций на 0.1-0.2 такта каждая?

Как насчет 15-байтных инструкций? Это почти 4 двойных слова, или почти 8 инструкций RV64C.

Про подгрузку данных в какой-нибудь AVX можно вообще не вспоминать, там объемы будут еще больше.

в Intel'ах есть кеш точек возврата, который с ними взаимодействует

Это старая оптимизация гарвардских RISC — локальный буфер на несколько точек возврата. Подразумевается, что несколько возвратов подряд невозможны, поэтому небольшой буфер может хранить несколько последних точек, и отлаженно выпихивать их в стек/подтягивать обратно.

Срочно запретить, если нет аппаратных умножителей чисел с плавающей точкой. Если есть — так же срочно разрешить.

Ладно, а с перехватом не реализованных в данной версии инструкций и их эмуляцией что делать? А с микрокодом?

Если что-то вроде «ой а тут надо сделать набор инструкций уменьшенного размера»

Осталось убедить полмиллиона квалифицированных инжеренеров, разрабатывающих процессорные архитектуры, компиляторы и прочее, что ваше мнение единственно верное, ага.

UPD:

Кстати, а чем альтернативный набор команд отличается от команд FPU/SIMD, которые вы так любезно разрешили? В железе он реализован.

Фиксированная длина машинных инструкций (например, 32 бита) и простой формат команды.Ну то есть с момента появления Thumb ARM RISC'ом не является.

Специализированные команды для операций с памятью — чтения или записи. Операции вида Read-Modify-Write отсутствуют.В целом ARM соблюдает это правило, но он ведь еще и atomic операции поддерживает, так?

Большое количество регистров общего назначения (32 и более)Тут да, хотя по этому правилу многие архитектуры подойдут.

По четвертому ничего сказать не могу, пятое не очень понял — оно предполагает, что, к примеру, TLB должна быть реализована полностью софтварно? Вот это правило уже кандидат на объявление устаревшим.

Вот так, в моем понимании, и получается, что ARM — не RISC. Что я упускаю?

Ну то есть с момента появления Thumb ARM RISC'ом не является.

С момента появления RV32C и RV64C — RISCV перестал быть RISC?

Сокращенные наборы команд исполняются в отдельном режиме процессора, работающем с одной, отличной от дефолтной, таблицей трансляции команд. Команды из дефолтной таблицы вызывают UB.

В рамках текущего набора команд все струтура командного слова продолжает оставаться регулярной.

Разницы между поведением процессора даже меньше, чем между привилегированным и непривилегированным режимами. Просто другой Instruction Set.

Если про распихивание immed в случайные дырки, то это в Thumb артефакт, решающийся банальным ремультиплексированием, возможно хардварным.

но он ведь еще и atomic операции поддерживает, так?

Некоторые вещи обязаны быть atomic.

Скажем, рестартовать загрузку/выгрузку может быть непросто, если речь идет о прерывании, а не об исключении обработки виртуальной памяти.

По четвертому ничего сказать не могу

пятое не очень понял

Это пример для DEC Alpha.

Там еще везде используются "характерно", "типично", и т.д.

То есть, ни один из этих признаков не является обязательным.

TLB должна быть реализована полностью софтварно?

Это ж аппаратный буфер. Вот обработчик исключений может быть реализован не закрытым микрокодом, а открытым кодом, использующим дефолтный набор команд.

Англовики немного более точна:

- Uniform instruction format, using single word with the opcode in the same bit positions for simpler decoding

Регулярный формат машинного слова - All general purpose registers can be used equally as source/destination in all instructions, simplifying compiler design (floating point registers are often kept separate)

Все GPR доступны любой команде. - Simple addressing modes with complex addressing performed by instruction sequences

Тут не совсем понятно, насколько простые режимы имеются ввиду. Возможно base + disp, без множителя и без двойной косвенной адресации.

В любом случае, это проблема компилятора, программист даже на C не будет видеть тонкостей адресации. - Few data types in hardware (no byte string or BCD, for example)

AAA, AAD, AAM, REPSB и прочий зверинец.

Как-то так.

Ну так, об этом каджит сказал уже пару раз, только другими словами )

UPD:

Не совсем.

С тех пор и от строго одинакового размера инструкций отказались

В спецификации Thumb — одинаковые регулярные инструкции. Ткните пальцем, где там по вашему что-то не так.

от "радикально" упрощённого набора инструкций

Это OISC, вырожденный случай.

So much reducing)

А теперь читаем определение в вики. Ссылки были выше.

В остальном да, вы примерно правы.

Использование RISC архитектуры набора команд процессора раздувает код программы до совершенно избыточных размеров

Не до совершенно избыточных, а лишь незначительно, и не раздувает, а сокращает.

на самом деле же уже все процы в том числе и x86 построены на архитектуре RISK как тот же ARM, только с эммуляцией CISC, получается x86 уже постепенно уходит в прошлое и в некотором будущем случится окончательный переход на ARM так как apple толкает индустрию к этому. После того как основные крупные разработчики окончательно уйдут на ARM и останется что-то узко специализированное.

Знаю что с тех пор intel «закрутили гайки» и запретили тем же E3-12** v5 работать на desktop чипсетах, однако выпускают и «игровые» материнки под эти процессоры, так что собирают и современные системы на новых Xeon.

для игр NUMA это смертный приговор.

А речь про «двуголовые» материнки и не идет, обычные, с одним сокетом, так что как минимум чисто экономически определенный смысл есть.

Но речь естественно была о архитектуре.

Если тема интересует то могу посоветовать изучить тему на overclockers и пару ютуб каналов 1, 2

С другой стороны, если уделить достаточно времени на исследование рынка этих материнских плат, то можно найти что-то подходящее и для топовых камней. Лично у меня 2680v2 на 10 ядер и 20 потоков уже два с половиной года работает на китайской материнской плате без каких-либо нареканий. Но это, конечно, не гарантирует, что у вас через год работы из области VRM не повалит дым. Впрочем, никто не застрахован, косяки вполне бывают и у классических десктопных производителей.

Нужно понимать, что любая затея с китайскими xeon-ами — это про соотношение цена\производительность, не цена\качество. Чем-то в итоге придется жертвовать.

Лично я планирую собирать переносную машинку для хранения и конвертации видео, и вполне буду снова рассматривать китайские железки для этих целей.

e5 2678 v3Надеюсь, что мой ответ не посчитают рекламой сайта. Посмотрите вот здесь информацию. Там по материнским платам есть рекомендации, плюс особенности работы.

От себя могу добавить, что фотошоп любит быстрые ядра, а не большое их количество, поэтому в зависимости от искушенности пользователя могут быть проблемы. И играться с вольтажом вроде как нельзя на китайских платах, ни в какую сторону.

Стоит ли оно того, если какой-нибудь ryzen 7 2700 при 16 потоках будет быстрее вашего процессора, при этом доступен локально и с гарантией? Да, оно слегка дороже будет — но при этом экономичнее и тише в повседневной жизни.

И да, для моих задач высокая производительность весьма желательна.

По задачам, требующим высокой производительности — лично мне выгоднее переносить их в облака. Это снижает как саму стоимость вычислений так и временные затраты на администрирование.

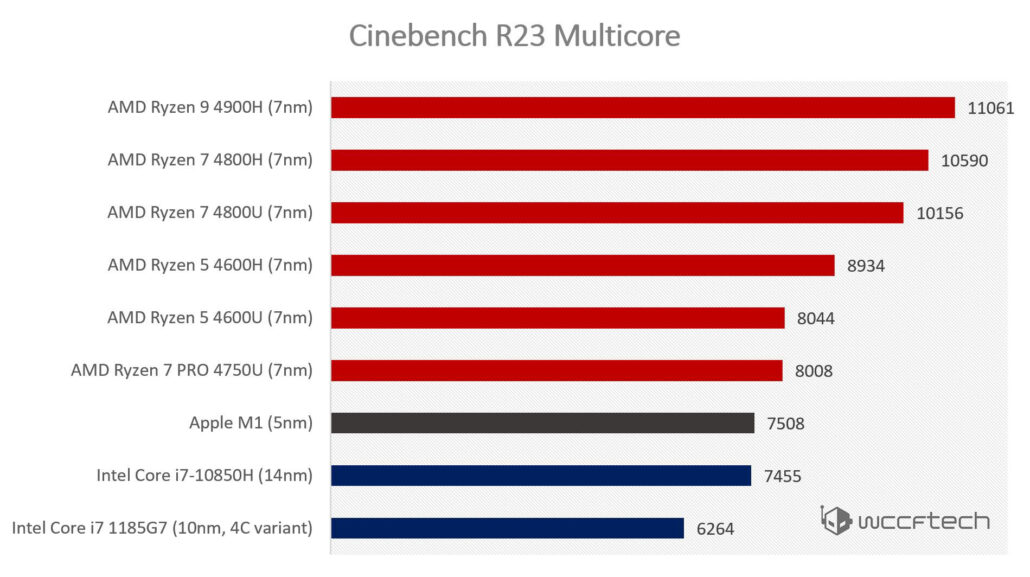

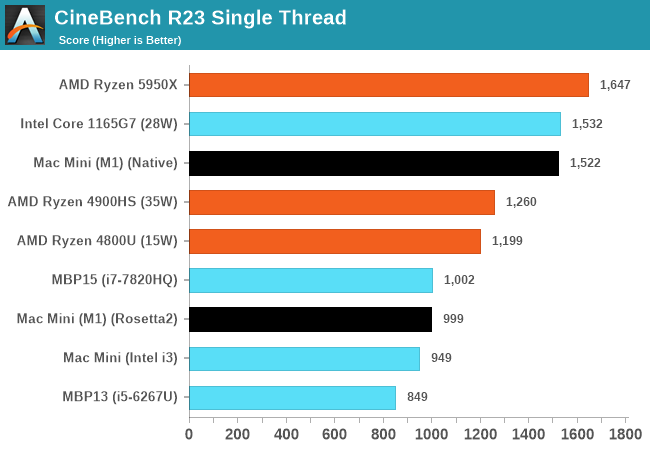

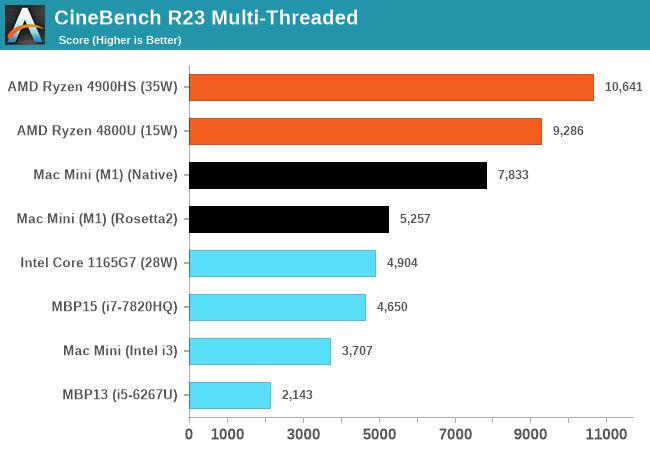

Тут я согласен, но речь вроде бы о том, насколько процессор от Apple подобрался близко к продукции Intel и AMD.

Я бы сказал что их «слабенький» начальный процессор на 15W очень так не слабо подобрался к продукции двух гигантов. И это начальный процессор, а обещали еще полноценный процессор, для тех, кому не только видео в браузере смотреть с ультрабука. Если они запихнут туда 12-16 своих мощных ядер вместо 4 в текущем чипе, и сделают нормальное количество оперативки, вот это будет мощно.

Невозможно сделать процессор одновременно и с высокой производительностью, и с малым энергопотреблением. Физику не обманешь.А теперь факты: процессор сравнительно легко наращивается вширь, до тех пор пока он не начинает превосходить свой тепловой бюджет. Процессор также можно разгонять, хоть это и менее эффективно (дает нелинейный прирост). Т.е. имея быстрое и энергоэффективное ядро мы точно можем сделать быстрый процессор с множеством таких ядер. Собственно, в M1 как раз то самое быстрое энергоэффективное ядро.

Скорее для простоя в минимальном состоянии, когда смысла нет крутить биги.ну это mac mini же, то, что в нём крутятся big ядра потребляя на целых пару ватт больше, это вообще не проблема для стационарного компьютера.

И это (xbox) уже в продаже и дешевле есть, жаль не в качестве ПК — я б взял.еще раз — консоли продаются в минус и окупаются за счет подписок и наценок, суммарная стоимость для среднего пользователя получается порядка $1000, если не больше. По крайней мере сравнимый ПК вы даже за $1000 не соберете

Ничего не замечаете? Да, энергопотребление скорей всего там выше, но и производительность видика — не сравнима.в M1 графика 2.6 tflops с 8 ядрами, в коробке — 12 tflops на 52 ядрах.

Если б можно было легко продать производителям распайку дорогих чипов у проца с заметным удорожанием всех чипов — они б так и сделалиКстати вот здесь видно как они интересно спаковали чип. Кажется, проблем расширения памяти быть не должно.

Увеличьте количество бигядер в 2 раза и нарастите видик до уровня амд.а еще уберите little ядра за ненадобностью в стационарных решениях

Почти в два раза кристалл больше размером, больше брака, больше цены.я же не утверждаю что им не придется перенимать чиплетный подход

процессор сравнительно легко наращивается вширь? Ну да, только вот у интелов не получаетсякажется, intel сейчас уперся в TDP а не в число ядер.

у амд за несколько заходов получилосьну да, в 2017, в сотрудничестве с той же foundry что и apple…

а еще уберите little ядра за ненадобностью в стационарных решениях

Intel с вами не согласен, потому свои будущие десктопные процы пилит с little ядрами.

То есть Эпл старались, старались, а вы лучше их понимаете как надо делать?little ядра нужны для экономии энергии, которая в стационарных решениях не является камнем преткновения.

да нет, именно что в ядра на своих 10нм процах. 4/8 могут, а выше — нетдаже если они уперлись в ядра, TDP до 265 Вт для десктопного проца это тоже многовато, не находите?

У вас отлично получается наглядно показывать почему макмини это прорыв )))а я и не говорил что mini — прорыв, лишь M1 как таковой, да и то больше в мобильном сегменте. Более того, это был бы скорее плохой продукт, если бы мобильный чип apple не оказался настолько хорошим (в некоторых типовых задачах), чтобы комплектовать им стационарник. А утверждаю я лишь то, что обладая технологией производства M1 apple вполне способны представить достойные решения и в других сегментах.

А дальше вы цепляетесь абсолютно за всё за что можете. И mini с консолью по цене сравнили, и air с игровым ноутом, и до числа транзисторов докопались, и до нейронки, и терафлопсов в GPU мало, и тип памяти не тот — абсолютно до всего. Только конечно же опустили пару совершенно незначительных нюансов — десятикратная разница в энергопотреблении, фиктивность цены, разный сегмент у продуктов… но это же не важно, верно? Как там быстро коробка видосы монтирует да код компилит?

Ещё раз, вы лучше эпла значете зачем они это делают?а что, надо быть гением чтобы понять что они просто запихали в мак мини такой же процессор как и в ноутбуки? Я думал это можно предположить из названия проца.

Но тдп и скорость отличные.не такие уж и отличные, но это и не принципиально. Мы, кажется, по второму кругу идем. Если бы у intel не было проблем с yield'ом на 10nm, мы бы эти 10nm во всей линейке процов увидели еще несколько лет назад.

О, вы ж сверху утверждали, что в декстопах это не важно?так вас это и применимо к ноутбуку не смутило. Там, правда, «всего» в 5 раз.

Я уже вам отвечал, что если будет windows mode (да, даже если это будет через подписку на игры за 15$) — то коробка станет вообще отличным решением и заодно узнаем, как быстро она код компилит и видосы монтируетчтобы ввести windows mode майкам придется поменять модель распространения xbox.

а что, надо быть гением чтобы понять что они просто запихали в мак мини такой же процессор как и в ноутбуки? Я думал это можно предположить из названия проца.

Что здесь удивительного? Производить несколько разных процессоров дорого.

Это вы про то, что максимальную энергоэффективность форсят? Например, если для показа видео хватит и 4 малых ядер, на кой чёрт задействовать большие?на кой черт вообще делать мелкие ядра в стационарниках? Там не стоит задача вычислить с минимальным энергопотреблением, там надо лишь уложиться в лимит.

Эм, их 10 нм процы вполне себе на ядро уделывали же свои декстопные, о чем вы? с ноутным тдп.1185G7 разгоняется примерно до 50 Вт.

правда не в пять… а в 10, у M1 TDP 10-18W, а у коробки 200 Вт.

в режиме 120 Гц при 4Kэто маркетинговое название режима «нет ограничения в 60 FPS», на самом деле даже 60 не гарантируется. Спору нет, это всё еще круто, в сравнении с mini, я и не говорю и не говорил что mini так может. Я утверждал лишь что apple могли бы сделать сопоставимый продукт, а сравнивать коробку с air'ом, а потом с mini начали вы.

Или вы про то, что в процессорах тдп проца в ноуте в 20 ватт в 5 раз ниже тдп 25 или даже 45 ватт?18 Вт против 45 в 4800H плюс 50 в 1650. Заметьте: я предлагал сравнивать с ноутами на мобильном 4800U, на 4800H с dgpu переключились вы.

Как вы там сказали? «Ворота едут»?

То есть ещё раз, ваш аргумент: у чипа м1 тдп 10 ватт, а у всего иксбокса 165 в реальном тесте, значит в 10 раз?вот только M1 это SoC с CPU, GPU и RAM — основными потребителями электроэнергии в коробке.

Люди играли в игру и получили потребление. Тут вы начинаете рассказывать, что они играют не правильно и вообще не могли таких цифр получить?я лишь для вашей просвещенности привел факт, подтверждающий, что консоли в очередной раз делают ровно то же самое, что они делают уже десятилетиями — выдают примерно половину заявленной производительности.

Не могли. При цене в 3 коробки продать получится только вам.это ваши личные спекуляции, основанные на едва релевантных данных. Которые вы пытаетесь выдать за факты, попутно подменяя все понятия, которые вам неудобны в рамках спора.

и я вам даже ответил почему, только вы раз за разом отказываетесь читать что вам пишут, что ж с этим поделать.

— давайте сравнивать устройства на мобильных чипах между собой

— я же написал что я буду сравнивать что хочу и с чем хочу, но вы же не читаете что вам пишут! А коробка дешевле air'а, ололо

Как с вами аргументированно спорить вообще?

Так «номинальная мощность» нового макмини 150 заявлена. Эпл врут?потому что она у intel версии 150 Вт

в два раза дороже коробки.

А какой смысл сравнивать стоимость с устройством, себестоимости стоимость которого даже не известна, но по косвенным данным (правда кое что есть только по соньке, которая +- на том же железе) она практически равна продажной стоимости, а по совокупным расходам консоли вообще в минус продаются (что подтверждает анализ отчетов от той же Sony для предыдущих консолей)?

Цель продажи консоли — заработать не на ней, а на комиссиях с подписок и продажи игр. Если бы у Apple была такая же структура дохода, то макбук бы стоил 299 долларов, но заставлял вас покупать приложения на каждый чих. И браузер был бы платным, да. И софт сторонний тоже запускать было бы нельзя вот прям совсем. В общем — экономика несколько по другому работает.

суммарная стоимость для среднего пользователя получается порядка $1000, если не больше

Это для кого они столько стоят?

Да, доступ к памяти соседнего чипа будет медленнее, но вряд ли медленнее, чем доступ к отдельной оперативке v Intel‐маках.

Но это просто мысли в слух

Это ужасное решение. Либо надо как у амд — отдельный котроллер общения с оперативкой для двух чиплетов. Но это сожрёт процентов 10 производительности. В вашем варианте сожрутся все 30.

30 % по сравнению с чем и почему?

Но даже если так, то это ж всё равно позволит наращивать производительность, при этом выпуская один и тот же чип, а не делая совершенно другой продукт.

Надо лицензировать IF?

Понятно, что здесь есть накладные издержки по сравнению с просто большим по площади аналогичным кристаллом. Но выпуск кристалла с большей площадью тоже связан с издержками и проблемами.

А тут её как без изменения чипов добавить?

А если переделывать чип, то тогда да, что-то подобное придумывать придётся для увеличения всего.

И тут же дело в том, что всё необходимое вполне может быть уже добавлено в чип.

Тут будет что-то типа NUMA, то есть обращение к соседней памяти через другой процессор.

Вот именно это я и имел в виду. Вот прям неизбежно будет медленнее, чем обращение просто к чипу памяти на таком же расстоянии? Или от реализации зависит?

И я не думаю, что у M1 вообще есть шина для межпроцессорного взаимодействия.

Может нет, а может и есть. Документации к M1 у нас то нет.

Такая шина это куча неиспользуемых на текущих устройствах контактов, потраченный впустую транзисторный бюджет. Никто такое не делает «про запас».

А куча разных процессоров — это потраченный долларовый бюджет. Когда бракованное ядро отключается, то тоже вроде как впустую потраченный транзисторный бюджет выходит, но так дешевле получается.

А он и не нужен. M1 для того, чтобы объединить платформы и запустить процесс переползания на новую платформу пользователей буков и десктопов.

Как появится интерес менее массовых пользователей — так будет повод выкатить новое.

Где кодирование видео? Производительность на ватт в различных задачах? Тепловыделение реальное? Да хотя бы игры в конце концов?

Это и понятно, все смартфоны сейчас ориентированы на медиа контент, и процессоры у них соответствующие. В тех же мессенджерах когда видео передаешь оно на лету конвертируется, сжимается. Запись 4к 60FPS HDR тоже надо кодировать на лету чтобы место сэкономить

По данным Wiki (Целочисленных регистров/FP регистров):

x86-64 — 16/16

ARM 64-bit — 31/32

Кстате именно по этому эмуляция x86 на ARM проходит более хорошо (быстро) нежели наоборот.

Переименование регистров не позволяет адресовать больше регистров.

FPU/MMX/SSE/AVX ∉ GPR

Все это есть и у ARM.

Тогда для чего же нужно переименование, если не для этого?) Оно как раз заменяет архитектурные регистры на микроархитектурные и позволяет адресовать больше, чем доступно архитектурных. На линейный участок это не повлияет, а вот на независимые вычисления — ещё как.

Разница как между линейной ram и переключаемыми банками.

У вас на современной архитектуре всегда есть регистровый файл. Часть его доступна явно: это архитектурные регистры. Их количество влияет на возможности оптимизации использования памяти компилятором, некоторые вычисления при малом количестве доступных регистров или недостаточной их разрядности потребуют сохранения промежуточных результатов в память. И сохранить, в общем случае, GPR в SIMD вы не можете, потому что SIMD делает свои вычисления, возможно даже завязанные на другой поток — а это penalty.

Теневые регистры — остаток регистрового файла — менее быстры в обращении, потому как их использование предполагает смену маппинга и, фактически, работает через аппаратный хук.

То есть, при недостатке регистров в общем случае вы должны еще где-то найти регистр или два свободных, чтобы загрузить в них адрес ячейки памяти для сохранения временного значения, что лишает компилятор уже трех регистров в сумме.

И даже если запушить регистр в стек (лучше чтобы при этом был отдельный data-stack, но это еще минус один GPR), это обращение к медленной внешней памяти, которое, в общем случае, непредсказуемо по penalty.

С большим количеством адресуемых регистров эта проблема возникает существенно реже.

А теперь если еще вспомнить, что половина x86-GPR сохраняет специализацию (у ARM их, на самом деле, примерно столько же) то увеличение адресуемой части в два раза дает компилятору втрое больше регистров для маневра.

или, спецверсию кодека, типа для аниме :)

NVEnc заметно уступает в качестве кодирования обычным процамКак и любой потребительский аппаратный кодировщик. Чуда не случится. Потребительские кодировщики жертвуют точностью в пользу скорости. Есть серьезные аппаратные кодировщики, которые не уступают программным в качестве, а даже их превосходят (см. Main report (Objective comparison, FullHD videos) summary), но я в живую не видел ни одного, и даже не знаю, где и за какие деньги их покупают.

Чудеса.

Выиграет от этого покупатель в любом случае.

Покупатель в любом случае проиграет.

И с системой команд x86 надо все же что-то делать, ведь даже Интель внутри уже давно не x86, а стоимость хардварной поддержки старины все выше и выше, и вот сейчас яблочные демонстрируют, насколько. Если очень надо запускать винду — уже имеет смысл делать это в виртуалке под софтварным транслятором. И очень скоро так будут делать вообще все.

Беспокоиться лучше все же заранее, потому что потом будет просто поздно. Телефонный рынок в Интел упустили полностью, потому что не побеспокоились заранее.

Они ещё годами сливали на него 20-30 миллионов и продавали в убыток, пока не утомились кота за уши тянуть. Там лет шесть подряд был убыток, но они каждый год писали, что вот сегодня эффективнее на 15% и быстрее аж на 5%. Так победим!

заранили

Копьями что ли?

Скорость трасляции в общем‐то не важна, а вот скорость эмуляции ещё как. Поэтому QEMU и не годится.

Сам Windows давно портирован, собирается и выпускается под ARM.

Динамическая трансляция для x86 приложений в активной разработке и выкатывается уже в ноябре по Windows Insider:

We are excited about the momentum we are seeing from app partners embracing Windows 10 on ARM, taking advantage… of Qualcomm Snapdragon processors.… we will soon release a native Microsoft Teams client optimized for Windows 10 on ARM. We will also expand support for running x64 apps, with x64 emulation starting to roll out to the Windows Insider Program in November.

Ошибся, вот тут говорят что они берут куски кода(скорее инструкций) и компилируют их в арм х64

docs.microsoft.com/en-us/windows/uwp/porting/apps-on-arm-x86-emulation

Динамическая трансляция для x86 приложений в активной разработке и выкатывается уже в ноябре по Windows Insider:

Скорее вы имели ввиду x64, ибо эмуляция х86 работает с первого Surface Pro X (Хотя пользователи жалуются на проблемы с производительностью того же фотошопа)

Это проблемы закрытого софта. Открытый никуда не нужно портировать, он и так собирается под полдюжины архитектур.

Так если у открытого софта есть деньги на компиляцию в несколько архитектур, то у закрытого, по идее, и подавно найдутся?

Вот знает ли такое слово конечный выгодоприобретатель — тот еще вопрос…

Ну на новый мак-то вместо б/у E495 с двумя батареями по втрое меньшей цене — нашлись же.

отличаются от потребностей среднестатистического пользователя ПК

Довольно странный посыл. «Среднестатическому» пользователю ПК по сути ПК и не нужен, телефона\планшета (чаще всего iPad) хватит.

Все, что делает «среднестатистический» пользователь — браузер, социалочки, документики, игрушки казуальные — новый чип делает лучше, чем существующие. Лучше — это всмысле так же быстро или быстрее и при этом компьютер меньше просит розетку.

То есть сам по себе ПК — уже давно именно что нишевый продукт. Большинство людей пользуются другими устройствами.

Какими-то «специфичными» потребностями относительно общего рынка обладают не так много категорий пользователей — программисты, инженеры различные, ученые. Процент их от общего количества пользователей при этом ничтожен.

Просто для понимания — количество программистов в мире оценивается в менее чем в 28 миллионов на текущий момент с ростом до 30 миллионов к 25 году и до 45 миллионов к 30-му.

Количество же проданных только ноутбуков в 2019 году оценивается в 261.2 миллиона с тенденцией к падению.

Даже если представить, что ученых и инженеров, которые реально работают со специфичным софтом на ноутбуках (что совершенно нетипичный кейс, для этого есть рабочие станции), столько же, сколько и вообще всех в мире программистов (то есть 56 миллионов всего) и если представить что все эти «специфичные» люди покупают ноутбук каждый год (что конечно же не так), то все равно они будут составлять лишь 20% от ежегодных покупателей ноутбуков.

Вот только ученых (вообще всех) в мире меньше чем программистов, ученых в RnD по оценкам WorldBank вообще только полтора миллиона, так что с шансом процентик еще и поменьше будет. А если вспомнить, что ноутбук покупается обычно на 2-3 года, то процент покупателей с «особенными» запросами, которые теоретически не может реализовать маубук на arm — упадет менее чем до 7%.

Далеко не все инженеры в CADах сидят, а python и прочее популярное в научно-инженерной среде и на arm прекрасно работает.

В общем — думается вы ошибаетесь.

Потребности «среднестатического» пользователя закрываются машинками от Apple на ARM более чем, даже с избытком. По сути, именно проблемы там сейчас только с одной категорией софта — виртуализацией x86, которая нужна по сути ничтожному проценту пользователей.

Покупатель в любом случае проиграет.

Ага, бедный-несчастный, у него ноутбук начал уверенно жить под нагрузкой дольше рабочего дня, за него начали просить меньше, чем раньше, новый виток конкуренции начался, который приведет к «быстрее, выше, дешевле», а он все равно проиграет.

P.S. Кстати — Windows под Arm уже давно есть. Surface не первый год на рынке, процессоры там от Qualcomm. Главная его проблема в том, что там нет аналога Rosetta, а значит количество софта ограничено. Вот только ее аналог обещают выкатить вот вот, что очень сильно поменяет картину. Так что беспокоиться еще как стоит. Я не думаю что Qualcomm не сможет сделать процессор, по скорости равный M1, который в свою очередь даже в режиме трансляции в x86 и пенальти по производительности порядка 30% из-за этого все равно быстрее low/middle линеек мобильных процов от Intel и AMD.

Какими-то «специфичными» потребностями относительно общего рынка обладают не так много категорий пользователей — программисты, инженеры различные, ученые. Процент их от общего количества пользователей при этом ничтожен.

Этот если считать, что «особыми» потребностями обладают все пользователи из этих категорий. Большей части разработчиков для работы достаточно браузера, текстового редактора и ssh клиента.

А я ещё тогда считал, что майковцы ошиблись, надо было в своё время сделать так, чтоб их винду можно было ставить на любые андроидные девайсывся современная история microsoft состоит из ретроспективно упущенных возможностей

Неа. Там и набор инструкций другой и системный API. И вообще все другое кроме PE заголовка, наверное.

Как же? Тот же ARM, тогда, правда, он был без hf, но его наличие в современных процессорах ничем не должно помешать.

Ну я не думаю что девайсы с winCE выпускались на armv8. Конечно, в режиме aarch32 оно должно заработать, если ядро его поддерживает и будут все нужные либы для aarch32.

То есть Win32API таки зарубили? Или как еще это понимать? Ведь WinCE работал с подмножеством обычного winapi.

Мне вот что-то кажется что winapi на winCE был не подмножеством, а скорее сделан по образу и подобию. Но могу ошибаться, конечно.

В Surface Pro X совсем другие чипы от Qualcomm. У них с M1 общая только базовая система команд.

А всё остальное — другое. Прям начиная с загрузчика, NVMe контроллера совмещённого с Secure Enclave и системы управления питанием, через свой собственный GPU к уникальным сопроцессорам для ML и Image processing.

Для всего этого кто-то должен сесть и написать драйвера, и я почему-то уверен, что эппл этим заниматься не будет.

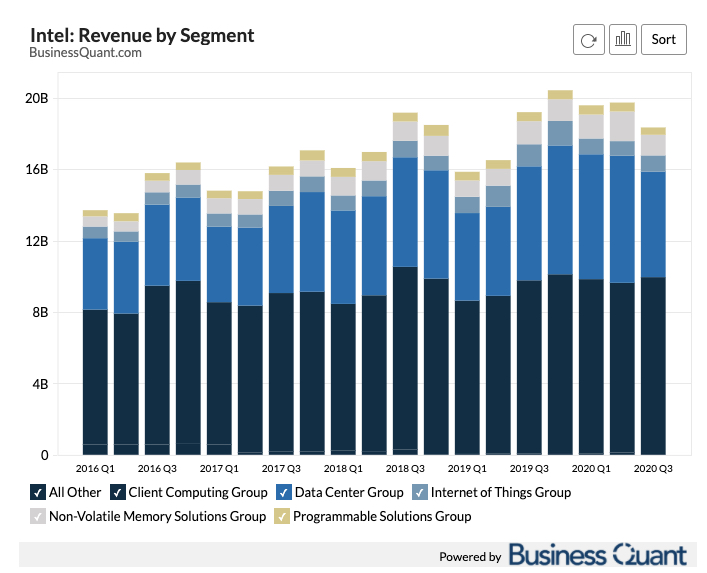

Вот распределение доли Intel/AMD.

А вот наглядное сравнение как и в серверном железе они проигрывают сражение.

Между прочим, мы сами в закупках перешли на сервера на базе AMD, потому что они производительнее и дешевле. Отказываемся от Xeon.

у Intel и AMD нет конкуренции на уровне обычной домохозяйки-школьника

Если за серверные решения я с вами согласен, то на счет школьников и домохозяек не особо.

Совсем дешевых устройств мало (пожалуй только хромбуки могут составить конкуренцию дешевым x86 ноутбукам), но вот в средней и высокой ценовой категории все сильно неоднозначно. Мало того, что весьма большая доля пользователей вообще пользуется телефоном\планшетом как основным устройством, так еще и их задачи прекрасно ложатся на ноутбук с очень долгим временем жизни, где браузер, офис и условный фотошоп прекрасно работают. И казуальные игрушки для домохозяек, и даже фортнайт для школьников.

При стоимости базового эира (которого с избытком хватит для их задач) на M1 для школьника в 900 долларов и для домохозяки в тысячу — это весьма неплохое предложение. Ноутов с таким времением жизни за эти деньги практически нет (что важно для школьника\студента), равно как и сама платформа Apple удобна для домохозяйки, если у нее уже есть iPhone (а он с большой вероятностью у нее есть). Тут еще и приложения универсальные подвезли, через полгодика на маках будет доступно все то, что доступно как минимум на iPad.

Ну то есть да, в дешевом нискомаржинальном сегменте властвует AMD/Intel, но вот в самый вкусный сегмент — middle/high зашла Apple со своим «за те же деньги, но лучше, 20 часов работы, единая подписка, привычные приложения, а еще можно в один клик фоточку перенести с айфона на комп».

Ну это при условии, что школьнику (ну, почему сразу школьнику) не нужен комп (десктоп с достаточной производительностью GPU), чтобы играть в игрушки (не проводил статистических исследований, но, кажется, большинство хотят игровые компы и играть в игрушки).

не нужен комп (десктоп с достаточной производительностью GPU), чтобы играть в игрушки

Статистика продаж игр говорит, что главная игровая платформа сейчас — мобилки, а главная игровая ниша — разнообразные мобильные

Я кстати без осуждения говорю, просто статистика.

Вот в целом данные по рынку игр:

Consoles account for 30% of the 2019 global gaming market at $45.3 billion.

PCs fall slightly behind with 24% market share or $35.3 billion.

Mobile, which we’ll discuss shortly, represents the biggest market with 46% share or $68.2 billion.3

Так что судя по всему не особо нужен, а если даже и нужен (представим, что доля у школьников между платформами такая же, как и общая, что не так, т.к. денег у них меньше, а значит покупать дорогие игровые компы, которые стоят как топовый iPhone + консолька последнего поколения на сдачу возможностей у них меньше), то только каждому четвертому.

В целом, если ты взрослый дяденька\тетенька с деньгами, или школьник с состоятельными родителями, никто не мешает тебе одновременно иметь и мак для документов, и игровой комп с 3080, и пару приставок для эксклюзивов. Вопрос то именно в приоритетах.

Сугубо по моим ощущениям и наблюдением за нынешними школьниками, игровой комп им не особо и нужен. Хитовый мультиплеер на мобилках, остальное есть на консоли. Статистика вроде +- об этом и говорит.

а зачем два компа?

"- А зачем им два телевизора?"

Задачи у них разные. У меня вот два личных компа. Жирный десктоп с 64 гб памяти, парой ТБ SSDшек, стареньким, но вполне еще бодреньким зионом и 2070 для игрушек и тяжелой работы с Linux+Windows in KVM и старенький MacBook Pro 13" 15 года, который я беру тогда, когда мне нужен терминал с браузером и я не за рабочим столом или еду куда-то. Просто разные задачи и оптимальный под них инструмент.

да нет, она про деньги обычно. Где зарабатывают больше. Ну в мобилках за счёт доения денег больше. А вот по количеству игроков речи нет

Ну тут статистика весьма мутная, я в целом согласен. Вот инфа от PC Gamers по рынку США:

If you extrapolate the computer percentage against the 67% total figure, that means roughly 35% of those in the U.S. game on PC. NPD rep Mat Piscatella says that PC gaming, for the purposes of this survey, means anything played on computers, likely including browser and social games. Still, games are games, even when you’re not tweaking settings to push your GPU to the limit.

IGN пишет несколько иначе:

1.5 billion, or 48% of global video game consumers, are PC game consumers. It's important to note, however, that «this includes some overlap with gamers that also use console systems and mobile devices.»

а главная игровая ниша — разнообразные мобильныедрочильнимногопользовательские игры вроде фортнайта и ему подобных.

Так вы уж определитесь,

Так, ну давайте пример pay2win в Fortnite, раз разницы нет)

В-баксы могут использованы для приобретения таких предметов, как экипировки, кирки, обёртки, эмоции и боевые пропуска.

Это всё косметика?

В общем, тут классическое «я Пастернака не читал, но осуждаю». Это как говорить, что Хабр – экстремистский ресурс. На вопрос, почему – привести список 100 статей с вопросом: «Они все неэкстремистские?». Вместо того, чтобы указать на конкретные признаки экстремизма в конкретной статье. И что, по абзацам их разбирать?

Так что я ничему не удивляюсь, а лишь написал о самых вероятных причинах.

Ну а во-вторых, не переживать же из-за виртуальных плюсиков :)

С налогами и другими сборами (в РФ еще курс валюты) выходит что цена базового air ~1300

Ну, если говорить и том, что происходит в РФ, калькуляция выйдет еще веселее, но давайте.

За такие деньги можно собрать хороший игровой пк или 2 неплохих ноута.

Нет и нет. 1300 долларов — это 100.000 рублей. 2 неплохихи ноута даже близко не стоят по 50к каждый.

Более того, хоть как-то стравнимая по качеству материалов и эксплуатационным характеристикам машинка от Lenovo серии Thinkpad по стоимости легко перешагивает сотку. И еще и фиг достанешь, я не так давно пробовал, как раз в РФ. Есть исключение в виде L серии, которая дешевле, но лучше никогда не сравнивать ее и макбук 1к1 на столе. Они просто из разных миров по качеству «всего». За 50к сейчас в России можно купить или кучку пластика, которая будет работать без розетки часа два и греться как утюг, или где-то за 70 «игровой» ноут от Asus или того же Lenovo в средних комплектациях в варианте «замена стационарнику». При том, что там тоже проблемы со временем жизни от батарейки, общим качеством и т.д. Они кстати все тоже не про апгрейд, а для такой машинки это важно. Можно с уверенностью сказать, что эир будет делать все то же самое, что он делает сейчас, еще года 3-4 как минимум. А вот «игровые» ноутбуки обычно за пару лет превращаются в тыкву. Хотя кому как, если для киберспортивных игрушек, то и подольше проживет, там требования обычно ниже. Если система охлождения не деградирует и оно само по себе не развалится по какой-то причине, а то есть у меня нехороший опыт с дешевыми ноутами про чисто механический износ.

А на счет хорошего игрового компа за сотку… это будет сложно. Но давайте попробуем прикинуть сколько обойдется именно системник, который потащит QHD на high/ultra хотя бы сейчас и в ближайшие пару лет без переферии вроде монитора. Про 4к за сотку можно смело забыть. Ну то есть что-то будет работать, что-то нет, но в целом целевым разрешением это назвать нельзя.

25к за Ryzen 3700x (пятой серии в продаже в РФ еще нет, но не думаю что 5600 будет стоить дешевле);

54к за RTX 3070 (представим что его можно купить по этой цене);

11к за материнку на B550, по низу рынка фактически;

10к за две плашки хорошей памяти, если быстрой — то 2х8, если средненькой, то 2х16;

4к за обычный дешманский корпус, но черт с ним;

5к за блок питания, тоже не самый топовый, но от приличной фирмы;

10к за 1tb SSD, тоже почти по низу рынка, что маловато по объему, но минимально для игрового компа сойдет.

Итого — 119к. И ужиматься толком некуда. В сотку по сути поместится только апгрейд-комплект проц+память+видюшка+мать, и то при большом везении. Ну или это будет уже не «хороший игровой комп», а комп из рекламы эльдорадо, кажется, которые «два ядра, два гига», а на выходе пшик:)

За 160 можно взять ноут с 3700x и 2070 (https://eurocom.com/ec/configure(2,463,0)NightskyARX15)

Наверняка игровой системник должен быть прилично дешевле

Ну не все так просто. Там B450 чипсет, 2 тысячи долларов стоит комплектация с одноканальной 8Гб памятью и HDD, да и 2070 это все таки предыдущее поколение. Если с такими расчетами то да, будет дешевле. Хотя вот у меня 2070 и не сказать чтобы она прям уж быстрая, 4к вообще чаще всего не может на настройках выше среднего, 1080 на ультах всегда, да. 1440p да, скорее всего будет достаточно хорошо, но у меня 4к дисплей, так что или 4к, или 1080.

Берём за 4к не дешманский корпус, а нормальный.

Найдете хороший удобный корпус не из полумиллиметрового силюмина и мгновенно царапающейся плексовой крышкой за 40 баксов — дайте ссылочку пожалуйста, я такого не видел уже лет 10.

в начальном эире 16 или даже более того 32 гигов и 1 тб ссд?

Нет. Так и не надо.

Я хочу заметить, что это вы же изначально начали сравнивать ультрапортатив (хороший, топовый ультропортатив) с «хорошим игровым компьютером» и «хорошим ноутбуком». В рамках класса эир очень хорош. Задачи, которые решает он, за эти деньги с тем же качеством не решает практически никто, есть только дороже.

Сравнивать имеет смысл только в рамках ниши, причем я изначально об этом говорил, но в итоге написал вам ответ с ценами, пойдя по вашему же пути сравнения.

Я в целом понимаю вашу позицию. Почти всегда можно вымутить варианты подешевле любого предложенного, пойдя на компромисы. Но если реально сужать рамки и конкретизирвать представление о «хорошем ноутбуке» или «игровом компьютере» то по сути результат сравнения будет напрямую зависить от интерпретации.

Лично я себе просто не возьму ноутбук, который работает меньше 6-7 часов без розетки, с дисплеем ощутимо хуже чем макбуковский, в пластиковом корпусе без гарантированно хорошей механической прочности, с гигантским блоком питания, плохим тачпадом и дюймовкой больше 15. При этом мне терафлопсы в вакууме нафиг не нужны, все реально тяжелое у меня CI собирает на облачных машинах, а всякая мелочевка дольше зависимости качает и распаковывет, чем реально компилирует. И в этом кстати опять мак выиграет, там обычно очень быстрые диски, и чем дальше — тем быстрее.

Это важно для меня, все эти вещи мне нужны на практике. В этих рамках что продукция Apple, что Lenovo, что Dell по стоимости особо не отличаются, а новые эиры вот еще и дешевле на круг. И это я не говорю о том, что просто надежность тоже важна. В маке я уверен, так же как в XPS, и в Thinkpad. Я знаю что для них есть куча сервисов в любой точке мира где мне их починят, я знаю что я двумя кнопками смогу в случае любых проблем откатить софт на машине, а если с ноутом что-то фатальное случиться, то мне нужен новый любой макбук и часок времени, чтобы развернуть бэкап из time machine и получить машину 1в1 с утраченой. И я знаю, что если я его потеряю или у меня его украдут, то данные из него не вытащат (хотя тут bitlocker тоже поможет). В общем много у этого плюсов. Равно как и у альтернативных решений.

В категории терафлопс на доллар вообще скорее всего победят китайские зионы с алика вкупе с китайской материнкой и БУшной памятью. Но для меня такое решение просто не приемлимо, наковырялся. Я хочу предсказумости, удобства и ощущаемого качества. И ноут одной рукой открывать, да:)

Найдете хороший удобный корпус

Define 7. Выглядит классно, но многое можно было бы сделать лучше, в том числе крепления дисков (как в 5), например.

И шлейф не доложили.

Нихарашо, ниудобна!

А так, до 4500 вместе с более приличным, чем low-levew, БП вписывается, например, InWin, который давно стандарт де-факто для "дешево и сердито".

Я в Польше, так что приведу местные цены, но в рубли перевести легко (20 рублей 1 злотый) — Define 7 обойдется в 739 злотых, или почти в 15 тысяч рублей.

Единственная доступная (из 3) модель этой ценовой категории от InWin mATX вот эта. Без БП. Она да, где-то около 3500. Но там ни удобства, ни качества.

Где вы в 2020 году нашли за 4500 корпус с «более приличным чем low level БП» — ума не приложу. Даже беглый поиск по рунету дал младшенькую модель InWin EFS052 без БП за 3940р по скидке при стандартной цене почти в пять тысяч. Вариант с совершенно убогим блоком питания на 400 заявленных ватт (и хз сколько фактических), стоит уже как раз 5 тысяч. Вот только ничего более-менее мощного и современного в такой корпус просто не упаковать. Да и он тоже ну никак не тянет на «качественный и удобный».

Нет, про цены второй абзац. Первый — это пример того, что неформализуемые критерии удовлетворить невозможно по определению.

У инвинов — поверманы, примерно уровня FSP БП'шки. Не Q'Dion, старого FSP.

Каджит собирает от случая к случаю, но пока осечек не было )

SuperFlower/Chieftec хорошо себя показывают, можно смело брать с загрузкой под 75-80% от номинала. Конструктивно они идентичны.

Seasonic тоже неплохи.

Из коплектных к корпусам — «beQuiet!», Inwin-Powerman и, на удивление, Exegate.

Новые дешовые чифтеки — 2 года в эксплуатации, пока без жалоб.

Вообще, если электричество не прыгает, то лет 5-7 протянет даже какой-нибудь китаец — но их надо брать с запасом по мощности раза 2÷3 — что-то вроде 600÷700W на шестиядерник + 2060 + диск.

А powerman — все тот же перекрашенный cwt только в профиль.

там хуже не то, что вы указали (кроме экрана и тачпада)

Это пожалуй две самых важных вещи из того, что я перечислил, потому что я в ноутбук обычно смотрю и работаю на нем без мышки.

Кроме того, судя по реддиту и характеристикам:

1. Нет вебки. Она нужна обязательно, 2020 год, удаленка, куча митингов. Да и до этого весьма активно ей пользовался. Вообще не представляю как можно сейчас ноут без вебки выпускать.

2. Действительно так себе экран (говорят в старшей модели лучше, но она уже перешагивает за тысячу долларов, что как по мне дороговато за сяомишный ноут, тем более остальные замечания остаются).

3. Проблемы с охлаждением. Пропилы снизу — беда. Еще и большие. Мусора там будет ой-ей. И надо обязательно на твердую поверхность ставить. У макбуков кстати такого нет, там конструкция такая, что если охлаждение активное, то он дует и забирает воздух сзади.

4. Медленный SSD.

5. Не поставляется официально за пределы Индии и Китая. Гарантия прощай.

Вообще вот тут есть обзорчик полный, правда на 16 дюймовую версию — www.notebookcheck.net/Xiaomi-RedmiBook-16-Ryzen-5-4500U-laptop-review-attractive-price-warrior-from-the-Far-East.482604.0.html

Если предположить что 14 дюймовая +- такая же, то как-то не однозначно. С одной стороны — в 2 раза дешевле. С другой стороны — SATA SSD в 2020 году. Ну то есть за свои деньги он топ (внезапно, как обычно сяоми), но с большими оговорками и все-таки не конкурент эиру, слишком уж много всего набирается, даже если не считать качество материалов и гарантии.

Корпус Chieftec CI-01B black mATX CI-01Bу сейчас за 3300 там же.

Все бы ничего, но тут (в Польше) он стоит где-то 4300 на рубли и он microATX. Это эм… весьма специфичный формат. Хотя в целом, если надо именно мелкий-мелкий корпус, то наверно пойдет, спасибо за инфу.

отыщит разницы с pcie кроме как в бенчмарках — это проблема?

Кому-то нужна причина, а кому-то — повод… )

на сайте эпла только 8 гб

Нет, объем накопителя и оперативки выбирается на втором шаге, когда вы выбрали первичную конфигурацию. Все конфигурации официально продаются везде.

sata ssd с которым большинство не отыщит разницы с pcie кроме как в бенчмарках

Это кстати весьма себе неправда. Разница чувствуется, в первую очередь по IOPS. Вот прям физически чувствуется. Поиск к примеру быстрее работает, всякие копирования документиков пачками и т.д.

Ну и проблема то не только в SSD. Остальное пожалуй даже более важно, чем собственно тип SSD. Считайте мое высказывание про диск просто фигурой речи:)

То есть 8гб/256гб в 2020 году

Вот кстати удивительно, но у меня есть прошка 15 года ровно в такой конфигурации. Она все еще достаточно бодро шевелится, причем именно потому, что там из коробки распаян весьма быстрый SSD (ну, по тем временам), который ощутимо быстрее SATAвского, что прилично ускоряет своп, а значит — не так страшно если память кончится.

Ну то есть да, лично мне уже некомфортно на нем работать, но жена к примеру меня не понимает, говорит что «все быстро же, что ты придумываешь». А я вижу эти полусекундные задержки, когда он в своп уходит и они мне кажутся вечностью. С другой стороны, если чисто серфить и документики править, то все еще вполне теплится, не смотря на весьма дохлый i5 и большинство затупов все таки связано с тем, что процессор в полку уходит, а не с тем, что памяти не хватает.

Бекап спасал уже несколько раз, в том числе и от внезапного выхода из строя встроенного SSD (который поменяли по гарантии).

У Synology DSM, которым пользовался некоторое время ранее, иногда бывали проблемы с TM. В самых тяжелых случаях лечились созданием новой копии Time Machine «с нуля». Предыдущая копия при этом или переименовывается или удаляется (через web или через командную строку).

С самой Time Machine тоже бывают «приколы», но со стороны операционной системы. Один раз по логам долго искал из за чего внезапно перестал работать бекап. Оказалось — из за файла с очень «кривым» названием. На файловой системы файл существовал и открывался, а вот TimeMachine не могла его скопировать и аварийно прерывала бекап.

Иногда TimeMachine прекращает работать, если на файловой системе остается мало места для создания локального Snapshot.

Обычно по логам можно найти причины проблем. Команда для вывода в консоль логов, параллельно работе TM:

log stream --style syslog --predicate 'senderImagePath contains[cd] "TimeMachine"' --infoНа счет ноута, это не по ценам РФ, конечно, взял пол года назад LG gram 17, 16/256 по цене базового air мака. Это более чем альтернатива. Где он и где 17-дюймовый ноут еще и меньший по весу, лол.

На счет ноута, это не по ценам РФ, конечно, взял пол года назад LG gram 17, 16/256 по цене базового air мака. Это более чем альтернатива. Где он и где 17-дюймовый ноут еще и меньший по весу, лол.

Он весит всё-таки больше Air (совсем немного 2.98lbs/1.35kg vs. 2.8lbs/1.3kg), меньше работает от батареи и очень проигрывает в производительности как CPU, так и GPU. Плюс хуже корпус, тачпад, спикеры.

Компенсируется ли это большим по размеру экраном, портами и наличием Windows? Кажется, это больше о личных предпочтениях, чем об объективном сравнении.

Про цены мне сложно судить из-за границы, но я вижу $1500+ по скидкам в крупных магазинах (за 16Гб/1Тб).

По начинке не уверен, мне кажется примерный паритет по cpu (с i7 8565u) и отставание графики, ок. Держат ноуты lg 8-10 часов или больше.

Корпус сделали специально такой, чтобы максимально снизить массу. Чувствуется не как пластик, а что-то напоминающее металл.

Про цены мне сложно судить из-за границы, но я вижу $1500+ по скидкам в крупных магазинах (за 16Гб/1Тб).

Сейчас все непонятно с ценами, но можно было взять хороший вариант за недорого.

Если сравнивать с предыдущим поколением air то там проигрыш был бы по всем фронтам, кроме может алюминиевого корпуса (кому надо) и звука. У граммов конечно все печально со звуком.

По начинке не уверен, мне кажется примерный паритет по cpu (с i7 8565u) и отставание графики, ок. Держат ноуты lg 8-10 часов или больше.

Если сравнивать с предыдущим поколением air то там проигрыш был бы по всем фронтам, кроме может алюминиевого корпуса (кому надо) и звука. У граммов конечно все печально со звуком.

Если сравнивать с предыдущим поколением, то как раз примерный паритет производительности и автономной работы. С новым же выглядит как избиение лежачего.

Я смотрел вот эти обзоры, там выдерживают примерно один набор тестов и бенчмарков, так что можно хоть какие-то цифры напрямую сравнить:

LG Gram 17 (2020)

Macbook Air (Early 2020) — Intel