Comments 293

По поводу отключения гибернации… Вместо него всегда использую режим сна. Нравится тем, что засыпает и просыпается моментально. Есть конечно вероятность потери данных при отключении электричества (если нет UPS), но такое случается весьма редко. =)

В режиме сна вентиляторы крутятся… Не кошерно :)

Разве? У меня ничего не крутится.

Если я не ошибаюсь, вам нужно попробовать поиграться с настройками БИОСа и выбрать режимы сна у системы S1 — S4, чуть подробнее ru.wikipedia.org/wiki/ACPI

Признаться, я даже не проверил это после апгрейда материнской платы :) Раньше не использовал, т.к. вертелись и скорее всего был режим S1. На новой материнке в режиме S3 пожалуй не будут крутиться. Правда интересно, как в таком случае обеспечить доступность компа извне, например, для TeamViewer, если он уйдет в такой глубокий сон (часто держу комп включенным, вдруг извне потребуется до него достучаться).

В моем случае вряд ли прокатит, т.к. у меня вместо LAN используется Wi-Fi, а по Wi-Fi этот пакет не умеет летать :)

Вообще то wake on Wireless LAN (WoWLAN) существует. Правда вифишных карт, которые это поддерживают не так много.

Что-то у вас не то в королевстве Датском.

Без проблем бужу комп с андроид-планшета и андроид-телефона и, конечно же, по Wi-Fi.

Причем, как из сна, так и из выключенного состояния.

Без проблем бужу комп с андроид-планшета и андроид-телефона и, конечно же, по Wi-Fi.

Причем, как из сна, так и из выключенного состояния.

комп подключен витой парой к wi-fi роутеру?

Подскажите, пожалуйста, какой софт на андроиде вы для этого используете?

Софтина с немного странным названием, но простая как две копейки и тупо выполняющая свои функции: Wol Wake on Lan Wan.

Asus CUV4X 2000-го года выпуска умела бесшумный спящий режим по умолчанию. Постоянно им пользовался. Правда в один прекрасный день CUV4X заснул и больше не проснулся. Взял с рук Soltek SL65EP-T, которая и памяти видела не более 512Мб, и в спящем режиме мало чем отличалась от бодрствующей. С тех пор как-то отвык от спящего режима — компьютер либо постоянно работает для возможности постоянного доступа по удаленке, либо выключен.

Можно использовать гибридный режим. Просыпаться будет моментально, а в случае отключения электричества считает данные в ОЗУ с винчестера.

И место на диске займём, и циклы потратим, и электричество для RAM порасходуем (а у кого-то вентилятор послушаем).

Гибридный режим, конечно, больше для HDD актуален. Но в любом случае всё зависит от предпочтений и привычек пользователя.

Обычно гибридный режим уходит в обычный hibernate через какое-то время. Я ноут всегда в этот режим отправляю. Если он понадобится через пол-часа-час, то рррраз и всё работает. А если я про него забуду до следующего дня, то он спокойно выключится и не будет жрать энергию аккума.

По поводу отключения гибернации… Вместо него всегда использую режим сна. Нравится тем, что засыпает и просыпается моментально.

Просыпается моментально и так и так (так уж оно устроено, AFAIK винде вовсе не нужно всю скинутую на диск память до конца считывать чтобы начать работать). А если использовать SSD, то, вестимо, разница в скорости просыпания будет ещё меньше. А вот засыпает в hibernate на HDD — да, медленновато. Иногда бывает желательно быстро усыпить комп и отреагировать на события реального мира (например если подошла твоя очередь/станция или дом горит), надеюсь с SSD уход в hibernate происходит быстрее. Sleep mode (тоже использую его когда можно) не всегда уместен: если есть батарейка — то в sleep mode она таки по-потихонечку сажается, если нет (вот у меня сдохла недавно), то питание отключать нельзя, соответственно если я собираюсь перемещать компьютер хотя бы к другой розетке — то приходится делать hibernate.

Как бы быстро все не работало на чистой системе — через год активного использования производительность значительно падает. Раньше на старт уходило около 12 секунд, сейчас около 20-25.

Это с засорившейся за год системой или с чистой?

Стоит для начала почитать вот это, там есть ответы на большинство вопросов: blogs.msdn.com/b/e7/archive/2009/05/05/support-and-q-a-for-solid-state-drives-and.aspx

например

То есть Superfetch (и Prefetch, который он заменил) и ReadyBoost на ssd и так по умолчанию отключен, и еще раз его отключать нет смысла.

Вообще, если у вас нет никаких спецтребований, оставляйте в винде все как есть, инженеры мсфт обычно лучше знают как делать.

например

Windows 7 will disable disk defragmentation on SSD system drives. Because SSDs perform extremely well on random read operations, defragmenting files isn’t helpful enough to warrant the added disk writing defragmentation produces. The FAQ section below has some additional details.

Be default, Windows 7 will disable Superfetch, ReadyBoost, as well as boot and application launch prefetching on SSDs with good random read, random write and flush performance. These technologies were all designed to improve performance on traditional HDDs, where random read performance could easily be a major bottleneck. See the FAQ section for more details.

То есть Superfetch (и Prefetch, который он заменил) и ReadyBoost на ssd и так по умолчанию отключен, и еще раз его отключать нет смысла.

Вообще, если у вас нет никаких спецтребований, оставляйте в винде все как есть, инженеры мсфт обычно лучше знают как делать.

>>на ssd и так по умолчанию отключен

Я об этом знаю, но в моем случае указанные службы и ветки реестра (а также соответствующие им каталоги с данным) содержали информацию, указывающую на то, что службы не были отключены. Видимо, диск фирмы OCZ фирма Microsoft за SSD не считает.

Я об этом знаю, но в моем случае указанные службы и ветки реестра (а также соответствующие им каталоги с данным) содержали информацию, указывающую на то, что службы не были отключены. Видимо, диск фирмы OCZ фирма Microsoft за SSD не считает.

Я думаю, не стоит тут ориентироваться на значение в реестре, как на признак включено или нет. У меня самый что не на есть стандартный интеловский ssd, и там тоже не 0. Другой ноут, там вообще родной ссд, и установленная производителем винда — та же картина.

Я думаю, где-то в другом месте стоит ключ, который отключает эти службы еще до проверки стандартных ключей включения-выключения служб.

В реестре хранится ключ, который говорит службе надо ей работать или нет. Далее всё просто, служба включается, ибо надо, видит SSD и больше его НЕ трогает. При этом, если у вас есть обычный HDD и на нём стоит софт, то с ним всё будет работать как обычно.

Вывод прост — не стоит лазать в реестр не зная что вы там делаете.

Вывод прост — не стоит лазать в реестр не зная что вы там делаете.

Вы мой первый вывод в конце статьи читали? Если да, то я не понимаю, о чем спор. Когда я явно прописываю, нужно службе работать или нет, у меня нет ощущения черного ящика (т.к. перечисленные службы нигде явным образом не показывают явным образом, пропускают они SSD или нет). Т.е. вы просто предлагаете надеяться на высокий IQ дядей из Microsoft и не париться. Мне такой подход не нравится, я хочу досконально разбираться в том, что происходит, и иметь полный контроль над тем, как работает система.

Это что же выходит: устанавливаем быстрый системный диск, а затем всю нагрузку с него (своп, темп, кэши приложений) переносим на старый медленный HDD? Что получаем в итоге — быстрый старт системы? А как насчёт быстрой работы?

Темп — там часто хранятся маленькие файлы, которые хорошо кешируются в ОЗУ — потери скорости нет.

Кеш приложений — зачем, если можно быстро прочитать приложение честно?

Своп для того и нужен, чтобы нежно намекнуть пользователю, что памяти маловато, но при этом ничего не сломалось.

Кеш приложений — зачем, если можно быстро прочитать приложение честно?

Своп для того и нужен, чтобы нежно намекнуть пользователю, что памяти маловато, но при этом ничего не сломалось.

Да, меня всегда радовали статьи «мы купили ссд, давайте теперь перенесем всё, для чего хдд был узким местом на него же, а ссд беречь будем».

На самом деле в каталог Temp (по крайней мере на моем компе) как правило сваливается всякий мусор при установке программ, для которого мне скорость не критична, зато я не боюсь ситуации, когда какая-то левая программа вдруг начнет использовать Temp для каких-то своих зловещих целей, перезаписывая внутри него сотни мегабайт информации.

Кэши браузера прекрасно лежат на RAMDisk'е, еще и очищаются при каждом ребуте, что приятно.

Кэши браузера прекрасно лежат на RAMDisk'е, еще и очищаются при каждом ребуте, что приятно.

Мегабайты? Ой страшно-страшно. Особенно при ресурсе SSD в несколько петабайт. Зачем нужен кэш браузера при быстром интернете? Я его отключил, оставил только кэш в памяти.

У браузера и так есть кэш в RAM, дисковый придуман в том числе для того, чтобы при перезагрузке компьютера не терялись кэшированные данные.

Я пришел к похожему выводу, но путем экспериментов выяснилось, что всякие мелкие программки, которые сидят в фоне и не требуют внимания пользователя — жрут ресурс очень не слабо (иногда по-круче «тяжеловесов» пишут какие-нибудь ненужные логи), какой смысл держать их на SSD? Что касается часто используемых тяжелых программ, то мой выбор однозначен — SSD, иначе опять же, какой смысл? В итоге, при такой логике всё летает, но чего-то действительно лишнего на SSD нет.

Пора уже психотерапевтам начать курсы «лечение SSDфобии» )

Самый здравый совет — купили, воткнули, пользуйтесь! Скорее вы купите новый прежде чем старый начнет ощутимо «сыпаться» из за выработанного ресурса.

У меня был Asus eee pc 900, купил его как только он вышел (года 4 назад), не знал я тогда о «проблеме ресурса SSD» и поэтому не парился о ресурсе (второй SSD там стоял вообще с ресурсом 10.000). Два года он работал у меня, сейчас до сих пор работает у друга.

Самый здравый совет — купили, воткнули, пользуйтесь! Скорее вы купите новый прежде чем старый начнет ощутимо «сыпаться» из за выработанного ресурса.

У меня был Asus eee pc 900, купил его как только он вышел (года 4 назад), не знал я тогда о «проблеме ресурса SSD» и поэтому не парился о ресурсе (второй SSD там стоял вообще с ресурсом 10.000). Два года он работал у меня, сейчас до сих пор работает у друга.

Проблема в том, что в этих SSD очень тухлая электроника. В условиях жёсткой ценовой конкуренции даже Intel уже начинает экономить на качестве. В итоге около 15% SSD дохнут в первый год работы, и отнюдь не потому, что там элементы памяти сыпаться начинают. Чаще всего просто умирает контроллер.

Так что покупка SSD — во многом лотерея. Если повезло и первый год он пережил, то дальше почти наверняка будет работать без проблем.

Так что покупка SSD — во многом лотерея. Если повезло и первый год он пережил, то дальше почти наверняка будет работать без проблем.

Тут главное понимать, что данные на SSD хранить не надо, только ОС и программы. Умер диск в первый год — сдали по гарантии и взяли новый, умер через 5 лет — ну а чего вы хотели, срок жизни вышел, покупайте новый. А данные пусть на стареньком HDD будут.

Важные данные надо бекапить. Зачем жертвовать комфортом ради мифического спокойствия? Старенький HDD имеет столько же шансов накрыться как и новенький SSD, а может и больше учитывая то, что это механика.

Тут уже скорее зависит от объёма хранимой информации. Сейчас да, пока цены на объёмные ssd высоки. Но в дальнейшем (когда деревья подрастут и цены упадут), буду хранить всю важную информацию именно на ssd. У меня куча дохлых hdd, которые просто вымерли от старости (подвижные части и всё такое). В ssd, когда заканчивается лимит на количество перезаписей, просто блокирует блок памяти — диск виден информация цела, только нельзя перезаписать.

Я так и решил, купив себе ССД. Система и весь софт на ССД, собираюсь этот раздел переодически бекапить на хард, туда где он раньше был( на всякий пожарный) а данные на харде… и не только потому что ССД а просто потому что 120ГБ как раз место под системный раздел, у меня туда больше ничего не влезет.

У меня в ноуте единственный диск 120Гб. На нём и система Win 7 и вся работа ( ~12-15 веб-проектов довольно больших) и ещё половина места свободна. Так что это сильно зависит от специфики деятельности. Если работа связана с монтажом видео, например, конечно этого очень мало, а среднестатистическая работа связанная с написанием кода вполне себе комфортно существует на 120Гб. Даже растолстевший от времени Win7 не вылезает у меня за пределы 22Гб.

А вы сборку программ делали на нем? Я взял именно для ускорения сборки, почти так воткнул и радуюсь. Сборка проекта серьезно ускорилась. Раза в два. Вот думаю сколько проживет, пока пол года полет нормальный.

У меня vertex 3 спокойно год прожил в таком конфиге:

— 2 раздела, на первом система, второй — скрытый, созданный для truecrypt.

— внутри truecrypt раздела собственно и лежало нехилое дерево java-проекта на десяток гигов, которое компилили и дебажили в хвост и в гриву.

Потом еще полгода на нем просто система работала (и собственно работает до сих пор).

SMART говорит что нагнулось 2 блока, но убеждает что в целом все ОК.

— 2 раздела, на первом система, второй — скрытый, созданный для truecrypt.

— внутри truecrypt раздела собственно и лежало нехилое дерево java-проекта на десяток гигов, которое компилили и дебажили в хвост и в гриву.

Потом еще полгода на нем просто система работала (и собственно работает до сих пор).

SMART говорит что нагнулось 2 блока, но убеждает что в целом все ОК.

чем smart смотрите, кстати?

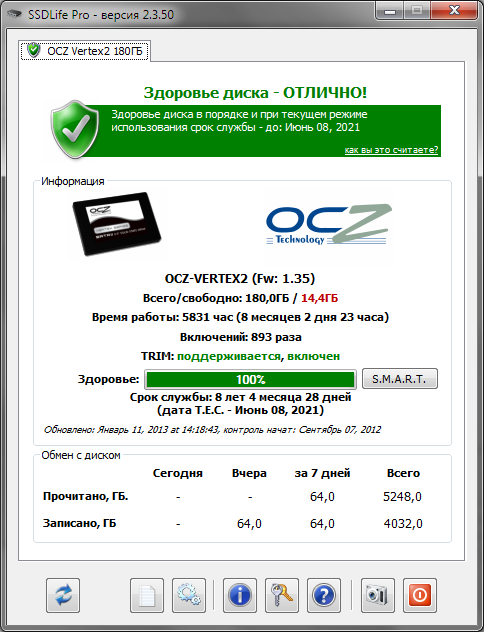

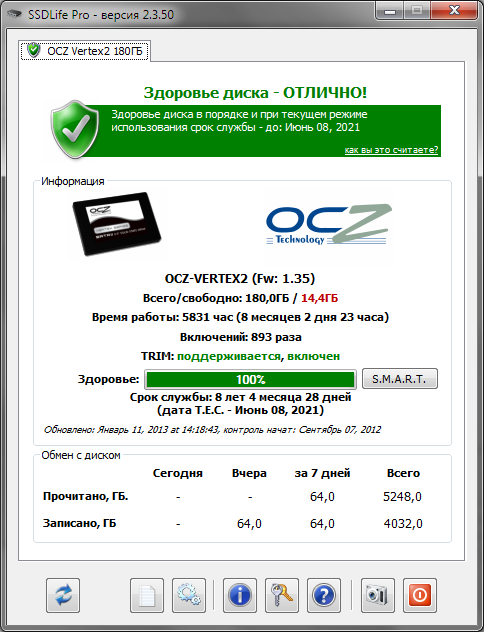

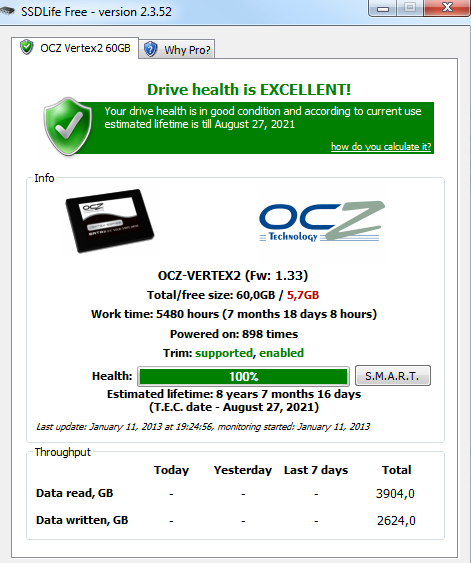

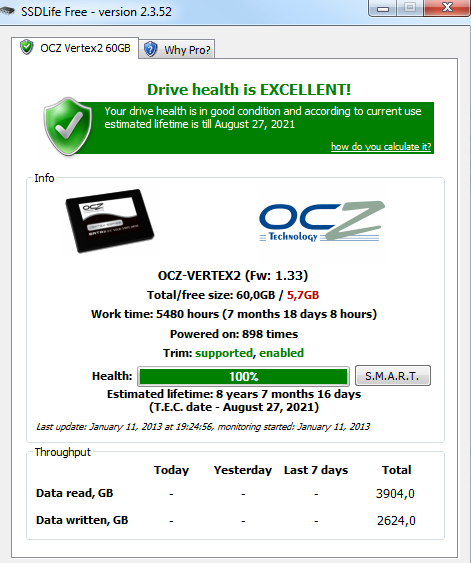

Под виндой — SSD life (что-то он кстати в последних free версиях перестал на онлайн-репорт редиректить), под линуксами — когда как.

он давно на онлайнрепорт редиректить перестали — они это убили судя по ответу мне на давний тикет.

А Pro версию они в Украине никак продавать не хотят, заразы. Так бы купил.

На русском софткее есть, на украинском — нет. Странный менеджмент.

А Pro версию они в Украине никак продавать не хотят, заразы. Так бы купил.

На русском софткее есть, на украинском — нет. Странный менеджмент.

А зачем софткей? Можно же прям из why pro? вкладки на страницу заказа уйти. А там, как я понимаю, они просто ключик вышлют, и вам достаточно его будет ввести в поставленной pro версии (которую можно скачать с оффсайта).

UPD: хотя на софткее почти на 150р. дешевле…

UPD: хотя на софткее почти на 150р. дешевле…

В принципе, когда появится кредитка, я этот момент исследую подробнее, да.

С другой стороны, мой 64 гиговый кингстон, наполовину забитый win2008r2/VS12/SQL12/Office13/Gimp в моём режиме использования (студия для десктопа и веба немного, броузинг, девушка фотографии в гимпе правит) за два года (5к часов налёта) использования обещается сдохнуть к концу октября 2016 года. Кажется, к тому времени у меня машина поменяется не один раз, чем этот Кингстон уйдёт в иной мир

С другой стороны, мой 64 гиговый кингстон, наполовину забитый win2008r2/VS12/SQL12/Office13/Gimp в моём режиме использования (студия для десктопа и веба немного, броузинг, девушка фотографии в гимпе правит) за два года (5к часов налёта) использования обещается сдохнуть к концу октября 2016 года. Кажется, к тому времени у меня машина поменяется не один раз, чем этот Кингстон уйдёт в иной мир

> В принципе, когда появится кредитка, я этот момент исследую подробнее, да.

Так жеж w.qiwi.com :)

А так да, я поначалу тоже следил периодически за состоянием диска, а через полгодика, понаблюдав тенденцию, как-то забил на это. Сейчас 11К с копейками часов налета, и мне еще обещают срок жизни диска до 2020 года.

Так жеж w.qiwi.com :)

А так да, я поначалу тоже следил периодически за состоянием диска, а через полгодика, понаблюдав тенденцию, как-то забил на это. Сейчас 11К с копейками часов налета, и мне еще обещают срок жизни диска до 2020 года.

Хотя можете еще вот здесь попробовать купить — soft.mail.ru/program/ssdlife/2.x — там по той же цене что и на софткее.

А Вы, кстати, у разработчиков спросите насчёт украинского отделения — может, они не в курсе просто?

Если решат вопрос и появится, и Вам удобнее будет, и другие проще купить смогут.

Если решат вопрос и появится, и Вам удобнее будет, и другие проще купить смогут.

тоже купил SSD OCZ Agility 3 для ускорения разработки (Visual Studio, большие проекты, постоянно включен Resharper, для тех, кто понимает).

Сборка и вообще скорость работы увеличилась в моем случае даже больше чем в 2 раза.

Тоже никаких настроек хитрых не делал, Temp не убирал, так как разумно посчитал, что пусть SSD работает и пусть даже если он проработает 2-3 года, мне хватит, да и все равно что-то новое выпустят и надо будет его менять, а скорость работы важней — компиляторы и инструменты много работают с временными папками.

А программа SSD Life показывает уже пол года 100% health и срок службы до 2023 года.

Сборка и вообще скорость работы увеличилась в моем случае даже больше чем в 2 раза.

Тоже никаких настроек хитрых не делал, Temp не убирал, так как разумно посчитал, что пусть SSD работает и пусть даже если он проработает 2-3 года, мне хватит, да и все равно что-то новое выпустят и надо будет его менять, а скорость работы важней — компиляторы и инструменты много работают с временными папками.

А программа SSD Life показывает уже пол года 100% health и срок службы до 2023 года.

А я ещё перенёс папки «Рабочий стол», «Документы» и т.п. на HDD (делается в свойствах папки — «Расположение») — чтобы если SSD крякнул сильно не переживать, да и место освободить (для начала решил потренироваться на Vertex 4, 64 Gb)

Насколько я знаю, SSD крякается в режим ReadOnly (из за выработанного ресурса конечно же), так что за документы можете не переживать.

С отключённым журналом (как советует автор), он сможет крякнуться в невалидном состоянии. С другой стороны, HDD может сломаться вряд ли с меньшей вероятностью.

Но важные документы сейчас и так все ответственные люди хранят и в где-то ещё, так что проблем нет.

Но важные документы сейчас и так все ответственные люди хранят и в где-то ещё, так что проблем нет.

у меня как-то вин7 не перенесла на ссд броска питания и после ребута прошлось из бекапа ресториться.

Соержимое моих документов и рабочего стола таки кешируется дл быстрого доступа виндой, поэтому с рабочего стола действительно лучше в принципе всё поубирать, оставив ярлычки. Ну а хранить Мои документ на мелком носителе при простаиващем несколько-терабайтном винде просто глупо.

Я сделал так же. В этих папках всегда скапливается всякий хлам, особенно в загрузках и на рабочем столе.

Про папку Desktop и правда можно поспорить, а вот Downloads прямая дорога на HDD, и даже не для уменьшения износа SSD, а просто потому что она легко может занимать объем больший чем весь SSD

При установке Windows можно запустить режим предпродажной подготовки и в нём указать, что вся папка Users должна располагаться на другом диске.

По поводу файла подкачки, с тех пор как в системе стало оперативки более 4 гигабайт, я просто отключил свопинг, за отсутствием необходимости. Сейчас у меня 8 гигов, хватает и виртуалки крутить и игрища играть. Пока система не жаловалась на нехватку памяти.

А вы запустите фотошоп с чем нить пожирнее, у меня 8 гиг и если нет файла подкачки то система с синьку падает.

Фотошоп… Запустите After Effects — 10 минут работы и 10 гигов оперативы скушал (из 16), и то только потому, что больше кушать не разрешают настройки.

Зато с 8Gb на офисном компе я забыл о проблеме 2+ открытых экземпляра Visual Studio — с 4Gb тормозило безбожно.

Зато с 8Gb на офисном компе я забыл о проблеме 2+ открытых экземпляра Visual Studio — с 4Gb тормозило безбожно.

У меня при отключенном свопе (или при установленном ниже рекомендованного минимума в 16Мб) фотошоп кушает 2 Гб памяти из восьми, после чего вылетает из-за нехватки памяти. Поставил своп в 512 Мб, фотошоп работает спокойно с любого размера документами. Загрузить 8Гб удается редко-редко, только очень тяжелыми афтерэфектами.

Т.е. все-таки своп лучше не отключать?

У меня он отключен. 8 гигов оперативки. При этом при работе в Фотошопе CS6 с жирным файлами система часто зависает и пишет, якобы не хватает оперативки, хотя ее при этом остается 1,5-2 гига. Замучался с этим и вернулся на CS5 — проблема исчезла.

У меня он отключен. 8 гигов оперативки. При этом при работе в Фотошопе CS6 с жирным файлами система часто зависает и пишет, якобы не хватает оперативки, хотя ее при этом остается 1,5-2 гига. Замучался с этим и вернулся на CS5 — проблема исчезла.

У него же своп — настройте как угодно и куда угодно и будет счастье. Фотошопу сколько памяти не давай — всю займет. Более того у него использование памяти (у CS2 точно) в процентах задавалось. Так что сколько поставишь — столько и съест. Настраивать нужно.

Ваше решение неустойчиво. Может хватить всего 1 страницы, чтобы «всё хорошо» превратилось в «всё сломалось». Со свопом система будет медленно переходить в другое состояние, что будет вовремя замечено человеком.

Обычным человеком? Врядли. Винда прозрачно переходит на использование свопа, визуально лишь небольшое замедление будет замечено (если у нас тот же своп на SSD). Но подобное замедление возможно ещё по множеству причин.

Это только если постоянно следить за расходом RAM можно чтото заметить. Но вы сами в это верите?

Это только если постоянно следить за расходом RAM можно чтото заметить. Но вы сами в это верите?

У меня было так 2 Гб -> 4 Гб -> 6 Гб, но все равно мало (и думаю нарастить до максимума, т.е. до 12 Гб на моем ноуте).

Искренне не понимаю почему такая большая критика в ваш адрес.

Действительно, фотошоп нужен чуть более, чем никому.

В моём случае система за порог в 4Гб не вылезает, хотя имею 8Гб.

Тем не менее, это так здорово, что даже рядовые сисадмины зачем-то держат у себя фотошоп.

Действительно, фотошоп нужен чуть более, чем никому.

В моём случае система за порог в 4Гб не вылезает, хотя имею 8Гб.

Тем не менее, это так здорово, что даже рядовые сисадмины зачем-то держат у себя фотошоп.

На самом деле фотошоп нужен многим, но не многие ворочают им гигабайтные изображения. А критика, видимо, основана на привычке выставить файл подкачки побольше, иначе «кризис» не запустится. И опять же, описываю свою домашнюю машину и ноут с дебианом, там так же своп отключен, и раздела как такового не размечал, ибо память стоит копейки.

> 2) Отключение гибернации

У меня семерка сама отключила гибернацию при инсталле на SSD.

> 4) Отключение файла подкачки.

Помимо HDD его также можно перенести на SD-карту (если это ноут — то там наверняка есть слот). Минус такого решения — карточка всегда должна быть в слоте.

Ну и еще неплохой идеей имхо будет жестко задать размер файла подкачки, если позволяет место — в районе 2*RAM.

Еще можно добавить перенос кэшей браузеров на HDD/SD-карту. Тот же Хром достаточно активно пишет в свой кэш.

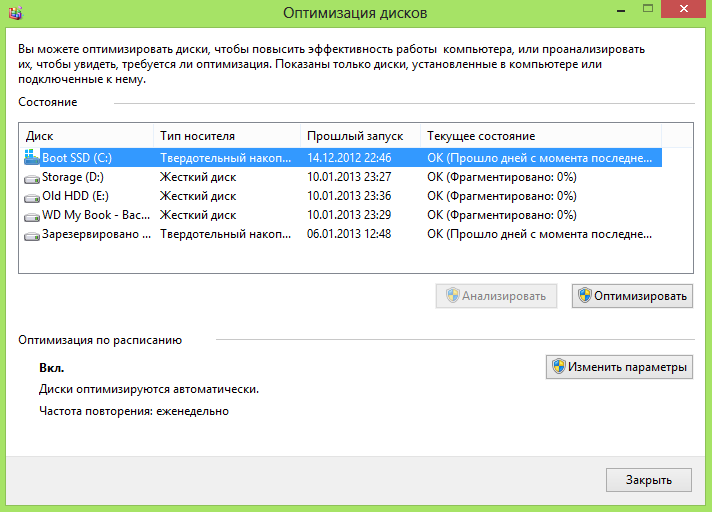

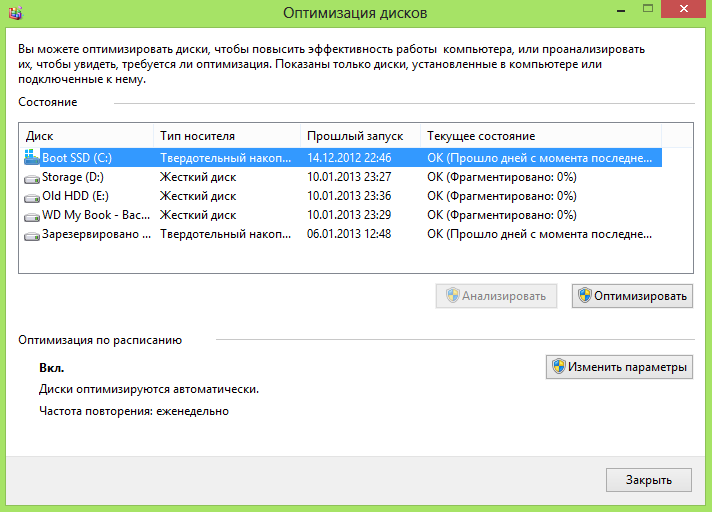

И там еще где-то в недрах настроек есть фича automatic maintenance, которая, судя по всему, делает проверку и дефраг диска по расписанию. Не помню уже точно где все это искать и отключает ли система сама этот дефраг.

UPD: нашел про автодефраг — Optimize drives называется. Там можно отключить scheduled optimization.

У меня семерка сама отключила гибернацию при инсталле на SSD.

> 4) Отключение файла подкачки.

Помимо HDD его также можно перенести на SD-карту (если это ноут — то там наверняка есть слот). Минус такого решения — карточка всегда должна быть в слоте.

Ну и еще неплохой идеей имхо будет жестко задать размер файла подкачки, если позволяет место — в районе 2*RAM.

Еще можно добавить перенос кэшей браузеров на HDD/SD-карту. Тот же Хром достаточно активно пишет в свой кэш.

И там еще где-то в недрах настроек есть фича automatic maintenance, которая, судя по всему, делает проверку и дефраг диска по расписанию. Не помню уже точно где все это искать и отключает ли система сама этот дефраг.

UPD: нашел про автодефраг — Optimize drives называется. Там можно отключить scheduled optimization.

Простите, а зачем переносить кэш браузера на более медленный накопитель? SSD обычно покупается для быстрой работы а не ради понтов )

А я и написал — «можно» :) Лично меня кэш на SSD совсем не напрягает, но мало ли, может кому пригодится. Изначально же, по поводу кэшей браузеров, их советовали вообще в RAM-диск переносить именно для ускорения работы браузеров.

А не проще вообще отключить браузерный кэш? Я в огнелисе отключил, и никакой разницы в быстродействии не замечаю. Во всяком случае, хуже не стало.

В интернетах пишут, что как минимум для Хрома отключать его совсем не рекомендуется. Развернутых пояснений почему я сходу не нашел.

+1. browser.cache.disk.enable = false и ощущается прирост скорости на HDD (и очень сильный при системе на флешке). Я не вижу смысла всякий мусор на диске складировать.

А можно перенести файл гибернациии на другой диск?

Мб есть какой-то хак?

Мб есть какой-то хак?

social.technet.microsoft.com/Forums/en-US/w7itproui/thread/b5baa5bf-bdb2-4c9e-8795-1441f59700a0/

technet.microsoft.com/en-us/library/2007.11.windowsconfidential.aspx

technet.microsoft.com/en-us/library/2007.11.windowsconfidential.aspx

Hibernation follows a similar pattern. Hibernating the operating system means dumping the entire contents of memory into the hibernation file; restoring from hibernation entails sucking that file back into memory and pretending nothing happened. Again, it's another chicken-and-egg problem: to load the hibernation file, you need the file system driver, but the file system driver is in the hibernation file. If you keep the hibernation file in the root directory of the boot drive, the miniature file system driver can be used instead.

Перенести нельзя, т.к. минидрайвер файловой системы, который используется при старте все ещё не умеет.

Можно уменьшить размер.

powercfg –h –size 50

Можно уменьшить размер.

powercfg –h –size 50

Можно без всяких хаков в ОС отличных от Windows.

Ну я видел совет не 2, а 1.5 раза. И он до сих пор светится во многих местах в MSDN. А в советах по настройке MS SQL Server для использования служб Full text search, они рекомендуют увеличить эту величину до 3-х раз вне зависимости от объема ОЗУ. Т.е. если у вас 24 ГБ ОЗУ, то по мнению Microsoft оптимальный размер файла подкачки 72 ГБ. И это не прикол.

Обоснование — файл подкачки используется, как для резервирования памяти, так и для сброса неиспользуемых страниц. Кроме того на него отображаются всякого рода разделяемые области памяти. Т.е. если программа зарезервировала очень много памяти, то (далеко не всегда, но в некоторых случаях) без подкачи эта память будет выделена в ОЗУ. А с файлом подкачки — в файле подкачки. А многие программы любят выделять память «про запас». Для них файл подкачки реально полезен.

Не трудно видеть, что максимально реально-полезный объём файла подкачки действительно равняется 2xобъёма ОЗУ. Половина (теоретически) может быть использована программами для резервирования (больше не имеет смысла, т.к. программа потом всё равно не сможет эффективно использовать эту память — объёма ОЗУ для отображения не хватит). А вторая половина — использоваться, как файл подкачки для реально используемого ОЗУ.

Но!

Это голая теория и лишь ориентир. Во-первых, на 32-х битных системах всё равно нет смысла делать подкачку более 4...6 Гб (их некуда отображать).

Во-вторых, объёмы ОЗУ растут быстрее, чем скорости работы с диском и при современных объёмах работа с такими объёмами займёт чуть более чем вечность.

Так что, сейчас, в общем случае, это правильо гласит, что объём подкачки должен быть от одного, до двух объёмов ОЗУ, но не более 8 Гб. Ну, кроме, конечно использования специализированного софта — при работе, например с фотошопом и 16 ГБ подкачки могут быть полезны (Но фотошоп, кстати, имеет свой файл подкачки)

Не трудно видеть, что максимально реально-полезный объём файла подкачки действительно равняется 2xобъёма ОЗУ. Половина (теоретически) может быть использована программами для резервирования (больше не имеет смысла, т.к. программа потом всё равно не сможет эффективно использовать эту память — объёма ОЗУ для отображения не хватит). А вторая половина — использоваться, как файл подкачки для реально используемого ОЗУ.

Но!

Это голая теория и лишь ориентир. Во-первых, на 32-х битных системах всё равно нет смысла делать подкачку более 4...6 Гб (их некуда отображать).

Во-вторых, объёмы ОЗУ растут быстрее, чем скорости работы с диском и при современных объёмах работа с такими объёмами займёт чуть более чем вечность.

Так что, сейчас, в общем случае, это правильо гласит, что объём подкачки должен быть от одного, до двух объёмов ОЗУ, но не более 8 Гб. Ну, кроме, конечно использования специализированного софта — при работе, например с фотошопом и 16 ГБ подкачки могут быть полезны (Но фотошоп, кстати, имеет свой файл подкачки)

* ГБ из соображение скорости чтения диска. Даже при быстром SSD и 400 МБ/сек весь файл подкачки может быть подгружен за 16 секунд (!!!). Для жёсткого диска — раза в четы дольше. Очевидно, что эффективно такие объёмы использоваться не могут (за это время проще программу заново загрузить, чем из свопа поднять).

* ГБ = 8 ГБ

Ну и плюс в своп кладётся полный crash dump при BSOD, при объёме свопа < RAM он туда просто не поместится.

Весь вопрос в том, сколько лет составляет срок жизни SSD до и после оптимизации (тут еще бы договориться, что понимать под «сроком жизни»). Если это, например, 3-4 года и 4-5 лет, то игра не стоит свеч — через 4 года в любом случае SSD на 256 Гб будет настолько же полезен, как флэшка на 512Мб сегодня. Будут SSD-терабайтники со скоростью чтения и записи под 1 Гб/сек, и машину — что оптимизированную, что нет — на SSD 2012-го года выпуска придется менять.

Учитывая стоимость в $100-200, речь идёт менее чем о кружке пива в месяц, поэтому можно вообще не забивать себе голову этой проблемой :)

Если ваш комп всё ещё без SSD, купите его и просто наслаждайтесь скоростью.

Учитывая стоимость в $100-200, речь идёт менее чем о кружке пива в месяц, поэтому можно вообще не забивать себе голову этой проблемой :)

Если ваш комп всё ещё без SSD, купите его и просто наслаждайтесь скоростью.

Пол года у меня стоит SSD, записано почти 100 террабайт, при емкости 120 гб (работаю с фотографиями в формате RAW, то, с чем работаю в данный момент, копирую на SSD). Грубые подсчеты показывают, что каждая ячейка перезаписана по 800 раз, при ресурсе в 100.000, думаю, я быстрее куплю новый компьютер, чем поменяю SSD из за его износа.

Я именно об этом.

в современных бытовых SSD ресурс записи примерно 3000 раз

10.000 для MLC вроде бы. 3K — это у Kingston была удешевленная серия (типа с меньшим ресурсом, потому и дешевая)

То есть современные SSD хуже чем те, которые были 3-4 года назад? Не верю. Но даже в этом случае, мне хватит на полтора-два года. Причем у меня он работает при гораздо больших нагрузках, чем у «среднего пользователя».

Вы, очевидно, говорите про «устаревшую» технологию SLC. Там действительно был ресурс 100000. Эта технология была признана, похоже, слишком дорогостоящей

По параметру «ресурс ячейки» современные ССД гораздо хуже, чем ССД, которые были 3-4 года назад, да даже 2 года. С каждым новым шагом уменьшения техпроцесса уменьшается ресурс ячейки, уменьшается себестоимость и улучшается энергоэффективность ССД.

Нравится мне слово террабайт. Есть в нем и терра, и террор…

Я думаю не все так просто и указанный ресурс явно завышен. Умирают же они от износа

Ресурс зависит от массы факторов. От заполненности диска. От того, сколько банков памяти у SSD. От бытродействия его контроллера. От прошивки SSD. От кривости настройки системы (если TRIM не работает, тто ресурс сразу падает на пару порядков).

В общем случае, если диск заполнен не более чем на 80%, стоят нормальные драйвера и работает TRIM, то для любого разумного использования ресурс можно считать бесконечным. Даже с нагруженной базой данных на таком диске ресурс получается лет пять.

В общем случае, если диск заполнен не более чем на 80%, стоят нормальные драйвера и работает TRIM, то для любого разумного использования ресурс можно считать бесконечным. Даже с нагруженной базой данных на таком диске ресурс получается лет пять.

Не расскажете, как получаются эти 100 ТБ (т.е. 550 ГБ в день)? Хочется понимать, с какими масштабами работают люди в наше время.

Файлов с одной съемки может доходить до 30-40 гб. Что там делают программы во время обработки я не знаю, эскизы всякие, кэши raw конвертора. Часть фотографий выводится из lightroom в 24-битных tiff (150 снимков по 200 мб это уже 300 гб).

Ну да, в своп система уходит часто при десятке открытых снимков в фотошопе (8 гб оперативы) и пару тяжелых программ в фоне. Планирую оперативку докупить

Вообще-то, 150 снимков по 200 мб это всего 30 ГБ. Это и подозрительно. Но в общем, если это 1000 фотографий в день и 500 МБ на фотографию, то понятно.

Хабровая традиция: купил SSD, запости совет по переносу темпа на медленный диск!

habrahabr.ru/post/148571/

habrahabr.ru/post/148571/

Проблема Хабра в одноразовости статей. Статья промелькнула, кто успел, тот и съел. Потом поиском ее фиг найдешь в этом море. Я специально перед тем как начинать писать статью написал в поиске «SSD», и вот именно той статьи я не увидел (по крайней мере на первых пяти экранах).

Старенький вертекс-2 (работает года два):

Тоже :) все отлично!

Оценка производительности:

у Вас сколько?

Оценка производительности:

у Вас сколько?

А что такое TRIM и как его включить?

Старенький вертекс-2 (работает года два):

и

контроль начат: Сентябрь 07, 2012

4 месяца же, а не «года два».

З.Ы. там еще и

Work time: 7 месяцев 18 дней 8 часов

Добавил опрос на тему «А есть ли у вас SSD». Надеюсь, те кто уже отхабрил статью все равно не поленятся вернуться и выбрать вариант ответа, благо их там аж целых 6 ;)

Ммм, а можете посоветовать, как лучше настроить систему в таком вот случае. У сотрудницы на ПК 16 ГБ оперативной памяти. На голом компе на диске C: (Windows 7) у неё есть 2 больших файла hiberfil.sys и pagefile.sys (по 12-16 ГБ). Изначально планировалось, что для офисной работы для системного диска должно хватить SSD на 64 гига. Но с этими ребятами на 64 гигах становится как-то тесно. И если файл подкачки можно уменьшить до нуля (хотя система сама почему-то предложила такой размер), то с гибернацией не всё так просто. Если хочешь ею пользоваться, то терпи такой размер файла на системном диске. Что можете посоветовать для экономии средств кроме отключения гибернации?

Можно ещё выделить файл подкачки на обычном харде, а на ССД убрать

Для офисной работы должно хватать 8 Гб оперативы. Выньте у неё половину памяти! И 16 гигов на диске освободите, и 8 Гб памяти обретёте

Оставить 4 Гб RAM, своп выставить в 1 Гб, гибернацию оставить как есть.

Для офисного компа этого с головой хватит.

Оставшиеся 12 Гб поставить себе.

Для офисного компа этого с головой хватит.

Оставшиеся 12 Гб поставить себе.

Для системного раздела почти полтора года работает исправно, все что сделано, так это:

— вынесен темп в ramdrive (16 гигов из них 4 на темп сейчас выделено)

— файл подкачки есть и вынесен на hdd

— перенесен chrome на hdd ибо чет пишет нереально много

в итоге SSD Life показывает 100% и обещает чуть ли не вечную жизнь. Система грузится очень быстро, хром живет нормально, визуалка открывается мгновенно, ну и этого хватает за глаза.

OCZ Vertex-3 120Gb.

— вынесен темп в ramdrive (16 гигов из них 4 на темп сейчас выделено)

— файл подкачки есть и вынесен на hdd

— перенесен chrome на hdd ибо чет пишет нереально много

в итоге SSD Life показывает 100% и обещает чуть ли не вечную жизнь. Система грузится очень быстро, хром живет нормально, визуалка открывается мгновенно, ну и этого хватает за глаза.

OCZ Vertex-3 120Gb.

Другие идеи и советы крайне приветствуются!

Всю статью нужно заменить на одну рекомендацию: «Регулярно делайте бэкапы ваших данных».

Ну и смысл tmp уносить с ssd?

Бросьте, диск копейки стоит.

Бросьте, диск копейки стоит.

>думаю самое время внести немного ясности в то море противоречевой информации о самих SSD и о настройке Windows для работы с ними.

Так интересно все начиналось, а под катом оказались набившие оскомину советы.

Так интересно все начиналось, а под катом оказались набившие оскомину советы.

> Кто-то советует переносить Temp на RAMDisk, но это скорее вредный совет. Связано это с тем, что некоторые программы (в т.ч. апдейты) пишут данные во временный каталог, затем отправляют компьютер в ребут, а затем ожидают, что данные никуда не делись за это время.

Уже несколько месяцев использую 2гб памяти под TEMP (8гб памяти позволяют). Единственная проблема была — антивирус писал трафик потокового видео во временный файл и место заканчивалось. И никаких проблем с установкой и обновлением программ.

С ssd никак не шаманил, использую как обычный hdd (торренты итд), т.к. у него гарантия несколько лет, а после можно и новый купить.

Уже несколько месяцев использую 2гб памяти под TEMP (8гб памяти позволяют). Единственная проблема была — антивирус писал трафик потокового видео во временный файл и место заканчивалось. И никаких проблем с установкой и обновлением программ.

С ssd никак не шаманил, использую как обычный hdd (торренты итд), т.к. у него гарантия несколько лет, а после можно и новый купить.

Переносить рабочие файлы с HDD на SSD как-то глупо, а вот чтоб освободить место на дорогом диске перенеся кучу барахла вполне можно. У меня первые кандидаты на перенос C:\Windows\CSC C:\WIndows\Installer. первое это файлы синхронизации, второй это хранилище всех инсталях, которые нужны только в момент собственно удаления программы.

Скажите, к чему это еще одно ничем не обоснованное мнение не разбирающегося в вопросе человека? Знаете анекдот:

Встречаются два фотографа:

— А я стал хирургом.

— Как тебя угораздило?

— Скальпель купил.

Встречаются два фотографа:

— А я стал хирургом.

— Как тебя угораздило?

— Скальпель купил.

Например, чтобы запустить обсуждение. В котором будут и другие мнения разной степени обоснованности.

Но я не понимаю, к чему комментарии типа «автор/комментатор не разбирается в вопросе» — без предложения альтернативы. Они звучат как «я знаю, как правильно, но вам рассказывать не буду, потому что такие, как вы, всё равно не поймут». Обидно…

Но я не понимаю, к чему комментарии типа «автор/комментатор не разбирается в вопросе» — без предложения альтернативы. Они звучат как «я знаю, как правильно, но вам рассказывать не буду, потому что такие, как вы, всё равно не поймут». Обидно…

> Но я не понимаю, к чему комментарии типа «автор/комментатор не разбирается в вопросе»

Потому что не первый и не второй и даже не десятый раз эти темы обмусоливаются. Зачем опять запускать обсуждение? Еще и куда ниже качеством.

> без предложения альтернативы

Гуглите.

Потому что не первый и не второй и даже не десятый раз эти темы обмусоливаются. Зачем опять запускать обсуждение? Еще и куда ниже качеством.

> без предложения альтернативы

Гуглите.

Потому что не первый и не второй и даже не десятый раз эти темы обмусоливаются.

Вы готовы привести 11 ссылок на подобные обсуждения? На Хабре?

Гуглите.

Нет никакой гарантии, что то, что я найду, будет более компетентным мнением. Скорее всего, оно окажется очередным «обсуждением людей, не разбирающихся в вопросе». Так что это будет временем, потраченным зря. По воле того, кто вместо того, чтобы дать единственную ссылку на известную ему абсолютную истину в данном вопросе, огранился лишь намёком, что она ему известна.

Статья как раз для Vogue.

Я бы выключил у себя подкачку, т.к. не вижу в ней смысла.

Но.

При падении в BSOD система отказывается писать дамп (даже минимальный), если выключен pagefile. Требует что-то около 256-300МБ под него выделить, чтобы все работало (так-то памяти 8Г).

Но.

При падении в BSOD система отказывается писать дамп (даже минимальный), если выключен pagefile. Требует что-то около 256-300МБ под него выделить, чтобы все работало (так-то памяти 8Г).

Купил в ноут Intel 320 на 120 гиг почти 2 года назад.

Юзал сначала ноут на работе. Там был проект на 10 гигов мелких файлов, которые постоянно перетрахивались — пересобирались, обновлялились, и т.п. SSD от такого через некоторое время начинал тупить, примерно также как тупит дико фрагментированный винт. Тесты тоже показывали дикое снижение производительности. Перепрошивка не помогла. Без нагрузки его через некоторое время отпускало.

Если его забить больше чем на 2/3 объема — наблюдались похожие эффекты, т.е. полезная емкость для меня была 80 гигов из 120-ти.

Потом проект сменился, ноут по работе требоваться перестал. Стал юзать ноут дома.

Винда до сих пор не переставлялась, весьма загажена, но грузится все равно шустро. С SSD по ощущениям сильно меньше «подвисонов» — всяких раздражающих лагов где не надо. Типа открываем «мой компьютер», а оно чего-то там думает.

Тяжелые игрушки грузиться быстрее на SSD не начинают. Софт — тоже не грузится заметно быстрее. Каких-то мега-приростов производительности я тоже не вижу.

Сейчас ноут использует жена, а я сел на комп с обычным винтом. Разительной разницы не наблюдаю.

Что я могу сказать по результатам:

— SSD весьма разочаровал: там где реально винт не справляется — на кучах мелких файлов, мой SSD точно также начал тормозить

— в бытовом плане SSD приятная штука, но не так чтобы это было сильно необходимо. Есть деньги и хочется сделать работу покомфортнее — можно и взять, но чудес ждать не стоит

Юзал сначала ноут на работе. Там был проект на 10 гигов мелких файлов, которые постоянно перетрахивались — пересобирались, обновлялились, и т.п. SSD от такого через некоторое время начинал тупить, примерно также как тупит дико фрагментированный винт. Тесты тоже показывали дикое снижение производительности. Перепрошивка не помогла. Без нагрузки его через некоторое время отпускало.

Если его забить больше чем на 2/3 объема — наблюдались похожие эффекты, т.е. полезная емкость для меня была 80 гигов из 120-ти.

Потом проект сменился, ноут по работе требоваться перестал. Стал юзать ноут дома.

Винда до сих пор не переставлялась, весьма загажена, но грузится все равно шустро. С SSD по ощущениям сильно меньше «подвисонов» — всяких раздражающих лагов где не надо. Типа открываем «мой компьютер», а оно чего-то там думает.

Тяжелые игрушки грузиться быстрее на SSD не начинают. Софт — тоже не грузится заметно быстрее. Каких-то мега-приростов производительности я тоже не вижу.

Сейчас ноут использует жена, а я сел на комп с обычным винтом. Разительной разницы не наблюдаю.

Что я могу сказать по результатам:

— SSD весьма разочаровал: там где реально винт не справляется — на кучах мелких файлов, мой SSD точно также начал тормозить

— в бытовом плане SSD приятная штука, но не так чтобы это было сильно необходимо. Есть деньги и хочется сделать работу покомфортнее — можно и взять, но чудес ждать не стоит

>>Тяжелые игрушки грузиться быстрее на SSD не начинают

У меня на Vertex4 в Skyrim при смене локации после переезда на SSD ожидание не ~10-20секунд, а ~5сек.

И PhpStrom/PyCharm на SSD стали запускаться и «поднимать» проекты ощутимо быстрее в линухе (если грубо, где-то секунд 3-5 против 20-30).

Собственно, SSD взял для ускорения работы IDEA. НЕ пожалел.

У меня на Vertex4 в Skyrim при смене локации после переезда на SSD ожидание не ~10-20секунд, а ~5сек.

И PhpStrom/PyCharm на SSD стали запускаться и «поднимать» проекты ощутимо быстрее в линухе (если грубо, где-то секунд 3-5 против 20-30).

Собственно, SSD взял для ускорения работы IDEA. НЕ пожалел.

У меня тоже первое время все грузилось очень быстро. Но довольно быстро прошло. Не то чтобы стало как HDD, все равно быстрее, но уже не в разы.

Ну и твой Vertex4 поновее чем мой, sata-3, все дела, может там все иначе.

Ну и твой Vertex4 поновее чем мой, sata-3, все дела, может там все иначе.

Intel SSD toolbox скачайте и проверьте в нём диск.

У меня sata-2 материнка :) Так что скорость упирается не в SSD а SATA.

Куплен 16.10.2012. Никаких пока проблем.

Не обновлял никаких прошивок. Только первый раздел выровнял на 1МБ.

Куплен 16.10.2012. Никаких пока проблем.

Не обновлял никаких прошивок. Только первый раздел выровнял на 1МБ.

«320» сейчас, мягко говоря, не самая шустрая серия по количеству IOPS при random чтении.

А есть здесь такие, кто полностью отказался от HDD и перешел на SSD?

Многие пользователи современных ноутбуков. Ну и как «полностью». Для этого нужно уходить в облака. У меня пока еще сетевое хранилище на 1тб дома стоит для скачивания сериалов.

Полностью — имею в виду, вообще все файлы, что хранятся на компе: и видео, и музыку и прочее мультимедиа, и все, что для работы используется.

Не совсем точный вопрос я задал. Вопрос больше к тем, кто юзает десктоп, а не ноутбуки.

Не совсем точный вопрос я задал. Вопрос больше к тем, кто юзает десктоп, а не ноутбуки.

Есть. 160 ГБ SSD от Intel мне вполне хватает. Доволен всем. На этом ноуте в VirtualBox работают время от времени виртуальные машины.

Свободного места ещё 55 ГБ, замедление системы не замечал. Никаких действий по оптимизации не предпринимал

Постоянные траблы были раньше с SSD от Vertex.

Сна SSD от Intel нареканий никаких нет. Кому советовал поставить SSD вместо HDD остались очень довольны.

Свободного места ещё 55 ГБ, замедление системы не замечал. Никаких действий по оптимизации не предпринимал

Постоянные траблы были раньше с SSD от Vertex.

Сна SSD от Intel нареканий никаких нет. Кому советовал поставить SSD вместо HDD остались очень довольны.

В пределах ноутбука — пришлось. Просто физически не удалось найти ни одного HDD на 1.8 дюйма (и не меньше 240 ГБ), в продаже были только SSD. А на десктопе отказываться не стал — 10 ТБ дисков заменить на SSD непросто. Поставил SSD 240 ГБ для рабочих проектов, и доволен. А винда осталась на HDD — не переставлять же её :)

У меня 256gb SSD диск и он один. Все на одном диске хранится и его мне хватает, я не являюсь фанатом фильмов, скачал, посмотрел, выкинул.

Есть внешний HDD 1TB USB 3.0 но он только для полной копии системы ( резерв)

Есть внешний HDD 1TB USB 3.0 но он только для полной копии системы ( резерв)

>> Отключение файла подкачки

А почему бы и нет? Если у меня 8 Гб быстрой ОЗУ, в среднем занято 3.5 Гб оперативной памяти, то зачем мне расходовать место на SSD/HDD, которые в добавок «медленней» оперативной памяти?

P.S. В системе Agility 3, правда на канале SATA2 и пока не получается выжать с него больше 250 Мбайт/сек, на следующей неделе буду пробовать SATA3.

А почему бы и нет? Если у меня 8 Гб быстрой ОЗУ, в среднем занято 3.5 Гб оперативной памяти, то зачем мне расходовать место на SSD/HDD, которые в добавок «медленней» оперативной памяти?

P.S. В системе Agility 3, правда на канале SATA2 и пока не получается выжать с него больше 250 Мбайт/сек, на следующей неделе буду пробовать SATA3.

Некоторые программы начинают сходить с ума, не найдя своп.

И дамп памяти с синего экрана некуда сохранить! Оптимально, выделить жестко своп на ssd — min 400 MB, max 2048 MB. Система будит яростно пытаться уложиться в 400 МБ (aka держать как можно больше в ОЗУ), будет куда выгрузить дамп, а программы будут счастливы, найдя своп.

И дамп памяти с синего экрана некуда сохранить! Оптимально, выделить жестко своп на ssd — min 400 MB, max 2048 MB. Система будит яростно пытаться уложиться в 400 МБ (aka держать как можно больше в ОЗУ), будет куда выгрузить дамп, а программы будут счастливы, найдя своп.

1. Гарантия на диск 1 год.

2. Гарантия у OCZ афигенная. Оформляешь RMA заявку на умерший SSD, высылаешь почтой. Там диск изучают и высылают новый или отремонтированный.

3. Не нужно жалеть SSD

4. Перенес на SSD каталог Adobe Lightroom, файлы превьюшек. Комфортная работа превыше всего.

5. Раз в неделю весь раздел с операционкой синхрнизируется в резеврным HDD, что бы была актуальная версия винды.

6. Профиль бэкапится раз в сутки.

2. Гарантия у OCZ афигенная. Оформляешь RMA заявку на умерший SSD, высылаешь почтой. Там диск изучают и высылают новый или отремонтированный.

3. Не нужно жалеть SSD

4. Перенес на SSD каталог Adobe Lightroom, файлы превьюшек. Комфортная работа превыше всего.

5. Раз в неделю весь раздел с операционкой синхрнизируется в резеврным HDD, что бы была актуальная версия винды.

6. Профиль бэкапится раз в сутки.

папку пользователи или Users тоже желательно перенести на обычный диск, туда програмы любят писать всякий хлам и папка документы и рабочий стол и остальные там же живут, а большинство людей складируют хлам именно здесь. Папку юзерс перенести хардлинком можно, папки рабочий стол и остальные через их свойства> задать местоположение или тем же хардлинком.

А разве система не держит самые часто используемые файлы в кэше в оперативной памяти? Я регулярно сталкиваюсь с тем, что гигабайтный файл программа читает за 1 секунду — просто потому, что она его уже прочитала при предыдущем запуске, и система не успела его забыть. При загрузке, конечно, копию брать неоткуда, но за сеанс работы система грузится только 1 раз.

Не будет, файлов которые требуются при загрузке системы в юзерс нет. как правило.

какого размера ntuser.dat? у меня 3 метра

Вы храните на рабочем столе вещи которые понадобятся при загрузке системы? Зачем?

В AppData не хранятся файлы что потребуются при загрузке системы, ну за исключением вирусов, которые любят эту папку так-как туда права на запись есть всегда у пользователя.

Вы храните на рабочем столе вещи которые понадобятся при загрузке системы? Зачем?

В AppData не хранятся файлы что потребуются при загрузке системы, ну за исключением вирусов, которые любят эту папку так-как туда права на запись есть всегда у пользователя.

Я бы посоветовал просто сменить расположения папок Videos, Music, Images, Downloads в свойствах медиапапки в Win7 на hdd, сам профиль, рабочий стол, поиски, документы конечно оставить на ссд

По поводу пункта 4 — у вас всё напутано. Каждый процесс имеет виртуальное адресное пространство 4Gb для x86, 8Tb для x64 (теоретические, на практике меньше, но это не суть важно). Дальше в системе есть физическая память, её может быть и 1Kb и 100500Tb. Объем физической памяти не связан с размером адресного пространства. Затем процесс может говорить операционной системе, что он зарезервировал в своём адресном пространстве какие-то участки. Это делается для внутренних нужд процесса, грубо говоря, что бы при ошибке программиста программа выдавала ошибку обратившись по незарезервированному адресу, а не работала с памятью заполненной мусором. Это то, о чем вы написали по поводу «шибко умных» программ. Они и в правду умные, без кавычек. Резервирование участков адресного пространства не «ест» физическую память. А вот дальше всё становится интересней. Когда процесс непосредственно совершает попытку что-то записать в память, или прочитать из неё, включается механизм подкачки страниц. Операционная система ведет таблицу того, каким участкам адресного пространства соответствуют какие физические страницы памяти. Если ОС видит, что по указанному адресу еще не выделена физическая страница, то он выделяет её из пула свободных страниц (читай физических ячеек), т.е. в этот момент и происходит «отъедание» памяти, или её реализация. Но физическая память, в отличие от виртуальной, не бесконечна. Когда нибудь свободные страницы в ней кончатся. Если объем физической памяти велик, то произойти это может очень нескоро. Но когда происходит, то ОС оказывается в трудном положении — программа хочет больше памяти, а её нет. Например, есть у вас 2Gb физической памяти, запустили вы Visual Studio, она съела 1,999Gb физической памяти. А потом запустили вы WinAMP, захотел он 100Mb памяти, и… упс. Но как вы могли заметить, этот «упс» никак себя не проявляет, WinAMP всё равно включается. А всё по тому, что ОС ведет себя хитро. Она проходит весь список физических страниц и ищет те, обращение к которым происходило очень давно. После того, как такие страницы найдены, они копируются в файл на диске, тот самый файл подкачки. После этого физические страницы освобождаются и передаются потребовавшему их процессу. Однако теперь VisualStudio частично выгружена из памяти, и если переключиться обратно на процесс студии, и что-то там подергать, вы можете заметить «тормоза». При попытках прочитать что-то из выгруженных участков памяти ОС будет вынуждена скинуть на диск какие-то другие страницы и прочитать запрошенные с диска, что не быстро. Это явление и называется swapping.

Конечно, это упрощенно, но всё так. И я постоянно встречаюсь с непониманием этого механизма.

Надеюсь теперь понятно, что всякие «оптимизаторы памяти» банальный развод на деньги, а отключение файла подкачки бессмысленное и вредное занятие.

Конечно, это упрощенно, но всё так. И я постоянно встречаюсь с непониманием этого механизма.

Надеюсь теперь понятно, что всякие «оптимизаторы памяти» банальный развод на деньги, а отключение файла подкачки бессмысленное и вредное занятие.

Теперь буду давать ссылку на этот коммент каждый раз, как увижу очередной холивор на тему файла подкачки.

Спасибо за первый более-менее профессиональный ответ. Но Ваше объяснение тоже не до конца «научное». Резервирование участков выполняется посредством WinAPI вызова VirtualAlloc. Если вы сможете простым языком пояснить разницу между MEM_RESERVE и MEM_COMMIT, думаю, все мои (и не только мои) сомнения по поводу файла подкачки будут развеяны.

И обратите внимание, что MEM_COMMIT Allocates memory charges (from the overall size of memory and the paging files on disk), т.е. выделение происходит как из диапазона адресов физической памяти, так и из диапазона адресов pagefile'а, а реальное выделение физической памяти происходит уже в момент обращения к памяти (о чем вы и писали).

Да, я специально опустил этот момент, как избыточный. Это всё программистские заморочки, от части исторически сложившиеся. По ссылке информация видимо немного устарела. Зато в примере всё правильно, есть там такой кусок, который всё ставит на свои места:

Переводя это человеческий язык — конечный результ — что сразу вызывать VirtualAlloc c флагом COMMIT, что только с флагом RESERVE, а потом уже с флагом COMMIT — один и тот же. Разница в том, что если сначала вызвать RESERVE для большого куска памяти, а потом из него комитить по страницам, то системные структуры ОС будут содержать меньший объем информации. На практике же все просто всегда резервируют большие куски с флагом COMMIT | RESERVE, а дальше и режет мелкие куски локальный менеджер памяти в самом выделяющем память процессе.

В общем сути дело это совершенно никак не меняет.

As an alternative to dynamic allocation, the process can simply commit the entire region instead of only reserving it. Both methods result in the same physical memory usage because committed pages do not consume any physical storage until they are first accessed. The advantage of dynamic allocation is that it minimizes the total number of committed pages on the system. For very large allocations, pre-committing an entire allocation can cause the system to run out of committable pages, resulting in virtual memory allocation failures.

Переводя это человеческий язык — конечный результ — что сразу вызывать VirtualAlloc c флагом COMMIT, что только с флагом RESERVE, а потом уже с флагом COMMIT — один и тот же. Разница в том, что если сначала вызвать RESERVE для большого куска памяти, а потом из него комитить по страницам, то системные структуры ОС будут содержать меньший объем информации. На практике же все просто всегда резервируют большие куски с флагом COMMIT | RESERVE, а дальше и режет мелкие куски локальный менеджер памяти в самом выделяющем память процессе.

В общем сути дело это совершенно никак не меняет.

Во, ща сформулирую еще более по человечески. Указывая флаг RESERVE процесс как-бы говорит ОС — мне может потребоваться участок памяти вот такого размера, и я не хочу что-бы какие-то другие участки кода с ним что-то делали, но он мне нужен не весь сразу и сейчас, а по мере надобности. А указывая флаг COMMIT процесс уже говорит — а вот этот участок памяти я скорее всего сейчас заюзаю, поэтому стоит к этому подготовится. А на это ОС уже выделяет внутри себя место под структуры данных в которых описано на какие физические страницы отображаются виртуальные.

Большое спасибо за разъяснение! Приятно видеть первого разбирающегося в теме файла подкачки комментатора (остальные просто делятся своим личным мнением, ничем не обоснованным). Объяснение звучит довольно правдоподобно, правда до конца не ясно, как на системе отражается резервирование виртуальных адресов (хоть в режиме RESERVE, хоть RESERVE | COMMIT) при отключенном файле подкачки. Вот именно в этом я и хотел разобраться: есть ли разница в ситуациях, а) когда адреса резервируются из диапазона адресов, относящихся к файлу подкачки и б) когда файл подкачки полностью отключен и адреса резервируются из диапазона физических адресов. В ситуации б) отдает ли система зарезервированные адреса другим приложениям, если им понадобится память (не виртуальная, а вполне себе реальная)?

Нельзя зарезервировать пространство «в файле подкачки». У вас есть адресное пространство процесса и точка. Вы можете резервировать в нем участки и освобождать. Можно было бы в современном Windows обойтись вообще без этих вещей, просто можно было бы давать читать и писать память по произвольным адресам, т.е считать что пространство закомичено всё сразу на старте процесса. Но тогда становится непонято, как отличить что в каком-то участке мусор, в каком-то код, а в каком-то данные. Если убрать резервирование, любая ошибка с арифметикой указателей в программе приводила бы к непредсказуемому её поведению.

Помимо того существует механизм отображения файлов в память. Это отдельная вещь с рядом назначений, используется в основном для организации IPC (межпроцессного взаимодействия). При помощи отображения файлов в память действительно можно проассоциировать участок адресного пространства процесса с областью из файла подкачки. Но, как я уже написал, это отдельное API, которое никак не меняет суть моего первого поста. Если вас интересуют детали реализации диспетчера памяти очень сильно советую ознакомиться с соответствующей главой из книги «Внутреннее устройство Windows» Марка Руссиновича.

По поводу того, что произойдет, если отключить файл подкачки. Это проявится в одной ситуации — когда у вас кончится свободная физическая память. Если файла подкачки нет, то процесс запросивший память (попытавшийся что-то прочитать или записать в неё) получит системное исключение ACCESS_VIOLATION и, скорее всего, будет аварийно завершен. Это вместо того, что бы «отнять» память у другого процесса.

А по поводу размера файла подкачки — почему больше размера оперативки — это сделано для того, что бы можно было не вести таблицу соответствия физических страниц памяти и участков в файле, в которые они выгружены, а просто читать или писать в файл по определенному смещению. Т.е. файл — это просто зарезервированное место на диске, а данные в нем расположены соответственно физической памяти. Причем, как нетрудно догадаться, пишется в него что-то только при крайней необходимости, когда деваться больше некуда (ну на самом деле не только, но объем системных операций принебрежительно мал).

Помимо того существует механизм отображения файлов в память. Это отдельная вещь с рядом назначений, используется в основном для организации IPC (межпроцессного взаимодействия). При помощи отображения файлов в память действительно можно проассоциировать участок адресного пространства процесса с областью из файла подкачки. Но, как я уже написал, это отдельное API, которое никак не меняет суть моего первого поста. Если вас интересуют детали реализации диспетчера памяти очень сильно советую ознакомиться с соответствующей главой из книги «Внутреннее устройство Windows» Марка Руссиновича.

По поводу того, что произойдет, если отключить файл подкачки. Это проявится в одной ситуации — когда у вас кончится свободная физическая память. Если файла подкачки нет, то процесс запросивший память (попытавшийся что-то прочитать или записать в неё) получит системное исключение ACCESS_VIOLATION и, скорее всего, будет аварийно завершен. Это вместо того, что бы «отнять» память у другого процесса.

А по поводу размера файла подкачки — почему больше размера оперативки — это сделано для того, что бы можно было не вести таблицу соответствия физических страниц памяти и участков в файле, в которые они выгружены, а просто читать или писать в файл по определенному смещению. Т.е. файл — это просто зарезервированное место на диске, а данные в нем расположены соответственно физической памяти. Причем, как нетрудно догадаться, пишется в него что-то только при крайней необходимости, когда деваться больше некуда (ну на самом деле не только, но объем системных операций принебрежительно мал).

Про отображение файлов в память я знаю, но мы не об этом сейчас говорим.

Я наконец-то нашел отличнейшую статью MSDN от 1993 года, которая ставит точки над i по поводу отличия MEM_RESERVE от MEM_COMMIT

Reserved Memory

When reserving addresses in a process, no pages of physical memory are committed, and perhaps more importantly, no space is reserved in the pagefile for backing the memory. Also, reserving a range of addresses is no guarantee that at a later time there will be physical memory available to commit to those addresses. Rather, it is simply saving a specific free address range until needed, protecting the addresses from other allocation requests. Without this type of protection, routine operations such as loading a DLL or resource could occupy specific addresses and jeopardize their availability for later use.

Committed memory

When memory is committed, physical pages of memory are allocated and space is reserved in a pagefile. That is, pages of committed memory always exist as either physical pages of memory or as pages that have been paged to the pagefile on disk. It is also possible that, while committing a chunk of memory, part or all of that memory will not reside in physical memory initially. Some pages of memory reside initially in the pagefile until accessed. Once pages of memory are committed, the virtual memory manager treats them like all other pages of memory in the system.

Я наконец-то нашел отличнейшую статью MSDN от 1993 года, которая ставит точки над i по поводу отличия MEM_RESERVE от MEM_COMMIT

Reserved Memory

When reserving addresses in a process, no pages of physical memory are committed, and perhaps more importantly, no space is reserved in the pagefile for backing the memory. Also, reserving a range of addresses is no guarantee that at a later time there will be physical memory available to commit to those addresses. Rather, it is simply saving a specific free address range until needed, protecting the addresses from other allocation requests. Without this type of protection, routine operations such as loading a DLL or resource could occupy specific addresses and jeopardize their availability for later use.

Committed memory

When memory is committed, physical pages of memory are allocated and space is reserved in a pagefile. That is, pages of committed memory always exist as either physical pages of memory or as pages that have been paged to the pagefile on disk. It is also possible that, while committing a chunk of memory, part or all of that memory will not reside in physical memory initially. Some pages of memory reside initially in the pagefile until accessed. Once pages of memory are committed, the virtual memory manager treats them like all other pages of memory in the system.

Что означает, что для RESERVED-адресов пофиг, есть своп или нет, и нет гарантии, что память будет в наличии, когда она потребуется, а вот для COMMITTED — не пофиг, т.к. эти адреса должны обязательно отображаться либо на pagefile, либо на физическую память, т.е. память для COMMITTED адресов должна обязательно быть в наличии к моменту, когда она понадобится (либо в файле подкачки, либо в физической памяти, а раз файла подкачки нет, то только в физической памяти). И получается, что неиспользуемые COMMITTED-диапазоны при отсутствии файла подкачки гарантированно расходуют физическую память (чего могло не происходить при его наличии).

When memory is committed, physical pages of memory are allocated and space is reserved in a pagefile.

Эта информация сильно устарела. Начиная с NT MEM_COMMIT это больше не физический комит, а виртуальный комит. Уже давно нет никаких оверлеев, никаких Local/Global mem. Сильно советую забыть всю статью и ознакомится вот с этим. Прочитайте весь раздел. Переход к следующей главе — правая ссылка из 3х под текстом.

Спасибо за ликбез! Буду читать. Но если я начинал эту дискуссию будучи на 100% уверенным, что pagefile в некоторых случаях нужен, то сейчас, послушав вас, я прихожу к выводу, что при достаточном объеме оперативки смысла от него нет (если все, что вы пишете — правда :) ).

Про важность pagefile'а для сохранения дампов памяти ядра при BSOD я уж не буду писать, т.к. кому сейчас нужны дампы памяти ядра?..

Про важность pagefile'а для сохранения дампов памяти ядра при BSOD я уж не буду писать, т.к. кому сейчас нужны дампы памяти ядра?..

По сути если оперативки много, то да, вероятность того что потребуется swapping крайне мала. Однако файл подкачки используется не только для свопинга. Если приложение вроде SQL сервера использует отображаемые в память файлы и не учитывает, что файла подкачки может и не быть, то оно, скорее всего не запустится или будет работать неверно. Впрочем обо всем этом написано по ссылке, которую я привел. Наверное проще будет надыбать PDF. У меня сей шедевр хранится в формате DeadTree :)

Нет, информация не устарела. Local/Global memory API все еще существуют, но используют они (точно так же как и CRT memory API) единый Heap manager.

Так что все верно, MEM_RESERVE — резервирует адресное пространство (например, если нужен мемори меппинг файл, но не хочется мепить его весь сразу), а MEM_COMMIT — резервирует виртуальную (pagefile backed) память. Если пейджфайла нет, то commit charge limit будет в точности равен объему физической памяти и даже при том, что физически страница не будет впечатана в рабочий набор процесса, можно считать что физическая память будет зарезрвирована и недоступна больше никому

Так что все верно, MEM_RESERVE — резервирует адресное пространство (например, если нужен мемори меппинг файл, но не хочется мепить его весь сразу), а MEM_COMMIT — резервирует виртуальную (pagefile backed) память. Если пейджфайла нет, то commit charge limit будет в точности равен объему физической памяти и даже при том, что физически страница не будет впечатана в рабочий набор процесса, можно считать что физическая память будет зарезрвирована и недоступна больше никому

Local/Global. API существуют с одной целью — обратная совместимость, и сами они реализованы через VirtualAlloc, логика работы которого тоже менялась со временем. Когда я пишу «больше нет» это значит, что оно еще там, но устарело. Если эти функции физически удалить то перестанут запускаться старые приложения. То же самое с исходниками Windows SDK, Microsoft не может просто выкинуть из них функции, вместо этого они помечаются как устаревшие.

CRT — это вообще другой уровень, это код внутри самого процесса, ОС про него ничего не знает. Про CRT я писал тут.

Про MEM_RESERVE вы всё поняли верно. А про COMMIT — нет. Что бы понять отлтичие, нужно знать как устроены структуры диспетчера памяти. По ссылке, всё есть, читайте про структуры адресного пространства — VAD, PTE. Приведу цитату:

Когда вы вызываете VirtualAlloc с флагом COMMIT вы отъедаете КВОТУ (а не саму память) ПРОЦЕССА (а не операционной системы) на ресурсы, резервируя элементы из каталога страниц процесса. Т.е. если вы будете мельчить с вызовами VirualAlloc(COMMIT) то вы просто потеряете возможность выделять память изнутри самого процесса, по тому что негде будет это выделение описать. Остальные процессы при этом совершенно никак не затрагиваются.

Хороший прмер — если в приложении утечка памяти, то рано или поздно посыпятся сообщения об ошибках вроде «Out Of Memory», но посыпятся то они только из одного процесса, а не изо всех сразу. На то память и называется виртуальной, у каждого процесса она как-бы своя, с точки зрения самого процесса.

CRT — это вообще другой уровень, это код внутри самого процесса, ОС про него ничего не знает. Про CRT я писал тут.

Про MEM_RESERVE вы всё поняли верно. А про COMMIT — нет. Что бы понять отлтичие, нужно знать как устроены структуры диспетчера памяти. По ссылке, всё есть, читайте про структуры адресного пространства — VAD, PTE. Приведу цитату:

Такой двухэтапный процесс (резервирование и передача) помогает снизить нагрузку на память, откладывая передачу страниц до реальной необходимости в них. Резервирование памяти — операция относительно быстрая и не требующая большого количества ресурсов, поскольку в данном случае не расходуется ни физическая память (драгоценный системный ресурс), ни квота процесса на ресурсы страничного файла (число страниц, передаваемых процессу из страничного файла). При этом нужно создать или обновить лишь сравнительно небольшие внутренние структуры данных, отражающие состояние адресного пространства процесса. (Об этих структурах данных, называемых дескрипторами виртуальных адресов, или VAD, мы расскажем потом.)(отсюда).

Когда вы вызываете VirtualAlloc с флагом COMMIT вы отъедаете КВОТУ (а не саму память) ПРОЦЕССА (а не операционной системы) на ресурсы, резервируя элементы из каталога страниц процесса. Т.е. если вы будете мельчить с вызовами VirualAlloc(COMMIT) то вы просто потеряете возможность выделять память изнутри самого процесса, по тому что негде будет это выделение описать. Остальные процессы при этом совершенно никак не затрагиваются.

Хороший прмер — если в приложении утечка памяти, то рано или поздно посыпятся сообщения об ошибках вроде «Out Of Memory», но посыпятся то они только из одного процесса, а не изо всех сразу. На то память и называется виртуальной, у каждого процесса она как-бы своя, с точки зрения самого процесса.

Local/Global. API существуют с одной целью — обратная совместимость, и сами они реализованы через VirtualAlloc, логика работы которого тоже менялась со временем

Первая часть не противоречит ни статье 93-го года, ни тому, что я сказал (я специально выделил «API» болдом) — да, эти вызовы все еще есть, выделяемая ими память ничем не отличается от остальной виртуальной памяти и «разливается из одной бочки» — heap manager-ом (который сам по себе является субаллокатором для NtAllocateVirtualMemory). А вот про «логику работы» — это уже Ваши домыслы (ну то есть особенности реализации менялись — оптимизация, приоритезированные стендбай списки, пейджкомбайнинг, «охлажение» многоканальной памяти и пр., но семантика осталась прежней)

CRT — это вообще другой уровень, это код внутри самого процесса

Это тоже не противоречит тому, что я сказал. С другой стороны, здесь можно долго спорить, что «является ОС», а что нет. msvcrt.dll (без версии) поставляется in-box точно так же как и те же kernel32.dll/kernelbase.dll и как ни крутись — является «частью ОС». С другой стороны, есть рантаймы с каждой версией VC, да еще статически/динамически линкуемые. Это никак не относится к тому факту, что «статья 93-го года» все так же актуальна, как и 20 лет назад.

Про MEM_RESERVE вы всё поняли верно. А про COMMIT — нет. Что бы понять отлтичие, нужно знать как устроены структуры диспетчера памяти. По ссылке, всё есть, читайте про структуры адресного пространства — VAD, PTE.

Нет, я «понял верно» и MEM_RESERVE и MEM_COMMIT. Про дерево VAD-ов и аппаратную трансляцию PDE/PTE (а также дополнительные метаданные самой винды для каждой страницы в виде nt!_MMPFN) я знаю и они к делу не относятся.

Когда вы вызываете VirtualAlloc с флагом COMMIT вы отъедаете КВОТУ (а не саму память) ПРОЦЕССА (а не операционной системы) на ресурсы, резервируя элементы из каталога страниц процесса

Точно так же и «квоты» на рабочий набор процесса никак не относятся к системному «commit limit»-у. Но раз уж мы меряемся длиной, то позволю себе отметить, что PDE/PTE как были невалидными до MEM_COMMIT, так и остаются после. Реальные физические страницы попадают в рабочий набор при soft-fault-ах. Упрощая, можно сказать, что коммит меняет только состояние записей в PFN database (и VAD), а PTE записи обновляются по мере необходимости (demand paged).

Т.е. если вы будете мельчить с вызовами VirualAlloc(COMMIT) то вы просто потеряете возможность выделять память изнутри самого процесса, по тому что негде будет это выделение описать.

Исчерпание (и/или фрагментация) адресного пространства — реальная проблема на 32-битных архитектурах. Забавным образом, она вообще не относится к коммиту. Адресное пространство можно легко фрагментировать (или выделить все и не оставить никому) и при помощи одного только MEM_RESERVE.

Остальные процессы при этом совершенно никак не затрагиваются.

Еще как затрагиваются. commit это «брать на себя обязательства», «обязывать», «фиксировать» и пр… То есть система ОБЯЗУЕТСЯ предоставить Вам страницу, когда она Вам потребуется (а не в момент самого NtAllocateVirtualMemory). Commit charge — это такой общесистемный счетчик, который подсчитывает сколько всего страниц было «обещано». Commit limit — это такой общесистемный счетчик, который считает сколько всего страниц МОЖЕТ БЫТЬ обещано (физическая память, которая может быть выгружена на диск плюс суммарный размер всех страничных файлов). Таким образом, когда процесс делает MEM_COMMIT, но не трогает эти страницы — его рабочий набор не изменяется, но commit charge растет. В то же время, если ядро выделяет физическую память (MDL-ами или из non paged pool-а), то уменьшается commit limit. Менеджер памяти все время следит, чтобы commit charge ни при каких условиях не стал больше commit limit. Подобная ситуация называется overcommit и термин используется при менеджменте любых ресурсов — не только физической памяти. Более того, он использовался за сотни лет до того, как появились компьютеры и означает буквально «осознанное обещание сделать больше, чем ты способен». Так вот, винда не оверкоммитит виртуальную память. Никогда и ни при каких условиях.

Хороший прмер — если в приложении утечка памяти, то рано или поздно посыпятся сообщения об ошибках вроде «Out Of Memory», но посыпятся то они только из одного процесса, а не изо всех сразу.

Действительно хороший пример. Предлагаю Вам попробовать:

add-type -Namespace Win32 -Name Mapping -MemberDefinition @"

[DllImport("kernel32.dll", SetLastError = true)]

public static extern IntPtr CreateFileMapping(

IntPtr hFile,

IntPtr lpFileMappingAttributes,

uint flProtect,

uint dwMaximumSizeHigh,

uint dwMaximumSizeLow,

[MarshalAs(UnmanagedType.LPTStr)] string lpName);

[DllImport("kernel32.dll", SetLastError = true)]

public static extern IntPtr MapViewOfFile(

IntPtr hFileMappingObject,

uint dwDesiredAccess,

uint dwFileOffsetHigh,

uint dwFileOffsetLow,

uint dwNumberOfBytesToMap);

"@

$mapping = [Win32.Mapping]::CreateFileMapping(-1, 0, 2, 1, 0, $null)

[Win32.Mapping]::MapViewOfFile($mapping, 4, 0, 0, 3Gb)

Ну или используйте Руссиновичевый "testlimit -m" (страницы коммитятся, но не «трогаются», так что рабочий набор не растет).

Зафиксируйте размер пейджфайла (или вовсе отключите), подведите commit charge вплотную к commit limit-у (оба числа хоть и постоянно перемещаются, но достаточно важны, так что показываются в task manager-ах всех виндов начиная как минимум с 2000 — до нее скорее всего тоже, но я просто не помню так что утверждать не берусь) и посмотрите сможете ли Вы почарджить память из другого процесса (хоть еще одним pagefile-backed memory map-ом, хоть VirtualAlloc-ом).

Да точно, это я не до конца верно понимал, как работает commit limit, он и правда общесистемный. Но тогда получается что отключать файл подкачки вдвойне вредно. Теряется не просто возможность своппинга, а выкидывается большая часть commit limit, и всякие тяжелые по использованию памяти приложения могут просто не работать. Спасибо, что обратили на это внимание.

Каждый раз когда того же Руссиновича спрашивают в духе «А какая, мол, текущая рекомендация по размеру страничного файла для системы с N физической памяти на борту» он всегда отвечает в духе «А хрен его знает». Иногда правда расширяет мысль: независимо от того, сколько в системе физической памяти размер необходимого пейджфайла от этого не зависит. Наилучшей рекомендацией (если уж сильно хочется зафиксировать размер) будет «отпустить» размер, погонять все-все свои ворклоады во всех-всех режимах, посмотреть Peak Commit Charge и выставить размер пейджфайла соответственно.

Что же отключения пейджфайла и прочих «твиков», я придерживаюсь мнения, высказанного где-то в этом посте Aux: не знаешь что конкретно ты делаешь — просто не лезь — существует высокая вероятность, что создатели ОС предусмотрели больше, чем способен предусмотреть ты. С другой стороны, я, к сожалению, не могу утверждать что отключение пейджфайла вредно абсолютно всегда (если бы все было так просто, возможности отключения просто бы не было), но к подобным вмешательствам в работу системы нужно подходить основательно и сначала проверить (чаще всего тестированием) действительно ли вообще нужно вмешательство и, если нужно, нужно ли оно именно здесь.

Что же отключения пейджфайла и прочих «твиков», я придерживаюсь мнения, высказанного где-то в этом посте Aux: не знаешь что конкретно ты делаешь — просто не лезь — существует высокая вероятность, что создатели ОС предусмотрели больше, чем способен предусмотреть ты. С другой стороны, я, к сожалению, не могу утверждать что отключение пейджфайла вредно абсолютно всегда (если бы все было так просто, возможности отключения просто бы не было), но к подобным вмешательствам в работу системы нужно подходить основательно и сначала проверить (чаще всего тестированием) действительно ли вообще нужно вмешательство и, если нужно, нужно ли оно именно здесь.

Спасибо за офигенный пост! дажемнепонятно!

«Есть и используется в качестве системного раздела»