Comments 424

Ну большинство пользователей все таки не профессионалы им зарабатывающие, а студенты, офисные служащие самые обычные

1. В богатых странах непрофессионалы и не айтишники зарабатывают достаточно, чтобы купить себе мак, если им хочется мак.

2. На США может быть приходится не очень большая доля населения, но очень большая доля рынка в денежном эквиваленте. Ну и речь не только про США, богатых стран много.

Но подавляющее большинство таки ездит на условном «гольфе» в комлектации «барабан с парктноником» и не особо задумывается о комфорте и мелких удобствах, т.к. машина — средство передвижения, а не предмет роскоши.

Аналогично и с рабочими компьютерами, ноутами и т.п.

Простите, что вмешиваюсь. Вы давно смотрели, сколько стоит новый фокус? Это как бы совсем небюджетные тачки

Это как с машинами.… А если вы зарабатываете на ней деньги, то вопрос вообще не стоит

Ага, то-то все таксисты ездят на машинах за 2М.

Для веб-разработки мак — это просто счастьеНе забывайте, пожалуйста, уточнять, какой именно вид веб-разработки имеете в виду. Потому что вот, например, мне, веб-разработчику (C#, .NET, TypeScript) из перечисленного вами не нужно ничего, а интерфейс более «человеческим» не воспринимается (там ведь всё ещё кнопка Return в одних местах открывает/запускает, а в других, типа списка файлов в Файндере, почему-то переименовывает?).

P.S. А какое вообще отношение Adobe имеет к разработке, если не секрет?

Не забывайте, пожалуйста, уточнять, какой именно вид веб-разработки имеете в виду. Потому что вот, например, мне, веб-разработчику (C#, .NET, TypeScript) из перечисленного вами не нужно ничего

Вы, судя по стеку, занимаетесь бекенд разработкой? Я тоже пишу последние 2 года одни бекенды и вполне успешно последние полгода сижу под линуксом. А товарищ выше занимается фронтендом и действительно лучше мака не придумать ничего — хотя бы проверять тот же сайт на ретина экране в сафари (не говоря уже про дебаг на айфонах), которая довольно популярна за бугром.

P.S. А какое вообще отношение Adobe имеет к разработке, если не секрет?

Самое прямое к фронтенд разработке, если заниматься вёрсткой. Вырезать ассетов себе, выдрать значения цветов да и просто глянуть на макет. Далеко не все перешли на всякие модные фигмы, а некоторые вообще сидят на скетче и без мака никак.

Главное, чтобы товарищи с 5K ретина-экраном не забывали, что в мире остались еще жалкие реликты с Full HD.

Вы, судя по стеку, занимаетесь бекенд разработкой?Нет, я full-stack. Бэк на C#, фронт на JS/TS. Неужто бэк часто смешанный бывает, на Дотнете с Нодой?

А товарищ выше занимается фронтендом и действительно лучше мака не придумать ничего — хотя бы проверять тот же сайт на ретина экране в сафари (не говоря уже про дебаг на айфонах), которая довольно популярна за бугром.А проверять для всех остальных, кто не ретина и не на маках (большинство)? Замечать проблемы макета на дефолтных win-шрифтах, непопадание в пикселы и всякие штуки вроде размытия при выравнивании по центру дивов нечётной (в пикселах) высоты через

transform-translate(-50%, -50%);выдрать значения цветов да и просто глянуть на макет.Для этого в Adobe Xd есть экспорт в веб, вам просто скинут ссылку на макет на xd.abobe.com/view/{guid}… и вот он у вас уже в браузере, открываете инструменты разработчика и включаете встроенную в них пипетку.

Вообще В 2020 при нужде в реально производительном ноутбуке не имеет особого смысле брать устройства не на райзен 4xxx. Там какой-то совершенно сумасшедший разрыв с интелом. Очень жаль что макбуков на них не будет. Очень жаль что аппл не выкатили версию мака про на новых тредрипперах. И также очень жаль что производители не торопятся ставить эти новые процессоры в топовые модели ноутбуков. Однако постепенно втягиваются.

А тут просто обратите внимание на то, какие модели процессоров окружают этот в рейтинге производительности.

Реалистично, хоть я тут кругом и защищаю ценовую политику эппл и с ней все как бы в порядке, нет ни одной причины брать ноутбук на интеле сегодня. Ну только если без мак ос жизнь не жизнь (а она жизнь, так-то). Ну и тандерболт еще, это важно, согласен. Но он там (имхо) скоро появится + USB-C со всеми возможными режимами все еще покрывает очень много юзкейсов.

А как разработка на TypeScript мешает работе с ним под linux/macOS?

В общем, с 2015-2016 годов всё в мире .net-а сильно поменялось к лучшему и теперь можно с двойным комфортом использовать мак для разработки сайтиков.

Понятно, что если есть какой-то lock на winapi, то да, от win уйти не просто (ну, например, писать GUI на WPF/UWP/WinForms или же на старом Asp.Net что-то допиливать).

рассчитано на использование одним человеком — PC.

PC рассчитан на работу одним человеком в один момент времени (логика в том, что устройств ввода один комплект), но при этом PC легко может делиться, например, разными членами семьи на протяжении времени

В ThinkPad T60 на максималках тоже система охлаждения справлялась вот буквально на грани...

И ладно бы в ноутах не было, так даже внешнюю видеокарту от Nvidia не получится использовать, если хочешь, например, что-то на CUDA посчитать.

Да, я как раз и хочу сказать, что внешняя не поможет.

Apple and Nvidia Are Over. На страничке для загрузки CUDA только Windows и Linux.

CUDA 10.2 ещё работает на macOS, впрочем. Но надолго ли её хватит?

За примерно 1600 долларов я могу купить себе очень годный thinkpad со свеженьким ryzen 4xxx о 8 ядрах и 16 потоках, да 32 гигах оперативной памяти

А не подскажете, где это вы можете себе купить такое? Я вот в официальном магазине в Украине ничего такого не вижу.

Плюс надо же эпплу будет хотя бы в первые годы мотивировать как-то людей брать технику на арме, особенно когда в актуальной линейке еще будут модели на интеле. Я вполне себе могу представить что часть этой мотивации будет в цене.

Плюс надо же эпплу будет хотя бы в первые годы мотивировать как-то людей брать технику на арме

Особенно это важно с широким выбором устройств с MacOS на рынке от разных производителей. Прямо глаза разбегаться будут: на арме брать или на х86.

1950 евро стоит база с i5, 8гб памяти и FHD монитором. Если подтянете его до базовой прошки 16 (hidpi дисплей, i7 и 16гб), то получатся те же 2600 евро.

На линуксе не будет первого, на windows — второго, хотя имхо в наш век контейнеров и дешевых (в смысле оверхеда) виртуальных машин гнаться за вторым особого смысле нет.

При средней зарплате в EU/USA, макбуки, айпэды и айфоны стоят просто как обычные качественные устройства.

Являясь далеко не качественными устройствами.

просто у тхинкпадов, деллов и HP нет таких последователей.

внезапно, но есть. Один коллега (да и второй такой же) полностью забил квартиру тхинкпадами. Да и я долгое время на них сидел...

Я вот, имея P50, подумываю о X230T, просто потому, что концепция прикольная. Ну и семирядку можно воткнуть.

А во-вторых, ценник за яблоко сравнительно высок только в небогатых странах, и только в сравнении с дешёвыми устройствами. При средней зарплате в EU/USA, макбуки, айпэды и айфоны стоят просто как обычные качественные устройства.

Ознакомьтесь по первой ссылке в гугле со «статистикой продаж ноутбуков в США» прежде чем пытаться убеждать в том чего нет. У меня ASUS ZenBook UX391U, купленный за 68000 и по характеристикам соответствующий MacBook Air 13" i5 за 120000. Я не вижу разницы в качестве этих продуктов. А в макоси не вижу преимуществ с вин10. Глянул на Амазоне, разница в цене 630$/1200$. Так что холивар вы всё-таки развели

Вот обгонят хотя бы Атом тогда и поговорим

Вот обгонят хотя бы интел i3 тогда и поговорим

———————— Сейчас мы тут —————————

Вот обгонят i5 тогда и поговорим

Вот сделают хотя бы макбук про на ARM тогда и поговорим

Вот сделают что б i9 обгонял тогда и поговорим

Вот когда они все маки на свои процессоры переведут, тогда и поговорим

Ну как будет работать какая нибудь IDEA на таком слабом железе без тормозов-тогда и можно рукоплескать будет

Ну как будет работать какая нибудь IDEA на таком слабом железе без тормозов-тогда и можно рукоплескать будет

Рукоплещите автору статьи habr.com/ru/post/510210

Их дело десятое.

Ценник яблочных фантазий скорее всего снизится немного с переходом на собственный чип. Яблочная компания при этом будет зарабатывать ешё больше, собственно за этим они все и затеяли.

В этом легко убедиться, если сравнить с любым компьютером похожей комплектации.

Или вы сравниваете по популярности среди разработчиков, дизайнеров и художников? Ну тут да, возможно доля и 40-50 наберется, не удивлюсь. Но мы то про весь мир в котором обычных пользователей гораздо больше.

А эйры сравнивал с примерно равными по начинке ноутами в примерно том же форм факторе.

С какими конкретно ноутами сравнивали? Просто интересно.

Мне вот интересно с чем вы сравнивали. Хочу вот тоже сравнить

Скорее всего вы найдете то что есть у apple но нет у другого ноута, но и наоборот тоже, как я и сказал apple за цену в полтора раза дороже тут уступает по некоторым характеристикам. Да и выбор других ноутов больше минимум на пару порядков. Можно подобрать без того что не нужно и с тем что нужно, а у apple ешь что дали.

Во-вторых мне цену не показывает на этот асер в этом магазине.

В-третьих не совсем корректно этот конкретно Acer сравнивать с Air, потому что это разные классы устройств (У Air фактически пассивно охлаждающийся процессор с минимальным TDP). Этот Acer надо сравнивать с базовой прошкой.

Ну так вот, согласно сайта производителя цена этого асера в этой комплектации — $999 (https://store.acer.com/en-us/laptops/ultra-thin/swift-5-pro-laptop-sf514-52tp-52lh — пруф)

Цена базовой прошки — 1300$ (https://www.apple.com/shop/buy-mac/macbook-pro/13-inch)

Да, она дороже, но.

У нее алюминиевый фрезерованный корпус (который вполне логично добавляет к цене)

У нее объективно лучший трекпад (стекло + haptic feedback вместо жидкого механического кликера, плюс монолитная конструкция без механически подвижных частей, за исключением датчика силы нажатия с минимальным люфтом)

У нее экран высокой плотности, а не full-hd. С очень большой долей вероятности с лучшей цветопередачей.

У нее тандерболт 3.

У нее мощнее графика (645 против 620)

У нее лучше динамики.

Если сравнивать этот Acer с Air (чего все-таки не стоит делать), то все еще грустнее для асера. Базовый эйр с такими же характеристиками стоит те же $999. И про экран, корпус, тачпад и тандерболт — это все к эйру тоже относится в полной мере.

При этом я ни в коем случае не утверждаю что Acer — плохой ноутбук. Нормальный. Скорее всего он с очень хорошим дисконтом в том магазине, который вы привели (скорее всего потому что никто не берет — msrp вы видели) и вероятно с этим дисконтом он стоит того. Однако он объективно дешеле техники Apple.

Это и есть основной плюс не apple ноутов, можно максимизировать только нужные тебе параметры, забить на то что не нужно и заплатить при этом в полтора-два раза меньше.

Но высокую цену я им вменить в вину не могу. Ну точнее да, они конечно дорогие, но они не в вакууме. Другие производители вокруг тоже делают железки и эти железки при том же наборе характеристик (помимо ТТХ в этот набор входит корпус из «премиальных» материалов, тандерболт, hi-dpi дисплей с хорошей цветопередачей, быстрые nvme ссд, а не древние sata ssd, качественные динамики и т.д. и т.п.)

Вам может быть все это неинтесно и это абсолютно нормально. Но если вам все это нужно то у вас нет выбора между маком задорого и не-маком задешево, есть выбор между моделями разных производителей в +- одну и ту же цену).

Еще раз — если кому-то это все не нужно, прекрасно, можно сэкономить и купить машинку попроще, я вообще на хромбуки пересел и доволен как слон, сильно больше макоси нравится.

И может быть алюминиевый корпус не лучше пластикового (хотя по жесткости все-таки объективно лучше), но он дороже. Как и все остальное перечисленное.

И поинт мой всю дорогу как бы в том что машинки с аналогичным набором характеристик от других производителей стоят ровно столько же. Что либо делает макбук не оверпрайснутым, либо делает оверпрайснутым не только макбук (но на самом деле не делает, они объективно столько стоят).

Кстати о высокой плотности. Как мне настроить 100% масштабирование у макбука?

Поставить https://github.com/avibrazil/RDM или любой аналог.

Вопрос в том, нужна ли эта комплектация. Недавно я собрал ПК на Ryzen 3600 и RX5700XT где-то за 90 тыщ. руб. Мой товарищ меня убеждал, что все это ерунда, и что надо брать моноблок iMac тысяч за 150, с каким-то i5 одного из предыдущих поколений и ГПУ на уровне RX580. На мое замечание о неадекватном соотношении цены и комплектующих, он возразил, что у iMac 5K экран, который сам по себе будет стоить где-то от 100 тысяч руб. Но если мне не нужен 5К экран в довесок к посредственному железу, то я предпочту собрать кастомную конфигурацию, которая удовлтетворяет моим потребностям.

Когда через несколько месяцев выйдут первые Apple Silicon Mac, мы будем знать больше

Действительно.

А сейчас как-то рано делать какие-то выводы или прогнозы.

Не создавший ничего, что как-то серьезно повлияло на рынок.

Сильнейший специалист. Его мнение, несомненно, очень важно для нас.

Если создатель Newton и BeOS

Каким образом бездарный барыга вдруг стал «создателем BeOS и Newton»? Гассе — типичный «эффективный менеджер».

Каких успехов при нем добилась Apple? Правильно, никаких. При нем она скатилась в УГ. Жадный барыга хотел иметь большую наценку, в результате чего Apple стала закономерно терять долю рынка. В результате сам Гассе получил пинка под зад.

Потом он организовал Be Inc., в которую пришли в т.ч. сотрудники Apple, которые и создали BeOS. И опять жадность барыги сыграла свою роль и похоронила систему, когда он не согласился на предложение Apple. Вместо этого Apple купила NeXT и вернула Джобса, с которым достигла фантастического рыночного успеха. А где сейчас BeOS и Be Inc.?

Оба случая демонстрируют профнепригодность.

Что там у нас еще? Ах да, гендиректор Palm (на самом деле нет — председатель совета директоров, и не Palm, а PalmSource). И закономерное отсутствие успехов на новом месте.

Так что с историей IT (и здравым смыслом) у меня все ОК.

То, что какой-то клоун занимает важный пост, не делает его менее клоуном.

Такой же бездарный и безграмотный клоун Рогозин был аж вице-премьером, а потом на должности главы «Роскосмоса» хохмил про космический батут. Но американский батут таки работает, а «Роскосмос» под руководством клоуна и «эффективного менеджера» только обещает.

А вы упорный.

Совершенно верно. Очень.

Ну что же, пройдёмся по фактам:

Это правильно. И желательно по фактам, а не по «фактам».

Гассе был исполнительным директором Apple Computer с 1981 по 1990

И начать можно с того факта, что Гассе был исполнительным директором отнюдь не с 1981 года.

Я верно понял, что Apple в период с 81-го по 90-й годы в вашем понимании «унылое говно»?

Нет, неверно. Apple скатывался в УГ, терял долю рынка и стоимость акций, за что Гассе потом и выкинули на мороз. Или по-вашему Скалли сделал это из зависти к успехам Гассе?

Простите, а вы всерьёз считаете, что глава компании — всего лишь жадный барыга, который наживается на труде рабочих?

Нет, я считаю, что именно Гассе — жадный барыга. Только наживаться он хотел не на мифических «бедных рабочих», а на покупателях продукции, неважно Apple или BeOS.

Ну попробуйте увести талантливых программистов из Apple/Google и создайте свою OS и свой комп под неё

Наверное не следует сравнивать рядового человека со стороны и многолетнего руководителя? Джобс тоже при своем уходе увел кучу народу и создал свою ОС. Это вообще совершенно обычная ситуация. Гассе тут не стал каким-то исключением из правил.

В реальности имело место гениальное умение Джобса продавать несуществующий продукт. Он сделал настолько крутую презентацию NextStep и её перспектив, что совет директоров купил его компанию

И как, они прогадали? Или все же оказались правы?

Но нет, решила крутая презентация.И неадекватные ценовые запросы Гассе. Мало ему было быть столбовой дворянкой, а в таких случаях обычно остаются с разбитым корытом. Гениальный управленец, чо.

а вовсе не шантаж вендоров со стороны Microsoft в виде прямого запрета ставить BeOS на новые компы под угрозой потерять лицензию на Windows

Microsoft угрожала Яблоку не продавать ему лицензии на Windows? Ишь какая страшная угроза!

Не будь Гассе таким жадным, BeOS продолжала бы жизнь на Маках, и угрозы Microsoft ничего тут не смогли бы изменить.

А ничего, что

Ничего. Джобс создал саму Apple для начала. И NeXT он-таки сумел вытянуть, пусть даже продав Яблоку. Да, сумел продать, сумел доказать перспективы. Много-много раз сумел. В отличие от Гассе и Be inc., который регулярно «ну нишмагла я, нишмагла». Крупнейшее достижение — настучал на Джобса, если бы не оно, то никто и имени его сейчас не знал бы.

Не вижу больших отличий между бизнесами «Next-NextStep-Джобс» и «BeBox-BeOS-Гассе».

Ни малейших, конечно. NeXT шикарно живет в виде MacOS. А BeOS осталась только в анналах, не имея существенного коммерческого успеха, о чем я и написал в первом же комментарии, на что меня обвинили в незнании IT-истории. Очень смешно.

Там же, где и Norton, Borland, Netscape и OS/2

Все вышеперечисленное было успешными и популярными фирмами/продуктами. Be не снилась даже тысячная доля от их распространенности.

До такой степени, что влюблённые фанаты уже 18 лет пилят Haiku.

Пусть пилят. К рыночному успеху это не имеет ни малейшего отношения.

Другие фанаты создали Linux, и он используется на миллиардах компьютеров. И это успех.

Кончайте уже позориться и называть талантливых людей барыгами и клоунами.

Талантливым был Джобс, талантливыми были создатели BeOS. А Гассе был, есть и будет только клоуном, стукачом, подсидевшим Джобса и занявшим после этого его место, и бездарным барыгой, профукавшим по своей жадности и недальновидности отличный продукт. Единственный его талант — делать вид, что он гениальный управленец. Но результаты говорят сами за себя: он слил всё, за что брался.

Так что клоунов и барыг я буду называть именно клоунами и барыгами.

Работает вполне себе неплохо. Уж получше х86 в таком формфакторе.

Galaxy Book S недавно выпустили с Lakefield. Результат — полный провал.

videocardz.com/newz/intel-core-i5-l16g7-lakefield-processor-tested

Плохое время жизни от батареи, троттлинг и на CPU и на GPU.

Он даже в однопотоке до паспортных частот не достаёт:

This is mainly due to limited maximum clock speed oscillating around 2.4 GHz. The editor says that he couldn’t observe advertised 3.0 GHz boost clock during his tests.

GPU LKF по производительности примерно аналогичен Snapdragon, когда не троттлится :)

Gaming is not great on the Galaxy Book S. The graphics performance drops after a little while (Fire Strike stress test not passed at 82%) and even simple titles hardly reach playable frame rates, which is also a result of the low CPU performance.

Intel скинет немного рынка

Немного? :) У Macos около 10% рынка, которые до недавнего времени использовали только интелы. Т.е. интел одномоментно лишится 10% рынка. Это прям очень много, особенно на фоне того, что им сейчас нечего предложить против амд.

Просто напомню что есть еще рынок серверов и высокопроизводительных рабочих станций, где у Apple доля ощутимо меньше.

Как бы Apple об этом уже сказала.

Примеры из истории —

Планшеты были до iPad, но iPad сделал революцию.

Умные телефоны были и до iPhone.

Думаю, что в Apple решили, что время ARM на десктопе пришло.

Опыт на iPad Pro показал, что «да все готово».

На серверах ARM придет, когда Apple начнет продавать свое облако на ARM.

Я думаю, даже когда это случится, многие будут еще некоторое время проходить стадии принятия.

Даже сейчас многим людям тяжело признать, что ноутбуке\серверах, амд лучше по всем параметрам. Я так и не понял до сих пор, почему даже имея на руках факты, люди не могут это принять сразу.

А тут, когда ты можешь уже взять свой телефон, скомпилировать любой бинарь и запустить прямо на устройстве, люди продолжают делать какие-то ложные предположения, устраивать срачи.

Как будто х86 им мать родная. Это на столько глупо придерживаться какого-то лагеря. Вы же в первую очередь сами выигрываете от такого положения дел.

С arm всё не так — софт, который поддерживает эту архитектуру, нужно как минимум перекомпилировать, а что-то более редкоиспользуемое и/или старое вообще не заведётся никак.

Это очень интересный вопрос, потому что arm на amd64 (на маке) запускается в докере на ура.

/ес-но через эмуляцию/

Остается только, чтобы на арм платформе хоть как-то работала эмуляция amd64 и дело в шляпе

А под Windows большинство приложений пишется под .NET.

То, переход под arm, это просто проблема времени и денег.

Да ситуация точно такая же. Просто другой уровень. Какая разница мне как потребителю, х86 или аарч64? Конечно никакой, мне важен перформанс и потребление.

И в отличие от грязного мира х86, где все так огорожено патентами и не подъемной лицензией, армы это как свежий глоток воздуха для конкуренции.

Даже если сейчас будет чуточку сложнее, завтра выиграете от этого вы лично. Пусть какой-то редкий софт сейчас не запускается, но это не повод быть под гнетом монополии.

Это как не менять президента какой-то гипотетической страны, ибо первое время будет хуже. И что теперь, всю жизнь страдать со старым маразматиком?

Пусть какой-то редкий софт сейчас не запускается,

Это, безусловно, повод радоваться что не сможешь сделать свою работу нормально или результатами мало кто сможет воспользоваться?

но это не повод быть под гнетом монополии.

Да да… будет зоопарк как мобильных приложения. Каждый себе напихает «новый-пупер-модуль-который-делает-ЗБСЪ!» и под него заточат прикрутят пару-тройку приложений. Потом или будут писать приложения под «минимальный набор как у всех» и будут удивляться «А что за хрень ?!» или будут «ноубук для экселя» и «ноутбук для фотошопа» и «ноутбук для поиграться». Проходили уже такие вещи (математические сопроцессоры, GPU, крипто и векторые вычисления и т.д.) — добром это не кончилось, ибо получились «CPU, который может все, но хреновенько и жрет как не в себя» поскольку все хотят «все и сразу» не сильно напрягаясь и бесплатно.

Это как не менять президента какой-то гипотетической страны, ибо первое время будет хуже. И что теперь, всю жизнь страдать со старым маразматиком?

Можно страдать с новым «с расстройствами личности» :) Скучно, как со «старым», точно не будет :))) Так себе альтернатива.

Не получится обмануть физику и экономику.

— или быстро и дешево но нифига не универсально (спец модули\ускорители)

— или универсально дешево, но нифига не быстро — (cpu без наворотов)

— или быстро и универсально но нифига не дешево — (cpu c наворотами, модульные решение (CPU + GPU + ...), облака, суперкомпьютеры и т.д.)

Во-первых, в режиме эмуляции все работает и работает неплохо.

Или софт никому не нужен, ибо то, что нужно и не заброшено — будет перекомпилировано.

Можно страдать с новым «с расстройствами личности» :) Скучно, как со «старым», точно не будет :))) Так себе альтернатива.

Это уже все давно предусмотрено специальными процедурами. Сменяемость власти, импичмент и прочая «муть», которую можно конечно игнорировать силовыми путями.

Не получится обмануть физику и экономику.

Это глупость, ибо ограничения не физические\технические\интелектуальные.

То, что интел кормил мир своим 14нм — не технические трудности.

Они просто решили, что раз у них нет конкуренции, то и делать ничего не надо. Это как шахматная партия. Они сдали атомы, потому что с армами на одинаковых техпроцессах они не шли ни в какое сравнение.

Но решили подоить мир на серверах и десктопах.

И у них это успешно получалось, но всему приходит конец.

На серверах уже неплохо себя показал Reference Implementation на армах, уже молчу про амд, он там сейчас правит.

Телефоны уже давно проиграны. Ноутбуки на райзенах сейчас не идут ни в какое сравнение даже с 10нм интела.

Остался десктоп, где нет ограничений по тепловыделению и потреблению.

И раз вы затронули физику. То идите дальше и смотрите на фундаментальные физические ограничения. Конкретно, но просто.

Например закон сохранения энергии и прочее.

Или софт никому не нужен, ибо то, что нужно и не заброшено — будет перекомпилировано.

Вот-вот, это основная причина, почему я с опасением смотрю на такое резкое продвижение arm во все компьютеры. Не запустится старый софт, часть которого имеет закрытые исходники, а часть не компилируется новыми версиями компилятора? Ну и пусть, зато прогресс.

При этом рядом вы пишете про эмуляцию — казалось бы, если x86 эмулируется, то какая разница заброшен софт или нет? Берёшь и запускаешь.

Мне действительно интересен этот вопрос и я не знаю, как сейчас дела обстоят касательно «полноценности» эмуляции.

Таких будет единицы. И если софт реально уже не поддерживается, то должен умереть. На его место придут новые. Эмуляция медленнее, но не поддерживаемый софт быстро работать не должен.

Это звучит радикально, но дело в том, что нет никакого другого пути.

И это продвижение не такое уж резкое. Просто обычные пользователи не обращали на это внимание. Многие до сих пор отрицают это явление, но тут уже клиника.

На рынке миллиарды арм устройств, для которых сейчас пишется софт. Десктоп тут уже не в топе давно.

Линукс со всем репозиторием уже давно на арме работает.

Еще в 2010м году запускал убунту на телефоне с арм и качал торренты через transmission.

Не получится обмануть физику и экономику.

Это глупость, ибо ограничения не физические\технические\интелектуальные.

То, что интел кормил мир своим 14нм — не технические трудности.

Это как раз экономические :) Не смогли они осилить следующий техпроцесс для своих процессоров, в то время как Samsung, TSMC, GlobalFoundries вполне смогли.

Полагаю Интел вполне знакомы с тем, что уменьшение размера чипа уменьшает себестоимость? Эти уж точно были бы рады такому пути.

Они просто решили, что раз у них нет конкуренции, то и делать ничего не надо.

А что серверное было предложеннии? неудачный бульдозер для отдельного класса задач которые оказались широко распространенными?

Это как шахматная партия. Они сдали атомы, потому что с армами на одинаковых техпроцессах они не шли ни в какое сравнение.

Когда делались и проектировались Atom вопросы «дешево и достаточно производительности» только появились, а Arm только только начали делать первые шаги на мобильных устройвах и планшетах (не серьезно считать «пошаговые стратегии» при открытии книжек или ICQ на КПК при разрешении 320х240). Не нужно сравнивать 10...5 лет назад и сейчас. Если так уж хочется — надо бы сравнивать Intel XScale с чем-то того-же временного отрезка. У AMD процессоры «AMD Opteron A» серии.

И раз вы затронули физику. То идите дальше и смотрите на фундаментальные физические ограничения. Конкретно, но просто.

Например закон сохранения энергии и прочее.

Спасибо, конечно, за подсказанное направление. Но в общем-то то известные проблемы — разрешение литографического оборудования (физика ?) и его цена (экономика?), цена производства кристалла и брак (экономика?), токи утечки (физика ?), нелинейное возрастание преобразование потребляемой электроэнергии в тепло при возрастании частоты (физика ?), теплоотвод от малой площади кристала (физика ?) ну и всякие побочные спецэффекты вроде подвижности зарядов и длинных линий при высоких частотах (физика?).

Пока никому не удалось этот клубок «распутать». Arm «решает» эти проблемы всякими big.LITTLE\DynamIQ что там насчет последних «ARM Cortex-X1» и «ARM Ethos-N..»? Наверное «Cortex-X Custom (CXC) program» ARM придумала от нечего делать?

Это как раз экономические :) Не смогли они осилить следующий техпроцесс для своих процессоров, в то время как Samsung, TSMC, GlobalFoundries вполне смогли.

У вас свой какой-то мир. Откройте вики хотя бы для начала.

Они не то что не могли. Они не захотели. Они еще в 2011 году заплатили ASML за разработку в уход в глубокий ультрафиолет.

И эта технология давно уже была готова.

У вас свой какой-то мир. Откройте вики хотя бы для начала.

А зачем вики, если можно первоисточники глянуть и сравнить?

Intel готовится к релизу первых настольных процессоров с 7-нанометровой топологией. Их выпуск может состояться в 2022 г., и в них ожидается поддержка памяти DDR5 и интерфейса PCI-Express 4.0.

Intel CFO: “10nm isn’t going to be the best node that Intel has ever had”

2019 Investor Meeting: Intel Previews Design Innovation; 10nm CPU Ships in June; 7nm Product in 2021

и новости агуста-сентября 2018 г.

Компания AMD представила серверные 64-ядерные процессоры Epyc Rome на базе новой архитектуры Zen 2 с нормами технологического процесса 7 нм, и с новой многокристальной компоновкой Chiplet Design.

Уже в 2019 г. AMD намерена перевести все свои процессорные линейки на архитектуру Zen 2 с нормами 7 нм. Сейчас, по данным компании, уже начаты поставки первых образцов процессоров Epyc поколения Rome на базе этой архитектуры ключевым заказчикам.

All Of AMD's 7nm Processors To Be Manufactured At TSMC

Может у интел и AMD тоже свой мир? :)

О чем вы вообще говорите. Основное оборудование для литографии всем поставляет одна компания. Не может такого быть, что самсы сделали, а интел не смогли.

Насколько я помню, у AMD\Samsung\TSMC и Intel используются разные изоляторы в полупроводниках. Из-за этого Intel и наступила на «физические грабли» с токами утечки и тепловыделения и технологически уперлась в тупик. Техпроцесс включает не только литографию, но из состав полупроводников из-за присадок разные и это влияет на дизайн чипов.

В смысле какую точку зрения они якобы отстаивают?

используют разные изоляторы в полупроводниках. Из-за этого Intel и наступила на «физические грабли» с токами утечки и тепловыделения и технологически уперлась в тупик.

И 6 лет они никак не хотели пробовать новые материалы.

Зачем вообще вы приводите эти бредовые догадки. К чему они? Вы не можете знать на таком уровне что там происходит.

Можно только оперировать теми фактами что есть. Куда вас вообще всех несет. Изоляторы у них не той системы…

Зачем вообще вы приводите эти бредовые догадки. К чему они? Вы не можете знать на таком уровне что там происходит.

Это физика, и ее практическое ответвление — электротехника. Говорят, если ее учить в школе, а после, в специальных учебных заведениях — догадки не очень нужны. А еще говорят, что знание немногих принципов освобождает от знания многих фактов.

Можно только оперировать теми фактами что есть. Куда вас вообще всех несет. Изоляторы у них не той системы…

Может обратимся к первоисточникам, истории, чуть к перспективам и «магии» станет чуть меньше?

Есть логический дизайн чипа, есть физический дизайн чипа, есть материалы из которых изготавливают, отработанный техпроцесс травления, промывки, нарезки, упаковки, рисования масок и т.д.

Но вашему «просто попробовать» это 5 минут работы? Это нужно заново сделать физической дизайн кристалла, оттестировать и запустить в процесс производства. На это уходят годы!

Они просто решили, что раз у них нет конкуренции, то и делать ничего не надо.

Это мягко говоря неправда.

«Intel continues its Tick-Tock domination, with 10nm CPUs arriving in 2016, and 7nm CPUs in 2018»

Они столкнулись именно с техническими трудностями, которые полностью не могут решить до сих пор.

Остался десктоп, где нет ограничений по тепловыделению и потреблению.

Они там точно такие же, разве что несколько более расслабленные.

Все десктопные процессоры ограничены по тепловыделению. Иначе бы они работали на максимальной частоте на всех ядрах без ограничений.

Это мягко говоря неправда.

14нм запустили в 2014м году. И ваша статья 1-е декабря 2014 года. Технические трудности были и будут всегда.

Понятно, что тогда у них могли быть какие-то трудности, но к этому моменту они все уже решились бы давно, если бы хотели.

О чем вы вообще говорите. Основное оборудование для литографии всем поставляет одна компания. Не может такого быть, что самсы сделали, а интел не смогли. Интел даже сейчас технически самый продвинутый из них. Вы другие статьи более технические почитайте на тему, раз решили влезть в историю.

Все десктопные процессоры ограничены по тепловыделению.

Ну блин, это очевидно, что ограничения в принципе есть. Тут не детский сад, чтобы такое разжевывать. Вопрос в количестве. Все в нашем мире ограниченно так или иначе

И ваша статья 1-е декабря 2014 года.

И? Посмотрите Интеловский слайд с планом выхода техпроцессов.

В 2014-м году 10нм уже находился в разработке. Тик-ток всё так же работал без сбоев. Ничего не предвещало беды.

У контор типа Интел всё расписано на годы вперёд. Ваше заявление "Они просто решили, что раз у них нет конкуренции, то и делать ничего не надо." это просто чушь.

Основное оборудование для литографии всем поставляет одна компания.

Инструменты одинаковые, а техпроцессы очень разные, с разными параметрами, разными материалами.

Дайте разным людям одинаковые инструменты, но дома они построят разные.

Интел даже сейчас технически самый продвинутый из них.

Самый продвинутый, который смог выпустить только двух-ядерник на 10нм со смешными частотами и низком Yield-е, отстав на два года от собственного плана? А спустя 2 года на новом 10нм техпроцессе родил 4-ядерник со всё ещё низкими частотами?

Вы другие статьи более технические почитайте на тему, раз решили влезть в историю.

Воспользуйтесь своим советом.

Ну блин, это очевидно, что ограничения в принципе есть

Они «не в принципе есть», а для многоядерных процессоров только они и есть.

И? Посмотрите Интеловский слайд с планом выхода техпроцессов.

В 2014-м году 10нм уже находился в разработке. Тик-ток всё так же работал без сбоев. Ничего не предвещало беды.

Господи. Вы думаете, что интел 6 лет не могла запустить новый техпроцесс? А самсунг и ТСМЦ пришли и сразу смогли, ага, конечно. Учитывая, что оборудование они все покупают в одном месте.

Инструменты одинаковые, а техпроцессы очень разные, с разными параметрами, разными материалами.

Дайте разным людям одинаковые инструменты, но дома они построят разные.

Ну это комментировать вообще бесполезно. Это не хлебопечка, вы не можете играться там с материалами разными.

Короче у вас нет пруфов, простите, но я больше не буду вести с вами диалог. Вы пишите глупости, основанные на каком-то собственном бреду.

Вы думаете, что интел 6 лет не могла запустить новый техпроцесс?

Да, именно так. Об этом не писал только ленивый.

Это не хлебопечка, вы не можете играться там с материалами разными.

www.intel.com/pressroom/kits/advancedtech/doodle/ref_HiK-MG/high-k.htm

fuse.wikichip.org/news/525/iedm-2017-isscc-2018-intels-10nm-switching-to-cobalt-interconnects

www.quora.com/Why-is-Intel-pursuing-Cobalt-but-TSMC-and-Samsung-are-not-and-how-much-of-an-advantage-is-Cobalt-over-Copper-interconnects

Короче у вас нет пруфов, простите, но я больше не буду вести с вами диалог. Вы пишите глупости, основанные на каком-то собственном бреду.

Откуда вы знаете что у меня их нет?

А у вас какие пруфы? «Я так сказал и точка?»

Ну да, с таким весомым пруфом даже личное признание какого-нибудь топ-менеджера TMG под присягой не будет значения :D

Несбывшиеся планы Интел, ровно как неудавшиеся попытки выкатить 10нм — мы видели воочию в последние несколько лет.

Вы живёте в альтернативной реальности, походу.

www.notebookcheck.net/Intel-admits-that-the-10nm-process-is-doing-poorly.456063.0.html

Нельзя остановить конвейер просто потому, что вам так захотелось.

Не поленился и посмотрел ссылки. Нигде не сказано, что кобальт там или что-то ещё привело к проблемам.

Но предполагать, что техспецы в интеле дураки и они не попробовали, что лучше… ну ок.

Я просил пруфы, что Интел по техническим причинам, реально не смогла в 10нм. Но я сомневаюсь что вы такое найдете )

Ну потому, что такое ну совсем глупо предполагать.

У меня пруфов нет, но я основываюсь на фактах хотя бы. 14нм интела в виде готового продукта очень хорошо себя чувствует. Да даже если бы у них были какие-то проблемы, они бы это уже решили давно, если бы хотели.

Другое дело, что новый техпроцесс стоит много денег и это уже реальное препятствие. Это просто здравый смысл.

Все "пруфы" с 10нм что вы сейчас найдете будет 2019+, когда они очнулись и в торопях начали этот 10нм делать. Но это никак не означает, что раньше у них были с этим проблемы.

Все «пруфы» с 10нм что вы сейчас найдете будет 2019+, когда они очнулись и в торопях начали этот 10нм делать. Но это никак не означает, что раньше у них были с этим проблемы.

А если посмотреть внимательно?

Intel: We Will Not Skip 10nm For 7nm, Ice Lake On Track For End Of 2020 Launch

Here is what Intel had to say, however:

So again it's a scenario where there is a lot of goodness in 10-nanometer that carries forward to 7-nanometer. And quite frankly, we're at a point in 10-nanometer where we have come through [ph] the order of (00:31:19) disentangling the core fundamental technology issues. And we're now in a point where we're ramping in high volume production

Начальные планы:

Результат:

Выступая на конференции UBS, Венката «Мурти» Рендучинтала (Venkata Murthy Renduchintala) вернулся к обсуждению причин, вызвавших задержку с переходом Intel на 10-нм техпроцесс. Желание сохранить действие так называемого «закона Мура» в своё время заставило Intel выбрать достаточно агрессивную цель по масштабированию плотности транзисторов – она должна была увеличиться сразу в 2,7 раза. Само по себе такое масштабирование не было единственным источником проблем. Как признался Венката, компания на ранних этапах разработки 10-нм технологии предусмотрела несколько нововведений в сфере литографии, которые должны были обеспечить нужный уровень масштабирования плотности. Казалось, что по отдельности они работали без проблем, но в сочетании всё оказалось не так, как предсказывали специалисты Intel.

Итог этих просчётов хорошо известен – 10-нм техпроцесс пришлось задержать на два года относительно первоначального срока. В этом контексте нужно помнить, что первые 10-нм процессоры в лице Cannon Lake формально вышли на рынок в 2018 году,

Во время финансового отчета Intel глава компании Брайан Кржанич сообщил, что производство чипов на 10 нм технологическом процессе задерживается. Теперь запуск 10 нм-продуктов состоится не во второй половине 2018 года, а в 2019 году. При этом он не может сказать, в первой половине или второй.

Это еще один неприятный поворот в истории перехода Intel на 10 нм, что и так не соответствует оригинальным планам. По словам Брайана инженеры выявили проблемы с эффективностью 10 нм техпроцесса, однако масштабирование производства может занять более года.

Мы продолжаем развивать наш 10 нм техпроцесс. Мы уже осуществляем небольшие поставки, а эффективность производства растет, однако скорость оказалась ниже, чем планировалось. В результате этого масштабный выпуск передвинут со второй половины 2018 года на 2019 год.

Сами представители Intel говорили «Упсъ! Ну не смогла я, не могла...» Смысл додумывать что-то за производителя?

Но я сомневаюсь что вы такое найдете )

Ну потому, что такое ну совсем глупо предполагать.

Зачем что-то предполагать, если они сами об этом говорили чуть ли не прямым текстом.

У меня пруфов нет, но я основываюсь на фактах хотя бы.

Просто потрясающе. О каких тогда (альтернативных) фактах идёт речь?

Напомнить что было, когда Интел вместо ожидаемого Cannon Lake на 10нм выкатили Kaby Lake на 14нм в 2016?

www.fool.com/investing/general/2016/01/18/what-is-the-name-of-intels-third-10-nanometer-chip.aspx

Management has told investors that they are pushing to try to get back to a two-year cadence post-10-nanometer (presumably they mean a two-year transition from 10-nanometer to 7-nanometer)

14нм интела в виде готового продукта очень хорошо себя чувствует.

Ага ^_^ Ядро TGL, которое они делали под 10нм для выпуска в 2018г пришлось портировать под 14 нм для того чтобы хоть что-то вы пустить на десктоп в 2020г.

Это факты.

Напоминаю, конвейер не остановить. Разработка процессора в Интел занимает 5 лет. Если вы даже на 1 год затянете выпуск, эти люди должны что-то делать. А получилось, что делают они то, что не могло быть выпущено.

Все «пруфы» с 10нм что вы сейчас найдете будет 2019+, когда они очнулись и в торопях начали этот 10нм делать.

Признайтесь, вас держали в пещере и только недавно выпустили?

Вы пропустили 10нм процессор Интел в 2018г? i3-8121U

Надо полагать, что полностью остановить все они не могут, ибо потом не запустят.

Но и торопиться им не к чему.

Ну и это слишком маловероятно, что 2 компании уже 5нм запустили, а там на секунду EUV.

Отговорки на дурака

Ну так вы путаете экономическую целесообразность и техническую возможность.

Т.е. компания Интел всегда хвалилась своим тик-током и нон-стоп лидерством, а потом вдруг расхотела ^_^

company’s plans to start commercial shipments of its “Cannonlake” processors for mobile devices in mid-2016

www.kitguru.net/components/cpu/anton-shilov/intel-we-will-reveal-schedule-for-10nm-chips-later-this-year

Я конечно понимаю, что с вашей стороны идёт толстый троллинг, а я и Lofer вас кормим, но гулять — так гулять, и я не смог удержаться и описал что происходило в вашей альтернативной реальности:

Пустив crackpipe по кругу, Совет Директоров решил:

«Воу, двухлетний цикл это слишком быстро, давайте сделаем 6-летний!

Неплохо бы сломать весь конвейер разработки — пусть одни люди сидят без работы, а другие делают что-нибудь ненужное, а мы потеряем бабло и дадим конкурентам преимущество.

Но инвесторам — то тупым идиотам, пообещаем вернуться к двух-летнему.

Вот развели лохов!

Давайте сделаем ядра под 10нм, а потом их же выпустим на 14нм, ведь у нас слишком много денег. Нужно что-то с этим делать!

Так же срочно нужно построить фабрику D1X, но разумеется ничего на ней производить не будем, а если спросят, скажем что запустили пилотное производство 10нм :)

Давайте растянем запуск производства Cannonlake года этак на два. Чтобы был низкий выход годных чипов, будем ссать на пластины. А сам процессор нужно сделать как можно более жрущим и работающим на низкой частоте. Ядер конечно нужно делать не больше двух! GPU можно сделать, но он всё равно будет выключен.

Пипл схавает!

Разумеется, выпустить нужно очень маленькую партию.

Так можно потратить много денег на настройку производства и меньше заработать.

Потом мы будем ещё 2 года разрабатывать новый техпроцесс, а чтобы поглумиться над юзверями, будем для ноутов выпускать 10нм чипы с низкой частотой и 4 ядрами, и одновременно 14нм чипы с большой частотой и 6 ядрами, чтобы эти лошары совсем запутались!»

Я ничего не упустил? Всё так и было? :)

Но и торопиться им не к чему.

Да, надо подождать, когда AMD с 5нм займёт значительную долю рынка.

Отговорки на дурака

Известно, что на собрании инвесторов можно скармливать любую дичь ^_^

а потом вдруг расхотела

Когда каждый тик стоит десятки миллиардов долларов?

Вы строите теории заговоров вокруг коммерческой компании. Когда все легко объясняется деньгами.

АМД в свое время так же стала фаблес, ибо у каждого тика есть окупаемость. И когда АМД, нвидиа, эппл, квалком и куча других компаний делают процы на одном заводе, и Интел только у себя…

Люди любят заговоры )

Когда каждый тик стоит десятки миллиардов долларов?

Вы строите теории заговоров вокруг коммерческой компании. Когда все легко объясняется деньгами.

Именно деньгами все и объяснятся.

Уже в 2016 году Intel начала подстилать соломку Intel отказывается от стратегии «тик-так»

Нужно было сохранить\удержать деньги инвесторов и не допустить падения акций, в противном случае деньги ушли бы «кому-то еще» (АМД, Nvidia, Apple и т.д.), а деньги вкладывают «в растущие», а не «тонущие».

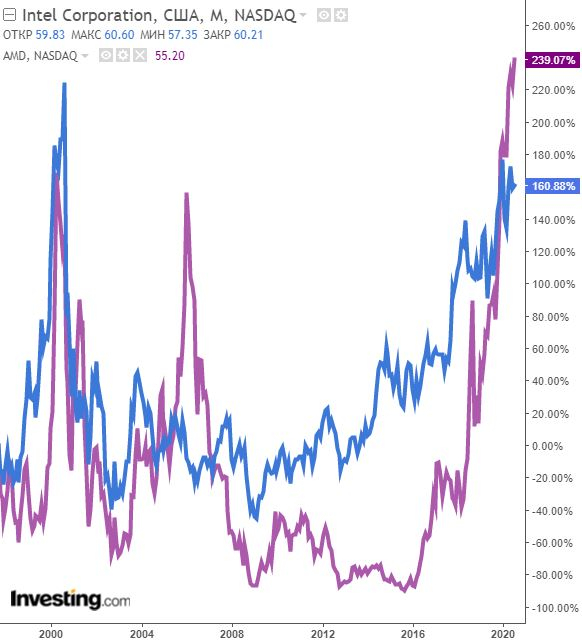

График стоимости акций Intel (синий) и AMD (фиолетовый). Нет новых продуктов — акции не растут, новый продукты появились — акции пошли расти.

По странному стечению обстоятельств а 2016 году «оказывает от Тик-Так в польз более прогрессивной и полезной для клиентов стратегии», в то же время 10нм буксуют, intel официально признает «не смогла, надо еще года два пилить техпроцесс». А как отладили 10 нм так официально объявили в конце 2019 "Также представитель Intel заявил, что компания намерена вернуться к своему старому графику крупных обновлений раз в 2-2,5 года. Речь о пресловутом графике «тик-так», когда новый техпроцесс и новая архитектура внедрялись примерно раз в два года. "

Если выглядит как утка, крякает как утка, плавает как утка, гадит как утка — это, скорее всего, утка.

Все остальные производители окупали новый техпроцесс вместе, в то время, как интелу для запуска нового техпроцесса придется долго его отрабатывать.

И сейчас перед ними стоял и стоит не простой выбор. Либо тратить тонны денег и выпускать 7нм, когда конкуренты уже вовсю осваивают 5нм EUV или заказывать свои чипы на TSMC, что негативно может сказаться на цене на рынке акций.

Но они некоторые свои чипы, не ЦПУ, уже выпускают на других заводах вроде. То ли optane то ли что-то еще.

Вероятно интел останется на 10нм, а последующие версии будут заказывать.

Это еще не считая того, что не факт далеко, что ASML готова им прямо завтра выдать все необходимое оборудование, сколько бы оно там не стоило, они надо полагать тоже не резиновые.

Вы строите теории заговоров

Это вы, как человек, который отрицает слова менеджеров Интел, отрицает все объективные факты, отрицает материалы аналитиков и журналистов, мне говорите? ^_^

Жир тут не просто уже капает, а гигантский столб раскалённого жира приближается к Луне.

Но нужно больше!

Тут английская поговорка от Lofer подходит как нельзя лучше.

Если выглядит как утка, крякает как утка, плавает как утка, гадит как утка — это, скорее всего, утка.

Интел постепенно отказывалась от этого тик-така, ибо это дорого, особенно, если в этом нет необходимости прямой.

Компания, которая торгуется на рынке не выйдет и не скажет: «вы знаете, мы тут решили подоить наших кастомеров, поэтому не запускали 10нм на всю катушку»

Это же реально выглядит как детский сад. Уж извините, если вы хотите верить в то, во что вы хотите, то никакие аргуементы и здравый смысл тут не помогут.

www.tomshardware.com/news/intel-announces-delay-to-7nm-processors-now-one-year-behind-expectations

«The company's 7nm-based CPU product timing is shifting approximately six months relative to prior expectations. The primary driver is the yield of Intel's 7nm process, which based on recent data, is now trending approximately twelve months behind the company's internal target.»

Выход годных катастрофический =)

Но конечно же «они всё врут»(с)

Давайте спросим ваш бредогенератор, в чём же «истинная»(tm) причина задержки.

Забавно, они ещё и на штрафные санкции могут попасть, если не поставят свои GPU для супера Aurora, который заказал DoE (проект и так уже задержан на 2 года). Наверняка в контракте это прописано.

Интел постепенно отказывалась от этого тик-така,

Да что вы говорите? ^_^

wccftech.com/intel-2021-2029-process-roadmap-10nm-7nm-5nm-3nm-2nm-1nm-back-porting

Starting off with the process roadmap, Intel will be following a 2-year cadence for each major node update. We got a soft launch of 10nm (10nm+) in 2019 which will be followed by 7nm in 2021, 5nm in 2023, 3nm in 2025, 2nm in 2027 and 1.4nm in 2029.

то никакие аргументы и здравый смысл тут не помогут.

Всё ещё жду от вас аргумент, хотя бы один :)

Как все сказанное ранее относится к вашим ссылкам?

Изъясняйте свои мысли точнее, не жалейте бумаги.

Начнем с начала. Ну ок, они отстают на полтора года с внедрением 7нм. Это по вашему сейчас доказало? Кто спорил с этим? Сам придумал сам поправил, молодец.

То же самое по второй. Мы тут с вами говорили про последние 6 лет, а вы кидаете планы, как космические корабли Интел будут бороздить космические пространства. Почти как Рогозин.

У вас кончились аргументы и вы решили написать хоть что-то?

AMD (NASDAQ: AMD) Shares Soar Over 16% as Intel Flounders in the 7nm Arena

Акции AMD рекордно выросли на фоне провала Intel — больше чем на 16%. Сейчас они торгуются по цене $69,40.

Причиной роста акций AMD журналисты называют недавний финансовый отчёт Intel по результатам второго квартала 2020. В связи с этим компания «синих» рассказала, что выпуск 7-нм процессоров сдвигается на шесть месяцев от запланированной даты.

В результате акции Intel упали. В настоящее время они торгуются по цене в $50,59, продемонстрировав падение на те же 16%. Положение усугубляют заявления различных аналитиков. Например, один из экспертов сказал: «Закон Мура не ждёт Intel». Также он добавил, что задержки «синих» положительно скажутся на AMD, которая теперь имеет преимущество в течение следующих трёх лет.

Полагаю, прения после этого перестают иметь какой-то смысл…

Вы ничего не перепутали? Это у ARM один лицензиант на всё, а у x86 есть как минимум три независимых источника.

Но я могу ошибаться, конечно, ибо сварщик не настоящий.

А снаружи к этим трём влезть, да, сложно — точнее, нет смысла: что-то уровня не выше SSE произвести может каждый, но зачем?

Но если вдруг ARM'у захочется кого-то не допустить к этой кормушке — у него будет сильно больше возможностей, чем у Intel или AMD, для которых в основном и перекомпилировать не надо.

Но если вдруг ARM'у захочется кого-то не допустить к этой кормушке — у него будет сильно больше возможностей

Вас ФАС за такое с говном съест. Это невозможно.

А если станет возможно, то у нас уже будет переход на АРМ и можем просто перейти далее на RISC-V и тому подобные.

Почему? Ему MIPS в затылок дышит, даром что кривее. Intel отъедает верхний сегмент. Нет тут никакой монополии…

> и можем просто перейти далее на RISC-V и тому подобные.

Можем. (Но сколько лет будем догонять?)

Это замечательно, что с хуавеем так поступили. Может они поумнеют и пойдут на риск-5. И сделают это первыми, а не как обычно по копирке обводить.

Команды процессора это контракт взаимодействия используемый миллионами. Если он может существовать в опенсорс, то туда ему и дорога. В софте как-то коллоборацию осилили вроде. Более менее

Не RISC-V единым.

стоит добавить его полусвободных коллег: power (OpenPOWER), sparc (LEON и OpenSPARC) и даже ARM, который «открыт и бесплатен» для некоторых категорий пользователей.

Только вот у RISC-V нет единой точки отказа — есть международная кооперация и множество центров развития. Даже центр координации теперь не в США, а в Швейцарии.

Так что разница гигантская.

И им конкуренты на этом рынке не нужны.

Это значит, что лицензия вам обойдется в такие деньги, что лучше не связываться. Поэтому никто и не связывается.

АРМ изначально идет по другому пути, у них другой подход, специально под лицензирование.

И даже АРМ конечно же не предел мечтаний. Набор комманд должен быть открытый по хорошему. Но это уже следующий этап.

Но на данном этапе, АРМ как некий стандарт(набора команд) не то, что лучше, а единственно разумный, если выбирать меж двух и не рассматривать всякие RISC-V.

Intel не продаст лицензии ни за какие деньги (ну разве что скупить Intel целиком), но есть AMD и VIA. Это принципиальная разница.

> Но на данном этапе, АРМ как некий стандарт(набора команд) не то, что лучше, а единственно разумный, если выбирать между двух

Скорее таки да. Intel безумен. AMD не сильно отстаёт. Но есть и другие факторы, начиная с объёма наработок.

Про Винду на ARM — даже не смешно, кто видел как это работает — тот знает почему.У как она работает? Вы на чем её видели?

Всякие Qt/Java, с ними конечно сложнее. Там с HDPI-то проблемы, не то что с компиляцией в виндовый arm.

Вроде в следующем же году собирались сделать эмуляцию x64 в винде(пока есть только x86), но пандемия двигает все планы ¯\_(ツ)_/¯

Dex — это когда телефон пордключается с монитору, клаве и мышке и выводит «взрослую» оболочку а не мобильную.

С учетом того, что приложения будут работать одинакого как на iPhone так и на iPad и Мак — это означает, что в будущем Apple просто предложит подключать iPad/iPhone к монитору и мышке (благо USB-C/Thunderbolt позволяют подключить всё через 1 порт).

И после подключения, все приложения просто переходят в режим OS X интерфейса, открывая ровно те же документы, что и пару минут ранее в iOS…

Таким образом, большинству достаточно будет иметь iPhone/iPad и сетап в виде монитора+мышки+клавы, экономя деньги на «компьютерное» железо.

Да и обновляться намного удобнее, купил новый телефон = купил новый компьютер.

PS На такое «скрещевание» намекает как минимум:

- в обратную сторону (приложения с iOS) на мак будут работать сразу на старте и из коробки.

- выпуск клавы и тачпада для iPad и адаптацию OS под это

Если Apple даст просто подключить iPad к монитору через стандартный type-c — это уже будет не Apple, это же бесплатный фукционал, не в их стиле, они должны переосмыслить и сделать платным.

Айпад сейчас подключается к монитору через usb-c

Pаботает с несколькими важными оговорками:

- Интерфейс отображается в режиме дублирования экрана, экран планшета при этом не отключается.

- Разрешение основного интерфейса не настраивается и не подстраивается под монитор.

- Type-C есть только на iPad Pro и на других ленейках заменять его не торопятся.

В текущем виде это можно использовать разве что для презентации, речь шла в первую про полноценную работу.

Покупатели iPad Pro — очень лояльные и платежеспособные клиенты, зачем лишать их возможности купить еще девайс или несколько? Если уж они придумали обоснование не делать калькулятор, то как и почему не давать делать рабочую станцию из планшета они придумают.

Все вышесказанное не относится к развитию планшетов как трансформеров в подобие ноутбука, тут просто отличная возможность продать ужасную клавиатуру (Magic Keyboard 2, по цене бюджетного ноутбука), после которой захочется купить полноценный ноутбук.

Никаких проблем. Можно распознавать режим и брать денежку. В DEX некоторые программы уже так умеют, в частности, MS Office.

> экономя деньги

Все бывает, конечно…

другое дело, что ос начинает самообслуживаться на многоядрах более эффективно.

правда, начинаем упираться в теплопроводность и вывести тепло из центра становится всё сложней.

Только многоядерность не решает проблему энергопотребления.

Пока стремительно уменьшался техпроцесс было возможно увеличивать количество транзисторов без повышения энергопотребления (как раз это самая многоядерность). Сейчас с этим стало сложнее. Просто так увеличить количество ядер без вреда для энергопотребления уже не выйдет, а пихать в телефон процессор с TDP 100W никто не будет.

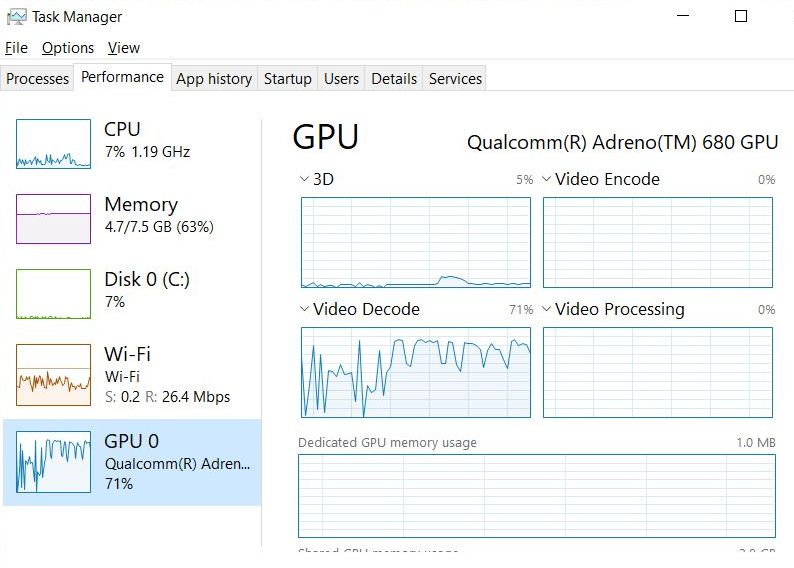

Когда уже перестанут оценивать десктопные процессоры по мобильному бенчу. Там и майковско-квалкомовский процессор в Surface рвал i5 и r5, но по итогу… Кхе.

Shadow of the Tomb Raider упирается в ГПУ. Он и древний AMD FX не нагружал сильно.

Когда уже перестанут оценивать десктопные процессоры по мобильному бенчу.

GB везде одинаковый — и на десктопе и на мобилках. Если ваш десктоп не может выступить быстрее мобилки, о чём это говорит?

Ну т.е. тупо запускается Clang с исходником и почему же он у вас медленнее работает?

Впрочем если не нравится GB — есть результаты SPEC 2006:

www.anandtech.com/show/14892/the-apple-iphone-11-pro-and-max-review/4

www.anandtech.com/show/13392/the-iphone-xs-xs-max-review-unveiling-the-silicon-secrets/4

Там и майковско-квалкомовский процессор в Surface рвал i5 и r5

Давайте придерживаться фактов, а не фантазий.

Вот первый попавшийся тест SQ1 против i5-8500 @ 4.1GHz (процессор того же 2018г)

browser.geekbench.com/v5/cpu/compare/2923814?baseline=2930842

Не рвёт, но и выступает не плохо.

по итогу...

По итогу что?

Я вот пользуюсь Galaxy Book S на основе 8cx — ноут просто отличный, работает быстро, долго и не перегревается.

А если порассуждать? Давайте так — производительность ARM меньше производительности x86 (и x64, конечно) равной тактовой частоты.

ARM бывают разные. Какие конкретно вы имеете в виду и на чём основано данное суждение?

Гонка гигагерцев закончится довольно быстро.

Интел её проиграл AMD ещё в начале 2000-х :D

В сухом остатке явное преимущество x86/x64 в «числодробильных» задачах. И это преимущество «покупается» за невысокую энергоэффективность

Где-где преимущество, простите?

www.fujitsu.com/global/about/resources/news/press-releases/2019/1113-02.html

A64FX — 7nm, 48 (52) ядер, 3,3792 TFLOPS (в DP), ПСП 1TB/s, 180W(?)

Epyc 7742 — 7nm, 64 ядра, 2,3TFLOPS, ПСП 204.8GB/s, 225W

Даже свежий TR Pro 3995WX с TDP 280W не достанет до ARM.

Как мы видим у топовых x86 меньше производительность при большем количестве ядер (ядра медленнее), меньше ПСП, больше TDP.

По всем параметрам… грусть-печаль.

По всем параметрам… грусть-печаль.

Давайте так. Я не могу спорить с маркетологами. Как говорится «в рекламе вкусно показать можно что угодно». Но первое впечатление любого, кто садится за ARM после любого x86 (даже Atom'а не к ночи будь помянут) — это ощущение тормозной консоли. Все системные утилиты, рассчитанные на работу в однопоточном режиме выполняются сильно дольше привычного времени. Я не работал с «серверными» решениями. Есть такой, но у меня к нему доступа нет за ненадобностью — мне кросс-компиляция больше нравится. И в первую очередь ровно потому, что кросс-компиляция выполняется сильно быстрее, чем нативная. Потому мой собственный опыт и только. Однако, не думаю что Apple будет ставить в свои десктопы серверные ARM'овские решения на полсотни ядер. Но посмотрим.

Банальный пример — роутер с 2 ядра ARM не может забить гигабит кучей подключений, nat тормозит. x86 j1800 тянет гигабит на одном ядре, и вытянул бы еще немного. Частоты были одинаковыми.

Ядро linux вряд ли перепишут подьвсе особенности(если таковы имеются) arm.

Вообще сегодняшняя ситуация вокруг ARM до боли похожа на ситуацию с SPARK и SUN. Те тоже пытались подвинуть Intel как минимум на серверном рынке. Конечно, сейчас ARM сильно популярнее чем когда-то SPARK. Где сейчас тот SUN и тот SPARK? А очень похоже по ощущениям от работы с консолью.

И да, я не то что не против. Я за. Я жду цен. И имею (слабую) надежду на то, что какой-нить mac-mini с ARM появится у меня на столе. До тех пор любые разговоры это просто гадание на кофейной гуще. Я мои посты целиком и полностью основаны на собственном опыте работы с Linux на ARM (как 32-, так и 64-разрядных). Пока ощущение такое — жить можно, но только так. Большинство пользовательских задач (игры, видео, музыка, обработка видео) вполне себе выполнимы. А вот разработчиковские (та же компиляция) — одна сплошная боль. И вылечить эту боль может только очень серьезная многоядерность. Но и тут надо помнить про «корень из N» и весьма серьезное усложнение чипа. Потому повторюсь — попкорн запасен. А там посмотрим что за кино получится. Не удивлюсь ни комедии, ни триллеру.

ARM разработает отдельное ядро персонально для Apple? Что может сделать Apple для того чтоб в разы увеличить производительность?

Так у них уже производительность ядер на уровне ядер интела. Именно у процессоров от Apple — A12Z

Я мои посты целиком и полностью основаны на собственном опыте работы с Linux на ARM (как 32-, так и 64-разрядных).

Ещё раз, не те это процессоры

А вот разработчиковские (та же компиляция) — одна сплошная боль. И вылечить эту боль может только очень серьезная многоядерность.

Посмотрите на Developer Transition Kit. Там как бы и система и Xcode уже стоят. И люди берут и компилируют

А вот про «не те процессоры» я не понял. Упомянутый A12Z основан на ядре ARMv8-A. Вполне понятно чего от ждать просто ориентируясь на построенные на близкородственных ядрах AARM64. Разве нет?

Упомянутый A12Z основан на ядре ARMv8-A. Вполне понятно чего от ждать просто ориентируясь на построенные на близкородственных ядрах AARM64. Разве нет?

Эм, нет. Это же набор иструкций. Так можно и AMD и Intel сравнивать — а чего, они ж оба x86-64. Тут можно посмотреть сравнение с Snapdragon 855. По вашей логике, тоже ARMv8-A. А вот разница очень даже существенная. У Apple одна их самых быстрых (если не самая быстрая) реализаций — это факт, и это было видно еще несколько лет назад.

К слову поправьте если не прав, но полагаю что никто не может — та доступ к консоли сильно лучше спрятан чем в том же Android'е

Ну, прижелании доступ есть — джейлбрейк никто не отменял

Но попробуйте собрать сколько-нить серьезный проект нативно. В моем случае это обычно ядро Linux, gcc или что-то подобное (chromium, firefox). И тут выяснится что кросс-компиляция на Intel сильно быстрее нативной компиляции. Да и XCode пока работает в основном на Intel, хоть и делает код для ARM'а

Я же говорю, вот, выпустили уже Xcode для ARM. Но, к сожалению, у меня нет DTK, чтобы это протестировать. Разработчикам, которые его получили, тоже, по традиции, рекомендовано воздержаться от комментариев, но тесты ня ютубе уже есть — но, к сожалению, не компиляции, это да

Ну, а то что Apple может «вытягивать» из ARM максимум, так это хорошо. Но я сомневаюсь что на реальных задачах там будут «разы». Хотя… Вспоминая как вел себя ARM-v7 с 16-разрядной шиной памяти в сравнении с тем же ядром, но 32-разрядной шиной могу сказать что все возможно. Ждем. Пока просто ждем.

Еще сильнее я не понимаю «ааа, так он же быстрее из-за шин, кешей». Какая мне разница, из-за чего? Он быстрее, важно только это.

Шины и кеши — это мое. Это я должен понимать за счет чего достигается такая производительность и где ждать подводных камней таких решений (понимать границы применимости). Согласен, пользователю это не очень интересно (если вообще интересно). И в этом плане тот же браузер не всегда показателен. Страница для iPad и для десктопа могут оказаться очень разными, даже рекламой разной и по разному напичканными. Одно это может вносить существенные искажения в восприятие скорости работы. Потому давайте я соглашусь с любой позицией. Говорите ARM от Apple в однопоточном режиме быстрее Intel'а — ОК, пусть будет так. Говорите что у Apple самая быстрая реализация AArm64 — не вопрос. Время рассудит что тут правда, а что вымысел и подгон под требуемый ответ.

Насчёт страниц в браузере — я согласен с замечанием, что сайты могут быть разные, но это не мой случай. Я часто читаю форумы, и они открываются именно в десктопной версии. Кроме того, на iPad нет блокировщика рекламы, что, по идее, должно ещё сильнее тормозить браузер на нем. Но не тормозит.

И что это меняет? Будет в несколько раз медленнее?

Да, будет в несколько раз медленнее.

Вы знаете что такое микроархитектура?

Представляете, почему Goldmont+ медленнее в разы чем IceLake?

Это как? ARM разработает отдельное ядро персонально для Apple?

Они не используют ядра ARM. Как и AMD не использует ядер Интел. Apple лицензирует архитектуру и разрабатывает микроархитектуру самостоятельно.

Сейчас ядра Apple вдвое быстрее чем ядра от ARM.

В Apple ноутах будет ядро на 20-25% более быстрое чем A13. Это поднимет планку производительности в однопотоке для всей индустрии.

SPARK и SUN

SPARC

мои посты целиком и полностью основаны на собственном опыте работы с Linux на ARM (как 32-, так и 64-разрядных).

Ну т.е. ездите на Ладе Приоре, но рассужаете о каком нибудь Porsche, дескать, он точно ничем не лучше. Ясно, понятно.

Ну т.е. ездите на Ладе Приоре, но рассужаете о каком нибудь Porsche, дескать, он точно ничем не лучше. Ясно, понятно.

Может быть. А может быть просто не пытаюсь использовать карьерный Белаз для ежедневных поездок на работу через центр города-миллионника. И тем более не пытаюсь найти оправдания того для чего я этим мог бы заниматься. А межу поршом и приорой общего сильно больше чем кажется. И уж точно нельзя познать особенности реализация порша не зная как работает приора или любой ее импортный аналог (если на отечественные авто стойкая аллергия).

Поправка про SPARC засчитана. Виноват. Все остальное для меня требует пояснения. То что вы пишите или слишком умно и сильно опережает мои знания, или… ровно наоборот (буду политкорректен). Я не понял про Intel и AMD. История этих компаний слишком на слуху для того чтоб так безапеляционно заявлять что их роднит только набор инструкций и так было всегда. Да и методика зарабатывания денег компанией ARM мне представляется несколько по другому.

История этих компаний слишком на слуху для того чтоб так безапеляционно заявлять что их роднит только набор инструкций и так было всегда

Причём тут история компаний? «Так было всегда»? Я такого вообще не говорил.

Речь о том, что ядро Ryzen никак не связано с Intel Core кроме как по архитектуре. У компаний есть кросс-лицензионные соглашения, но AMD не лицензирует микроархитектуру ядра у Интел, и наоборот.

То что вы пишите или слишком умно и сильно опережает мои знания, или… ровно наоборот (буду политкорректен)

Как изволите, но мне не пришлось бы разжёвывать элементарные вещи,

если бы вы в них ориентировались. Расширяйте кругозор. Возможно, вам эта информация не нужна, но вы же делаете безапелляционные заявления вроде «производительность ARM меньше производительности x86 (и x64, конечно) равной тактовой частоты.», хотя даже не знаете какие бывают ARM и какую они имеют производительность.

Да и методика зарабатывания денег компанией ARM мне представляется несколько по другому.

Важно, не как вам представляется методика, а как это работает на самом деле.

О том, как работает ARM, написано в хорошо знакомом месте:

www.anandtech.com/show/10366/arm-built-on-cortex-license

www.anandtech.com/show/7112/the-arm-diaries-part-1-how-arms-business-model-works

Как изволите, но мне не пришлось бы разжёвывать элементарные вещи, если бы вы в них ориентировались. Расширяйте кругозор.

Хм… Понимаете какое дело. Мне, как человеку который уже не один десяток лет занимается адаптацией загрузчиков и ядра Linux под разные камни (включая те, на которых ни одно ни другое даже не поддерживается) безусловно стоит расширять кругозор. И конечно мне не надо объяснять элементарные вещи. Хотя не скрою — я очень люблю послушать как именно их объясняют. Очень много сразу становится понятно о человеке. Насколько глубоко он в теме, по каким «учебникам» учился. Потому позволю себе встречный совет вам: вечно расширять кругозор не получится. Мир меняется сильно быстрее, чем вы об этом успеваете даже прочесть. Потому выберите уже тему, в которой вам будет интересно и копайте вглубь. Нет ничего страшного в том, что не знаешь всего.

Мне, как человеку который уже не один десяток лет занимается адаптацией загрузчиков и ядра Linux под разные камни

Я, знаете ли тоже

То что вы адаптируете Линукс, ничего не говорит о ваших знаниях в области микроархитектур ARM. Тем более вы с чипами Apple не работаете и программы на них не запускаете. Кстати для iPhone тоже есть Линукс ядро. projectsandcastle.org

Мир меняется сильно быстрее, чем вы об этом успеваете даже прочесть.

Именно так. Несколько лет назад ваше утверждение, из-за которого появилась эта ветка, было валидным, а сейчас оно не соответствует действительности.

Вы в курсе про чайник Рассела? Надеюсь да, и тогда я жду продолжения. Меня настолько часто обвиняют в некомпетентности, что я даже сопротивляться не буду. Но, думаю, что если б хоть у кого-то был ARM достаточно производительный, чтоб потеснить современный Intel и об этом можно было бы писать не боясь судебных исков, то все бы давно гудели. А так быстрее, но со звёздочкой (на отдельных задачах). И именно понимание архитектуры и процессора как такового и системы в целом и позволяет мне предполагать с хорошей долей уверенности что таковое в принципе невозможно. Если конечно не сравнивать ультра современный ARM с допотопным Intel. Но тогда мой браслет на порядки производительные суперкомпьютеров прошлого. И да, напоминаю про чайник (и жду продолжения).

Напомню:

производительность ARM меньше производительности x86 (и x64, конечно) равной тактовой частоты.… В сухом остатке явное преимущество x86/x64 в «числодробильных» задачах.

Я вас не обвиняю в некомпетентности — я вашей работы не видел. Я просто говорю, что мир вокруг вас изменился, а вы старательно пытаетесь спрятаться за старой догмой «Интел — круче всех». Имеет место быть инерционность мышления.

то все бы давно гуделиТак все и гудят :) И именно потому Apple тратит миллиарды на смену архитектуры, хотя часть пользователей они потеряют.

А так быстрее, но со звёздочкой (на отдельных задачах)

У Интел в ноутах/десктопах осталась лишь одна «звёздочка» — широкий SIMD. В HPC даже её не осталось.

Кроме синтетики, применений AVX-512 на декстопе довольно мало.

Преимущество AVX2 закроет стоковое ядро ARM Matterhorn (2021г) с 256-битным SIMD. По некоторым косвенным данным у Apple Silicon уже в этом году может быть широкий SIMD (узнаем в сентябре). Айфон 12 покажет чего ждать от ноута.

И именно понимание архитектуры и процессора как такового и системы в целом и позволяет мне предполагать с хорошей долей уверенности что таковое в принципе невозможно.

*Зевая* Возьмите свежий айфон и погоняйте там код, если не верите тем, кто это уже сделал.

Лично я не настолько увлечён вопросом «В интернете кто-то неправ», чтобы делать это за вас :D

"Мы наш, мы новый мир построим" ©

Зевая Я подожду десктопа и проверю. Там и будет видно быстрее ли, энергоэффективнее ли, дешевле ли. А то сравнивать iPhone и десктопную машину все равно что сравнивать пончики с Айвазовским. Буквально недавно Microsoft пытались. Даже не для десктоп, а то ли планшет, то ли ноутбук. По ощущениям у них не получилось.

А тестировать каждую разрекламированную новинку у меня нет ни времени, ни денег, ни желания. Мне деньги не за это платят. К слову а вы не один из сотрудников того новостного портала на который ссылки шлете?

А про чайник все же почитайте. Зевая Вдумчиво.

Все системные утилиты, рассчитанные на работу в однопоточном режиме выполняются сильно дольше привычного времени.

Какая ОС, какой процессор?

Раз уж вы делаете вид что вы не маркетолог, предметно можете говорить?

У меня на 8сх нет такого ощущения каких-то тормозов.

Я не работал с «серверными» решениями.

И в первую очередь ровно потому, что кросс-компиляция выполняется сильно быстрее, чем нативная.

Откуда вы знаете, если вы не работали?

Знаете ли вы что то-же Clang, к примеру на телефоне Apple работает быстрее в однопотоке чем на самом топовом х86? Понятно что больших ядер там мало, т.е. в целом победит десктоп, но в ноуте будет 8 вместо двух.

Ось почти всегда Linux. Железо — встраиваемые железки с arm-v7a, arm-v8 (последнее время от Freescale). Это наша целевая платформа. Пробовал железки и от NVidia (для нас избыточны) и от более «приземленных» производителей (ST Microelectronics, Atmel). Да, выборка не очень презентативна в части производительности, но я и сравниваю их отзывчивость не с Xenon'ами. Скоре с Atom'ами и Celeron'ами. Что до «нет ощущения тормозов» — так на том что делаем мы тоже нет ощущения тормозов. Иначе бы железки наши не покупали. Не путайте пользовательский опыт и ощущения разработчика. Я знаю о своем изделии сильно больше, чем конечный пользователь. Так что верю — нет ощущения тормозов и славненько. Я буду очень рад оказаться не правым и пересмотреть свои взгляды. Ждем.

Clang, к примеру, на телефоне Apple я не запускал. У меня из Apple есть только macOs на хакинтоше. Потому действительно сказать ничего не могу. Но взялись писать — пишите. Что компилирует Clang на смартфоне и x86 (и который из них самый топовый, участвующий в сравнении)? Они производят один и тот же бинарь или разные? Где вообще описание данного теста?

Там ARM-v8 (64 бита), дай бог памяти 16 ядер и не помню сколько оперативы и тактовую частоту.

Кроме первого Graviton я так из головы и не могу назвать ничего серверного с 16 ядрами.

Graviton 1 построен на ядре A72 (оно далеко не серверное). Только вот текущий Graviton2 уже заметно быстрее чем первый (хотя и медленней серверных чипов х86). Серверные платформы от ARM выпускаются заметно позднее чем телефонные чипы. Оно и понятно — там серверные фишки да и тестируются такие чипы тщательнее.

>> Дело было год-полтора назад.

Ну да, точно Graviton значит.

A72 в 4 раза медленнее чем десктопное ядро Интел.

Graviton2 где-то в 2 раза медленнее в однопотоке, но компилировал бы он быстрее чем i7.

browser.geekbench.com/v5/cpu/compare/2124955?baseline=2853917

>> Что компилирует Clang на смартфоне и x86

Clang в GB5. Я лично Clang не собирал и не запускал под iOS (при джейле можно тупо из консоли запускать), но бенчмарк вполне правдоподобен.

GCC в SPEC2006. www.anandtech.com/show/14892/the-apple-iphone-11-pro-and-max-review/4

>> Они производят один и тот же бинарь или разные?

Один и тот же.

>> Где вообще описание данного теста?

Стр 12

www.geekbench.com/doc/geekbench5-cpu-workloads.pdf

Скопирую из отсюда (я могу писать только 1 раз в час)

Ширины шины данных, размер кешей. Другое дело, что есть серьезный вопрос поможет ли это в реальной жизни на реальных задачах, а не на чистой синтетике. И да, Intel и AMD можно (и нужно) сравнивать. Собственно все именно этим и занимаются.

Большой кэш с низкой латентность и высокой ассоциативностью не поможет в «реальных» задачах?

L1D 8-way / 128KB / 3 такта; L2$ 4MB 14-16 тактов у Apple

L1D 8-way / 32KB / 4-5 тактов; L2$ 256KB 12 тактов у Comet Lake.

Декодирование 7 инструкций за такт (A13), 6 ALU операций за такт, быстрый FPU тоже не помогут? Там и остальные блоки уровня state-of-art.

www.anandtech.com/show/13392/the-iphone-xs-xs-max-review-unveiling-the-silicon-secrets/3

Кстати новое ARM-овское ядро Cortex-X1 (которое пока никто не показал) может запускать из МОП кэша 8 макроопераций за такт. У Интел всего 6 МОП-ов за такт.

www.anandtech.com/show/15813/arm-cortex-a78-cortex-x1-cpu-ip-diverging/3

Про остальное. Ну хорошо, будем считать что я согласился. Мне спорить с редакторами www.anandtech.com совсем не хочется. А не верить им безоговорочно — это мое право. Как и право сомневаться в кроссплатформенных тестах. Даже подсчет хешей или расcчет числа Pi (казалось бы чисто вычислительные задачи) не дают четкого результата.

Потому просто повторю основную идею — ждем. Ждем цен. Ждем реальных оценок (что бы это не значило). Будет любопытно если десктопный ARM от Apple окажется быстрее серверного 1,5-годичной давности. Впрочем, сильно такому раскладу я не удивлюсь.

А, ну и еще, помимо этих вопросов есть вопрос цены и по всему выходит что Apple сильно будет экономить на своем силиконе. И это прям немаловажный фактор.

А еще появляются многоядерные системы, позволяющие параллелить и базовые системные функции.

Скорее всего это и есть бустер, который будет использовать Apple.

Более того, Apple не покупает дорогущие чипы Xeon, используемые в миллионах облачных серверов – а их доля в прибыли Intel постоянно растёт.

А как же Mac Pro?

конец эры Wintel…на ≈10% ПК (и вычтем Mac Pro, как выше сказали)

И при чём тут Wintel?

Неприятно, но на апокалипсис не тянет.

И Windows на армах была уже лет 5 назад. Но вау-эффекта не последовало.

Если отбросить в сторону все громогласные рассуждения автора о технологическом превосходстве Apple над Microsoft и ARM над AMD64 (причем оба тезиса весьма спорны)ну про Apple vs microsoft можно долго холиварить (хотя индустрия чаще следует за первыми чем за вторыми), а вот то что ARM чипы энергоэффективнее и дешевле в производстве чем их x64 аналоги это скорее факт чем спекуляция. А еще у apple в ближайшем будущем будут 5 nm чипы, а ведь в ноутбуках решающий критерий именно энергоэффективность.

то в сухом остатке мы имеем уменьшение доли интеля на десктопах на 10%.дайте apple разгуляться в верхнем сегменте и они и в средний полезут.

И Windows на армах была уже лет 5 назад. Но вау-эффекта не последовало.если бы win 8 RT был тем, что от него ожидали — windows 7 с адаптированным под тач интерфейсом, последовало бы. На деле же это была планшетная версия провальной win phone.

(хотя индустрия чаще следует за первыми чем за вторыми)Зато первые часто следуют за вторыми. То плоский дизайн позаимствуют, то разделение экрана, то живые плитки…

- 2000: MS представили windows mobile. Занял нишу коммуникаторов и прожил ровно до релиза айфона

- 2001: MS представили первый планшетный компьютер. Провал

- 2007: apple представили айфон. Спустя пару лет практически все мобильники копируют дизайн айфона

- 2010: apple представили ipad, положив начало «планшетным компьютерам»

- 2010: MS представили windows phone как ответ айфону. Провал, который добил nokia.

- 2011: apple представили siri. В течение последующих лет подобные решения появились и у конкурентов

- 2012: MS представили свой ответ ipad'у — планшет microsoft surface. Провал

- 2015: apple выпускает ноутбук с одним лишь thunderbolt интерфейсом, и производители постепенно переходят на него

- 2016: apple удалили из телефона jack. Конкуренты перенимают

- 2020: apple объявила о переходе на ARM (---мы здесь---)

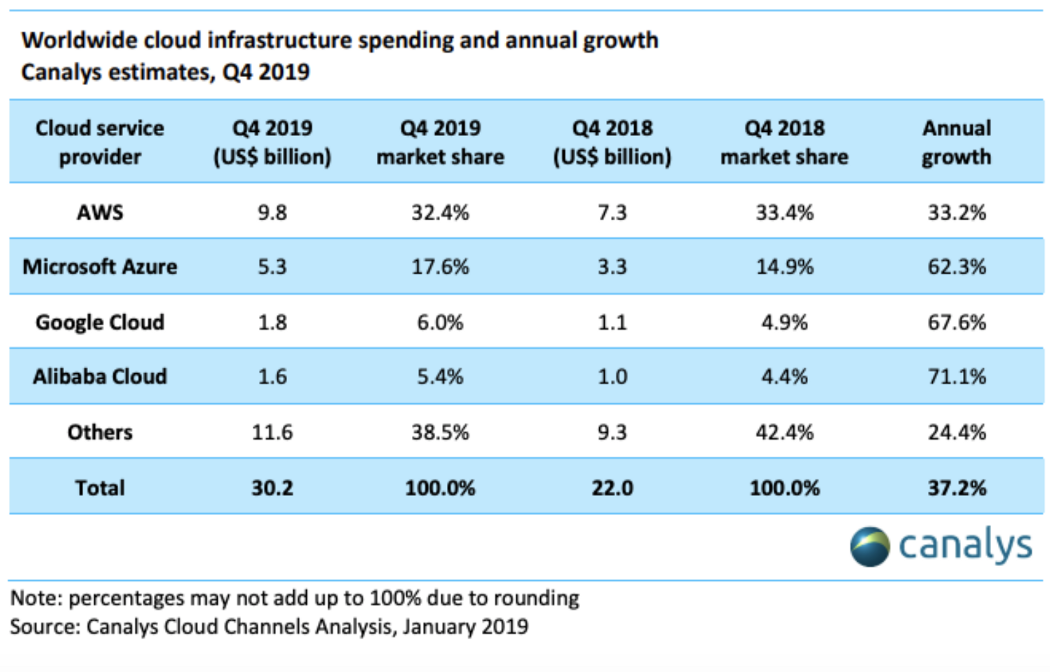

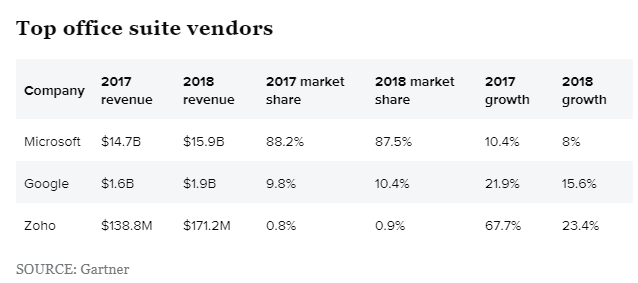

Итого все крупные «мувы» apple оказываются успешными, а все крупные мувы MS — нет. Что там еще есть у MS? Azure? Я бы поставил на AWS. Office? Будущее за google docs. Итого MS лидирует только в некоторых крайне нишевых областях (типа hololens для медицины) и пытается сохранить монополию там, где может.