Как я рабочую задачу автоматизировал, не написав ни строчки кода, с помощью AI-ассистента

AI-сервис Phind - ассистент по программированию для не программистов. Или как я автоматизировал свою рабочую задачу, не написав самостоятельно ни строчки кода.

AI-сервис Phind - ассистент по программированию для не программистов. Или как я автоматизировал свою рабочую задачу, не написав самостоятельно ни строчки кода.

В прошлом материале мы рассказали, с какой проблемой столкнулись, и проанализировали четыре СУБД в поиске рабочего решения. Мы оценили преимущества и недостатки каждого отобранного варианта и остановились на ClickHouse. Несмотря на то, что готовой интеграции этой БД с Zabbix не существует, CH отлично подходил как решение под наши инженерные задачи.

БД в Zabbix

Прежде чем мы перейдем к рассказу о реализации, расскажем о специфике работы БД в Zabbix. Вся ее логика вынесена в отдельную библиотеку — zbxhistory. Она используется сервером и прокси для сохранения данных мониторинга. В классе history описывается интерфейс, который имплементируется каждой реализацией подключения к хранилищу данных.

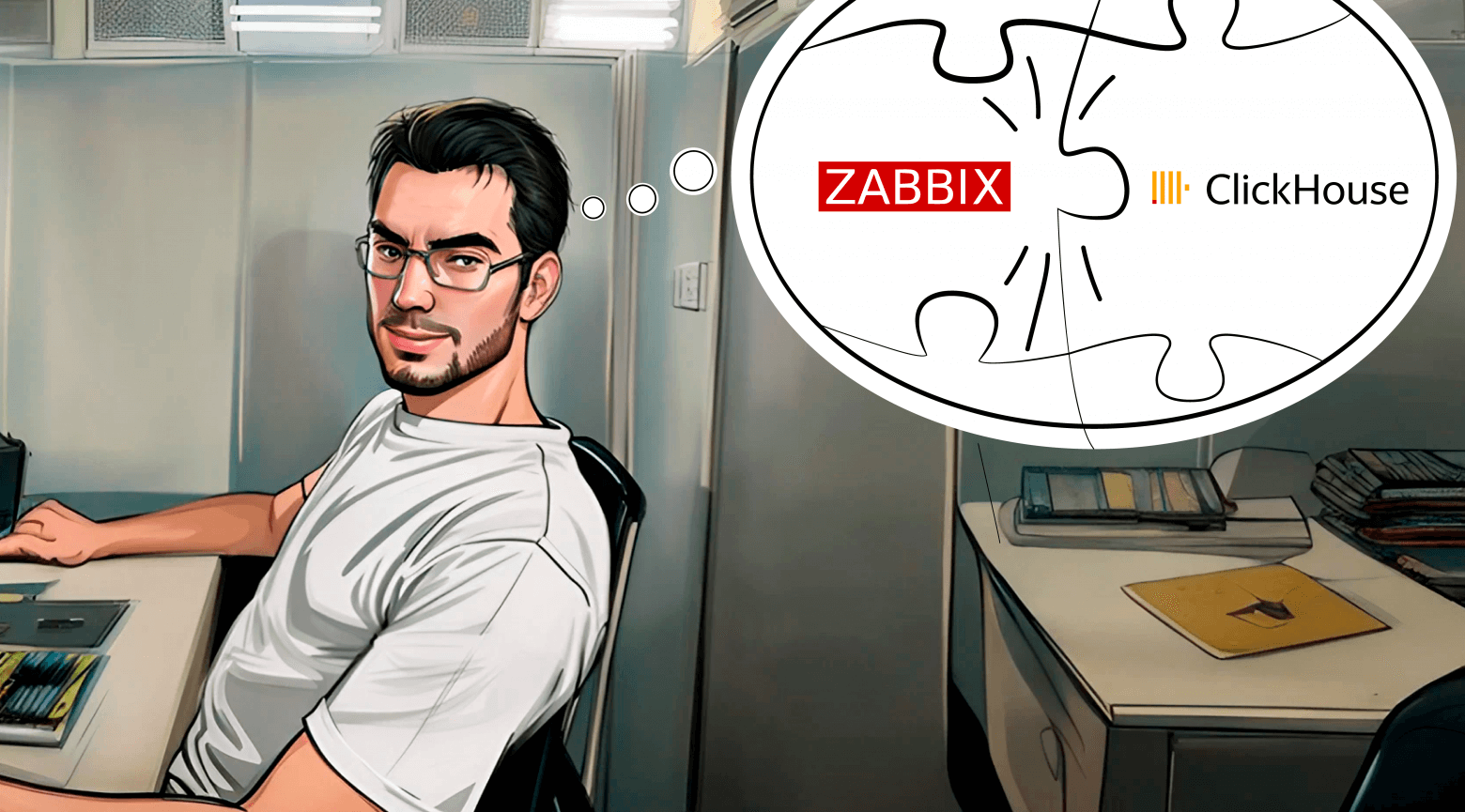

Недавно в нашу компанию «Инфосистемы Джет» пришел заказчик с проблемой долгой реализации создаваемых портов на NSX-T (до 2 минут до момента запуска трафика). Основная боль заключалась в том, что новые поды K8s не всегда укладывались в timeout Health Check'a и процесс начинался опять.

Исходные данные у нас были такие. NSX использовался для построения микросегментированной сети в кластерах Kybernetes + Kyverno. Взаимодействие K8s и NSX было реализовано при помощи плагина VMware NCP. Несмотря на большое количество объектов, в интерфейсе все метрики по утилизации были в «зеленых» значениях, но ощущалось сильное замедление работы UI.

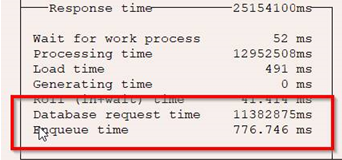

Недавно решая проблему заказчика – крупного ритейлера, мы значительно ускорили работу одного из процессов, реализованных в SAP ERP. Периодически задания по загрузке цен работали ооооооооооооооооооооооооооочень медленно, причем задержка составляла не каких-нибудь 10 минут, а могла доходить до нескольких часов.

Для сравнения приводим два скрина. На первом отображено нормальное время выполнения задачи:

Пришёл ученик к мастеру. И спросил:

— Что вы делали до просветления? Как жили?

Мастер ответил:

— Колол дрова, носил воду, готовил еду.

— А что вы делаете после просветления? — спросил ученик.

— Колю дрова, ношу воду, готовлю еду, — ответил мастер.

— А что изменилось?

— Да всё!

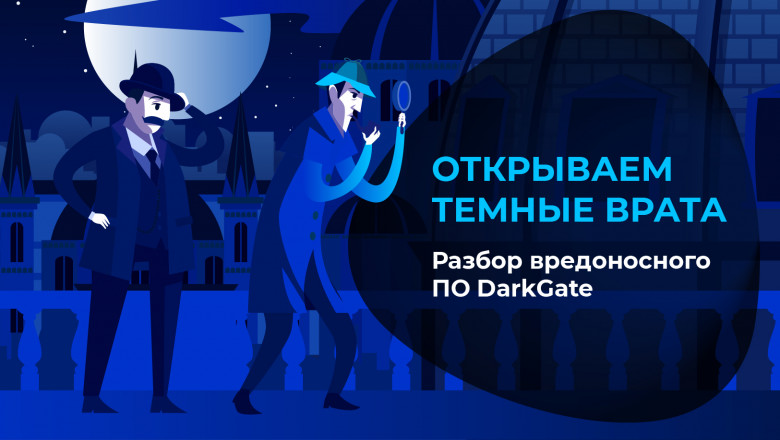

0x0 Введение в предмет исследования

Работа аналитика киберразведки часто подбрасывает интересные задачи из совершенно разных областей жизни. Иногда мы в Jet CSIRT анализируем очередное ВПО, которое еще никто не разбирал «по косточкам», или того, что уже было написано, оказывается мало, и приходится выкручиваться как можем находить решения и проводить настоящую исследовательскую работу. Так произошло и в нашем случае, когда коллеги из «Лаборатории Касперского» сообщили о возобновившем активность вредоносе DarkGate практически в тот же момент, когда мы проводили анализ семпла. Выяснилось, что существовавшие с 2017 года «Темные Врата» не просто оживили в 2023-м, но и оснастили дополнительным мощным инструментарием.

Изначально ничем не примечательный инцидент привел к исследованию, результатами которого мы решили поделиться с комьюнити.

Всем привет! Сегодня хочу рассказать о своем «семейном» проекте на Raspberry Pi. Путешествуя по миру, я постоянно сталкиваюсь с потребностью подключаться к быстрому и, что не менее важно, безопасному интернету.

Пожалуй, одной из самых опасных и крайне нежелательных сущностей, которые могут завестись в скомпрометированной Windows-инфраструктуре, является Golden Ticket. Это абсолютно легитимный Kerberos-билет, содержащий специально созданные данные, позволяющие злоумышленнику обойти нормальные механизмы проверки и получить высокие привилегии в сети.

С помощью золотого билета злоумышленник может получить доступ к любому ресурсу в Active Directory, притворяясь валидным пользователем, без фактической аутентификации.

Про Golden Ticket написано уже очень много статей, и аналитики знают, что такую атаку очень сложно обнаружить (большой труд в этом направлении проделали коллеги из R-Vision, рекомендуем к прочтению статью о Golden Ticket).

Не так давно Microsoft выпустила поэтапные обновления безопасности, которые меняют правила использования Golden Ticket. В этой статье мы постараемся разобраться, как обстоят дела с этой атакой сейчас и как Microsoft упростила ее детектирование своими обновлениями. Мы возьмем два инструмента (Mimikatz и Rubeus), сделаем с помощью них Golden Ticket с разными параметрами, а потом попробуем ими воспользоваться и посмотрим, какие сгенерируются события и как отследить их в SOC.

Одна из самых часто используемых техник при атаках — получение учетных данных из операционной системы. В этом можно убедиться, читая аналитические отчеты различных компаний: техника T1003 OS Credential Dumping в подавляющем большинстве случаев входит в ТОП-5. После проникновения в систему злоумышленникам необходимы учетки для перемещения по сети и доступа к конфиденциальной информации, а данная техника направлена на извлечение локальных и доменных учетных записей из системных файлов, реестра и памяти процессов.

В этой статье мы акцентируем внимание на своевременном выявлении подозрительной активности с помощью мониторинга ИБ и расскажем, как на основе событий штатной подсистемы аудита ОС обнаружить, что пытаются сдампить учетные данные в Windows. Логика детектирования будет представлена в общем виде по полям событий, а также в виде псевдокода, который можно адаптировать под синтаксис любой системы мониторинга. Ну и для возможности тестирования правил корреляции будут приведены краткая справка по атакам и способы их реализации.

Рассмотрим покрытие таких подтехник, как:

· дамп процесса lsass.exe;

· кража данных из базы SAM;

· дамп базы NTDS;

· извлечение секретов LSA;

· получение кэшированных данных;

· атака DCSync.

Оффтоп

Наш рассказ — это гид автостопщика, некое summary тех вещей, которых нам не хватало при знакомстве с Vault. В нем мы сделаем несколько остановок: поговорим в целом про управление секретами, о том, почему мы рекомендуем именно Vault; рассмотрим, как Vault работает; поделимся лайфхаками по работе с секретами и болью о том, чего нам не хватает в продукте.

Этот пост я хочу посвятить кейсу с крупного ИТ-проекта, который делала наша компания. В рамках проекта внедрялось большое количество сервисов, и для них нужно было обеспечить LDAP-аутентификацию при следующих операциях:

• Доступ в GUI-интерфейсы сервисов.

• Доступ по SSH на серверы, где функционируют сервисы, с ограничением доступа на основании членства пользователей в группах LDAP-каталога.

У заказчика уже была развернута служба каталогов Microsoft Active Directory. Требованием проекта было отсутствие прямого доступа между внедряемыми сервисами и AD. На стороне сервисов не должны были прописываться параметры сервисных учетных записей AD. Кроме того, сетевой доступ к контроллеру MS AD был разрешен только для одного хоста.

Под катом — подробности о том, как мы решили эту задачу.

Привет, Хабр. Меня зовут Виктор, я работаю в компании «Инфосистемы Джет» пентестером и активно играю на киберполигоне Standoff 365 под ником VeeZy. Сегодня я хочу поделиться с тобой, на мой взгляд, самым красивым критическим событием, которое есть на платформе!

Инцидент, который мы реализуем, называется «Оплата товаров по QR-кодам за счет украденных средств», и за него можно получить 7500 баллов.

Взлом новостного портала, путешествие в страну Kubernetes, кража денежных средств с клиентских счетов, и это далеко не всё! Разумеется, это всё в рамках закона и служит исключительно в образовательных целях! Устраивайся поудобней, а мы начинаем.

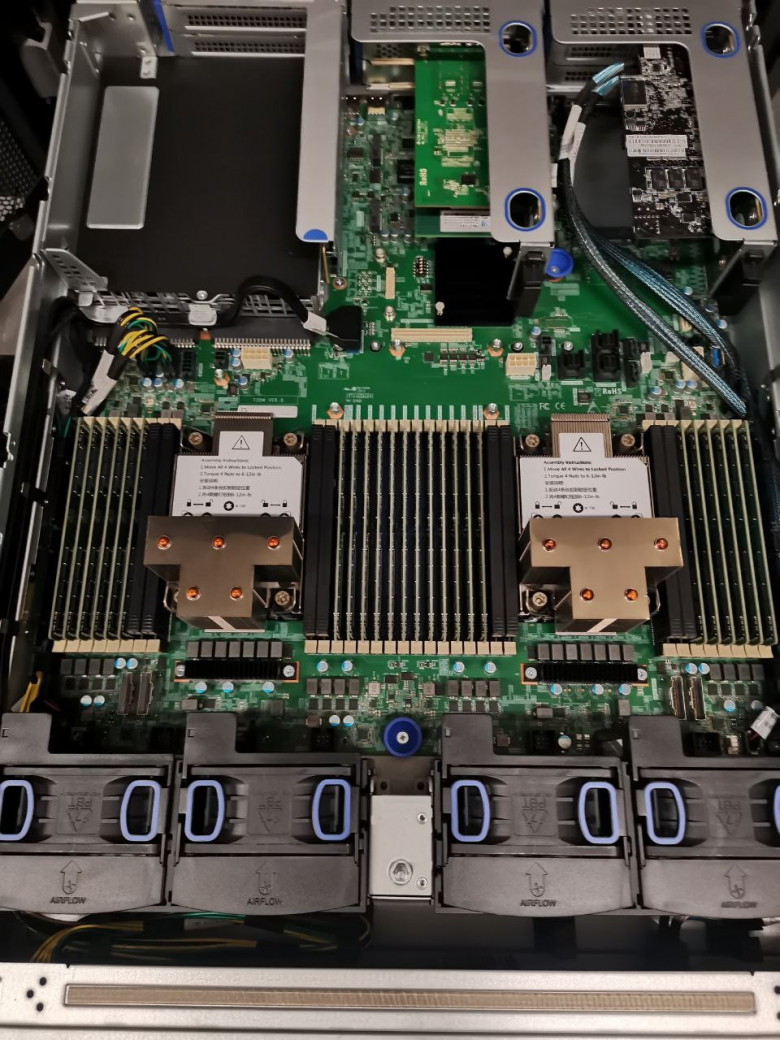

В нашу лабораторию Jet RuLab на тестирование попали серверы бренда TTY, довольно успешно продающиеся на китайском внутреннем рынке, но малоизвестные в России. В этом посте рассказываем о моделях двух поколений, возникших проблемах и можно ли с этим жить.

В этой статье мы хотим посмотреть на несколько российских решений с точки зрения их функциональных особенностей. По всем этим решениям мы прошли обучение у вендоров, протестировали их в нашей лаборатории и провели пилотные внедрения у заказчиков. У нас накопился опыт по отечественным продуктам, которым хотим поделиться.

Для начала отметим, что VDI по своей сути — это система автоматизации двух ключевых процессов:

— Управление жизненным циклом виртуальных рабочих мест (ВРМ) (развертывание из шаблона с регистрацией в службе каталога, пауза, перезапуск, удаление, переразвертывание после внесения изменений в шаблоны и т. п.).

— Управление пользовательскими сессиями: авторизация пользователей, организация сессий, проброс пользовательских устройств на виртуальные АРМ.

Весь остальной функционал, по сути, вспомогательный, хотя и не менее важный на практике: кластеризация компонентов управления VDI, балансировка и туннелирование трафика, управление пользовательскими профилями, доставка отдельных приложений, терминальные сессии, удаленный помощник.

Изменять конфигурацию узла Kubernetes нужно не только в момент создания кластера, но и при его обновлениях или изменениях в инфраструктуре. Хорошо, если узлы можно автоматизированно пересоздать или изменить без перезагрузки узла. А что делать, если такой возможности нет или количество узлов в кластере переваливает за сотню?

Меня зовут Александр Краснов, CTO компании «Лаборатория Числитель». Мы занимаемся разработкой программного обеспечения, создаем собственные продукты в области контейнерных платформ, DevOps, облачных решений и мониторинга. Я же проектирую и внедряю Kubernetes в Enterprise.

В основе этого поста — мой доклад с DevOps Conf 2023. Я расскажу про распространенные варианты управления конфигурацией кластеров с помощью Ansible, Cluster API и OpenShif Machine Config.

Привет, меня зовут Виктор Езерский, я работаю в центре управления данными «Инфосистемы Джет». Мы занимаемся построением хранилищ, Data Lake, платформ данных, ETL/EL-T и BI-систем. Последние 5–7 лет при построении хранилищ данных у наших заказчиков одна из часто встречаемых архитектур — Data Vault. Мы участвовали в доработке готовых хранилищ на базе Data Vault и делали Data Vault «с нуля».

Из опыта борьбы я вынес одно правило: Data Vault без фреймворка и автоматической генерации — большая беда. В этом посте расскажу, почему, а также поделюсь нашими подходами к созданию генератора. Сразу предупреждаю, что не дам готовых рецептов, но расскажу о наших основных подходах и что они нам дали.

Я недавно начала заниматься администрированием проектов в ИТ-инфраструктуре. Здесь много постов менеджеров проектов о том, как ставить задачи технической команде, контролировать статусы и общаться так, чтобы тебя не ненавидели. Однако оказалось, что с инженерами универсальные способы часто не работают, или работают, но не со всеми.

Короче, взять придуманную другими волшебную таблетку и использовать ее для всех случаев у меня не получилось. Но получилось всё же организовать нашу работу так, чтобы инженерам было проще, а в меня пореже летели лучи их ненависти. О тех инсайтах и соображениях, которые мне в этом помогли, и собираюсь рассказать.

Из этой статьи вы узнаете, почему важно проводить «лабораторные испытания» ML-моделей, и зачем в тестировании наработок «ученых по данным» должны участвовать эксперты из предметной области, а также — как выглядят тесты после того, как модель покинула датасайнтистскую лабораторию (и это не только мониторинг качества данных).

На первый взгляд кажется, что тестирование ML-моделей должно проходить по классическим ИТ-сценариям. Моделируем процесс, присылаем сценарии тестерам, и начинается магия — невозможные значения входных данных, попытки сломать логику системы и т. д. В некотором смысле все работает именно так: процесс разработки ML-сервисов включает и этот этап. Но только в некотором смысле — ведь у науки о данных есть масса особенностей.

Специалисты по анализу данных используют много разных инструментов, причем новые технологии (фреймворки, библиотеки и т.д.) появляются так часто, что у начинающих свой путь в отрасли постоянно возникает вопрос, что им нужно изучать в первую очередь. Здесь вы найдете обзор базовых инструментов. В следующих постах мы продолжим тему и расскажем об инструментах, не вошедших в этот обзор.

За прошедшие 3-4 года я прочитал в общей сложности более 25 000 страниц технической литературы и стал замечать, как сильно изменились подходы к выбору книг и их изучению. В этой заметке хочу поделиться наблюдениями и выводами, которые помогут читателю сэкономить время, сохранить мотивацию к чтению и выбрать действительно полезную книгу.