Comments 779

Эту статью следовало в политических изданиях публиковать, а не в технических.

Ситуация с ARM совсем другая. У него офигенно удобная для производителей модель лицензирования с очень невысокой стоимостью. И именно поэтому, процессоры на архитектуре ARM сейчас доминируют (по крайней мере в мобильном сегменте).

И ещё они лезут в серверный сегмент, предлагая меньший TDP, при сравнимой производительности (Amazon EC2). Также у ARM есть большой плюс для всех сегментов рынка, — отлаженные ОС, с многолетней историей.

Т.е. перенос софта на ARM с x86, — это вопрос поставки десктопов с ARM разработчикам. Apple делает именно этот шаг. Т.е. не для мобильных разработчиков, у которых это всё уже итак есть, а для десктопных. И закладтвает базу, для продвижения своей ОС вместе с «новой» (правильнее сказать проталкиваемой) аппаратной архитекутрой. Если ч-з 5 лет нёрды не будут хотеть убивать смузихлёбов за фразу «MacBook for gaming», это будет означать, что раскрутка от Apple удалась.

Вот вы говорите, что у Itanium отвратительна была цена/производительность?

Вот производительность в каких задачах вы брали? Ведь оный на момент своего выхода (начало 2000-х) это конкурент Alpha. Причем успешный, если все пользователи последнего перешли на Itanium.

Проблема была в том, что в самом массовом сегменте на тот момент доминировала x86-архитектура, команды которой транслировались в IA64 очень плохо, таким образом, выйти к широкому потребителю было нереально.

Intel стала заложником успешности своего детища с одной стороны и конкуренции с другой.

Оно не могло вложиться в новую архитектуру, т.к. новая архитектура это кап вложения для разработчиков, которые они не хотят делать. Это с одной стороны.

А с другой нету никакой возможности вложиться на полную в новую архитектуру, т.к. конкуренты готовы урвать свой кусок. И AMD это активно делала.

Во всей этой истории я до сих пор не понимаю почему они не дали ход своей видеоархитектуре, т.к. их интегрированная всегда была уровне.

Во всей этой истории я до сих пор не понимаю почему они не дали ход своей видеоархитектуре, т.к. их интегрированная всегда была уровне.

У них она была, но слишком наркоманская https://www.youtube.com/watch?v=um-1fAVU1OQ

Причем успешный, если все пользователи последнего перешли на Itanium.

Кормили сказочками.

Itanium был убыточным бизнесом для Интел вплоть до 2009г.

Забавно, что в том же году обанкротилась SGI, которая сделала ставку на Itanium.

bits.blogs.nytimes.com/2009/11/17/a-decade-later-intels-itanium-chip-makes-a-profit

не дали ход своей видеоархитектуре, т.к. их интегрированная всегда была уровне.

Быструю видяху у них только Apple и выклянчивал. Поэтому они кое-как выпустили Iris. Ну и сейчас пытаются что-то сделать с Xe. Но очень долго запрягают. Пока что кроме несчастного TGL и аналогичной ВК для десктопа у них нет ничего.

Причем успешный, если все пользователи последнего перешли на Itanium.

Кормили сказочками.

Itanium был убыточным бизнесом для Интел вплоть до 2009г.

Вы мешаете в кучу успех у потребителя и успех у производителя.

Для того чтобы выйти на безубыточность нужны большие объемы производства. До достижении этих объемов вполне можно выпускать продукт как убыточный, планируя отыграться потом.

Если этого не сделать — покупатели ни будут раскачивать объемы покупок. Это может сделать только производитель.

Мне довелось «потренироваться» в работе на титаник+OpenVMS. Это нечто! Дикое количество ключей оптимизации, при этом практически никогда не удавалось достичь желаемой производительности. В общем титаник своё дело сделал. Утащил на дно OpenVMS и Alpha.

Я не про производительность. А про цена/производительность. Бизнес считает деньги. А потом Oracle выпускает Exadata на х86, и хоронит супердома окнчательно, прекратив разработку ПО для Itanium в 2011, после заявления Intel о EOL Itanium.

Всё, — платформа мертва. Интел прекратил заниматься фигнёй избавившись от убыточного производства. HP не создал массового рынка для Itanium и не занял значительной ниши в Enterprise. HP-UX имел просто отвратительную поддержку в плане свежего ПО. HP не стермился создавать массовый продукт, он не создавал массовую экосистему, как это делали Intel&MS, и Intel&IBM&RedHat и куча других включая Google.

Itanium изначально был маргинальной системой, не оправдывающей своей цены.

А про цена/производительность.

Один из параметров ясен (цена), а второй?

А потом Oracle выпускает Exadata на х86, и хоронит супердома окнчательно, прекратив разработку ПО для Itanium в 2011, после заявления Intel о EOL Itanium.

Всё, — платформа мертва. Интел прекратил заниматься фигнёй избавившись от убыточного производства. HP не создал массового рынка для Itanium и не занял значительной ниши в Enterprise. HP-UX имел просто отвратительную поддержку в плане свежего ПО. HP не стермился создавать массовый продукт, он не создавал массовую экосистему, как это делали Intel&MS, и Intel&IBM&RedHat и куча других включая Google.

Я никак не пойму, как это обосновывает утверждение, про соотношение цена\производительность в 2001 году…

Один из параметров ясен (цена), а второй?

п р о и з в о д и т е л ь н о с т ь

spec.org, tcp.org

Я никак не пойму, как это обосновывает утверждение, про соотношение цена\производительность в 2001 году…

Создав дорогой процессор, удешивить который не смогла, и параметр цена/производительность вытянуть на уровень не смогла. HP не смогла создать рынка (внутри куча факторов, читайте пост выше).

Если ещё что-то не понятно, спрашивайте.

Ну, ок, будем тыкать носом.

Серьёзно? Сравниваете Alpha на 1150MHz с Itanium на 1500MHz? Ну ок.

Почему не сравнить с тем, что не умерло?

2007-й год SunFire X4100

98,857 QphH, 2.65 USD per QphH

www.tpc.org/tpch/results/tpch_result_detail5.asp?id=107102901

2008-й год HP Integrity Superdome

63,650 QphH, 38.54 USD per QphH

www.tpc.org/tpch/results/tpch_result_detail5.asp?id=108022701

www.tpc.org/tpch/results/tpch_result_detail5.asp?id=109090801

2009 HP ProLiant DL380 G6

51,085 QphH, 1.09 USD per QphH

Вы думаете Oracle, Exadata на х86-х запустила и линейку SuperCluster просто так похоронила, хотя SuperCluster на SPARC-ах в TPC-C например лидером был? Нет, не просто так, топ производительность за больше деньги никому не нужна. Нужна за разумнеы деньги.

Сравниваете Alpha на 1150MHz с Itanium на 1500MHz? Ну ок.

Сравниваю два конкурента на момент выхода. А разницу в тактовых частотах Opteron в то время неплохо нивелировал.

2007-й год

Itanium вышел в 2001, Itanium 2 в 2002. Тогда же были и планы выхода на широкий рынок. Однако этого не произошло, т.к. x86 плохо выполнялся, а доп. козырь в виде 64-битной архитектуры успешно выбил AMD.

И отжимал со страшной силой долю, вплоть до 2006 года, т.е. до выхода Core 2. И в 2007 году вы сравнивать архитектуру в которую в течении 5 лет вкладывались деньги и проц, финансировавшийся по остаточному принципу, а потом делать вывод о том что его сгубило…

Про Exadata и SuperCluster не моя тема. Но Гугл говорит, что Oracle запустил Exadata в 2008 и сразу на x86, а SPARC-и им достались от Sun, которую они поглотили в 2009-2010 годах. А SuperCluster похоронен в 2019 году.

И опять же, для БД, на которые вы упираете, важен не сколько параллелизм (а это главная фишка Itanium), сколько размер кэша и скорость доступа к оперативке.

Все остальное значения не имеет.

Ваша демагогия, и припысывание мне, не изречённых мною слов, также значения не имеет. Ключевой показатель всегда будет цена/производительность, который напрямую влияет на возможность создания массового рынка.

Возможно, это и сложно с точки зрения разработки, но сложнее ли это того, чтобы медленно и мучительно пытаться перестраивать самолёт из старого кукурузника в аэробус прямо на лету?

en.wikipedia.org/wiki/List_of_x86_manufacturers

Это будет что-то уровня Pentium-M в лучшем случае… Rosetta быстрее.

И имхо, переход на арм это конечно важный шаг для эппл, более того, уверен, за эппл последует и майкрософт, сделав нормальную вин 10 для арм, но это не говорит о том, что интел обречена. У них много денег, опыта, тысячи специалистов своего дела и только их решения покажут, насколько интел готова к будущему. Несомненно арм отжимает солидный кусок рынка настольных ПК, но это нормально вполне и происходит уже не первый год

Я не считаю ARM новейшей технологией, и чуть ниже написал, что хорошо бы, если б кто-нибудь (например, Intel) сделал абсолютно новый процессор.

у интел тоже самое, но арм не тащит на себе легаси, ну, или не заставляет.

Во-первых, x86 по такому подходу из 70-х: 8008, следы совместимости с которым тянутся, это 1972, 8080, уже с которым очевидно для любого — 1974. ARM — начиная от 1983, ближе к 1985, ну а ARM/64 (в котором выкинули кучу старья) это уже 2011.

Во-вторых, ключевое тут то, что в ARM меняли архитектуру с откидыванием старья, а в x86 — нет. В 64-битном режиме продолжают быть доступными, например, бесполезные команды типа rcl, rcr, xchg продолжает сохранять лок, продолжается дурь с OF и PF, не удлинены нафиг не нужные однобайтовые in/out, cmc, hlt, in/out и т.п., зато VEX занимает по 4 байта… там полный комплект будет с полсотни таких ляпов. И нельзя винить AMD — они как раз когда изобретали архитектуру amd64, были нищими… но Intel строил миражи на песке из IA64 и игнорировал эти попытки.

В результате, победа ARM сейчас ближе к вопросу времени — повторить те наработки по десктопу, что уже есть у Intel.

В этом плане ARM лучше уже хотя бы тем, что предоставляет большее число регистров общего назначения, что в свою очередь даёт большие возможности для автоматической оптимизации. Намного большие, чем крайне редко используемые оптимизированные команды из расширенного набора инструкций.

Однако, я говорил не только и даже не столько об ARM, сколько о новой современной архитектуре. Так сказать, начать жизнь с чистого листа. Но, наверное, и ARM сойдёт.

модемы не смогли вытащить. и ещё что-то недавно продали.

Главный ресурс Intel — это как раз R&D. Которые могут любое говно вытащить.

До сих пор их главный ресурс — имя и продажники.

R&D как-то уже не смотрится, если он ограничен x86. Начиная со Skylake прирост со следующими поколениями ничтожен.

И всё это решается внедрением нативных ядер (грубо говоря, плюс один контакт, напряжение на котором определит на каком ядре этот проц будет работать со старта).

Вплоть до уровня 486-Пентиума: патентная защита закончилась или заканчиваеться (25 лет на железо, есть еще авторское книжное право, но можеш обозвать команды по своему или ссылаться на добросовестное использование). Можешь производить или эмулировать архитектуру, другое дело кому такой уровень сейчас нужен.

В США -25 лет.Срок действия патента зависит от страны патентования, объекта патентования и составляет от 5 до 35 лет (ГК РФ Статья 1363, ГК РФ Статья 1424).

Вот, например, вроде связанно с FMA: patents.google.com/patent/US8745119B2

1995-08-31 Priority to US08/522,067

2015-08-31 Anticipated expiration

Суды США разрешили продлевать до 5 лет срок действия патента- в случае засекречивание патента, обоснование окупаемости разработок по технологии патента и в случае дополнения или усовершенствования патента. В общем из-за патентных троллей непонятная ситуация, поэтому юристы перестраховываються и рекомендуют исходить из срока 25 лет, если только сам патентообладатель не заявил что срок истек или предоставил в публичную собственность

Ладно, если вам ну НАСТОЛЬКО необходимо прямо и досконально разжёвывать — я хотел сказать, что Intel потенцитально мог бы направить усилия своего R&D департамента на создание совершенно новой архитектуры (вероятно RISC), с парой ядер на архитектуре х86, на платформе IBM PC, всё равно у них уже давно только свои чипсеты. И в итоге получить одновременно и обратную совместимость, и резкий рост производительности (за счёт новой архитектуры). Из минусов — только то, что это не оба сразу, либо обратная совместимость с так себе производительностью, либо отличная производительность без обратной совместимости. Но поскольку у Intel более чем достаточное влияние на рынок настольных ПК, они вполне могли бы задвинуть новый стандарт и лет за пять-десять производительность в режиме обратной совместимости не требовалась бы вообще, а весь новый софт писался бы под новую архитектуру.

И да, я знаю про Itanium и их неудачный опыт. Но вот чего не хватало Itanium — так это как раз обратной совместимости. Нельзя просто так взять и забросить новую архитектуру, отдав обратную совместимость в руки только программистам. И вот как раз поэтому я и говорю о том, чтобы выделить отдельные полноценные x86 ядра под обратную совместимость, чтобы они работали отлично, но их всего-лишь было не так много, как в топовых процессорах.

Т.е. не для мобильных разработчиков, у которых это всё уже итак есть, а для десктопных.

Мобильные разработчики сейчас пользуются для отладки эмуляторами (включая владельцев MacBook, к слову). Разве нет?

Или для любого другого десктопа на ARM под Linux?

Уверен, что большинство разработчиков тестируют ПО именно на QEMU, иначе Debian не смог бы выйти на aarch64 уже в конце 2014 ввиду отсутствия железа и дороговизны плат разработки в то время.

Почему Linux не завоевал десктоп? Потому, что игры для него пишут в 100 раз реже чем для Win и консолей. Все отговорки про «линукс сложен для домохозяек», — бред. Эта сложность скрывается без проблем при вкладывании бабла (и в разработку и в маркетинг), как это было сделано с Android. Это как раз и есть создание рынка. Для десктопов на Linux, никто не создаёт рынка, и если пытаются, то мелковато, и рынка выстроить не в состоянии.

Игры это просто пример. Возможность делать массовый продукт вот, что важно.

Почему Chrombooks до сих пор существуют на ARM? Потому, что есть рынок. Который создал Google. Скрыв сложность Linux от домохозяек. Google в это вложился и создал рынок. Теперь тоже самое делает Apple. Причём пока в той-же нише примерно.

Массового универсального десктопа на ARM, не существует. Его нужно создавать, создавая рынок.

Почему Linux не завоевал десктоп? Потому, что игры для него пишут в 100 раз реже чем для Win и консолей.

Смотрю на свою библиотеку в Стиме и не согласен. Примерно четверть игр портированы на Linux. Спасибо дядюшке Гейбу, еще столько же запускает Протон.

Так для ублажать хайпожоров есть консоли.

А на ПК до выхода первого/второго сервиспака SeasonPass заядлые геймеры как раз и не смотрят — там еще в Discples II и HoMM III не все переиграно.

но ведь компы станут мощнее через год

То есть, у этого автоматически пропишется в системнике Ryzen 6950X, а то и целый TR X990 и парочка 4090? )

Топовое доступное на рынке к массовому отношения не имеет.

и по той же стоимости что немаловажно

Смотрит на цену 2077 в steam и psstore

Ню-ню. Консоли — это, прежде всего, сервис и унифицированная программно-аппаратная среда, т.е. отсутствие типичных софтовых заморочек.

Плюс на старые игры цена со временем уменьшается (издатели снижают «полный ценник»), а когда появляется скидка 85%, то это просто улёт.

К этому добавляем всякие humble bundle ($12 за месячную подписку с 6 играми на выбор из 24), оттуда же берём игры по $1, и так далее.

У меня в Стиме три аккаунта разных стран, поверьте мне, я знаю, о чём говорю.

Даже в США можно достаточно дешёво покупать игры. Если не гоняться за хайповыми тайтлами. А в этом помогают вышеупомянутые HoMM 3 и Disciples 2.

Я могу либо пиратить, либо покупать игры, недоступные в моём регионе, на американский аккаунт. Предпочитаю второе.

Обычно американцы и европейцы заводят аккаунты развивающихся стран ради экономии, у меня американский аккаунт не ради экономии.

Конкретно за Стим не скажу, но в некоторых сервисах мне поддержка рекомендовала заводить аккаунты для разных стран, как стандартный способ разруливания ситуации "гражданин одной страны и резидент другой страны"

для меня, как геймера ничего не изменилось за годы. как держал две оси (работа и вин для игр) так и держу. я не особо разбираюсь, но такое ощущение что протон надо под каждую игру допиливать, иначе я не понимаю почему до сих пор тонны игр (не ааа, а инди ) на нем не работают. имхо такими темпами ничего не измениться на рынке игр для линуксов, т.к. среднего геймера не устроит ни 25 ни 50%

Одно слово: Intanium. Его похоронила отсутствие должной совместимости с x86

Нет, Itanium похоронила дороговизна и отвратительная цена/производительность с очень узким рынком. HP его заказал, HP его похоронил.

При эмуляции x86 только.

В нативном режим Itanium себя хорошо показал.

HP его заказал, HP его похоронил.

Враньё.

HP судилась с Интел чтобы Интел продолжала выпускать Itanium. Интел не смогла написать хороший компилятор для него.

Если бы AMD не сделала AMD64, то сидели бы на Итаниумах щас.

Ситуация с ARM совсем другая. У него офигенно удобная для производителей модель лицензирования с очень невысокой стоимостью.

После покупки ARM Нвидией и разрушением Трампом свободного рынка этот ARM стал нафиг никому не нужен. Переходят на RISC-V или OpenPOWER.

Яблоко влило денег в продвижение своего проца, и

Серверные ARM много кто делает, пока не преуспели особо.

этот ARM стал нафиг никому не нужен.вряд ли инициатива эппла с ARM провалится, их маркетинговая машина всему миру объяснит, что MacBook на ARM предел мечтаний любого человека. Так что ARM будет очень даже нужен ;)

Ну вот после анонсов и обзоров М1 я в первый раз серьёзно задумался о покупки Air, а то не читал, но осуждаю. )

P.S. У меня вот вообще два ноута, и все живут от розетки. Всегда. А мобильным является телефон или планшет. Ну и там да, ARM, в телефонах-то.

Поэтому у меня все ноутбуки живут не меньше 6 часов от батареи, это одно из обязательных требований при выборе и покупке.

20 часов — очень круто. Это когда утром туда, днём там, вечером обратно. Всё это на самолётах / поездах. Грубо говоря — гарантированные сутки работы (с перерывом на сон) в реальных условиях.

Ну т.е. я согласен, что 20 это круто — но это практически предел. Я бы даже сказал, что предел это 24-8 на сон, или еще меньше. И больше никому практически не нужно. И да, работать 16 часов вредно, это я вам уверенно говорю.

В реальности там будет включен wi-fi, будет работать IDE, например PyCharm, который при каждом допечатывании условного класса или объекта нагружает проц под 100% (пилорамная нагрузка, вверх-вниз), браузер (о прожорливости JS кода не говорит только ленивый), что-то там еще. То есть реально время работы будет меньше. Причём, я думаю, минимум на треть.

И потом, я не работаю 16 часов, я могу на движухе быть 16 часов, а это не работа, это развлечение (раз в месяц-два). Наконец, ну сидишь в аэропорту, в самолёте или в поезде, делать нечего. Достаёшь лэптоп и фигачишь.

К примеру, написал систему деплоймента средней руки проекта именно в аэропорту. Ну получилось так, нахлынуло вдохновение.

В другой раз летал — написал торгового бота.

И потом, я изложил свой сценарий, он вполне типичный — многие ноут вместо настольной машинки держат только ради того, чтобы перенести от одного стола с розеткой до другого. Иногда — выйти в переговорку (где тоже есть розетки и экран). В моем окружении это практически все. Я не говорю что это все — но таких много.

если бы я в молодости не работал по 12 часов, я бы сегодня возможно был более здоровым, чем есть

Не в качестве спора или наезда.

Не такой уж молодой и с детства не здоровый, 3 работы, 14-16 часов в сутки только где-то на работе не считая дороги и 6,5 дней в неделю…

А что делать, если зарплаты с этих 3 работ едва дотянули до половины средней по области? Что на одну не проживёшь, а уехать — нормально оплачиваемую работу не смог найти

предлагаю воспользоваться моментом и найти удаленную работу (пока бушует пандемия, даже банки вынуждены держать бОльшую часть айти сотрудников на удаленке).

Сейчас даже ручным тестировщикам-джуниорам платят вполне достойно. Если вдруг не вы не админ и не умеете программировать.

P.S.: я почти так и сделал. Осуществил давнюю мечту — найти работу в другом городе без переезда.

Не здоровый? Гагарин по сравнению с вами овощ на искусственном дыхании. Вы вообще спите? При таком здоровье вам прямая дорога на олимпийские игры — все медали соберёте.

> А что делать, если зарплаты с этих 3 работ едва дотянули до половины средней по области?

С такой работоспособностью минимум в Москву можно ехать чисто на авось автостопом без гроша в кармане. Что за область и что за работы хоть?

А дворник может аж в трёх местах работать, «и в министерстве на счету, и в Академии считаются!»(с)

недавно заменял сторожа — днём сидишь админом, ночью спишь сторожем, опять днём админом… Но почему-то устаёшь будто работал физически. То есть ночью отдыхать не получается.

А зарплата раньше была на 1 тыр больше, чем вышенаписанное "днём админом", сейчас она заметно меньше. Ну и оно "сторож-истопник-дворник_у_здания"

нельзя. Им платят столько же (сколько инженерам, эникейщикам и "почти админам"), но при этом вакансий дворника давно нет, заняли пенсионеры.

день техником-админом, 2-4 часа на прежней работе эникейщиком и до 22-23ч у знакомого на мебели, где на данный момент из постоянных работников остался я один (кто болеет, кто уехал домой в другой город...)

И кстати да — удаленка. По нынешним реалиям все почти ее предлагают. За последние пару месяцев мне приходило штук пять предложений пообщаться, и пару раз удаленку предложили с ходу, даже не спрашивая меня.

С другой стороны, так зарядка мастхэв, как ключи. А когда её раз в месяц только нужно использовать, то наверняка понадобится когда рядом не будет.

На фоне 4,5кг ноутбука и 1 кг сумки я пренебрегаю

У меня настольный ПК в сборе легче, всего 3 килограмма :)

Core i7-4770 4C/8T 3.4 (3.9), 16GB, GTX 1050 Ti, 2*2,5 SSD в алюминиевом корпусе и с блоком питания на борту (правда, поскольку я начал до Steam Machines, то корпус делал под более распространенные тогда PSU TFX, а жизнь показала, что надо было под PSU SFX делать).

Размер 300*250*90, объем 7 литров.

Учитывая, что с первого дня жизни этого проекта я сменил 5 городов, то мне кажется, что идея была выигрышной.

Хотя бы потому, что высокая автономность многим нафиг не сдалась.Да ну?

У меня вот вообще два ноута, и все живут от розетки. Всегда.Железная аргументация! Мы, наше царское величество, властью, данной нам Богом, заявляем: автономность ноутбукам не нужна.

Все равно ведь в лес его на неделю не возьмешьБандура 14" стоимостью over 1k$ в лесу действительно не нужна. Такие машинки обычно едут с хозяином в автомобиле и носятся в дипломате или специальной сумке. Хотя, у кого-то бывает ещё такой кейс — научная экспедиция в труднодоступные места, куда можно разве что заброситься вертолётом.

Ну вот зачем вам ноут с работой от батарейки 20 часов?Чтобы заряжать его также часто, как и смартфон — раз в 2-3 дня. Аккум дольше проживёт. И начнёт умирать уже тогда, когда сам ноут морально устареет.

Т.е. есть некий лимит автономности, выше которого уже бессмысленно ее наращивать.Вот силюсь всё себе представить, где ж этот самый лимит есть. Вот были бы ноутбуки, которые могли бы работать неделю — тогда их можно было бы смело брать в отпуск, и не переживать, что в гостиницу не завезли розеток нужного вида, напряжения и частоты. Лимит автономности в настоящее время диктуется исключительно массой и размерами АКБ, а никак не длительностью работы.

Не ради автнономности, у меня тоже ноут живёт от розетки всегда, если не забыл включить придя в офис или домой. Тут именно поиграться хочется ) Технически интересная штука получилась, кажется, если получится линукс и/или докер завести

А вы что, реально верите тестам? Я думаю как раз это чистый маркетинг. Ну не на 100% конечно, но точно не без этого.

Ну и потом, мне вот нужно обновить машинку. Что вы думаете я буду ставить в первую очередь? Память до 64Гб.

Хотя я заранее согласен, что такие люди, кто рассматривает покупку HP ZBook — они меньшинство.

И если нет привязке к платформе, то зачем за худшее переплачивать.

По поводу тестов. Эти тесты кто только уже не выкладывает. Люди компы уже с 16 числа вроде бы получают. Так что тестам верю.

А в общем, тоже удивляюсь.

Я был бы рад ПСИе карте с армом или рискомЯ бы тоже. Сам удивляюсь, почему до сих пор никто не сделал arm-овый одноплатник в виде PCIe-карты. Не промышленный компьютер, который вставляется в пассивную материнку, а такой, чтобы можно было вставлять в обычный десктоп или сервер, чтобы она была видна как ethernet-адаптер. Конечно, в ней должно быть 2 ethernet: один был бы разведён на PCIe-bridge, другой — наружу, на разъём. Разработчикам на такой компьютер в виде PCIe-карты удобно было бы заливать и сразу тестировать софт, а обычный пользователь мог бы разместить там ноды для Tor и прочих скрытосетей, DNSCrypt-клиент, VPN-клиент. А ещё из таких карт можно было бы собрать кластер для какой-нибудь студенческой лаборатории.

обычный пользователь мог бы разместить там ноды для Tor и прочих скрытосетей, DNSCrypt-клиент, VPN-клиент.

Это НЕ обычный пользователь.

Ну и прикиньте, сколько надо вложить денег, и сколько потом продать устройств, чтобы получить прибыль.

Были геймерские карты с подобным функционалом — не пошло.

Но в целом, вы описали функции типичного роутера. Так почему бы его и не взять?

en.wikipedia.org/wiki/SunPCi

Это слишком темная история.Это был типа совместный проект.Зачем менеджеры НР похоронили свой успешный процессор не понятно.(ходят слухи про утечку инфы о переговорах Бабаяна с SUN) Да они отставали по частотам про сравнению с тем же Alpha.Но был очень экономный процессор, у них при хорошей производительности кэша 2 уравня долго не было, только в последних перед закрытием появились.А так был лидером по командам за такт-до 6 шт с арифметикой!

Но! Они сделали маленький шаг для человека и огромный для человечества. Они показали и продолжат показывать что ARM может конкурировать с x86 в сегменте десктопов. Как обычно, такое уже пытались сделать, вспомним робкие попытки Qualcomm, с ноутбуками на снапах, но ничего не вышло.

А у Apple выйдет (но это не точно).

В итоге будет как обычно, Apple сделала, остальные рванули за ней.

Рынок десктопов наводнят производители ARM и Intel (И AMD) придётся уже не вяло пихать друг друга, а полноценно конкурировать с огромной кодлой ARM производителей. Что, скорее всего, похоронит Intel и, с чуть меньшей вероятностью, AMD. Всё же они более динамично развиваются.

Так что, как бы я не любил технику Apple, именно их действия, зачастую, двигают рынок.

Сделать Not So Long Instruction Word. Насколько я понимаю, именно с шириной VLIW был допущен просчет, что потом компилятор не мог наполнять бандлы командами. При этом остальные идеи в IA-64 весьма ценны и их жаль в стол хоронить.

укоротить бандл команд

Там и так 3 инструкции максимум. Куда уж ещё укорачивать?

При этом остальные идеи в IA-64 весьма ценны и их жаль в стол хоронить.

В современных реалиях эти идеи гроша ломаного не стоят.

Предел возможностей Itanium это линейные циклы с вращением регистров

Может у Itaniumа есть еще шанс, например если ему укоротить бандл команд?

У него нет шансов, пока из-за тормозов DRAM получается, что из L1 получить данное это 1-2 такта, а из DRAM — до 200 (иногда и больше). Эта неровность убивает любое пред-планирование команд.

Хотя можно, конечно, комплектовать SRAMʼом. Для некоторых задач и 10-15-кратное удорожание оперативной памяти вполне сойдёт… там и кэш будет не нужен...

Насколько я понимаю, именно с шириной VLIW был допущен просчет, что потом компилятор не мог наполнять бандлы командами.

Дело не в ширине, дело в том, что оно explicitly parallel instruction computing.

При этом остальные идеи в IA-64 весьма ценны и их жаль в стол хоронить.

Это какие же?

Intel действительно упоролись своим положением собаки на сене. X86 обратная совместимость это здорово

Разве у ARM нет обратной совместимости?

Intel должен бояться не Apple, а как раз Nvidia: именно они сосредоточили у себя разработку и cpu и gpgpu.

Самое смешное, что я в 2007 году лично слышал от маркетинговой шишки Интел рассказ о том, что будущее за носимым компьютером/телефоном и что это будет главный рынок. Забавно, что, все понимая, эти этот рынок проспали.

Они пытались не проспать: были смартфоны на Атомах. Кстати, процессоры по тем меркам были весьма неплохие, на них даже флагманские устройства делалась (Lenovo K900, например). А потом… Ну, это уж нам неведомо.

hitech.tomsk.ru/2006/09/29/idf_fall06_intel_demonstriruet_80jadernyjj_processor_s_proizvoditelnostju_v_1_teraflop.html

www.ixbt.com/news/hard/index.shtml?07/75/60

Я помню, как облизывался на nVidia Shield Portable (Console). Но в результате вместо того, чтобы купить классную штуку, купил доллары (не прогадал).

Не поймите меня неправильно, но это как-то не пахнет массовой революцией. Скорее — нишевым рынком. Я знаю одного человека со Свитчем, и десятка два — с айфонами.

В 720p всё-таки.

И 65 миллионов проданных устройств — это немаленький такой «нишевый» рынок.

www.eurogamer.net/articles/digitalfoundry-2018-switch-mobile-mode-analysed-in-unprecedented-detail

И там числа еще ниже называются. От 360p и далее 432p, 480p, 540p, в зависимости от игр и сцен… Динамическое разрешение, оно такое.

Про проц ничего плохого не скажу, а 1 ГБ ОЗУ было маловато.

Понятное дело смартфон, планшет и ноутбук это удобно, но они не сравнятся с десктопом.

Вот не понимаю, почему не сравнятся? Что позволяет десктоп, чего не позволяет смартфон с тем же набором периферии? Я сейчас не про производительность, если что.

А во-вторых, x86 позволяет достаточно легко поставить любую ОС, тогда как для носимых устройств это не всегда возможно в принципе. Конечно, для большинства пользователей это не важно, но, например, для меня — один из основных критириев при выборе устройства.)

Snapdragon 636, 4 ГБ ОЗУ.

П.С. При свободной памяти вообще не подвисает, а если активно махать рукой то и комментарии пролистываются быстро. Памяти отжирает порядка 700 МБ.

И кому оно надо больше памяти процессоров чтобы просто было? Единицам. Половина населения земли в интернете сидит почти только с телефона.

Вообще, если отвлечься и подумать, то удивительно такое слышать в 2020 году, когда все уже просто носятся с утверждением что будущее, оно за числодпробилками: обработка биг дата, распознавания, ML/DL, генерация видеопотока с высокми битрейтом и кодеки к нему, дедупликация данных на ZFS RAID и т.п., смарт-контракты на blockchain и куча всего. А 6 млр хомяков со смартом в кармане будут потреблять ровно то, что для них сделают. Все эти фуфелы с постами в фейсбук из серии «Crowd Sourcing» — не они будут задавать тренды или генерить новую НТР.

В конце-концов, на чем создавать обещанный голивудом скайнет?

Я сейчас не про производительность, если что.

А можно и про неё. Флагманские модели значительно обгоняют всякие там нижнесегментные офисные машинки. Причём даже флагманы прошлых лет.

Но да, если прикрутить тот же объём периферии и допилить ОС — пользоваться смартфоном будет ничуть не менее удобно (по крайней мере для обычных офисных задач, я не предлагаю на нём чертить в электротехническом САПРЕ, которого туда не завезли, или пока не завезли).

Плюс USB Type-c, который стал универсальным стандартном и для зарядки и для передачи данных и для вывода изображения на экран (но, пока, увы с оговорками).

В итоге именно смартфоны могут сделать идею BYOD реальностью.

Ну если текст редактировать, причем не большой, то может быть я и поверю. А так мобильное железо (если брать чистую производительность, без юзанья всяких узкоспецифичных расширений логики таких как какой-нибудь аппаратный кодек, ии и т.п.) — то вряд ли новейшие фламаны смогут потягаться с офисными low-end дестопными машинками, со схожим объёмом ram, 10-и летней давности.

По крайней мере у меня honor10, это типа флагман 18 года, и десктоп околотоп по меркам 2011. Ну нигде Хонор не быстрее, даже если взять основанный на quaker3 движок ioquake3, то на Андроиде спервого взгляда кажется что типа да, круто, красиво, но стоит сделать скриншоты на телефоне и ПК и разница в графике становится очевидна — на мобилке на сглаживания ни анизотропки. И более того все эти 60fps падают когда много игровых объектов.

Далее, листинг 36 мегапиксельной фотки в маштабе 1к1 это прям на нервы действует. Про комп думаю не стоит говорить что ему это легко — и так понятно.

Так что зря вы про производительность.

Кроме всего прочего — компы внушают доверие. Мобилки вам внушают? Да они мрут через 2-3 года очень аккуратного юзанья. А в компе если что-то сломается — можно в кратчайшее время изолировать прооблему и решить её. А с мобилкой — идти в сервис, где ее будут греть феном чтобы разобрать, а потом от этого фена пойдут желтые пятна после ремонта…

Мобилка — это карманный помощник — у него нет цели быть мощным, удобным и надёжным для договременной профессиональной работы. Нет и не будет.

Не измерял, я же сказал, что я не про производительность. Я про форм-фактор "маленькая коробочка с сенсорным экраном, универсальным разъёмом для подключения хаба/док-станции и батареей". Понятно, что для задач типа компиляции миллионов строк кода за раз или рендеринга полноценного кинофильма большая коробка с той же плотностью электроники сделает задачу быстрее, но я о задачах, где количества транзисторов в корпусе телефона недалёкого достаточно для нормального UX в сценариях, где у современного десктопа CPU почти всегда в idle, потому что ждёт io, а оперативка забита кэшами файлов по сути.

А в компе если что-то сломается — можно в кратчайшее время изолировать прооблему и решить её.

Это если комп самосборный или типа того. А если это какой-то брендовый системник на расширенной корпоративной гарантии, то всё то же самое, кроме того, что автомобиль нужен до сервиса довезти.

M1 — вот у него … честные ядра =)

У него половина ядер урезанные, речь шла об этом.

И что что урезанные, зато при ненагруженности меньше жрет, да и производительные ядра шустрей чем чем у Интел и амд.

То что компы вам внушают доверие — это чисто психологический фактор.

По поводу Хонор 10, у меня он быстрее пашет, чем ноут 2015 на i3, который жужит во всю и нагревается сильно под нагрузкой.

Ну вот только за прошлый месяц вроде пара статей была про Linux-смартфоны. Или для вас нормальная опреационка- это WIndows?

Librem Purism, PinePhone не делают погоды.

Это очень, очень нишевые решения, продающиеся хорошо если тысячами штук.

Я же не говорю, что если прямо сейчас взять любой смартфон на рынке, то им можно заменить топовый десктоп. Просто высказал мнение, что если вендорам железа это будет интересно, то объективных препятствий не вижу.

если вендорам железа это будет интересно, то объективных препятствий не вижу.а им неинтересно — самсунг свой DeX переделал в компаньона десктопной винде, хотя поначалу развивал Ubuntu десктопный прям на своих DeX устройствах.

Всегда интересно было, откуда они знают про востребованность или её отсутствие, если эти устройства, по сути, не вышли на широкий рынок?

Ну вероятно есть статистика использования. Может там пользовался один на миллион.

Во всех таких начинаниях есть положительная обратная связь. Если на рынке миллион устройств с поддержкой технологии, то может быть будет один пользователь на это всё, и он будет работать в отделе тестирования технологии. Зато когда будет 1,2 млн. устройств — пользователей будет 3, когда будет 10 млн. — их будет 100 тыс.

Да даже банально время на привыкание нужно, чтобы не-гики прознали про наличие такой возможности в их гаджете, ну и время на лечение детских болячек дать (а как я слыхал, там их было немало, и по сути так они и остались). А так-то, конечно — можно на минимальной выборке не увидеть 100% покрытия и убить начинание на корню.

GNU/Linux+Gnome/KDE/...?

Где при наличии аппаратной клавиатуры, экранная не вылазит постоянно

У меня это и на x86 неттопе нормально не работало (ubunta gnom plasma что ещё пробывал уже не помню)а мне всего лишь только браузер нужен был. В первый раз в конце 17года и последний с 19году. Единственная win 10 (8,1 тоже должна нормально уметь, но не пробывал.) из коробки могла нормально работать с подключенными клавиатурами и тачем и понимать какой именно в данный момент используется способ ввода.

Ну вот у меня есть tv-box, перешитый на armbian. Всё норм работает, полноценная десктопная система.

Просто подобная система нафиг не впёрлась на мобильном устройстве. Удобство использования в районе плинтуса.

То-то на iOS для планшетов куча проф софта, хорошо нагружающего процессор.

Зная авторитет Apple, можно не сомневаться: софт будет. Потому что как бы мы её не критиковали, но в чём ей не откажешь так это в умении внедрять инновации. Сами, может, ничего нового не изобретают, но внедряют на ура.

Емнип, ему давно уже требуется подкидывать рендерер фанатский, потому что его старый OpenGL косячный, а подсистемы, на которые основной D3D/DDraw полагался, выпилены давно из винды.

Сейчас софт пишется сразу под много платформ.

Если раньше Windows X86 была безальтернативной платформой, то сейчас если софт даже и пишется под Винду, всё равно закладывается кроссплатформенность.

Невозможность нормально написать имя компании это диагноз.

кто захочет нормальный видеоускоритель

будет чуть попозже с mbp 16 и imac

просто хочет Интел или АМД

просто это как? как хочу красненькую машинку?

кому под ОС не дали драйверов

Да все появится. И ОС и драйверы. Эппл просто показала, что так можно, если продажи будут ок, все начнут мигрировать на АРМ косяками.

Offtop: CH341A programmer — это который китайский, крякнутый и накрытый сверху VMProtect? Идет в комплекте с копеечными программаторами с алиэкспресса. Но зачем? Для работы с этим программатором есть длинный список нормального софта (AsProgrammer, Colibri, flashrom в конце концов)

del

у аппла (сам не использую, имхо) засчет контроля ПО не позволяется сильная гонка в размерах ПО, получается оптимизированнее, проще и за счет этого и их предпочитают — отзывчивость у систем выше чем у их конкурентов. большой выбор хуже чем 2-4 варианта, но максимально вылизанных. привет капитализму и сотни сортов

у меня под Вин 10 есть ПО

А под MacOS? Они уже 1 раз переходили на интел и ничего, перешли. Так что и еще раз перейдут и весь софт, который деньги приносит, быстренько адаптируют так или иначе.

У закрытого софта есть проблемы, увы, видимо скоро придётся регулярно запускать qemu под арм для эмуляции x86.

BogoMIPS: 50.00

Hardware: Marvell Armada 370/XP (Device Tree)

А что, кросс не работаел 5 лет назад для АРМ?

Дебажить на таргете — это экстренные случаи.

А сборка — в принципе не имеет смысла, как мне кажется, особенно сейчас, когда с контейнерами легко сделать нужное окружение типа правильной версии gcc без танцев с бубном.

Видимо apple очень хотела выпустить финальные устройства в этом году. Или результаты оказались лучше, чем они ожидали и пришлось форсировать сроки.

Если подымается linux, то поднимутся и контейнеры.

Правда, некоторые вещи придется собирать под архитектуру ручками, благо oss под это и рассчитано.

Или появится повод глянуть в сторону Erlang/Elixir.

Зная эпл — мы перестанем быть владельцами и компов, и софта

Просто кто-то не читает тексты лицензий.

И это касается не только Apple, если что.

Владельцами софта мы перестали быть лет 20 назад.

Чушь.

Просто не используйте для софта принципы, применимые только к материальным предметам.

Владелец софта — это его разработчик или тот кому разработчик передал права на продажу софта.

От того, что вы «купили MS Office» вовсе не следует, что теперь у вас есть права на многократную перепродажу лицензий на MS Office. А у фирмы Microsoft — эти права есть. Вот её и можно назвать «владельцем софта», а вы всего лишь «владелец экземпляра».

а вы всего лишь «владелец экземпляра».

Нет.

Владелец права использования без права передачи другому лицу.

Ограниченного неисключительного права использования.

а вы всего лишь «владелец экземпляра».

Нет.

Владелец права использования без права передачи другому лицу.

Необязательно.

К примеру в Германии даже Windows по лицензии OEM, что во всех странах привязана к железу и умирает вместе с ним, высудили право продавать.

Разумеется, не большее число экземпляров, чем купили.

Например 20 лет назад заплатив за лицензию Photoshop я не становлюсь владельцем программы но я могу пользоватся ей сколько захочу, пока у меня работает железо и операционка. А вот сегодня к примеру по хотению Adobe Photoshop перестанет работать по всему миру, кончится срок подписки и они например не будут больше его продлевать — а выпустят что то новое например…

Немного дополню — я лично под текст «Владельцами софта мы перестали быть лет 20 назад.»

Например 20 лет назад заплатив за лицензию Photoshop я не становлюсь владельцем программы но я могу пользоватся ей сколько захочу, пока у меня работает железо и операционка. А вот сегодня к примеру по хотению Adobe Photoshop перестанет работать по всему миру, кончится срок подписки и они например не будут больше его продлевать — а выпустят что то новое например…

Это особенность конкретно Photoshop и лет этой особенности не 20, а всего лишь несколько.

Больше того, вы его продать могли спокойно. Что для меня гораздо больший ярлычек права владения. А стим игру уже не продать особо без доброй воли стима (есть ли она я честно говоря не помню)

Вы поосторожнее с такими высоконадёжными заявлениями, а то я всё же напрягусь и найду политику лицензирования Alias PowerAnimator, например, который ещё 30 лет назад был исключительно _арендуемым_ продуктом.

Просто люди только сейчас начали понимать(когда это стало действительно массовым явлением) что они ничего никогда не покупали, они всё это время — арендаторы.

>>Это особенность конкретно Photoshop и лет этой особенности не 20, а всего лишь несколько.

Да ну? А вы исследования проводили, да? Вчитывались в лицензии?

PS: Надо будет Valve/Steam сообщить что они — «всего лишь частный случай и им всего лишь несколько лет». На Хабре специалисты сказали, ага.

linustechtips.com/topic/953835-you-own-the-software-that-you-purchase-and-any-claims-otherwise-are-urban-myth-or-corporate-propaganda

Интел предлагает «убогое» решение — CPU + мост. А на мамке у вас — разъемы, питание, ну и пара ПЗУ флешек с батарейкой. Ну и какой нить суперио чип, для всяких клавиатур и тпм.

Все остальное — в 2х чипах интел. А именно:

В мосте — контроллеры SATA, PCIe, Ethernet, USB и прочие вайфаи и итуси. В процессоре — контроллеры RAM, PEG (PCIe для видюх), графика, ME и прочие эмэмикмсы.

При этом я не понимаю зачем закладывать в мост 15 портов PCIe или 16 SATA или 16 USB, плодя количество ножек в геометрической прогрессии…

Большинство ARM — это SoC, без моста, все в проце. А Apple еще на него влепила RAM — вообще красавцы, выкинули сложную и не любящую тряску DRAM, заменив ее на memory-down. Мамка в таком варианте — просто плата со слотами расширения и развязкой питания. Какая тут инфраструктура? Нет моста — нет проблем при переходе между поколениями процессоров.

При этом у интел есть еще гадки ME, который не слабо потребляет, и хрен знамо чем занят. И загрузчик для интел (БИОС) — это тоже монстр в пинетках из UEFI, в котором черт ногу сломал. У ARM — все гораздо проще, лучше и понятней.

А запустить игру 99 года — можно и через эмулятор x86.

P.S. Uboot для ARM собирается GCC, под линукс. Интеловский EDK2 (скелет для UEFI BIOS) — лучше всего собирать в MS Visual Studio. У интела система сборки на «батничках». Когда увидел это — понял, они все, закончились.

Проснитесь, сейчас и интел комбайны делает в ноутбучном сегменте. Только ноутбук и смартфон — это 2 большие разницы, хотя бы по организации питания: разница на порядок. И интеграция компонентов в кристалл ни к чему хорошему не привела. Будет проще, говорили они. Будет дешевле, говорили они. Не стало проще, не стало дешевле. Комбайны вылетают, особенно из-за вечной интеловой проблемы с юсб, реже — из-за повреждения vrm, стоимость замены камня сравнима со стоимостью ноутбука, если цена, по крайней мере, до 30 тысяч, но не суть, потребителю не легче. Раньше это была замена относительно копеечного моста, особенно во времена южников/северников, ибо их состав позволял выпускать себя на старом окупившем себя обррудовании. Процессор же занимался сугубо своими делами, и от косяков остальной части пк не страдал. Если ноутбучные/настольные армки будут по цене хотя бы вполовину интела при равной скорости, либо ниже, то это еще куда ни шло. В противном случае, это очередной виток закабаления поребителя.

ибо их состав позволял выпускать себя на старом окупившем себя оброудовании

и в результате чипсеты грелись едва ли не больше Атомов.

Все же помнят кулеры на чипсетах — это оно — старое, окупившее себя решение.

Нет моста — нет проблем при переходе между поколениями процессоров.

Лютый, феерический бред.

Запустите-ка прошивку от телефона А на телефоне Б. Там же ARM SoC, экономия ножек, все дела. Я даже на инженерных версиях железа готов запустить (чтобы исключить secure boot и проверку подписи вендора).

Берешь последний ролик coldfusion с ютуба, переводишь и выдаешь за свою статью

А, да! И рекламный блок в конце вставлять! Куда же без рекламного блока.

Имхо, главное преимущество x86 на сегодня — всеобщая совместимость. Если у меня есть какое-то устройство с процессором x86, то я могу зайти на сайт любой операционной системы, скачать сборку (Win/Lin/CrOS/etc) и, вероятнее всего, она успешно встанет на мой компьютер. И наоборот, покажите мне хоть одну ОС, которую я могу установить на произвольно выбранное ARM-устройство. Нет таких, это невозможно — под каждый планшет своя прошивка и т. д.

Но для пользователей важно удобство, для корпоративного использования — вендор с поддержкой, сертификацией и курсами.

В результате Gentoo реально нужен единицам процентов. Даже среди (в среднем) продвинутых Linux пользователей.

Кстати, как представитель махрового ынтырпрайза, должен отметить, что даже за установку свежего unzip из исходников машину снимают с поддержки (вот так вот). В лучшем случае — соберут куда-нибудь в пользовательскую папочку, после десятка согласований.

Как нынешний пользователь генты я сам понимаю, что я тут ССЗБ во всей красе, зато получаю именно то, что моя пятая точка себе хочет заиметь.

просто писал тикеты, что что-то не работало/глючило, а в результате переписки прилетали скрипты и пакеты с инструкциями, как это поставить, собственно голова у меня не болела о «надо бы новый libwornderass скомпилить и поставить чтоб pimpmyfsck завелось», она болела у техподдержки красношляпых

Тоже рабочий вариант, если у вас есть много времени.

Я работал (работаю) в RnD, там обычно просят «побыстрее».

Имхо, главное преимущество x86 на сегодня — всеобщая совместимость. Если у меня есть какое-то устройство с процессором x86, то я могу зайти на сайт любой операционной системы, скачать сборку (Win/Lin/CrOS/etc) и, вероятнее всего, она успешно встанет на мой компьютер. И наоборот, покажите мне хоть одну ОС, которую я могу установить на произвольно выбранное ARM-устройство. Нет таких, это невозможно — под каждый планшет своя прошивка и т. д.

А зачем эта совместимость, если имеется определённый шанс, что что-то не взлетит под другой осью. Например:

1) Не будет дров вообще под Win7/Win10.

2) Конкретно эта сетевая/wi-fi/BT карты не запускаются под конкретно этим дистрибутивом Linux.

3) Всего хватает, но энергосбережения и оптимизацию не завезли, в итоге ноут работает полчаса вместо четырёх.

4) Мощности самого железа не хватает, чтобы тянуть эту самую новую сборку.

Нет, вы не подумайте, я не топлю против очевидной пользы обратной совместимости. Я лишь хочу сказать, что она не настолько всемогуща.

Сегодня миром правит сетевой формат — 70% пользователей плевать, что у них за процессор и ОС, главное чтобы браузер запустился, а в нем их любимая ферма/елочка/индикот…

Не понятно как в диаграмме из обзора Anandtech разрыв между 7700к и 9900к может быть в 10%, при том что в 9900к в 2 раза больше ядер и потоков

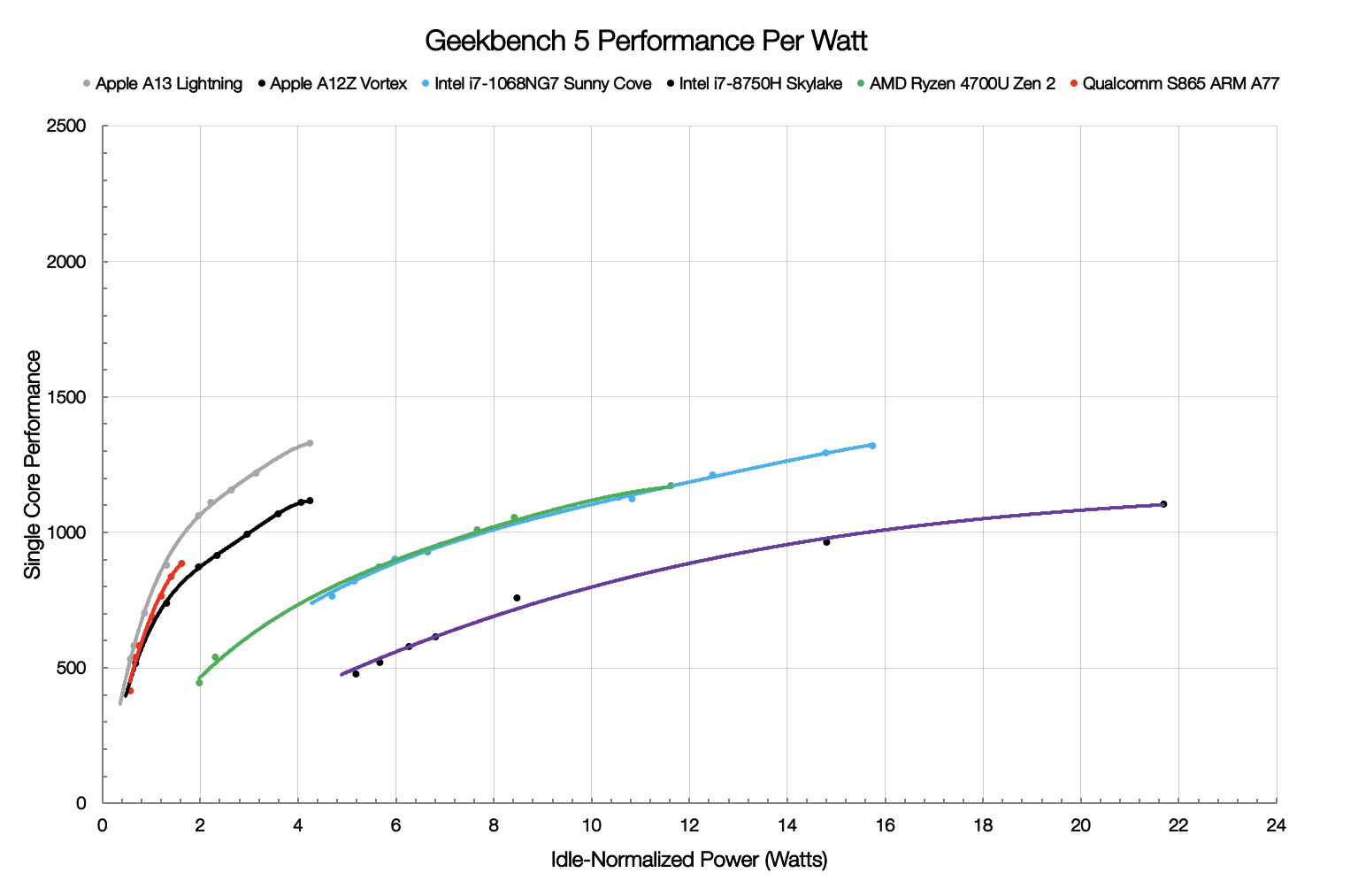

Если вы начнёте смотреть на реальное потребление энергии вместо бумажных TDP вас ждут интересные открытия.

Что такое этот "idle normalized power"?

Он там расположился бы чуть выше A13, если бы эти замеры делали сейчас, а не до выпуска A14 и M1.

Улучшенный тех. процесс + больший результат в Geekbench при примерно том же максимуме потребления.

Это был ответ на:

«Огромная производительность в расчёте на ватт» — примерно одинакова с Zen 2

Мне кажется, картинка достаточно хорошо иллюстрирует кардинальный разрыв в этой метрике между ядрами от Apple и Zen 2.

Zen 3 в мобильном исполнении на данный момент не существует, а десктопные версии плохо помещаются на этот график по горизонтальной оси:

https://www.reddit.com/r/hardware/comments/jrt0ay/apple_announces_the_apple_silicon_m1_ditching_x86/gbxiaaf/

А в чём перл? Это CPU с интегрированной видеокартой для лёгкого ноутбука с пассивным охлаждением. Интегрированные GPU от Intel и AMD сильно слабее, поэтому, чтобы хоть с чем-то сравнить, нашли близкую по производительности дискретную карту.

Так же, как не будет и у тысяч других ультрабуков со встройкой и без Thunderbolt.

Почему его GPU надо сравнивать именно с 2080 или 1660/1080? Эти карты в принципе не влезут в нужный энергопакет. С тем же успехом можно поставить рядом десктопную 3090 и насмехаться.

Тем временем, на рынке интегрированных GPU ничего сравнимого просто нет.

M1 сейчас стоит только в ультрабуках (Mac Mini — отдельный разговор) и именно для них делался.

С любым ноутбуком без Thunderbolt нельзя использовать внешний видеоускоритель. Не говоря уже о том, что ниша использования eGPU довольно узкая.

С любым ноутбуком без Thunderbolt нельзя использовать внешний видеоускоритель.

Спорное утверждение. Еще 10 лет назад, сняв задюю крышечку, к ноутбукам подключали PCIe видюхи :)

Знатное извращение, но ведь работало!

Плашку "перевод" всё-таки надо бы поставить: https://jamesallworth.medium.com/intels-disruption-is-now-complete-d4fa771f0f2c

Покрутить бы этот М1 в своих руках. А то никак не могу избавится от подозрений что эпл оптимизировала некие узкие задачи, на которые и делают упор бенчмарки. А geekbench вызывает серьёзные сомнения в репрезентативности при сравнении разных архитектур — например, на древнем Xeon X5650 браузер летает, а на Galaxy S9 та же страница "подлагивает", несмотря на бОльшую производительность на ядро у телефона.

Это легко объясняется тем, что все эти тесты много лет оптимизировались под x86, включая использование ассемблерных вставок с AVX инструкциями: https://forums.anandtech.com/threads/new-apple-soc-m1-for-lower-end-macs-geekbench-5-single-core-1700.2587205/page-42#post-40361688

Под ARMv8 никто их не оптимизировал, в лучшем случае перекомпилировали "что есть", иногда получая результаты хуже, чем у x86-версии с SSE-оптимизациями через Rosetta.

Серьёзно? Кучка разношёрстных кусков кода, про которые достоверно известно, что многие оптимизировались исключительно под x86, лучше, чем набор специально подобранных и предназначенных для кроссплатформенной оценки разных аспектов производительности CPU тестов (SPEC2006/2017, Geekbench)?

Про какую непредвзятость вы сейчас говорите вообще?

Geekbench — это набор платформозависимых бенчмарков для различных аппаратных ускорителей. К производительности CPU это очень слабо относится.

Комментарий Линуса Торвальдса:

On ARM64, that SHA1 performance is hardware-assisted. I don't know if SHA2 is too, but Aarch64 does apparently do SHA256 in the crypto unit, so it might be fully or partially so.

And on both ARM and x86, the AES numbers are similarly just about the crypto unit.

So basically a quarter to a third of the "integer" workloads are just utter BS. They are not comparable across architectures due to the crypto units, and even within one architecture the numbers just don't mean much of anything.

And quite frankly, it's not even just the crypto ones. Looking at the other GB3 "benchmarks", they are mainly small kernels: not really much different from dhrystone. I suspect most of them have a code footprint that basically fits in a L1I cache.

Сюрприз, на x86 теперь тоже hardware-assisted: https://en.wikipedia.org/wiki/Intel_SHA_extensions

И это Линус писал про GB3, с тех пор они очень хорошо поработали над сравнимостью результатов для разных платформ, и заработали хорошую репутацию. Сейчас в результатах GB5 сомневаются только те, кто не может поверить в то, что ARM в принципе может соревноваться с x86.

Сюрприз, на x86 теперь тоже hardware-assisted: https://en.wikipedia.org/wiki/Intel_SHA_extensions

Вы сначала дочитайте пост, на который отвечаете до конца, потом комментируйте:

And on both ARM and x86, the AES numbers are similarly just about the crypto unit.

Так, а в чём претензия-то тогда?

И там и тут это инструкции процессора, входящие в базовую ISA, которые используются в реальных криптографических приложениях. Тест назван Crypto. Результаты сравнимые.

Сейчас вот Intel Tiger Lake даже выигрывает в этом тесте у M1, что не даёт ему большого преимущества: https://browser.geekbench.com/v5/cpu/compare/5079627?baseline=5078369

Ну я вот тоже, если честно, не могу поверить, учитывая что ARM архитектура создавалась с прицелом на простой и ограниченный набор команд, а также максимальную энергоэффективность. Этот вектор, вроде как, противоположен вектору быстродействия. Физически невозможно на простых коротких командах достичь большего быстродействия, т.к. этих команд потребуется гораздо больше для достижения того же результата

ARMv8 очень далеко ушёл от академических измышлений об ограниченном наборе команд.

Сейчас плотность кода x86 и ARMv8 примерно одинаковая.

У большого количества команд есть свои проблемы. Если мне не изменяет память, то у современных х86 процессоров бывает, чтобы полностью пройти весь пайплан выполнения команды нужно пройти по 12 шагов. И если branch prediction не угадывает, то последующие команды выбрасываются и вам придется подождать 12 тактов, чтобы продолжить работу в нормальном режиме.

Зато их можно параллельно загрузить в 8/16/256 декодеров разом.

Собственно, 8 декодеров были уже в Marvell Thunder.

CISC-инструкции нельзя загрузить параллельно в декодер, не декодировав частично инструкцию — вы просто не будете знать, откуда начинать загрузку следующей инструкции. Поэтому увеличивать ширину процессора для x86 бессмысленно, если не удлинять сами конвейры — что накладывает штрафы на производительность нелинейного кода.

А RISC — он не про упрощенные команды, как многие думают, а про регулярную структуру и заточку на максимальное быстродействие команд.

Хоть ликбез пиши…

С большой шириной уже скорее в ROB упор пойдет — в худшем случае нагрузка на него будет расти как произведение одновременно выходящих с конвейров операций на количество операндов.

Зато можно сбросить частоты, сохранив производительность, что даст возможность понизить напряжение, отчего мощность упадет уже в квадрате — дополнительно к снижению от понижения частоты.

Но да, бутылочных горлышек еще хоть отбавляй. Собственно, их преодоление и обеспечивает рост.

Вы же отлично понимаете, что это не произвольный набор непонятно чего, а именно что отобранные и проверенные целым комитетом куски кода. И SPEC отвечает за результаты своей репутацией.

У вас есть какие-то конкретные факты, что "более реальные" задачи выполняются на M1 хуже, чем на Intel аналогах, при прочих равных?

Если нет, тогда к чему эти спекуляции про затачивание под тесты?

Я уже показывал вам результаты цивилизации через Rosetta:

https://www.tomsguide.com/news/macbook-pro-m1-benchmarks-are-in-and-they-destroy-intel

https://www.macworld.com/article/3597198/13-inch-macbook-pro-m1-review-amazing-breakthroughs-in-processing-and-battery-performance.html

И нет, это не "при прочих равных" и не про процессор.

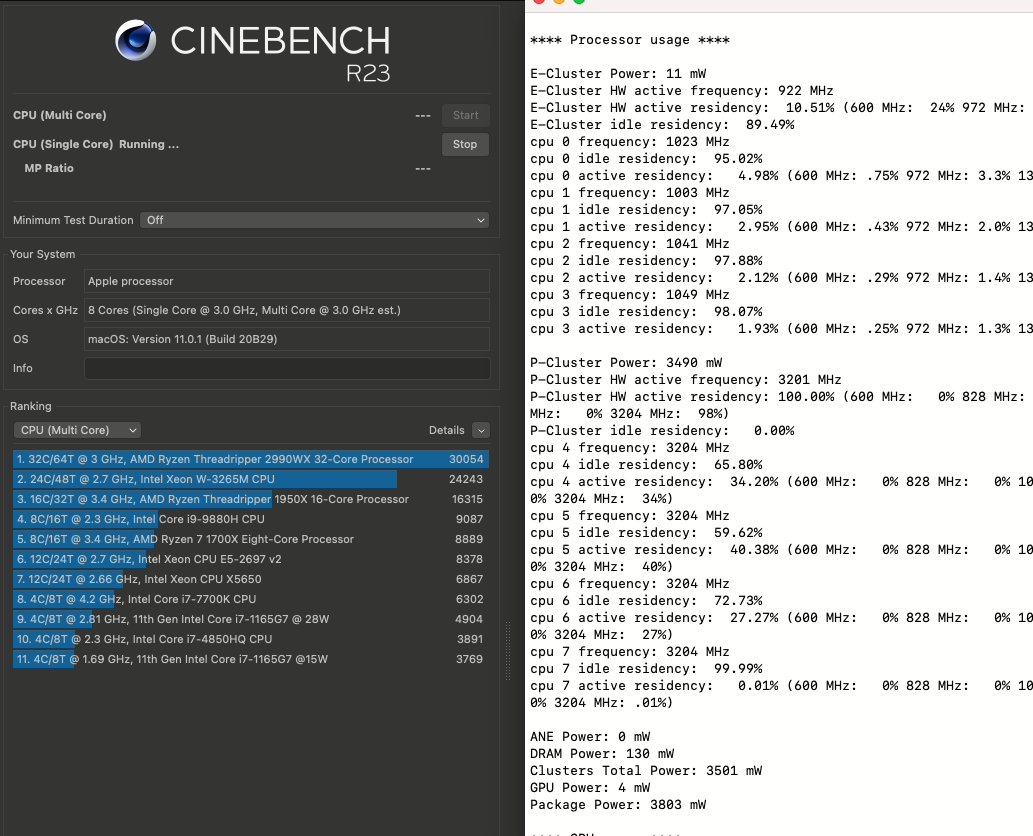

Посмотрите cinebench r23. Имхо, самый объективный бенчмарк.

Cinebench меряет производительность в одной конкретной задаче на одном конкретном "render engine". Его результат нельзя считать взвешенной оценкой производительности CPU в целом.

Плюс к нему тоже есть ряд вопросов:

1) насколько хорошо его успели портировать под M1, учитывая, что под x86 оптимизировали много лет?

2) низкая загрузка CPU на M1

Ну, 23 версию создавали для arm, а не для m1.

Проверить ее можно сравнив результаты обычных х86 процессоров с результатами в прошлых версиях. Насколько знаю, там примерно паритет.

Мне этот тест нравится тем что измеряет грубую производительность. Я думаю со временем вопрос с низкой загрузкой решат или дадут объяснение.

А сейчас бывает что-то не гетерогенное? Даже простые микроконтроллеры сейчас со спецядрами, как минимум, для CRC и крипты.

Справедливости ради, для JS там есть специальные инструкции :)

https://stackoverflow.com/questions/50966676/why-do-arm-chips-have-an-instruction-with-javascript-in-the-name-fjcvtzs

Это просто режим работы преобразования float->int, где определяется что делать если число не влезает в int. FCVTZS делает насыщение до 0x7fffffff, FJCVTZS оставляет модуль 2^32.

Вы ведь помните что в Pentium 4 были специальные инструкции для «ускорения Интернета»? :)

Intel calls the new architecture of Pentium 4 'NetBurst'. The idea behind this name is for me just as unfathomable as the 'Internet SIMD Streaming Extension'

Мне же искуственные попугаи бенчмарков фиолетовы — пусть лучше сравнят что-нибудь вроде вычислительной гидродинамики в каком-нибудь Ansys Fluent.

Если под конкретный бенчмарк у М1 есть подходящее специализированное ядро — то он с лёгкостью уделывает конкурентов, если нет — то сливает по полной.

Так в каких тестах сливает по полной из-за того, что якобы не нашлось акселератора?

упоминая всякие Neural Engine и Final Cut Pro.

Давайте наконец выясним, как Neural Engine помогает тому же Clang?

в каком-нибудь Ansys Fluent.

В SPEC2017 есть тест просчёта динамики жидкостей 519.lbm_r

www.anandtech.com/show/16252/mac-mini-apple-m1-tested/4

M1 там всех обгоняет в однопотоке: любой Интел (с большим отрывом) и даже Ryzen 3 =)

Вот ведь какие хитрецы! Наверное встроили «специализированное ядро» для просчёта fluid dynamics ^_^

А как по мне, ваш Ansys Fluent есть такой же «фиолетовый» бенчмарк, а вот Clang инструмент, которым я пользуюсь постоянно.

А что если запустить виртуалку с андройдом на зеоне и потестить производительность на ней и на смартфоне?

Ну я согласен с тем, что андроид плохо оптимизирован, но исполняется то он на трубке нативно а не через ВМ.

Лицу, пожелавшему остаться неизвестным, спасибо за плевок в карму. Во что это хабр превращается, если за предложение сравнить производительность там и тут так весело карают?

Как-то так и выходит, Geekbench известный оптимизированный под Apple бенчмарк. Есть хороший старыый тред об этом: https://www.realworldtech.com/forum/?threadid=136526&curpostid=136598

Это всё равно что делать выводы про Taycan на основе опыта эксплуатации Lohner-Porsche.

Другие тесты, другая методика, другие датасеты.

В GB3 мобильные и декстопные тесты использовали разные датасеты.

Сейчас, когда мобильные чипы соперничают с десктопами, тесты не отличаются ни чем.

GB3 полное говно, а GB5 вполне годный кроссплатформенный бенчмарк.

оптимизированный под Apple бенчмарк.И что же в нём оптимизировано под Apple?

Давайте детали, не томите уже =)

Даже если бы Clang, LZMA, PDF, HTML парсеры бы как-то хитро оптимизированы под Apple, то сравнивать платформы Apple (x86, ARM) всё можно было бы, верно?

www.youtube.com/watch?v=59gAjXT7qyw

Еще интересно то, что все тесты, где новый arm побеждает x86, сделаны этим гикбенчем

Прям таки все? =)

www.anandtech.com/show/16252/mac-mini-apple-m1-tested

techcrunch.com/2020/11/17/yeah-apples-m1-macbook-pro-is-powerful-but-its-the-battery-life-that-will-blow-you-away

то он там тестирует — неизвестно

А вы… пытались узнать?

www.geekbench.com/doc/geekbench5-cpu-workloads.pdf

www.geekbench.com/doc/geekbench5-compute-workloads.pdf

support.primatelabs.com/kb/geekbench/interpreting-geekbench-5-scores

В основном, по крайней мере.

Если бы вы прошли по ссылке, то увидели бы тестирование в SPEC и других бенчах.

SPEC разумеется показывает тоже самое что и GB. Потому что ядро Firestorm очень мощное и справляется с любыми задачами.

Что они там сами о себе пишут, мне категорически не интересно,

Занятно… То вы утверждали что это якобы «неизвестно», но как оказывается всё прекрасно известно, просто вам не интересен данный вопрос.

В описании представлены опенсорсные программы и библиотеки которые они тестируют в купе с описанием датасетов.

Тесту, который прячет свои исходники, априори никакого доверия.

Вам кто-то мешает скачать те же самые программы и запустить?

у самого интела такая тема была с пентиум 4. который неплохо «ускорял интернет» в тестах, но проигрывал в играх и других программах, где было сильное ветвление кода.

Покрутить бы этот М1 в своих руках. А то никак не могу избавится от подозрений что эпл оптимизировала некие узкие задачи, на которые и делают упор бенчмарки.не удивлюсь, мне тут недавно заявили, что замеры автономности при просмотре видео на MBP надо измерять только в православном iTunes. Тогда, возможно, при совпадение всех условий вы получите те цифры, которые заявляет Apple

Но я еще хотел спросить, вот вы рассказываете про закат х86 и восход ARM. А в конце статьи пишите, что сдаете в аренду «эпичные» сервера с процессорами Intel и AMD. Вам не кажется, что немного нелогично?

А расскажите, какие заводы за миллиарды и десятки млрд долларов построила Интел в последние годы?

Не ещё.

Компьютером, как вы его понимаете, он никогда и не станет.

Хотя, мой старый iPad Air с джейлом пытается. Но сами понимаете...

Эниак сторонние приложения поддерживал?)

Не стоит удивляться, если это будет процессор с 6-16 большими ядрами, а в течение 18-36 месяцев мы увидим следующее поколение с 16-32 большими ядрами. И преимущество архитектуры ARM никого не будет удивлять на рынке и настольных компьютеров, и серверных систем.

Преимущество x86 не сводится только к повышенной производительности и пониженному потреблению энергии. Важная часть — совместимость между устройствами и операционными системами. Сегодня я могу взять флешку с Дебианом и поставить его почти на любой x86 компьютер. С ARM такой номер не прокатит. Даже похожие ARM устройства требуют каких-то уникальных драйверов (часто несвободных) и каких-то плясок.

Вот когда для ARM будет достигнута совместимость на уровне подобном x86, Интелу можно будет насторожиться. А пока — нет.

При нужном компиляторе, проектов 80% можно будет собрать одним кликом мыши, с выбором галочки «собери под arm».

Да, возможно что то поправить будет нужно, но это не будет переписыванием кода с 0.

При нужном компиляторе, проектов 80% можно будет собрать одним кликом мыши, с выбором галочки «собери под arm».

Дело не в приложениях, а во взаимодействии железа и операционной системы. Для ARM нет стандартной открытой архитектуры, подобной той которая в своё время возникла с IBM PC. Почему ГНУ/Линукс, Виндовс, БСД и прочие операционки могут запускаться на незнакомом железе? Всё потому что есть набор поддерживаемых стандартов или стандартного железа. В мире ARM всё иначе. Каждой новое ARM устройство получается несовместимым с существующими операционными системами и требует какую-то свою уникальную прошивку, драйвера и хитрые настройки, известные только производителю.

Именно это сдерживает рынок ARM устройств от взрыва, способного снести Интел.

Насколько помню x86, что то подобное проходили или как раз пришли к этой идеологии в x86,

Опять же, требуется всего лишь время, создадут альянс стандартизации

Требуется время, да. Но не только время. Нужно ещё желание. Захочет ли этого, например, Эппл, который делает всё, вплоть до штекеров нестандартным? Если бы стандарт был нужен, его бы уже сделали. Похоже что пока всех, от кого это зависит, всё устраивает.

А значит Интел может пока расслабиться. К сожалению.

Да господи, интел завтра sleep() из микрокода уберет и выпустит очередные "революционные" процы, которые они хранили на случай проблем.

Как это было при переходе от Netburst к P6, перемаркированной в Core.

P4 долго сливал их же P!!!, сперва в виде Tualatin, потом Pentium M и Core.

А потом его выкинули.

U-boot уже умеет заводить UEFI поверх себя.

Ну и инструкция от xypron

До текущего времени была монополия на процессоры для рабочих станций, и серверов(AMD и Intel). Причем обе компании Американские.

Теперь Apple, пусть не самый большой игрок, но определенное значение в ИТ имеет, ставит в свою технику ARM. Тем самым показывая что процессоры доросли до премиум сегмента. Замечу, это несмотря на большие издержки по переносу ПО на новую архитектуру.

Второе Китай сейчас ссорится с Америкой, и они имеют мощности для производства своей компонентной базы. Что дает определенный вектор на создания алианса.

Третье в геополитической картине получилось так, что все кто опоздал, оказались не удел в создании процессоров(тут Америка всех выиграла и держит монополию), и нагнать на x86 архитектуре до последнего момента было не реально. А вот архитектура ARM позволяет сократить такой разрыв.

Поэтому может быть рано говорить что Intel не удел, но и не все так радужно со стороны Intel и AMD.

Дело не в приложениях, а во взаимодействии железа и операционной системы. Для ARM нет стандартной открытой архитектуры, подобной той которая в своё время возникла с IBM PC. Почему ГНУ/Линукс, Виндовс, БСД и прочие операционки могут запускаться на незнакомом железе? Всё потому что есть набор поддерживаемых стандартов или стандартного железа.

Я ни в коем случае не отрицаю возможных бонусов обратной совместимости и стандартизации.

Проблема тут только в одном: если бы оно действительно работало именно так, то не было бы тем вида «посоветуйте ноутбук под линукс», или «а какая сетевая карта заработает под FreeBSD?», или «а я установил OS-name и мой ноутбук стал работать от АКБ в три раза меньше» и не было бы списков совместимости.

То есть да, условная совместимость есть. И часть свежих операционных систем без серьёзных проблем стартанут на свежем железе. А вот будет ли оно пригодно к работе — вопрос. Например у фряхи есть определённые проблемы с рилтек сетевыми (сам сталкивался), которые могут проявляться в том числе и как зависание сетевого стека при определённой нагрузке. Решение в моём случае оказалось поставить другую сетевую карту от Intel.

То есть, выражаясь иными словами, x86 это экосистема и архитектура, а ARM — это просто набор команд центрального процессора. Через это, их и сравнивать-то не корректно.

Armv8 никогда не был RISC

Но отчасти соглашусь, современный ARM это совсем не RISC и тянет за собой legacy хвост подлинее интелловского x86.

Если ограничиться только длиной команд, числом регистров и ld/st — то безумный квалкрммовскийи Hexagon тоже RISC. А это вообще VLIW DSP.

Причем забавно, что сама Qualcomm его при этом RISC не считает:

This packet is claimed by Qualcomm to be equal to 29 classic RISC operations; it includes vector add (4x 16-bit), complex multiply operation and hardware loop support. All instructions of the packet are done in the same cycle.

Обычно, разделение RISC/CISC применяют к процессорам общего назначения. VLIW DSP к ним не относится. Кроме того, само наличие VLIW, как бы отменяет RISC, по-моему.

Вы программировали под него на ассемблере? Я — да. И реверсил. Это самая странная архитектура, с некоторой я имел дело до этого. Так что "безумный" — мое оценочное суждение.

Насчёт RISC я всего лишь взял ваше определение. К которому вы аппелировали в случае с ARMv8. И по нему выходит что шестиугольник — тоже RISC.

Вы программировали под него на ассемблере?

Я без претензии спрашивал. Из любопытства. Сам когда-то писал под Oak и Carmel DSP, там тоже VLIW, аппаратные циклы и параллельное программирование на уровне ассемблера. Старшие товарищи рассказывали, что это на всех DSP так.

Всё-таки, в DSP обычно есть инструкции которые под RISC никак не подходят.

С другой стороны, и в ARM, и в MIPS, есть DSP расширения (да и другие всякие расширения), так что все эти определения и категории довольно условны

и в ARM, и в MIPS, есть DSP расширения

Вы имеете ввиду команды SIMD для обработки векторов, матриц, FFT и тому подобных вещей?

все эти определения и категории довольно условны

Согласен.

В то же время ARM32 значительно «прямолинейнее» и проще. Регистры доступны все. Флаги в инструкции всегда. Вплоть до того, что переходы это загрузка в PC, а относительная адресация от PC использует неявно длину конвеера, и это вынужденно тянется с рождения. И то его Thumb/Thumb2 уже врядли можно считать RISC. (Там уже и про фиксированный размер инструкций как-то забыли постепенно, и условное исполнение блоков добавили).

Кстати, посмотрите как кодируется длинный прыжок в Thumb, это просто адская жесть!

ARM64 ISA полная противоположность 32 битной. Забили на простой декодер ради более компактного кода. Огромное количество сложных инструкций. Их длина действительно фиксирована. Нет прыжков между режимами. Отказ от свободной манипуляции регистрами (PC, SP) — например RET это RET, а не MOV PC, LR. Вместо сумбурных команд с этими операндами (которые не всегда имеют смысл) довольно стройно вписался [W/X]ZR.

Субьективно, основное отличие от CISC (навроде AMD64) только в фиксированной длине команды.

И по нему выходит что шестиугольник — тоже RISC.

С чего бы?

В RISC не упаковывают несколько независимых команд в одну широкую команду.

В признаках, идентифицирующих RISC такого и быть не должно.

Это специфическое свойство VLIW и есть одно из основных его отличий от других.

Вы можете сказать про ARM-овский add+shift, но это одна команда с модификатором источника. Как и lea на х86.

Заметьте, ни слова о пакетной обработке или характере самих инструкций.

По этим критериям оппонент классифицировал ARMv8 как RISC. Хексагон удовлетворяет всем этим критериям. Но он, очевидно, не RISC.

А теперь заменяем x86 на AArch64 и получаю прикол вида «таак, а где devicetreeblock под конкретно эту плату». Сдохла старая материнка, купил другую — снова привет, надо для неё devicetree.

Ну а пакеты да, собираются и работают.

Apple как катализатор перемен выглядит слабо; они могут делать сколько угодно хорошее железо но всегда этому мешают фундаментальные ценности компании:

- У Apple слишком маленькая доля на рынке.

- Большинство их коннекторов и интерфейсов — проприетарные. А значит для Apple всегда будет меньше возможностей для кастомизации и расширения.

- Ограниченная поддержка софта. Железо Apple нормально работает только под ОС от Apple. Все последние макбуки уже много лет хуже работают под Windows и Linux из-за отсутствия профилей питания для процессора, от чего он перегревается, работает медленее и меньше по времени (от батареи).

- Быстрая софтовая смерть. 5-7 лет в зависимости от модели и Apple перестает обновлять ОС для вполне живого ноутбука.

Помню как раньше Apple продвигали свои отвратительные интерфейсы (FireWire, Apple Display Connector и прочая дичь) и везде их ждала неудача. Хорошо хоть этим перестали заниматься и поставили USB-C как все остальные. Хотя lightning до сих пор живет.

последовательно продвигается как минимум с 1014 года

Что-то медленно продвигается, если целую 1000 лет на это надо...

А это всего лишь опечатка, эх.

Тем, что в тот момент уже был USB, который работал.

Apple с Сони 10 лет не могли поступить как мужчины и закончить никому не нужную войну форматов.

возможность устройства быть как хостом, так и ведомым

А можете раскрыть мысль подробнее? USB otg host в смартфонах появились задолго до Type-C; понятное дело, что их всё ещё можно было подключать к ББ как внешнее устройство.

P.S.: нашёл, можно было (не ко всем моделям), но большинство имели usb-хабы и могло-таки работать в этом режиме.

У моего последнего устройства (Samsung WiTu/Omnia i900) был проприетарный разъём, там точно можно было.

Хост — это отдельный USB интерфейс и именно в этом и было преимущество USB перед FireWire: если хост не нужен, то его и не ставили. В FireWire все фичи были добровольно-принудителными, поэтому в лучшем случае жрали дополнительную энергию и увеличивали стоимость.

КПК с USB хостом появились уже в конце их эры и требовали переходников со своих проприетарных разъемов.

Совершенно другая проблема хостов в том, сама эта возможность не дает почти ничего: вся суть в поддержке со стороны ОС и наличии достаточного питания. Обычно они ограничивались мышками и клавиатурами.

Удобство разъема еще ни о чём не говорит (но он, пожалуй, всё же удобнее microUSB), особенно, учитывая, что у нас теперь есть зоопарк всяких Gen'ов, PD, QC/-2/-3/-4, Thunderbolt'ов и прочих расширений и спецификаций, применимых как к устройствам, так конкретным разъёмам на этих устройствах, так и кабелям. Которые, казалось бы, должны быть универсальными (но нет. Какая ирония — Universal Serial Bus cable ни разу не универсален в нашу эпоху).

Всяким мышкам не нужны все эти гены, доставки поверов и прочие Thunderbolt.

можно будет делать любые разумные комбинации

противоречит друг другу. Мышкам, может быть и не нужны, а хостовым устройствам нужны. А еще мониторам нужны, чтобы они картинку показывали. В результате, если кабель обладает лишней «полезной» нагрузкой, и он вставлен одним концом в мышку (предположим, что там есть разъем), а другим в современный макбук, то он просто не задействует части возможностей. А если дешевый кабель, который выглядит как USB cable, пахнет USB cable, и продаётся как USB cable, но не передаёт видео, будучи вставленным в монитор и в макбук другим концом, то это проблема.

Что касамео флешек — у меня были двусторонние флешки. С одной стороны microUSB, с другой USB. Тоже работало.

Вы сводите всё удобство к единообразию разъема и только лишь. Единообразие разъема — одно из условий, но не единственное.

одинаковому разъёму сейчас можно соединить любые 2 устройства, но это не всегда имеет смысл.

Кажется с этим ужасом долго и упорно боролись, а теперь опять пришли к нему же. Даже в шлейфах к флопикам разные пины заклёпывали, чтобы нельзя было соединить 2 устройства так, чтобы это не имело смысла.

Вы все правильно поняли)

Хост все еще не обязателен, Type-C это вообще только спецификация разъема, можно сделать абсолютно пассивный порт и подключить его к древнему микроконтроллеру, который умеет только USB 2.0 slave и все будет работать. Вот этим USB и хорош.

то я тогда решительно не понимаю, о чём говорит sumanai

О том, что Apple в очередной раз создали мегареволюционную, опередившую время технологию, но злые люди не поняли Великих Гениев и ставили везде отсталый медленный USB, не желая платить Apple по двадцать баксов с устройства за разъем, обязательный логотип и микросхему — интерфейс.

Если бы не злые дяди из USB-IF, то у нас сейчас бы были флешки, которые можно было бы соединять друг с другом и копировать между ними файлы! А, забыл, благодаря уникальной технологии DaisyChain можно было бы в задницу одной флешки втыкать другую и экономить порт!

Они ровесники. Просто разные отцы (Apple, Sony & прочие против Intel, Microsoft, Philips & прочие) и неправильная лицензионная политика.

При этом FireWire поддерживал такие фичи, как подключение нескольких устройств (есть в Thunderbolt) и возможность устройства быть как хостом, так и веломым (появилось с Type-C).

Какой смысл в этой демагогии, если USB был лучше изначально и поэтому и стал самым массовым стандартом подключения периферии?

USB был хуже и медленнее, но сильно дешевле

На Хабре есть перевод отличной статьи об истории FireWire

https://habr.com/ru/post/405673/

А вы можете мне скинуть pdf этой статьи на FireWire — флешку? Ха-ха)

В той статье не написано главное: стандарт убила жадность Apple, которая привела к тому, что разъем, лицензия на обязательный логотип и микросхема-контроллер стоили дороже, чем 99% устройств, которые хотелось подключать.

Мертворожденный стандарт, который почти всем технически хуже USB.

Хуже сложностью, дороговизной, неприспособленностью к реальной жизни, энергопотреблением и наличием бесполезных фич, которые в реальности никогда не работали.

Взять тот же DaisyChain, на бумаге классно, а в реальности скорость выставлялась по самому медленному устройству. Подключил мышку к сканеру — он начинает сканировать в десять раз медленнее. То есть реально это было применимо к мышкам и клавиатурам, а во всех остальных устройствах нисходящего порта не было.

Жаль, что в USB не было возможности сделать клавиатуру с USB портом для мышки… а постойте-ка, в USB есть хабы, которые к тому же могли согласовывать скорости и такого бреда, как в FireWire, когда одна мышка замедляла всю ветвь дерева не было.

По сути FireWire — это коаксиал с шинной топологией, продолжение ADB, а USB — это витая пара со свитчами.

Прямо сейчас такая.

А ты точно умеешь в сарказм и чтение предложений целиком?)

Жаль, что в USB не было возможности сделать клавиатуру с USB портом для мышки… а постойте-ка, в USB есть хабы, которые к тому же могли согласовывать скорости.

Пишут, что и на USB бывает такое с некоторыми хабами.

А у FireWire это бывает всегда. Потому что выбор шинной топологии был ошибкой.

А вы можете мне скинуть pdf этой статьи на FireWire — флешку? Ха-ха)

Я скину, прысылайте флешку :D

большинству пользователей вообще не хочется и не нужно возиться с внутренностями, для них интерфейс с железкой — это её практичная функциональность — воспроизведение звука/видео, открытие книжек/вебстраничек, игрушки, карты/переводчик/