Comments 283

TL;DR: Intel решил показать, чем PC лучше Mac, выставив это своей заслугой. Всё остальное (кроме первого сравнения) — лишь заслуга монополии Intel. С играми сравнение несколько странное ИМХО — игра на встроенной графике с хорошей картинкой и FPS не очень похожа на реальность.

И теперь рассказывайте, что M1 выигравает за счёт специальных блоков.

Мир серьёзных вычислений — это не для ARM.

Хорошо, что Fujitsu с их A64FX о вашем мнении не узнали;)

A64FX расширен разработанным самим Fujitsu набором комманд, схожим с AVX512. В обычных ARM (и даже M1) такого расширения нет, и у ARM производители его не купят.

С другой стороны, это ведь логичный следующий шаг со стороны Эппла: лицензировать у Fujitsu этот доп.набор комманд и добавить его реализацию в свои процы. Правда, это увеличит размер и так не маленького ядра процентов на 30.

A64FX расширен разработанным самим Fujitsu набором комманд, схожим с AVX512.

Враньё.

1) SVE разработан совместно ARM и Fujitsu

2) SVE это стандартное расширение ARMv8.2.

3) SVE не схож с AVX-512.

AVX-512 это SIMD с фиксированной архитектурной длиной вектора, а SVE код не зависит от длины вектора — она может меняться от 128 до 2048 бит в зависимости от имплементации.

и у ARM производители его не купят.

Враньё.

servernews.ru/1021265

Ядро Neoverse V1 имеет поддержку SVE (2x256 бит).

Процессор с этим ядром (SiPearl Rhea) выйдет в следующем году.

Правда, это увеличит размер и так не маленького ядра процентов на 30.

Чушь. У Apple A14/M1 и так SIMD 512-бит (4 ALU по 128 бит).

Чтобы переделать NEON в SVE не нужно много места.

Ну почему сразу "враньё"? Враньё — это намеренная попытка ввести в заблуждение. В данном случае, я сам заблуждался и (признаюсь честно) поленился проверить.

Спасибо, что исправили мои ошибки!

Не за что.

Если у вас есть сравнительные тесты AVX и матричного сопроцессора в M1 — поделитесь. А то, знаете, пока это больше похоже на разницу в наименованиях...

суперкомпьютерных чипов.

В пару Fujitsu A64FX вскоре появится Rhea:

www.anandtech.com/show/16072/sipearl-lets-rhea-design-leak-72x-zeus-cores-4x-hbm2e-46-ddr5

Берём AVX и всё, M1 улетел в трубу.

Окажите себе услугу — почитайте что-нибудь про NEON, SVE.

Клиентский Sunny Cove имеет один 512-битный юнит, что даёт 32 FLOPS/такт (Single Precision).

M1 достигает те же самые 32 FLOPS/такт.

Да, за счёт частоты Интел будет несколько быстрее, но только вот многоядерные Интелы работают на тех же ~3ГГЦ.

А это ещё не всё. В M1 есть кастомное расширение AMX — матричный умножитель.

gist.github.com/dougallj/7a75a3be1ec69ca550e7c36dc75e0d6f

medium.com/swlh/apples-m1-secret-coprocessor-6599492fc1e1

nod.ai/comparing-apple-m1-with-amx2-m1-with-neon

Apple’s M1 custom AMX2 Matrix Multiply unit can outperform ARMv8.6’s standard NEON instructions by about 2X.

Берём AVX и всё, M1 улетел в трубу. Мир серьёзных вычислений — это не для ARM.берем ARM SVE…

AVX, все-же, это довольно таки general-purpose векторное расширениекаждый день вижу AVX в general purpose софте, говорят он очень хорошо ускоряет перекладывания json и xml (шутка, конечно же).

Мир серьёзных вычислений — это не для ARM.yet

говорят он очень хорошо ускоряет перекладывания json

github.com/simdjson/simdjson

simdjson: Parsing gigabytes of JSON per second

Intel использовала разные яблочные устройства и разные собственные процессоры для манипуляции фактами. На хоботе жуликов красиво вывели на чистую воду.

https://www.ixbt.com/news/2021/02/07/intel-soc-apple-m1-cpu-ryzen.html

Так и думал, что они разные процессоры для теста производительности и для теста автономности использовали. Интересно как там с ёмкостью аккумуляторов и разрешением дисплея у ноутбуков, а ещё что там за нагрузка такая была. Подозреваю, что по минимуму, потому что чем больше нагрузка тем больше влияние непосредственно процессора.

Для современных процессоров веб-браузинг, просмотр фильмов, редактирование документов — это практически простой, они больше 3...5% не грузят.

Не постоянно, конечно, но несколько раз в час на на минуту.

по бытовому ваттметру

Как инженер-электроник, могу сказать что наиболее вероятно бытовой «ваттметр» на низких мощностях вам будет показывать нечто между фазой луны и положением солнца.

Потому что:

1185G7 8...9 Вт

Можно открыть официальный сайт Intel и обнаружить что минимальный TDP 12 Ватт (да, я в курсе что там средняя величина, но тем не менее): ark.intel.com/content/www/ru/ru/ark/products/208664/intel-core-i7-1185g7-processor-12m-cache-up-to-4-80-ghz-with-ipu.html

То есть по оказаниям вашего ваттметра весь ноутбук, вместе с экраном, процессором и периферией потребляет меньше, чем потребляет процессор по даташиту производителя.

Ваттметр меряет с помощью АЦП контроллера СТМ8 падение напряжения на шунте, поэтому точность приемлемая и вроде даже с RMS, начинает показывать от 0,1 Вт.

Вообще создаётся впечатление, что большинство процессоров со времени первого Pentium работают в заводском разгоне, тем более видеочипы.

Если вы инженер, то должны знать, что TDP — это потребляемая мощность при 100%-ной загрузке всех ядер, в таком режиме при настройке 15 Вт ваттметр показывает 30 Вт.

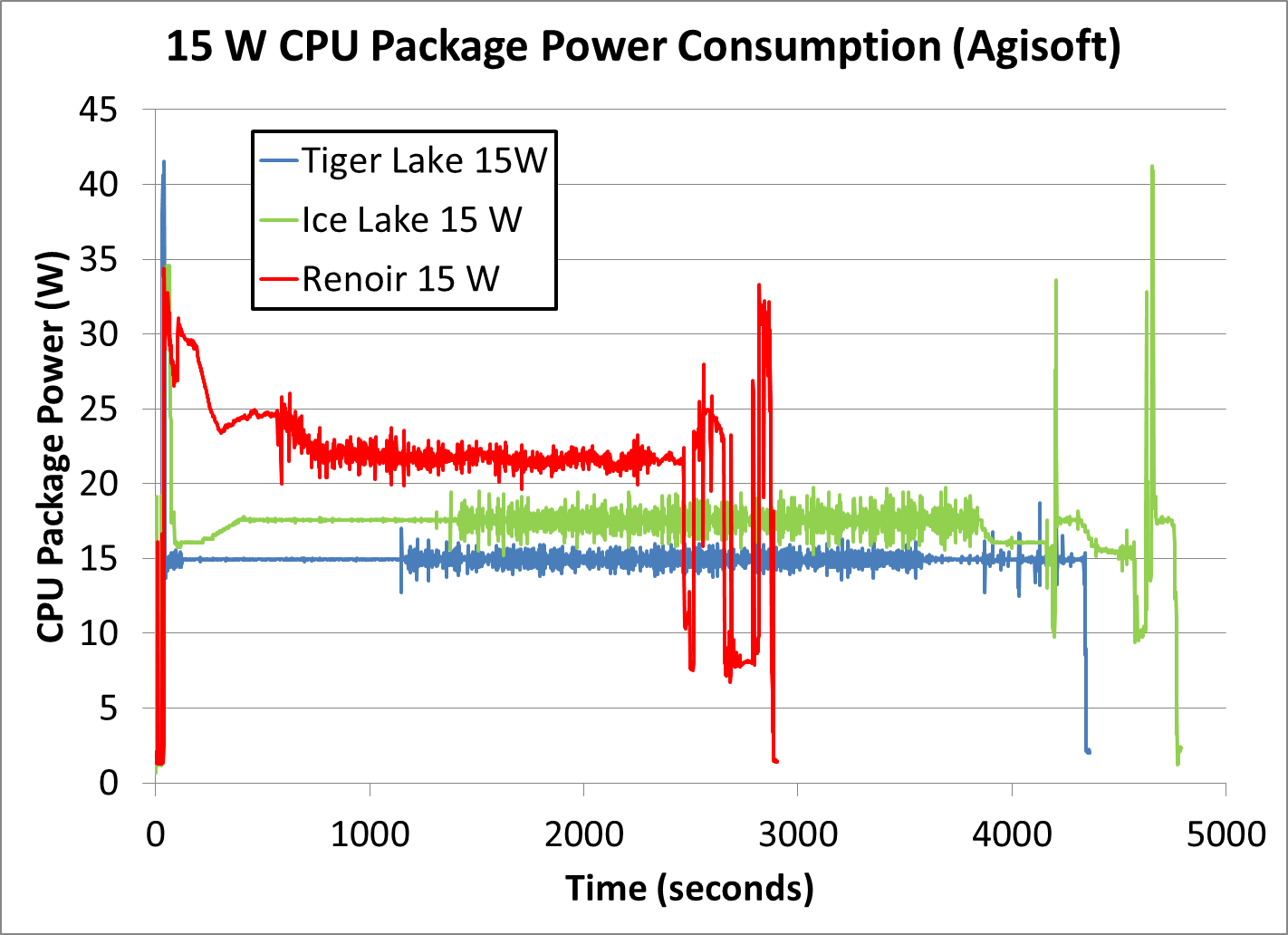

Если мы говорим об Intel, то TDP это величина, которая говорит в целом мало о чём: www.anandtech.com/show/16084/intel-tiger-lake-review-deep-dive-core-11th-gen/5

А при Idle порядка 97% потребление процессора и его периферии резко падает до единиц Вт.

Если бы это было действительно так — из спящих режимов ноутбуки могли бы не выходить десятками суток (учитывая что экран тоже отваливается). Но это немножечко не так.

8..9 Вт… ваттметр показывает 30 Вт

И вот тут вопрос:

У вас в idle потребление всего ноутбука 8...9 Вт, а при загрузке подпрыгивает до 30. Вы, конечно, не уточнили чем загружаете и что, но если это синтетика — нагрузка может быть точечной и в процессор. Допустим, что 8...9 Вт это именно вся обвязка: матрица, SSD, оперативка и всякое другое барахло. Добавляем к 8 15 Вт и получаем 23. Откуда ещё 7? :)

напряжения на шунте

Да, действительно можно получить и вполне себе неплохую точность, но в таком случае шунт надо подбирать так, чтобы желаемый измеряемый ток попадал в две трети диапазона измерения. Например, нормальные шунты выпускаются на такие измеряемые ряды токов: 100мА, 200мА, 500мА, 1А, 2А… ну вы поняли.

Ваша бытовая розетка, наиболее вероятно, рассчитана минимум ампер на 10. То есть, условно 2,2 кВт (при условии подключения ТЭНа). Вы же измеряете ей мощность 30 Вт. Сколько сколько это в процентах?

И да, я искренне сомневаюсь, что в бытовой розетке внутри шунты на разные диапазоны токов и автоматическое их переключение.

RMS

Чёткие пацаны используют True RMS :)

Особенно учитывая что потребитель — импульсный блок питания, который прекрасно шумит (скорее всего) в питающую сеть.

И самый главный вопрос: а как ваша розетка измеряет косинус Фи, без которого на переменном токе можно измерять только ВА, а никак не Вт? :)

P.s. я ещё раз говорю что бытовые розетки это индикатор, а никак не средство измерения. Особенно если вы пытаетесь ей измерить мощности, которые едва дотягивают даже до 1% диапазона измерения.

Если бы это было действительно так — из спящих режимов ноутбуки могли бы не выходить десятками суток

Это уже давно так, почитайте про режим Modern Standby. Только не десятки суток — ёмкость ноутбучных батарей 50...80 Вт*ч, поэтому только пару суток.

7 Вт взялись из-за потребления периферии, которая в спящем режиме тоже резко снижают потребление. Да и 15 Вт для процессора — скорее маркетинговая велечина, нежели инструментально измеренная и задокументированная.

шунт надо подбирать так, чтобы желаемый измеряемый ток попадал в две трети диапазона измерения.

У меня есть китайские весы на 500 грамм за 7 долларов, которые взвешивают с разрешением 0,01 грамм: видят даже очень маленький кусочек бумажки. Вот с помощью такой же магии 2-кВт ваттметр видит доли ватта — оверсэмплинг и интегрирование, и из 10-битного АЦП (если там стоит не СТМ32 с 12-битником) вытаскиваются сравнительно честные 12...13 бит. Косинус фи отлично меряется и арифметически корректируется с помощью второго канала АЦП, синхронно измеряющего напряжение.

7 Вт взялись из-за потребления периферии, которая в спящем режиме тоже резко снижают потребление.

Ага, например экран. Или SSD, который действительно будет кушать меньше. Но и синтетика его не прогрузит. Плюс вы говорили о режиме покоя, а не о спящем режиме ;-)

Или у вас ноут в режиме покоя 7 ватт кушает?

Да и 15 Вт для процессора — скорее маркетинговая велечина, нежели инструментально измеренная и задокументированная.

Я собственно об этом же и говорил

Вот с помощью такой же магии 2-кВт ваттметр видит доли ватта — оверсэмплинг и интегрирование, и из 10-битного АЦП

Ага. Жаль, что производители нормальных СИ про это не знают. И в модулях измерения токов 4...20 мА стоят шунты не на 10А.

Косинус фи отлично меряется и арифметически корректируется с помощью второго канала АЦП, синхронно измеряющего напряжение.

Прочитайте на досуге про измерение несинусоидальных токов и напряжений. А ведь именно такой ток у вас и будет на импульсных блоках питания. Потом уточните как измерять косинус фи в случае таких токов.

Поэтому, вы уж извините, но я вам в очередной раз повторяю: бытовая розетка и СИ это две принципиально разных вещи. Проверено бытовыми розетками и СИ с сертификатами СИ и обязательной поверкой.

З.ы.

У меня есть китайские весы на 500 грамм за 7 долларов, которые взвешивают с разрешением 0,01 грамм: видят даже очень маленький кусочек бумажки.

Вот бы ещё знать сколько реально этот клочок бумажки весит. А то один метр нормального кабеля под тензометрическую ячейку стоит дороже этих весов в сборе.

Это уже давно так, почитайте про режим Modern Standby.

Это который народ с матами вырубает, потому что спящий режим сжирает батарею.

Когда нанял блмщиков и поувольнял инженеров… Благо кредиты сейчас бесплатны

По данным Intel, система на Tiger Lake оказалась, в среднем, вдвое мощнее.

Забавные ребята. Получается, Интел утверждает, что как только выйдет Apple Silicon MacBook Pro 16” с удвоенным-утроенным количеством мощных ядер, нужно брать? Это у Интел какая-то антиреклама их продукции получилась, даже не заглядывая, что они там в тестах подкрутили :)

Т.е. сам склоняешься к м1?

/не знаю кто и за что влепил синус — видимо, тебя опять по диагонали читали/

1185G7, M1, 4800U/5800U — 15...28 Вт процессоры, вы действительно не видите разницы с 45 Вт? Вместе с 30-Втной обрезанной 1650 получается тихий, долгоживущий и достаточно мощный компьютер для работы. И вот на AMD такой конфигурации не было, когда я выбирал новый компьютер, хотя они появились раньше.

У амд же тдп заявлено для упора в 100% при всех ядрах на базовой частоте

Anandtech с вами не согласен:

2

2Anandtech с вами не согласен:

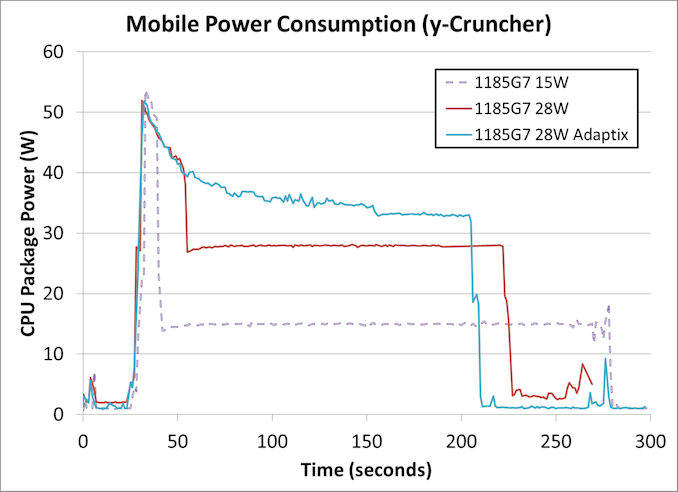

К слову о 1185G7, на предыдущей же странице есть график того, как он выдерживает 28 Вт:

А ещё чуть раньше объяснение, что такое PL1, PL2 и почему TDP от Intel не имеет никакого смысла.

The maximum power draw in the turbo mode is ~50 W*

Не только. Он полминуты жжёт на 50-40 Вт при обычном "28W" профиле. Этого вполне достаточно, чтобы основательно прогреть всю систему охлаждения и запустить вентиляторы на полную.

А турбо-режим есть у всех современных процессоров

В Apple M1 нету :)

А вообще, эти профили очень сильно зависят от производителя ноутбука. Как пример, одна и та же нагрузка на одном и том же процессоре: Dell XPS 13 9310 (обзор), Razer Book 13 (обзор), HP Pavilion 13 (обзор)

В М1 обязательно подвезут турбобуст, возможно, сейчас у них временные сложности, это же первый их процессор.

Конкретно в M1 не подвезут, он спроектирован именно под такую работу. Турбо-буст вообще нужен чтобы балансировать на пределе системы охлаждения, обрабатывая "взрывную" нагрузку. Apple выбрала приоритетом длительность автономной работы и стабильность производительности вне зависимости от типа и длительности нагрузки. Даже Air без активного охлаждения сохраняет 80-85% максимальной производительности при "троттлинге".

И, да, это далеко не первый их процессор.

В качестве плюсов своей продукции компания также привела тот факт, что ноутбуки на Tiger Lake могут оснащаться сенсорным экраном

У меня 14 дюймовый ноутбук «трансформер» с тачскрином. Только вот в Windows толку от него не вижу. Хорошего софта, который под него был бы заточен, так и не нашел. Может кто то подскажет?

Еще фотки удобно листать, свайпая пальцем как на телефоне.

Ну и можно PDF с компьютерной литературой в альбомном режиме листать а ля «большая читалка».

Больше реальных применений за 4 года пользования не нашел.

То есть тоже самое что можно и делать на android/iOS планшете.

Я искал под свои задачи что то более узкоспециализированное, типа на ходу видео смонтировать, фотки поретачить и пр. В итоге на android смартфоне это делать удобнее, так как там софт именно под тач заточен. А на ноуте клавиатура + тачпад (мышь беспроводная).

В windows store до сих пор практически один лишь шлак.

Тыкать в крошечные, незаточенные под тач-управление элементы? Ну не знаю, не знаю.

Беспроводная мышь проигрывает тем, что при работе с клавиатурой нужно отвлекаться на ее поиск и определения курсора на экране. А здесь куда пальцем ткнул, там и будет курсор.

Выделить какую-то область — опять же на сенсорном экране проще, чем сделать это тачпадом.

нет

Масштаб — то же самое.

нет

Ссылки на странице, запустить программу с рабочего стола, переключиться между программами — для этого тачпад вообще не нужен.

на сенсорном экране я постоянно промазываю — в частности — на телефоне, когда хабр в десктопном варианте листаю. Очень неудобно. Лучше уж тачпад. ей-Богу

А здесь куда пальцем ткнул, там и будет курсор.

проблема в том, что элементы управления должны быть циклопического размера, чтобы пальцем можно было попасть в один элемент. Либо стилус. Но тогда все преимущество сенсорного экрана пропадает

В общем — все Ваши аргументы — вкусовщина.

Не говорю уж о паттернах работы, когда нужно набирать много текста (предлагаете переносить руку с сенсора на клаву и назад? или сенсорную клаву использовать ?)

Тем не менее уже то, что есть люди подобные мне, которые имеют имеют положительный опыт работы с сенсорным экраном уже означает, что сенсорный экран не бесполезная вещь даже при отсутствии какого-то специализированного софта.

Я не против, чтобы и Вам тоже было удобно, но все-таки для сенсора есть планшет (а не ноут). И я очень не хотел бы, чтобы у меня на ноутбуке были элементы управления циклопического размера. Как, например, плиточный интерфейс W10 — буэ. Если б разрабы могли предоставить два режима работы для операционки и для приложений… Но сами знаете ) что выйдет

Вы похоже просто на маках 2015+ тачпадом не пользовались. На самом деле куда удобнее когда есть нормальный тачпад, нежели сенсорный экран.

Ну вот, тачпад вполне обычный, вся магия в софте

Как мне показалось, он хорошо понимает, что ты от него хочешь. На Windows постоянно натыкаюсь на ложные срабатывания жеста или наоборот на то, что не срабатывает жест с первого раза. На Мак пересел — все сразу нормально.

Я думаю дело даже не столько в самом таче, сколько в софте. И для меня тач на ноуте это наоборот самое важное.

Джобс еще более десяти лет назад расписал почему они не видят смысла в тачскринах на макбуках — A/B тестирование показало что людям не нравится — рука устает.

В результате лично у кого я видел ноутбук с тачскрином никогда им не пользовались, а кто пробовал — весь дисплей в отпечатках через 30 секунд, а значит надо протирать раз в пару минут. Выглядело конечно максимально убого и ужасно.

Два ноутбука-трансформера и оба с сенсорным экраном (и оба на amd ryzen). HP ENVY и Lenovo idepad Flex. Тачскрином пользуюсь не постоянно, но частенько. И очень этому рад.

Кейсы использования — очень удобно тыкать кнопки в машине. Очень удобно делать пометки в PDF/Снимках экрана/Word/Excel

Про весь дисплей в отпечатках не подтверждаю. Каждые 30 секунд протирать его точно не приходилось. Но в силу использования ноутбука в основном в поездках за экраном в любом случае приходится следить лучше, чем за стационарным компом.

Если использовать ноутбук в качестве замены ПК, то сенсорный экран может быть и будет лишний. На работе стояло несколько моноблоков с сенсорным экраном. Большинство сотрудников даже забывало о том, что экран сенсорный. Сидя за столом тыкать в экран действительно неудобно.

У меня 14 дюймовый ноутбук «трансформер» с тачскрином. Только вот в Windows толку от него не вижу. Хорошего софта, который под него был бы заточен, так и не нашел. Может кто то подскажет?зато в макбуках есть куча планшетных приложений… парапарапам… без тачскрина!

Какие все в комментах негативные, аж неприятно. Подумаешь яблочники сделали то что никто не хотел делать — жирный реордер, теперь подняли шум что армы тащат, жесть.

Кхм. Интересно что в некоторых приложениях из их тестов разницы с М1 почти нет, чем это обусловлено?

Интел так не сделает. Они за АМД даже угнаться не могут, а за Эпплом теперь и подавно. Надо же понимать, что М1 это первый и самый слабый проц в линейке. Его на эйры ставят. Сравнили самый дешёвый проц с крутым — ахахах :)

К тому моменту когда Интел выпустит что-то не убогое (а за последние годы от неё ничего не убогого не было), у Эппла будет пачка крутых процессоров уже. Вон М1Х обещают скоро, а там вроде как аж в 2 раза больше быстрых ядер.

Сравнили самый дешёвый проц с крутым — ахахах :)дело даже не в цене. «Сравнили ноут с пассивным охлаждением с ноутом с активным охлаждением в задачах, которые целенаправленно оптимизировались под процы intel»

а в каком месте проц из мобильного 11 поколения i7 интела «крутой»?

1185G7 это процессор с самой совершенной микроархитектурой Интел, созданный на самой совершенной технологии Интел.

А крутыми у них будут 8 ядерники

На более старом ядре (клон ICL) и старом техпроцессе :)

Zen 555: AM5+DDR5+PCIe5!

а если серьёзно, то PCIe4 ещё нету нигде толком, поэтому на из пятёрок остаются только номер сокета и поколение памяти

а если серьёзно, то PCIe4 ещё нету нигде толком

Вроде же zen3 поддерживает? И нвидиа 30xx серии тоже. Даже материнки видел с pcie4. Или там поддержка чисто маркетинговая?

но лично мне кажется сомнительным выход PCIe5 в потребительском сегменте вместе с zen4 и AM5

Ведь эта новая технология от нвидии RTX IO, когда ресурсы грузятся в видяху с SSD в обход процессора — она pci4 требует. Так что смысл есть.

Ну это чисто беглый взгляд, это всё сложно, уву

а за последние годы от неё ничего не убогого не было— потому что она была монополистом в отрасли, не? Ей тупо было пофиг на это всё ибо деньги приносит и зачем делать лучше? Забыл про эти шуточки — «Невероятный рост производительности на 10% каждый год»? (это и к видяхам относилось, когда нвидиа была во всех областях рынка успешней амд)

Как сказал один чувак — «они сдавали позиции амд в далёком прошлом, а потом переосмыслили проектирование процов и выпустили архитектуру 'Core' которая доминировала на рынке более 10 лет. Сейчас у неё вполне себе хватает денег чтоб создать подобный скачок снова.»

"А то сейчас парадигма в мире какающих радугой единорогов — «железо всё стерпит»"

Так — то это парадигма современных программистов.

У меня до сих пор на старом винте лежит кооперативный 3D шутер весом порядка 5 мегабайт.

Надо будет его перетащить на новый винт. И если запустится под 10-кой буду троллить современных игроделов…

Вы что, правда думаете, что в современных играх весом 50-70Гб основное место занимает код? Серьёзно? Ну тогда еще графикой по тролить современных игроделов не забудьте...

Да и код, отдельная тема, сколько было случаев что exe ужимался с 150 до 3 Мб или терял в районе 600 Мб просто из-за удаления какой-нибудь Денувы.

А там на удивление нормальная, зато там нет пуленепробиваемых лисиье и доскок, как в некоторых современных играх.

Когда 3Д игры столько весили, никакой кооперативной игры в них не было…

Больше ничего нового Аппле не сделала.

Ну нет. M1 — первый массовый процессор 5нм. Тут, правда, не эппл, а TMSC постарались, и интел тут позади ощутимо.

Тут, правда, не эппл, а TMSC постарались

Apple является главным клиентом TSMC. Без яблока у TSMC не было бы столько денег (недавние 25 миллиардов инвестиций в 5nm) на новые фабрики для будущих ARM-чипов (80% для Apple). Там максимальный симбиоз.

Разработали эппл а TSMC его только выпустили. Или АМД тоже не делали своих процессоров?

Самое главное и прекрасное, что сделал эппл — начал популяризацию ARM, который теперь перестает быть узкоспециализированной архитектурой, под которую далеко не всегда всё можно было легко собрать.

Яблоко популяризировало ARM еще в 2013, когда выпустило первый 64-битный ARM-чип в iPhone 5S и с того времени ни Samsung со своими Exynos, ни Qualcomm со Snapdragon не могут и близко наблизиться к производительности яблочных чипов, из-за чего даже мой iPhone 6S на iOS 13 почти не лагает. А где смартфоны на Андроиде тех годов — вопрос риторический.

Какой-нибудь Samsung Galaxy S6 и сейчас вполне бодр.

iPhone 5S вышел в сентябре 2013, а Galaxy S6 в апреле 2015. Полтора года разницы. При этом на Galaxy самый новый Android — 2016 года релиза, а на iPhone iOS 12 2019 года релиза (и она до сих пор получает минорные апдейты, последний в январе этого года).

Заметили да, как Интел оказался в роли догоняющего? А Эппл, который раньше ассоциировался только со впариванием маркетингового булщита, неожиданно оказался технологическим лидером?

Формулировки Интела — «ну, у нас вот тут тоже вроде неплохо, вот тут вроде даже чуть мощнее, вот тут примерно равно, вот тут хуже в целом, но игр нет!» — каким боком тачскрин и отсутствие нативных игр является заслугой процессора? :)

У меня 1 ноут на линуксе, 1 десктопный ПК на 10 винде и 1 макбук эйр. То есть я не долбанутый фанат эппла. Но М1 действительно потрясающе крутой. А «отзывчивость системы» там намного лучше и винды и линукса, так что Интел не надо плз балаболить

Главное — что яббл смогли поставить Интел в позицию, когда последним приходится оправдываться и, ну, не подделывать, но делать не совсем честные сравнения. Честно — мне как потребителю — лучше, чтобы Интел собрались и выпустили что-то путное, чтобы Яббл тоже не расслабляли будем, но если смотреть идеологически — я устал от засилья Интела. Может эта… им реально пора на покой? Это нормально, когда лидеры прошлого уступают место новым Кумирам и уходят в туман…

Готовы к процессорам среднего звена по $1000?

Мне вообще пофиг, я процессоры уже лет 5 не покупаю.

Покупаю готовое устройство — будь то компьютер (брендовый), либо ноут, либо телефон (планшет)

А Эппл, который раньше ассоциировался только со впариванием маркетингового булщита

Ну это наверное только на постсоветском пространстве, забугром всегда при реверс-инжиринге удивлялись мастерству яблочных инженеров. Технологически ведь все годы конкуренты только их и догоняют в плане начинки.

Даже линуксовые мейнтейнеры ядра линукса сидят на макбуках из-за их инженерных особенностей и пишут об этом статьи на LWN:

Apple is the only remaining vendor to build a multiplexer into hybrid graphics laptops, which have both high-end and low-power GPUs. The multiplexer allows the panel to be switched between the GPUs and the unused GPU to be powered off. All other manufacturers use a "muxless" solution, whereby the discrete GPU is headless and copies rendered data over PCIe into the integrated GPU's framebuffer. "Muxed" solutions, such as the one used by Apple, offer superior power saving and latency, but are more difficult to implement.

Я не фанат эпла, но до этого у меня был рабочий mac pro 2018 на i9 и он грелся просто ужасно и сейчас получил новый на m1 то разница чувствуется, m1 так сильно не греется

Если в курсе, подскажите, как там Homebrew работает в нативном режиме и портировали ли GCC с Fortran и OpenMP?

Наверное, потому, что удобно:) Множество пакетов доступно, система Homebrew основана на гит. Кстати, пакеты дебиан отлично на маке собираются, можно поддерживать единую кодовую базу для пакетов Homebrew и дебиан (если нужны собственные пакеты и там и там), одной командой код разворачивается на нужном количестве инстансов Amazon EC2 (Alibaba cloud почти полностью совместимы, за исключением странных нюансов с сортировками… ох уж эти китайцы с их иероглифами).

Странно что Intel не продемонстрировал многопроцессорную матплату, с кратным увеличением производительности)

Надо ещё проверить, не был ли подключён аквариумный чиллер к процессору во время тестов, как однажды уже делал интел

Всем давно известно, что х86 — это про тяжёлые вычисления, а ARM — это про энергосбережение и более низкую цену. Есть задачи для которых, на данном этапе, одна архитектура рвёт вторую в клочья, но ещё больше задач для которых обе архитектуры одинаково хороши. Прогресс не стоит на месте. ARM становится более быстрым. И вот уже ARM способны потянуть то, что раньше без успокоительного можно было делать только на x86. Таким образом мы получаем всё увеличивающуюся долю пользователей, которых ARM удовлетворяет на все 100%. Здесь убивается сразу 2 зайца — устройство на ARM дешевле и в силу пониженного энергопотребления более мобильное. Говоря простым русским языком — в силу естественных причин ARM вытесняет х86. Моё «экспертное» мнение склонно считать, что экспансия ARM продолжится, но не до полной и окончательной победы. Сервера, CAD, видеообработка и другие задачи, требовательные к вычислениям, ещё долго будут оставаться за x86. Такова тенденция развития отрасли в целом. Кто возглавит крестовый поход ARM на x86, дело третье. Это может быть как вполне реальный M1, так и гипотетический A+100500.

Apple применила грязненький маркетинговый ход (что в отрасли делается сплошь и рядом), и на него клюнет куча народа, НО для этой кучи народа на самом деле нет смысла использовать x86. Им нужны видосики с ютуба + пара-тройка других соцсетей и чтоб это можно было делать по пути в электричке. А если ещё и гламурный, раскрученный логотипчик на железке будет — это вообще шик.

А тем, кто выполняет тяжёлые расчёты — x86 в руки и розетку под боком.

Так м1 дороже х86 — это один из самых «жирных» чипов сейчас по количеству транзисторов

Или два чемодана пауэрбанков, как в выпуске Ералаша про «умные часы». Надеюсь, в ARM всё же внедрят что-то типа AVX, чтобы не нужно было спину надрывать или сидеть в плену у розетки.

А в чем заключается грязненький ход Apple? В том, что в М1 память встроенна внутрь? Ну так уже давно она (память) распаяна на материнские и её обыватель не может заменить/увеличить.

хотя тот же Ryzen 5000 серии немного его превосходит и в однопотоке.десктопные то да, но надо наверно дождаться мобильных, хотя по предварительным утечкам не превосходят они M1 в однопотоке

Если не учитывать инструкции AVX, то процессоры использующие инструкции ARM и x86 работают по очень похожему принципу.

Вы наверное хотели сказать AMX? Потому как AVX, AVX2 ничем не отличаются от NEON (в AArch64) и спокойно в него транслируются.

godbolt.org/z/MME59f

В цикле для ARM выполняются операции над двумя порциями по 128 бит, а у х86-64 над одной 256-бит порцией. По времени выполнения на M1 и TGL разницы так же быть не должно.

В AVX-512 добавили scatter-gatter и регистры масок. Но в SVE они есть. Код AVX-512 так же спокойно транслируется в SVE, а вот обратно уже нет.

Что касается AMX, то на A13/A14/M1 имеется нестандартный матричный акселератор с аналогичным названием.

Пора продавать акции Интел, все сильно хуже чем я подозревал. Очевидно они понимают что 12е поколение заведомо хуже конкурентов и бьются в истерике.

Ага, каждый раз, когда у меня рабочие скрипты (писанные под Linux) падают из-за несовместимости GNU sed и BSD sed, я очень радуюсь "нормальному юниксу". :)

В W10 я в такой ситуации ставил Ubuntu из Windows Store и вообще горя не знал.

P.S. Не топлю ни за, ни за другое, все хороши (и ужасны одновременно). Но аргумент про Unix немного странный.

Де-факто стандартом является скорее GNU, чем POSIX.

Я не настоящий сварщик и не готов аргументированно рассуждать на тему того, хорошо это или плохо, но имеем что имеем.

P.S. Disclaimer: под фразой "де-факто стандартом является" я имел ситуацию, которую вижу сам в IT-среде вокруг себя; возможно, где-то есть знатоки, который пишут по стандартам и у них всё хорошо, а я не прав и не понимаю, о чём пишу. :)

На маке ставите bash или любой другой интерпретатор из пакетов Homebrew — совместимость 100%. В чем проблема-то?

дело не в этом, дело в том, что на Mac OS не GNU окружение.

Как bash из homebrew вдруг сделает sed GNU'тым? Ответ — никак.

Я уже напарывался на разницу в флагах sed, tar, nc — может что-то еще.

Так я и говорю, ставите гнутые версии вместо системных — и разницы не будет.

zanuda mode on.

Вы про баш говорили, а это только часть окружения.

Так я и говорю, ставите гнутые версии вместо системных — и разницы не будет.

в такой формулировке согласен

Обычно несовместимости баша людям больше всего жить мешают. А уж когда вы знаете разницу в ключиках юниксовых утилит на разных платформах, то вы знаете, как это решается :)

был один мудрец, который скрипт под последний баш написал (который 5-й вроде?). Я потом заманался — он нигде не работает, кроме как там, где стоит последняя версия баша ))) Скрипты надо писать так, чтобы они на голом /bin/sh работали )))

Я тоже так думал когда-то… но, знаете, прямое указание интерпретатора в скрипте и проверка его версии решают проблему гораздо лучше. Бэкпортировать требуемый баш — дело минут, а вот решать непонятную проблему — как повезет.

За последние годы доводилось неоднократно на университетских кластерах свои скрипты запускать… так вот на древнем центосе (стандартная ось для таких кластеров) баш ни фига не совместим с таковым в дебиане от того же года, который я вполне себе помню. Потому что в центосе времен прошлой пятилетки баш стоит времен позапрошлой :)

Совсем недавно писал небольшой скрипт, строк 160 вместе с многострочными константами и комментариями. На баше.

Потому что ассоциативные массивы на sh все еще не работают, а инструмент нужен с минимальными зависимостями.

Да нет никакой проблемы, так же как нет проблемы на W10 в три клика получить полноценное UNIX-окружение. ¯\_(ツ)_/¯

для вяленогоэто как? :)

Wayland, наверное, имеется ввиду.

Что-то они ни bzip, ни gcc, ни llvm в качестве бенчмарков не использовали. А ведь это очень сложные вычислительные задачи на которых хорошо видно, кто быстрее "в целом", а не за счёт пачки удачных интринзиков.

https://habr.com/ru/post/531006/

https://github.com/devMEremenko/XcodeBenchmark

https://www.macrumors.com/2020/11/17/apple-silicon-m1-compiles-code-as-fast-as-mac-pro/

Ещё где-то мелькала информация, что M1 довольно быстро устанавливает Xcode (разархивирует).

Утверждение Apple о том что это самое быстро процессорное ядро не соответствуют действительностиа они не это утверждают. эппл упирает, что м1 лучшее соотношение perf/watt

вот ещё сомнения по поводу роста а14/м1

semianalysis.com/apple-a14-die-annotation-and-analysis-terrifying-implications-for-the-industry

Утверждение Apple о том что это самое быстро процессорное ядро не соответствуют действительности, а сравнения со старинными Intel Core 8 серии — это ещё большая манипуляция чем текущая презентация Intel.на момент презентации ryzen 5000 не вышли, и в некоторых тестах M1 действительно лидировал в однопотоке. Ну и сравнивали они не с «intel core 8-й серии» всё-таки, а с предыдущей моделью их же устройств. Имо любой производитель имеет полное моральное право так делать.

на момент презентации ryzen 5000 не вышли

Вышли на 5 дней раньше :)

Думаю из-за этого слайды переделывать не стали, но голосом добавили оговорку про "low-power".

И да, сравнивали они с MacBook Air с 1.2 ГГц Core i7 (1060NG7) и получили up to 3.5x faster CPU performance. Честное сравнение, ничего не скажешь.

Они сравнивали ровно с предыдущим поколением моделей, которые заменили на M1. И эти сравнения прозрачные и понятные покупателям макбуков — за ту же цену в 2-3 раза быстрее, чем в прошлом году.

Вы не смотрели презентацию, да? Рабинович напел?

Можете просто заглянуть в сноски на каждой странице продуктов, чтобы увидеть что с чем сравнивается:

https://www.apple.com/macbook-air/

https://www.apple.com/macbook-pro-13/

https://www.apple.com/mac-mini/

И да, сравнивали они с MacBook Air с 1.2 ГГц Core i7 (1060NG7) и получили up to 3.5x faster CPU performance. Честное сравнение, ничего не скажешь.Во-первых, в некоторых задачах получалась разница аж больше четырех раз. Во-вторых, сравнили старую модель за $1000 с новой моделью за $1000 и получили в 3.5 раза выше перф, в чем проблема? Apple бы сделали абсолютно то же самое будь их новое поколение на обновленных супермощных intel (жаль они не вышли), на ryzen, qualcomm, да хоть на эльбрусе.

Это называется манипуляция фактами. Собственно, этим же занимается и Intel, но куда более осторожно.Пример: судя по слайдам intel, 1185G7 обошел M1 в WebXPRT 3 аж на 32%. Круто, да? Но чет не верится. Идем на сайт бенчмарка WebXPRT 3, ищем там в топе M1 и 1185G7 (подсказка: 286 против 255 соответственно, M1 на ~10% быстрее), делаем выводы. Это даже не манипуляция фактами, это откровенная ложь в пресс-релизе.

Референсный ноутбук от Intel в WebXPRT 3 набирает 271 балл (https://www.computerbase.de/2021-02/amd-ryzen-5000-mobile-test/2/#diagramm-webxprt-3-v293). Это примерно столько же, сколько и у M1.

И этот скор включён в рассчёт среднего. И он всё ещё меньше, чем минимальный полученный для M1.

Если взять вполне себе реальные задачи, то в PugetBench Photoshop немного быстрее Intel (706 против 659 у М1), в Premiere Pro ситуация обратная (300 против 359). Сравнение вполне себе корректное, поскольку сравниваются нативные версии.

Если мы пройдём по ссылке, то обнаружим там ровно тот же балл у M1 за photoshop. А если приглядеться к дате публикации, то поймём, что статья была опубликована чуть раньше, чем вышла первая нативная бета фотошопа. Упс.

Premiere Pro — тоже через Rosetta. И это при том, что PP даже в нативной версии сейчас работает намного медленнее, чем DaVinci и Final Cut.

Rise of the Tomb Raider они вообще сами не тестировали, а взяли где-то в интернетах. Я, например, видел посты про 40 fps на 1920x1200 Very High. К слову, это всё тоже Rosetta.

В общем, как всегда сравнили тёплое с мягким.

Примечательно, что разница в производительности между нативной версией Photoshop и запущенной через Rosetta 2 совсем небольшая (от -5 до 25%): petapixel.com/2020/12/08/benchmarking-performance-lightroom-on-m1-vs-rosetta-2-vs-intel

Это существенно картину не меняет. Забавно, что в трех тестах из четырех MacBook Pro предыдущего поколения с четырехядерным 2.3ГГц Core i7 справилась быстрее чем M1, а в оставшимся тесте они были на одном уровне.

Это говорит о том, что Adobe пока не оптимизировала многие алгоритмы под ARM, раз через трансляцию такая небольшая разница. С другой стороны, это понятно — у них было 20 лет на затачивание под x86, и всего несколько месяцев на портирование на M1. Под iPad они так и не смогли выпустить версию, спустя 2 года после обещаний.

В 3.5х быстрее, ага.

Да, в 3.5 раза быстрее прошлого эйра. Или вы что-то другое хотели сказать? Наверное, приписать Apple или оппонентам то, что они не утверждали никогда?

В то же время рассматривать М1 как ноутбук для игр или профессиональной работы с видео, графикой, ML я бы не стал. Все же она предполагает наличие рабочего места, где вопрос с потребляемой мощностью и автономностью в принципе не стоит.

И правильно. Этот процессор (и GPU) для вполне определённой ниши, которая очерчивается устройствами, в которые его поставили, и тут ему сложно найти конкурента.

А для других устройств будут другие процессоры.

Да, приятно, когда ноутбук работает тихо и не греется, но все становится куда проще, если стоит выбор между заработать условные 250$ и 500$ в день просто потому что модель быстрее обучилась, проект быстрее отрендерился, или видео быстрее экспортировалось.

Или ноутбук в дороге не сядет за час, а проработает 6. И коленки не прожжет. И не будет весь рабочий день гудеть над ухом.

Вариантов много можно придумать. Вот только разницы с M1 в 2 раза по CPU вы не найдёте в ноутбуках.

Ещё более однозначно ситуация обстоит, если есть перспектива вообще ничего не заработать, если возник какой-то баг с софтом и пришлось потрать день на пляски с бубнами.

От этого вы нигде не застрахованы, ARM/x86 тут вообще не в кассу.

Ноутбуки с тем же 5900H и условной GTX 3070 гораздо быстрее, там все предсказуемо с софтом, а также и не нужно ждать пока кто-то что-то оптимизирует.

Во-первых, он всё ещё не быстрее в однопотоке.

Во-вторых, вы продолжаете сравнивать разные ниши устройств, с кардинально разными предназначением, размерами, потреблением и ценой. С тем же успехом можно продолжать кивать на десктопные 16-ядерники.

Отсюда и задержки с выходом нативных версий, и сравнимая производительность по сравнению с Rosetta.

Задержки у них из-за плохой культуры кода. Можете посмотреть, с каким лагом они выпускали версии под новые платформы каждый раз.

И да, Ryzen 5900H показывает идентичную производительность в однопотоке.

Не показывает нигде, кроме Cinebench. Я решил проверить ещё раз, и обнаружил, что и Blender и 7-zip на M1 тоже тестировали через Rosetta.

Поэтому мобильный Zen 3 сравним по производительности на поток с M1 в режиме трансляции x86.

Что касается стоимости, то MacBook Pro 13" в конфигурации с 16Гб/1ТБ стоит на $100 дороже чем Asus G713 с Ryzen 5900H и GeForce GTX 3070 ($1899 против $1799 у Asus)

А десктоп можно ещё дешевле собрать. Только от него примерно столько же толку будет в поездке.

Референсный ноутбук от Intel в WebXPRT 3 набирает 271 балл (https://www.computerbase.de/2021-02/amd-ryzen-5000-mobile-test/2/#diagramm-webxprt-3-v293). Это примерно столько же, сколько и у M1Это всё еще на 5% ниже, а не выше на заявленные 32%.

Что презентация Apple, что нынешняя презентация Intel — это чистой воды манипуляциявы всерьез не видите разницы между утверждением «наш новый продукт лучше нашего предыдущего продукта в N раз», где этот N воспроизводим (да даже в банальном geekbench multicore), и утверждением «наш продукт лучше продукта конкурента на N%», где этот N невозможно воспроизвести? А если они использовали условный chrome через rosetta2, то это противоречит утверждению про «нативные версии приложений» в их же пресс-релизе.

Новые Ryzen 5000 серии все равно быстрее.мобильные ryzen 5000 всё равно не дотянут до M1 в однопотоке. А в многопотоке и 4000-е побеждают.

А в geekbench набирает на 10%+ меньше. И это самый топовый и самый горячий из условно мобильной линейки процессоров на 45+ Вт.

Это не утверждение "geekbench рулит, cinebench — говно", а просто замечание, что полноценного тестирования пока ни у кого не было, поэтому рановато пока делать такие заявления.

Вообще все ваши сообщения про M1 выглядят как подгонка аргументов под выводы. В выборе приводимых тестов вас ведёт confirmation bias, сравнения постоянно делаете с разными соперниками по разным параметрам, энергопотребление вообще игнорируете как "неважное" лично вам, и обязательно упоминаете дискретные GPU, как будто интегрированной графики у конкурентов вообще не существует.

Даже из комментариев инженера Intel (заранее прошу прощения, если где-то в другом месте почерпнули выводы изложенные в топовом комментарии) вы вынесли только его мнение, что микроархитектура Apple уже на пределе, дальнейшее развитие невозможно, а Apple зря затеяла переход, и их ждёт провал.

Я вам по-секрету скажу, они и текущий M1 считали абсолютно невозможным пока он не вышел. И даже за A7 не видели никакого будущего, когда там появилось 6 декодеров, потому что тогда считали частоту 1ГГц предельной для такого широкого процессора.

Однако реальность вносит коррективы. IPC у Firestorm на 30-40% выше, чем у любого x86-ядра. Частоту нарастили до 3.2 ГГц, сохранив потребление в 2-4 раза ниже.

Apple ведь только начала процесс перехода на свои процессоры — со своих младших ноутбуков, ориентированных на автономность — а их уже сравнивают только с самым топом, про энергоэффективные/компактные/дешёвые модели вообще больше никто не заикается.

какая разница, сколько в общем может жрать проц, если тест однопоточный

Разница в прогреве коленок и разряде батарейки, очевидно же.

а интегрированный гпу конкурент дискретному?

Младшим дискретным — уже да. По производительности, не по нише.

Intel Xe, кстати, тоже неплохое улучшение в сравнении с прошлыми поколениями, и делает практически бессмысленными GeForce MX, 10xx серии (да, их реально ставят в новые ноутбуки).

а ещё лучше вопрос: а кроме интегрированного гпу что-то было предложено?

Нет. Как и раньше не было в этих моделях.

Если нужно мощнее — есть старшие Intel версии с дискретками, их пока не апгрейдили.

Всё возможно, почему.

Ну вот один архитектор тут под одним из прошлых постов признавался, что они не знают, как M1 вообще получилось сделать, и считает, что это физический предел, дальше некуда.

Правда тут оказывается, что кристалл уже большой, сравним с чипами приставок по бюджету транзисторов.

Вы уже несколько месяцев ходите с причитаниями про количество транзисторов, но так и не объяснили на что это влияет.

Текущий M1 (по расчётам диванных аналитиков) обходится Apple примерно в $25-45 за кристал, что в несколько раз ниже закупочной цены на чипы от Intel для прошлых поколений. Даже если предположить, что условный M1X будет просто монолитом в 2x площади, это поднимет цену всего в 2.5-3 раза (это с учётом defect rate и заполнения пластин), и будет всё ещё дешевле топовых ноутбучных чипов от Intel.

При этом мы вообще не знаем, как именно они решили масштабировать свои CPU/GPU. Зато знаем, что в этих решениях настолько уверены, что поставили весь бизнес маков на них.

Так что запасаюсь попкорном и жду в два раза больше ядер от Эпл.

Если условный M1X внезапно побьёт 5900H/5980HS в многопотоке Geekbench и Cinebench, а макбук с ним не подорожает относительно предыдущего поколения, признаете свою неправоту?

(Про GPU не готов делать прогнозов — в их линейке никогда не было игровых ноутбуков, и топовых GPU не ставили, так что я не ожидаю ничего масштаба RTX 30xx Mobile).

в однопоточном тесте?

Прогрев будет только в многопоточном, на все 45 ватт.

В однопотоке будет 15-20 Вт с турбо-режимом. В сравнении с 3.5-5 Вт разница в батарейке будет ощутимой, и вентиляторы включить придётся.

ну вот амдшные идут от 1660 до 2060чего-то там. Это если H. и вообще — если это U.

Младшие AMD ноуты идут и с 1050, и с MX350. И более старшие бывают совсем без дискретки — не всем нужны игровые станции вместо ноутбуков.

Гравитейшен 2 — 30 млрд на 7 нм, вроде. Предел найден? )

Он говорил не про количество транзисторов, а про алгоритмы.

На брак и стоимость. Внезапно, да?

На это влияет площадь и техпроцесс, которые с количеством транзисторов связаны далеко не линейно. Плотность также зависит от микроархитектуры.

уверены? ну, как бы рынок уже изменился… скосил глаз на маркет: хотя да, подозреваю, что тут вы правы… это будет дешевле интелов…

Топовые Tiger Lake, по косвенным оценкам, обходятся производителям платформ в $150-250 за чип.

Подозреваю, что не просто простым x2 больших ядер. а гпу — нужно выносить/дискретное.

Поэтому я и говорю, просто экстраполировать площадь кристала тут бессмысленно, без понимания, как именно Apple проектирует будущие чипы.

Если вынести GPU и добавить ещё столько же CPU ядер, то площадь основного кристала даже уменьшится по сравнению с текущим M1.

Верю, вполне сможет сравняться, на один поток быстрее, 8 больших ядер. Не верю, что это будет не в том же ваттном диапазоне, что у АМД.

Для 8+8 это будут максимальные 30 Вт и серьёзный перевес по многопотоку.

тот, который на дорогих интелах? а что это докажет? что у Эпл всегда была хорошая маржа?

То, что все эти разговоры про невероятно огромные чипы никак не отразятся на конечном потребителе.

Мне просто в тех темах приводили макмини, как конкурента консолям.

Никакой не конкурент для игр, конечно, а по цене никогда и не будет. Приставки продаются с отрицательной маржой.

Ну и что игровые ноуты слишком дорогие, лучше взять эпл + консоль

Ну я примерно в эту же сторону склоняюсь, потому что мне надоели печки на коленях, которые не живут больше 4 часов. А играю я значительную часть времени в VR, и тут игровой ноут очень серьёзно проигрывает старому доброму десктопу.

консоль без подписки не имеет смысла, а с подпиской на много лет будет стоить столько же, сколько минимальный макмини.

Для Sony/MS средняя консоль на играх/подписке приносит как раз дополнительно около $500 за время жизни. Консоли — довольно выгодный бизнес. И то, что можно экономить, не играя в новые игры, мало кому служит утешением.

А так, я не говорю, что m1x будет настолько больше, что цена станет дороже сильно. я про предел, если требуется создать что-то круче и в цпу, и в графике. или сделать декстопный проц.

M1 уже довольно неплохой десктопный 4-ядерник, говорю как довольный пользователь M1 Mini.

Большое количество ядер и мощные GPU мы обязательно увидим в следующие год-полтора, когда будет время обновлять iMac Pro/Mac Pro.

Я не вижу, какой тут может быть предел, если не считать, что всё должно быть на одном кристале. И даже сейчас есть кристалы, например видеокарт, которые многократно больше M1, и конечные продукты с ними продаются в рознице за подъёмные деньги.

Извините, сравнивать ноуты за терть от цены минимального эпла как-то вообще странно в этом плане, вам не кажется?приведите пример ноутбука на 4800U за 30к.

Плотность и техпроцесс вполне себе неплохо связаны, на 5 нм вроде как +30% транзисторов с тем же количеством брака, как на 7нм получается примерно.+70%*. По числу дефектов на единицу площади поровну получается, а плотность у 5нм выше как раз примерно на 70%.

Вот я на сходный многопоток ставлю. И на то, что при переносе с 7 на 5 нм амд догнал бы по энергии ±, то есть тут преимущество чисто технологическое.про это забываем. AMD только в следующем году представят мобильные решения на 5 нм, к тому моменту apple уже 3 нм клепать будет.

Меня печалит, что за те же деньги я вижу ноуты с 4800H, 16 гб, 0,5-1 тб и 1660Ti с 4 гб. Жалко, что их без дисплея, клавиатуры и тачпада не продают, ага. Да и корпус можно попрощес таким качеством сборки что хочется доплатить еще 50 к за нормальный ноут?

А где я такое написал?здесь: «Извините, сравнивать ноуты за терть от цены минимального эпла как-то вообще странно в этом плане, вам не кажется?». Или вы отрицаете существование ноутов с 4800U и всякими 1660? Или треть от макбука за 100к рублей не транслируется в порядка 30-33к рублей?

ну то есть конкуренция на арм vs x86, а техпроцессом?я про то, что на одинаковом техпроцессе intel/amd смогут конкурировать с apple только лет через 5, а к тому моменту очень многое может измениться.

асусы имеют нормальную сборку. HP вроде как тоже. Lenovo. но для вас главное же любой ценой аргумент оспорить?вы давно вообще в магазине последний раз были и качество сборки ноутов смотрели? Я например готов отметать ноуты, в которых верхняя часть тачбара нажимается с некомфортным усилием, а это подавляющее большинство не-макбуков. А то что вы сравниваете пластиковые ноуты с цельноалюминиевыми тоже не имеет значения?

Да, не указал, что сравнению с M1 подлежат только 8 ядерные АМД, прочие — нет. То есть если выбрать 8 ядер нового поколения, то там так.

Извините, сравнивать ноуты за терть от цены минимального эпла как-то вообще странно в этом плане, вам не кажется?

Сорри, я совсем потерял нить этого обсуждения. Вы спросили, является ли конкурентом дискреткам интегрированное GPU в M1, я явно ответил, что только младшим. Эти младшие сейчас всё ещё ставятся в ноутбуки.

Ни к каким дальнейшим выводам я не вёл.

Плотность и техпроцесс вполне себе неплохо связаны, на 5 нм вроде как +30% транзисторов с тем же количеством брака, как на 7нм получается примерно.

На той же микроархитектуре.

Плотность A13 на 55% выше, чем у основного кристала 5800x, хотя они на одном техпроцессе сделаны.

Зачем 8+8? 8Б+4М, ставлю на такую схему. Смысла увеличивать мелкие по мне нет, они ж для энергоэффективности.

Это я для простоты рассчётов. Скорее всего, да, маленьких ядер больше не станет, а вот про количество больших ядер пока нет понимания.

Теперь посмотрите на начинку консоли, на её цену, добавьте 500$, посмотрите на цены миников…

Я вот не понимаю зачем их вообще сравнивать. Это устройства с разной, почти не пересекающейся функциональностью.

Ну вы ж понимаете, что на АМД я это решу для себя ещё дешевле?

Только пойдя на компромисс в автономности, а возможно и производительности.

Меня печалит, что за те же деньги я вижу ноуты с 4800H, 16 гб, 0,5-1 тб и 1660Ti с 4 гб.

Меня не очень печалит, потому что для моих задач 4800H будет медленнее, а 1660Ti будет греться и шуметь. И никакой макоси. Но это всё, конечно, уже персональные предпочтения.

Меня поправил человек, который вроде ссылку и давал, что там было до 70%. С 30% я был не прав.

Я вёл к тому, что вклад микроархитектуры в плотность очень велик, что можно увидеть сравнив A13 и 5800X на одном процессе TSMC N7P. И переход 7nm->5nm может выглядеть у AMD совсем не так, как у Apple.

Ну, я конкретно рассматривал 4800U

Они не живут реальных 10-15 часов даже при лёгкой работе.

Так видик греется и шумит только в момент его нагрузки, так то он отключен

Или когда внешний 4k-монитор подключен. Или когда видео посмотреть захотелось. И ещё в куче разных случаев. Мой корпоративный макбук взлетает на ровном месте, когда какой-нибудь Zoom или Slack захотел видеокарту зачем-то.

И ноут в ответ на макмини m1 я привёл потому, что никто, нехорошие люди, никто не выпускает минидекстопов на амд.

Вообще выпускают. На том же Anandtech есть несколько обзоров мелких коробочек с Renoir.

Эм, конечно в 4800H видик встроен похуже, но… 4k ему не проблема.

4800U

Выводить, конечно, может, пиксельрейт позволяет. Только, скорее всего, будет лагать даже с композингом окошек с видео. По крайней мере, так было на встройке Intel до последнего поколения.

в драйверах нвидии давно были настройки, что запускать только с такими-то программами

Иметь достаточно производительную и холодную встройку удобно именно тем, что вот этим всем не надо заниматься вообще.

Его с внешними видиками не ставят, при этом у Ryzen 7 4800H интегрированы 7 графических ядер, а у 4800U — 8, то бишь графика в 4xxxH даже похуже встроенная.

Производительность встроенной графики по тестам у H вроде побольше, чем у U. Правда, и потребление выше.

Поэтому я 4800h написал, что даже у него хватить должно.

Сорри, это я спутал.

Интел в последнем поколении, кстати, графику как раз выкатил встроенную неплохую.

Её хотя бы для банальной работы с окошками на нескольких мониторах хватит, уже неплохо.

То, что 30к ноуты не конкуренты 100к эплу никто не споритчет ноуты с 4800H и 1660 ни разу не за 30 предлагают

Верю, вполне сможет сравняться, на один поток быстрее, 8 больших ядер. Не верю, что это будет не в том же ваттном диапазоне, что у АМД.а чего это не верим то? 4800U выдает процентов на 25 больше чем M1 в многопотоке потребляя в полтора раза больше

Мне просто в тех темах приводили макмини, как конкурента консолямгде, товарищ наглый лгун? Где я говорил что «макмини конкурент консолям»?

Am0ralist вообще не готов ответить за свои слова.

В июле он писал, что «офигеет», если эппл сможет выкатить что-то сравнимое с х86.

По факту, начались отмазки и ужимки…

Ну так я всё ещё жду, когда покажут сравнимое с x86. Или для вас x86 это только ультрабуки и тесты с упором на одно ядро?эппл и представила продукт только в этом сегменте.

Просто по вашему, если я офигею, то должен буду после этого стать фанатиком или сразу все аргументы перестать воспринимать критически? Извините, что разочаровал.нет, адекватный человек при появлении новой информации меняет мнение. У вас я смотрю ничего не поменялось с лета.

Публично признавать свою неправоту сложно.

Давайте не будем опускать уровень дискуссии, и вернёмся к уважительному общению, мы здесь не ради удовлетворения ЧСВ собрались.

Правда тут оказывается, что кристалл уже большой, сравним с чипами приставок по бюджету транзисторов.

Cколько там транзисторов мало кого волнует.

Цена определяется площадью и выходом годных кристаллов.

Кристалл Xbox Series X — 360.45 mm²

Apple M1 119 mm²

С 300мм пластины выходит ~430 годных чипов при плотности дефектов 0,1.

Значение для 5нм TSMC не озвучивали, но для 7нм оно составляет 0,09.

Пластины с 5нм стоят довольно дорого — около $17к (по слухам).

$17000/430 = $39 за сам кристалл (до биннинга).

А вот размеры кристаллов прошлых процессоров Apple:

Apple A5X 163mm²

Apple A9X 147mm²

Apple A12X 122mm²

Нарастить гпу даже не в два раза и цпу в два — это его сделать сравнимым по данному бюджету с серверным гравитеёшеном 2

CPU+GPU занимают <50% кристалла.

Если увеличить их вдвое, размер кристалла увеличится до 180,

что более чем вдвое меньше чем Graviton2.

Только не забываем, что кроме просто добавить обычно нужно ещё переработать много чего для правильной коммутации.

Много чего? Второй кластер из 4 ядер подключается к тому же системному кэшу. GPU так же легко масштабируется (по крайней мере до определённого лимита).

12/16 ядерники выйдут в этом году.

до рабочих станций решение всё так же не подойдёт

www.bloomberg.com/amp/news/articles/2020-12-07/apple-preps-next-mac-chips-with-aim-to-outclass-highest-end-pcs

For higher-end desktop computers, planned for later in 2021 and a new half-sized Mac Pro planned to launch by 2022, Apple is testing a chip design with as many as 32 high-performance cores.

У эпл есть только выключенное ядро в видео…

For its future high-end laptops and mid-range desktops, Apple is testing 16-core and 32-core graphics parts.

For later in 2021 or potentially 2022, Apple is working on pricier graphics upgrades with 64 and 128 dedicated cores aimed at its highest-end machines

Сейчас 8 ядер и 2,6TFLOPS.

Посчитать флопсы и размер кристалла 128 ядерного GPU предоставляю вам =)

Правда тут оказывается, что кристалл уже большой, сравним с чипами приставок по бюджету транзисторовчерт подери, да хоть бы раз, один раз, сравнил не с игровым устройством, которое не умеет ни во что что нужно ноутбуку, а с прямым конкурентом, посмотрел на цифры, сделал выводы, и забыл про этот чертов аргумент. У мобильного 4800U на TSMC 7nm 10 млрд транзисторов, и в нем нет ни нейроускорителя, ни поддержки thunderbolt

Так что запасаюсь попкорном и жду в два раза больше ядер от Эпл. Всё же интересно посмотреть, как они выкрутятся, ибо более топовые решения без внешней графики будут смотреться… так себе.мне интересно, а когда это произойдет, вы наконец заткнетесь про бюджет транзисторов, или продолжите песню уже с формулировкой «ну дальше то они точно никак не нарастят»?

Опять решили взять на спор, что докажете мне,чисто статистически, безнадежно даже пытаться. Я буду просто по мере появления новых фактов, противоречащих вашим утверждениям, вас в них тыкать.

А M1 поддерживает работу с внешними видками? Ах да, я забыл, тандерболт же не подразумевает… ой, постойте.Поддержка thunderbolt гарантирует по сути передачу данных по PCIe, а дальше дело только в драйверах. Драйвера же под M1 не пишут потому, что это нерационально. Но это не значит что невозможно.

мне простую математику, доступную всем, как подсчитать из указанных условий процент брака

caly-technologies.com/die-yield-calculator

(Сайт лежит на данный момент)

Клон работает

cloud.mooreelite.com/tools/die-yield-calculator/index.html

а у эпла есть поддержка лучей, длсс и прочего в видике, как в коробках?

«Лучи» у AMD это небольшой блок определения пересечений в текстурнике.

В отличии от «коробок», NPU в Apple аппаратный.

www.eurogamer.net/articles/digitalfoundry-2020-inside-xbox-series-x-full-specs

The RDNA 2 architecture used in Series X does not have tensor core equivalents, but Microsoft and AMD have come up with a novel, efficient solution based on the standard shader cores.

Они доработали умножитель так, чтобы он умел считать вместо 32*32бит умножения 4 x 8*8бит или 8 x 4*4бит, о чём написано в тексте.

32*32: 12+ / 16*16: 24+ / 8*8: 49 / 4*4: 97 TOPS

Но это пиковая производительность умножения и не учитывает стриминг/упаковку/распаковку данных.

NPU в Apple считает всё в FP16 (11TFLOPS), но делает это параллельно с работой CPU/GPU.

А M1 поддерживает работу с внешними видками?

Объясните, почему именно M1 тут виноват, а не банальное отсутствие драйверов?

Хм, не знаю, например, потому что:И что с того?

Apple делает ставку на кэш когерентность GPU, а текущий коннект через TB этого не обеспечивает. Но это не значит что GPU не может работать.

twitter.com/cmwdotme/status/1353185336747315200

Вот когда техдир Corellium напишет, что это невозможно по таким-то причинам, только тогда и можно будет предметно говорить.

У 5980HS TDP заявлен на уровне 35 Вт и он действительно потребляет эту мощность после 10 минут. До этого — 42 Вт.

Да, простите, не разбирался в постфиксах всех версий. Всего 42 (или 80, см. дальше) vs. 15.

При этом многоядерная производительность у этого чипа гораздо выше чем у М1 и сравнивать их не совсем корректно.

Их не очень корректно сравнивать потому, что количество ядер у них разное. При прочих равных, всегда можно уменьшить частоту и "взять числом" — зависимость, как вы помните, квадратичная. А равных тут даже близко не наблюдается.

Если взять Tiger Lake, то тестов тоже довольно много. Вот достаточно большое сравнение: openbenchmarking.org/result/2012250-FI-2012032FI40 Самое забавное, что в большинстве тестов 1165G7 оказывается быстрее.

Эти "тесты" даже тут на хабре уже разбирали с десяток раз. Там полностью отсутствует какая-либо методология, на M1 почти всё запускается через Rosetta, даже там, где не отмечено, множество экзотических приложений с ручными оптимизациями под AVX и так далее.

Прошу вас не ссылаться больше туда.

Начнем с того, что декодер в принципе не является узким местом современного процессора.

Пока ваш целевой IPC не начинает превышать количество декодеров, или частые бранчи не вымывают uops-кэш. И вот тут внезапно пропускная способность декодеров оказывается решающей. Насколько это влияет на итоговую производительность — думаю, тема для хорошей научной работы.

Да, можно расширить ширину блоков переименования, количества планировщиков, а также исполнительных блоков, но вот чип в итоге получится не только большим по площади, но и не сможет работать на частоте выше условных 2 ГГц просто потому что все два десятка логических элементов не будут успевать переключиться в такт.

У нас уже перед глазами рабочий пример на 3.2 ГГц.

И вот тут начинаются различия. Intel и AMD изначально делали процессор для ноутбуков и ПК, где основной приоритет — это производительность.

Основной приоритет везде очень давно производительность на ватт. Никому не сдался одноядерный процессор на 6 ГГц и 300 Вт, мы их видели уже 15 лет назад.

Самым эффективным способом ее нарастить является увеличение частоты.

Которого уже много лет практически не происходит. Intel и AMD так же давно наращивают IPC для увеличения производительности.

В дальнейшем AMD и Intel будут фокусироваться на увеличении IPC при сохранении частот, а Apple на увеличении частот при сохранении IPC.

Ваша логика ломается когда вы безосновательно отказываете Apple в увеличении IPC, а Intel/AMD добродушно разрешаете.

Apple уже несколько лет выдают бранч-предикторы на голову выше, ренейминг за гранью воображения инженеров Intel, гигантский ROB и т.д.

И вот только сейчас взялись по-серьёзному за десктопные чипы, где, скорее всего, будет много разных технологий, которые просто нерационально было внедрять для телефонов.

Что касается комментариев инженера, то вы совершенно не поняли что он вам пытался объяснить.

Я-то его отлично понял, вы могли не пересказывать своими словами.

Я просто не стал принимать все его предсказания всерьёз, после его же признаний, что инженерам Intel даже такое ядро собрать не под силу.

Фактическое энергопотребление 5980HS составляет 35 Вт на длительных нагрузках и 42 Вт на краткосрочных с пиком в 56 Вт первые секунды: www.anandtech.com/show/16446/amd-ryzen-9-5980hs-cezanne-review-ryzen-5000-mobile-tested/4

Да, и в этом конкретном профиле там ничего, кроме Geekbench с M1 не сравнивается на многопотоке. И выигрыш AMD довольно смешон для двукратного перевеса по ядрам, даже если забыть про потребление.

Что касается точности предсказания переходов, то в Zen 3 это в среднем 98-99%, у Intel на полпроцента хуже (9xxx серия), у M1 на полпроцента лучше. Андрей (тот который редактор Anandtech) у себя в Твиттере выкладывал огромные таблицы с процентом промахов.

Да, я про них и говорил [1] [2], только память на цифры вас обманывает.

И замеры там A14, и только пара тестов, которые, в свою очередь, отличаются от таблицы 5900X/9900K. Полная таблица есть только для древнего A12, и там, к сожалению, тесты тоже не те же, что для Zen 3.

На тестах A12/9900K усреднённый результат [1.924% vs. 2.508%].

Для 5900X/9900K — [2.440% vs. 2.940%]

А14 от A12 на 2 тестах ещё прилично выигрывает [2.273% vs. 3.077%] и [3.657% vs. 4.055%]. Остальное нельзя впрямую сравнивать — код разный.

Если я где-то пропустил таблицу именно с M1, пришлите ссылку, пожалуйста, буду признателен.

Цифры вполне себе сравнимые и говорить о каком-то существенном преимуществе не приходится.

Полпроцента сверх 99% — это же в два раза реже промахи получается :)

Что касается производительности на ватт, то это актуально лишь для мобильных устройств и всяких ультрапортативных ноутбуков. Многие 15" ноутбуки, не говоря уже о 16 и 17" моделях большую часть времени и так подключены к сети.

Вы чего, это вообще везде актуально. Просто в десктопах потолок чуть выше, а проблемы ровно те же.

Если бы энергопотребление было неважно, мы бы уже 15 лет назад сидели бы за 6 ГГц P4. Или по 16 ядер сейчас на максимальном турбо-бусте держали. И ещё много всего делали бы, но не можем.

Да, приятно, когда ноутбук или компьютер работает тише, но для многих основной приоритет — это все же производительность.

Я вот не понимаю, для вас производительность — это или топ в Cinebench MT или ничего? Тогда текущий M1 просто не для вас, подождите несколько месяцев.

В формфакторе MB Air, M1 вообще никаких конкурентов сейчас не имеет по производительности и автономности.

В общем, с М1 получилось очень много хайпа, покупать устройство с ним для чего-то серьезного пока рано.

Пока что он не устраивает только вас, заочно.

Все мои знакомые (кроме считающих сеточки на eGPU) в полнейшем восторге от M1 и продают свои топовые MBP 16 на i7/i9, переходя на Air.

Geekbench в силу своих особенностей плохо масштабируется на x86.

Каких именно особенностей? Просветите, а то общественность не в курсе.

Гораздо более показательным в данном случае является Cinebench R23

Тут я могу парировать тем, что движок Cinema 4D состоит из множества алгоритмов, которые много лет разрабатывали под x86, а на портирование на ARM у них было от силы несколько месяцев. И, судя по другим тестам, вроде SPEC, Cinebench сильно неоптимально работает на M1 в сравнении с x86 — это хорошо видно в однопоточном тесте.

Но это исключительно моё мнение, можно не принимать его за аргумент.

где 5980HS набирает 12629 баллов против 7762 у M1 по данным Notebookcheck. Аналогичная картина и в 7-Zip, и в Blender. Ссылки выше.

Ок, т.е. чуть хуже, чем можно было ожидать от двойного количества ядер.

Что касается предсказаний переходов, то вы подтвердили мои слова. Разница там минимальна и в среднем составляет все те же пол процента.

Суммарно это означает на 20% меньше промахов, которые относительно дороги.

По поводу производительности на ватт — это актуально в первую очередь для мобильных устройств, которые в принципе часто работают от батареи. Для более крупных ноутбуков и ПК производительность все же гораздо важнее. Условный 3995WX может потреблять до 280W, современные видеокарты вроде 3090 столько же.

Вы не слышите, что я говорю. Эти 280 Вт — потолок. Он выше, чем в телефоне/ноутбуке, но точно так же ограничивает производительность сверху. Вы не можете завести все эти 64 ядра на полной частоте, не говоря уже о бусте.

И что? Это кого-то беспокоит? Если система делает работу в 10 раз быстрее чем условный М1, то никого не будет беспокоить что она при этом потребляет условные 400-600 Вт. Стоимость электричества не соизмерима со стоимостью времени специалиста.

Я скорее покручу у виска, увидев человека, всерьёз запускающего на M1 задачу, которая требует, а главное может утилизировать 64 ядра с 128 потоками.

M1 — это не чип для рабочей станции, и сравнивать его с тредриперами как минимум странно. Apple не собиралась одним чипом покрыть всю индустрию вычислений.

Если взять обычное офисное применение с браузингом и офисом, то тут вообще без разницы что М1, что условный Tiger Lake.

Для обычного офисного применения есть разница во времени автономной работы и комфорте от температуры и вентиляторов.

Что касается ваших знакомых, то какие у них есть варианты?

Есть, конечно. Весь остальной рынок.

Сама macOS требуется для работы очень немногим, для большинства это просто вопрос комфорта. Если условно AMD выпустит чип превосходящий M1 на голову и по производительности и по потреблению, многие так же радостно побегут продавать макбуки.

Ну и не стоит также забывать, что в М1 все же восемь одновременно работающих физических ядер.

Из них только 4 полноценных. Производительность маленьких ядер практически идентична второму SMT потоку в AMD процессорах — 20-25% от полного ядра, в идеальном случае.

Это не так много для устройств, которые в основном используются от сети.

И это всё ещё потолок, ограничивающий максимальную производительность, в любом форм-факторе.

Они не смогут просто так взять и перейти на Windows.

Ради производительности и автономности можно и потерпеть без приятных фишек. Особенно для рабочего компьютера.

Чтобы этот процесс был не так дискомфортен, некоторые утешают себя мыслю, что отсутствие полноценных USB портов и картридера — это нормально, тачбар, наверное, нужен раз его добавили, а также 200$ за дополнительные 8 Гб оперативки и $200 за дополнительные 256 Гб SSD — это нормально.

Не надо так.

Порты USB там самые полноценные, что есть на рынке — USB4/Thunderbolt4.

Тачбар — мелкое неудобство для одних, приятная фишка для других.

Гораздо более показательным в данном случае является Cinebench R23,cinebench тупо математику гоняет, это лишь один из видов нагрузок современного ПК, очень далекий от нагрузок среднего пользователя, и абсолютно не актуальный для профессионалов (потому что они математику считают на GPU). Geekbench хотя бы пытается тестировать пользовательские юзкейсы (браузинг, компиляция, архивация и пр.)

Сравнимые с Cinebench результаты были получены и в других тестах, включая 7-Zip и Blenderblender тоже чисто математический бенчмарк

В Geekbench есть такие «нужные» тесты как Navigation (на ноутбуке без GPS, ага)кажется речь идет о навигации по веб страницам

Face Detectionсейчас в каждом втором ноуте есть windows hello.

Speech Recognitionа почему нет то? Голосовой ввод может быть удобнее обычного некоторым пользователям. Ну и Алисы там всякие, кортаны…

AES-XTSдовольно-таки важная штука, между прочим. Сквозное шифрование диска сейчас много где есть, и это весьма востребованная для бизнеса фича.

Это именно то, чем занимается средний пользователь на ноутбуке.это явно ближе среднему пользователю чем рендеринг 3d сцены на CPU или вычисление миллионного знака пи.

Intel решила продемонстрировать, что ее процессоры лучше Apple M1