Comments 991

потому что вы просто закончите с рождественским цветным беспорядком

Статья же про зрение и глаза, да? Вытекают. Неужели какое-нибудь "вы получите рождественский цветной беспорядок" в голову не пришло?

end up with a christmas light messна самом деле переводится как «избавитесь от рождественской гирлянды».

Если бы там было "You'll just end a cristmas light mess", то это можно было бы перевести как "Вы просто покончите с этим разноцветным безобразием". Но там "end up with" — идиома, означающая "получить что-то в результате".

То есть перевод — "у вас просто получится разноцветное безобразие". Можно перевести дословно: "мешанина рождественских огней", но это как-то натянуто. "Неряшливая ёлочная гирлянда" вроде бы получше.

Во-первых, как уже сказали, переводится не так. Во-вторых — переводить надо литературно.

"Закончите с беспорядком" я, к примеру, автоматически в уме поправляю на "покончите с беспорядком" — а это совсем не то, что имелось в виду в английском тексте. Понять, что имел в виду автор, мне помогло только знакомство с английским выражением.

Можно получить 26 дюймов из 4-х этих ваших 13-дюймовых… крест по середине это мелочи, да, зато модельный ряд сразу расширится, если все так делать начнут

На телефонах уже 4к есть, так что все спокойно впихивается. Просто спроса, видимо, пока что нет такого большого.

А будет ли он без таких статей? :) Да и с ними — монитор обычно на годы покупается, просто так бежать и покупать новый монитор, увидев, что что-то на рынке прикольное появилось, мало кто будет.

Да и статья-то высосана из пальца.

Автор какой-то странный. Буквы у него размытые. Он протереть экран не пробовал?

Высокое разрешение нужно, например, при работе с чертежами в Autocad, иногда нужно вывести на экран вид с большим количеством мелких деталей и чтобы при этом надписи читались — приходится постоянно увеличивать разные участки.

Но тут возникают как минимум две проблемы.

Первая — найти монитор 4k с диагональю 20"-22" (больше не влезает в поле зрения, нужно крутить головой).

Вторая — большое разрешение для нормальной работы требует больше вычислительных ресурсов.

Как вариант, существуют ноутбуки 4k с диагональю 15,6".

В любом случае, одно рабочее место будет стоить 100-150т.р., сомневаюсь что хотя бы на одном предприятии в РФ инженерам поставят такое.

Где-нибудь в Боинге может быть проектировщики на таких и работают, но не у нас.

Первая — найти монитор 4k с диагональю 20"-22" (больше не влезает в поле зрения, нужно крутить головой).

Монитор от головы отодвиньте. Получаете меньшее поле обзора с меньшим размером пикселей (удвоение расстояние эквивалентно эффективно удвоению dpi). Двойной профит.

Вообще, большинство описанных в статье проблем решаются нормальным расстоянием до экрана.

Иногда чтобы отодвинуть монитор нужно квартиру новую купить Ж)

А если увеличивать масштабирование — то это получается шило на мыло, получаем столько же информации сколько на 1080 но на отодвинутом мониторе.

Большие диагонали скорее для кино и гейминга, чем для работы. Возможно где-нибудь в полиграфии и дизайне они тоже нужны.

Не у всех орлиное зрение. Мне лично некомфортно, если монитор дальше 75 см.

Вам тогда и dpi высокий не нужен.

А мне вот норм головой вертеть :D У самого 21:9 монитор на 34 дюйма. И еще один на 24 дюйма рядом для мелочей. Оба правда 1080p. Сижу где-то в 70 см. от него и вообще норм. Чеб шею и не поразминать)

Домашний монитор брал лет 7 назад — Китай с матрицей Мака (типа во вторую смену завод делает :) ), Мак и лыжа — разницы на АКАДе не вижу. И глаза не устают.

Домашний монитор брал лет 7 назад — Китай с матрицей Мака (типа во вторую смену завод делает :) ),

а что за чудо такое?

После рабочего Мака — разницы глаза не увидели.

Для автокада лучше 2*27 :)

Наверное, затем, что важно не только количество, но и качество отображения текста? Пассаж про "сложнее читать" не понял.

Пассаж про «сложнее читать» не понял.Все современные шрифты, без исключения, сложнее читать, чем растровые шрифты конца XX века. Просто потому что природу не обманешь — контраст любых современных шрифтов гораздо меньше, чем контраст жёстких, резких, шрифтов Windows 3.0 или даже Windows 2.0. Которые не требовалось подгонять под сетку — они были такими от рождения!

Просто потому что тогда у вас выбора не было: то месиво, в которое вырождаются эти шрифты даже в крупных размерах (типа 14 pt вместо 7pt — вполне себе имитация той самой злощастной «ретины») — на старых мониторах с плохой фокусировкой различить были бы невозможно в принципе.

Потому тот факт, что совренные шрифты хуже читаются — это просто факт. Его легко проверить.

Наверное, затем, что важно не только количество, но и качество отображения текста?Да, можно найти 100500 причин (начиная от эстетики и кончая разного вида психологией) почему это круто для всяких ваятелей рекламных брошюр и объявлений… но нафига всё это программистам?

но нафига всё это программистам?

очень странный вопрос. Наверное затем, что программистам тоже не чужды обсуждаемые причины (те, которые "начиная от эстетики и кончая разного вида психологией")?

Это не слишком сложно, если вы действительно занимаетесь программированием.

Ну что за детский сад, ей-богу: матрицы 5x7 более, чем достаточно чтобы различимо отобразить все латинские и русские буквы. И всё.

Да, я знаю: UX'ы плачут и объясняют, что я ничего не понимаю в шрифтах.

Возможно. Но зато я точно знаю, что если не содавать самому себе проблем и не искать красивостей там, где они не нужны — то и решать оные проблемы не потребуется.

Так я за свои купил на работу обычный второй моник, б/у,$80. Моя самамя лучшая инвестиция. Компания еще несколько лет не предлагала доп. монитор.

Хотя, к эргономике отношение религиозное.

Когда-то тоже помню прыгал от счастья, когда смотрел в только что купленный LG Flatron F700P (после какого-то 14" древнего самса, уже и не вспомню)… С его 1920 x 1440 и «всего» 65 Гц… Фишки ЭЛТ, кстати, в том, что они перерисовывают картинку по-честному каждый раз (а не держат её в буфере, как делают ЖК); и в идеальном аппаратном масштабировании (нет сетки пикселей — нет необходимости пытаться впихнуть невпихуёвымаё или что-то пересчитывать). Ну и скорость света (а именно с такой скоростью отрисовывается картинка в ЭЛТ) — тоже не хухры-мухры… )))

Вот, к слову, автор статьи ни разу не обмолвился об ЭЛТ, хотя то же Compaq нативно может 2048x1536 / 80Hz, и это будет выглядеть гарантированно лучше, чем любая покоцанная рескейлом картинка (и особенно динамика) на ретине… И этого точно хватит для разработки и красивых шрифтов… Однако же, потребительские качества (в виде компактности) выходят на первый план, и мало кто может позволить себе держать «архаичную бандуру» на столе, хотя бы и она давала картинку лучше… Маркетинг такой маркетинг…

Вместо сетки пикселей в них "сетка" люминофора, "размер зерна" помните понятие? Электроника hires режимы поддерживать могла высокие, но два соседних пикселя разных цветов вполне могли оказаться слившимися в хорошо так заметную градиентную полосочку с чистыми цветами по краям и чем-то средним в центре

Вместо сетки пикселей в них «сетка» люминофора, «размер зерна» помните понятие?«Размер зерна» сильно меньше влиял, как это ни странно.

два соседних пикселя разных цветов вполне могли оказаться слившимися в хорошо так заметную градиентную полосочку с чистыми цветами по краям и чем-то средним в центреНе могли. Ну то есть вообще никак.

Зерно, во-первых, не обязано было быть зерном (Тринитрон, да), а во-вторых — и «зерно» и, уж конечно, вертикальная полоска люминофора, не загорались целиком. Свет излучался там, куда попадал электронный луч — то есть яркостная картинка строго соответствовала задумке — а вот уже с цветами всё могло быть не так просто. Это можно даже на картинке из Wikipedia заметить — там белая букве «e» под микроскопом и на ней заметно, что слева задействуются больше красного, а справа — больше зелёного.

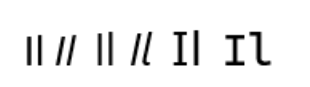

Никакой ClearType так не может. LCD просто чисто аппаратно не может зажечь полпикселя. А поскольку цветовое зрение человека сильно менее острое, чем чёрно-белое, то при том же разрешении картинка на экране LCD — заметно хуже воспринимается, чем на экране CRT.

Вот если приблизиться гораздо ближе к экрану, чем обычно (или, вообще, посмотреть на него в лупу) — то может показаться, что разницы между LCD и CRT вообще нету. Но она есть — если знать куда смотреть…

Таким образом форма мелких объектов на CRT передаётся отлично (и независимо от разрешения вообще), а вот цвета… да, цвета страдают. Но это можно заметить только если у вас жуткая близорукость и вы буквально «носом в монитор» упираетесь.

Кроме маркетинга ещё и бывает сложно решить проблему куда поставить "архаичную бандуру" дюймов на 19, чтобы носом в неё не утыкаться.

/sarcasm/ представляю себе ноут или планшет с элт трубкой, вместо lcd матрицы

Углы обзора. Для ЭЛТ такого понятия не существует в принципе, там угол будет 180 (а если моник не плоский, то даже чуть больше))), и это будут честные градусы, где картинка не будет меняться вообще никак. Даже на распрекрасных (без сарказма) Super AMOLED plus картинка меняется, не говоря уже про IPS-LCD и тем более TN…

Время отклика «матрицы». Опять же, для ЭЛТ это без малого скорость света (понятно, что реальные устройства ограничены скоростью преобразования сигнала в аналоговый).

Равномерность подсветки. Если (ошибочно) допустить, что люминофор выгорает равномерно, то яркость в любой точке ЭЛТ будет одинакова. В ЖК (кроме семейства OLED).

Рискну предположить, что существует некоторая небольшая ниша, где важно отображение именно аналогового сигнала безо всяких аппроксимаций (возможно, какие-нибудь осцилографы и т.п.). Тут точно ЭЛТ (но не те, которые с решётками/масками). Хотя скорее, это я уже за уши притягиваю; думаю, разрешающей способности современных ЖК должно хватать всем…

Может найдутся и ещё какие-то критерии, где ЭЛТ будет лучше. В остальном они, конечно, сильно проигрывают… Потому и ушли на заслуженный покой с рынка… Так что тут вы правы и я с вами согласен.

А про маркетинг — это я больше про статью. Очень мало кому действительно нужна ретина, для большинства же она даже может стать источником лишних проблем (например, обсчитывать 4-10К сильно сложнее, чем 2К, то есть кому-то придётся обновить железо и платить больше за электричество). Причём кроме расходов на саму ретину есть ещё оверхэд на hidpi (например, смасштабировать картинки в браузере). То есть та же ретина в ноутбуке может стать и нежелательной, потому что съест больше батарейки…

Это если игры не запускать, даже старые. Какой-нибудь half life 2 на 4к может серьёзно нагружать неигровую систему.

Ой, а можно я тоже про профили немножко поною? Профиль High422 тоже реализуется примерно никем, из-за чего я не могу перекодировать оцифровки VHS-кассет без искажения цвета :(

А толку от софтовых кодеров-декодеров, если на большинстве не слишком "умных" телевизоров их всё равно нет и не предвидится, да и на том же андроиде ещё нужно додуматься предварительно установить из гугл-плея какой-нибудь плеер с софтовым декодером

А толку от архивов, если их просмотреть будет толком не на чем) Так-то если ограничиваться каким-нибудь VLC в каком-нибудь линуксе на каком-нибудь современном Core i5, то можно хоть в Lossless H.265 писать если места не жалко, а если хочется чтобы условные родственники просто воткнули флешку в телек и не парились, но при этом постараться максимально сохранить качество, то приходится различные связанные с кодированием дилеммы решать. Ну или кодировать дважды в два разных формата, если места совсем не жалко (а мне жалко)

Lossless H.265 писать если места не жалко

Я наоборот считал HEVC способом сжать в относительно низкий битрейт. Ну а интеграшка в «современном Core i5» наверное должна потянуть декодирование такого сжатого видео легко.

Как это ни удивительно, он весит даже немного больше чем Lossless H.264 (или это просто libx265 недостаточно оптимизирован?), ну и относительно lossy они оба здоровые (65 Мбит/с даже с пресетом veryslow ради какого-то жалкого VHS — спасибо, не надо). А мой ноутбучный Haswell в принципе не поддерживает аппаратный H.265 :(

А в VHS было 320x240 и 120 линий цветоразности?

А вопрос в том, как эти 10 бит потом отобразит монитор.

В лучшем случае сокращать битность будет MadVR, в худшем это произойдёт намного раньше.

Я экспериментировал с 10-битным цветом, когда писал собственный просмотрщик изображений. Идея была в использовании ordered dithering: что в блоках 2х2 пикселя к каждому пикселю добавлялось 0, 1, 2 и 3 соответственно, а затем цвет округлялся до 8 бит. На 4К мониторе градиенты выглядели идеально, неотличимо от истинных 10 бит.

Ну а выводить 10 бит на монитор умеет тот же MadVR, но только в полноэкранном режиме, и мой монитор при этом переключается, а делает он это до безобразного долго, около 5 секунд.

Так можно же задать 10 бит глобально для системы, и не будет тратиться время на переключение.

Другое дело, что под Windows все равно придётся переключаться в полноэкранный режим для просмотра 10-битного цвета — это программно-маркетинговое ограничение.

Под Linux такого ограничения нет, но графический интерфейс начинает работать ощутимо медленнее.

P.S. Что-то в Хроме висит ввод комментов на Хабре.

Но только для зажигания пикселя. Погасание может затянуться на несколько кадров из-за послесвечения люминофора

Впрочем, что это я — и на ЖК обновление пикселей происходит с частотой кадров, а время реакции матрицы добавляется к межкадровому интервалу как задержка.

Учитывая, что частота повтора клавиатуры 30 раз в секунду, курсор сдвигается с периодом 0,0(3) с — получается, хвост шлейфа затухал через 0,1 с.

Еще надо понимать, что процесс послесвечения люминофора аналоговый, низкие уровни послесвечения сохраняются очень долго, в полной темноте можно наблюдать послесвечение люминофора только что выключенного телевизора и хвосты при желании можно заметить, если знать куда смотреть. На ЖК матрицах, кстати говоря, тоже можно заметить хвосты, но причина уж не в люминофоре.

ЖК да, тоже имеют свою инерционность — ведь молекулам нужно время на изменение положения. Но оно, по идее, очень маленькое.

Насчет аппаратного предела разрешения — он там есть. Это у монохромных мониторов можно разрешение вытягивать до размеров зерна люминофора, у цветных не так. Конкретно у платформы Mitsubishi 2060u — потолок около 0.20мм по горизонтали, по вертикали можно выставить что угодно, но по факту точность сведения будет где-то около техже цифр. Так что ставить что-то выше 1600х1200 есть смысл только для скриншота чтобы побольше влезло и в печать, или использовать аппаратное масштабирование с софтом, который не умеет что-то подобное сделать также красиво программно.

Когда пересел с 19" на 28", то казалось, что слишком огромный.

Сейчас — посматриваю в сторону 32".

Самый яркий момент при переходе на монитор 4K — это абсолютно чёткие тонкие линии в буквах. Как на бумаге.

Эффект «он слишком большой» действительно проходит и вот сейчас мне хочется заменить свой 34" на что-нибудь типа 40+. Но это почти невозможно сделать, моделей мало и они дорогие.

Да и все современные сериалы в 16:9 идут. Формат 21:9 используется только для большого кино для кинотеатров.

Я как раз имел в виду фильмы в формате 2.4:1, т.е. практически вообще все фильмы за последние 20 лет. У меня нет телевизора, поэтому все фильмы смотрю на мониторе.

На DVD фильмы выпускались или в формате 16:9 с полями сверху и снизу. Или в формате 16:9 с обрезкой краёв. Чаще всего кадр делали тупо по центру, но иногда встречались варианты интеллектуального кадрирования, когда в разных сценах кадр двигали влево или вправо. Как это выпускают на блюрее я не знаю.

Я не то что киноман, но много смотрю кино и сериалов на компьютере. Почти все отлично походят под соотношение 16:9. Редко-редко встречаются другие соотношения. Ну и на большом мониторе даже полоски сверху не особо мешают.

Я тоже не понимал что такое фильмы формата 2.4:1 (а это вообще-то абсолютно все фильмы) пока не купил монитор 21:9. Оказалось что это очень круто когда фильм идёт на весь экран.

Но только не подумайте что это у меня религия такая. Просто мне дома так удобнее. По центру стоит большой 34" монитор, а сбоку есть ещё 24", на котором я запускаю сериалы и всякие прочие стримы когда работаю на основном.

Я не то, что не понимаю, такого нет. Просто 40" монитора позволяют даже с полосками иметь достаточно большую картинку. Но 720р (даже честные) на нем смотрятся отвратительно.

Я давно хочу 40", но почему-то про 16:9 не думал, как-то упёрся в 21:9 и не рассматривал варианты. Может быть как раз есть смысл взять то же самое по ширине, но больше по высоте. Но тут уже, наверное, без 4К не обойтись. Значит начнутся все эти заморочки с «видеокарта не тянет X-Plane» и всё такое.

А наверное 40" 16:9 по ширине как раз соответствуют 34" 21:9Хм, посчитал. Результат для меня несколько неожиданный:

34" 21:9 должен иметь ширину 793,8 мм

40" 16:9 — 885,5 мм

Другое дело, что я в магазине посмотрел как-то на телевизор 40" 4к с расстояния вытянутой руки, как я обычно смотрю на монитор — мне не понравилось. С пикселами — всё ок, но углы обзора, под которыми смотришь на углы картинки, такие, что кажется что смотришь на выпуклый шар.

Для меня, похоже, максимальный комфортный размер плоского монитора — 27"

Жаль, что производителям мониторов эти все аргументы совершенно побоку.

Я вам более того скажу, вашим глазам эти аргументы тоже абсолютно побоку, на самом деле. По крайней мере, если речь идет о переходе со «стандартных» 92 dpi на более высокую плотность.

Я, например, прекрасно вижу разницу между 95 dpi и 180 dpi. Может глазам и побоку, но мне неприятно смотреть на пикселизированный текст.

В статье давят как раз на первое

а где именно в статье на это давят? Дайте цитату, пожалуйста, может я проглядел.

Я программист. Я не занимаюсь цифровой живописью, обработкой фотографий, видеомонтажом. Меня действительно не волнует широкая гамма или даже правильная цветопередача. Я провожу большую часть своих дней в текстовом браузере, текстовом редакторе и текстовом терминале, глядя на едва движущиеся буквы.И в заключении:

Поэтому я оптимизирую настройки, чтобы показывать действительно, действительно хорошие буквы. Для этого необходим хороший монитор. Не просто нужен, а ОБЯЗАТЕЛЕН.

Текст не может выглядеть хорошо на дисплеях с низким разрешением.Хорошо-нехорошо — это на самом деле субъективное «приемлемо». Мне вот сейчас на ноутбучном 96 DPI — читать текст нормально. На домашнем 1080p 24" мониторе я сижу так далеко, что иногда текст увеличиваю, опять же «приемлемо».

Год или два назад кто-то в комментариях на Хабре рассказывал, что вообще всё сглаживание отключал + надстройки, чтобы получить pixel-perfect шрифт как на Windows XP ЕМНИП (или была цель несглаженный шрифт?). Его скриншоты смотрятся именно что — по-другому. Хуже или нет — дело вкуса.

Никто не будет спорить, что при 4К (читай: выше DPI) текст будет выглядеть лучше. Но у автора — это вообще святой Грааль, а вы чукчи и, конечно, 4К 120Гц чуточку дороговат (2000$ — это у него сарказм такой или истинное непонимание?), но того стоит (тм)

У меня не возникло ощущения, что автор пишет о физиологии. Скорее об эстетике и комфорте. На самом деле я автора поддерживаю — каждый должен иметь возможность попробовать поработать за retina-like монитором чтобы выяснить для себя, что лучше. Подозреваю, что многие юзера сейчас пользуются старыми мониторами так как даже не знают, что на рынке существуют экраны, способные предоставить намного лучший опыт. И автор высказывает мысли в таком ключе, чтобы поднять этот вопрос, расшевелить рынок, так сказать.

Другой вопрос, что если сделать экраны физически малоотличимыми от реального объекта, который они изображают — то это будет и эстетично и физиологично (по-крайней мере, нельзя будет сказать, что смотреть на экран вреднее, чем смотреть на реальный мир, который экран отображает).

А что является реальным объектом, если на экране буквы?

Эстетично или нет — это дело вкуса. Как выбор шрифтов. По физиологии — нужно сначала доказать, что пиксельный текст вреднее (или не вреднее) гладкого. Это если экран фонит рентгеном, или мерцание вызывает эпилепсию боль в глазах, то сразу более-менее ясно, что для здоровья такой экран не очень.

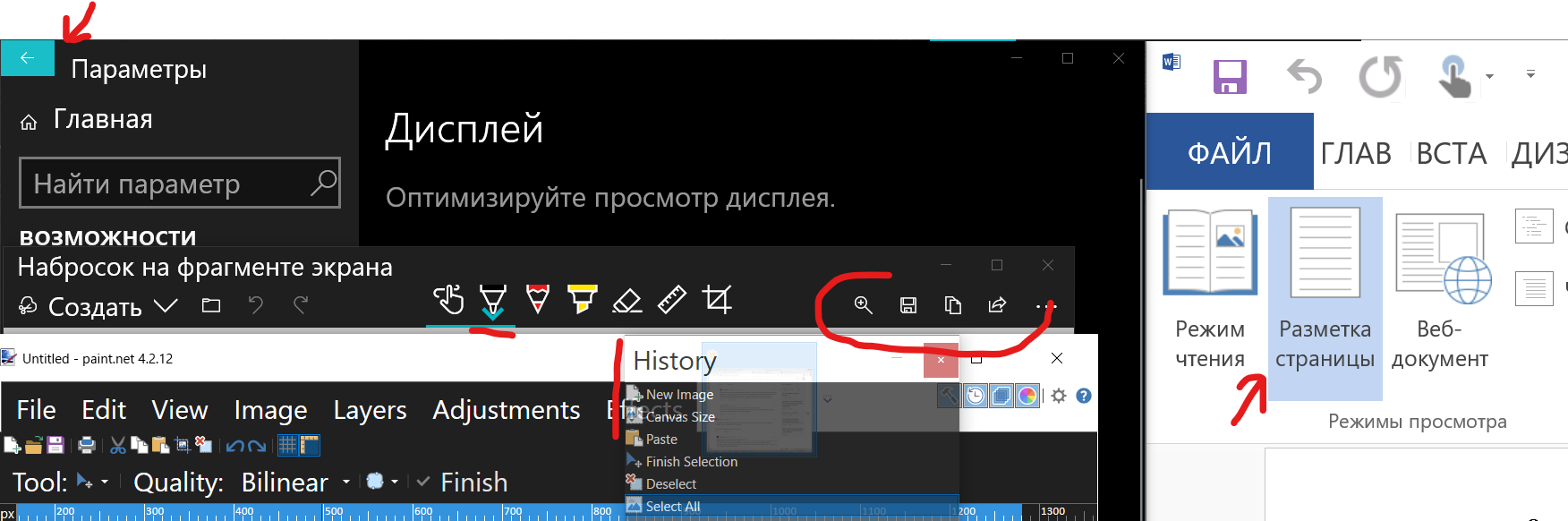

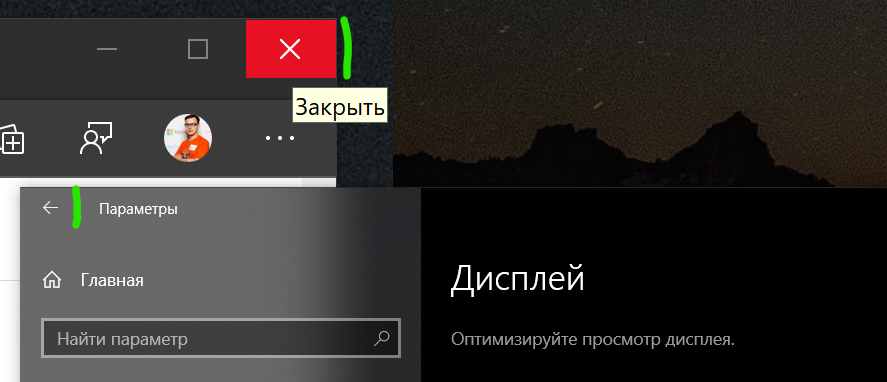

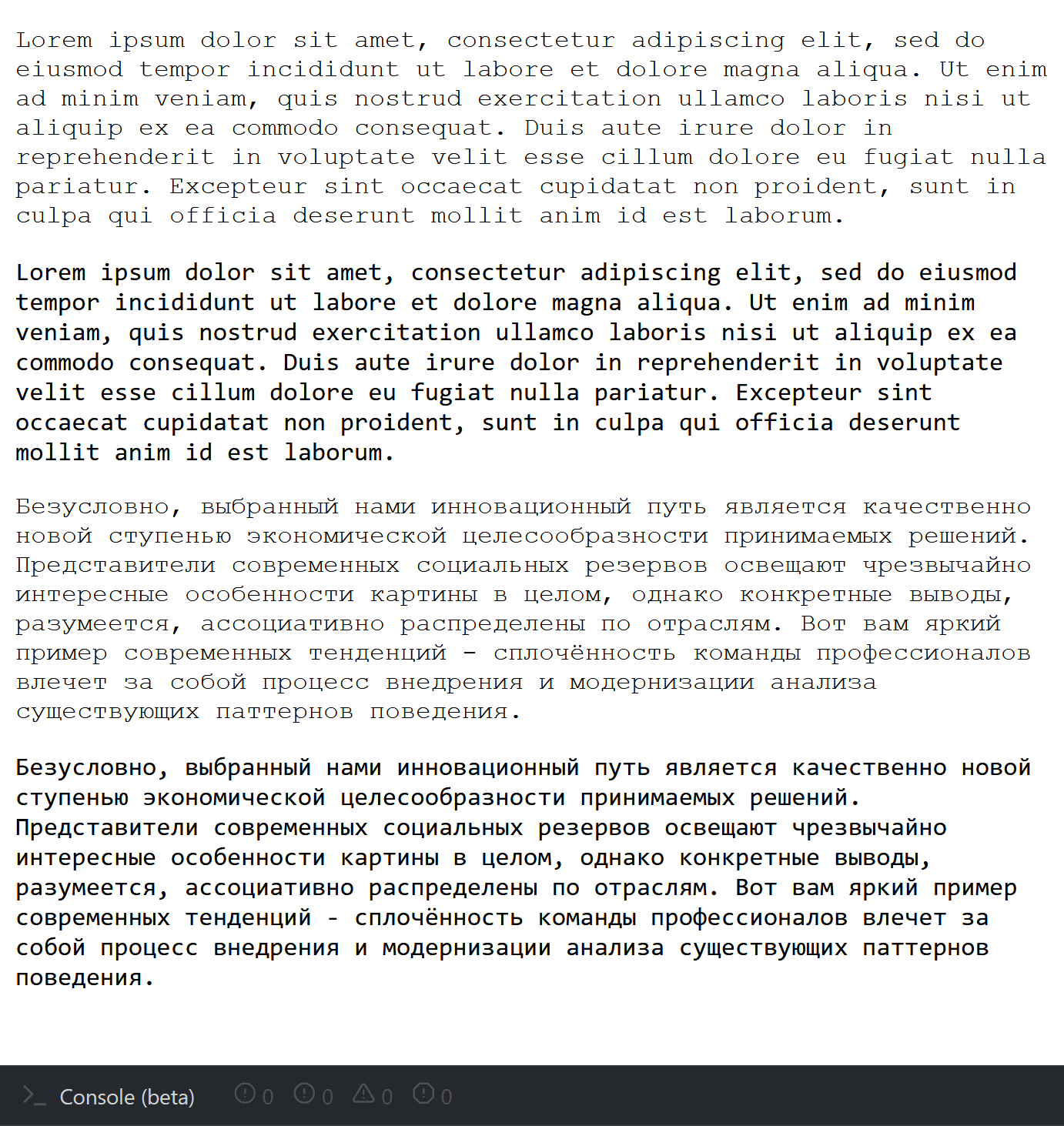

Ставить масштабирование — ловить блох по всем подсистемам, или постоянно переключаться.А что за ОС, какой версии?

Ставить масштабирование — ловить блох по всем подсистемам, или постоянно переключаться.Мы тут (и выше) как раз обсуждали баги масштабирования, и вроде как пришли к выводу, что если у вас 10-ка и мониторы подключены постоянно, то проблемы будут только уж в очень древнем софте, времен висты-xp.

Но если вы приведете примеры программ, где масштабирование не лечится параметрами совместимости, то можно будет развить тему еще.

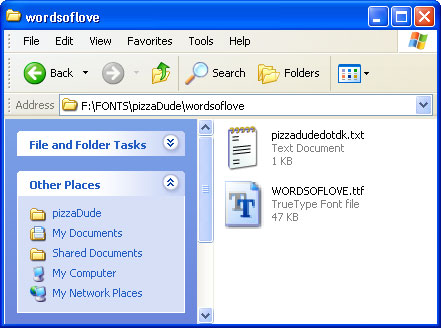

Если мылится текст — да. Если иконки/картинки — нет. Вот пример старого приложения, к которому сам виндовс применяет масштабирование: https://prnt.sc/tfb8wg

Пользоваться можно, но выглядит не очень. В более новых приложениях такой проблемы нет (как пример: https://prnt.sc/tfbe0w )

Ради интереса поставил только что этот Workbench (https://prnt.sc/tfcfda) — таки да, это пример одной из немногих современной, но не адаптированной программы. Позор Ораклу. Но, в принципе, оно выглядит несколько лучше, чем то приложение, которое я приводил выше, пользоваться можно.

То есть под монитор и ОС выбирать, и от мобильности (даже вида системник вожу с работы домой и обртано) отказываться? :)

Год или два назад кто-то в комментариях на Хабре рассказывал, что вообще всё сглаживание отключал + надстройкиЭто, небось, я:)

habr.com/ru/post/463799/#comment_20514385

fastpic.ru/fullview/106/2019/0816/99b291d35da095fb19d8aaf3e43f93df.png.html

Всё ещё жду нормального монитора 23" 4K. А пока что отрубаю всё сглаживание, так что всё выглядит a-ля Win98.

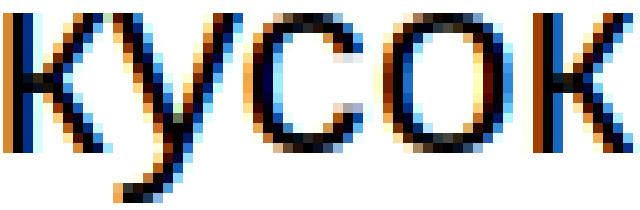

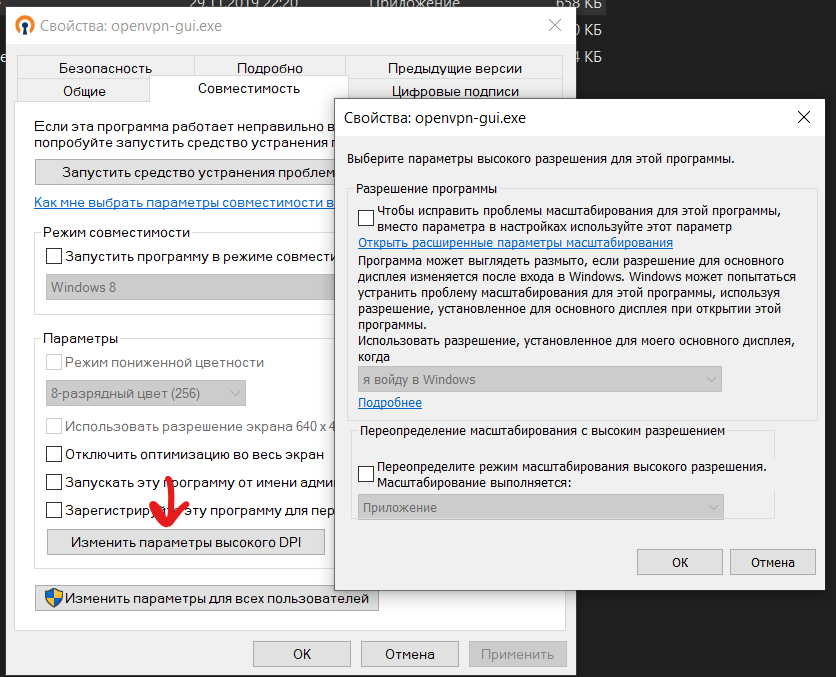

Дл крупных шрифтов сглаживание — это прекрасно. Но для мелких, когда количество сглаженных пикселей больше половины от всех пикселей шрифта, то как будто надел очки на здоровые глаза.

24 сильно больше?

А вот и нижеследующий пример, как Chrome превращает шрифты в мыло. Где-то слышал, что это проблема из-за (кривой) конфигурации Skia. В итоге на Electron-based программы смотреть невозможно (а ≤13pt просто невыносимо). Это как раз те мелкие шрифты, которые сама ОС (Win7) рендерит на ура, в отличие от.

А в вашем тексте практически нету ни одного несглаженного пикселя. Вот сравнение вашего текста и моего Tahoma 12:

fastpic.ru/fullview/112/2020/0703/ca7a67e2c8107a213b54a4f3f7bb718e.png.html

Разрешение человеческого глаза: 1-2 минуты. Этого достаточно, чтобы видеть смазанность шрифтов на 23" FullHD на расстоянии 60см.

Что ж, если в кратце: дело-таки в шрифтах!

Я сравнил Firefox и Electron (Discord app) друг с другом. При одинаковых настройках различий нет. Аппаратное ускорение: да, что-то изменяет (видно, если наложить слои XOR'ом), но незаметно для глаза.

Результатом оказалось, что «старый-добрый» Segoe UI лучше всего ложится на пиксельную сетку при 96 DPI, оттого и кажется чётче. Дело в новых шрифтах, что используют Steam+Discord (других вакханалий Electron на ПК пока не держу). Потому, когда Steam перешел от native чат клиента на Electron и казался текст мылом.

Скриншоты, 96 DPI:

100%, оригинал [160 КБ] (да, размер в настройках блокнота правильный)

400% увеличение через nearest neighbour [286 КБ] (чтобы не использовать неконтролируемое увеличение браузера со сглаживанием)

Тут для меня явный фаворит — это Segoe UI. Мне уже непонять, либо это сугубо личное (знакомый шрифт + пригляделся за года), либо он в самом деле рендерится с меньшим количеством сглаживания.

PS: Скриншоты сводил в Paint.NET 3.5, но он вроде субпиксельно не сдвигает картинки, поэтому ошибок быть не должно.

Font rendering

gfx.canvas.azure.backends > direct2d1.1,cairo,skia (old font rendering)

gfx.content.azure.backends > direct2d1.1,cairo,skia (old font rendering)

Отсюда. Firefox поддерживает несколько бекэндов для отрисовки шрифтов. Вот и всё — откуда могут быть (или не быть) различия.

Мы перешли на так называемый Native font stack, то есть на использование шрифтов, встроенных в операционную систему и используемых в ней в качестве шрифтов «по умолчанию». Такой подход позволяет лучше согласовать оформление сайта с дизайном операционной системы и, кроме того, немного ускоряет загрузку, поскольку страница не подгружает отдельный файл со шрифтом. Соответственно, для замены шрифта вы можете изменить основной шрифт вашей системы или использовать расширения для браузеров, позволяющие применять собственные css-стили к странице.

шрифтов, встроенных в операционную систему и используемых в ней в качестве шрифтов «по умолчанию»

Только вот в моём Arch Linux стал использоваться Segoe UI, который ну вообще категорически не является нативным

.comment__message, .comment-form__preview {

...

font-family: "-apple-system",BlinkMacSystemFont,"Segoe UI",Arial,sans-serif;

}Я установил) Только вот сам факт его установки совершенно не делает его системным/нативным

И то второй без регулировки высоты.

Просто купите кронштейн. Можно сразу на два монитора (если вы используете несколько). Один раз вложили деньги — и со следующими мониторами можно не заморачиваться вообще. Бонусом — появляется место на столе, настройки осей будут всегда именно те, что нужны вам. Высота, наклон, поворот, вынос — всё, как вы захотите.

Мне очень понравились качеством изделия Arm Media: https://market.yandex.ru/catalog--kronshteiny-i-stoiki/56146/list?glfilter=7893318%3A10713369&onstock=1

Использовал несколько лет кронштейны на стену, сейчас подвесил на стол 2 монитора с помощью Arm Media LCD-T42 — поразительно устойчивая конструкция получилась.

Не все мониторы имеют VESA.

Это не проблема, продаются переходники на VESA. Я себе на кухню купил моник Dell 27" вместо телика, он без VESA. Купил сначала переходник, но он оказался очень громоздким и мешал открываться шкафу. В итоге сделал ему переходник на 3D принтере, быстросъемный с креплением типа ласточкин хвост.

В целом, пользуюсь второй год и доволен как слон — яркий и четкий монитор, занимает немного места на столе. Жалко, что следующая версия на 24" оказалась менее удачной — меньше разрешение при таком же размере, меньше яркость, негативные отзывы про качество, поддержка только Thunderbolt 3.

Еще косяк — если используешь пару таких мониторов, то надо подключать каждый своим кабелем к макбуку. Док станции с 2 usb-c видеопортами я не нашел.

еще засада, что там usb-c порты со скорость usb 2.0 всего

Док станции с 2 usb-c видеопортами я не нашел.

А мак в такое и не умеет. Подключал к dell latitude и xps в один type-c порт док на два монитора — все нормально. Тот же самый док с макбуком — изображение на мониторах дублируется, и все. Хотя в последний мак про не пробовал ещё.

Да, матрица 27" 16:9 по высоте почти соответствует 24", но зато она настолько широка, что полностью ломает привычный процесс работы и шаблоны движения мыши по экрану.

Мне не нужен экран 27". У меня 3 монитора по 24", и они отличаются от просто широкого экрана тем, что на каждом мониторе свой отдельный контекст. Я никогда не смотрю на два монитора одновременно. Нужна информация со второго монитора — повернулся к нему. А широкий 27" экран заставляет меня постоянно вертеть головой при работе с одним контекстом.

Рынок правит миром.

Но вот недавно решился на радикальные 43" 3840×2160 в качестве основного монитора. Основной проблемой-ограничением оказалось рабочее место — нужен банально широкий и достаточно большой в глубину (чтобы отодвинуть монитор дальше привычного, увеличив масштаб).

Про «вертеть головой» забылось на следующий день. Сейчас лишь жалею, что не взял изогнутый — теперь понимаю, что это такие же предрассудки, которые развеваются через пару дней реального использования, когда представить возвращение к предыдущему «мелкоскопу» нереально.

Скромный вывод и совет от похожего по тону консерватора — попробуйте, не знаю как, но попробуйте пару дней поработать. Всё не так, как кажется.

Не думали о том, чтобы широкоформатные мониторы ориентировать не в альбомную (стандартную), а портретную ориентацию (ну, как мы А4 листом пользуемся в быту). И тогда по горизонтали проблем не будет, а т.к. ширина кода всегда стандартная (сколько там обычно — 80 символов?), то по вертикали будет влезать больше информации

По этой причине подумываю на счет нового dell xps 15, наконец то ноут с таким соотношением

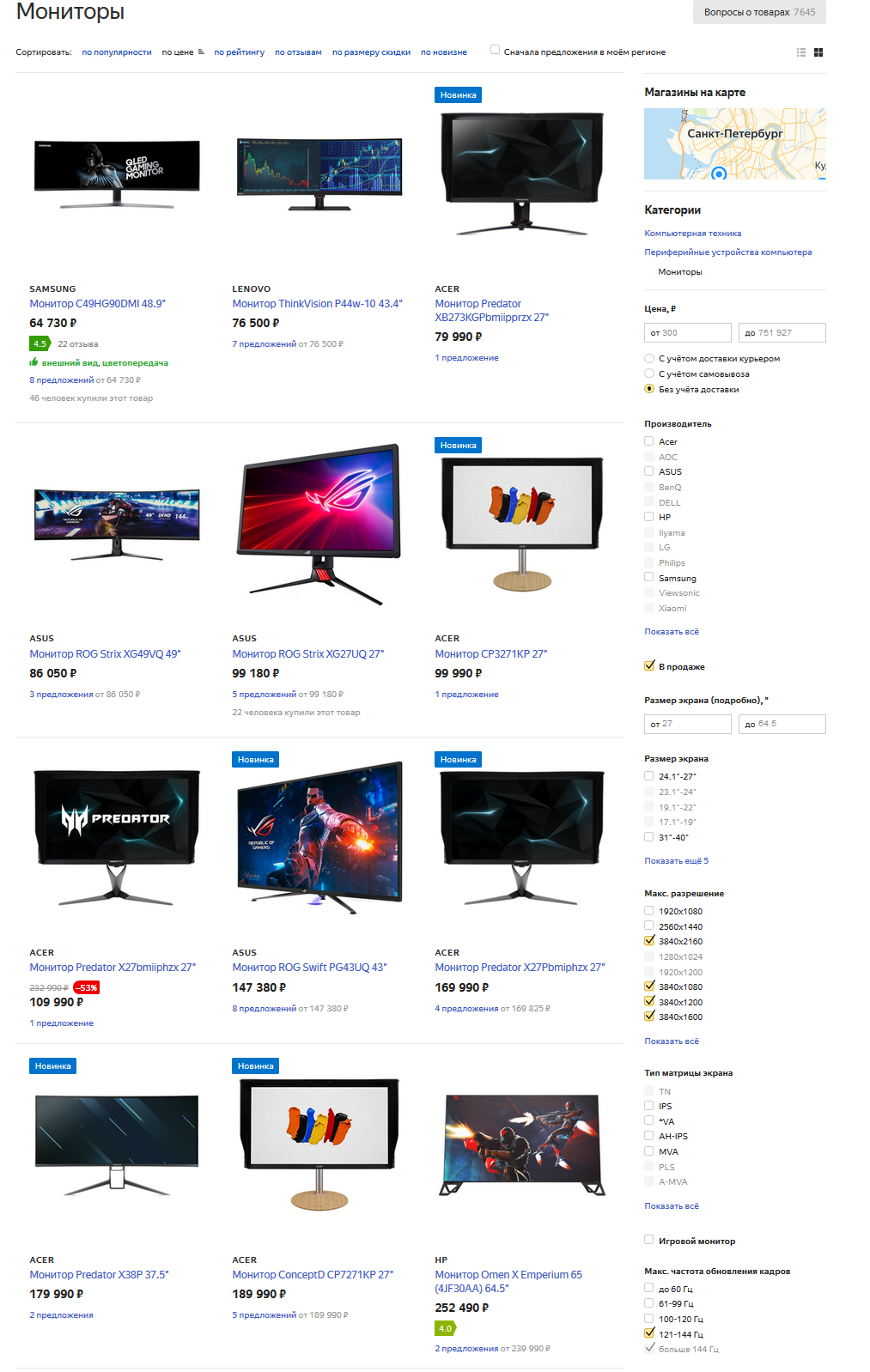

Монторов с 4k и диагональю 24" (27 мне уже многовато) на яндекс-маркете ровно два

Просто поставьте свой монитор дальше, и получите улучшенный аналог 24".

Единственное, когда нужно 24" — когда слишком маленький рабочий стол. В остальных случаях это слишком мало, т. к. требует ставить монитор слишком близко к глазам.

Менее 27" — слишком маленькая диагональ.

Также менее 27" может быть актуально при нескольких мониторах, т. к. при нескольких нужен ещё более большой компьютерный стол — не у всех такой есть.

Купите нормальный рабочий стол — это не так дорого. Тогда сможете хоть 40" поставить, но дальше от глаз — размер картинки будет такой же, но глазам будет намного полезнее, т. к. не придётся напрягаться для фокусировки на близкое расстояние.

Дополнительно это решит проблему изменения размера картинки при изменении позы.

Я к тому, что чем монитор больше, тем всегда лучше для глаз и для пользователя. Главное, чтобы рабочий стол позволял вместить его.

Исключение составляют пользователи, у которых уже развилась близорукость, и которые теперь не в состоянии сфокусироваться на мониторе, который расположен слишком далеко от глаз. Но чтобы она не развилась, как раз и нужен большой монитор. Если же уже развилась, то не знаю, может плавно отодвигать монитор или сходить к врачу.

Какая разница какой физический размер монитора? Главное его угловой размер, не слишком большой, чтобы головой не крутить и не слишком маленький, чтобы видеть достаточное количество информации. Грубо говоря между 27" на 70 см или 24" на 60 см (цифры от балды, точно считать лень) разницы н едолжно быть заметно при прочих равных.

Какая разница какой физический размер монитора?На самом деле разница есть, хотя и вторичная. 24" в 60см и 55" в 120см (цифры от балды тоже), отличаются тем, что во втором случае можно спокойнее двигать головой, глазу нужно не так сильно изменять фокусировку при движении от края к центру и обратно, изменение освещенности не так заметно и т.д.

Поэтому при прочих равных — чем больше тем лучше.

С фокусировкой и освещенностью согласен, с головой, видимо, не уловил.

Но есть ещё один критерий: прочие равные буду только если место не ограничено, ни, грубо говоря, столом, ни, руками.

С фокусировкой и освещенностью согласен, с головой, видимо, не уловил.Сидишь обычно не неподвижно. Сядешь так, сядешь сяк, голову направо подвинешь, налево. Если монитор небольшой и недалеко, то любое неосторожное движение и вылетаешь из удобного центра, если большой и далеко — то чувствуешь себя свободно.

Но есть ещё один критерий: прочие равные буду только если место не ограничено, ни, грубо говоря, столом, ни, руками.Мы со своей фрилансерской колокольни:) Телек 65" стоит столько же сколько моник 42", но при этом поставить его можно на таком расстоянии, что даже не придется особо думать где сесть что бы все было видно.

- Чем дальше монитор, тем лучше для глаз (меньше напряжение глаз, т. к. чем ближе объект, тем больше усилий требуется для фокусировки; особенно это актуально при длительных нагрузках).

- Чем дальше монитор, тем меньше изменяется угловой размер при изменении позы. Пример:

- Маленький монитор:

- Расположен на расстоянии 50 см. Расстояние до дальней точки (например, в левом верхнем углу) — 58.4 см.

- После изменения позы мы отодвинулись на 20 см дальше, стало 70 см. Расстояние до дальней точки — 76.2 см. Расстояние после изменения позы увеличится в 1.30 раза, а масштаб текста станет меньше в 1.30 раза. Из-за этого может выйти ситуация, что когда мы придвинуты, текст слишком крупный, а когда отодвинуты — слишком мелкий.

- Большой монитор (диагональ в 2 раза больше):

- Расположен на расстоянии 120 см. Расстояние до дальней точки (например, в левом верхнем углу) — 134.4 см.

- После изменения позы мы отодвинулись на 20 см дальше, стало 140 см. Расстояние до дальней точки — 152.5 см. Расстояние после изменения позы увеличится 1.13 раза, а значит масштаб текста уменьшится в 1.13 раза, а не в 1.30 раза как раньше. Это значит, что размер текста будет примерно одинаковым во всех позах.

- Пояснение: тут можно заметить, что большой монитор мы расположили на расстоянии 120 см, а не 100 см. Так произошло, потому что расстояние было подобрано так, чтобы размер текста остался таким же в дальней позе. Дальная поза была 70 см, увеличили диагональ монитора в 2 раза — стало 140 см.

- Маленький монитор:

Но чтобы она не развилась, как раз и нужен большой монитор.

В большинстве случаев, близорукость — это изменение формы глаза, оно не зависит от близости экрана.

Цитирую с Wiki:

Также близорукость может быть вызвана спазмом цилиарной мышцы

К сопутствующим факторам появления близорукости относятся ранние и интенсивные зрительные нагрузки на близком расстоянии

Автор что-то хорошо покурил.

Хотя, может уже память обманывает. Но я точно помню очень крупные «точки» из которых рисовался текст.

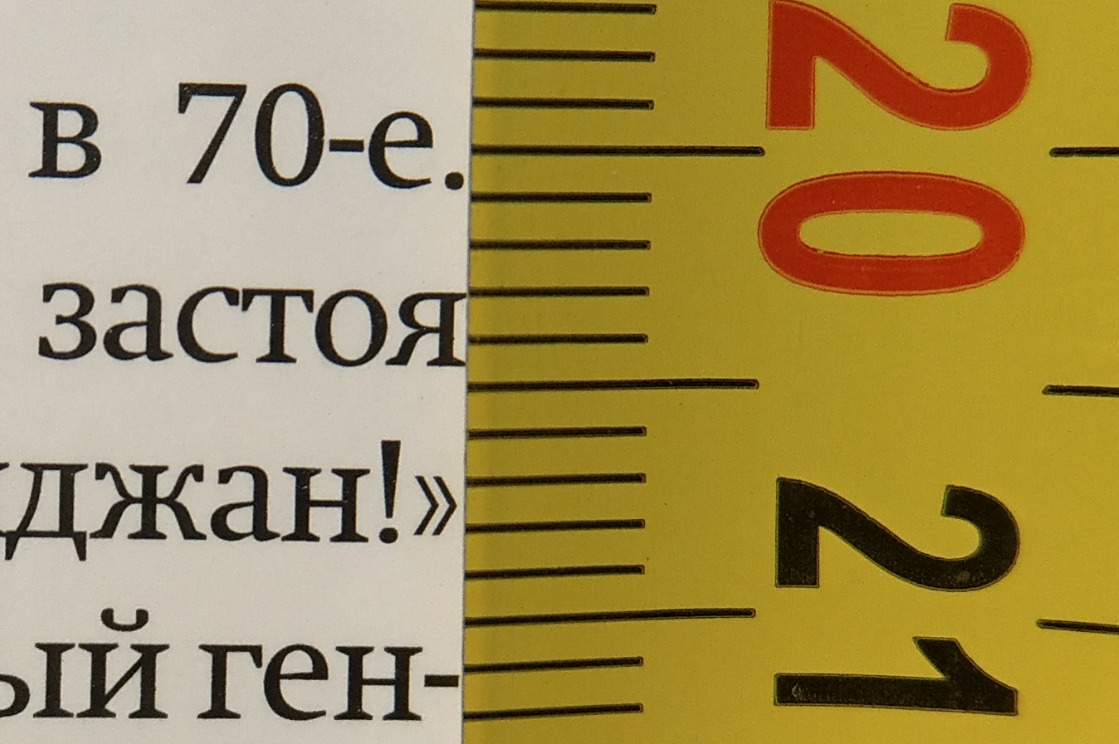

Я сейчас хотел сфотографировать кусочек из «Намедни», чтобы показать реальные границы неровности букв, но у меня банально не оказалось чем сделать макроснимок достаточного увеличения: недостатки камеры уже видно, а букв — ещё нет.

Что интересно, предыдущая страница выглядит более-менее

А разница в бумаге не ощущается? Выглядит как будто первая страница на более рыхлой бумаге.

Ну это уже технический вопрос. Глаза у меня напрягаются и болят независимо от того, точки там или расползлось что-то.Я отвечал на утверждение, что в печатном тексте мало точек/низкое разрешение.

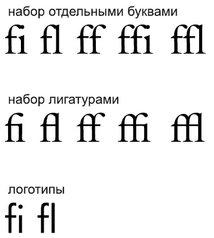

Зато C и I слилось (это что, лигатура?).Нет, лигатура — это когда буквы объединяются вместе в новый символ, отличающийся от просто написания двух букв с перекрытием.

выглядит очень размыто

Называется растискивание, потому что краска жидкая, а валик, с которого она переносится, немного вибрирует. Ну и потому что от бумаги очень сильно зависит: у вас в примере дешёвая тонкая матовая (uncoated), у неё растискивание сильнее. Зато контуры получаются плавные (размытые), именно это позволяет печатать фотографии на тонкой газетной бумаге в разрешении 180 dpi без особой потери качества (визуально). В примере из «Намедни» бумага дороже, плотнее и глянцевая (coated), там растискивание меньше.

На бумажке выходила итоговая картинка в 5к dpi? Потому что за исключением хороших дорогих книг, часто попадаются напечатанные на почти «туалетной» бумаге, шрифт паршивый и глаза устают. Да, сейчас то я умный, а тогда умудрялся покупать и такое.

Это из серии "Слышал я ваших Битлов… Рабинович по телефону напел".

Пока что ни DPI ни контрастность нормальной (даже не высококлассной) бумажной печати для дисплеев недостижимо даже в ближайшем будущем.

А если отправить им картинку с в 4 раза большим количеством пикселей, то не приняли бы?

Глаза устают не потому что «шрифт паршивый», а потому что бумага плохая (тонкая и тёмная, контрастность низкая) и напечатано так, что растискивание очень сильное (там куча факторов на самом деле: и бумага, и краска, и растворитель, и машина, и износ валиков, и прямые руки и иногда волшебство печатника) и буквы «едут».

Финальное разрешение в терминах dpi или ppl посчитать нельзя, есть LPI (lines per inch), но его по факту считают, печатая миры с известным количеством линий и шагом между ними. И понятно что даже внутри одного тиража LPI будет плавать.

Представьте себе дизайнера шрифтов, который тщательно сбалансировал каждую букву, поместил каждую точку с точностью до 1/100 пикселя

Нет, яблочники действительно верят в такое?

Внутри шрифта используется специальная система координат, в которой за 1 единицу принимается 1/N-ая часть кегля, где N = 1000, 1024 или 2048 (в большинстве случаев, но иногда бывает и больше).

Если взять дефолтный вебовский кегль 16px и поделить его на минимальные 1000 частей, то получится, что автор даже почти не преувеличивал.

Переход на 4к монитор — это дорога в одну сторону.

Помню, как купил 4к монитор, подключил, поработал пару дней — вроде неплохо. Ну не знаю, стоило ли оно того, но дело сделано.

А потом практически случайно заглянул в старый FullHD монитор.

И тут я все понял :)

Это правда. 120 не пользовался, но разница между 30 и 60 огромная.

А на ЭЛТ-мониторе когда-то замечал разницу между 60 и 75, глазам было комфортнее на 75.

Возможно, стоило вместо герц вложить деньги в более высокое разрешение, чем 1920x1080, но, поправьте, если я заблуждаюсь, если мне при 1920x1080 приходится работать с масштабом 150%, то при 2560 x 1440 пришлось бы ещё больше увеличивать масштабирование и смысл высокого разрешения был бы потерян.

P.S. Проверьте ещё, что у вас и в ОС выставлено 144Гц, и в играх успевает столько отрисовываться.

А на практике у меня на LCD при 60 Гц начинают болеть глаза, а потом кружиться голова. На 75 — нормально.

У меня такое было на старом (кажется, от samsung) мониторе, купленном в 2005 году. 60Гц ощутимо отличались от 75Гц тем, что на 60Гц ровно через две минуты начинали болеть глаза.

Мониторы, которые я покупал позже, в основном поддерживали максимум 60Гц, но глаза от них не болят.

Если устают глаза, попробуйте уменьшить яркость. Не первый раз слышал от людей, как они этого не замечали и сидели с буквально красными глазами из-за монитора (а у некоторых мониторов контраст/резкость такие высокие по-умолчанию, что там только от этого глазам больно как по мне).

В моём случае в подсветке монитора были люминесцентные трубки дневного света. Неужели и они регулировались PWM, зависящим от частоты обновления экрана? На 75Гц было комфортно и по 12 часов за монитором сидеть, независимо от яркости.

Трубки CCFL тоже регулируются ШИМом (PWM), но от частоты обновления он никак не зависит, его частота задается чипом в мониторе. Для CCFL это обычно 175 Гц. Соответственно, возможна ситуация, когда частота ШИМа и частота обновления "синхронизируются", что усиливает эффект мерцания и ведет к боли в глазах. Изменили частоту обновления, "рассинхронизировали", все ок.

BENQ GW2765, кому интересно

Возможно, стоило вместо герц вложить деньги в более высокое разрешение, чем 1920x1080, но, поправьте, если я заблуждаюсь, если мне при 1920x1080 приходится работать с масштабом 150%, то при 2560 x 1440 пришлось бы ещё больше увеличивать масштабирование и смысл высокого разрешения был бы потерян.Вопрос сводится не к разрешению, а к угловому размеру точки. Если Вам на мониторе при 1920х1080 приходится работать с 150% масштабом, то можно или а) сесть поближе б) купить монитор побольше размером. Второе разумнее.

Если посмотреть нормы санпина, то для комфортной работы 1920х1080 должно быть примерно на 24" мониторе (исходя из размера точка, размеров монитора, расстояния до экрана). Но попробуйте такое сказать публично где-то и Вас заклюют поклонники ретины:) Для 4к надо не меньше 42". Для 2560х1440 в районе 32" нормально.

Но попробуйте такое сказать публично где-то и Вас заклюют поклонники ретины

простите, что? Где именно поклонники ретины (например, автор этой статьи) диктуют логический dpi?

43% всё ещё используют мониторы с плотностью пикселей на дюйм менее 150:

Почему это проблема?

и далее по тексту много аналогичного.

Справочно: 1920х1080 при 24" имеет 90dpi.

А, понял вас. А можете, плиз, дать ссыль на эти нормы санпина, где прописан dpi для комфортной работы — хочу просветиться.

А можете указать, в каком пункте об этом говорится? Не смог найти ничего о размерах точки.

Окей, последний раз — «5.5 Ширина контура знака должна быть от 0,25 до 0,5 мм.»©

Вот прямо сейчас у меня на 4К экране эти буквы шириной около мм.

Я там вижу про знак. Где конкретно про точку? Знак может состоять как из 10 точек, так и из 100 (при ретине). Так что это явно не я издеваюсь.

Сколько бы физических дпи не было — хоть 10 хоть 100, логический дпи вполне четко определяется гостом.

Если Вы не разобрались что такое «знак», то ширина контура знака в минималке это как раз и есть один логический пиксел.

ad1Dima в данном контексте речь про логические пикселы шла. То что физически у Вас 240к экран может быть — не имеет значения, коль скоро Вы фуллхд выставили на нем.

Э-э. Я что-то потерял нить дискуссии. Конечно, в том комменте я говорил о логическом dpi. Давайте вернемся к исходному вашему сообщению, на которое я отвечал:

Если посмотреть нормы санпина, то для комфортной работы 1920х1080 должно быть примерно на 24" мониторе (исходя из размера точка, размеров монитора, расстояния до экрана).

Значит, здесь вы говорили о логическом dpi? И именно этот параметр диктует санпин? Ок, здесь я не имею ничего против.

Но, следующее ваше предложение:

Но попробуйте такое сказать публично где-то и Вас заклюют поклонники ретины:)

вот я, один из поклонников ретины, и я не вижу, за что вас должны заклевать. Поклонникам ретины строго пофигу, какой логический dpi предпочитает юзер, их волнует только физический dpi. Физического dpi должно хватать, чтобы физические точки не были заметны. Только и всего.

для обычного комп. стола нужен не более 27 дюймов, и соответственно не более wqhd 1440p. Проверено.

Если взять угловое разрешение глаза (1 угловая минута) и посчитать разрешение на расстоянии 40 см от экрана, получится как раз 220 dpi. Что и называется Retina — размер пикселя соответствует разрешению глаза. Типа, верхний предел — дальше улучшать нет смысла. Но все что меньше — заметно хуже (при условии фиксированного растояния, если поставить монитор дальше, dpi будет другим, конечно).

А если поставить на 80, то будет как раз 110 dpi, типичный 1080p на 24" :) Я взял 27" 1440p с теми же 110 dpi, просто потому что два монитора дома ставить тупо некуда, надо менять всё начиная с квартиры

OLED гораздо быстрее умеет переключаться и там блюр сильно менее выражен.

К сожалению, OLED-монитор для компьютера за разумные деньги пока не купить.

Зачем нужен заоблачный PPI? После 300 разницу можно увидеть только разглядывая экран вплотную.

А для 1000 Гц нужно уметь полный цикл отрисовки успевать в 1 мс. При том, что сейчас многие приложения даже в 16 не всегда укладываются.

для шрифтов практически нет предела разрешения с которым их можно рендерить

У техники есть ограничения по pixelrate, который она может выдавать :(

И любое увеличение плотности пикселей ведёт к квадратичному росту требуемой производительности и ширины всех каналов.

А про рефреш рейт — пока запроса нет, то и программ таких не будет

Есть такой запрос — VR. Чем выше refresh rate и чем ниже общая задержка всего цикла motion-to-light, тем реалистичнее ощущается виртуальный мир. На текущих технологиях мы где-то в районе 2880x1600@144 Гц и 22 мс. Это на самых топовых компьютерах, в простых по графике играх, с кучкой специфичных оптимизаций драйверов.

То, что сегодня «топовые компьютеры с кучкой специфических оптимизаций» имеет все шансы через десять лет стать просто обычными компьютерами с обычными драйверами.

Это да. А вот по поводу бурного прогресса в топовых компьютерах через 10 лет у меня большие сомнения.

Пока выглядит так, что единственным реальным способом повышать разрешение и снижать задержки является отслеживание движений зрачков и отрисовка в высоком разрешении небольшой области в центре взгляда. Длительность и предсказуемость траектории саккад вполне позволяет проворачивать такой финт за время подготовки кадра.

Но вот обычным мониторам и прикладным программам это никак не поможет, как не помог гейминг в 120 Гц за последние 15-20 лет.

про инпут лаг ещё мало кто слышал

Геймеры в массе слышали и выбирали устройства по нему. С тех пор мало что изменилось.

а вспомнить что тогда было на телефонах так вообще труба — слайдшоу из-за хреновеньких экранов и плохой производительности

Как раз ровно 10 лет назад вышел iPhone 4, который к неплохой производительности и отзывчивости интерфейса добавил Retina экран.

да и софт был ппц, всё подряд блокировало отрисовку

Нет, конечно. Нормальные программисты и тогда разделяли потоки UI и основной работы. А с ппц софтом всё только хуже становится — electron везде, flutter заводят под лозунгом "стабильных 60 fps", которые он не может выдать даже на последних iPhone с процессором мощнее чем в моём ноуте.

Потом постепенно и инпут лаг заметили (и начали бороться, потому что потребители требовательные ныли)

Не вижу я этой борьбы. И отдельные фанатики latency тут ничего не решают.

Разница между 24 кадра фильма и 50-60 кадров ТВ и видео заметна, наверное, всем людям. А вот заметно ли разницу между 60 и 120 кадров даже проверить не на чем. Скорее всего, тоже будет заметно, но насколько — вопрос.

Разницу между 60 и 120 можно увидеть, банально подвигав мышкой.

не проще ли просто переключить тогда мышь на другое разрешениеКак это спасёт от того, что при резком движении курсор перед вами отрисуется в нескольких дискретных точках вместо плавного движения? Или вы предлагаете сделать так, чтобы быстро мышью вообще невозможно было двигать? Такое себе решение.

— Я когда бегаю, мне в ботинках неудобно, может, кроссовки подороже купить?

— Нет, просто прострелите себе ногу! Вы не сможете бегать, и проблема исчезнет.

И эта частота — 24 кадра.

Нет. 24 к/с были выбраны как компромисс после появления звукового кино. И здесь чисто технические причины, а не оптические.

А снимать быстрее 24 к/с уже и тогда умели, никаких сложностей в этом нет. Только расход пленки повышается.

Чтоб вы понимали о чем речь: раньше на кинопленке был записан и звук. Оптическим способом.

Встречный вопрос: почему выбрали 24, хотя слайд-шоу уже не видно и на 16, а Томас Эдисон выступал за 46 (или 48)?

А куда, по-вашему, писался звук?

Где находится верхний предел, за которым человек не видит изменений — не особо понятно и зависит от индивидуальных особенностей, тренировки и того, что мы считаем изменениями и например, яркости (потому что в темноте «скорость затвора» увеличивается как и у фотоаппарата).

Абсолютно согласен что предельная частота кадров это дело крайне темное; особенно, если вспомнить как разницу в FPS можно наблюдать по игровых скелетным анимациям. Реальный предел, по-моему, лежит между 40-50, максимум до 55 Гц.

Кстати, пример с курсором говорит скорее в пользу моего взгляда и того, что наблюдаемая разница выше 40 Гц связана просто с изменениями движения курсора.

Я отлично вижу разницу между 90 и 120 Гц.

Между 120 и 240 для меня уже едва различимо, но профессиональные игроки в шутеры эту разницу отлично чувствуют в слепых тестах.

Что можно увидеть 120Гц кажется маловероятным

Попробуйте посидеть день за монитором с 240 Гц, а потом переключить его в 90 Гц. Отлично видно, как скролл и анимации распадаются на отдельные кадры.

При 240 -> 120 я такого уже не вижу, только ощущаю снизившуюся гладкость интерфейса.

Чтобы изображение дёргалось рывками даже на 240 Гц?

Я думаю, вы хотели сказать про Motion-to-Light latency.

Эта задержка зависит от многих параметров: перифирия ввода, архитектура игрового движка, настройки игры, настройки видеокарты, пропускная способность видеовыхода, софт в мониторе, технологии G-Sync/Freesync… В обычных условиях она может находиться в диапазоне от 25 до 100+ мс.

Чтобы снизить эту задержку для VR до 20 мс пришлось сделать множество нетривиальных изменений в архитектуре игр, видеодрайверах и даже видеоподсистеме Windows.

Собственно, от перехода 120 Гц -> 240 Гц эта latency уменьшается очень незначительно, примерно на 4 мс.

А ещё можно добавить задержку реакции человека, которая превышает 100 мс и скорость нервной проводимости, по которой я видел данные о 20-50 мс от возникновения сигнала в головном мозге до начала движения руки.

Чтобы изображение дёргалось рывками даже на 240 Гц?

Любые кадры сменяются резко, причем граница заметности это смены лежит явно гораздо ниже 240 Гц. Официально, вообще говоря, 50 Гц. Если-же под изображением понимается именно само изображение курсора, то его восприятие упирается всю в ту-же границу.

Я думаю, вы хотели сказать про Motion-to-Light latency.

Нет, ничего общего. Описываемый эффект связан не с геймингом на мониторе, а с использованием шлемов ВР, причем проблемой являются не жалобы на качество картинки или движения в ВР среде, а банальное укачивание игрока.

А ещё можно добавить задержку реакции человека, которая превышает 100 мс

Не уверен но в таком случае хватило бы 10 Гц для иллюзии непрерывности анимации.

Да? Спецификации человека от самого Его?

В смысле, от некоего бога или от какого-нибудь известного деятеля информационной сферы? На самом деле, 50Гц и есть некий максимум восприятия, а +10Гц запас, отсюда и известные всем 60Гц.

И возникает оно потому что показания вестибулярного аппарата расходятся с показаниями глаз.

Ну а информация поступающая через глаза зависит от частоты кадров в самих очках ВР.

Меня, кстати, и в обычных играх с ездой укачивает без всякого ВР, GTA5 укачивала примерно после 15 минут игры.

Вот и я спрашиваю, откуда дровишки?

Даже не обращаясь к какому-либо поиску, можно определить что предел частоты (ок. 50 Гц) для восприятия глаза был установлен примерно в конце 19-го — максимум в начале 20-го века. И об этом очень легко догадаться, если вспомнить о войне токов и о распространении бытовых сетей переменного тока с лампами накаливания.

Как будто от самого Бога получили.

Как видно, для решения вопроса боги тут не нужны, а достаточно лишь вспомнить об освещении или посмотреть на уличные лампы ДНаТ (оранжевый свет).

Ах да, восприятие штука не дискретная.

Не могу не согласиться, скорость восприятия человека действительно может меняться в зависимости от внимания. Напр. можно просто посмотреть на движущуюся секундную стрелку часов, а потом попытаться внимательно проследить за ней, во втором случае покажется, что она движется куда медленнее.

Поворот головы активирует гироскоп, который шлёт сигнал в ПК, который пересчитывает кадры, которые поступают назад на дисплей шлема.

Это скорее уже к производительности или скорости чтения носителя информации.

Кстати, я в туалете поставил дешевые светодиодные лампы — при повороте головы — довольно сильно заметный стробоскопический эффект.

Аналогичный эффект заметен в играх на 60 Гц при резком развороте

Я просто привел иллюстрацию того, что 50-60 Гц обновления картинки на мониторе в некоторых ситуациях — недостаточно.

Если мы, например, пытаемся читать текст при плавной или достаточно быстрой прокрутке — при недостаточной частоте кадров — текст расплывается и для его чтения нужен монитор с высокой частотой кадров, о чем и говорит авто статьи.

Да, без чтения при прокрутке можно обойтись, но если кто-то может позволить себе дополнительный комфорт, то почему бы и нет?

Любые кадры сменяются резко, причем граница заметности это смены лежит явно гораздо ниже 240 Гц.

Я про то, что если снижать именно чувствительность, а не увеличивать Input Lag мыши, то непонятно, чего вы добьётесь, кроме как скачущего рывками курсора мыши.

Официально, вообще говоря, 50 Гц.

Что значит "официально"? Закон такой приняли?

Нет, ничего общего. Описываемый эффект связан не с геймингом на мониторе, а с использованием шлемов ВР

Если что, эта метрика применима к чему угодно. Для VR она просто стала критично необходимой, поэтому о ней много начали говорить.

В игре за монитором она означает время от физического сдвига мыши до изменения изображения на мониторе.

Не уверен но в таком случае хватило бы 10 Гц для иллюзии непрерывности анимации.

Интересно вы так связали между собой задержку реакции и восприятие непрерывности движения.

Я про то, что если снижать именно чувствительность, а не увеличивать Input Lag мыши, то непонятно, чего вы добьётесь, кроме как скачущего рывками курсора мыши.

Я нашел очень простое объяснение — если допустить, что синхронизация изображения и курсора мыши происходит лишь каждый кадр, то все становится на свои места. Увеличение частоты кадров (в т.ч. без всякой оглядки на устройство вывода, напр. 200FPS на 60Гц мониторе) попросту повышает частоту синхронизации изображения и устройства ввода, отсюда и плавность которую люди чувствуют при высоких значениях ФПС. Повышение частоты кадров аналогично должно вызывать и повышение плавности прокрутки, движения самого курсора и т.п., что тут и описывают люди. Однако-же, реально больше кадров человек не видит исходя из общих представлений о физиологии.

Что значит «официально»? Закон такой приняли?

Почему 50 Гц вызывают такую реакцию? Еще 15 лет назад все и везде могли наблюдать лампы накаливания, мерцающие с частотой бытовой сети т.е. с частотой 50 Гц.

Если что, эта метрика применима к чему угодно.

Я не нашел. Да и укачивание за мониторов явление нечастое.

Интересно вы так связали между собой задержку реакции и восприятие непрерывности движения.

0.1сек задержка -> мгновенная реакция -> 0.1 сек задержка -> мгновенная реакция и т.д.

Еще 15 лет назад все и везде могли наблюдать лампы накаливания, мерцающие с частотой бытовой сети т.е. с частотой 50 Гц.

Я и 35 лет назад не мог, и 15, и сейчас не могу...

Я нашел очень простое объяснение — если допустить, что синхронизация изображения и курсора мыши происходит лишь каждый кадр, то все становится на свои места.

Объяснение простое, но неправильное.

Данные от мыши в приложение приходят абсолютно независимо от видеоподсистемы. Драйвер мыши опрашивает устройство с фиксированной частотой (от 125 до 1000 Гц, в зависимости от устройства и драйвера), ОС опрашивает драйвер тоже с какой-то фиксированной частотой и передаёт события в приложение. А уже приложение само решает, в какой момент их обработать. При отсутствии vsync — так часто, как позволяет производительность компьютера рассчитывать новые кадры.

Повышение частоты кадров аналогично должно вызывать и повышение плавности прокрутки, движения самого курсора и т.п., что тут и описывают люди. Однако-же, реально больше кадров человек не видит исходя из общих представлений о физиологии.

Так как же люди видят плавность, если не видят? :D

Вот возьмём равномерно прокручиваемую страницу с текстом. Я отчётливо вижу разницу между прокруткой на мониторе с 60 Гц и с 120 Гц. Откуда взяться увеличившейся "плавности", если не из частоты обновления изображения на мониторе?

Почему 50 Гц вызывают такую реакцию? Еще 15 лет назад все и везде могли наблюдать лампы накаливания, мерцающие с частотой бытовой сети т.е. с частотой 50 Гц.

Лампы накаливания почти не имеют пульсаций, поэтому я не понимаю, что именно вы наблюдали 15 лет назад.

UPD: Поправлю сам себя — это верно только для мощных ламп с теплоёмекой нитью накаливания. Плохие лампы дневного света мерцают гораздо сильнее, поэтому осталось хорошее впечатление от "нагреваек".

Мерцание CRT мониторов вплоть до 100 Гц я наблюдал, да, и меня это крайне раздражало.

Я не нашел. Да и укачивание за мониторов явление нечастое.

Про укачивание я ничего не горорил, это вы начали о нём зачем-то.

Я говорил о том, что по сравнению с полным циклом обработки компьютером одного фрейма, input lag мыши невелик и не вносит существенной разницы (на частотах 120-240 Гц).

0.1сек задержка -> мгновенная реакция -> 0.1 сек задержка -> мгновенная реакция и т.д.

Если вы хотите дёргать рукой на каждое изменение изображения, то больше 10 Гц вы не достигните, да.

Но это не имеет вообще никакого отношения к восприятию непрерывности движения и различению отдельных кадров.

Данные от мыши в приложение приходят абсолютно независимо от видеоподсистемы. Драйвер мыши опрашивает устройство с фиксированной частотой (от 125 до 1000 Гц, в зависимости от устройства и драйвера), ОС опрашивает драйвер тоже с какой-то фиксированной частотой и передаёт события в приложение. А уже приложение само решает, в какой момент их обработать. При отсутствии vsync — так часто, как позволяет производительность компьютера.

А дальше-то что?

А далее некое приложение (что угодно) отрисовывает кадр и показывает его пользователю. Это и есть синхронизация курсора и положения мыши.

Если кадров много мы видим курсор все чаще, его движения кажутся все плавнее. Аналогично про камеру в 3d игре.

Так как же люди видят плавность, если не видят? :D

А я и не разу не использовал слова «видеть» в отношении числа ФПС; я как раз неоднократно писал, что увидеть больше определенного предела кадров невозможно, а почувствовать легко.

Я отчётливо вижу разницу между прокруткой на мониторе с 60 Гц и с 120 Гц. Откуда взяться увеличившейся «плавности», если не из частоты обновления изображения на мониторе?

А какова была и есть частота входящего в мониторы сигнала?

Лампы накаливания почти не имеют пульсаций, поэтому я не понимаю, что именно вы наблюдали 15 лет назад.

Я наблюдал отсутствие мерцания. Это говорит, что более 50Гц увидеть человек не может т.к. это частота тока в бытовой сети.

Про укачивание я ничего не горорил, это вы начали о нём зачем-то.

Именно так, потому что укачивание в ВР-очках и есть главное последствие и проблема данного эффекта.

Я говорил о том, что по сравнению с полным циклом обработки компьютером одного фрейма, input lag мыши невелик и не вносит существенной разницы (на частотах 120-240 Гц).

Это хорошо, но я писал об увеличении чувствительности мыши.

Если вы хотите дёргать рукой на каждое изменение изображения, то больше 10 Гц вы не достигните, да.

Но это не имеет вообще никакого отношения к восприятию непрерывности движения и различению отдельных кадров.

И?..

А далее некое приложение (что угодно) отрисовывает кадр и показывает его пользователю. Это и есть синхронизация курсора и положения мыши.

Так а что тогда предлагается "компенсировать" в эксперименте? Ограничить частоту обновления мыши в 60 Гц на 120 Гц мониторе? Что тогда этот эксперимент вообще может показать?

А я и не разу не использовал слова «видеть» в отношении числа ФПС; я как раз неоднократно писал, что увидеть больше определенного предела кадров невозможно, а почувствовать легко.

У вас в одном предложении "не использовал слова «видеть» в отношении числа ФПС" и "неоднократно писал, что увидеть больше определенного предела кадров невозможно".

Я при всём желании не могу понять, что вы имеете в виду.

Я отчётливо вижу разницу между прокруткой на мониторе с 60 Гц и с 120 Гц. Откуда взяться увеличившейся «плавности», если не из частоты обновления изображения на мониторе?

А какова была и есть частота входящего в мониторы сигнала?

Ровно такая, какую отображает монитор. Мониторы так работают.

Я наблюдал отсутствие мерцания. Это говорит, что более 50Гц увидеть человек не может т.к. это частота тока в бытовой сети.

Вы наблюдали тепловую инерцию нагреваемой спирали. Она не успевает остыть и погаснуть перед следующим циклом.

С мерцанием вообще всё не так, как с восприятием движения. 60 Гц при low-persistance отчётливо видят видят все мои знакомые, которые пробовали Gear VR.

Про укачивание я ничего не горорил, это вы начали о нём зачем-то.

Именно так, потому что укачивание в ВР-очках и есть главное последствие и проблема данного эффекта.

Какого ещё эффекта?

Я указал величину Motion-to-Light задержки только чтобы показать, насколько потенциальное время реакции профессионального геймера превышает максимальную разницу во времени расчёта фреймов на мониторе 120 Гц и 240 Гц.

Это хорошо, но я писал об увеличении чувствительности мыши.

Чувствительность мыши в общепринятых терминах — это количество различимых состояний, которые мышь может сообщить при перемещении на определённое расстояние (DPI — dots per inch).

Если вы что-то другое имеете в виду, прошу расшифровывать.

Так а что тогда предлагается «компенсировать» в эксперименте?

Увеличение чувствительности мыши (предполагается, что пользователь двигает ею с некоторой усредненной но постоянной скоростью; при повышении частоты кадров скорость мыши также увеличивается, смтр. хотя-бы пример с частотой выше).

Ограничить частоту обновления мыши в 60 Гц на 120 Гц мониторе?

Частоты опроса мыши на порядок выше.

У вас в одном предложении «не использовал слова «видеть» в отношении числа ФПС» и «неоднократно писал, что увидеть больше определенного предела кадров невозможно».

Где я указывал что более 50 Гц можно увидеть?

Ровно такая, какую отображает монитор. Мониторы так работают.

В этом и ответ — подключая монитор с большей частотой пользователь заставляет компьютер выдавать сигнал с большей частотой; если производительности на это хватает, то пользователь не увидит кадров больше естественного предела, но почувствует увеличение синхронизации отображаемой картинку с мышью. Это и есть объяснение, почему работающие на мониторах с большей частотой не могут согласиться, что разницы с более низкочастотными нет, но и не могут конкретно указать в чем она.

Вы наблюдали тепловую инерцию нагреваемой спирали. Она не успевает остыть и погаснуть перед следующим циклом.

Для наблюдения разницы спираль и не должна остыть полностью; достаточно вспомнить что разница между поверхностью Солнца и солнечными пятнами составляет всего 1.5 тыс. град. (что совсем немного для термоядерныъ энергий и температур светила), при этом они отлично видны и были засвидетельствованы еще в незапамятные времена.

Кроме ламп накаливания, мерцают почти все типы источников света (в т.ч. мерцать даже светодиодные при плохом источнике питания) — 30 лет назад были очень распространены удешевленные варианты светильников люминесцентных ламп работавших без повышения частоты напряжения.

Какого ещё эффекта?

Я указал величину Motion-to-Light задержки только чтобы показать, насколько потенциальное время реакции профессионального геймера превышает максимальную разницу во времени расчёта фреймов на мониторе 120 Гц и 240 Гц.

Описываемый термин был создан для пояснения эффекта укачивания в очках ВР, к мониторам он прямого отношения не имеет вовсе.

Чувствительность мыши в общепринятых терминах — это количество различимых состояний

А квантовое состояние мыши? Мышь движется лишь по двум осям в одной плоскости, какие уж «количество различимых состояний»…

DPI — dots per inch

Число точек уместнее, но причем они к «количеству различимых состояний»?

С чего бы?

Смтр. пример выше с сайтом который показывает курсор мыши на разных частотах.

Как раз 120 по умолчанию. Можно довести до 1000.

У всех A4Tech в серии X7 (сколько им десятилетий не знаю, но как минимум ок. полутра уже) частота опроса 500-1000 Гц. Хотя, признаться, на максимальной частоте одна мышь у меня испортилась.

Смтр. пример выше с сайтом который показывает курсор мыши на разных частотах.

А теперь запишите видео, как эти курсоры двигаются и увидите, что их линейная скорость одинакова и указана в настройках теста.

У меня F4 и это настройка.

Смысл фразы в русском языке будет тем менее понятен, чем хуже соблюдаются окончания, суффиксы…

Ах да, 90% мышей не являются игровыми, а в офисных используется стандартные 125 Гц (про 120 я ошибся).

Даже частота 125 Гц вдвое выше стандартной частоты монитора, а наложением двух частот и обусловлена прерывистость курсора.

Эм, нет, вы не правы по всем фронтам.

Где?

Увеличение чувствительности мыши (предполагается, что пользователь двигает ею с некоторой усредненной но постоянной скоростью; при повышении частоты кадров скорость мыши также увеличивается, смтр. хотя-бы пример с частотой выше).

Скорость движения курсора мыши не зависит от частоты монитора.

пользователь не увидит кадров больше естественного предела, но почувствует увеличение синхронизации отображаемой картинку с мышью.

Что такое "увеличение синхронизации"?

1) Изменение положения мыши с большей частотой отображается на мониторе? — Так в этом и смысл выставления большей частоты.

2) Меньше задержка от движения мышью до изменения картинки? — Крайне незначительно, не больше 4 мс на 30-50 мс общей задержки.

Описываемый термин был создан для пояснения эффекта укачивания в очках ВР

Ещё раз повторю — этот термин отлично подходит для измерения общей задержки компьютера, от устройства ввода до устройства вывода. Не нравится термин — давайте будем называть "суммарная задержка".

А квантовое состояние мыши? Мышь движется лишь по двум осям в одной плоскости, какие уж «количество различимых состояний»…

Число точек уместнее, но причем они к «количеству различимых состояний»?

Вы в демагогию начали скатываться. Я вас попросил дать расшифровку, что именно вы подразумеваете под "чувствительность мыши", а заодно объясните, каким образом связали с частотой монитора.

Скорость движения курсора мыши не зависит от частоты монитора.

Зависит, конечно

Наглядно www.testufo.com/mousearrow#count=4&pps=3840

Что такое «увеличение синхронизации»?

Когда пользователь чаще видит обновление положения курсора мыши (более соответствующее ее положению).

1) Изменение положения мыши с большей частотой отображается на мониторе? — Так в этом и смысл выставления большей частоты.

Реального смысла тут нет т.к. производительность пользователя никаким образом не изменяется, меняются лишь его субъективные ощущения от использования манипулятора.

Крайне незначительно, не больше 4 мс на 30-50 мс общей задержки.

50 мс это 20 Гц, 30 мс это 33 Гц; хотя эти частоты тоже обсуждались выше, они далеки даже от 50 Гц.

Ещё раз повторю — этот термин отлично подходит для измерения общей задержки компьютера, от устройства ввода до устройства вывода.

Может подходит, может нет. Но для мониторов его все равно не используют, а столь внезапно адаптировать его не время.

Не нравится термин — давайте будем называть «суммарная задержка».

Зачем?

Вы в демагогию начали скатываться.

Я не умею давать ответы на бессвязные фразы. Могу конечно, но смысла в ответе будет не больше чем в вопросе.

Чувствительность мыши в общепринятых терминах — это количество различимых состояний

Так квантовых состояний или каких вообще?

Я вас попросил дать расшифровку, что именно вы подразумеваете под «чувствительность мыши»

Способность датчика мыши регистрировать изменения ее положения в пространстве.

заодно объясните, каким образом связали с частотой монитора

Поскольку я это описывал уже неоднократно, специально повторю чтобы всем было видно и понятно.

Сигнал устройства вывода (монитор) опаздывает относительно сигнала устройства ввода (чаще всего это мышь); момент отображения измененного положения курсора и есть момент синхронизации реального положения мыши с курсором. Очевидно, что частота синхронизации не может превысить частоту обновления кадров.

При низкой частоте кадров заметная часть положений движущегося курсора будут выпадать, отсюда и характерная прерывистость. При высокой частоте наоборот будет появляться плавность т.к. мышь вполне реально чаще опрашивается приложением. Может возникать впечатление, что человек видит дополнительные кадры сверх физиологического предела (ок. 50Гц), но это правда лишь наполовину — движущийся курсор действительно будет виден лучше. Он будет виден лучше лишь потому что движется с большой скоростью, которая заведомо не позволяет отображать все его положения не при 60, не при 120, не при 240 Гц (частота опроса мыши заметно выше). Не уверен, стоит ли разбирать пример с testufo, но это быстро — на нем мы видим, что опоздание и прерывистость курсора тем меньше, чем выше частота экрана. Так получается лишь потому что при повышении частоты повышается шанс увидеть быстро движущийся курсор. «Идеальная» плавность движения курсора будет достигнута при частоте монитора, соответствующей частоте опроса мыши, но конечному пользователю разницы от этого не будет т.к. эффект и заканчивается лишь на скорости движения мыши и плотности отображения ее изменений.

Почему люди работают на 120 Гц мониторе, переходят на 240 Гц и чувствуют разницу? Потому что на 120Гц мониторе сигнал почти всегда будет 120 Гц, а на 240 до 240 т.е. речь идет не столько о двух разных мониторах, сколько о двух разных частотах исходящего из компьютера сигналов. Изменения в работе и правда есть, пользователи не врут, но они вызваны лишь повышением частоты кадров в рабочей среде.

По той-же причине не врут и пользователи, которые заявляют что «видят» разницу, когда приложение с производительностью, скажем, более 100 ФПС, выдает 60 Гц сигнал на обычный монитор. Разница есть, увидеть ее как таковую нельзя (если только не следить за курсором мыши очень внимательно), но почувствовать по движению мыши или изменению плавности прокрутки можно.

Я дал исчерпывающее объяснение большей части описанных в статье и комментариях эффектов?

Извиняюсь, но вы пытаетесь рассуждать на темы, в которых не разбираетесь ВООБЩЕ.

50 мс это 20 Гц, 30 мс это 33 Гц; хотя эти частоты тоже обсуждались выше, они далеки даже от 50 Гц.

Компьютеры не работают мгновенно. Они не выполняют все операции синхронно. Пока один кадр ещё только начинает отображаться на мониторе, второй уже заканчивает рендеринг на GPU, в игровом движке в это время рассчитывается состояние мира для отрисовки третьего, и вот примерно в начале этого рассчёта берётся последнее актуальное положение мыши от ОС, которая получила его от драйвера, который получил данные от устройства. На каждом из этих этапов есть буферы, ненулевое время обработки данных, ненулевое время передачи.

Полное время, за которое информация о сдвиге мыши отображается на мониторе — не меньше 25-30 мс в самом идеальном случае: в сурово оптимизированной игре, на высокочастотном мониторе с G-Sync/Freesync, с мышью с минимальными внутренними задержками (да-да, мышь сама по себе, ещё до передачи данных на USB шину, может вносить до 20 мс).

В реальности выходят цифры ближе к 50 мс.

При этом игра может легко рендерить 500 fps, а монитор отображать 240.

Дальнейшую клоунаду с "речь идет не столько о двух разных мониторах, сколько о двух разных частотах исходящего из компьютера сигналов" комментировать не могу, это какая-то клиника.

Компьютеры не работают мгновенно. Они не выполняют все операции синхронно. Пока один кадр ещё только начинает отображаться на мониторе, второй уже заканчивает рендеринг на GPU, в игровом движке в это время рассчитывается состояние мира для отрисовки третьего, и вот примерно в начале этого рассчёта берётся последнее актуальное положение мыши от ОС, которая получила его от драйвера, который получил данные от устройства. На каждом из этих этапов есть буферы, ненулевое время обработки данных, ненулевое время передачи.

Все это прекрасно; но к чему?

Полное время, за которое информация о сдвиге мыши отображается на мониторе — не меньше 25-30 мс в самом идеальном случае: в сурово оптимизированной игре, на высокочастотном мониторе с G-Sync/Freesync, с мышью с минимальными внутренними задержками (да-да, мышь сама по себе, ещё до передачи данных на USB шину, может вносить до 20 мс).

На основании чего сделаны такие выводы? 20мс отвечают обсуждаемой частоте 50Гц.

Впрочем, почему теперь 20 если выше было 50 и 30 мс?

Дальнейшую клоунаду с «речь идет не столько о двух разных мониторах, сколько о двух разных частотах исходящего из компьютера сигналов» комментировать не могу, это какая-то клиника.

Нужно просто внимательно читать написанное и все станет на свои места.

Кроме того, выше я изложил довольно доступно и подробно большую часть из описанных и наблюдаемых эффектов, можно было бы по ним ответ получить, вместо переписывания общеизвестных фактов?

Все это прекрасно; но к чему?К тому, что курсор может отрисовываться с любой частотой и плавностью, хоть каждую миллисекунду, но реальные движения реальной мыши, которым будет соответствовать каждое его положение, будут произведены за 50мс до отрисовки этого положения. Итого: «момента синхронизации» просто нет — отрисовка курсора в новом положении всегда отстаёт от реального положения мыши, пока она двигается. Пока вы ведёте мышь, курсор следует за ней с отставанием как минимум в 50мс.

пример с testufo, но это быстро — на нем мы видим, что опоздание и прерывистость курсора тем меньше, чем выше частота экранаОт чего вы видите опоздание там? Там реальной мыши нет, от которой можно опаздывать, а положения курсоров в моменты отрисовки полностью совпадают.

К тому, что курсор может отрисовываться с любой частотой и плавностью, хоть каждую миллисекунду, но реальные движения реальной мыши, которым будет соответствовать каждое его положение, будут произведены за 50мс до отрисовки этого положения.

К сожалению, это невозможно т.к. в таком случае реальная частота обновления изображения в кадре в ответ на любые сигналы от устройства ввода не смогла бы превысить 20 Гц. Напр. невозможно было бы вертеть камеру 3d игры с реальной частотой более 20 ФПС.

От чего вы видите опоздание там? Там реальной мыши нет, от которой можно опаздывать, а положения курсоров в моменты отрисовки полностью совпадают.

Точно?

К сожалению, это невозможно т.к. в таком случае реальная частота обновления изображения в кадре в ответ на любые сигналы от устройства ввода не смогла бы превысить 20 Гц. Напр. невозможно было бы вертеть камеру 3d игры с реальной частотой более 20 ФПС.Так почему нет-то? Всё будет с этой скоростью двигаться. Просто с отставанием — начнётся на 50мс позже и закончится на столько же позже. Предположим, вы были неподвижны, а потом двинули мышку, она была в движении 1 секунду. Мышь будет посылать новые координаты каждую миллисекунду, но кадры будут отрисовываться в течение 50мс. Отрисовка вашего движения длиной 1 секунду начнётся на 50мс позже реального, все эти 50мс будут отрисовываться неподвижные кадры, 50 штук, основанные на предыдущих данных, через 50мс кадры начнут меняться, и каждую миллисекунду будет отрисовываться новый кадр, соответствующий положению мыши за 50мс до вывода его на экран. Через 1050мс после того, как вы начали движение (и через 50мс после того, как вы его закончили), кадры снова перестанут меняться, последний из перерисованных кадров будет соответствовать положению мыши за 50мс до его отрисовки — в момент, когда вы остановили мышь.

Точно?Точно. У вас на скриншоте курсоры на нижних двух полосках показаны не в момент их отрисовки, а в промежутке до следующей отрисовки.

Так почему нет-то? Всё будет с этой скоростью двигаться. Просто с отставанием — начнётся на 50мс позже и закончится на столько же позже.

Так будет лишь в одном случае, когда речь идет о заведомо разученном представлении, оно и правда, начнется на 5 минут позже, и закончится на 5 минут позже. Таких громадных задержек не существует (реальная частота опроса хорошей мыши 500Гц т.е. 2мс) просто потому что они накладывались бы друг на друга т.к. движение мышью не является одной линией (да и ее вести с опозданием было бы тягостно), а прерывисто.

У вас на скриншоте курсоры на нижних двух полосках показаны не в момент их отрисовки, а в промежутке до следующей отрисовки.

Это неверно — все курсоры на скриншоте показаны одинаково (да и вообще, почему именно 2 должны быть отдельно, может, 3?), непосредственно в момент их отрисовки (в противном случае их невозможно было бы увидеть). Разница в движении возникает из-за выпадения части положений курсора на меньшей частоте кадров.

просто потому что они накладывались бы друг на друга т.к. движение мышью не является одной линиейТак почему бы им накладываться-то? Для каждой точки, отправленной оптическим сенсором мыши, может отрисовываться соответствующее положение курсора. В каком порядке они приходят, в том и отрисовываются. Какую кривую описала мышь, ту же опишет и курсор, только начнёт он её описывать чуть позже (те самые 50мс). Частота опроса влияет только на количество промежуточных точек в этой кривой.

непосредственно в момент их отрисовки (в противном случае их невозможно было бы увидеть)С чего бы их было невозможно увидеть? Они же после отрисовки не прячутся, а остаются на том же месте до следующей отрисовки.

Так почему бы им накладываться-то? Для каждой точки, отправленной оптическим сенсором мыши, может отрисовываться соответствующее положение курсора. В каком порядке они приходят, в том и отрисовываются. Какую кривую описала мышь, ту же опишет и курсор, только начнёт он её описывать чуть позже (те самые 50мс). Частота опроса влияет только на количество промежуточных точек в этой кривой.

Все это прекрасно, но причем вообще тут?

С чего бы их было невозможно увидеть?

Потому что они не нарисованы.

Они же после отрисовки не прячутся, а остаются на том же месте до следующей отрисовки.

Это и так ясно; но что из этого должно следовать?

Все это прекрасно, но причем вообще тут?Вот это мы и пытаемся понять, какое отношение задержка между моментом сдвига мыши и моментом отрисовки соответствующего нового положения курсора имеет к частоте кадров?

Потому что они не нарисованы.Пока нарисовано новое положение, мы видим предыдущее.

Вот это мы и пытаемся понять, какое отношение задержка между моментом сдвига мыши и моментом отрисовки соответствующего нового положения курсора имеет к частоте кадров?

habr.com/ru/post/508824/?reply_to=21815770#comment_21807398

Пока нарисовано новое положение, мы видим предыдущее.

Это абсолютно верно.

habr.com/ru/post/508824/?reply_to=21815770#comment_21807398

Процитируйте, пожалуйста, что вы тут хотели привести. Там по ссылке комментарий на три экрана.

В котором написано, в том числе, что курсор должен оказаться там же, где и мышь (это вы там называете «синхронизацией»), и это произойдёт, дескать, при отрисовке ближайшего же кадра, поэтому зависит от частоты обновления экрана. Я правильно понял?