В этой части мы, как и в

первой, распакуем файл gzip вручную, но теперь ещё и декодируем коды Хаффмана.

Для начала запишем данные на диск:

$ echo "hector the frantic father on an anchor or a rare fat cat sat on the ranch" > test-huff.txt

$ xxd test-huff.txt

00000000: 6865 6374 6f72 2074 6865 2066 7261 6e74 hector the frant

00000010: 6963 2066 6174 6865 7220 6f6e 2061 6e20 ic father on an

00000020: 616e 6368 6f72 206f 7220 6120 7261 7265 anchor or a rare

00000030: 2066 6174 2063 6174 2073 6174 206f 6e20 fat cat sat on

00000040: 7468 6520 7261 6e63 680a the ranch.

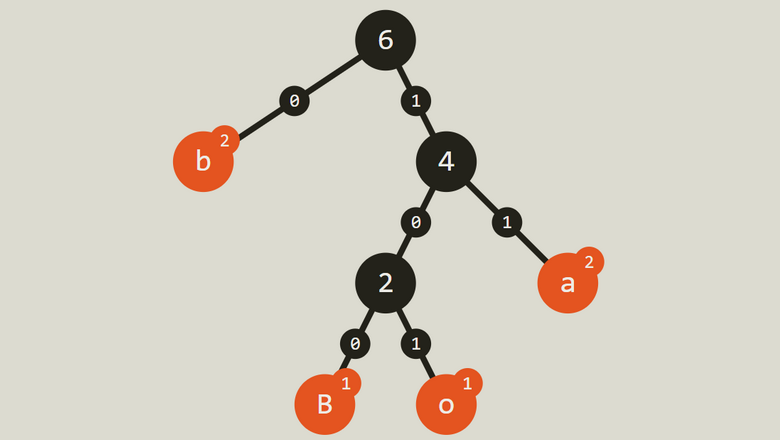

На этот раз файл получился размером 74 байта и содержит 13 символов:

a, c, e, f, h, i, n, o, r, s, t; пробел (0x20) и перевод каретки (0x0a).

В этой строке есть много повторений. Надеюсь, gzip это учтёт. Поскольку я работаю под Windows, то для распаковки использовал

7zip-zstd.

$ 7z a -mx9 test-huff.txt.gz .\test-huff.txt

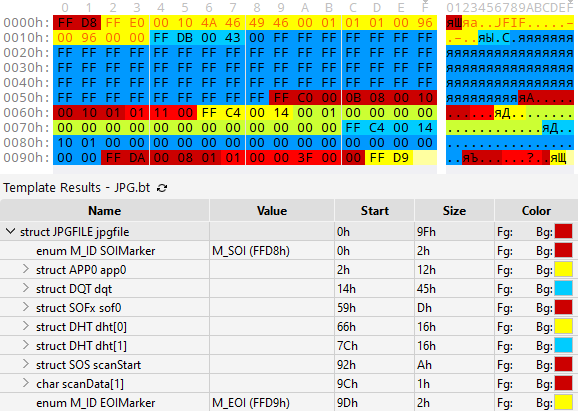

$ xxd test-huff.txt.gz

00000000: 1f8b 0808 d76f 6565 0200 7465 7374 2d68 .....oee..test-h

00000010: 7566 662e 7478 7400 158b 410a 0031 0c02 uff.txt...A..1..

00000020: effb 0abf 2621 257b 69c1 e6ff d480 1e64 ....&!%{i......d

00000030: c6ca e823 7425 96b8 fb0f 2c7a 0967 8393 ...#t%....,z.g..

00000040: 2873 8710 9543 11ee 75ad cc51 237d 0fc7 (s...C..u..Q#}..

00000050: 9797 d64a 0000 00 ...J...

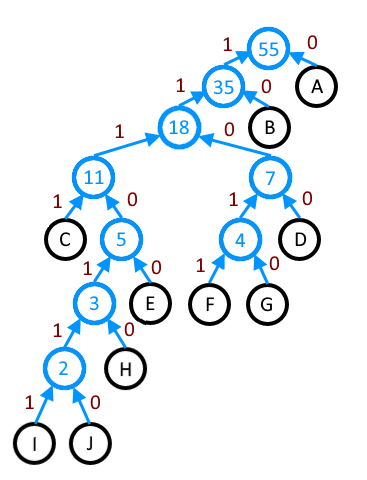

Чтобы вы лучше поняли, как будет выглядеть декодирование, покажу первую строку декодированного потока gzip:

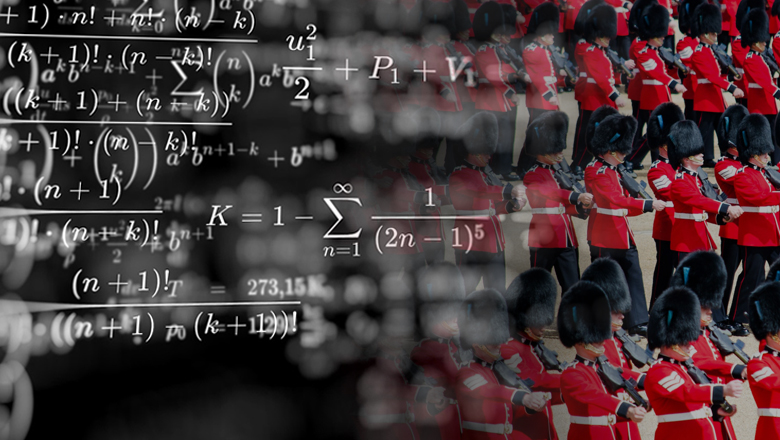

0101 1001 0001 1101 00111 010 000 1101 0101 1001 000

h e c t o r ' ' t h e ' '

Ну а подробности читайте далее.