Как ИИ-агенты теперь сами дообучают LLM

Недавно шумела в инфополе новость, что дообучать LLM модели теперь проше, HuggingFace выпустили скилл дообучения для ИИ-агентов. HuggingFace если кто не знает это что-то вроде GitHub для ИИ-моделей. Там хранятся открытые модели, датасеты, там же можно арендовать GPU и запустить обучение. Короче главная тусовка ML-сообщества.

Так вот они сделали некую инструкцию (skills) для ИИ-агентов типа Claude, Cursor и прочих для дообучения открытых LLM. Теперь дообучить модель стало дешевле в разы, и с этим может справиться человек с небольшим техническим бэкграундом.

Что произошло?

ИИ-агенты типа. Сlaude, ChatGPT, Cursor и т.д могут дообучать более простые LLM по ТЗ от продакта или разработчика. Вот эти скиллы (инструкции) от HuggingFace дают все необходимые знания для ИИ-агента, чтоб она могла за вас собрать датасет (тут конечно не нужно обольщаться всё же нужен от вас датасет), провалидировать его, а именно превратить в понимаемый формат например в JSONL. Короче агент возьмёт ваш датасет, разметит его в нужный формат, напишет скрипт, выберет железо, запустит обучение и сохранит готовую модель. Вы просто смотрите.

Вообще дообучение оно не всегда и не всем нужно. Как правило дообучали модель под специфику домена: медицинские термины, математику и т.д. А больше никто особо этим не заморачивался ибо дорогое это удовольствие нужно нанять ML-команду, GPU-кластер, месяц работы минимум. И это ещё если датасет уже собран, а если нет вообще несколько месяцев минимум.

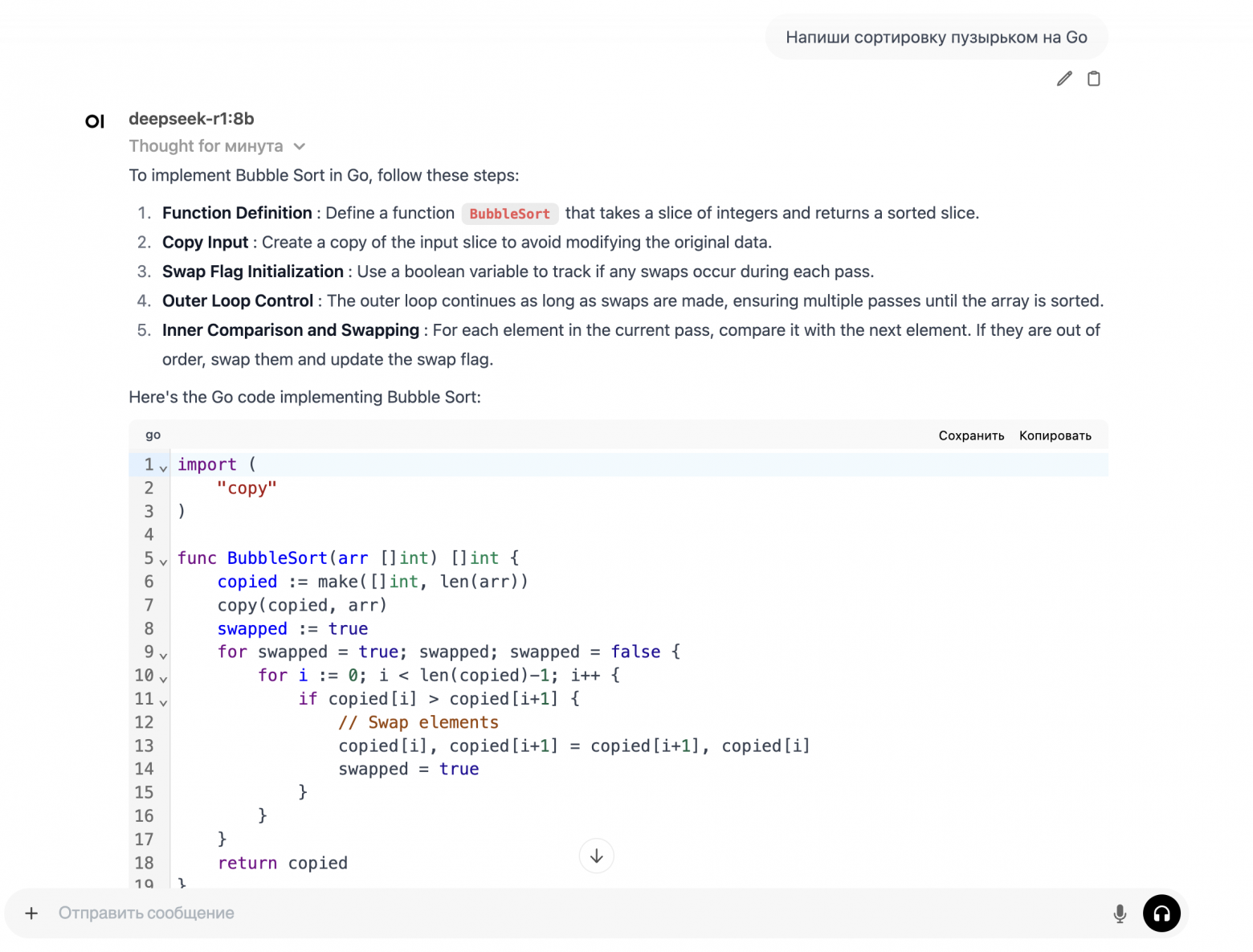

Я перед тем как это вам рассказать решил проверить на себе. У меня уже был опыт дообучения моделей и были свои датасеты. Загрузил один из них и поехали.

Задача, которую я поставил это обучить модель разговаривать "по-русски" и не звучать как робот. Это реальная проблема, часто встречаю ИИ-агентов, которые тупо пересказывают то, что достали из RAG, но никаким Tone of Voice и не пахнет, в следствии самый главный параметр (метрика) бизнеса Customer Voice на самом низком уровне, или SEO-статьи, написанные ИИ, любой детектор видит сразу и не будет индексировать, хотя идея писать статьи с помощью ИИ очень крутая.

Задача для меня показалась интересной и решил проверить справятся ли скиллы от HuggingFace.

Дообучали модель через LoRA методом SFT

LoRA это способ дообучать не всю модель целиком, а маленький адаптер поверх неё. Если представить что есть модель на 7млрд параметров как энциклопедию. То дообучить всю (файнтюнить или по другому называется pretrain) это как переписать всю энциклопедию заново, будет стоить очень дорого и нет смысла это делать.

А метод LoRA делает вот что: открывает главы в энциклопедии и к каждой главе поверх всего текста пишет свои дополнения типо заметочки. Это означает что не вся глава правилась, а есть точечные апдейты. Вот эти заметки и есть адаптер.

SFT это на чём обучаем. Формат данных: где в датасете мы показываем вопрос и правильный ответ. Нужно выбирать под разные задачи разные методы

Такой подход применяется сейчас для дообучения моделей специфическим или доменным знаниям, например медицинские термины, термины другого профиля, или еще вот как пример взять модель изначально предназначенную для написания кода и дообучить её писать код на 1С тогда LoRA в целом подходит.

Claude AI со скиллами справился с задачей

Дальше мы берём эту нашу новую дообученную модель и по классике у себя разворачиваем с помощью vLLM.

На выходных выложу модельку дообученную, можете использовать у себя, бесплатно. Если такое вам надо. Если нужна инструкция пишите, запишу видео или снова устроим воркшоп. Только будьте готовы воркшоп будет часа на 3.

А вот ссылка на плагин (https://github.com/huggingface/skills)

Стоимость аренды сервера – 60$

Файл со сравнением базовой и файнтюненной прикрепил

–––––––––––