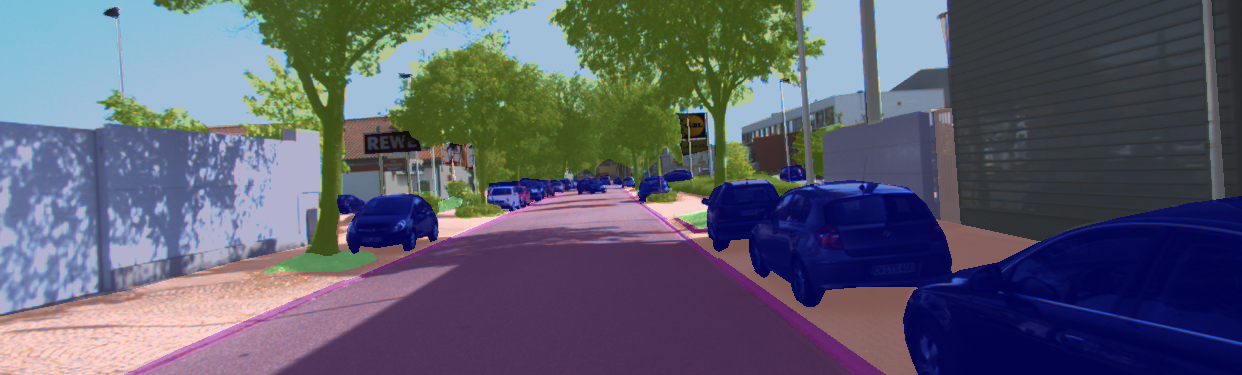

Прежде чем стать достоянием общества, беспилотные автомобили, роботы и автономные системы должны обеспечить высокий уровень восприятия и понимания окружающего их мира. Как же достичь этого уровня? Сегодня мы реализуем его при помощи компьютерного зрения, машинного обучения и множества датчиков. Обычно в качестве таких датчиков используются камеры, радары, сонары и лидары (LiDAR, Light Detection and Ranging).

У каждой компании-разработчика БА (беспилотных автомобилей) есть собственный подход к выбору подходящего датчика, расположению датчиков и использованию общего массива собираемых данных. Лидар, прошедший за последние годы долгий путь развития, становится всё более важным устройством, поскольку играет фундаментальную роль в обеспечении безопасного перемещения БА по дорогам. Несмотря на

заявления Илона Маска, отрасль БА в целом убеждена в том, что этот датчик и его возможности — ключ к успеху автономности. И в самом деле, в отличие от камер, датчики-лидары способны хорошо проявлять себя в условиях плохой видимости, например, в плохую погоду, или даже лучше разбираться с тенями и сложным освещением, с которыми камеры испытывают трудности.