Сегодня у нас в гостях две 980 Ti в SLI, одна GTX 1070, много грязных ругательств, 4k2k и вопросы «как такое может быть». В общем, всё как всегда, будет интересно, заглядывайте под кат.

Графические адаптеры

Какая видеокарта по вашему мнению самая лучшая — RTX 3060? А если нет денег — geforce GTX 1060? А если нет денег, но хочется новую? А если так, чтобы ещё и по производительности она что-то могла? А если… А если… А если…

Сравнение видеокарт — для кого-то хобби. Для кого-то боль. А кто-то просто заказывает лучшее у сборщиков. Да и маркетинг тоже работает. Не зря же весь стим сидит на Geforce RTX 3060.

Я решил посмотреть на видеокарты под другим углом, и был приятно удивлен. И стоимостью, и мощностью, и требованиями к питанию… Дилетантская статья, о том что поставить в свой комп в 2023-ем году. А если будет майнинг бум, то и в 2024-ом.

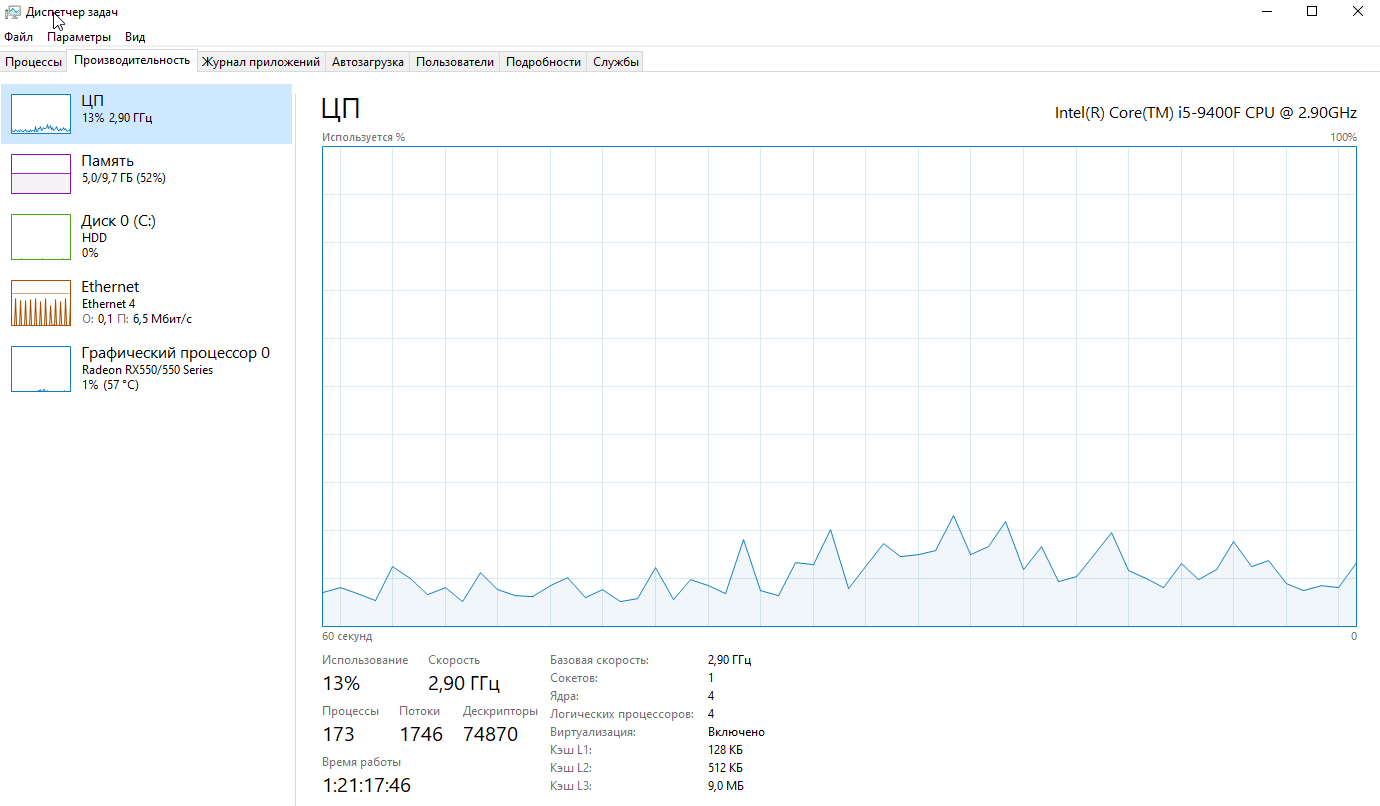

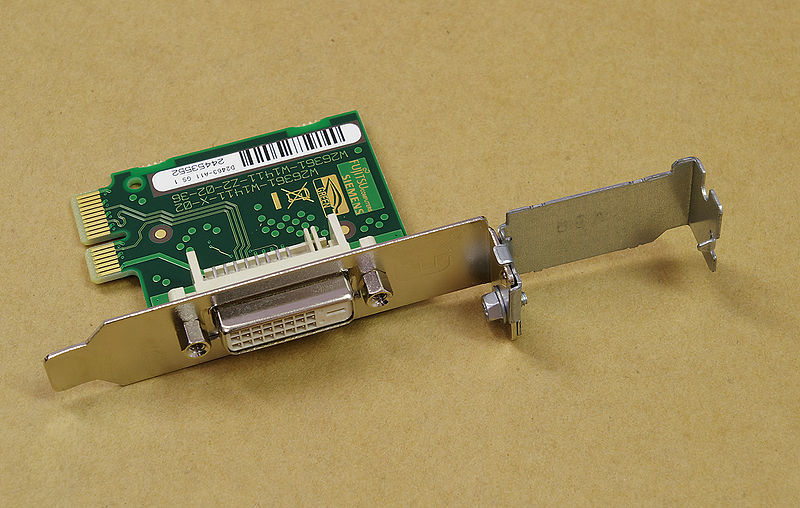

Две разные системы (win + linux) на одной аппаратной базе - реальность. В этом нет ничего нового или инновационного (на данный момент времени), но если требуется максимальная производительность гостевой системы, то не обойтись без проброса реальных устройств в виртуальную машину. Проброс сетевых карт, usb-контроллеров (etc) экстраординарных особенностей не несёт, а вот попытка "шаринга" ресурсов видеокарты и процессора вполне может принести некоторое количество проблем.

Итак, а для чего, собственного говоря, городить системы с полнофункциональным использованием ресурсов GPU и CPU? Самый простой и очевидный ответ - игры (широко известный факт - если не большинство, то очень многие, написаны под ОС Windows). Другой вариант - полноценное рабочее место с возможностью запуска требовательных приложений (например, CAD-софта), быстрым бэкапом (скопировать файл ВМ куда проще, чем создавать полную копию HDD/SSD) и опцией полного контроля сетевого трафика гостевой системы.

Если стационарный компьютер или ноутбук ориентирован на новые и требовательные видеоигры, а также работу с системами автоматизированного проектирования и другими специализированными приложениями, то в нём чаще всего установлен видеоускоритель либо компании Nvidia, либо AMD. Текущее поколение видеоускорителей представлено девятисотой серией GeForce и трёхсотой серией чипов Radeon. Обе постепенно заполняются моделями разной направленности: Nvidia начала делать это осенью 2014 года, AMD — в прошлом июне.

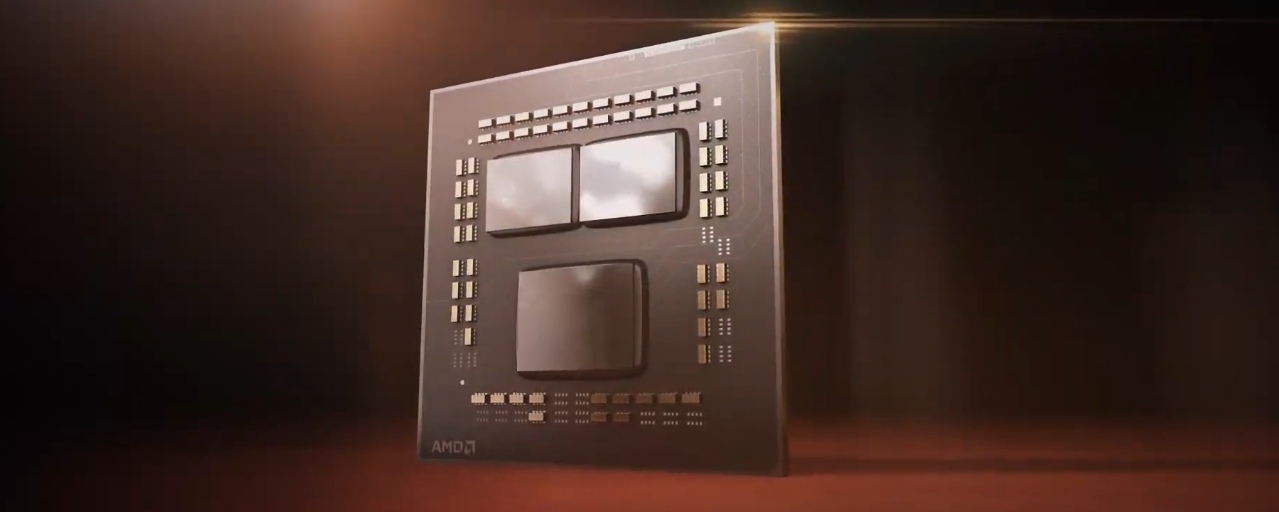

Если стационарный компьютер или ноутбук ориентирован на новые и требовательные видеоигры, а также работу с системами автоматизированного проектирования и другими специализированными приложениями, то в нём чаще всего установлен видеоускоритель либо компании Nvidia, либо AMD. Текущее поколение видеоускорителей представлено девятисотой серией GeForce и трёхсотой серией чипов Radeon. Обе постепенно заполняются моделями разной направленности: Nvidia начала делать это осенью 2014 года, AMD — в прошлом июне. Как считает сама AMD, компания годами определяла новые типы памяти для графических ускорителей, а остальная индустрия выступала в роли догоняющего. Это давало продуктам AMD конкурентное преимущество, к примеру, в своё время нововведение в виде GDDR5 обеспечило Radeon HD 4870 лидерство по производительности. В итоге GDDR5 стала стандартом, но с момента её первого появления прошло уже семь лет, и каких-либо фундаментально новых изменений не происходило. Следующий прорыв должен обеспечить стандарт High Bandwidth Memory (память с высокой пропускной способностью). Первый видеоускоритель на его основе может выйти уже через несколько месяцев.

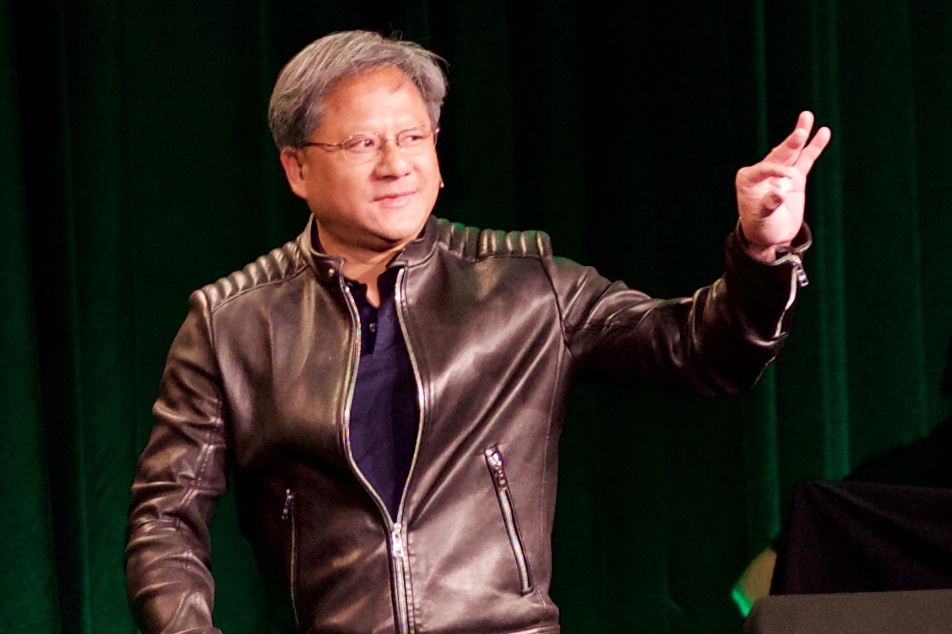

Как считает сама AMD, компания годами определяла новые типы памяти для графических ускорителей, а остальная индустрия выступала в роли догоняющего. Это давало продуктам AMD конкурентное преимущество, к примеру, в своё время нововведение в виде GDDR5 обеспечило Radeon HD 4870 лидерство по производительности. В итоге GDDR5 стала стандартом, но с момента её первого появления прошло уже семь лет, и каких-либо фундаментально новых изменений не происходило. Следующий прорыв должен обеспечить стандарт High Bandwidth Memory (память с высокой пропускной способностью). Первый видеоускоритель на его основе может выйти уже через несколько месяцев. Несколько часов назад вечером в Лас-Вегасе в рамках пресс-конференции нулевого дня Международной выставки потребительской электроники 2015 года глава nVidia Жэнь-Сунь Хуан вышел на сцену и рассказал о новом мобильном решении «система на кристалле» под названием Tegra X1.

Несколько часов назад вечером в Лас-Вегасе в рамках пресс-конференции нулевого дня Международной выставки потребительской электроники 2015 года глава nVidia Жэнь-Сунь Хуан вышел на сцену и рассказал о новом мобильном решении «система на кристалле» под названием Tegra X1.

Каждый раз, когда встает заветный вопрос, апгрейдить ли карточки в серверной или нет, я просматриваю подобные статьи и смотрю такие видосы (нет, маркетинговым материалам от Nvidia конечно верить нельзя, как показал недавний кейс с числом CUDA-ядер).

Канал "Этот Компьютер" очень сильно недооценен, но автор не занимается ML. А в целом при анализе сравнений акселераторов для ML в глаза как правило бросаются несколько вещей:

Не нужно быть семи пядей во лбу, чтобы знать очевидный ответ на вопрос "а какая карта лучше?": карточки серии 20* в массы не пошли, 1080 Ti с Авито до сих очень привлекательны (и не особо дешевеют как ни странно, вероятно по этой причине).

Все это прекрасно и вряд ли стандартные бенчмарки сильно врут, но недавно я узнал про существование технологии Multi-Instance-GPU для видеокарт А100 и нативную поддержку TF32 и мне пришла идея поделиться своим опытом реального тестирования карточек на архитектуре Ampere (3090 и А100). В этой небольшой заметке я постараюсь ответить на вопросы:

За деталями прошу под кат.

День добрый, камрады! Я пока только начинающий музыкант, зато есть опыт в программировании. И почему бы не взять какие-нибудь данные и попробовать из аудиализировать (это как визуализировать, только… кэпъ)?

Тащемта, план таков: