Первые компьютеры были аналоговыми и представляли собой массивные мейнфреймы, заполненные электронными лампами. Они были очень громоздкие, сложные в программировании, дорогие в обслуживании и ограниченные в точности. Позже интегральные микросхемы сделали вычисления более дешёвыми и надёжными. С 1970-х годов XX века аналоговая технология начала постепенно отмирать, поскольку точность аналоговой электроники всегда ограничивалась её компонентами. Независимо от того, в оборудовании использовались ли зубчатые колеса, вакуумные трубки или химическая плёнка: точность была ограничена производственными допусками и ухудшалась со временем.

Сегодня миром правят цифровые устройства. ПК, ноутбуки, смартфоны, электромобили, камеры наблюдения, устройства для умного дома и другая цифровая электроника формирует будущее. Никто не ожидает, что дисковые телефоны или арифмометры приползут из небытия. Дискеты, VHS-кассеты, электронно-лучевые трубки — покоятся с миром. Точно так же не используют старые аналоговые компьютеры в центрах обработки данных.

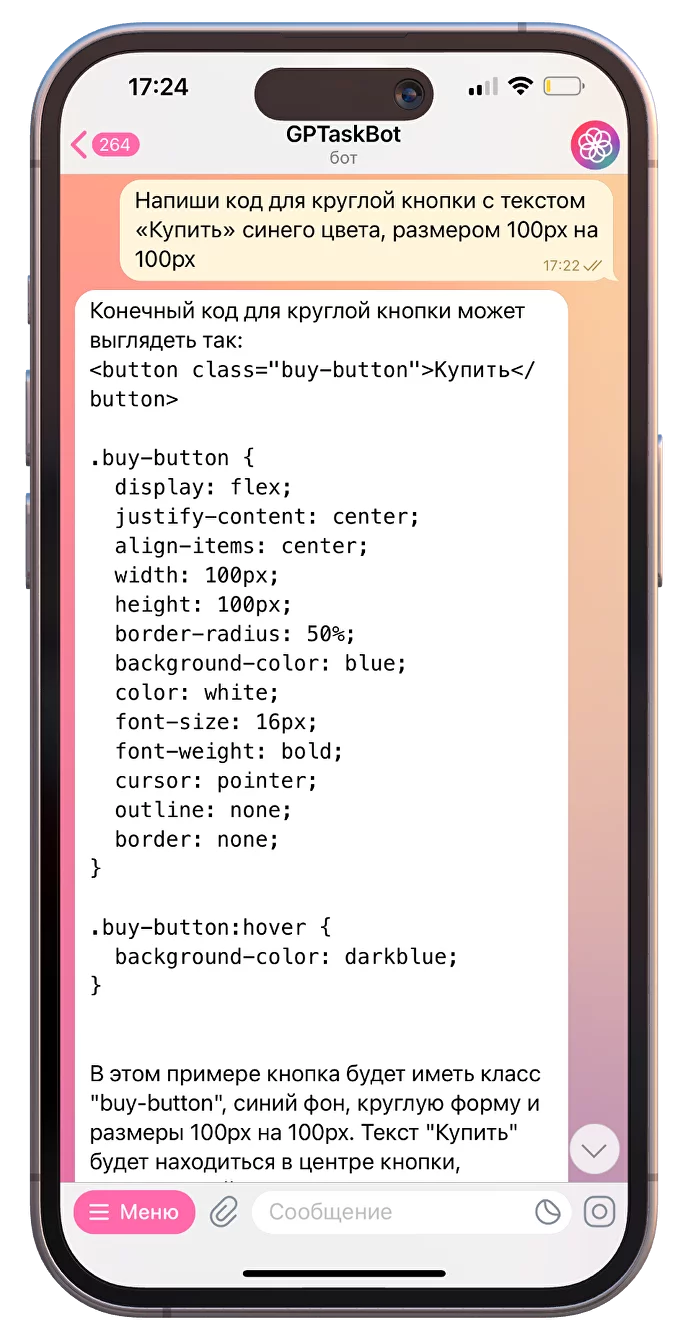

Но аналоговая технология может вернуться. Возвращение аналоговых компьютеров в гораздо более продвинутых формах, чем их исторические предки, радикально и навсегда может изменить мир вычислений. У компаний Кремниевой долины есть секретные проекты по созданию аналоговых чипов для ИИ. Компания

Mythic разработала «первый аналоговый матричный процессор с искусственным интеллектом».